1. 命令行运行

2. 脚本运行

3. jdbc运行

4. 图形接口GUI

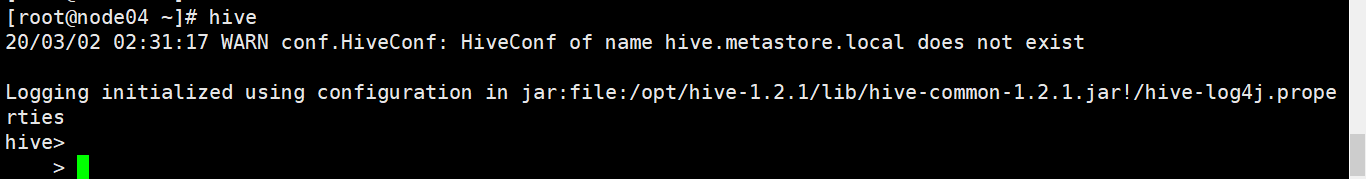

1.命令行方式运行

这种运行方式需要一台服务器启动 hive --service meta store 服务

另一台服务器启动 hive

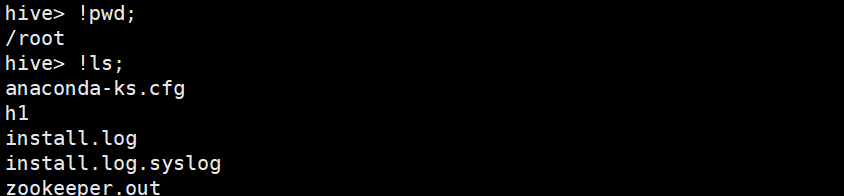

注意:这种运行方式可以直接访问hdfs文件系统和本地文件系统。比外面单独访问hdfs速度更快。(由于在启动hive时,hive就和hdfs文件系统建立了连接)。在访问hdfs时,以dfs 为开头,访问本地文件系统时,以!命令 的方式访问

注意:这种运行方式可以直接访问hdfs文件系统和本地文件系统。比外面单独访问hdfs速度更快。(由于在启动hive时,hive就和hdfs文件系统建立了连接)。在访问hdfs时,以dfs 为开头,访问本地文件系统时,以!命令 的方式访问

hdfs dfs 的参数

Usage: hadoop fs [generic options]

[-appendToFile <localsrc> ... <dst>]

[-cat [-ignoreCrc] <src> ...]

[-checksum <src> ...]

[-chgrp [-R] GROUP PATH...]

[-chmod [-R] <MODE[,MODE]... | OCTALMODE> PATH...]

[-chown [-R] [OWNER][:[GROUP]] PATH...]

[-copyFromLocal [-f] [-p] [-l] <localsrc> ... <dst>]

[-copyToLocal [-p] [-ignoreCrc] [-crc] <src> ... <localdst>]

[-count [-q] [-h] <path> ...]

[-cp [-f] [-p | -p[topax]] <src> ... <dst>]

[-createSnapshot <snapshotDir> [<snapshotName>]]

[-deleteSnapshot <snapshotDir> <snapshotName>]

[-df [-h] [<path> ...]]

[-du [-s] [-h] <path> ...]

[-expunge]

[-get [-p] [-ignoreCrc] [-crc] <src> ... <localdst>]

[-getfacl [-R] <path>]

[-getfattr [-R] {-n name | -d} [-e en] <path>]

[-getmerge [-nl] <src> <localdst>]

[-help [cmd ...]]

[-ls [-d] [-h] [-R] [<path> ...]]

[-mkdir [-p] <path> ...]

[-moveFromLocal <localsrc> ... <dst>]

[-moveToLocal <src> <localdst>]

[-mv <src> ... <dst>]

[-put [-f] [-p] [-l] <localsrc> ... <dst>]

[-renameSnapshot <snapshotDir> <oldName> <newName>]

[-rm [-f] [-r|-R] [-skipTrash] <src> ...]

[-rmdir [--ignore-fail-on-non-empty] <dir> ...]

[-setfacl [-R] [{-b|-k} {-m|-x <acl_spec>} <path>]|[--set <acl_spec> <path>]]

[-setfattr {-n name [-v value] | -x name} <path>]

[-setrep [-R] [-w] <rep> <path> ...]

[-stat [format] <path> ...]

[-tail [-f] <file>]

[-test -[defsz] <path>]

[-text [-ignoreCrc] <src> ...]

[-touchz <path> ...]

[-usage [cmd ...]]

Generic options supported are

-conf <configuration file> specify an application configuration file

-D <property=value> use value for given property

-fs <local|namenode:port> specify a namenode

-jt <local|resourcemanager:port> specify a ResourceManager

-files <comma separated list of files> specify comma separated files to be copied to the map reduce cluster

-libjars <comma separated list of jars> specify comma separated jar files to include in the classpath.

-archives <comma separated list of archives> specify comma separated archives to be unarchived on the compute machines.

The general command line syntax is

bin/hadoop command [genericOptions] [commandOptions]

2.脚本运行方式

hive的参数

//定义一个变量值,在交互中可以引用

-d,--define <key=value> Variable subsitution to apply to hive

commands. e.g. -d A=B or --define A=B

--database <databasename> Specify the database to use

//后面参数为需要执行的sql语句,查询完,自动退出hive,注意\\的冲突问题

-e <quoted-query-string> SQL from command line

//后面参数为一个文件,,查询结束,自动退出hive ,适合多语句

-f <filename> SQL from files、

//查看hive帮助文档

-H,--help Print help information

--hiveconf <property=value> Use value for given property

--hivevar <key=value> Variable subsitution to apply to hive

commands. e.g. --hivevar A=B

//初始化sql文件

-i <filename> Initialization SQL file

//静默模式 ,不会打印hive查询中的状态信息 可以把查询的数据重定向到文件保存

-S,--silent Silent mode in interactive shell

//详细信息输出到控制台

-v,--verbose Verbose mode (echo executed SQL to the

console)

3.jdbc运行方式

beeline 必须依赖与hiveserver2(hiveserver的优化版本,hiveserver只支持一台客户端访问,和hiveserver2支持多用户访问,支持并发,常用于生产环境)。

一台服务器启动hiveserver2

客户端以beeline方式连接

方式1:

beeline -u jdbc:hive2://<启动hiveserver2的节点>:10000/default -n root

方式2:

>beeline

>!connect jdbc:hive2://<启动hiveserver2的节点>:10000/default <用户名> <密码>

beeline连接时,不会校验用户名和密码,但必须填写

!close:关闭连接命令

4.图形界面GUI

配置过程复杂,查询不友好。不建议使用。