首先还是要感谢平安的这次比赛,让自己对数据处理有了更深层次的一些了解。

话不多说,进入正题。最优成绩为0.2878.

主要比赛流程(结合自身经验总结)

1.基本数据的分析EDA以及随机森林或者Xgboost方法进行对应主要特征的提取。(红色部分是参赛心得)

2.在对有序多值特征时,需要结合实际问题来对具体参数进行map赋值处理,对于多值无序的特征需要进行独热编码处理(one-hot编码),这样不仅扩充了特征,也排除了人为设置对应关系带来的干扰。

3.在计算机硬件允许的情况下,还是要对数据进行SMOTE方法的上下采样,从理论上进行对数据的扩充,减少样本分布不均衡造成的影响。(虽然自己没有复现出来)

4.本人思路,从结果来看,分数还是可以接受的。自己出发点是既然有70W+的正样本和3293个负样本,单方面认定70W+的正样本是大量的无用的重复特征,增加了特征提取和模型训练的难度。所以随机对70W+的正样本进行了抽样(按行抽样)。然后用lgm/gbdt/xgboost分别对1:5 1:10 1:15的正负样本比例进行训练,然后根据线下AUC分数的比例得到了三者的比例为1:1:3这样进行最终模型的投票选择。采用三个不同比例样本训练的出发点是,为了更好的训练模型对极小负样本数量特征的提取,有助于模型对少数样本的预测。不能过于信赖精确率这个指标!

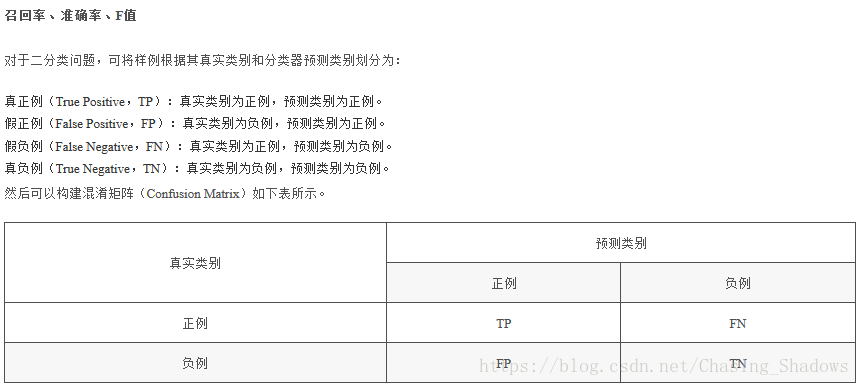

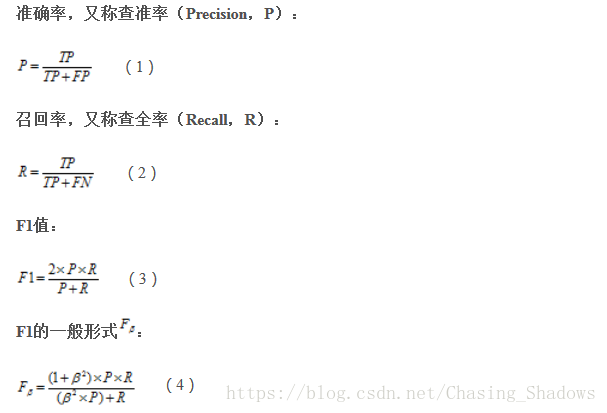

5.在样本极度不均衡的条件下,平时用到的精确率率这个指标就作废了,主要用到召回率,准确率和F 值。本次比赛标准用到F2值。

具体的参赛代码,可以参考github网址,https://github.com/Shadow-Yang/PingAn2018jike