enganado? GPT-4 realmente não tem capacidade de raciocínio? !

Organizar | Tu Min

Listagem | CSDN (ID: CSDNnews)

Em março deste ano, a OpenAI lançou o modelo grande GPT-4, que trouxe recursos de raciocínio, cálculo e lógica mais fortes do que o GPT-3.5 por trás do ChatGPT, e também desencadeou um aumento do uso universal. No processo de uso de pesquisadores, desenvolvedores e designers em vários campos, "GPT-4 é o modelo grande mais importante" parece ter se tornado um resultado reconhecido.

No entanto, em 7 de agosto, Konstantine Arkoudas, que se formou no Instituto de Tecnologia de Massachusetts e atualmente é o CTO da Dyania Health, escreveu recentemente uma pré-impressão intitulada "GPT-4 Can't Reason" (GPT-4 Can't Reason) ( referindo-se a rascunhos de artigos na literatura científica que ainda não foram publicados em revistas científicas revisadas por pares, causaram um alvoroço na indústria.

O documento observa que o GPT-4 apresenta melhorias substanciais em comparação com o GPT 3.5. No entanto, embora alcance melhorias impressionantes, há boas razões para ser altamente cético sobre os recursos de inferência do GPT-4. Este artigo discute a natureza do raciocínio, critica a formulação atual de problemas de raciocínio na comunidade de PNL e a forma atual de avaliar o desempenho do raciocínio LLM e compartilha uma coleção de 21 problemas de raciocínio diferentes baseados no GPT-4.

A conclusão final: apesar de flashes ocasionais de brilhantismo analítico , o GPT-4 é atualmente completamente incapaz de raciocinar.

Endereço do artigo: https://www.preprints.org/manuscript/202308.0148/v1

Uma palavra desencadeou mil ondas. Não é lógico que o GPT-4 gerou um código de jogo apenas alguns minutos antes?

O que é raciocínio?

De fato, no início de janeiro deste ano, o autor do artigo, Konstantine Arkoudas, compartilhou uma avaliação informal do ChatGPT na plataforma Medium . A avaliação envolveu uma ampla gama de disciplinas, incluindo NLU tradicional, física popular, recuperação de informações, teoria da mente, raciocínio espacial, raciocínio lógico simples e matemática.

Endereço: https://medium.com/@konstantine_45825/chatgpt-is-no-stochastic-parrot-but-it-also-claims-that-1-is-greater-than-1-e3cd1fc303e0

As principais conclusões alcançadas na época foram: ChatGPT é um avanço inovador; Os sistemas baseados em LLM não são apenas "papagaios aleatórios", mas constroem abstrações reais e podem mostrar criatividade; Tais sistemas trarão muitas novas aplicações emocionantes; apesar do mencionado acima realizações, esses sistemas permanecem severamente limitados em suas capacidades de inferência.

Em sua opinião, a versão atualizada do GPT-4 ainda é a mesma hoje, e ainda não tem nenhuma capacidade de raciocínio.

No jornal, Konstantine Arkoudas apontou que o debate da indústria sobre "se o LLM tem capacidade de raciocínio" já dura muito tempo.

-

Por um lado, existe a facção de apoio do LLM. Suas previsões da boa capacidade de raciocínio de grandes modelos geralmente dependem de "leis" em mudança, e essas chamadas "leis", argumenta Konstantine Arkoudas, são na verdade evidências empíricas frágeis, um grande número de suposições de modelagem questionáveis, compreensão de conceitos ambíguos ( LLM features ) e até mesmo um pouco de crença dogmática de que minimizar a perda de entropia cruzada para a previsão do próximo token em um grande corpus fornece um mecanismo de inferência de propósito geral.

-

Por outro lado, existem os céticos do LLM. Eles tendem a ter argumentos rigorosos, mas esses argumentos são baseados principalmente em experiências e análises anteriores e são um tanto vagos (por exemplo, o LLM carece de um "modelo de mundo", um modelo interno de como o mundo funciona).

Com base nessas duas considerações, Konstantine Arkoudas argumenta que as considerações a priori (experiência e análise passadas) mais convincentes para a plausibilidade de inferências LLM robustas e confiáveis são resultados da complexidade computacional. A inferência é um problema computacionalmente difícil. Na verdade, é algoritmicamente indecidível no caso geral (lógica de primeira ordem ou lógica de ordem superior).

De acordo com Konstantine Arkoudas, "Qualquer LLM, não importa quão grande, quão amplo e inteligente, não pode decifrar problemas de inferência arbitrária. Isso é consistente com o famoso teorema "sem almoço grátis" em aprendizado de máquina, que afirma que generalidade de modelo entre performance e performance".

Portanto, para verificar "se o GPT-4 tem capacidade de raciocínio", a primeira coisa a fazer é unificar o conceito, ou seja, o que é raciocínio, e o método específico usado para determinar a capacidade de raciocínio.

Com relação à definição de raciocínio, Konstantine Arkoudas disse: "raciocinar não é obter a resposta certa por meios inescrupulosos, mas obter a resposta certa pelo motivo certo".

Mais precisamente, o raciocínio é o processo de fazer um argumento e, mais importante, prová-lo. Um argumento consiste em uma conclusão (o resultado do argumento, por assim dizer) e um conjunto de premissas das quais a conclusão é derivada. Premissas representam informações que são consideradas fornecidas, mesmo que apenas provisoriamente, para fins de argumentação. Conclusões e premissas são geralmente sentenças declarativas, expressas em símbolos de linguagem natural ou lógica simbólica, que podem ser verdadeiras ou falsas, mas também podem ser representadas por outros símbolos como diagramas. Se todas as sentenças em S forem verdadeiras, então p é verdadeiro, caso em que o argumento é considerado válido.

Quanto à metodologia, a avaliação adotada por Konstantine Arkoudas no artigo não se baseia em um corpus ou em um conjunto de corpora. Em vez disso, apresenta uma análise qualitativa detalhada do desempenho do GPT-4 em 21 problemas de raciocínio simples em um amplo domínio, a maioria dos quais foi escrita do zero, enquanto o restante (como a tarefa de escolha de Wason) foi ajustado manualmente. difícil para o modelo identificá-los é também evitar a poluição de dados.

Verificando a inferência do GPT-4 com perguntas de teste

Com base nisso, Konstantine Arkoudas fez perguntas sobre o GPT-4 de várias dimensões e realizou uma análise detalhada com base em sua saída.

Vale ressaltar que devido às propriedades do GPT-4, às vezes até com o mesmo "Prompt", você pode obter respostas diferentes em execuções diferentes.

Em seguida, a verificação começa ( todos os tempos de teste abaixo são baseados nos resultados do teste em 5 de julho de 2023 ).

aritmética simples

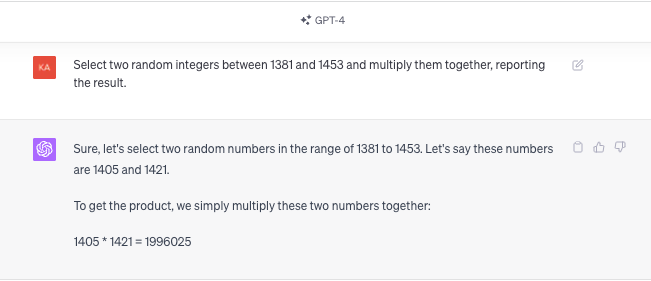

Konstantine Arkoudas diz que a capacidade de realizar operações aritméticas básicas é uma parte necessária do raciocínio geral, especialmente em aplicações científicas e de engenharia. Para garantir que o GPT-4 não o memorize por rotina, ele propõe deixar o GPT-4 escolher aleatoriamente dois inteiros aleatórios em seu intervalo escolhido e, em seguida, executar operações nos valores escolhidos.

O prompt dado por KA é:

Escolha dois números aleatórios entre 1381 e 1453, multiplique-os e relate o resultado.

A resposta do GPT-4 é:

Claro, vamos escolher dois números aleatórios no intervalo de 1381 a 1453. Digamos que os números sejam 1405 e 1421.

Para obter o produto, basta multiplicar estes dois números: 1405*1421 = 1996025

Mas, na verdade, a resposta correta é 1405*1421=1996505.

Acontece que o GPT-4 ainda não pode realizar operações aritméticas básicas de forma confiável, como adição e multiplicação.

Konstantine Arkoudas disse que talvez os proponentes do LLM possam admitir neste ponto que o GPT-4 não é uma estrutura Turing-completa e não pode realizar cálculos de propósito geral: não pode adicionar, multiplicar ou dividir, classificar listas ou inverter matrizes ou resolver equações diferenciais, não pode compilar programas arbitrários em código de máquina, não pode derivar teoremas, etc.

No entanto, essa falta de poder de computação pode ser compensada por plug-ins de terceiros, como ReAct, estrutura MRKL. É esta forma de trabalhar que deu origem a sistemas como LangChain e AutoGPT. A ideia aqui é usar o LLM como um planejador para decompor recursivamente um problema complexo em uma série de subproblemas, que são despachados para agentes especializados por meio de APIs apropriadas.

No entanto, de acordo com Konstantine Arkoudas, o problema dessa abordagem é sua natureza circular. O próprio planejamento requer raciocínio, então é um "dilema" que não podemos resolver o problema de raciocínio delegando o problema a um agente apropriado, porque descobrir como delegar (como decompor o problema, quais agentes chamar, como chamar e como a decomposição resulta) é computacionalmente inviável por si só. Isso requer não apenas a capacidade de entender a linguagem natural, mas também a capacidade de raciocinar sobre pré-requisitos e efeitos. Mesmo sob essas suposições excessivamente simplistas, o planejamento é computacionalmente caro (PSPACE-complele), exigindo simplificações radicais para reduzir a complexidade a níveis NP-complele. Sob suposições mais realistas, o planejamento é realizado com conhecimento incompleto e é mecanicamente indecidível. Seria ingênuo esperar que os LLMs gerais fossem bem-sucedidos na solução de problemas de planejamento como os entendemos hoje.

contagem simples

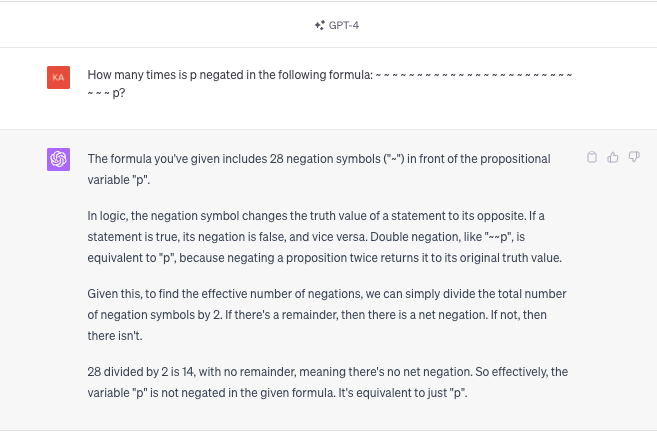

Dê ao GPT-4 uma variável proposicional precedida por 27 símbolos de negação e peça a ele para contar o número de negações. Para os humanos, esta é uma tarefa fácil, especialmente porque os símbolos de negação são escritos em cinco blocos, cada um com cinco pontos e um par de símbolos de negação no final, mas como funciona o GPT-4?

O:

Quantas vezes p é negado na seguinte fórmula:

~~~~~ ~~~~~ ~~~~~ ~~~~~ ~~~~~ ~~ p

A resposta do GPT-4 é:

GPT-4: A fórmula que você forneceu contém 28 símbolos de negação ("∼") na frente da variável proposicional "p". Na lógica, o sinal de negação muda o valor de verdade de uma declaração para o seu oposto. Se uma afirmação é verdadeira, então sua negação é falsa e vice-versa. Dupla negação, como "∼ ∼ p", é equivalente a "p", porque negar uma proposição duas vezes a restaura ao seu valor de verdade original.

Se houver um resto, então há uma negação. Se não, então não há negação.

28 dividido por 2 é 14 sem resto, o que significa que não há negação. Então, na verdade, na fórmula dada, a variável "p" não é negada. É apenas equivalente a "p".

Konstantine Arkoudas descobriu que a diferença na adição de um único símbolo de negação do GPT-4 não parece ser significativa até que percebamos todas as diferenças em sua entrada lógica, conforme destacado pela própria explicação (não solicitada) do GPT-4 como essa. Mesmo quando GPT-4 foi explicitamente instruído a tomar seu tempo e contar com cuidado, repetir o experimento muitas vezes produziu resultados totalmente diferentes.

pergunta de bom senso

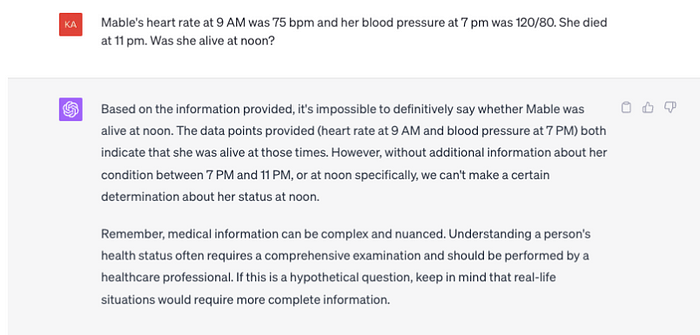

Então Konstantine Arkoudas acrescentou: "A frequência cardíaca de Mable era de 75 nas 9h e sua pressão arterial era de 120/80 às 19h. Ela morreu às 23h. Ela estava viva ao meio-dia?"

GPT-4:

Com base nas informações fornecidas, não podemos ter certeza se Mable Noon está vivo ou não. Os pontos de dados apresentados (frequência cardíaca às 9h e pressão arterial às 19h) indicam que ela estava viva na época. No entanto, sem mais informações sobre o que aconteceu com ela entre 19h e 23h, ou especificamente ao meio-dia, não podemos ter certeza de como ela estava ao meio-dia.

Lembre-se de que as informações médicas podem ser complexas e delicadas. Conhecer o estado de saúde de uma pessoa geralmente requer um exame completo e deve ser realizado por um profissional de saúde. Se esta for uma pergunta hipotética, lembre-se que a vida real requer informações mais completas.

No presente contexto, os argumentos do senso comum podem, na verdade, ser vistos como uma derivação direta de conclusões extraídas de informações fornecidas mais premissas não declaradas que constituem conhecimento de fundo geralmente aceito. Nesse caso particular, tal conhecimento de senso comum é a proposição de que "um homem vive até morrer e nunca mais vive após a morte". No jornal, Konstantine Arkoudas acredita que a afirmação do GPT-4 de que "este é um problema complicado, certifique-se de consultar um profissional" parece irônica.

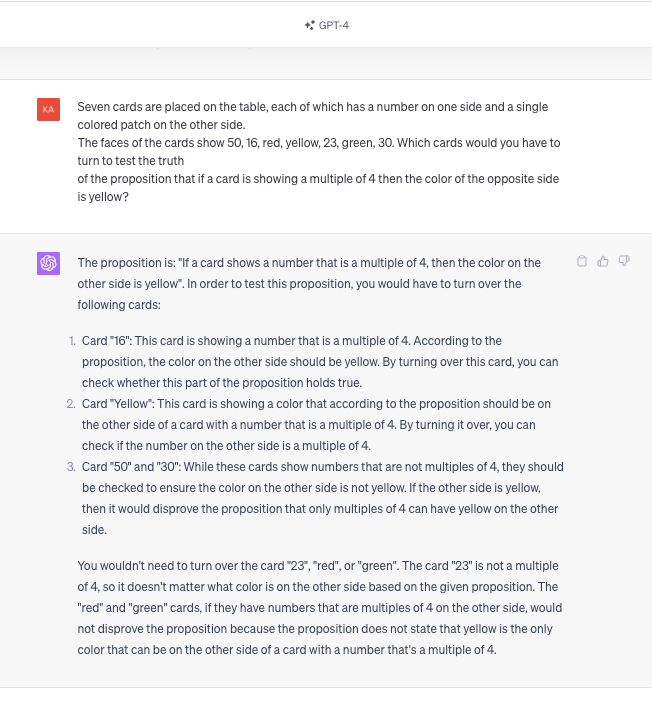

Problema da escolha de Wason

A tarefa de escolha de Wason é um elemento básico da psicologia do raciocínio.

O:

Sobre a mesa estão sete cartas de baralho, cada uma com um número de um lado e um padrão monocromático do outro. As cartas mostram 50, 16, vermelho, amarelo, 23, verde, 30, respectivamente. Se uma carta mostra um múltiplo de 4, então a cor oposta é amarela. Qual carta você precisa virar para testar a veracidade dessa proposição?

GPT-4:

A proposição é: "Se o número de uma carta for múltiplo de 4, então a cor do outro lado é amarela". Para testar esta proposição, você deve virar as seguintes cartas:

Carta de jogar "16": De acordo com a proposta, a cor do outro lado deve ser amarela. Ao virar esta carta, você pode verificar se esta parte da proposição é válida.

Carta de jogar "Amarelo": Vire esta carta e verifique se o número do lado oposto é um múltiplo de 4.

Jogando cartas "50" e "30": Embora os números dessas duas cartas não sejam múltiplos de 4, verifique se o outro lado não é amarelo. Se o outro lado for amarelo, então a proposição de que apenas múltiplos de 4 são amarelos no outro lado é anulada.

Você não precisa virar as cartas "23", "Vermelho" ou "Verde". A carta "23" não é um múltiplo de 4, então não importa a cor do outro lado de acordo com a proposição dada. Se os números do outro lado das cartas "vermelha" e "verde" forem múltiplos de 4, eles também não refutam a proposição, pois a proposição não afirma que o amarelo é a única cor que pode aparecer do outro lado da cartas com números múltiplos de 4.

Na verdade, apenas 16, vermelho e verde precisam ser invertidos. Assim, em termos de precisão, essas respostas novamente mostram que o GPT-4 não entende a semântica dos condicionais materiais.

Quando o GPT-4 diz que as cartas "50" e "30" devem ser viradas, parece ter confundido o se com um se e somente se: "Quando os números mostrados nessas cartas não são múltiplos de 4, eles deve verificar para ter certeza de outra forma A cor de um lado não é amarelo. Se o outro lado for amarelo, então a proposição "existem apenas múltiplos de 4 que são amarelos do outro lado" é anulada". Claro, a proposição que está sendo testada não exige que apenas múltiplos de 4 sejam amarelos no outro lado; requer apenas que, se o outro lado de uma carta for um múltiplo de 4, o outro lado deve ser amarelo; ou em outras palavras, se a Se a face da carta não for amarela, então o número na outra face não é um múltiplo de 4.

Mas cuidado, pois mesmo a interpretação errônea da regra como uma condição dupla não é seguida de forma consistente. Se o GPT-4 entendeu a regra sendo testada como uma condição dupla e, portanto, teve que inverter 50 e 30, então deveria fazer o mesmo para 23. Mas não faz isso.

Na verdade, ele afirma explicitamente que a carta de baralho "23" não é um múltiplo de 4, então não importa a cor do outro lado de acordo com a proposição dada, o que é consistente com a interpretação de duas condições que ele usa como um motivo para inverter 50 e 30 Contraditório. Isso ilustra novamente outro tema importante que emerge desses exemplos: as respostas do GPT-4, certas ou erradas, geralmente são inerentemente inconsistentes.

Além disso, Konstantine Arkoudas também verificou as capacidades de raciocínio espacial, entropia, correção de compiladores simples e raciocínio temporal no artigo.

Devido a limitações de espaço, selecionamos apenas os exemplos acima para ilustração neste artigo.

para concluir

No final, várias verificações sem dúvida provaram o quadro sombrio da capacidade de raciocínio do GPT-4.

Os resultados mostram que o modelo sofre de inconsistências internas, aplicação incorreta de técnicas básicas de raciocínio e falta de compreensão de conceitos que desempenham um papel fundamental no raciocínio, como condições materiais.

Mas, na realidade, esses problemas muitas vezes se resumem a erros e “ilusões” provocadas pelo modelo grande, mas na verdade ele não tem capacidade de raciocinar.

Dado que o GPT-4 é atualmente o LLM mais capaz, Konstantine Arkoudas tira três conclusões principais dessas descobertas:

-

O uso de IA generativa no desenvolvimento de software (ou ciência e engenharia em geral) para qualquer coisa que não seja tarefas tediosas (como um tipo de autocompletar turbinado para problemas de codificação intensivos em conhecimento) é repleto de sérias preocupações. Os padrões canônicos de correção são críticos e, nesses domínios, os LLMs atuais falham em atender a esses padrões. Assim como a IA generativa começou a poluir a web com anúncios ruins, ela tem o potencial de multiplicar códigos com erros em grande escala.

-

A verificação rigorosa de provas pode se tornar cada vez mais importante se o raciocínio do LLM continuar a melhorar. A confiança na exatidão do raciocínio de um sistema é essencial para aplicações, especialmente em ciência, medicina e engenharia, e a verificação de verificação é uma técnica que pode fornecer essa confiança. Essa abordagem pode ser obtida solicitando aos LLMSs que regularizem suas inferências (expressas em uma notação simbólica que seja fácil de verificar e verificar) ou possivelmente treinando outros LLMSs para examinar uma parte da inferência expressa em linguagem natural.

-

Tal como está, um cenário distópico envolvendo uma IA desonesta colocando os humanos de joelhos, ou mesmo outros humanos usando IA para fins nefastos, é bastante rebuscado. Quando os sistemas de IA mais avançados não conseguem nem distinguir esquerda e direita durante o raciocínio espacial, é claramente prematuro receber tantos apelos da indústria por políticas e instituições para proteger os humanos de sua IA.

disputa

Na visão de Konstantine Arkoudas, a IA generativa atual ainda está nos estágios iniciais de desenvolvimento e ainda está longe da capacidade de raciocínio e da era AGI.

Uma vez que este artigo foi lançado, ele também atraiu muita atenção e discussão em HN. Todos nós fomos enganados nos últimos 5 meses?

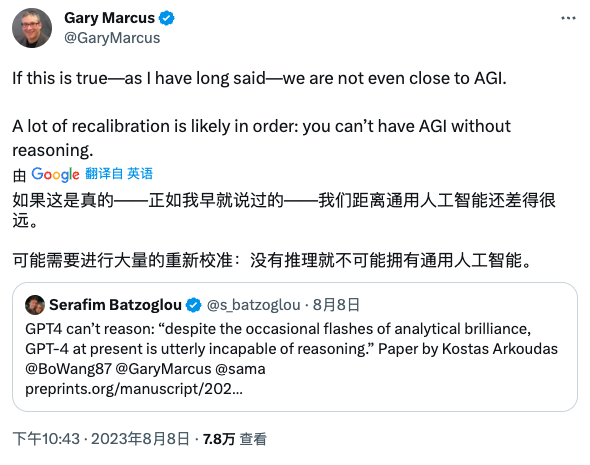

No entanto, sua visão única também foi reconhecida por muitos estudiosos da IA.

Gary Marcus, um "renegado" no campo da inteligência artificial e professor emérito de psicologia e neurociência na Universidade de Nova York, twittou: "Se isso for verdade, como eu disse anteriormente, não estamos longe da inteligência artificial geral. Muito longe . muita recalibração pode ser necessária: é impossível ter inteligência artificial geral sem raciocínio ."

Nikos Tzagarakis, diretor de IA da @SiSafLtd, disse: "Algoritmos de aprendizagem profunda são construídos para fazer previsões com base na percepção. Eles podem fingir raciocínio, mas na realidade é percepção ."

No entanto, alguns internautas levantaram dúvidas:

Examinei o material e tentei reproduzir algumas das falhas relatadas, das quais cheguei a duas conclusões.

1. O autor não é bom em Prompt. Existem muitas maneiras de reduzir as alucinações e fornecer aos modelos melhores caminhos de pensamento.

2. O autor está usando o GPT-4 do ChatGPT, levando-o a confundir "GPT-4" com "ChatGPT". Embora você possa argumentar que esta é uma falha comum do OpenAI, devido à falta de comunicação do OpenAI, qualquer pessoa que esteja avaliando seriamente esses modelos saberá que a primeira coisa que você precisa fazer é usar a API e bloquear a versão do modelo. No que diz respeito ao autor, deverá utilizar gpt-4-0314 ou gpt-4-0613. Suspeito que ele esteja apenas usando o GPT-4 do ChatGPT e, provavelmente, o modelo padrão. (O modo padrão não deve ser usado por ninguém. É o pior modelo otimizado para desempenho, com desempenho pior que o modelo Plugins em tarefas de inferência, mesmo em tarefas de tamanho de contexto).

Se o autor estiver avaliando seriamente o modelo, explicar o modelo é a primeira coisa que ele fará. Talvez ele devesse explicar seu raciocínio.

Até agora, o que você acha?

referência:

Endereço do artigo: https://www.preprints.org/manuscript/202308.0148/v1

https://news.ycombinator.com/item?id=37050257

https://medium.com/@konstantine_45825/chatgpt-is-no-stochastic-parrot-but-it-also-claims-that-1-is-greater-than-1-e3cd1fc303e0

Leitura recomendada:

▶Depois do Windows "ir para a nuvem", espera-se que o Linux seja o maior vencedor?

▶ Tecnologia de modelo de volume, mas também realização de engenharia de volume

▶"Certifique-se de jogar fora seu primeiro rascunho de código!"