anuário

1 Introdução aos métodos de aprendizagem estatística

5 árvore de decisão --ID3, C4.5, CART

6 modelo de regressão logística com o máximo de entropia

7 SVM - minimização da sequência SMO

1 Introdução aos métodos de aprendizagem estatística

aprendizagem supervisionada: classificação, regressão, marcação; sem supervisão: agrupamento

função comum de perda: função de perda 0-1, função de perda quadrática, a função perda absoluta, função de perda logarítmica.

Regularização: Experiência é o risco de erro no conjunto de treinamento, o risco estrutura do modelo é o risco de utilização indevida (over-fitting, usando a regularização). L1 positivo ou L2 norma do vetor parâmetro.

A validação cruzada: a simples validação cruzada (formação de 70%, 30 de teste); S-dobrar validação cruzada (dados em grupos de S, S-1 conjuntos de treino, deixando um conjunto de testes seleccionados de entre o grupo S mínima de erro de teste modelo); leave-one validação cruzada (S vezes validação cruzada S = N, isto é, N-1 de dados de treino, os dados de ensaio, deixando um), no caso da falta de dados.

Categoria de avaliação: a precisão da classificação geral, para precisão e recordação geralmente usado dicotômica relação P R. P = TP / (TP + FP), R = TP / (TP + FN). P é um valor positivo previsto classe positivo na classe (a classe é previsto positivo negativo positivo classe classe + está previsto classe positivo) rácio é positivo em todas as classes na previsão. R é n-tipo quantidade de n-tipo no previsto (n + classe Classe está previsto positivo negativo positivo tipo de classe previsto) é a razão entre a classe real n seja recolhido.

Harmónica valor significativo F1, 2 / F1 = 1 / P + 1 / R, isto é, F1 = 2PR / (P + R), um P e R são elevados, F1 será alta.

2 Perceptron

modelo linear de classificação, sinal (w * x + b), n é maior do que 0 classe 0 é menor do que um tipo negativo. wx + b = 0 a uma hiperplana separar, w é o vector normal, b é a intercepção.

A função de custo: ponto de erros de classificação de distância hyperplane

Algoritmo: Um método de gradiente descendente estocástica, cada vez que a seleção de um ponto de gradiente descida

Quando o conjunto de dados de separáveis linearmente, uma certa convergência.

3 k-nearest neighbor

Algoritmo: Calcular o vector de distância a partir de cada amostra de entrada, para seleccionar as amostras de k recentes, a maioria dos onde o maior número de decisões de classificação tal classe

k-mais próximo método vizinho não mostra o processo de aprendizagem. Quando o conjunto de treino é determinada, o método de medição de distância, o valor k, as regras de decisão de classificação (por exemplo, uma maioria), para qualquer entrada é exclusivamente determinada uma nova instância da classe a que pertence.

distância métrica Lp, p tipicamente leva dois. Para melhorar a eficiência da busca k-vizinhos mais próximos, você pode usar método de árvore de kd. conjunto 1- formação configurado primeira árvore equilibrada, 2- pesquisa

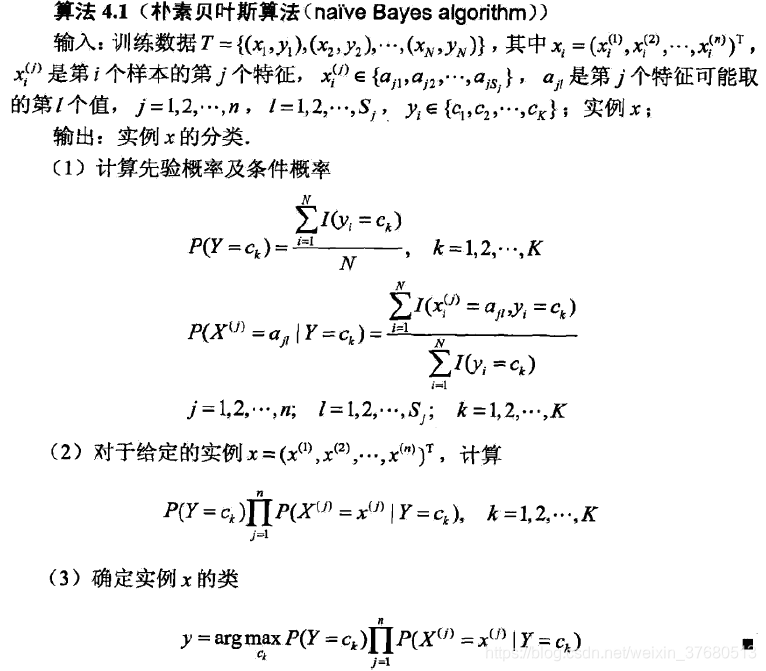

4 método Naive Bayes

probabilidade anterior, refere-se a todos os dados conhecidos, em que o cálculo de probabilidades, a probabilidade é conhecido no conjunto de treino.

probabilidade posterior, meios de entrada conhecidos, cada probabilidade de adivinhar saída, a ser testado probabilidade derivada

Estimativa de probabilidade máxima: calcular a probabilidade de cada, pode haver uma probabilidade zero.

Estimativa Bayesiana Naive: Quando o original é calculada com base em probabilidades a priori, a adição de moléculas de lambda, o denominador foi adicionado K * lambda; ao calcular probabilidades condicionais, em conjunto com lambda molecular, mais o denominador Sj * lambda, Sj cada característica Os valores possíveis de j ter uma Sj

algoritmo:

1> probabilidades calculadas a priori, a probabilidade de cada classe no conjunto de treino; calcular uma probabilidade condicional de cada j característica em cada classe k em cada um dos possíveis valores de probabilidade do aji.

2> probabilidade estes podem possivelmente ocorrer em cada classe K para uma dada característica é calculado. Porque o pressuposto iid entre as características de modo a que a probabilidade multiplicando

3> Selecione a probabilidade máxima posterior da classe.

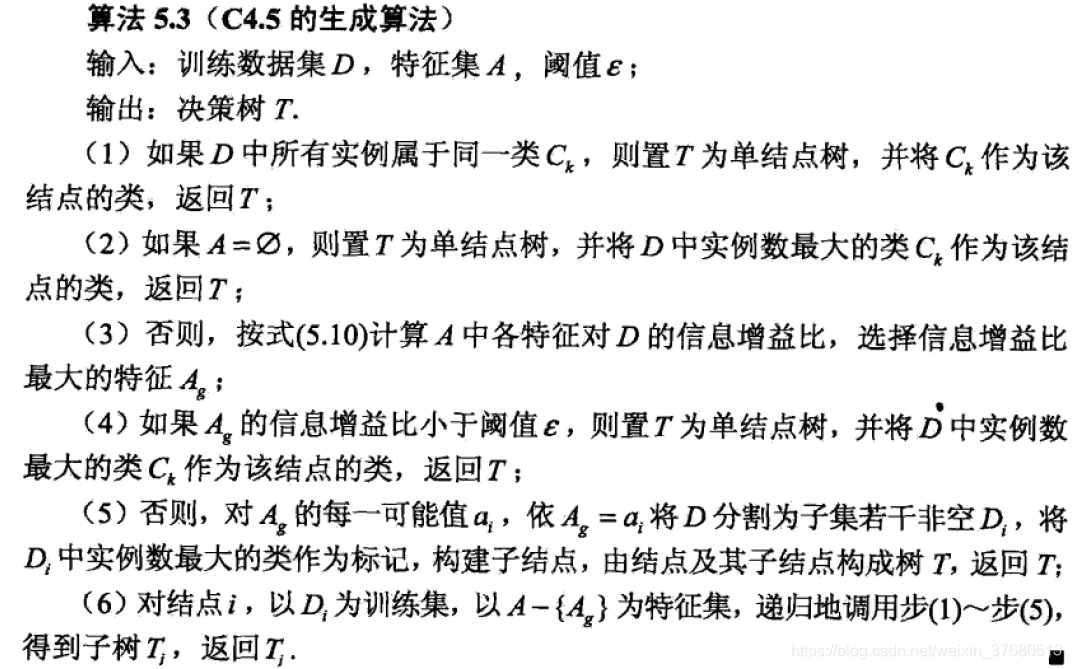

5 árvore de decisão --ID3, C4.5, CART

Árvore de Decisão: seleção de recursos, gera árvores de decisão, poda de árvores

selecção característica : o conjunto de dados de entrada e em que a, características de saída óptimas

- Calcule a experiência conjunto de dados entropia: o nível de experiência de incerteza entropia conjunto de dados, conjunto de dados de classificação

- Uma experiência cálculo recurso a entropia condicional do conjunto de dados: uma dada característica, a classificação baseada no recurso, a entropia condicional experiência neste caso de computação. Condições entropia fórmula de cálculo: sob as condições dadas é definido como X, a entropia da distribuição de probabilidade de Y as condições desejadas para X em. Interpreta-se no conjunto de dados: Uma dada característica, e calcular a probabilidade de um subconjunto dos subconjuntos classificados A, esta probabilidade é usado para calcular as condições esperadas de um; e, em seguida, para cada subconjunto, o subconjunto classificar calculado entropia (número de diferentes tipos de moléculas, o denominador é o número de subconjuntos, que é, tendo em conta um, classificação entropia condicional distribuição de probabilidade). De um modo geral, com a primeira classificação característica, o sub classificadas centralizada computar a entropia condicional, em seguida, os resultados da classificação (probabilidade) de buscar uma entropia condicional desejado.

- Computando ganho de informação

Árvore de Decisão : ID3 usa ganho de informação, uso C4.5 da relação de ganho de informação

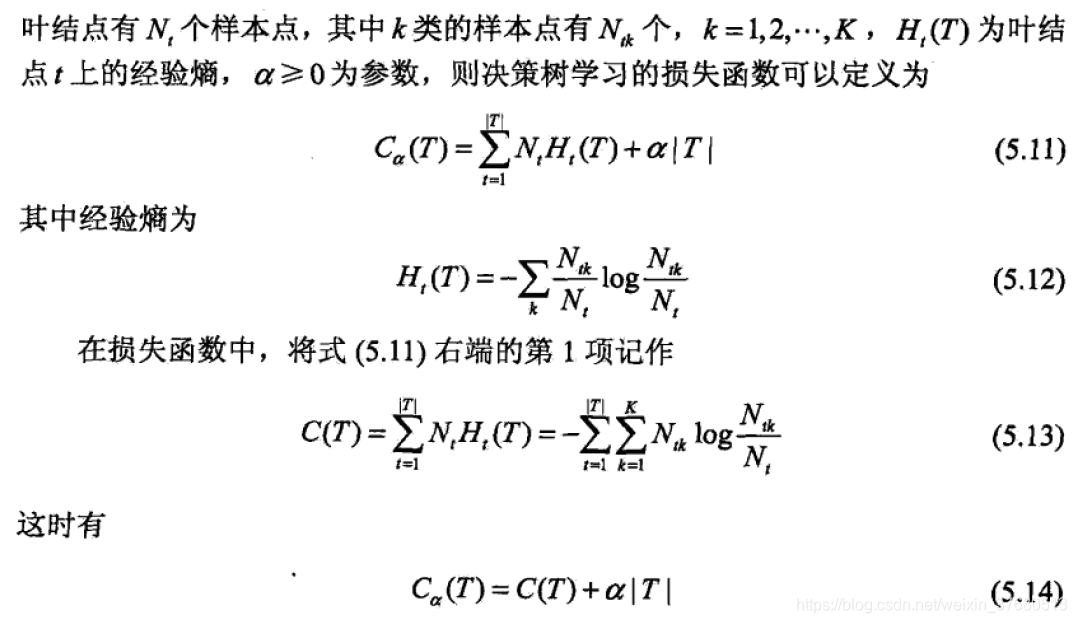

Poda de árvores :

| T | é o número de nós de folha, NT é o número de pontos no nó de folha de amostra, Ht a experiência nós folha de entropia. Se após a retracção do nó de folha correspondente para as diminuições funcionais de perda de pai nó, a poda. Até sem poda, obter a função sub perda mínima

algoritmo CART: Uma árvore de decisão é uma árvore binária, árvore de regressão com os critérios de minimização de erro quadrado, classificação minimização árvore usando o índice de Gini.

6 modelo de regressão logística com o máximo de entropia

Regressão Logística: binomial regressão logística P (Y = 1 | x) = exp (wx) / (1 + exp (wx)), P (Y = 0 | x) = 1 / (1 + exp (wx)) ele pode ser estendido para multi-classificação

log de probabilidade logarítmica (p / (1-P)) = wx linear. função log-probabilidade G (w) = sigma (ylog (HX) + 1-y) log ((1-HX)), hx = exp (1 + exp (wx))

7 SVM - minimização da sequência SMO

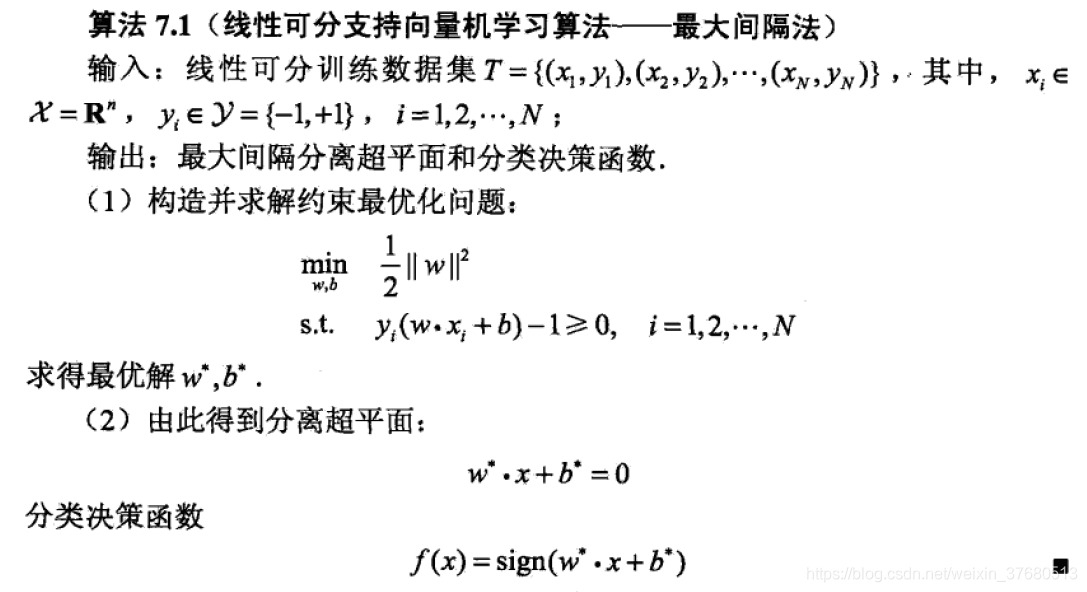

máquina de vetores de suporte separável linearmente

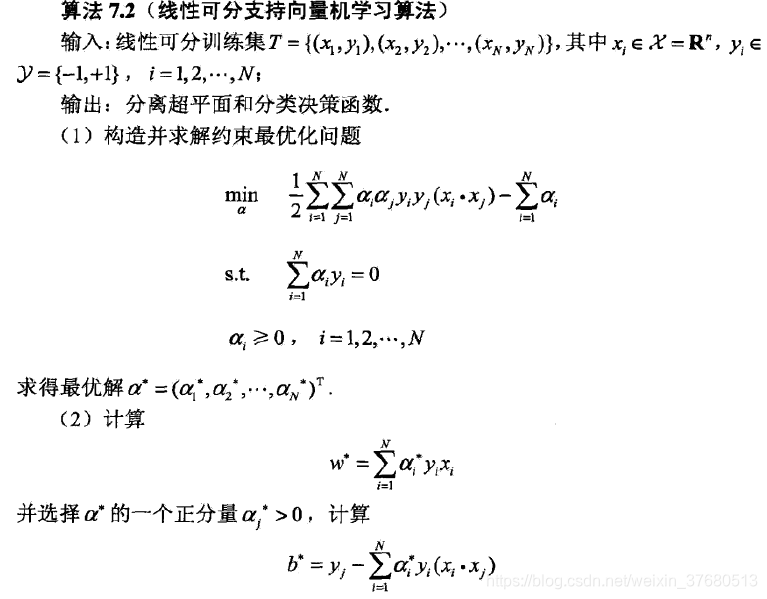

Linearmente separáveis algoritmo dupla:

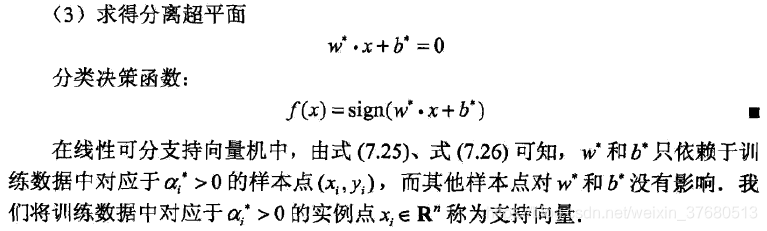

Linearmente inseparáveis : a adição de uma variável de folga

![]()

Não-lineares Support Vector Machines: Usando a função kernel, a semelhança originalidade é calculada

algoritmo de minimização seqüência de SMO

8 método de actualização --AdaBoost, levantando a árvore (classificação, regressão), gradiente aumentando a árvore (GBDT)

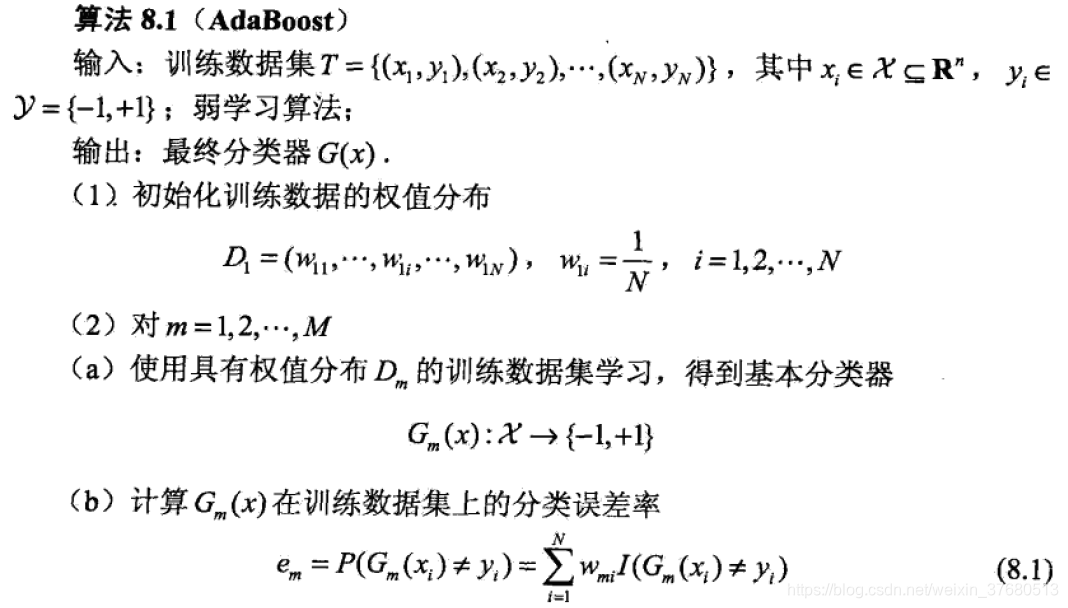

AdaBoost (Adaptive Boosting):

1> conjunto de inicialização de distribuição de dados D

2> treinando classificador de dados para obter G (x)

- Cálculo na formação definir um e_m erro de classificação

- O cálculo deste erro pesos classificador alpha_m

- Atualize o conjunto de dados de distribuição D

3> M após vezes, o classificador final é uma combinação linear dos sub-classificadores

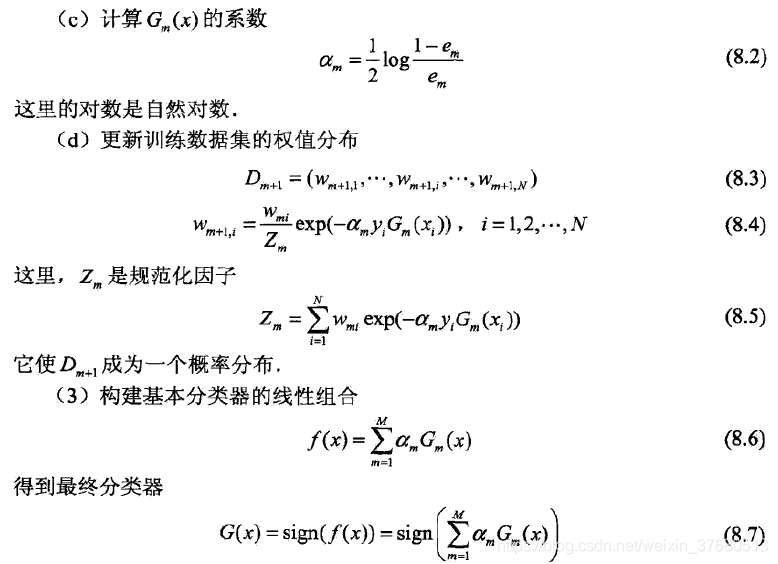

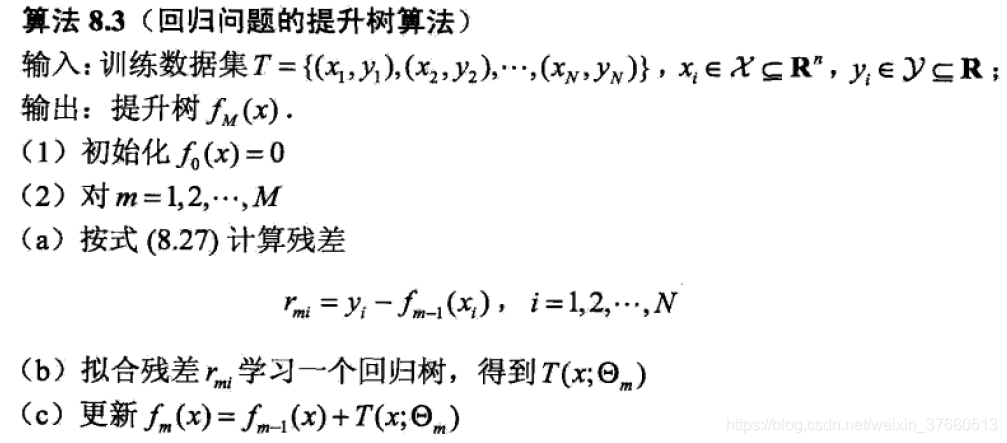

Impulsionar árvore: dois de classificação, regressão

algoritmo de árvore classificação binária para melhorar o classificador básico AdaBoost pode usar de segunda classe árvore de classificação.

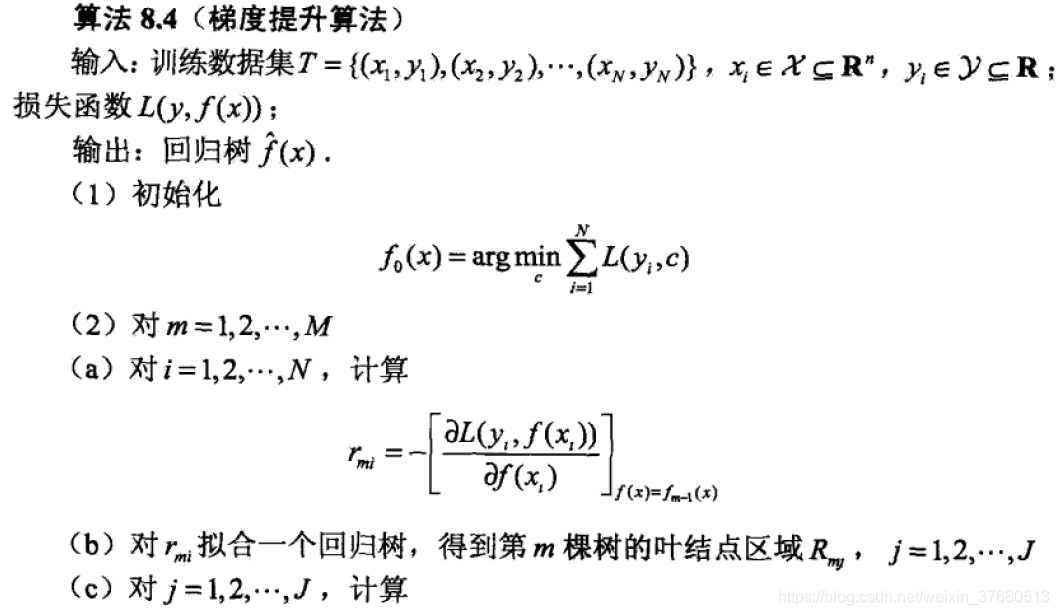

Para aumentar os problemas de regressão árvore, o algoritmo é a seguinte:

1> f0 = 0 Inicialização

2> para aprender uma árvore de regressão

3> são calculados para cada resíduos de dados de treino, continuam aprendendo através de resíduos de árvores de regressão

Gradiente impulsionar árvore GBDT (Gradiente sobre impulsionando decisão Tree):

Para uma função perda geral, em que o gradiente negativo residual.