最近、Nvidia は H200 の仕様を明らかにしました。H200 は基本的に、独自のアクセラレータとしての GH200 のホッパー半分のように見えます。 もちろん、ここでの最大の違いは、HBM3 から HBM3E への切り替えです。これにより、NVIDIA はメモリ帯域幅とメモリ容量を増やすことができます。 - そして、NVIDIA は 6 番目の HBM メモリ スタックを有効にします。 、これは元の H100 では無効でした。これにより、H200 のメモリ容量は 80GB から 141GB に増加し、メモリ帯域幅は 3.35TB/秒から NVIDIA の暫定予想の 4.8TB/秒に増加します。これは帯域幅の増加で約 43% です。

合計帯域幅とメモリ バス幅に基づいて、これは H200 のメモリが約 6.5Gbps/ピンで動作することを示唆しています。これは、オリジナルの H100 の 5.3Gbps/ピン HBM3 メモリと比較して周波数が約 25% 増加しています。 H200 は、GH200 の異例の 141GB メモリ容量も保持します。 HBM3E メモリ自体の物理容量は 6 つの 24GB スタックの形式で 144GB ですが、NVIDIA は生産上の理由からその容量の一部を保留しています。その結果、顧客はオンボードの 144 GB のすべてにアクセスできるわけではありませんが、H100 と比較して容量とメモリ帯域幅の利点がある 6 つのスタックすべてにアクセスできます。

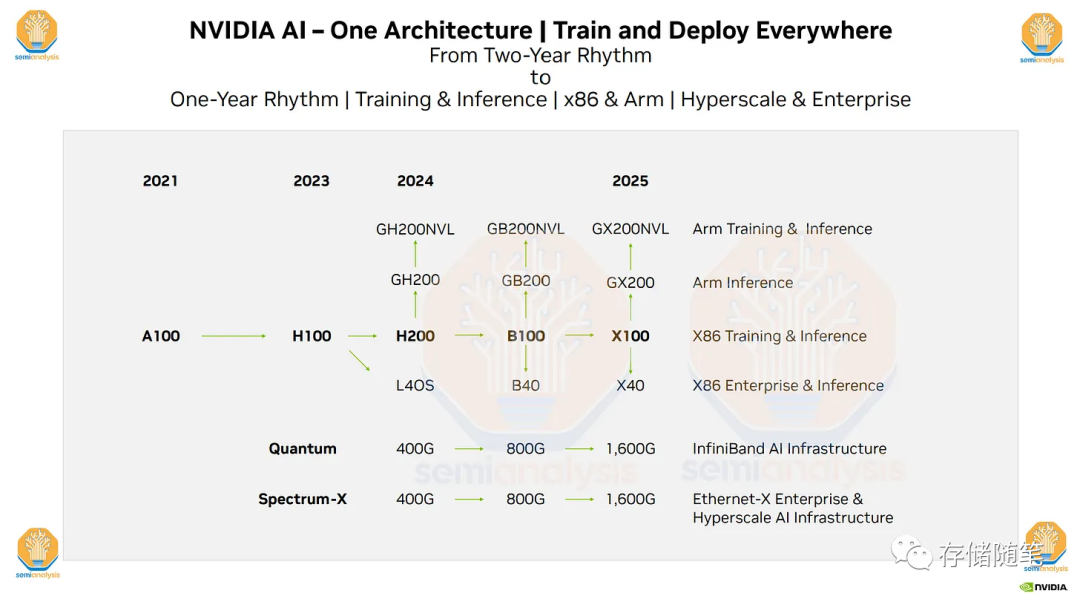

特に、今後数年間のハードウェア ロードマップ。今後の H200、B100、および「X100」GPU を含みます。 AI GPU を毎年更新するという Nvidia の動きは非常に重要であり、多くの影響を及ぼします。 Nvidia のプロセス テクノロジ プラン、HBM3E の速度/容量、PCIe 6.0、PCIe 7.0、および非常に野心的な NVLink および 1.6T 224G SerDes プラン。この計画が成功すれば、Nvidia は他社を超えることになります。

高帯域幅メモリ (HBM) は、AMD と SK Hynix が開発した 3D スタッキング テクノロジーに基づいた高性能 DRAM です。この種類のメモリは、グラフィックス プロセッサ、ネットワーク スイッチングおよび転送機器 (ルーター、スイッチなど) など、高いメモリ帯域幅要件を持つアプリケーションに適しています。

HBM は、3D スタッキング プロセスを使用して複数のメモリ チップを垂直にスタックし、より高いストレージ容量とより高速なストレージ帯域幅を実現します。この設計により、HBM は従来の DRAM よりも高いデータ転送速度を実現できます。

具体的には、HBM は、複数の DRAM チップを垂直方向に積み重ねることにより、インターフェイスとコントローラを結合します。このようにして、各 DRAM チップは、他のチップとデータを共有しながら、独立したストレージ ユニットとして機能することができます。この設計により、HBM はより高いデータ転送速度とより大きなストレージ容量を実現できます。

HBM には高帯域幅、大容量、低遅延という利点があるので、ハイ パフォーマンス コンピューティング、データ センター、メモリ帯域幅を必要とするアプリケーションで広く使用されています。ネットワーク中継装置等これらのアプリケーションでは、HBM は従来の DRAM よりも高いデータ転送速度と大きなストレージ容量を提供できるため、 システム全体のパフォーマンスが向上します。

さらに、HBM はグラフィック プロセッサでも使用され、画像のレンダリング速度が向上し、ゲーム エクスペリエンスが向上します。 人工知能と機械学習の分野では、HBM はさまざまなアルゴリズムやモデルのトレーニングにも広く使用されており、より高速な計算速度とより優れたトレーニング効果を実現します。< a i=2> 。

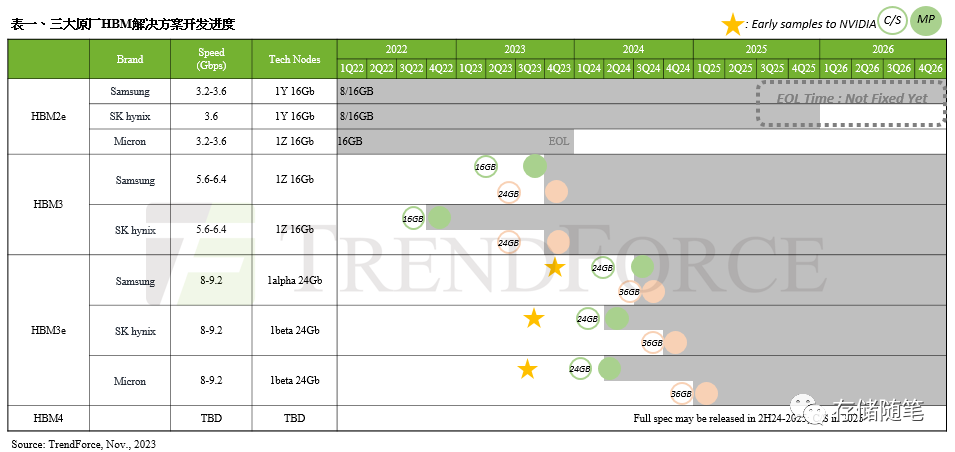

TrendForce の最新の HBM 市場調査によると、より適切で健全なサプライ チェーン管理を実現するために、NVIDIA はさらに多くの HBM サプライヤーに加わることも計画しています< a i=2 > このうちSamsungのHBM3(24GB)は今年12月にNVIDIAで検証を完了する予定だ。 HBM3eの進捗状況をタイムラインに沿って整理すると、下表の通り、Micronは今年7月末に8hi(24GB)のNVIDIAサンプルを提供し、SK hynixは今年8月中旬に8hi(24GB)のサンプルを提供し、 Samsung 8hi (24GB) のサンプルは、今年 10 月初旬に提供される予定です。

HBM 検証プロセスは煩雑で 2 四半期かかると予想されているため、TrendForce では 2023 年末には一部のメーカーから HBM3e 検証結果が得られると予想しています。3 つの主要な正規メーカーは 2024 年の第 1 四半期に検証を完了する予定です。各純正メーカーの HBM3e 検証結果によって、2024 年の HBM サプライヤー間の最終的な NVIDIA 調達重量配分も決定されることは注目に値します。ただし、検証はまだ完了していないため、2024 年の全体的な HBM 調達量はまだわかりません。 。