この記事の主な対象はVision Transformer の計算消費量を削減、新しい方法が提案されています。ViT では、Transformer トークンの数がパッチ サイズに反比例することがわかっています。つまり、パッチ サイズが小さいほど、モデルの計算コストが高くなり、パッチが大きいほど、モデルの損失が大きくなります。効果。これは私たちの目的に反しています。

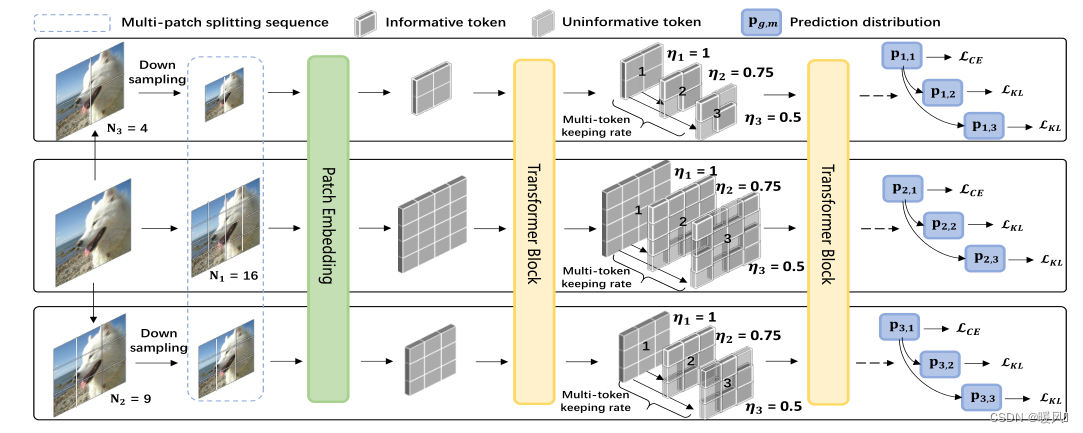

この記事の主な対象はVision Transformer の計算消費量を削減、新しい方法が提案されています。ViT では、Transformer トークンの数がパッチ サイズに反比例することがわかっています。つまり、パッチ サイズが小さいほど、モデルの計算コストが高くなり、パッチが大きいほど、モデルの損失が大きくなります。効果。これは私たちの目的に反しています。多尺度的patch分割SuperViT の作成者は、と の2 つの側面からパフォーマンスを向上させています多种保留率。計算量を最小限に抑えて計算を高速化し、モデルのパフォーマンスを向上させます。画像分類では基本的にこの方法で問題はありませんが、超解像の分野では、ピクセルの破棄は依然としてモデルのパフォーマンスに深刻な影響を与えます。

元のリンク:スーパー ビジョン トランスフォーマー