1. Implementar una máquina independiente redis en k8s

1.1 Introducción a redis

Redis es una base de datos no relacional de código abierto (base de datos nosql) basada en el protocolo BSD. El autor es el desarrollador italiano Salvatore Sanfilippo y se lanzó en 2009. Está escrito en lenguaje C, redis se basa en el almacenamiento de memoria y actualmente es una popular valor clave.Base de datos (base de datos de valores clave), que proporciona un servicio para compartir memoria de forma remota a través de la red. Memcache proporciona funciones similares, pero en comparación con Memcache, redis también proporciona funciones como fácil expansión, alto rendimiento y datos. persistencia. . Los principales escenarios de aplicación incluyen el uso compartido de sesiones, que a menudo se usa para Tomcat en un clúster web o el uso compartido de sesiones para múltiples servidores web en PHP; cola de mensajes, caché de registros de ELK y sistemas de suscripción y publicación para algunas empresas; contadores, que se usan a menudo para acceder a clasificaciones y navegación de productos. Escenarios estadísticos numéricos relacionados con números y tiempos; almacenamiento en caché, a menudo utilizado para consultas de datos, información de productos de sitios web de comercio electrónico, contenido de noticias, etc.; en comparación con Memcache, redis admite la persistencia de datos y puede ahorrar memoria. datos en el disco y reiniciar el servicio redis. O el servidor puede luego restaurar los datos del archivo de respaldo a la memoria para su uso continuo.

1.2, PV/PVC y Redis independientes

Dado que los datos de Redis (principalmente instantáneas de Redis) se almacenan en el sistema de almacenamiento, incluso si el pod de Redis muere, los datos correspondientes no se perderán; porque cuando se implementa una máquina independiente de Redis en k8s y el pod de Redis muere, k8s reconstruir el pod correspondiente. Durante la reconstrucción, el PVC correspondiente se montará en el pod y se cargará la instantánea, de modo que los datos de Redis no se pierdan debido a que el pod se cuelgue;

1.3 Construir imagen de Redis

root@k8s-master01:~/k8s-data/dockerfile/web/magedu/redis# ll

total 1784

drwxr-xr-x 2 root root 4096 Jun 5 15:22 ./

drwxr-xr-x 11 root root 4096 Aug 9 2022 ../

-rw-r--r-- 1 root root 717 Jun 5 15:20 Dockerfile

-rwxr-xr-x 1 root root 235 Jun 5 15:21 build-command.sh*

-rw-r--r-- 1 root root 1740967 Jun 22 2021 redis-4.0.14.tar.gz

-rw-r--r-- 1 root root 58783 Jun 22 2021 redis.conf

-rwxr-xr-x 1 root root 84 Jun 5 15:21 run_redis.sh*

root@k8s-master01:~/k8s-data/dockerfile/web/magedu/redis# cat Dockerfile

#Redis Image

# 导入自定义centos基础镜像

FROM harbor.ik8s.cc/baseimages/magedu-centos-base:7.9.2009

# 添加redis源码包至/usr/local/src

ADD redis-4.0.14.tar.gz /usr/local/src

# 编译安装redis

RUN ln -sv /usr/local/src/redis-4.0.14 /usr/local/redis && cd /usr/local/redis && make && cp src/redis-cli /usr/sbin/ && cp src/redis-server /usr/sbin/ && mkdir -pv /data/redis-data

# 添加redis配置文件

ADD redis.conf /usr/local/redis/redis.conf

# 暴露redis服务端口

EXPOSE 6379

#ADD run_redis.sh /usr/local/redis/run_redis.sh

#CMD ["/usr/local/redis/run_redis.sh"]

# 添加启动脚本

ADD run_redis.sh /usr/local/redis/entrypoint.sh

# 启动redis

ENTRYPOINT ["/usr/local/redis/entrypoint.sh"]

root@k8s-master01:~/k8s-data/dockerfile/web/magedu/redis# cat build-command.sh

#!/bin/bash

TAG=$1

#docker build -t harbor.ik8s.cc/magedu/redis:${TAG} .

#sleep 3

#docker push harbor.ik8s.cc/magedu/redis:${TAG}

nerdctl build -t harbor.ik8s.cc/magedu/redis:${TAG} .

nerdctl push harbor.ik8s.cc/magedu/redis:${TAG}

root@k8s-master01:~/k8s-data/dockerfile/web/magedu/redis# cat run_redis.sh

#!/bin/bash

# Redis启动命令

/usr/sbin/redis-server /usr/local/redis/redis.conf

# 使用tail -f 在pod内部构建守护进程

tail -f /etc/hosts

root@k8s-master01:~/k8s-data/dockerfile/web/magedu/redis# grep -v '^#\|^$' redis.conf

bind 0.0.0.0

protected-mode yes

port 6379

tcp-backlog 511

timeout 0

tcp-keepalive 300

daemonize yes

supervised no

pidfile /var/run/redis_6379.pid

loglevel notice

logfile ""

databases 16

always-show-logo yes

save 900 1

save 5 1

save 300 10

save 60 10000

stop-writes-on-bgsave-error no

rdbcompression yes

rdbchecksum yes

dbfilename dump.rdb

dir /data/redis-data

slave-serve-stale-data yes

slave-read-only yes

repl-diskless-sync no

repl-diskless-sync-delay 5

repl-disable-tcp-nodelay no

slave-priority 100

requirepass 123456

lazyfree-lazy-eviction no

lazyfree-lazy-expire no

lazyfree-lazy-server-del no

slave-lazy-flush no

appendonly no

appendfilename "appendonly.aof"

appendfsync everysec

no-appendfsync-on-rewrite no

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb

aof-load-truncated yes

aof-use-rdb-preamble no

lua-time-limit 5000

slowlog-log-slower-than 10000

slowlog-max-len 128

latency-monitor-threshold 0

notify-keyspace-events ""

hash-max-ziplist-entries 512

hash-max-ziplist-value 64

list-max-ziplist-size -2

list-compress-depth 0

set-max-intset-entries 512

zset-max-ziplist-entries 128

zset-max-ziplist-value 64

hll-sparse-max-bytes 3000

activerehashing yes

client-output-buffer-limit normal 0 0 0

client-output-buffer-limit slave 256mb 64mb 60

client-output-buffer-limit pubsub 32mb 8mb 60

hz 10

aof-rewrite-incremental-fsync yes

root@k8s-master01:~/k8s-data/dockerfile/web/magedu/redis#

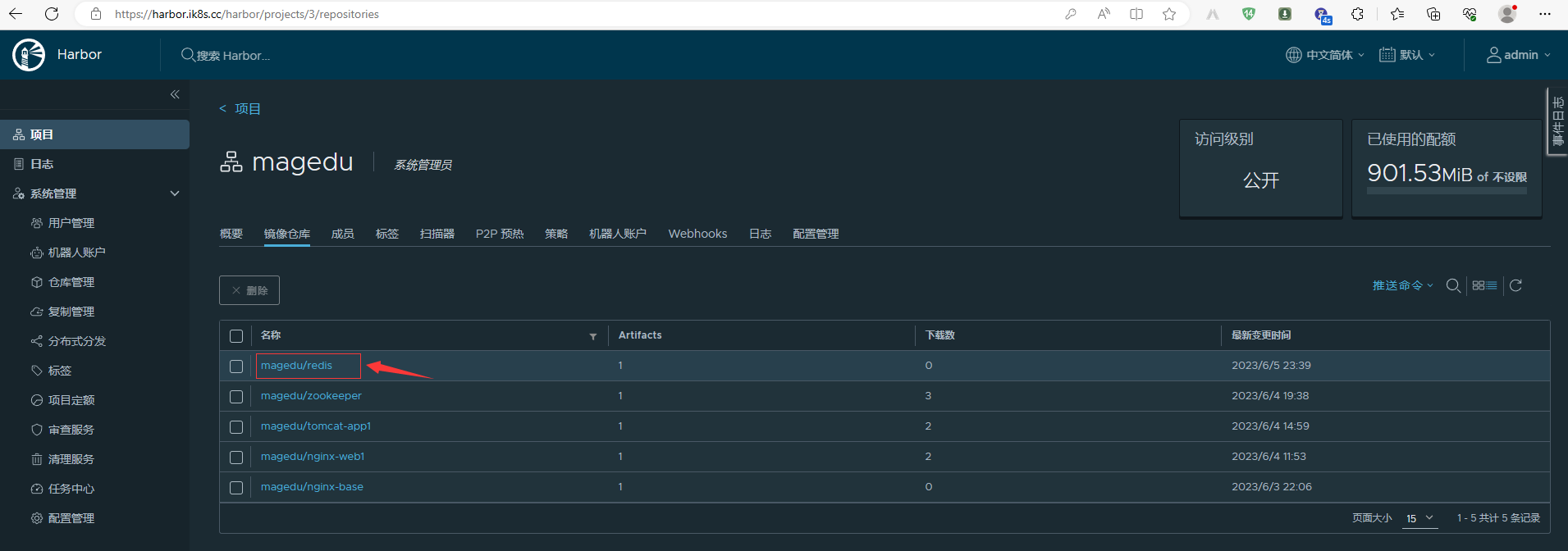

1.3.1 ¿Verificar si la imagen rdis está cargada en el puerto?

1.4 Probar la imagen de Redis

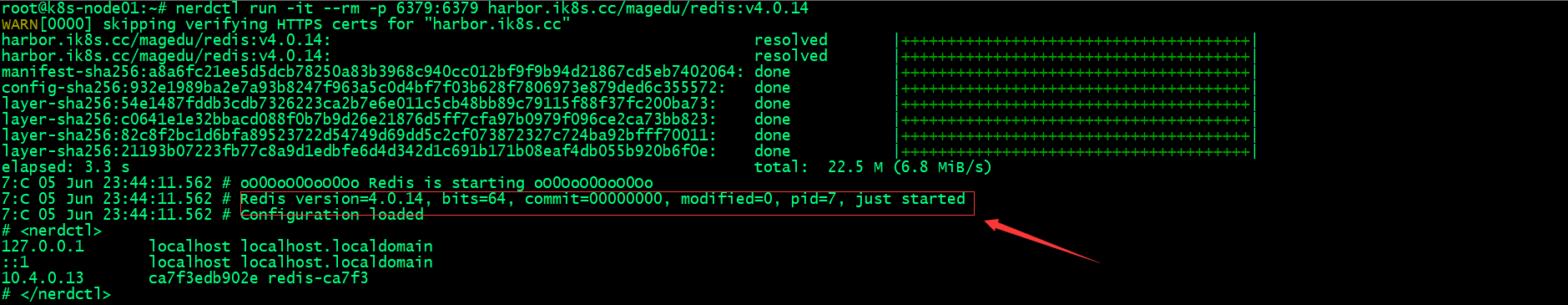

1.4.1 Verificar que la imagen de Redis se ejecute como contenedor para ver si se ejecuta normalmente.

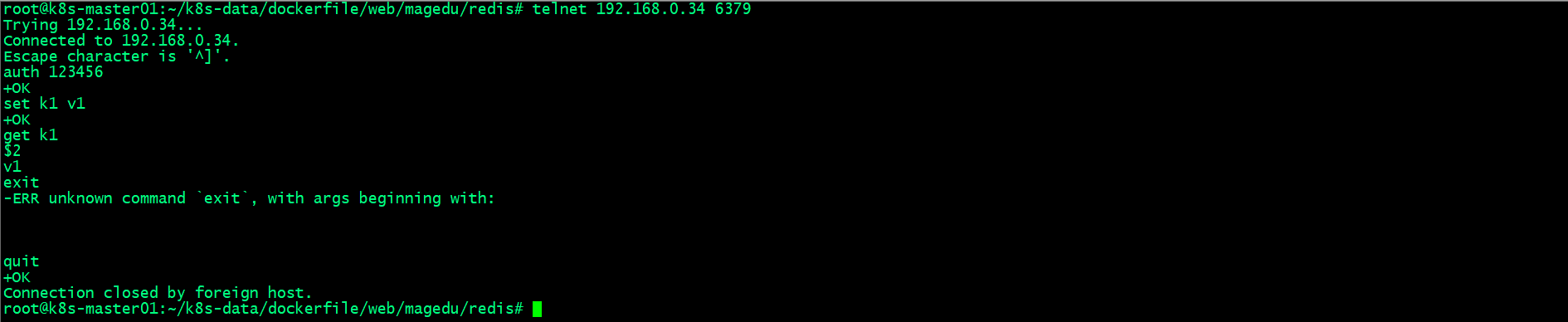

1.4.2 ¿Conectar Redis de forma remota para ver si la conexión puede ser normal?

Poder ejecutar la imagen de Redis como contenedor y poder conectarse a Redis a través de un host remoto para leer y escribir datos muestra que no hay ningún problema con la imagen de Reids que construimos;

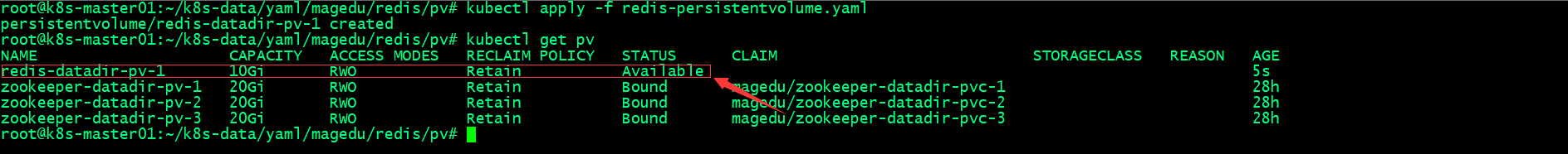

1.5 Crear fotovoltaico y PVC

1.5.1 Prepare el directorio de almacenamiento de datos de Redis en el servidor nfs

root@harbor:~# mkdir -pv /data/k8sdata/magedu/redis-datadir-1

mkdir: created directory '/data/k8sdata/magedu/redis-datadir-1'

root@harbor:~# cat /etc/exports

# /etc/exports: the access control list for filesystems which may be exported

# to NFS clients. See exports(5).

#

# Example for NFSv2 and NFSv3:

# /srv/homes hostname1(rw,sync,no_subtree_check) hostname2(ro,sync,no_subtree_check)

#

# Example for NFSv4:

# /srv/nfs4 gss/krb5i(rw,sync,fsid=0,crossmnt,no_subtree_check)

# /srv/nfs4/homes gss/krb5i(rw,sync,no_subtree_check)

#

/data/k8sdata/kuboard *(rw,no_root_squash)

/data/volumes *(rw,no_root_squash)

/pod-vol *(rw,no_root_squash)

/data/k8sdata/myserver *(rw,no_root_squash)

/data/k8sdata/mysite *(rw,no_root_squash)

/data/k8sdata/magedu/images *(rw,no_root_squash)

/data/k8sdata/magedu/static *(rw,no_root_squash)

/data/k8sdata/magedu/zookeeper-datadir-1 *(rw,no_root_squash)

/data/k8sdata/magedu/zookeeper-datadir-2 *(rw,no_root_squash)

/data/k8sdata/magedu/zookeeper-datadir-3 *(rw,no_root_squash)

/data/k8sdata/magedu/redis-datadir-1 *(rw,no_root_squash)

root@harbor:~# exportfs -av

exportfs: /etc/exports [1]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/kuboard".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [2]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/volumes".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [3]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/pod-vol".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [4]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/myserver".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [5]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/mysite".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [7]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/images".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [8]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/static".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [11]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/zookeeper-datadir-1".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [12]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/zookeeper-datadir-2".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [13]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/zookeeper-datadir-3".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [16]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/redis-datadir-1".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exporting *:/data/k8sdata/magedu/redis-datadir-1

exporting *:/data/k8sdata/magedu/zookeeper-datadir-3

exporting *:/data/k8sdata/magedu/zookeeper-datadir-2

exporting *:/data/k8sdata/magedu/zookeeper-datadir-1

exporting *:/data/k8sdata/magedu/static

exporting *:/data/k8sdata/magedu/images

exporting *:/data/k8sdata/mysite

exporting *:/data/k8sdata/myserver

exporting *:/pod-vol

exporting *:/data/volumes

exporting *:/data/k8sdata/kuboard

root@harbor:~# 1.5.2 Crear PV

root@k8s-master01:~/k8s-data/yaml/magedu/redis/pv# cat redis-persistentvolume.yaml

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: redis-datadir-pv-1

spec:

capacity:

storage: 10Gi

accessModes:

- ReadWriteOnce

nfs:

path: /data/k8sdata/magedu/redis-datadir-1

server: 192.168.0.42

root@k8s-master01:~/k8s-data/yaml/magedu/redis/pv#

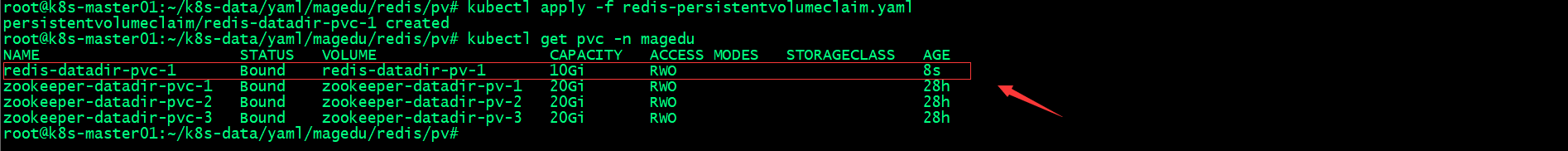

1.5.3 Crear PVC

root@k8s-master01:~/k8s-data/yaml/magedu/redis/pv# cat redis-persistentvolumeclaim.yaml

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: redis-datadir-pvc-1

namespace: magedu

spec:

volumeName: redis-datadir-pv-1

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 10Gi

root@k8s-master01:~/k8s-data/yaml/magedu/redis/pv#

1.6 Implementar el servicio Redis

root@k8s-master01:~/k8s-data/yaml/magedu/redis# cat redis.yaml

kind: Deployment

#apiVersion: extensions/v1beta1

apiVersion: apps/v1

metadata:

labels:

app: devops-redis

name: deploy-devops-redis

namespace: magedu

spec:

replicas: 1

selector:

matchLabels:

app: devops-redis

template:

metadata:

labels:

app: devops-redis

spec:

containers:

- name: redis-container

image: harbor.ik8s.cc/magedu/redis:v4.0.14

imagePullPolicy: Always

volumeMounts:

- mountPath: "/data/redis-data/"

name: redis-datadir

volumes:

- name: redis-datadir

persistentVolumeClaim:

claimName: redis-datadir-pvc-1

---

kind: Service

apiVersion: v1

metadata:

labels:

app: devops-redis

name: srv-devops-redis

namespace: magedu

spec:

type: NodePort

ports:

- name: http

port: 6379

targetPort: 6379

nodePort: 36379

selector:

app: devops-redis

sessionAffinity: ClientIP

sessionAffinityConfig:

clientIP:

timeoutSeconds: 10800

root@k8s-master01:~/k8s-data/yaml/magedu/redis#

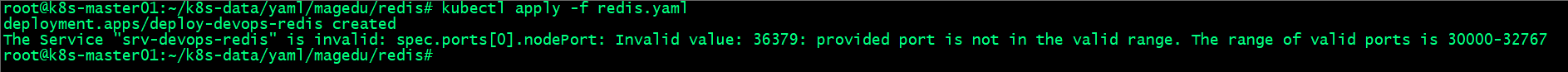

El informe de error anterior dice que nuestro puerto de servicio está fuera de rango. Esto se debe a que especificamos el rango de puerto de servicio al inicializar el clúster k8s;

1.6.1 Modificar el rango de puertos del puerto de nodo

Edite /etc/systemd/system/kube-apiserver.service y modifique el valor especificado por la opción --service-node-port-range; los otros dos nodos maestros también deben modificarse.

1.6.2 Vuelva a cargar kube-apiserver.service y reinicie kube-apiserver

root@k8s-master01:~# systemctl daemon-reload

root@k8s-master01:~# systemctl restart kube-apiserver.service

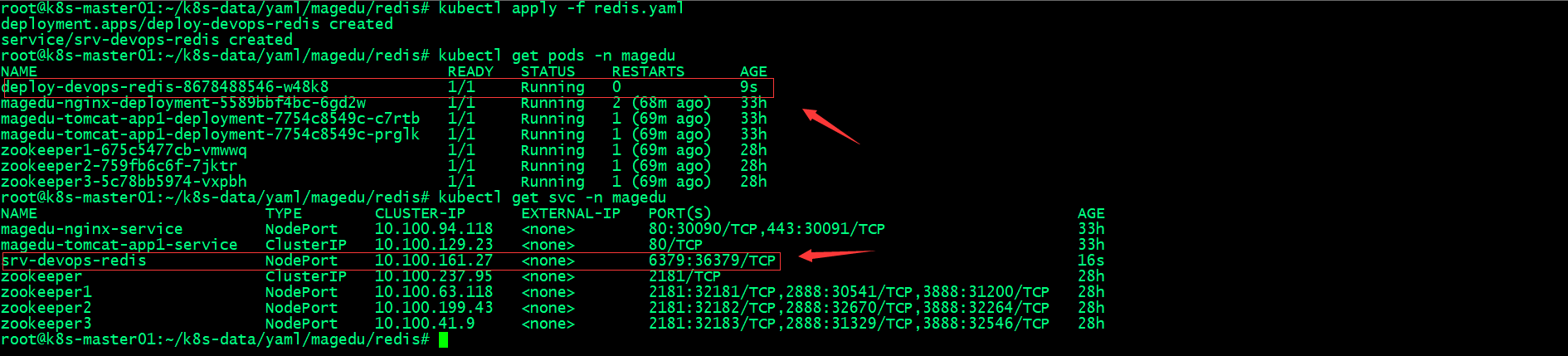

root@k8s-master01:~# Implementar redis nuevamente

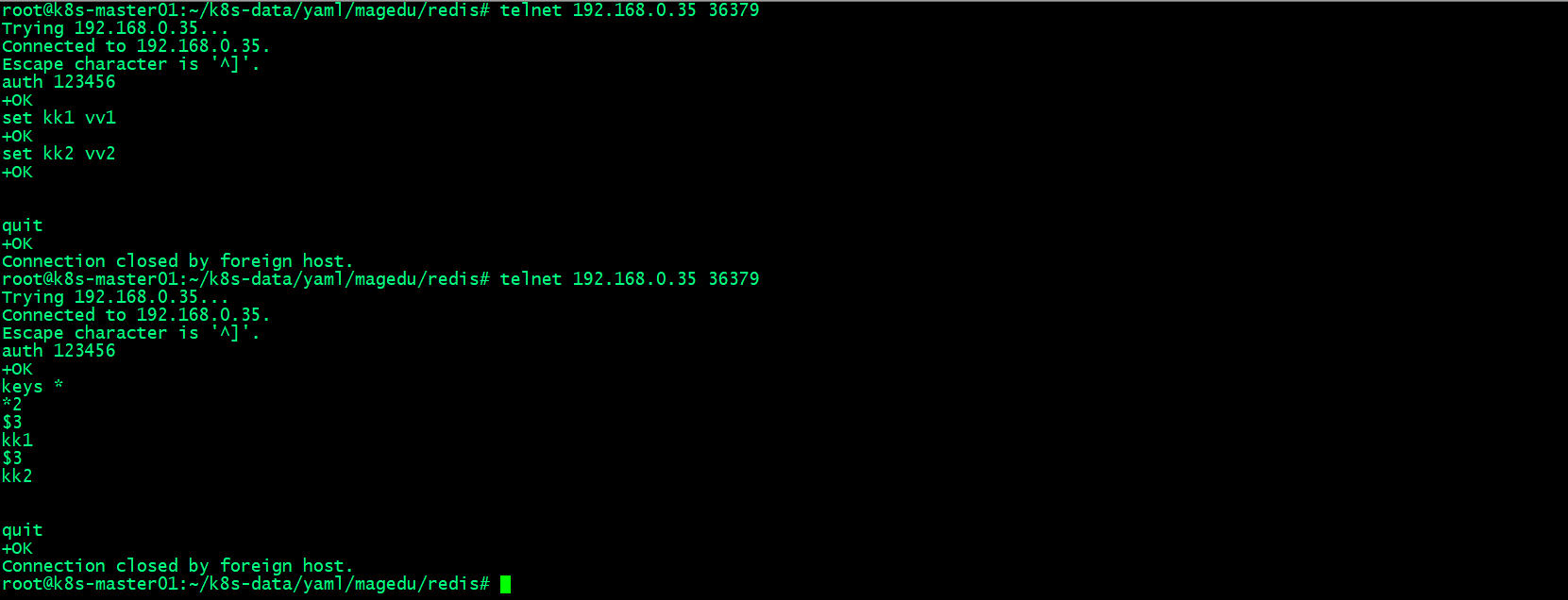

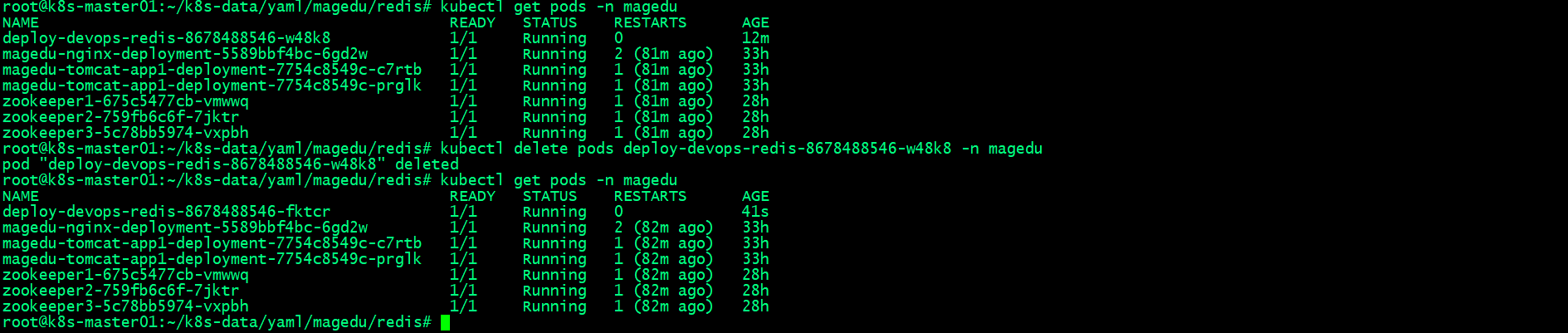

1.7 Verificar la lectura y escritura de datos de Redis

1.7.1 Conéctese al puerto 36376 de cualquier nodo k8s y pruebe redis para leer y escribir datos.

1.8 ¿Verificar si se pierden los datos correspondientes a la reconstrucción del pod de Redis?

1.8.1 ¿Verificar si el archivo de instantánea de Redis está almacenado en el almacenamiento?

root@harbor:~# ll /data/k8sdata/magedu/redis-datadir-1

total 12

drwxr-xr-x 2 root root 4096 Jun 5 16:29 ./

drwxr-xr-x 8 root root 4096 Jun 5 15:53 ../

-rw-r--r-- 1 root root 116 Jun 5 16:29 dump.rdb

root@harbor:~#

Puede ver que acabamos de escribir datos en redis y redis tomó una instantánea cuando encontró el cambio de clave dentro del tiempo especificado. Debido a que el directorio de datos de redis está montado mediante nfs a través de pv/pvc, podemos trabajar normalmente en el directorio correspondiente a nfs Vea este archivo de instantánea;

1.8.2 Elimine el pod de Redis y espere a que k8s lo reconstruya.

1.8.3 Verificar los datos del pod de Redis reconstruidos

Puede ver que el pod de Redis después de la reconstrucción de k8s aún conserva los datos del pod original, lo que muestra que el pvc del pod anterior se montó cuando se reconstruyó k8s;

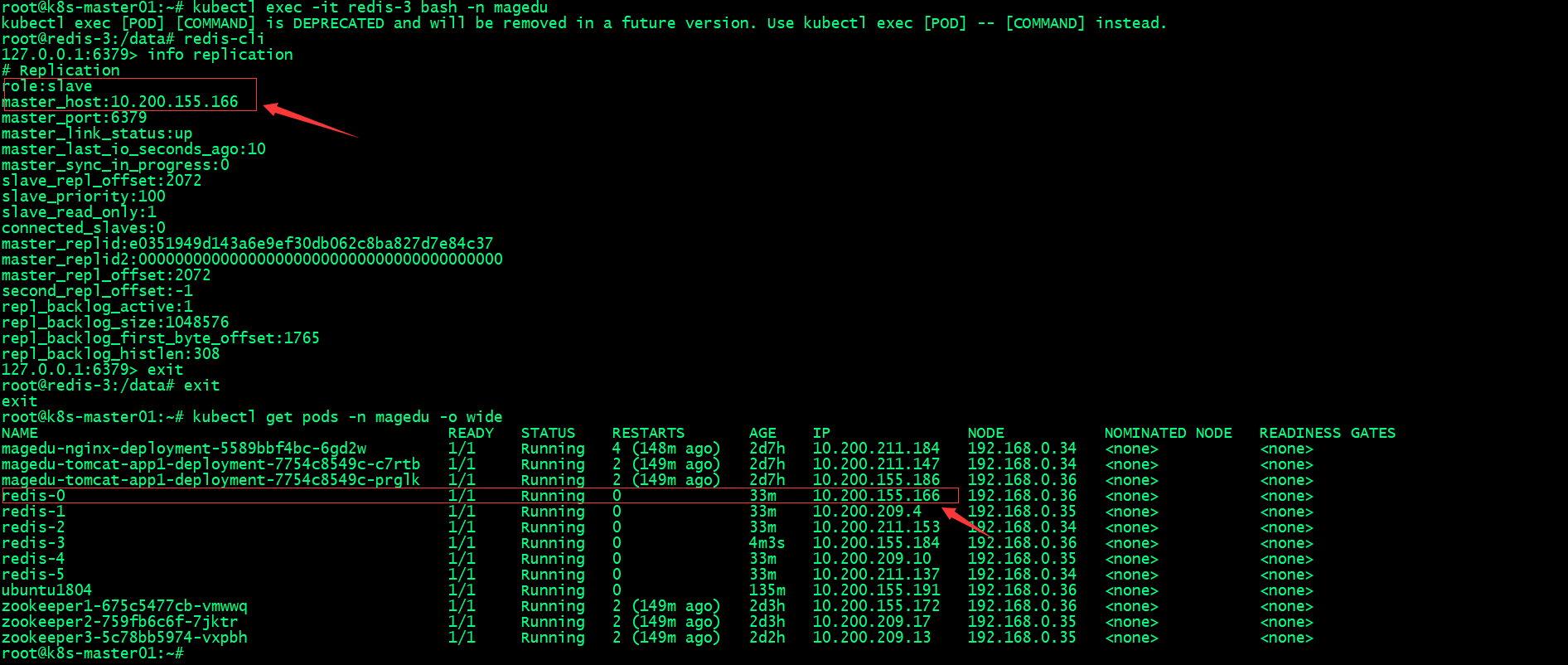

2. Implementar el clúster de Redis en k8

2.1, PV/PVC y Redis Cluster-StatefulSet

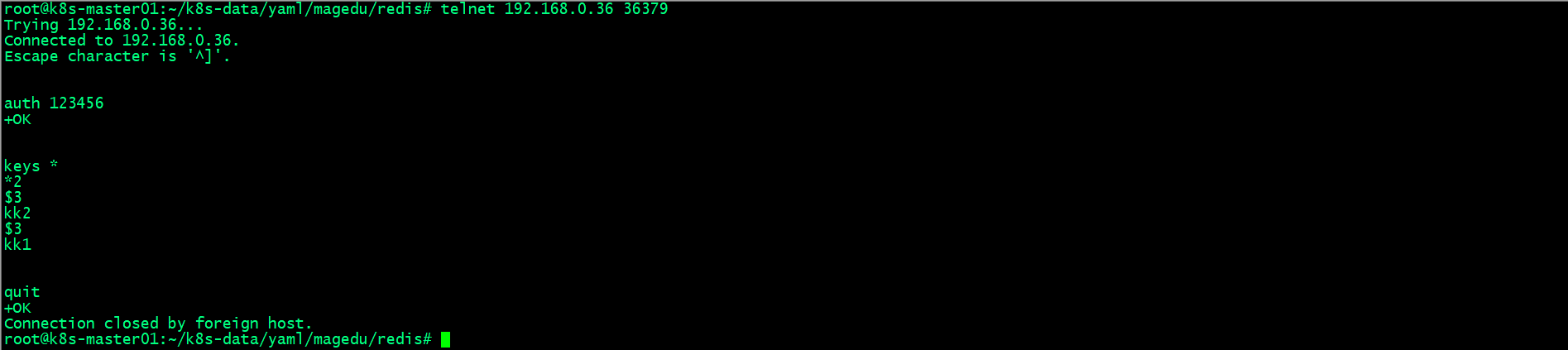

El clúster de Redis es un poco más complicado que la máquina independiente de Redis. También almacenamos los datos del clúster de Redis en el sistema de almacenamiento a través de pv/pvc. A diferencia de la máquina independiente de Redis, el clúster de Redis realizará el cálculo crc16 en los datos almacenados y luego tomará la módulo con 16384. Calcule y obtenga un número, que es una ranura almacenada en el clúster de Redis, es decir, el clúster de Redis distribuye uniformemente 16384 ranuras a todos los nodos maestros del clúster, y cada nodo maestro almacena parte de los datos completos del clúster; De esta manera Hay un problema. Si el maestro deja de funcionar, los datos en la ranura correspondiente no estarán disponibles. Para evitar que el maestro sea un único punto de falla, también debemos hacer que el maestro tenga alta disponibilidad, es decir , utilice un nodo esclavo para hacer una copia de seguridad del maestro. Si el maestro deja de funcionar, cuando la máquina esté fuera de línea, el esclavo correspondiente se hará cargo del maestro y continuará brindando servicios al clúster, logrando así una alta disponibilidad del maestro del clúster de Redis; Como se muestra en la figura anterior, usamos un clúster de Redis con 3 maestros y 3 esclavos, redis0, 1 y 2 son maestros, luego 3, 4 y 5 corresponden a los esclavos 0, 1 y 2, que son responsables del respaldo. recoger los datos de sus respectivos maestros; estos seis pods almacenan datos en el sistema de almacenamiento a través del pv/pvc del clúster k8s;

2.2 Crear PV

2.2.1 Prepare el directorio de datos del clúster de Redis en nfs

root@harbor:~# mkdir -pv /data/k8sdata/magedu/redis{0,1,2,3,4,5}

mkdir: created directory '/data/k8sdata/magedu/redis0'

mkdir: created directory '/data/k8sdata/magedu/redis1'

mkdir: created directory '/data/k8sdata/magedu/redis2'

mkdir: created directory '/data/k8sdata/magedu/redis3'

mkdir: created directory '/data/k8sdata/magedu/redis4'

mkdir: created directory '/data/k8sdata/magedu/redis5'

root@harbor:~# tail -6 /etc/exports

/data/k8sdata/magedu/redis0 *(rw,no_root_squash)

/data/k8sdata/magedu/redis1 *(rw,no_root_squash)

/data/k8sdata/magedu/redis2 *(rw,no_root_squash)

/data/k8sdata/magedu/redis3 *(rw,no_root_squash)

/data/k8sdata/magedu/redis4 *(rw,no_root_squash)

/data/k8sdata/magedu/redis5 *(rw,no_root_squash)

root@harbor:~# exportfs -av

exportfs: /etc/exports [1]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/kuboard".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [2]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/volumes".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [3]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/pod-vol".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [4]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/myserver".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [5]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/mysite".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [7]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/images".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [8]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/static".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [11]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/zookeeper-datadir-1".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [12]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/zookeeper-datadir-2".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [13]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/zookeeper-datadir-3".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [16]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/redis-datadir-1".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [18]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/redis0".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [19]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/redis1".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [20]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/redis2".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [21]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/redis3".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [22]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/redis4".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exportfs: /etc/exports [23]: Neither 'subtree_check' or 'no_subtree_check' specified for export "*:/data/k8sdata/magedu/redis5".

Assuming default behaviour ('no_subtree_check').

NOTE: this default has changed since nfs-utils version 1.0.x

exporting *:/data/k8sdata/magedu/redis5

exporting *:/data/k8sdata/magedu/redis4

exporting *:/data/k8sdata/magedu/redis3

exporting *:/data/k8sdata/magedu/redis2

exporting *:/data/k8sdata/magedu/redis1

exporting *:/data/k8sdata/magedu/redis0

exporting *:/data/k8sdata/magedu/redis-datadir-1

exporting *:/data/k8sdata/magedu/zookeeper-datadir-3

exporting *:/data/k8sdata/magedu/zookeeper-datadir-2

exporting *:/data/k8sdata/magedu/zookeeper-datadir-1

exporting *:/data/k8sdata/magedu/static

exporting *:/data/k8sdata/magedu/images

exporting *:/data/k8sdata/mysite

exporting *:/data/k8sdata/myserver

exporting *:/pod-vol

exporting *:/data/volumes

exporting *:/data/k8sdata/kuboard

root@harbor:~# 2.2.2 Crear PV

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# cat pv/redis-cluster-pv.yaml

apiVersion: v1

kind: PersistentVolume

metadata:

name: redis-cluster-pv0

spec:

capacity:

storage: 5Gi

accessModes:

- ReadWriteOnce

nfs:

server: 192.168.0.42

path: /data/k8sdata/magedu/redis0

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: redis-cluster-pv1

spec:

capacity:

storage: 5Gi

accessModes:

- ReadWriteOnce

nfs:

server: 192.168.0.42

path: /data/k8sdata/magedu/redis1

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: redis-cluster-pv2

spec:

capacity:

storage: 5Gi

accessModes:

- ReadWriteOnce

nfs:

server: 192.168.0.42

path: /data/k8sdata/magedu/redis2

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: redis-cluster-pv3

spec:

capacity:

storage: 5Gi

accessModes:

- ReadWriteOnce

nfs:

server: 192.168.0.42

path: /data/k8sdata/magedu/redis3

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: redis-cluster-pv4

spec:

capacity:

storage: 5Gi

accessModes:

- ReadWriteOnce

nfs:

server: 192.168.0.42

path: /data/k8sdata/magedu/redis4

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: redis-cluster-pv5

spec:

capacity:

storage: 5Gi

accessModes:

- ReadWriteOnce

nfs:

server: 192.168.0.42

path: /data/k8sdata/magedu/redis5

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster#

2.3 Implementar el clúster de Redis

2.3.1 Crear mapa de configuración basado en el archivo redis.conf

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# cat redis.conf

appendonly yes

cluster-enabled yes

cluster-config-file /var/lib/redis/nodes.conf

cluster-node-timeout 5000

dir /var/lib/redis

port 6379

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# 2.3.2 Crear mapa de configuración

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# kubectl create cm redis-conf --from-file=./redis.conf -n magedu

configmap/redis-conf created

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# kubectl get cm -n magedu

NAME DATA AGE

kube-root-ca.crt 1 35h

redis-conf 1 6s

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# 2.3.3 Verificar mapa de configuración

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# kubectl describe cm redis-conf -n magedu

Name: redis-conf

Namespace: magedu

Labels: <none>

Annotations: <none>

Data

====

redis.conf:

----

appendonly yes

cluster-enabled yes

cluster-config-file /var/lib/redis/nodes.conf

cluster-node-timeout 5000

dir /var/lib/redis

port 6379

BinaryData

====

Events: <none>

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster#2.3.4 Implementar el clúster de Redis

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# cat redis.yaml

apiVersion: v1

kind: Service

metadata:

name: redis

namespace: magedu

labels:

app: redis

spec:

selector:

app: redis

appCluster: redis-cluster

ports:

- name: redis

port: 6379

clusterIP: None

---

apiVersion: v1

kind: Service

metadata:

name: redis-access

namespace: magedu

labels:

app: redis

spec:

type: NodePort

selector:

app: redis

appCluster: redis-cluster

ports:

- name: redis-access

protocol: TCP

port: 6379

targetPort: 6379

nodePort: 36379

---

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: redis

namespace: magedu

spec:

serviceName: redis

replicas: 6

selector:

matchLabels:

app: redis

appCluster: redis-cluster

template:

metadata:

labels:

app: redis

appCluster: redis-cluster

spec:

terminationGracePeriodSeconds: 20

affinity:

podAntiAffinity:

preferredDuringSchedulingIgnoredDuringExecution:

- weight: 100

podAffinityTerm:

labelSelector:

matchExpressions:

- key: app

operator: In

values:

- redis

topologyKey: kubernetes.io/hostname

containers:

- name: redis

image: redis:4.0.14

command:

- "redis-server"

args:

- "/etc/redis/redis.conf"

- "--protected-mode"

- "no"

resources:

requests:

cpu: "500m"

memory: "500Mi"

ports:

- containerPort: 6379

name: redis

protocol: TCP

- containerPort: 16379

name: cluster

protocol: TCP

volumeMounts:

- name: conf

mountPath: /etc/redis

- name: data

mountPath: /var/lib/redis

volumes:

- name: conf

configMap:

name: redis-conf

items:

- key: redis.conf

path: redis.conf

volumeClaimTemplates:

- metadata:

name: data

namespace: magedu

spec:

accessModes: [ "ReadWriteOnce" ]

resources:

requests:

storage: 5Gi

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster#

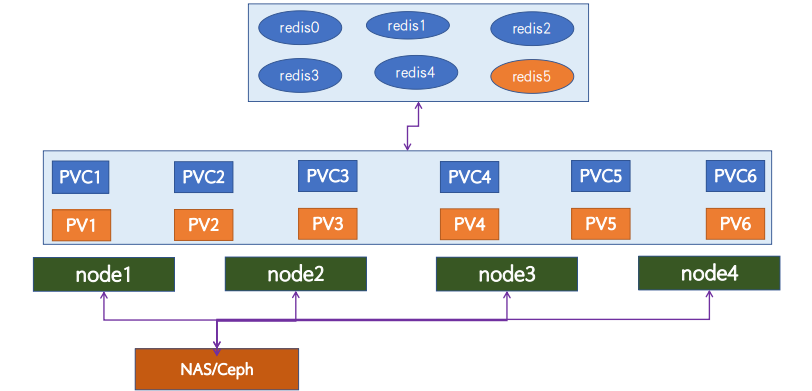

La lista de configuración anterior usa principalmente el controlador sts para crear 6 copias de pod. Cada copia usa el archivo de configuración en el mapa de configuración como archivo de configuración de redis, usa la plantilla de pvc para especificar el pod para asociar automáticamente el pv en k8 y crea el pvc. en el espacio de nombres magedu., es decir, siempre que haya pv libre en k8s, el pod correspondiente creará un pvc de acuerdo con la información de la plantilla de pvc en el espacio de nombres de magedu; por supuesto, podemos usar la clase de almacenamiento para automáticamente cree el pvc, o podemos crear el pvc con anticipación. Generalmente, usamos el controlador sts, podemos usar la plantilla de pvc para especificar pod para crear pvc automáticamente (siempre que k8s tenga suficiente pv disponible);

Aplicar la lista de configuración para implementar el clúster de Redis

Utilice el controlador sts para crear un pod. El nombre del pod es el nombre-id del controlador sts. El nombre del pvc creado usando la plantilla de pvc es el nombre de la plantilla de pvc-nombre del pod, es decir, el nombre de la plantilla de pvc-sts. nombre-id del controlador;

2.4 Inicializar el clúster de Redis

2.4.1 Cree un contenedor temporal en k8s e instale la herramienta de inicialización del clúster redis

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# kubectl run -it ubuntu1804 --image=ubuntu:18.04 --restart=Never -n magedu bash

If you don't see a command prompt, try pressing enter.

root@ubuntu1804:/#

root@ubuntu1804:/# apt update

# 安装必要工具

root@ubuntu1804:/# apt install python2.7 python-pip redis-tools dnsutils iputils-ping net-tools

# 更新pip

root@ubuntu1804:/# pip install --upgrade pip

# 使用pip安装redis cluster初始化工具redis-trib

root@ubuntu1804:/# pip install redis-trib==0.5.1

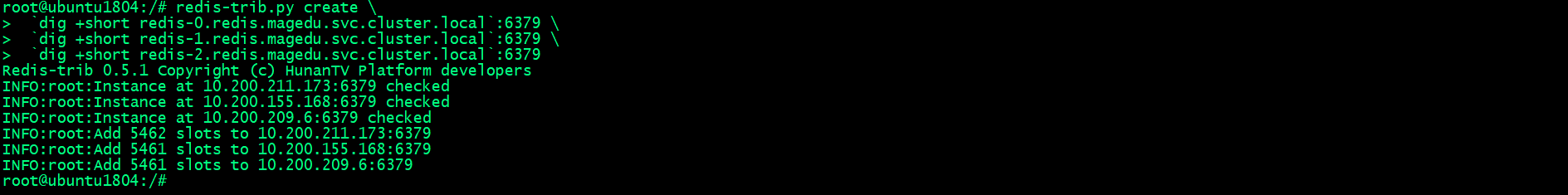

root@ubuntu1804:/#2.4.2 Inicializar el clúster de Redis

root@ubuntu1804:/# redis-trib.py create \

`dig +short redis-0.redis.magedu.svc.cluster.local`:6379 \

`dig +short redis-1.redis.magedu.svc.cluster.local`:6379 \

`dig +short redis-2.redis.magedu.svc.cluster.local`:6379

En k8s, usamos sts para crear pods. El nombre del pod correspondiente es fijo, por lo que cuando inicializamos el clúster de redis, podemos usar directamente el nombre del pod de redis para resolver directamente la dirección IP del pod correspondiente; inicializar redis en una máquina virtual tradicional o una máquina física Para el clúster, podemos usar la dirección IP directamente, la razón es que la dirección IP de la máquina física o la máquina virtual es fija, pero la dirección IP del pod en k8s no es fija;

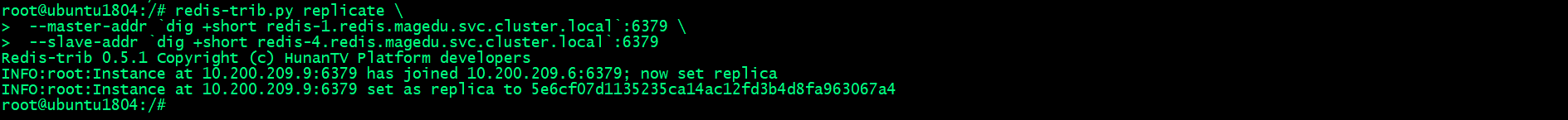

2.4.3 Especificar esclavo para maestro

-

Especifique esclavo como redis-3 para redis-0

root@ubuntu1804:/# redis-trib.py replicate \

--master-addr `dig +short redis-0.redis.magedu.svc.cluster.local`:6379 \

--slave-addr `dig +short redis-3.redis.magedu.svc.cluster.local`:6379

-

Especifique esclavo como redis-4 para redis-1

root@ubuntu1804:/# redis-trib.py replicate \

--master-addr `dig +short redis-1.redis.magedu.svc.cluster.local`:6379 \

--slave-addr `dig +short redis-4.redis.magedu.svc.cluster.local`:6379

-

Especifique el esclavo como redis-5 para redis-2

root@ubuntu1804:/# redis-trib.py replicate \

--master-addr `dig +short redis-2.redis.magedu.svc.cluster.local`:6379 \

--slave-addr `dig +short redis-5.redis.magedu.svc.cluster.local`:6379

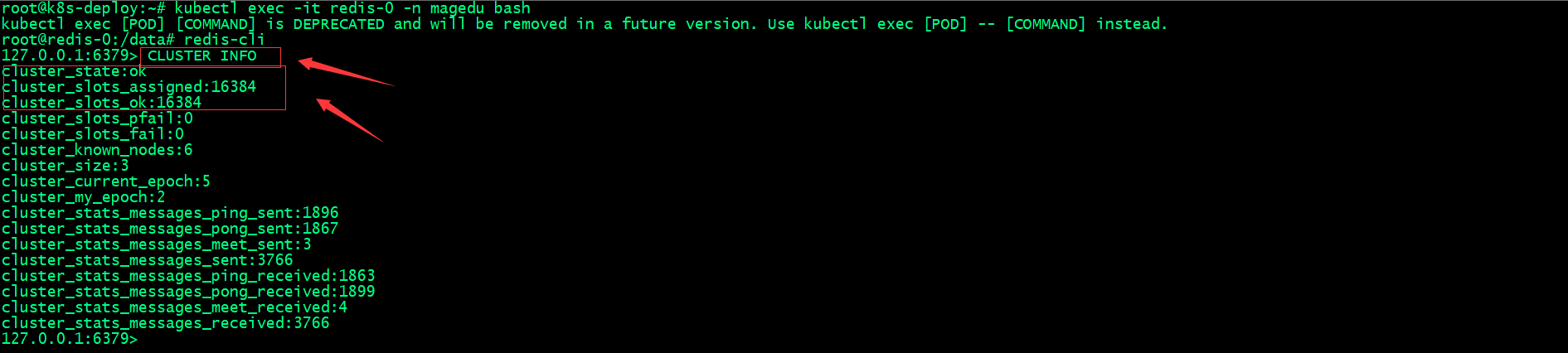

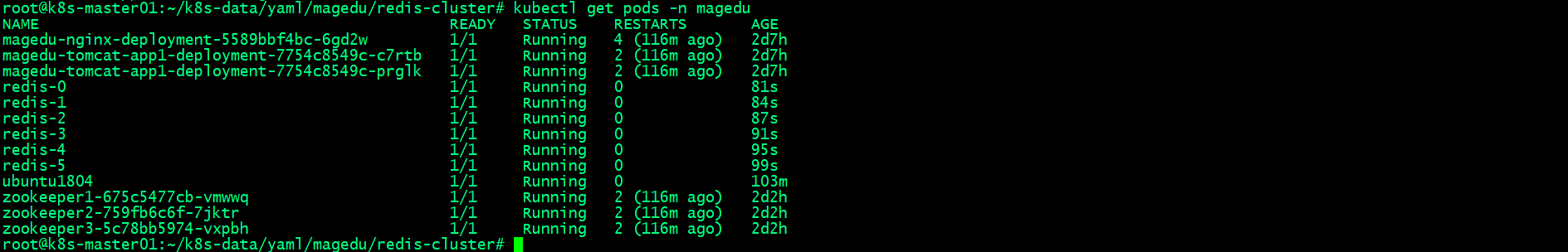

2.5 Verificar el estado del clúster de Redis

2.5.1 Ingrese cualquier pod en el clúster de Redis para ver la información del clúster

2.5.2 Ver nodos del clúster

La información del nodo del clúster registra la identificación del nodo maestro y la identificación del esclavo, donde el esclavo corresponderá a la identificación del maestro, lo que indica que la copia de seguridad del esclavo corresponde a los datos del maestro;

2.5.3 Ver información del nodo actual

127.0.0.1:6379> info

# Server

redis_version:4.0.14

redis_git_sha1:00000000

redis_git_dirty:0

redis_build_id:165c932261a105d7

redis_mode:cluster

os:Linux 5.15.0-73-generic x86_64

arch_bits:64

multiplexing_api:epoll

atomicvar_api:atomic-builtin

gcc_version:8.3.0

process_id:1

run_id:aa8ef00d843b4f622374dbb643cf27cdbd4d5ba3

tcp_port:6379

uptime_in_seconds:4303

uptime_in_days:0

hz:10

lru_clock:8272053

executable:/data/redis-server

config_file:/etc/redis/redis.conf

# Clients

connected_clients:1

client_longest_output_list:0

client_biggest_input_buf:0

blocked_clients:0

# Memory

used_memory:2642336

used_memory_human:2.52M

used_memory_rss:5353472

used_memory_rss_human:5.11M

used_memory_peak:2682248

used_memory_peak_human:2.56M

used_memory_peak_perc:98.51%

used_memory_overhead:2559936

used_memory_startup:1444856

used_memory_dataset:82400

used_memory_dataset_perc:6.88%

total_system_memory:16740012032

total_system_memory_human:15.59G

used_memory_lua:37888

used_memory_lua_human:37.00K

maxmemory:0

maxmemory_human:0B

maxmemory_policy:noeviction

mem_fragmentation_ratio:2.03

mem_allocator:jemalloc-4.0.3

active_defrag_running:0

lazyfree_pending_objects:0

# Persistence

loading:0

rdb_changes_since_last_save:0

rdb_bgsave_in_progress:0

rdb_last_save_time:1685992849

rdb_last_bgsave_status:ok

rdb_last_bgsave_time_sec:0

rdb_current_bgsave_time_sec:-1

rdb_last_cow_size:245760

aof_enabled:1

aof_rewrite_in_progress:0

aof_rewrite_scheduled:0

aof_last_rewrite_time_sec:-1

aof_current_rewrite_time_sec:-1

aof_last_bgrewrite_status:ok

aof_last_write_status:ok

aof_last_cow_size:0

aof_current_size:0

aof_base_size:0

aof_pending_rewrite:0

aof_buffer_length:0

aof_rewrite_buffer_length:0

aof_pending_bio_fsync:0

aof_delayed_fsync:0

# Stats

total_connections_received:7

total_commands_processed:17223

instantaneous_ops_per_sec:1

total_net_input_bytes:1530962

total_net_output_bytes:108793

instantaneous_input_kbps:0.04

instantaneous_output_kbps:0.00

rejected_connections:0

sync_full:1

sync_partial_ok:0

sync_partial_err:1

expired_keys:0

expired_stale_perc:0.00

expired_time_cap_reached_count:0

evicted_keys:0

keyspace_hits:0

keyspace_misses:0

pubsub_channels:0

pubsub_patterns:0

latest_fork_usec:853

migrate_cached_sockets:0

slave_expires_tracked_keys:0

active_defrag_hits:0

active_defrag_misses:0

active_defrag_key_hits:0

active_defrag_key_misses:0

# Replication

role:master

connected_slaves:1

slave0:ip=10.200.155.175,port=6379,state=online,offset=1120,lag=1

master_replid:60381a28fee40b44c409e53eeef49215a9d3b0ff

master_replid2:0000000000000000000000000000000000000000

master_repl_offset:1120

second_repl_offset:-1

repl_backlog_active:1

repl_backlog_size:1048576

repl_backlog_first_byte_offset:1

repl_backlog_histlen:1120

# CPU

used_cpu_sys:12.50

used_cpu_user:7.51

used_cpu_sys_children:0.01

used_cpu_user_children:0.00

# Cluster

cluster_enabled:1

# Keyspace

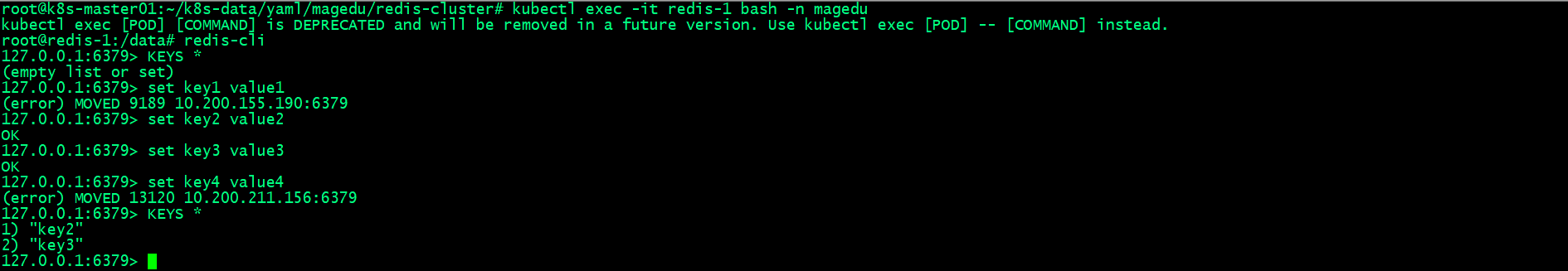

127.0.0.1:6379> 2.5.4 ¿Verificar si el clúster de Redis lee y escribe datos normalmente?

2.5.4.1 Conéctese manualmente al clúster de Redis para leer y escribir datos

Conéctese manualmente al nodo maestro del clúster de Redis para leer y escribir datos. Existe el problema de que cuando la clave que escribimos se calcula en módulo 16384 mediante crc16, es posible que la ranura correspondiente no esté en el nodo actual. Redis nos dirá dónde escribir el clave. ;Como puede ver en la captura de pantalla anterior, el clúster de Redis ahora puede leer y escribir datos normalmente.

2.5.4.2 Utilice una secuencia de comandos de Python para conectarse al clúster de Redis para leer y escribir datos

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# cat redis-client-test.py

#!/usr/bin/env python

#coding:utf-8

#Author:Zhang ShiJie

#python 2.7/3.8

#pip install redis-py-cluster

import sys,time

from rediscluster import RedisCluster

def init_redis():

startup_nodes = [

{'host': '192.168.0.34', 'port': 36379},

{'host': '192.168.0.35', 'port': 36379},

{'host': '192.168.0.36', 'port': 36379},

{'host': '192.168.0.34', 'port': 36379},

{'host': '192.168.0.35', 'port': 36379},

{'host': '192.168.0.36', 'port': 36379},

]

try:

conn = RedisCluster(startup_nodes=startup_nodes,

# 有密码要加上密码哦

decode_responses=True, password='')

print('连接成功!!!!!1', conn)

#conn.set("key-cluster","value-cluster")

for i in range(100):

conn.set("key%s" % i, "value%s" % i)

time.sleep(0.1)

data = conn.get("key%s" % i)

print(data)

#return conn

except Exception as e:

print("connect error ", str(e))

sys.exit(1)

init_redis()

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# Ejecute el script y escriba datos en el clúster de Redis

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# python redis-client-test.py

Traceback (most recent call last):

File "/root/k8s-data/yaml/magedu/redis-cluster/redis-client-test.py", line 8, in <module>

from rediscluster import RedisCluster

ModuleNotFoundError: No module named 'rediscluster'

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster#Aquí se le indica que no se encuentra el módulo rediscluster, la solución es instalar el módulo redis-py-cluster a través de pip;

Instalar el módulo redis-py-cluster

Ejecute el script para conectarse al clúster de Redis para lectura y escritura de datos.

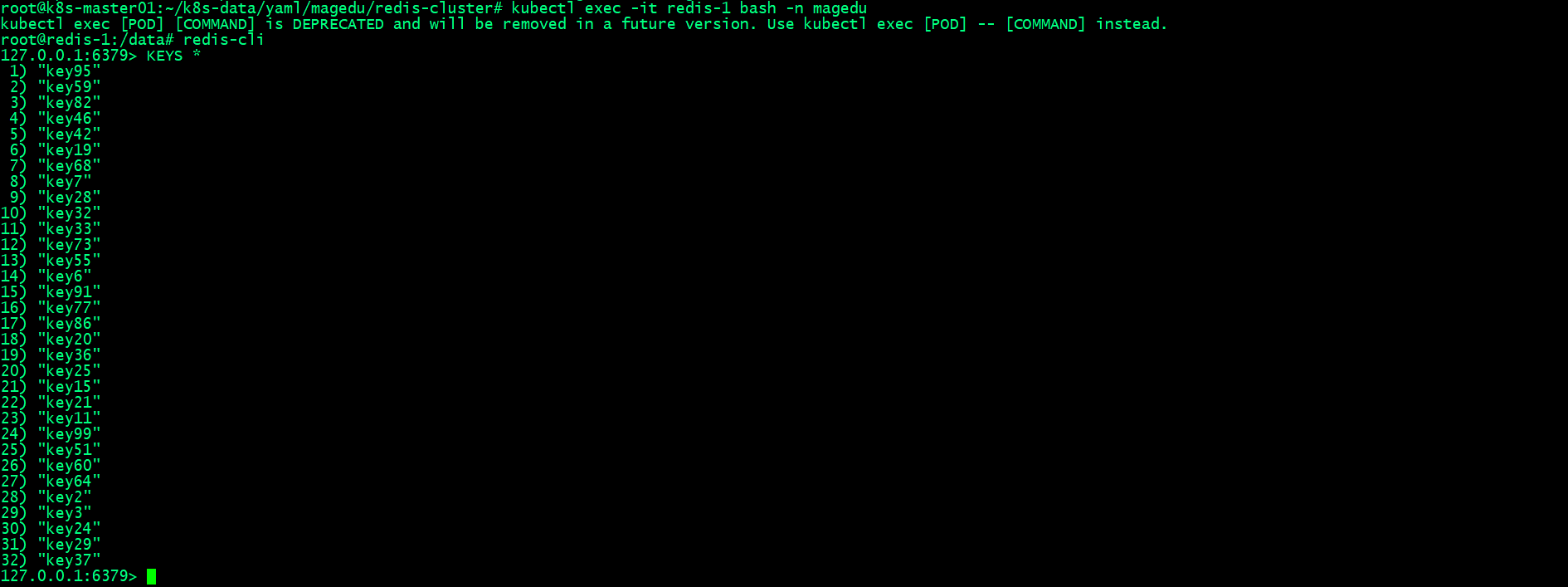

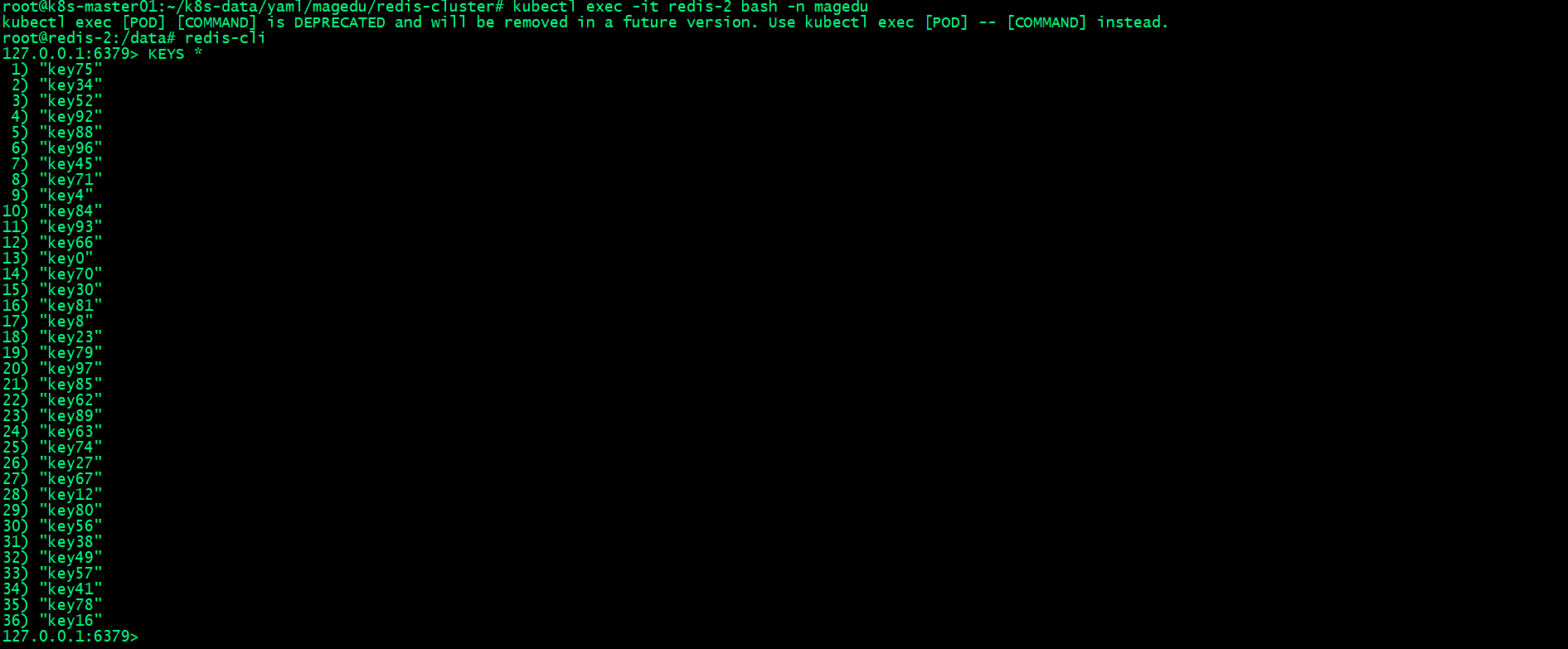

¿Conéctese al pod de Redis y verifique si los datos se escriben normalmente?

En la captura de pantalla anterior, podemos ver que cada uno de los tres pods maestros del clúster Reids almacena parte de la clave, no toda; significa que simplemente usamos un script de Python para escribir los datos en el clúster Redis normalmente;

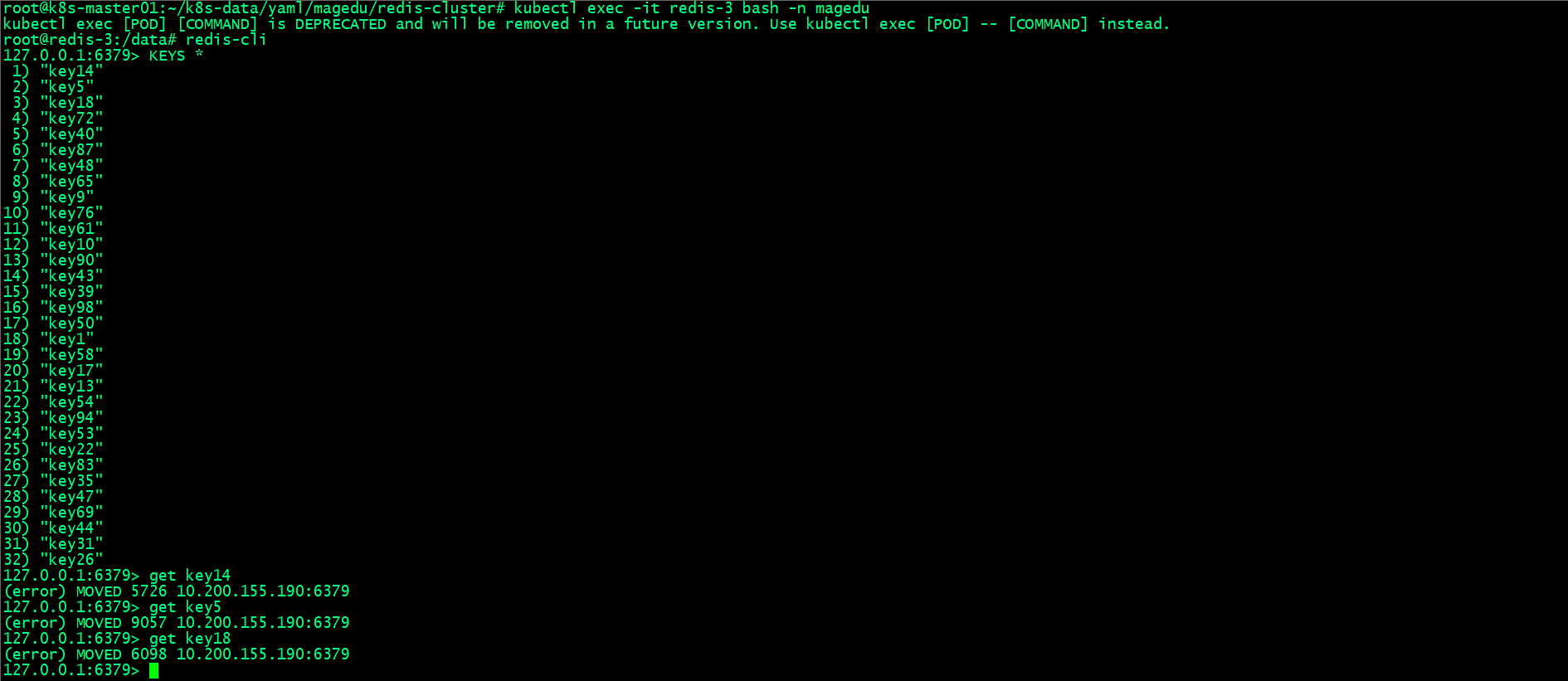

¿Verificar que el nodo esclavo esté disponible para leer datos normalmente?

De la captura de pantalla anterior, podemos entender que los datos no se pueden leer en el nodo esclavo;

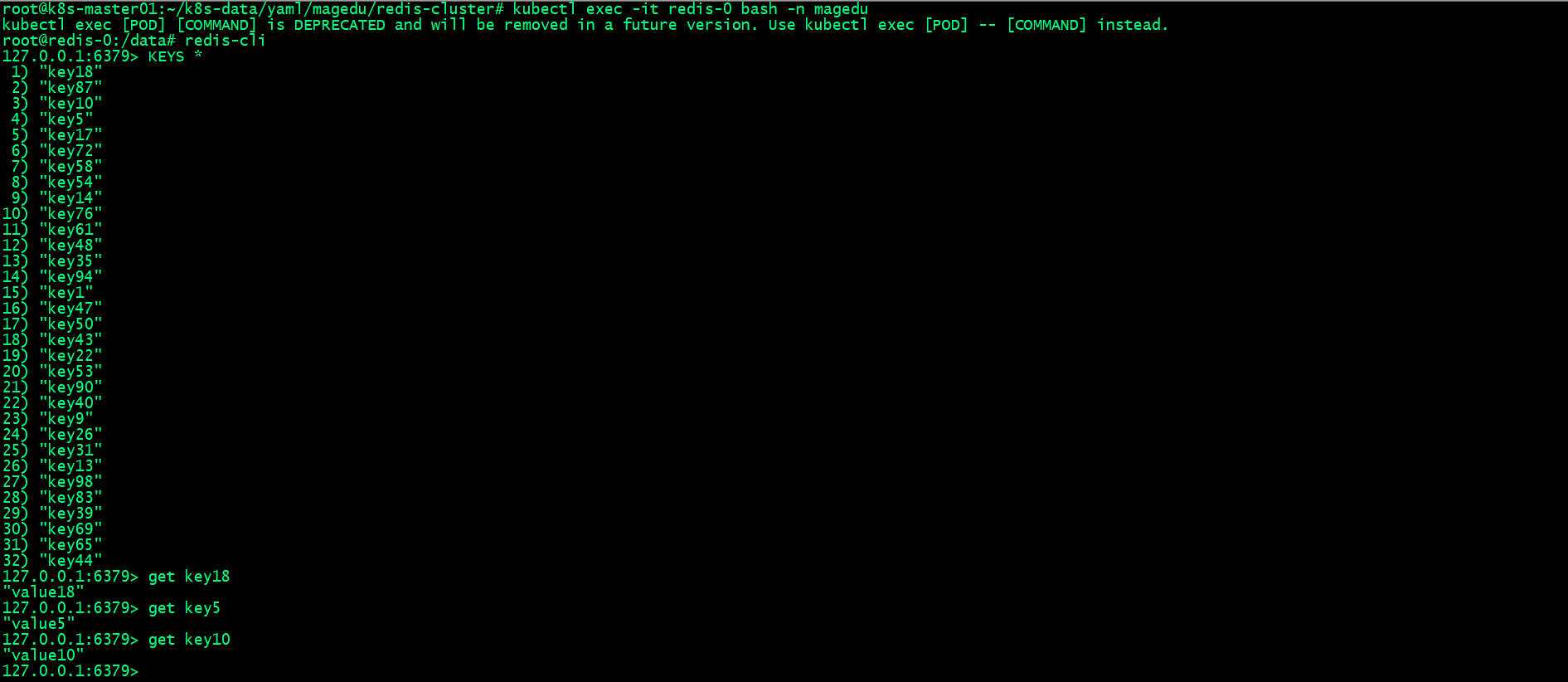

Leer datos del nodo maestro correspondiente al esclavo

La verificación anterior muestra que solo el maestro en el clúster de Redis puede leer y escribir datos, y el esclavo solo realiza una copia de seguridad de los datos maestros y no puede leer ni escribir datos en el esclavo;

2.6 Verificar la alta disponibilidad del clúster redis

2.6.1 Cargue la imagen redis:4.0.14 en el puerto local en el nodo k8s.

-

Modificar etiqueta de imagen

root@k8s-node01:~# nerdctl tag redis:4.0.14 harbor.ik8s.cc/redis-cluster/redis:4.0.14-

Sube la imagen de Redis al puerto local.

root@k8s-node01:~# nerdctl push harbor.ik8s.cc/redis-cluster/redis:4.0.14

INFO[0000] pushing as a reduced-platform image (application/vnd.docker.distribution.manifest.list.v2+json, sha256:1ae9e0f790001af4b9f83a2b3d79c593c6f3e9a881b754a99527536259fb6625)

WARN[0000] skipping verifying HTTPS certs for "harbor.ik8s.cc"

index-sha256:1ae9e0f790001af4b9f83a2b3d79c593c6f3e9a881b754a99527536259fb6625: done |++++++++++++++++++++++++++++++++++++++|

manifest-sha256:5bd4fe08813b057df2ae55003a75c39d80a4aea9f1a0fbc0fbd7024edf555786: done |++++++++++++++++++++++++++++++++++++++|

config-sha256:191c4017dcdd3370f871a4c6e7e1d55c7d9abed2bebf3005fb3e7d12161262b8: done |++++++++++++++++++++++++++++++++++++++|

elapsed: 1.4 s total: 8.5 Ki (6.1 KiB/s)

root@k8s-node01:~# 2.6.2 Modificar la imagen de la lista de implementación del clúster de Redis y la estrategia de extracción de imágenes

Nos resulta conveniente modificar la imagen a una imagen del puerto local y una estrategia de extracción para probar la alta disponibilidad del clúster de Redis;

2.6.3 Volver a aplicar la lista de implementación del clúster de Redis

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# kubectl apply -f redis.yaml

service/redis unchanged

service/redis-access unchanged

statefulset.apps/redis configured

root@k8s-master01:~/k8s-data/yaml/magedu/redis-cluster# Esto equivale a actualizar el clúster de Redis. La relación de clúster entre ellos aún existe porque la configuración de la relación del clúster se guarda en el almacenamiento remoto;

-

¿Verificar que todos los pods estén funcionando normalmente?

-

Verificar el estado del clúster y las relaciones del clúster

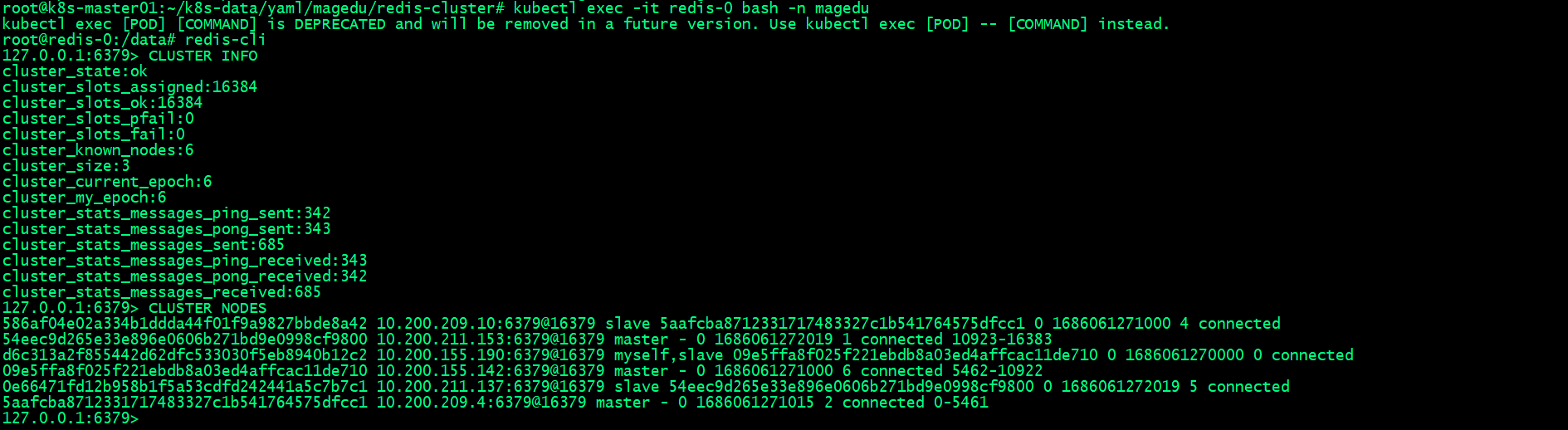

A diferencia de antes, aquí rdis-0 se ha convertido en esclavo y redis-3 se ha convertido en maestro; en la captura de pantalla anterior, también encontramos que después de implementar el pod de clúster de redis en k8 y reconstruirlo (la dirección IP cambia), la relación de clúster correspondiente se restablecerá. no cambia. Los cambios ocurren; la relación correspondiente entre el maestro y el ungüento siempre se cambia entre el maestro correspondiente y las cápsulas de ungüento. Esto en realidad es alta disponibilidad;

2.6.4 ¿Detener el puerto local, eliminar el pod maestro de Redis y ver si el esclavo correspondiente será promovido a maestro?

-

Detener el servicio portuario

root@harbor:~# systemctl stop harbor

-

¿Eliminar redis-3 y ver si redis-0 será promovido a maestro?

Puede ver que después de que eliminamos redis-3 (equivalente al tiempo de inactividad del maestro), el esclavo correspondiente fue promovido a maestro;

2.6.5 ¿Restaurar el servicio portuario y ver si sigue siendo el esclavo de redis-0 después de la reunión de reanudación de redis-3 correspondiente?

-

Restaurar el servicio portuario

-

¿Verificar si redis-3pod está restaurado?

Después de eliminar redis-3 nuevamente, el pod correspondiente se reconstruye normalmente y está en estado de ejecución;

-

Verifique la relación maestro-esclavo de redis-3 ,

Puede ver que después de restaurar redis-3, se une automáticamente al clúster y se convierte en esclavo de redis-0;

El artículo está reproducido de: Linux-1874

Enlace original: https://www.cnblogs.com/qiuhom-1874/p/17459116.html