Este artículo abre una nueva dirección de investigación sobre la segmentación de instancias en condiciones de poca luz. Es el primer documento que establece sistemáticamente un marco de verificación de capacitación y pruebas, por ejemplo, segmentación en condiciones de poca luz.

Tema: Segmentación de instancias en la oscuridad

Unidad: Instituto de Tecnología de Beijing y Princeton

Autor: Linwei Chen · Ying Fu · Kaixuan Wei · Dezhi Zheng · Felix Heide

Enlace del artículo:

https://arxiv.org/abs/2304.14298

https://link.springer.com/article/10.1007/s11263-023-01808-8

Enlace de código:

GitHub - Linwei-Chen/LIS: Segmentación de instancias IJCV2023 en la oscuridad

Cita:

@article{2023lis,

title={Instance Segmentation in the Dark},

author={Chen, Linwei and Fu, Ying and Wei, Kaixuan and Zheng, Dezhi and Heide, Felix},

journal={International Journal of Computer Vision},

volume={131},

number={8},

pages={2198--2218},

year={2023},

publisher={Springer}

}

Este artículo abre una nueva dirección de investigación sobre la segmentación de instancias en condiciones de poca luz. Es el primer artículo que establece sistemáticamente un marco de verificación de capacitación y pruebas, por ejemplo, segmentación en condiciones de poca luz ( énfasis agregado, ¡puede ser una nueva dirección para el volumen! ).

Este documento recopila y produce un conjunto de datos de segmentación de instancias con poca luz (LIS), que incluye cuatro conjuntos de datos de poca luz, exposición normal, JPEG y RAW emparejados, y proporciona 8 tipos de anotaciones de píxeles de instancia, que se pueden usar, por ejemplo. segmentación, tarea de detección de objetivos. (¡ Nuevo conjunto de datos! )

Este artículo observa que las imágenes RAW tienen un mejor potencial que las imágenes JPEG para lograr una mayor precisión de segmentación de instancias, y el autor analiza además que esto está relacionado con el hecho de que RAW puede proporcionar más información de profundidad de bits (¡RAW es todo lo que necesita! ) .

Este artículo observa que en condiciones de luz oscura, el ruido de la imagen provocará perturbaciones de alta frecuencia en las características de las redes neuronales profundas, lo cual es una razón importante por la que los métodos de segmentación de instancias existentes funcionan mal en condiciones de luz oscura (¡el ruido es la clave! ) .

¿Cómo es el efecto? Utilizando el marco del método de este artículo, basado en los resultados de Mask R-CNN-ResNet50, en comparación con el modelo grande Segment Anything entrenado con una gran cantidad de datos, el método propuesto en este artículo aún funciona bien.

Las técnicas de segmentación de instancias existentes apuntan principalmente a la entrada de imágenes de alta calidad en condiciones de iluminación normal, pero su rendimiento disminuye significativamente en entornos con iluminación extremadamente baja. En este trabajo, profundizamos en la segmentación de instancias en condiciones de poca luz e introducimos varias técnicas que mejoran significativamente la precisión de la inferencia en condiciones de poca luz. El método propuesto se basa en la observación de que el ruido en imágenes con poca luz introduce interferencias de alta frecuencia en los mapas de características de las redes neuronales, lo que degrada significativamente el rendimiento. Para suprimir este "ruido de características", proponemos un método de aprendizaje novedoso que se basa en capas de reducción de resolución ponderada adaptativa, bloques de convolución direccionales suaves y aprendizaje de supresión de interferencias. Estos componentes reducen eficazmente el ruido de las características durante las operaciones de reducción de resolución y convolución, lo que permite que el modelo aprenda características resistentes a las perturbaciones. Además, descubrimos que las imágenes RAW de alta profundidad de bits retienen mejor información de escena más rica en condiciones de poca luz que la salida sRGB típica de una cámara, lo que admite el uso de algoritmos de entrada RAW. Nuestro análisis muestra que una alta profundidad de bits es crucial para la segmentación de instancias con poca luz. Para aliviar la escasez de conjuntos de datos RAW anotados, utilizamos un proceso de composición RAW con poca luz para generar datos realistas con poca luz. Además, para facilitar una mayor investigación en esta dirección, capturamos un conjunto de datos de segmentación de instancias con poca luz del mundo real que consta de más de dos mil imágenes emparejadas con poca luz/luz normal con anotaciones a nivel de píxel a nivel de instancia. En particular, sin ningún preprocesamiento de imágenes, logramos un rendimiento de segmentación de instancias satisfactorio (AP 4% más alto que los competidores de última generación) en condiciones de muy poca luz, al tiempo que brindamos investigaciones futuras que abren nuevas oportunidades. Nuestro código y conjuntos de datos están disponibles públicamente para la comunidad (https://github.com/Linwei-Chen/LIS).

Abstracto

Las técnicas de segmentación de instancias existentes están diseñadas principalmente para entradas de alta visibilidad, pero su rendimiento se deteriora significativamente en entornos con poca luz. En este trabajo, analizamos en profundidad la segmentación de instancias en la oscuridad e introducimos varias técnicas que aumentan sustancialmente la precisión de la inferencia en condiciones de poca luz. El método propuesto está motivado por la observación de que el ruido en imágenes con poca luz introduce perturbaciones de alta frecuencia en los mapas de características de las redes neuronales, lo que degrada significativamente el rendimiento. Para suprimir este "ruido de características", proponemos un método de aprendizaje novedoso que se basa en una capa de reducción de resolución ponderada adaptativa, un bloque convolucional orientado suavemente y un aprendizaje de supresión de perturbaciones. Estos componentes reducen eficazmente el ruido de las características durante las operaciones de reducción de resolución y convolución. permitiendo que el modelo aprenda características invariantes a las perturbaciones. Además, descubrimos que las imágenes RAW de alta profundidad de bits pueden preservar mejor información de escena más rica en condiciones de poca luz en comparación con las salidas sRGB típicas de las cámaras, lo que admite el uso de algoritmos de entrada RAW. Nuestro análisis indica que una alta profundidad de bits puede ser fundamental para la segmentación de instancias con poca luz. Para mitigar la escasez de conjuntos de datos RAW anotados, aprovechamos una canalización sintética RAW con poca luz para generar datos realistas con poca luz. Además, para facilitar una mayor investigación en esta dirección, capturamos un conjunto de datos de segmentación de instancias con poca luz del mundo real que comprende más de dos mil imágenes emparejadas con luz normal y baja con anotaciones de píxeles a nivel de instancia. Sorprendentemente, sin ningún preprocesamiento de imágenes, logramos un rendimiento satisfactorio en la segmentación de instancias con muy poca luz (4% AP más que los competidores de última generación), mientras abrimos nuevas oportunidades para futuras investigaciones. Nuestro código y conjunto de datos están disponibles públicamente para la comunidad (https://github.com/Linwei-Chen/LIS).

Observaciones y motivación

Dos observaciones clave:

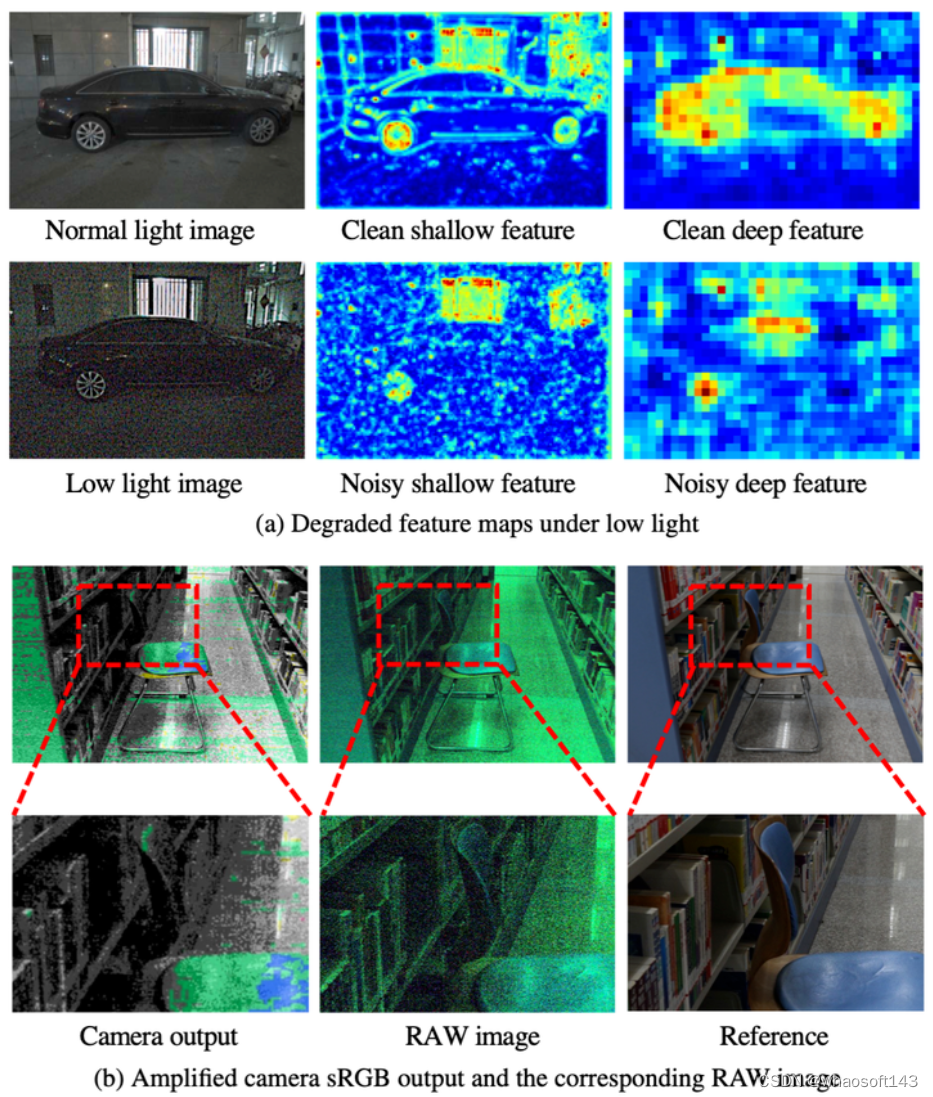

a. Degradación del mapa de características en condiciones de poca luz. Para imágenes claras con luz normal, la red de segmentación de instancias es capaz de capturar claramente características de bajo nivel (por ejemplo, bordes) y de alto nivel (es decir, respuestas semánticas) de objetos en capas tanto superficiales como profundas. Sin embargo, en imágenes ruidosas con poca luz, las características superficiales pueden estar contaminadas y llenas de ruido, mientras que las características profundas responden menos semánticamente a los objetos.

b. Comparación entre la salida sRGB de la cámara y la imagen RAW en la oscuridad. Debido a la relación señal-ruido significativamente reducida, la salida de la cámara de 8 bits pierde mucha información de la escena; por ejemplo, la estructura del respaldo del asiento es casi irreconocible en la salida de la cámara, mientras que todavía es identificable en la imagen RAW ( ampliado para obtener mejores detalles).

Ilustración de nuestras observaciones clave en regímenes oscuros que impulsan el diseño de nuestro método: mapas de características degradadas en condiciones de poca luz. Para imágenes limpias con luz normal, la red de segmentación de instancias es capaz de capturar claramente el nivel bajo ( p. ej ., bordes) y el nivel alto ( p. ej.,, respuestas semánticas) características de objetos en capas poco profundas y profundas, respectivamente. Sin embargo, para imágenes ruidosas con poca luz, las características superficiales pueden estar corruptas y llenas de ruido, y las características profundas muestran respuestas semánticas más bajas a los objetos. b Comparación entre la salida sRGB de la cámara y la imagen RAW en la oscuridad. Debido a la SNR significativamente baja, la salida de la cámara de 8 bits pierde gran parte de la información de la escena; por ejemplo, la estructura del respaldo del asiento es apenas perceptible, mientras que todavía es reconocible en la contraparte RAW (Acerque el zoom para obtener mejores detalles).

Retos y métodos

El enfoque general es el siguiente

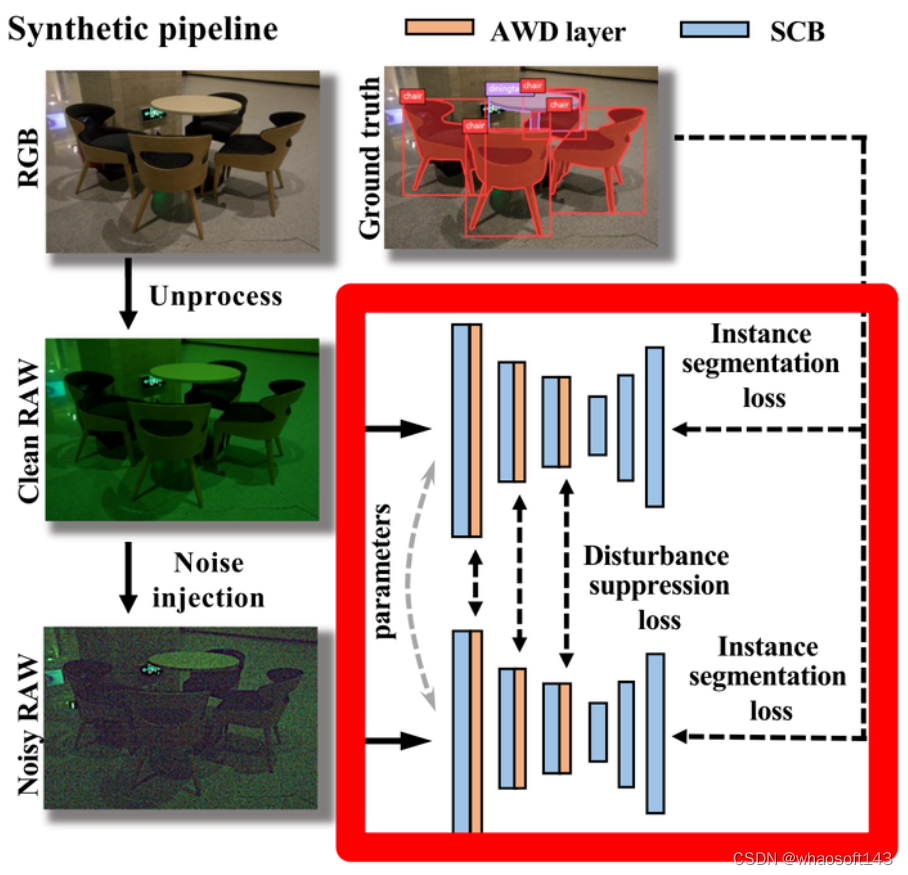

Tubería sintética RAW con poca luz

Desafío: entrenar un modelo de segmentación requiere datos masivos con anotaciones de segmentación de instancias, y actualmente no existe tal conjunto de datos. Es costoso recopilar imágenes de luz oscura adicionales y etiquetar conjuntos de datos de luz oscura a gran escala. Al mismo tiempo, los existentes Los datos RAW también son muy escasos.

Solución: Diseñe una canalización desde imágenes RGB hasta imágenes RAW ruidosas con luz oscura, de modo que el conjunto de datos de segmentación de instancias existente se pueda usar para entrenar un modelo de segmentación de instancias para entrada RAW en condiciones de luz oscura sin costo alguno.

Nuestro proceso de composición RAW con poca luz consta de dos pasos, inyección bruta y de ruido:

Procesamiento inverso. La recopilación de conjuntos de datos de imágenes RAW a gran escala es costosa y requiere mucho tiempo, por lo que consideramos aprovechar los conjuntos de datos de imágenes sRGB existentes (Everingham et al., 2010; Lin et al., 2014). Las imágenes sRGB se obtienen mediante una serie de operaciones de transformación de imágenes del procesamiento de señal de imagen (ISP) interno de la cámara, como mapeo de tonos, corrección gamma, corrección de color, balance de blancos y demostración de mosaicos. Mediante operaciones no procesadas (Brooks et al. 2019), podemos invertir estas transformaciones del procesamiento de imágenes y así obtener imágenes RAW. De esta forma, podremos crear un conjunto de datos RAW sin coste alguno.

Inyección de ruido. Después de obtener una imagen RAW limpia mediante operaciones sin procesar, para simular una imagen real con ruido y poca luz, necesitamos inyectar ruido en la imagen RAW. Para producir resultados de ruido complejos más precisos, adoptamos un modelo de ruido basado en la física propuesto recientemente (Wei et al., 2020, 2021) en lugar del modelo de ruido Poissoniano-Gaussiano ampliamente utilizado (es decir, el modelo gaussiano heteroscedástico (Foi et al. , 2008)). El modelo puede describir con precisión la estructura del ruido real, teniendo en cuenta muchas fuentes de ruido, incluido el ruido de disparo de fotones, el ruido de lectura, el ruido de patrón de franjas y el ruido de cuantificación.

Nuestra tubería sintética RAW con poca luz consta de dos pasos, es decir, desprocesamiento e inyección de ruido. Los presentamos uno por uno.

Sin procesar. Recopilar un conjunto de datos de imágenes RAW a gran escala es costoso y requiere mucho tiempo, por lo que consideramos utilizar conjuntos de datos de imágenes sRGB existentes (Everingham et al., 2010; Lin et al., 2014). La imagen sRGB se obtiene a partir de imágenes RAW mediante una serie de transformaciones de imagen de procesamiento de señal de imagen (ISP) en la cámara, por ejemplo , mapeo de tonos, corrección gamma, corrección de color, balance de blancos y demostración. Con la ayuda de la operación de no procesamiento (Brooks et al., 2019), podemos invertir estas transformaciones de procesamiento de imágenes y se pueden obtener imágenes RAW. De esta forma, podemos crear un conjunto de datos RAW sin coste alguno.

Inyección de ruido. Después de obtener imágenes RAW limpias sin procesar, para simular imágenes reales con ruido y poca luz, necesitamos inyectar ruido en las imágenes RAW. Para obtener resultados más precisos para el ruido complejo real, empleamos un modelo de ruido basado en la física propuesto recientemente (Wei et al., 2020, 2021), en lugar del modelo de ruido Poissoniano-Gaussiano ampliamente utilizado (es decir, el modelo gaussiano heteroscedástico (Foi et al., 2021). otros, 2008)). Puede caracterizar con precisión las estructuras de ruido real teniendo en cuenta muchas fuentes de ruido, incluido el ruido de disparo de fotones, el ruido de lectura, el ruido de patrón de bandas y el ruido de cuantificación.

Capa de reducción de resolución ponderada adaptativa

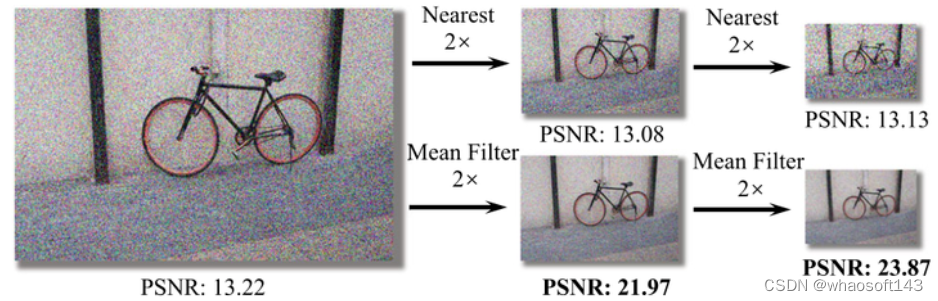

Desafío: Cómo resolver la característica "perturbación de ruido" causada por el ruido de la imagen  . Una observación simple es que, debido a las propiedades previas suaves de la imagen, reducir la resolución de la imagen mediante filtrado de paso bajo puede reducir el nivel de ruido.

. Una observación simple es que, debido a las propiedades previas suaves de la imagen, reducir la resolución de la imagen mediante filtrado de paso bajo puede reducir el nivel de ruido.

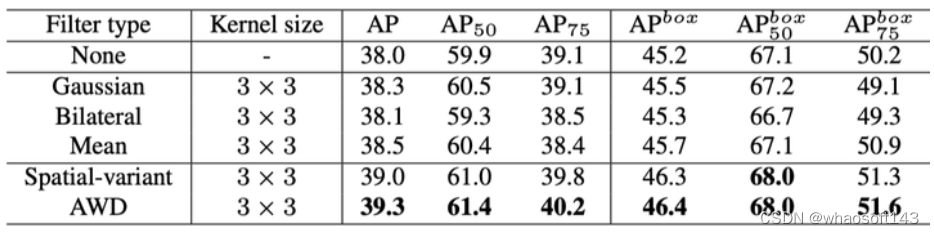

Teniendo en cuenta que las redes existentes a menudo tienen múltiples capas de reducción de resolución, ¿no sería posible aprovechar al máximo estos procesos de reducción de resolución? Los experimentos han demostrado que simplemente insertando un filtro medio se puede lograr un rendimiento casi sin costo en la segmentación de instancias de luz oscura.  Aunque son eficaces, los filtros fijos, como el filtro medio, no se pueden ajustar de forma adaptativa según las características y, por lo tanto, pueden borrar información detallada. En este sentido, el autor propone la capa de reducción de resolución ponderada adaptativa (AWD, por sus siglas en inglés), que predice de forma adaptativa el filtrado de paso bajo en las características canal por canal. y punto por punto. Por lo tanto, el paso bajo aumenta en el área de ruido y el nivel de paso bajo se reduce en el área de detalle para retener los detalles. Mirando el código fuente, FC se reemplaza por Profundidad,

Aunque son eficaces, los filtros fijos, como el filtro medio, no se pueden ajustar de forma adaptativa según las características y, por lo tanto, pueden borrar información detallada. En este sentido, el autor propone la capa de reducción de resolución ponderada adaptativa (AWD, por sus siglas en inglés), que predice de forma adaptativa el filtrado de paso bajo en las características canal por canal. y punto por punto. Por lo tanto, el paso bajo aumenta en el área de ruido y el nivel de paso bajo se reduce en el área de detalle para retener los detalles. Mirando el código fuente, FC se reemplaza por Profundidad,  y el efecto es equivalente. Las fórmulas no aparecen aquí, si estás interesado puedes leer el texto original.

y el efecto es equivalente. Las fórmulas no aparecen aquí, si estás interesado puedes leer el texto original.

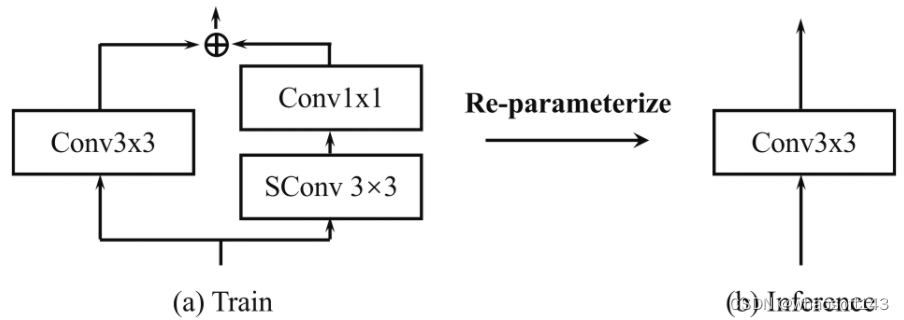

Bloque convolucional orientado suavemente

Para reducir aún más la perturbación de las características por el ruido de alta frecuencia en las imágenes, el autor también propuso utilizar tecnología de reparametrización para entrenar simultáneamente un conjunto de núcleos de convolución suaves durante el entrenamiento y fusionarlos en los núcleos de convolución originales durante la inferencia. De esta forma la convolución es más robusta frente al ruido. ¡Vale la pena señalar que esto no aumenta la cantidad de parámetros y cálculos durante la inferencia! ¡Pura prostitución!

Aprendizaje de supresión de perturbaciones

Al mismo tiempo, el autor también realizó algunos ajustes durante el aprendizaje del modelo, permitiendo que el modelo aprenda imágenes limpias y ruidosas al mismo tiempo, y restringiendo las características de la entrada para que sean imágenes ruidosas para estar más cerca de las imágenes limpias, lo cual es algo similar a la destilación de conocimientos, pero no requiere un maestro. Esto no solo mejora la robustez del modelo bajo luz oscura, sino que también mejora las imágenes con iluminación normal, lo que es muy consistente con el escenario de aplicación real, es decir, un modelo puede hacer frente a aplicaciones tanto de día como de noche.  Conjunto de datos LIS

Conjunto de datos LIS El conjunto de datos fue capturado por Canon EOS 5D Mark IV y tiene las siguientes características:

El conjunto de datos fue capturado por Canon EOS 5D Mark IV y tiene las siguientes características:

-

Muestras emparejadas. En el conjunto de datos LIS, proporcionamos imágenes en formatos sRGB-JPEG (salida de cámara típica) y RAW, cada formato incluye imágenes emparejadas de exposición corta con poca luz y las correspondientes imágenes de larga exposición con luz normal. Nos referimos a estos cuatro tipos de imágenes como sRGB-Dark, sRGB-Normal, RAW-Dark y RAW-Normal. Para asegurarnos de que estuvieran alineados al nivel de píxeles, montamos la cámara en un trípode resistente y la controlamos de forma remota a través de una aplicación móvil para evitar vibraciones.

-

Escenarios diversos. El conjunto de datos del LIS consta de 2230 pares de imágenes recopiladas en varias escenas, tanto en interiores como en exteriores. Para agregar variedad a condiciones de poca luz, tomamos imágenes de referencia de larga exposición usando una variedad de niveles ISO (por ejemplo, 800, 1600, 3200, 6400) y deliberadamente a través de una variedad de factores de poca luz (por ejemplo, 10, 20, 30). , 40, 50 , 100) Reduzca el tiempo de exposición y tome imágenes de exposición corta para simular condiciones de muy poca luz. whatosoft aiot http://143ai.com

-

Etiquetas a nivel de píxel a nivel de instancia. Para cada par de imágenes, proporcionamos etiquetas precisas a nivel de instancia a nivel de píxel que anotan instancias de las 8 categorías de objetos más comunes en nuestra vida diaria (bicicletas, automóviles, motocicletas, autobuses, botellas, sillas, mesas de comedor, televisores). Observamos que LIS contiene imágenes tomadas en diferentes escenas (interiores y exteriores) y bajo diferentes condiciones de iluminación. En la Figura 7, la oclusión de objetos y los objetos densamente distribuidos hacen que LIS sea más desafiante fuera de condiciones de poca luz.

– Muestras pareadas. En el conjunto de datos LIS, proporcionamos imágenes en formato sRGB-JPEG (salida típica de la cámara) y RAW; cada formato consta de imágenes emparejadas de exposición corta con poca luz y las correspondientes imágenes de exposición larga con luz normal. A estos cuatro tipos de imágenes los denominamos sRGB-oscuro, sRGB-normal, RAW-oscuro y RAW-normal . Para asegurarnos de que estén alineados en píxeles, montamos la cámara en un trípode resistente y evitamos las vibraciones mediante control remoto a través de una aplicación móvil.

– Escenarios diversos. El conjunto de datos del LIS consta de 2230 pares de imágenes, que se recopilan en varias escenas, incluidas interiores y exteriores. Para aumentar la diversidad de condiciones de poca luz, utilizamos una serie de niveles ISO ( p. ej., 800, 1600, 3200, 6400) para tomar imágenes de referencia de larga exposición, y reducimos deliberadamente el tiempo de exposición mediante una serie de factores de poca luz (p. ej., 10, 20, 30, 40, 50, 100 ) para tomar imágenes cortas. -Imágenes de exposición para simular condiciones de muy poca luz.

– Etiquetas en píxeles a nivel de instancia. Para cada par de imágenes, proporcionamos etiquetas precisas en píxeles a nivel de instancia que anotan instancias de las 8 clases de objetos más comunes en nuestra vida diaria (bicicleta, automóvil, motocicleta, autobús, botella, silla, mesa de comedor, televisión). Observamos que LIS contiene imágenes capturadas en diferentes escenas (interiores y exteriores) y diferentes condiciones de iluminación. En la Fig.7, la oclusión de objetos y los objetos densamente distribuidos hacen que LIS sea más desafiante además de la poca luz.

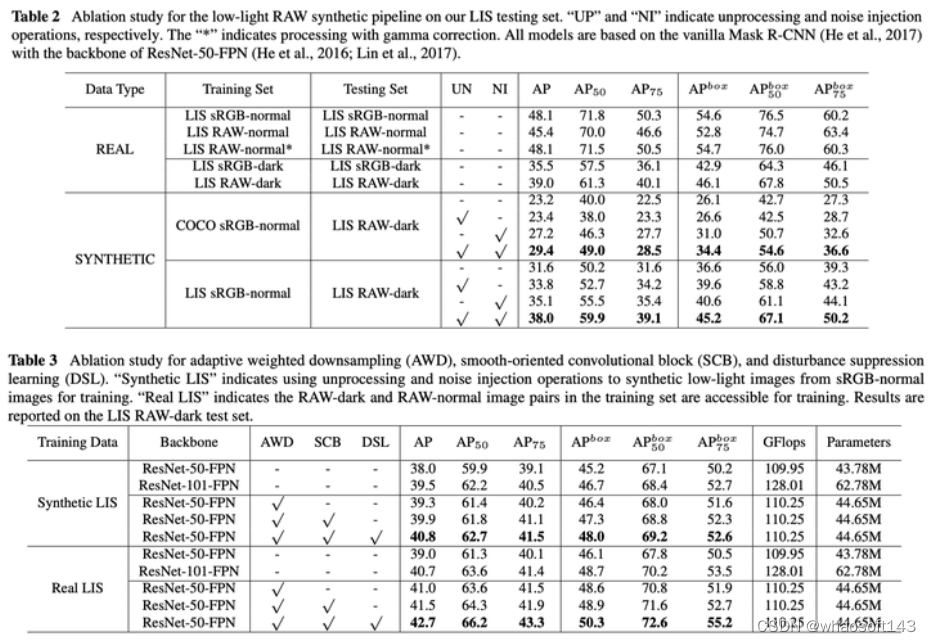

Resultados experimentales

Ablación  Principales resultados

Principales resultados

Proporciona el uso de los métodos Mask R-CNN, PointRend, Mask2Former, Faster R-CNN y la red troncal ResNet-50, Swin-Transformer, ConvNeXt para demostrar la efectividad en las dos tareas de segmentación de instancias y detección de objetivos: inspiración de resultados visuales

.

.

La detección y la segmentación son una dirección de investigación popular y los artículos están surgiendo uno tras otro. Si desea explorar el océano rojo, la mejor manera es crear un océano azul usted mismo. Este artículo encuentra un nuevo escenario de aplicación, por ejemplo la segmentación, construye un marco, por ejemplo, entrenamiento y verificación de segmentación en condiciones de luz oscura, y obtiene una serie de métodos simples pero efectivos a partir de la observación de fenómenos clave. Se puede ver que la observación es la base de la investigación científica. Una buena observación puede permitir a las personas descubrir fenómenos y problemas interesantes, lo que conducirá a nuevos problemas y abrirá nuevos caminos.