¿Estás listo para explorar todo el potencial de ChatGPT? Imagine tener una herramienta de inteligencia artificial que pueda ayudarlo de muchas maneras: desde responder preguntas y crear contenido interesante hasta brindar recomendaciones personalizadas. Aquí es donde entra en juego la "Ingeniería de indicaciones": una forma eficaz y poderosa de hacer que ChatGPT funcione mejor mediante la creación cuidadosa de indicaciones y orientación.

En este artículo, exploraremos el apasionante mundo de Prompt Engineering, cubriendo sus conceptos básicos, consejos, mejores prácticas y estrategias avanzadas para crear un chatbot. Si está interesado en el potencial de los modelos de lenguaje, este artículo será su guía para utilizar ChatGPT y aprovecharlo al máximo.

¿Estás listo para descubrir los secretos de Prompt Engineering y cambiar la forma en que usas ChatGPT? ¡Empecemos!

Conceptos básicos de ingeniería rápidos

Supongo que ya no necesitamos presentar ChatGPT. Si no conoce ChatGPT, lea los artículos anteriores relacionados:

https://blog.csdn.net/jeansboy/article/details/131689471?spm=1001.2014.3001.5501 A medida que la tecnología continúa desarrollándose, la forma en que trabajamos también evoluciona constantemente. Como programadores, a menudo tenemos que afrontar tareas tediosas, comprender códigos complejos y resolver problemas difíciles. Sin embargo, ahora hay un nuevo asistente, ChatGPT. ChatGPT es un chatbot basado en un potente modelo de lenguaje que puede ayudarnos a mejorar la eficiencia y la calidad a la hora de escribir código, e incluso automatizar algunas tareas tediosas. En este artículo, compartiré mi experiencia y consejos sobre cómo utilizar ChatGPT como programador y los beneficios prácticos que ha aportado a mi trabajo. https://blog.csdn.net/jeansboy/article/details/131689471?spm=1001.2014.3001.5501Como programador, ¿cómo uso ChatGPT para ayudarme a escribir código? Blog-CSDN de Yitang Grocery Store Cada uno de nosotros deseamos el éxito, y una de las formas más efectivas de lograr el éxito es resolver los problemas de tantas personas como sea posible en el menor tiempo posible, especialmente los problemas que todos tenemos. Podemos observar los excelentes productos que nos rodean para comprender qué tipo de problemas resuelven estos productos.

https://blog.csdn.net/jeansboy/article/details/131707126?spm=1001.2014.3001.5501Cómo utilizar ChatGPT de forma eficaz para ayudar al desarrollo de software Parte 2: Liberar el potencial del código_Blog-CSDN de Yitang Grocery StoreSi no sabe que existe una primera parte, se recomienda leer primero la parte anterior. Cada uno de nosotros desea el éxito y una de las formas más efectivas de lograrlo es resolver los problemas de tantas personas como sea posible en el menor tiempo posible. tiempo posible Especialmente las preguntas que todos tienen. Podemos observar los excelentes productos que nos rodean para comprender qué tipo de problemas resuelven estos productos. Recientemente, OpenAI lanzó el modelo GPT-4, que hace que las funciones de la IA sean más potentes y diversas. Este avance ha causado curiosidad y preocupación generalizadas, especialmente entre los programadores. La gente empezó a preguntar "¿ChatGPT reemplazará a los programadores?" en los motores de búsqueda, y se convirtió en una recomendación de búsqueda popular.

https://blog.csdn.net/jeansboy/article/details/131762514?spm=1001.2014.3001.5501

Prompt Engineering es fundamental para maximizar la utilidad del modelo de lenguaje de OpenAI, ChatGPT. En esta sección, presentamos los conceptos básicos de la ingeniería de mensajes, incluida su definición, el papel de los mensajes en la interacción con ChatGPT y los muchos factores que influyen en la selección de mensajes.

¿Qué es la ingeniería rápida?

Un proceso interactivo para obtener los resultados relevantes deseados a través de ChatGPT se llama Prompt Engineering. Implica crear una serie de instrucciones y entradas que controlan el comportamiento del modelo y dan forma a la calidad y relevancia de la salida generada. En algunos escenarios, podemos entender que Prompt es un parámetro de entrada para controlar la salida del modelo.

La importancia de Prompt Engineering es que mejora las capacidades de ChatGPT y adapta su respuesta a campañas u objetivos específicos. Los usuarios pueden maximizar la interpretación de sus intenciones y obtener información precisa y contextual del modelo proporcionando indicaciones bien diseñadas. Es como controlar un automóvil de alto rendimiento: puedes aprovecharlo al máximo cuando estás familiarizado con él.

¿Por qué Prompt es crucial para la interacción con ChatGPT?

Las indicaciones son muy importantes en la interacción entre los usuarios y ChatGPT. Proporcionan al modelo el contexto que necesita para crear respuestas relevantes y sirven como punto de partida para las conversaciones. Los usuarios pueden guiar a ChatGPT hacia los resultados deseados con instrucciones claras y precisas.

Según la investigación, Prompt Engineering tiene un impacto considerable en el rendimiento de los modelos de lenguaje. Las indicaciones bien diseñadas pueden ayudar a evitar resultados dañinos o sesgados, mejorar la precisión de las respuestas generadas y tener más control sobre el comportamiento de su modelo. La investigación de OpenAI sobre Prompt Engineering para mejorar los modelos de lenguaje lo demuestra.

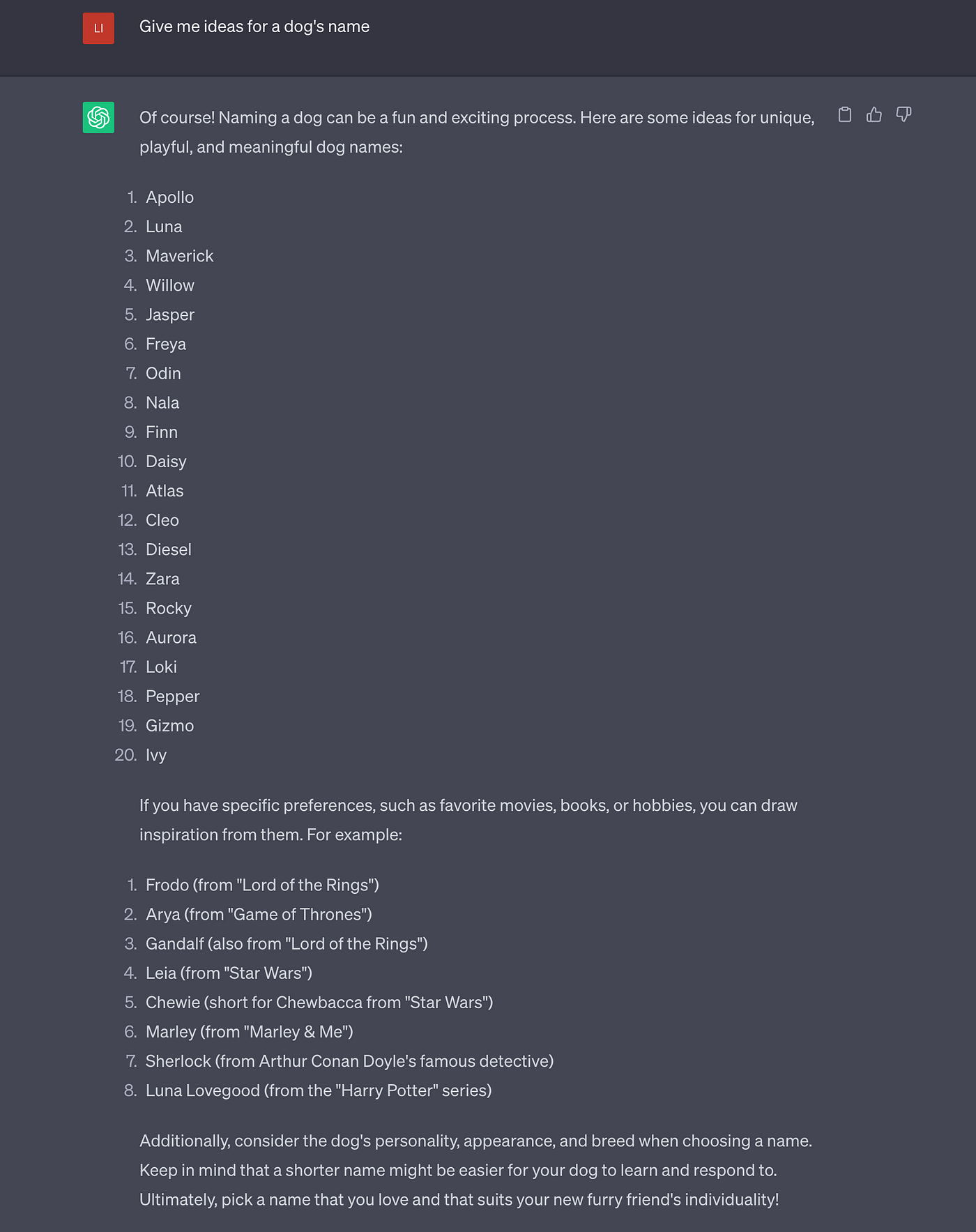

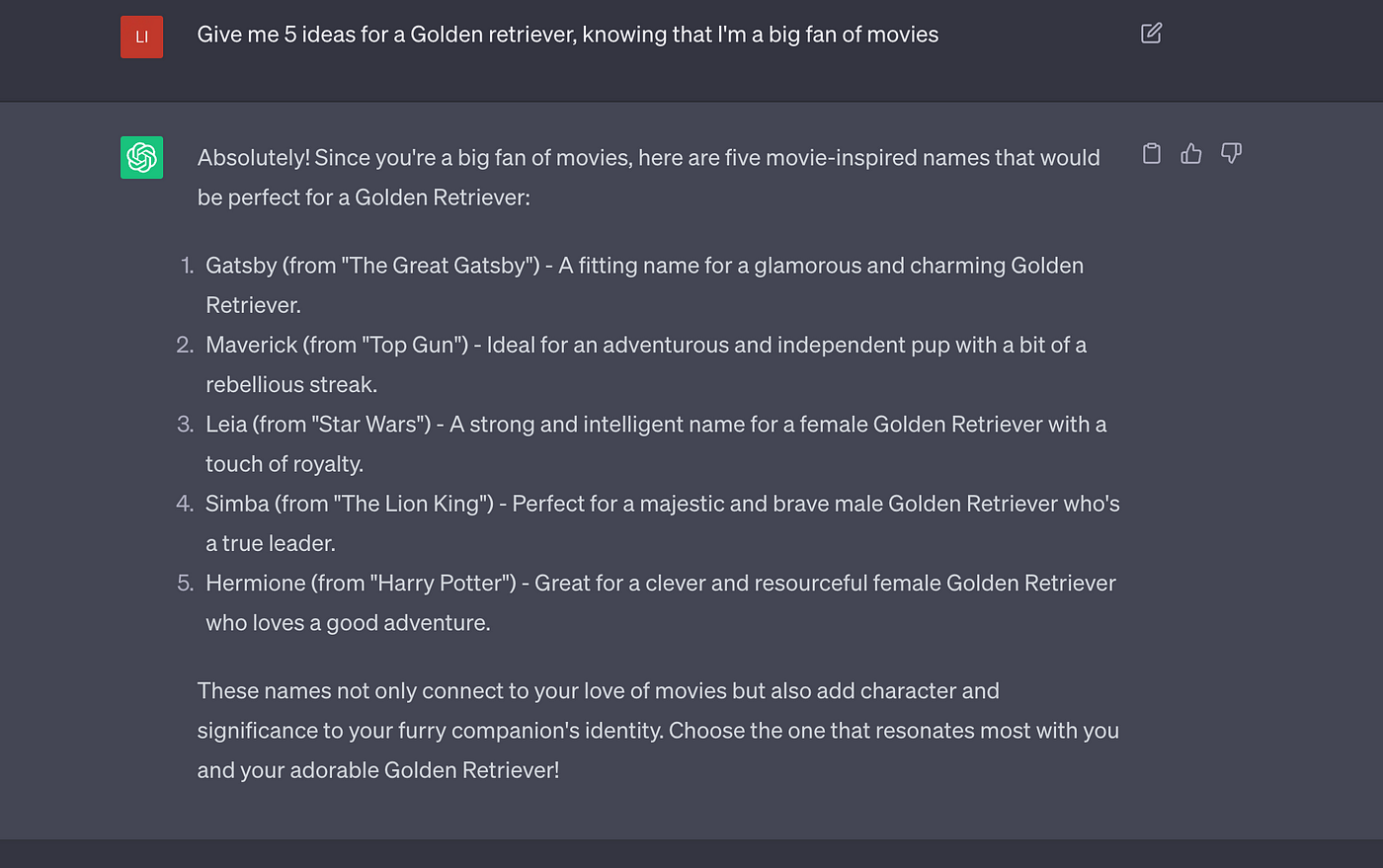

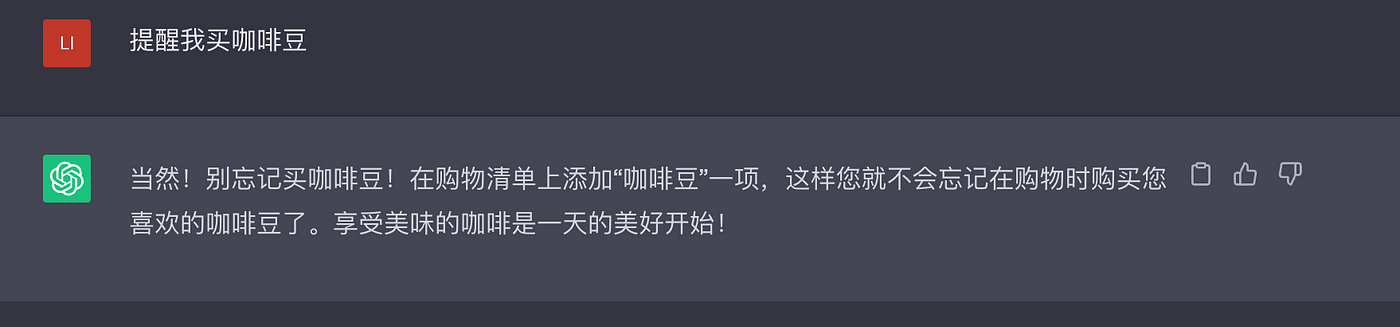

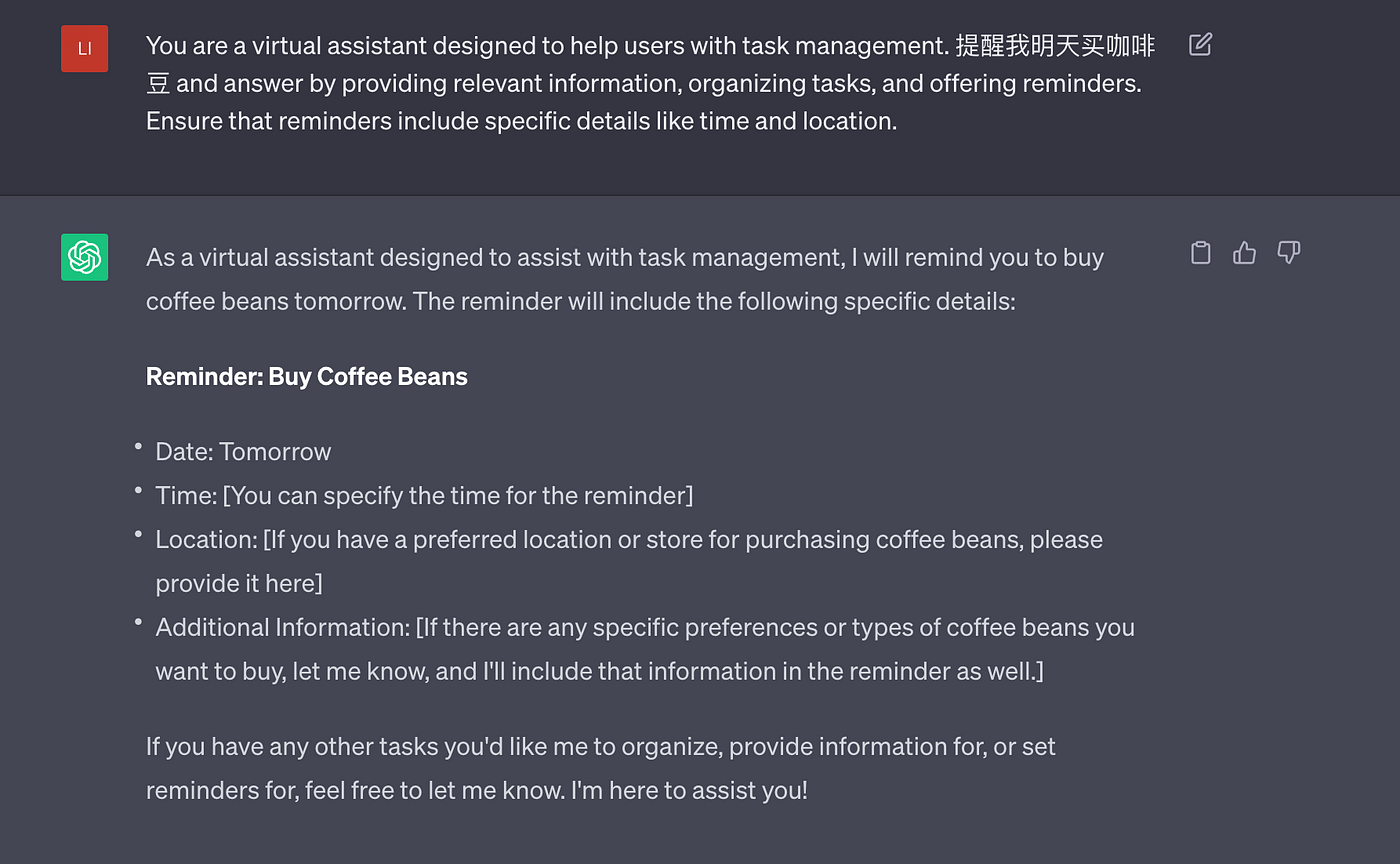

A continuación, veamos las dos consultas siguientes y sus correspondientes respuestas ChatGPT:

Pregunta 1:

Pregunta 2:

El segundo mensaje produce una respuesta más específica y significativa.

Este ejemplo resalta la importancia de la precisión y la claridad en la ingeniería rápida.

¿Qué es la categoría Aviso?

Prompt es una herramienta importante para una comunicación fluida con modelos de lenguaje de IA.

Para crear indicaciones de alta calidad, primero debe comprender cómo se clasifican. Esto le permite estructurarlos de manera eficiente para centrarse en respuestas objetivo específicas.

Las principales categorías de consejos incluyen:

1. Solicitar recuperación de información

Estas indicaciones están diseñadas para recopilar información mediante preguntas de "qué" y "cómo". Son excelentes para extraer detalles o hechos específicos de modelos de IA. Por ejemplo:

- ¿Cuáles son los beneficios para la salud de una dieta vegetariana?

- ¿Cómo puedo ser más productivo?

2. Aviso basado en instrucciones

Las indicaciones basadas en instrucciones son indicaciones que guían al modelo de IA para realizar tareas específicas. Estas indicaciones son similares a cómo interactuamos con asistentes de voz como Siri, Alexa o Google Assistant. Por ejemplo:

- Concierte una cita con el dentista el próximo martes a las 10 a.m.

- Encuentra la ruta más rápida al aeropuerto.

3. Aviso que proporciona información contextual.

Estas indicaciones proporcionan información contextual al modelo de IA, ayudándolo a comprender mejor las respuestas esperadas por el usuario. Al proporcionar contexto, puede obtener respuestas más precisas y relevantes de la IA. Por ejemplo:

- No sé nada sobre jardinería. ¿Cuáles son algunas plantas fáciles de cultivar para principiantes?

- Quiero planear una cena romántica para mi novia. ¿Puede brindarnos algunas sugerencias e ideas para mejorar la atmósfera?

4. Aviso comparativo

Los mensajes comparativos se utilizan para evaluar o comparar diferentes opciones para ayudar a los usuarios a tomar decisiones informadas. Son especialmente útiles a la hora de sopesar los pros y los contras de diferentes opciones. Por ejemplo:

- ¿Cuáles son los pros y los contras de alquilar y comprar una casa?

- Comportamiento de vehículos eléctricos y convencionales de gasolina.

5. Incitar a buscar perspectiva

Estas indicaciones guían a la IA para expresar opiniones o puntos de vista sobre un tema determinado. Pueden ayudar a generar ideas creativas o tener debates que inviten a la reflexión. Por ejemplo:

- ¿Qué impacto potencial podría tener la IA en el mercado laboral?

- ¿Cómo podría cambiar el mundo si la tecnología de teletransportación se hiciera realidad?

6. Mensaje reflexivo

Las indicaciones reflexivas ayudan a las personas a obtener una comprensión más profunda de sí mismas, de sus creencias y comportamientos. A menudo fomentan el crecimiento personal y la introspección basándose en temas específicos o experiencias personales. Es posible que deba proporcionar alguna información general para obtener la respuesta ideal. Por ejemplo:

- ¿Cómo puedo generar confianza y superar las dudas?

- ¿Qué estrategias puedo adoptar para mantener un equilibrio saludable entre el trabajo y la vida personal?

¿Cuáles son los factores que influyen en la pronta selección?

Al crear un mensaje eficaz, hay muchos factores a considerar que afectan la calidad, relevancia y precisión de las respuestas de ChatGPT. Los factores importantes incluyen:

- Conocimiento del modelo : comprenda las fortalezas y debilidades de ChatGPT . Incluso los modelos de vanguardia como ChatGPT pueden necesitar ayuda con tareas específicas o producir datos erróneos. Esta comprensión ayuda a crear señales que aprovechan las fortalezas del modelo y minimizan sus defectos.

- Intención del usuario : es fundamental comprender la intención del usuario para generar respuestas relevantes. Las indicaciones deben reflejar claramente las expectativas del usuario, permitiendo a ChatGPT proporcionar información relevante y correcta.

- Sea claro y sin ambigüedades : asegúrese de que las indicaciones sean claras y sin ambigüedades para reducir la ambigüedad o la incertidumbre, que pueden generar respuestas deficientes.

- Especificidad del dominio : cuando se trata de dominios altamente especializados, considere utilizar vocabulario o contexto específico del dominio para guiar el modelo hacia las respuestas esperadas. Agregar contexto o ejemplos ayuda al modelo a producir resultados más precisos y relevantes.

- Restricciones : determine si se requiere alguna restricción (como la longitud o el formato de la respuesta) para producir los resultados deseados. Las restricciones, como límites de caracteres o formatos estructurados, se pueden especificar explícitamente para ayudar al modelo a generar respuestas que satisfagan necesidades específicas.

La ingeniería rápida con estos factores en mente puede mejorar la eficacia de ChatGPT y garantizar que las respuestas generadas coincidan estrechamente con los objetivos deseados.

Vale la pena señalar que Prompt Engineering es un tema de investigación en curso que se mejora y perfecciona constantemente para mejorar la interactividad y la practicidad de los modelos de lenguaje (como ChatGPT).

en conclusión:

Consejos principales:

- Identifique el problema u objetivo: indique claramente en qué desea que ChatGPT lo ayude y el tipo de respuestas que espera.

Ejemplo: generar un titular atractivo para una campaña de marketing dirigida a jóvenes profesionales de la industria de la moda. - Agregue palabras clave y frases relevantes: incluya los términos más relevantes relacionados con el tema y específicos de la industria en el mensaje para ayudar a ChatGPT a generar el resultado deseado.

Ejemplo: redactar un texto de marketing persuasivo para nuestras zapatillas de deporte, centrándose en la comodidad, la durabilidad y el rendimiento. Para entusiastas del fitness y deportistas. Incluya palabras clave como "rendimiento", "comodidad", "durabilidad" y "atleta". - Consejo de redacción: utilice las palabras clave y frases identificadas en los pasos anteriores para crear una sugerencia concisa que transmita de manera efectiva la información y la tarea requeridas.

Ejemplo: "Cree una publicación atractiva en las redes sociales que destaque los beneficios de nuestra nueva gama de cuidado de la piel orgánico, enfatizando ingredientes como 'naturales', 'nutritivos', 'ecológicos' y 'piel suave'". - Pruebe, evalúe e itere: utilice ChatGPT para generar respuestas, evaluar los resultados y modificar las indicaciones según sea necesario para obtener el resultado deseado. Repita este proceso hasta que haya creado un mensaje exitoso que produzca consistentemente la respuesta esperada.

Elementos de un buen mensaje:

Un resultado excelente depende principalmente de los datos de entrenamiento, los parámetros del modelo y las indicaciones efectivas. Sólo podemos incidir en uno de los factores que afecta al usuario y es el Prompt. Los siguientes son los elementos que componen un buen Prompt:

- Lenguaje claro y conciso, sencillo y sin ambigüedades.

- El rol asignado a ChatGPT que desea que desempeñe en las indicaciones.

- La información y los ejemplos que proporciona son su aporte. (ChatGPT puede hacer referencia a información y ejemplos del historial de chat anterior)

- La tarea específica que le pides a ChatGPT que complete, es decir, el resultado que esperas.

- Ajuste según sea necesario después de recibir la respuesta inicial, es decir, repita hasta obtener el resultado deseado.

Consejos de ingeniería rápidos

En este capítulo, exploraremos varias técnicas de Prompt que se pueden utilizar para optimizar la ingeniería de Prompt y maximizar el efecto de interacción con ChatGPT. Echemos un vistazo más profundo a estos consejos y comprendamos su importancia.

Instrucciones claras

Las instrucciones claras e inequívocas son la base de una ingeniería rápida y eficaz. Al proporcionar una guía clara, los usuarios pueden mejorar la calidad de las respuestas de ChatGPT. La investigación de OpenAI muestra que las indicaciones claramente definidas afectan significativamente el rendimiento de los modelos de lenguaje.

Pregunta 1:

Aviso simple

Pregunta 2:

Un mensaje específico y claro

Utilice restricciones claras

Agregar restricciones claras al mensaje puede guiar el proceso de pensamiento de ChatGPT y garantizar respuestas más precisas y bien fundadas. Las restricciones sirven como instrucciones adicionales que dan forma al comportamiento del modelo y mejoran la relevancia del resultado generado.

Por ejemplo, cuando se busca orientación paso a paso, agregar restricciones como "proporcione un proceso secuencial detallado" puede ayudar a ChatGPT a generar una orientación coherente y fácil de seguir. La investigación de OpenAI muestra que el uso de reglas claras puede conducir a resultados más controlables y esperados.

Probando diferentes contextos y ejemplos.

El contexto juega un papel vital en Prompt Engineering. Al proporcionar contexto relevante y ejemplos en las indicaciones, los usuarios pueden mejorar la comprensión de ChatGPT y guiarlo para generar respuestas contextuales más precisas.

Por ejemplo, incorporar contexto relevante en las indicaciones puede ayudar a ChatGPT a brindar respuestas más reveladoras cuando solicita información sobre un tema específico.

Pregunta 1:

Aviso sin contexto

Pregunta 2:

Preguntar con contexto

Las indicaciones ricas en contexto pueden guiar a ChatGPT a generar respuestas consistentes con áreas de interés específicas.

Uso de problemas del Sistema 1 y del Sistema 2

Las preguntas del Sistema 1 y del Sistema 2 proporcionan un enfoque equilibrado para la Ingeniería Rápida. Las preguntas del Sistema 1 provocan respuestas rápidas e instintivas, mientras que las preguntas del Sistema 2 requieren respuestas reflexivas y detalladas. La combinación de estos dos tipos de preguntas agrega variedad y profundidad a las interacciones con ChatGPT.

Por lo tanto, utilizar preguntas del Sistema 1 y del Sistema 2 en Prompt Engineering es una forma de influir en el tipo de respuestas que brinda ChatGPT.

Los usuarios pueden indicarle a ChatGPT que genere respuestas que satisfagan sus necesidades al incluir preguntas del Sistema 1 y del Sistema 2 en el mensaje. Considere el siguiente ejemplo para ilustrar este concepto:

Ejemplo: Asistente de IA de consejos de viaje

Mensaje: "Como asistente de recomendación de viajes, su objetivo es brindar a los usuarios recomendaciones de viaje personalizadas e informadas. Utilice las preguntas del Sistema 1 y del Sistema 2 para generar respuestas relevantes. Las preguntas del Sistema 1 deben centrarse en recomendaciones rápidas, mientras que las preguntas del Sistema 2 Las razones detrás Se deben explorar las recomendaciones.

Pregunta del sistema 1 “¿Cuáles son las atracciones turísticas populares en París?

Pregunta del Sistema 2 “¿Puedes explicar el significado histórico de la Torre Eiffel y sus características arquitectónicas?

En este ejemplo, el problema del Sistema 1 hizo que ChatGPT proporcionara rápidamente recomendaciones para las principales atracciones turísticas de París. Los usuarios que busquen consejos sobre itinerarios de viaje cortos se beneficiarán de información concisa y fácil de entender. Las respuestas pueden incluir lugares de interés como el Museo del Louvre, la Catedral de Notre Dame y los Campos Elíseos.

Y las preguntas del Sistema 2 alientan a ChatGPT a explorar la importancia histórica y los aspectos arquitectónicos de atracciones específicas, como la Torre Eiffel. Respuestas como esta son muy útiles para los usuarios que desean comprender mejor y aprender más sobre la atracción. Las respuestas pueden incluir los antecedentes históricos de la torre cuando se construyó para la Exposición Universal de 1889, el diseño de Gustave Eiffel y su famosa estructura de celosía de hierro.

Al incluir preguntas del Sistema 1 y del Sistema 2, los usuarios obtienen recomendaciones rápidas y explicaciones más detalladas. Esto permite que el asistente de consejos de viaje se adapte a los gustos de los diferentes usuarios, brindando consejos prácticos y al mismo tiempo satisfaciendo la curiosidad de los usuarios interesados en la historia y las características arquitectónicas de las atracciones.

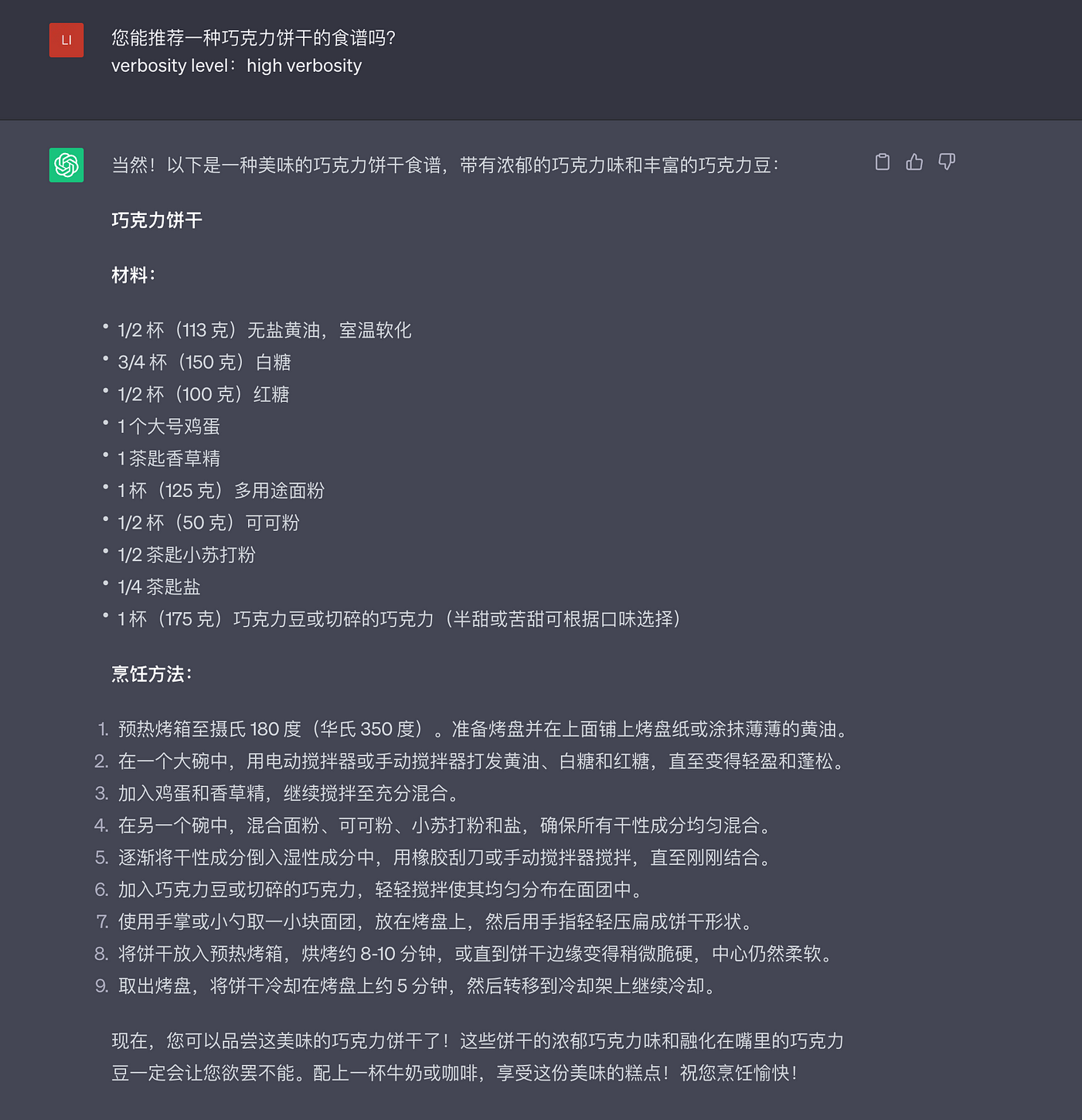

Longitud de salida de control

Controlar la longitud de las respuestas de ChatGPT es un componente clave de una rápida ingeniería de avisos. Permite al usuario controlar la detalle y la longitud de la salida generada. Considere el siguiente ejemplo para ver cómo gestionar la longitud de la salida:

Pregunta 1:

salida corta

Pregunta 2:

salida detallada

En esta respuesta, ChatGPT demuestra una gran verbosidad y proporciona recetas detalladas paso a paso. Contiene explicaciones y sugerencias adicionales para ayudar a los usuarios durante el proceso de horneado. Esta profundidad es apropiada para quienes necesitan orientación detallada, especialmente para panaderos novatos o quienes prefieren un enfoque más integral.

De esta manera, ChatGPT puede adaptarse a diversas preferencias de los usuarios y optimizar la experiencia de conversación ajustando la verbosidad de las respuestas, lo que permite al chatbot brindar respuestas relevantes a las necesidades de los usuarios y fortalecer las conexiones con los usuarios.

Mejores prácticas de ingeniería rápidas

Prompt Engineering es un proceso dinámico que requiere suficiente pensamiento y experimentación para obtener los mejores resultados. En esta sección, veremos las mejores prácticas de Prompt Engineering para ayudar a los usuarios a aprovechar al máximo sus interacciones con ChatGPT. Echemos un vistazo a estas prácticas y veamos qué tan efectivas son.

Pruebas y mejoras continuas.

La ingeniería rápida eficaz depende en gran medida de las pruebas y mejoras continuas. Los usuarios pueden mejorar continuamente las instrucciones y mejorar la calidad de las respuestas de ChatGPT revisando periódicamente los resultados y ajustando las indicaciones en consecuencia.

Iteración 1:

Iteración 2:

El mensaje chino todavía se está probando, pero la versión en inglés puede generar directamente un recordatorio formateado.

Iteración 3:

Un equilibrio entre intención y creatividad.

En Prompt Engineering, también es crucial equilibrar la intención del usuario y la creatividad del modelo en sí. Eche un vistazo al chatbot de inspiración para la escritura a continuación, que se esfuerza por promover la creatividad y al mismo tiempo brinda indicaciones adecuadas:

ChatGPT brinda indicaciones apropiadas al equilibrar las intenciones del usuario y mejorar la creatividad del modelo, fomentando la imaginación y al mismo tiempo siendo consistente con los objetivos de escritura del usuario.

Integre recursos externos y API

Aprovechar los recursos externos y las API es una técnica poderosa en Prompt Engineering que permite a ChatGPT aprovechar información adicional y mejorar sus capacidades de respuesta. Veamos un ejemplo para comprender cómo utilizar recursos externos y API:

Ejemplo: Asistente de información meteorológica

Mensaje: "Como chatbot de información meteorológica, aproveche los recursos externos y las API para proporcionar datos meteorológicos precisos y actualizados a los usuarios".

Consulta del usuario: "¿Cómo está el tiempo en Shanghai hoy?"

Este chatbot se puede integrar con API meteorológicas externas (como Weather.com) para proporcionar información meteorológica precisa. Al llamar a la API, el chatbot puede obtener datos meteorológicos en tiempo real para una ubicación específica.

Integración API

import requests

def get_weather(city):

api_key = "YOUR_API_KEY"

url = f"https://api.weatherapi.com/v1/current.json?key={api_key}&q={city}"

response = requests.get(url)

data = response.json()

return data["current"]["condition"]["text"], data["current"]["temp_c"]La función get_weather() anterior demuestra un ejemplo de integración con WeatherAPI, que devuelve las condiciones climáticas y la temperatura en grados Celsius para una ciudad determinada.

Plantilla de respuesta:

city = "Shanghai"

weather_condition, temperature = get_weather(city)

response = f"The weather in {city} today is {weather_condition}. The temperature is {temperature}°C."Resultado de la respuesta:

“El clima en Shanghai hoy está parcialmente nublado. La temperatura es de 22°C”.

Al aprovechar los recursos externos y las API, el chatbot puede recuperar información meteorológica precisa e incorporarla en las respuestas. Esto proporciona a los usuarios actualizaciones meteorológicas en tiempo real adecuadas para su ubicación especificada.

La integración con recursos externos y API permite a ChatGPT obtener grandes cantidades de información más allá de sus datos de entrenamiento para brindar respuestas más valiosas y confiables a las consultas de los usuarios.

Ejemplos de API de OpenAI

La API OpenAI permite a los desarrolladores integrar ChatGPT en sus aplicaciones, productos o servicios. A continuación se muestra un ejemplo que muestra cómo utilizar la API OpenAI:

import openai

# Set up your OpenAI API credentials

openai.api_key = 'YOUR_API_KEY'

# Define a function for interacting with ChatGPT

def ask_chatbot(question, chat_history=None):

if chat_history is None:

chat_history = []

# Format the input for the API call

input_text = '\n'.join(chat_history + [f'User: {question}'])

# Call the OpenAI API to generate a response

response = openai.Completion.create(

engine='text-davinci-003',

prompt=input_text,

max_tokens=50,

temperature=0.7,

n=1,

stop=None,

temperature=0.7

)

# Extract the generated response from the API response

answer = response.choices[0].text.strip()

# Append the user's question and the chatbot's answer to the chat history

chat_history.append(f'User: {question}')

chat_history.append(f'Chatbot: {answer}')

return answer

# Example usage

chat_history = []

user_question = "What is the capital of France?"

response = ask_chatbot(user_question, chat_history)

print(response)En este ejemplo, definimos la función Ask_chatbot(), que recibe la pregunta del usuario y un historial de chat opcional como entrada. Esta función formatea el historial de chat y las preguntas de los usuarios y luego realiza una llamada API a la API OpenAI utilizando el método openai.Completion.create().

La respuesta de la API contiene la respuesta generada desde ChatGPT. Extraemos las respuestas de las respuestas y agregamos las preguntas del usuario y las respuestas del chatbot al historial de chat. Finalmente, se devuelve la respuesta generada.

Con la API ChatGPT OpenAI, los desarrolladores pueden integrar la funcionalidad de ChatGPT en sus aplicaciones, permitiendo a los usuarios interactuar con el chatbot y recibir respuestas basadas en sus consultas.

Evitar cualquier sesgo y utilizarlo dentro de principios éticos.

ChatGPT debe utilizarse de forma ética y sin prejuicios. He aquí un ejemplo importante:

Ejemplo: selección de candidatos asistida por IA

Imagine un sistema de inteligencia artificial que utilice ChatGPT para analizar las respuestas a las entrevistas y seleccionar a los solicitantes de empleo. El proceso de selección debe ser ético y libre de prejuicios.

Los siguientes pasos pueden reducir el sesgo y garantizar la equidad:

- Diversidad de datos de entrenamiento : optimice ChatGPT utilizando datos de una variedad de razas, géneros y etnias. Es fundamental abordar el sesgo en los datos de entrenamiento desde el principio, ya que puede generar sesgo.

- Evaluación de sesgos : evalúe periódicamente las respuestas del modelo para identificar y reducir manualmente los sesgos. Utilice Equilibrio e Igualdad de oportunidades para ver si las recomendaciones del modelo equilibran los efectos de factores como el género o la raza. Haga ajustes para reducir el sesgo.

- Pautas transparentes : comunique las pautas del sistema a revisores y desarrolladores humanos. Estas directrices deben hacer hincapié en la equidad, la ética y la evitación de prejuicios. Proporcione instrucciones claras para evitar favorecer o discriminar a grupos específicos durante el proceso de selección.

- Revisión de la intervención humana : permita que los humanos analicen las respuestas del sistema. Este paso ayuda a descubrir cualquier sesgo del modelo y garantiza que los humanos puedan considerar el contexto y tomar decisiones justas.

- Monitoreo y retroalimentación continuos : Supervise continuamente el rendimiento del sistema y recopile comentarios de los usuarios y revisores. Verifique la salida del sistema para detectar sesgos y efectos no deseados. Los bucles de retroalimentación ayudan a resolver problemas rápidamente.

- Equipo diverso de revisores : asegúrese de que los miembros del equipo responsables de revisar y optimizar los resultados del sistema provengan de diversos orígenes. Equipos diversos pueden descubrir y abordar sesgos que grupos homogéneos pueden pasar por alto.

Estas prácticas ayudan a que los sistemas de selección de candidatos asistidos por IA eviten sesgos y evalúen a los candidatos en función de sus habilidades y cualificaciones.

Estrategias avanzadas de ingeniería rápida

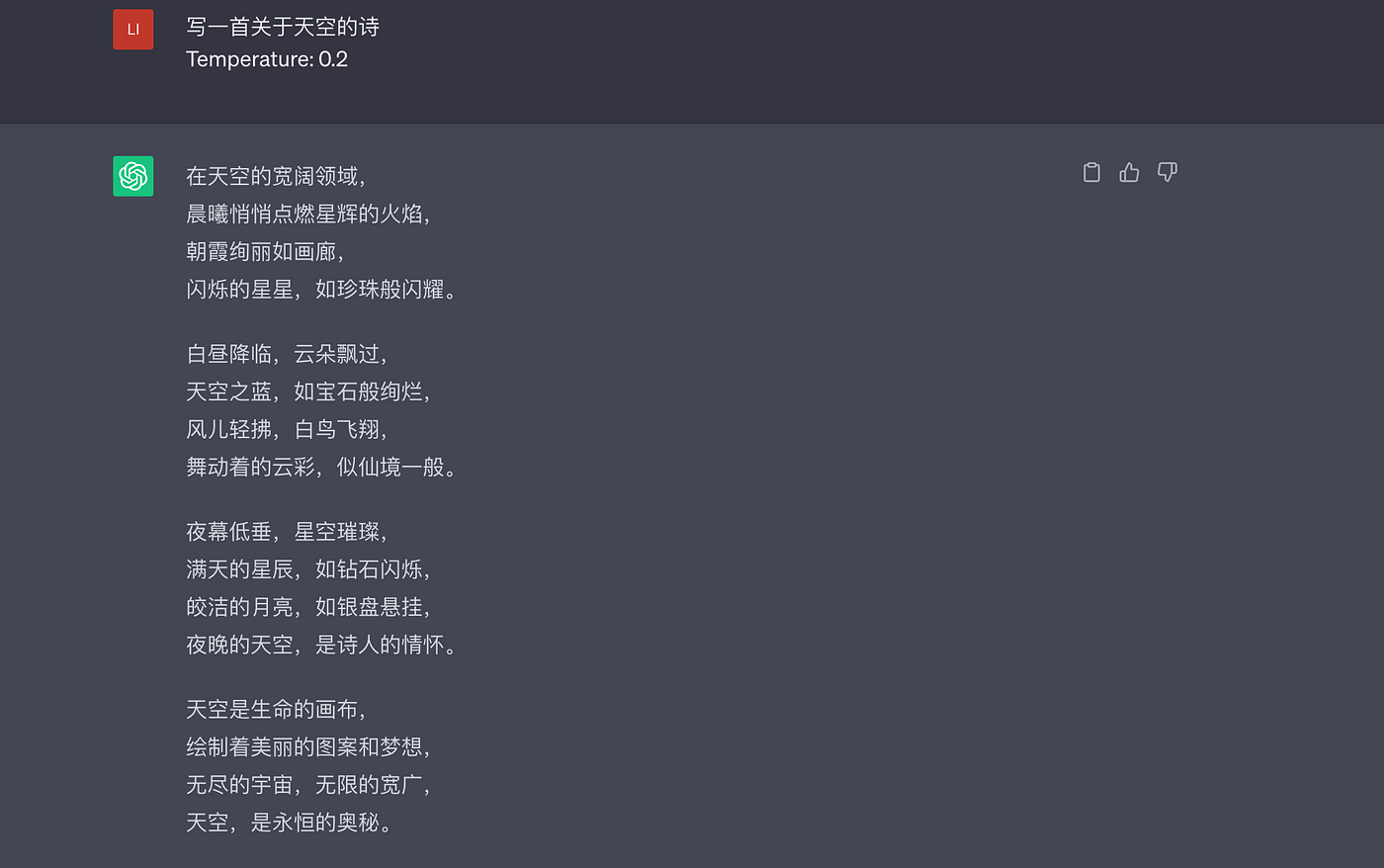

Prompt Engineering puede ir un paso más allá e incluir estrategias innovadoras para optimizar aún más el rendimiento y la adaptabilidad de ChatGPT. Esta sección presentará algunas estrategias avanzadas de ingeniería de avisos, como control de temperatura y tokens, vinculación de avisos para múltiples rondas de diálogo, modificación de avisos para aplicaciones de dominio específicas y manejo de entradas de usuario confusas o contradictorias.

Gestión de temperatura y token.

Los controles de temperatura y token son formas efectivas de ajustar el comportamiento de ChatGPT. Los usuarios pueden cambiar la aleatoriedad de la salida generada mediante el control de temperatura. Una temperatura más baja, como 0,2, producirá respuestas más centradas y deterministas, mientras que una temperatura más alta, como 1,0, producirá resultados más variados y exploratorios. Este valor también representa la creatividad y racionalidad del modelo de control.

La investigación de OpenAI revela el impacto del control de temperatura en la diversidad de respuestas de ChatGPT. Al experimentar con diferentes configuraciones de temperatura, los usuarios pueden lograr el equilibrio ideal entre proporcionar respuestas comprensibles e incorporar nuevas funciones en las respuestas generadas.

Pregunta 1:

Pregunta 2 :

¿Es más poético?

El control de tokens requiere especificar la cantidad máxima de tokens para limitar la longitud de la respuesta. Esto permite a los usuarios controlar la detalle de la salida de ChatGPT y obtener respuestas concisas y concisas. Al establecer límites de token adecuados, los usuarios pueden asegurarse de que ChatGPT proporcione respuestas que correspondan a la longitud esperada de las respuestas.

Cadena de mensajes y múltiples rondas de diálogo

La cadena rápida y las conversaciones de varias rondas pueden lograr una comunicación ChatGPT más interactiva y dinámica. Los usuarios pueden vincular varias indicaciones para formar un flujo de conversación continuo. Cada mensaje puede hacer referencia a entradas anteriores o respuestas anteriores de ChatGPT, lo que permite conversaciones ricas en contexto.

Al utilizar Prompt Chain, los usuarios pueden crear una experiencia más conversacional e interactuar repetidamente con ChatGPT. Esta técnica es adecuada para tareas que requieren instrucciones de varios pasos o discusiones detalladas.

Ajustar las indicaciones para aplicaciones específicas de dominio

La adaptación de avisos para aplicaciones de dominios específicos es un método importante de ingeniería de avisos. Implica adaptar las indicaciones a industrias o campos específicos para garantizar que las respuestas sean relevantes y precisas. Usemos un ejemplo para ilustrar cómo ajustar el mensaje para aplicaciones específicas de dominio:

Ejemplo: Asistente de IA de diagnóstico médico

Mensaje: "Diseñe un mensaje para un asistente de IA de diagnóstico médico para ayudar a los usuarios a evaluar sus síntomas y brindar recomendaciones iniciales".

Ajustar las indicaciones para los asistentes de IA de diagnóstico médico requiere agregar terminología médica, síntomas y consideraciones de diagnóstico relevantes.

Mensaje: "Describa sus síntomas e historial médico y el asistente de IA le proporcionará una evaluación inicial basada en la información proporcionada. Tenga en cuenta que esta evaluación no sustituye el asesoramiento médico profesional. Si está experimentando una emergencia médica, por favor comuníquese con los servicios de emergencia de inmediato."

Usuario: "Tengo dolor de cabeza, fiebre y dolor de garganta".

El aviso adaptado tiene en cuenta los síntomas del usuario y le informa de las limitaciones de la evaluación. Las respuestas generadas por el asistente de IA pueden proporcionar sugerencias iniciales basadas en la información proporcionada:

Respuesta: "Dependiendo de tus síntomas de dolor de cabeza, fiebre y dolor de garganta, puede indicar que tienes una infección viral común, como gripe, o puede ser laringitis. Es importante consultar a un profesional médico para un diagnóstico preciso. y el tratamiento adecuado. Mientras tanto, puede descansar, mantenerse hidratado y tomar analgésicos de venta libre para aliviar los síntomas. Si sus síntomas empeoran o persisten, busque atención médica para una evaluación adicional".

Al adaptar Prompt como asistente de IA de diagnóstico médico, las respuestas son consistentes con la aplicación en el campo específico y brindan sugerencias preliminares al tiempo que enfatizan la importancia del asesoramiento médico profesional.

Ofuscar o resolver entradas conflictivas del usuario

Prompt Engineering necesita lidiar con algunos conceptos vagos o entradas contradictorias del usuario. ChatGPT debe procesar cuidadosamente dichos comentarios y responder de manera significativa. Veamos un ejemplo para ilustrar cómo:

Ejemplo: Chatbot de recomendación de restaurantes

Mensaje: "Como chatbot de recomendación de restaurantes, maneje las entradas ambiguas o contradictorias de los usuarios para garantizar respuestas precisas y útiles".

Usuario: "Estoy buscando un restaurante en la ciudad que tenga opciones vegetarianas y de carnes".

En este caso, el usuario quiere tener opciones de carne y vegetarianas. Los chatbots pueden aclarar:

Respuesta: "¡Sí! Estaré encantado de ayudarte a encontrar un restaurante. ¿Preferirías un restaurante vegetariano o te gustaría una variedad de opciones, incluido el bistec?"

El chatbot solicita aclaraciones para comprender mejor la solicitud del usuario y brindar recomendaciones más precisas.

Usuario: "Me gusta un restaurante que tenga platos vegetarianos y de carne".

Después de que los usuarios aclaren sus preferencias, el chatbot puede responder:

Respuesta: "¡Genial! Recomiendo el restaurante "The Grill House", ya que ofrece platos vegetarianos y de carne. Ofrecen deliciosos platos vegetarianos y de carne en su extenso menú. ¡Disfruta tu comida!"

Al interactuar activamente con los usuarios y buscar aclaraciones, el chatbot maneja la ambigüedad de la consulta inicial, comprende los deseos del usuario y recomienda restaurantes que coincidan con sus necesidades.

Manejar las entradas conflictivas de los usuarios es similar. El chatbot puede aclarar los objetivos del usuario y guiarlo cuando quiere un restaurante barato pero lujoso.

Caso: Ingeniería Rápida en el mundo real

En aplicaciones prácticas, Prompt Engineering ha producido resultados positivos. Echemos un vistazo a varios casos de Prompt Engineering en diferentes campos:

Chatbot de atención al cliente

Los chatbots de atención al cliente mejoran el servicio al cliente y la capacidad de respuesta. Prompt Engineering puede mejorar la precisión y eficiencia de los chatbots y mejorar la experiencia del cliente.

Prompt Engineering ayuda a los chatbots a aprender y responder a los comentarios de los clientes, haciendo que las interacciones sean más personales y efectivas.

Caso: HubSpot Chatbot Builder , que puede programar reuniones, vincularse a KB e integrarse con el sistema de órdenes de trabajo.

Creación y edición de contenidos.

También se requiere Prompt Engineering para la creación y edición de contenido. ChatGPT ayuda a los usuarios a escribir excelentes publicaciones de blog, correos electrónicos y trabajos creativos.

Al proporcionar indicaciones específicas y detalladas, los usuarios pueden ayudar a ChatGPT a desarrollar texto que coincida con su estilo, tono y objetivos. Las sugerencias pueden proporcionar información general, ejemplos o restricciones claras para garantizar que el contenido generado cumpla con los requisitos.

OpenAI realizó una investigación sobre Prompt Engineering para mejorar la coherencia y relevancia del contenido, permitiendo a los usuarios generar texto más atractivo y relevante para el tema al probar diferentes mensajes y ahorrar tiempo de edición.

Recuperación de conocimientos específicos de un dominio

Prompt Engineering puede recuperar de manera eficiente conocimientos específicos de un dominio. ChatGPT se puede entrenar con grandes cantidades de datos específicos de un dominio para proporcionar información sobre temas precisa y relevante.

Los usuarios pueden guiar a ChatGPT para recuperar conocimientos en campos específicos personalizando indicaciones y agregando palabras clave o contexto. En sectores como el sanitario, el jurídico, el financiero y el tecnológico, la información precisa es fundamental.

Las estrategias de Prompt Engineering facilitan la recuperación de conocimientos específicos del dominio, proporcionando a los usuarios información precisa y actualizada.

Narración interactiva y juegos.

Prompt Engineering hace que la narración interactiva y los juegos sean más divertidos. ChatGPT responde a las aportaciones del usuario e impulsa la historia.

Los usuarios pueden utilizar Prompt para crear historias y juegos inmersivos, introduciendo elementos de la historia, elecciones del usuario o mecánicas del juego. La cadena de mensajes y el diálogo de varios turnos logran una rica narrativa e interacción en el juego.

Estudio de caso: AI Dungeon de OpenAI muestra cómo Prompt Engineering puede transformar la narración y los juegos interactivos. AI Dungeon permite a los usuarios coparticipar en una narrativa dinámica a través de indicaciones.

Qué significa ChatGPT Prompt Engineering para los desarrolladores

Deep Learning AI lanzó recientemente un curso llamado "ChatGPT Prompt Engineering for Developers", impartido por Isa Fulford y Andrew Ng (Ng Enda).

Cursos cortos  https://www.deeplearning.ai/short-courses/?continueFlag=40c2724537472cbb3553ce1582e0db80

https://www.deeplearning.ai/short-courses/?continueFlag=40c2724537472cbb3553ce1582e0db80

En el curso, enfatizan el potencial de los grandes modelos de lenguaje (LLM) como herramientas de desarrollo, aprovechando las llamadas API a los LLM para el desarrollo rápido de aplicaciones de software, algo que aún no ha recibido suficiente atención. Su objetivo es compartir posibilidades y mejores prácticas para el uso eficaz de los LLM. El curso cubre las mejores prácticas rápidas para el desarrollo de software, así como casos de uso diario como resumen, razonamiento, transformación y expansión, y demuestra cómo usar LLM para crear chatbots.

El modelo ChatGPT de OpenAI se utiliza principalmente en el curso, especialmente GPT 3.5 Turbo, y Python (especialmente en Jupyter Notebook) se utiliza para demostraciones.

Estas son algunas de las cosas aprendidas:

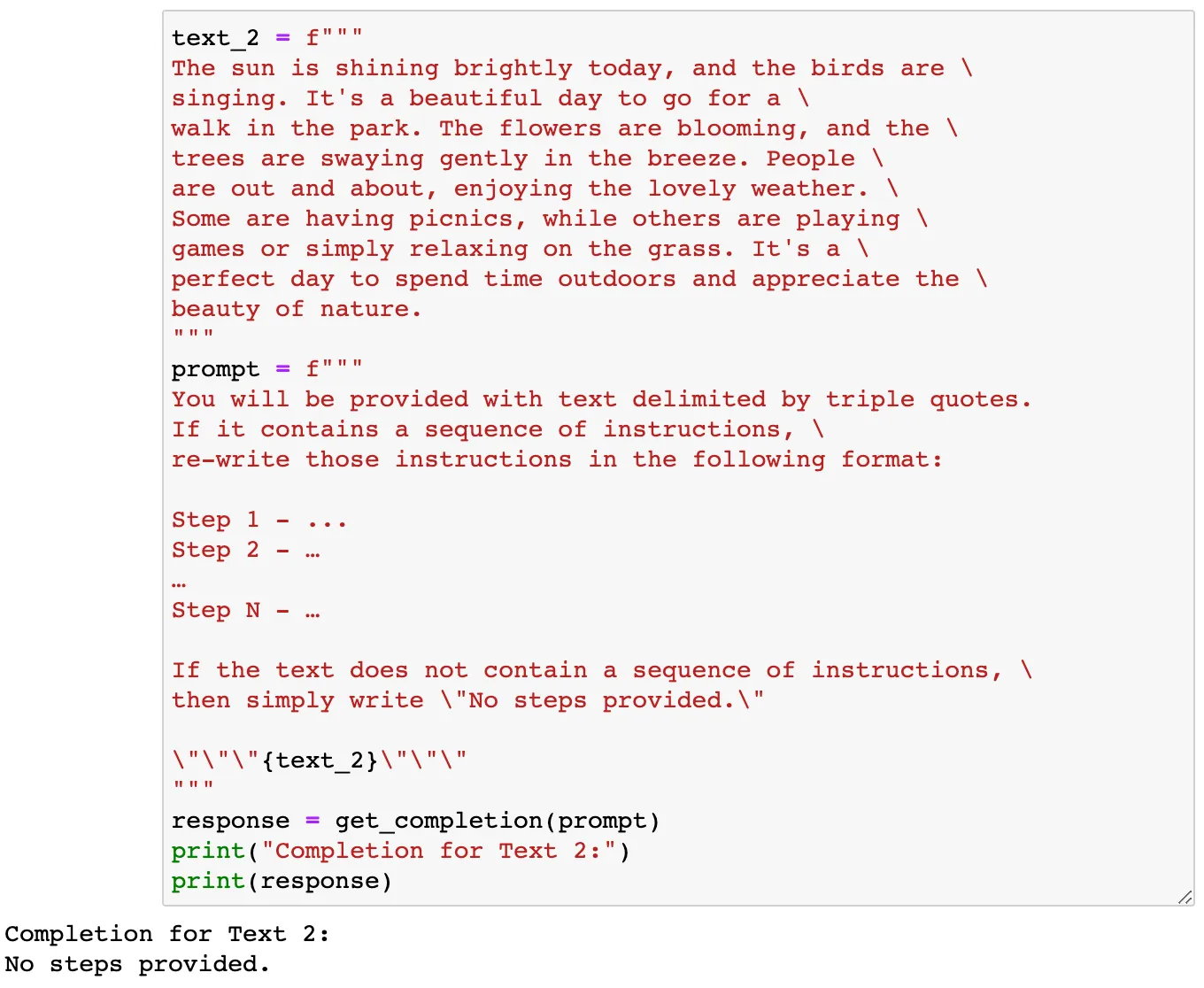

Dos principios:

Principio 1: escriba instrucciones claras y específicas

Articular instrucciones claras e inequívocas es crucial para guiar eficazmente el modelo y reducir la posibilidad de respuestas irrelevantes o incorrectas. Evite confundir indicaciones claras con indicaciones breves, ya que las indicaciones más largas generalmente brindan más claridad y contexto, lo que da como resultado resultados detallados y relevantes.

- Estrategia 1: utilizar delimitadores para indicar diferentes partes de la entrada, como comillas triples ('''), tres comillas invertidas ('*'), tres guiones (' — -'), corchetes angulares (‹ ›) o etiquetas XML. (<etiqueta› ‹/etiqueta›). Los delimitadores también ayudan a evitar la inyección rápida, donde las instrucciones de usuario inconsistentes pueden engañar al modelo.

text = f"""

You should express what you want a model to do by \

providing instructions that are as clear and \

specific as you can possibly make them. \

This will guide the model towards the desired output, \

and reduce the chances of receiving irrelevant \

or incorrect responses. Don't confuse writing a \

clear prompt with writing a short prompt. \

In many cases, longer prompts provide more clarity \

and context for the model, which can lead to \

more detailed and relevant outputs.

"""

prompt = f"""

Summarize the text delimited by triple backticks \

into a single sentence.

```{text}```

"""- Estrategia 2: solicitar resultados estructurados, como formato HTML o JSON, para facilitar el análisis de las respuestas del modelo. Esto hace que las respuestas del modelo sean más fáciles de procesar y extraer información.

prompt = f"""

Generate a list of three made-up book titles along \ with their authors and genres.

Provide them in JSON format with the following keys: book_id, title, author, genre.

"""

response = get completion (prompt)

print (response)

- Estrategia 3: verificar si se cumplen los requisitos previos de la tarea. Primero, el modelo Prompt verifica estas condiciones previas y señala cualquier condición no cumplida sin intentar completar la tarea por completo. Considere posibles casos extremos y asegúrese de que su modelo pueda manejarlos adecuadamente para evitar errores o resultados inesperados. Esto aumenta la fiabilidad y robustez del modelo.

- Estrategia 4: aprovechar sugerencias breves para proporcionar ejemplos de tareas realizadas con éxito antes de pedirle al modelo que realice la tarea requerida. Utilice ejemplos para que el modelo sepa cómo manejar tareas similares y proporciónele la orientación necesaria. Esto acelera el aprendizaje y la adaptabilidad del modelo, lo que facilita comprender la intención del usuario y generar respuestas precisas.

prompt = f"""

Your task is to answer in a consistent style.

<child>: Teach me about patience.

<grandparent>: The river that carves the deepest \ valley flows from a modest spring; the \ grandest symphony originates from a single note; \ the most intricate tapestry begins with a solitary thread.

<child>: Teach me about resilience.

"""

response = get completion (prompt)

print (response)

Principio 2: Dale al modelo suficiente tiempo para pensar.

Deje suficiente tiempo para que el modelo piense y razone sobre el problema para evitar errores de razonamiento y conclusiones prematuras. Las tareas complejas pueden requerir una guía paso a paso o una secuencia de pasos de inferencia relacionados antes de que el modelo pueda proporcionar una respuesta final.

- Estrategia 1: Sea claro acerca de los pasos para completar la tarea, especialmente si responder directamente es difícil. Al igual que los humanos resolviendo problemas, el modelo debe seguir una serie de pasos de razonamiento adecuados antes de proporcionar una solución final. Esto asegura que el modelo piense y razone completamente antes de generar una respuesta, mejorando así la precisión y plausibilidad de sus respuestas.

prompt 2 = f"""

Your task is to perform the following actions:

1 - Summarize the following text delimited by <> with 1 sentence.

2 - Translate the summary into French.

3 - List each name in the French summary.

4 - Output a json object that contains the following keys: french_ summary, num names.

Use the following format:

Text: <text to summarize>

Summary: <summary>

Translation: <summary translation>

Names: <list of names in Italian summary>

Output JSON: <ison with summary and num names>

Text: <{text!>

response = get_completion (prompt_2)

print "InCompletion for prompt 2:")

print (response)

- Estrategia 2: Indique al modelo que encuentre una solución antes de llegar a una conclusión. Instruir explícitamente al modelo para que razone y piense antes de dar una respuesta a menudo produce mejores resultados. Este enfoque le da al modelo tiempo suficiente para procesar y obtener una respuesta precisa.

Siguiendo estos principios y estrategias, los desarrolladores pueden optimizar el uso de LLM y lograr los resultados deseados en el desarrollo de software. Esto mejora el rendimiento y la flexibilidad del modelo para satisfacer mejor las necesidades del usuario.

Desarrollo rápido iterativo:

El proceso de desarrollo rápido iterativo es similar a la práctica de programación. Implica probar diferentes enfoques, mejorar según sea necesario y volver a intentarlo. Estos son los pasos a seguir:

- Pruebe una solución.

- Analizar los resultados para identificar cualquier discrepancia con los resultados esperados.

- Aclare las instrucciones y dé más tiempo para pensar.

- Utilice un lote de ejemplos para optimizar las indicaciones.

- Repita este proceso.

En un ejemplo de curso, los instructores presentaron un estudio de caso que implicaba generar textos de marketing a partir de especificaciones de producto. Resolvieron de forma iterativa tres problemas clave optimizando las indicaciones en cada paso:

Problema 1: El texto es demasiado largo -> Solución: Limitar el texto a un máximo de 50 palabras.

Problema 2: centrarse en detalles irrelevantes -> Solución: incluir el público objetivo, por ejemplo, "La descripción es para un minorista de muebles..."

Problema 3: Falta la tabla de tallas -> Solución: Formatee todo en HTML.

Habilidades:

Resumen de lectura:

Los modelos de lenguaje grandes se han utilizado ampliamente para el resumen de textos. Puede solicitar un resumen del precio y el valor proporcionando un mensaje específico.

prompt = f"""

Your task is to generate a short summary of a product \

review from an ecommerce site to give feedback to the \

pricing deparmtment, responsible for determining the \

price of the product.

Summarize the review below, delimited by triple

backticks, in at most 30 words, and focusing on any aspects \

that are relevant to the price and perceived value.

Review: ```{prod_review}```

"""Y también puedes escribir un bucle para resumir varios textos:

reviews = [review_1, review_2, review_3, review_4]

for i in range(len(reviews)):

prompt = f"""

Your task is to generate a short summary of a product \

review from an ecommerce site.

Summarize the review below, delimited by triple \

backticks in at most 20 words.

Review: ```{reviews[i]}```

"""

response = get_completion(prompt)

print(i, response, "\n")razonamiento:

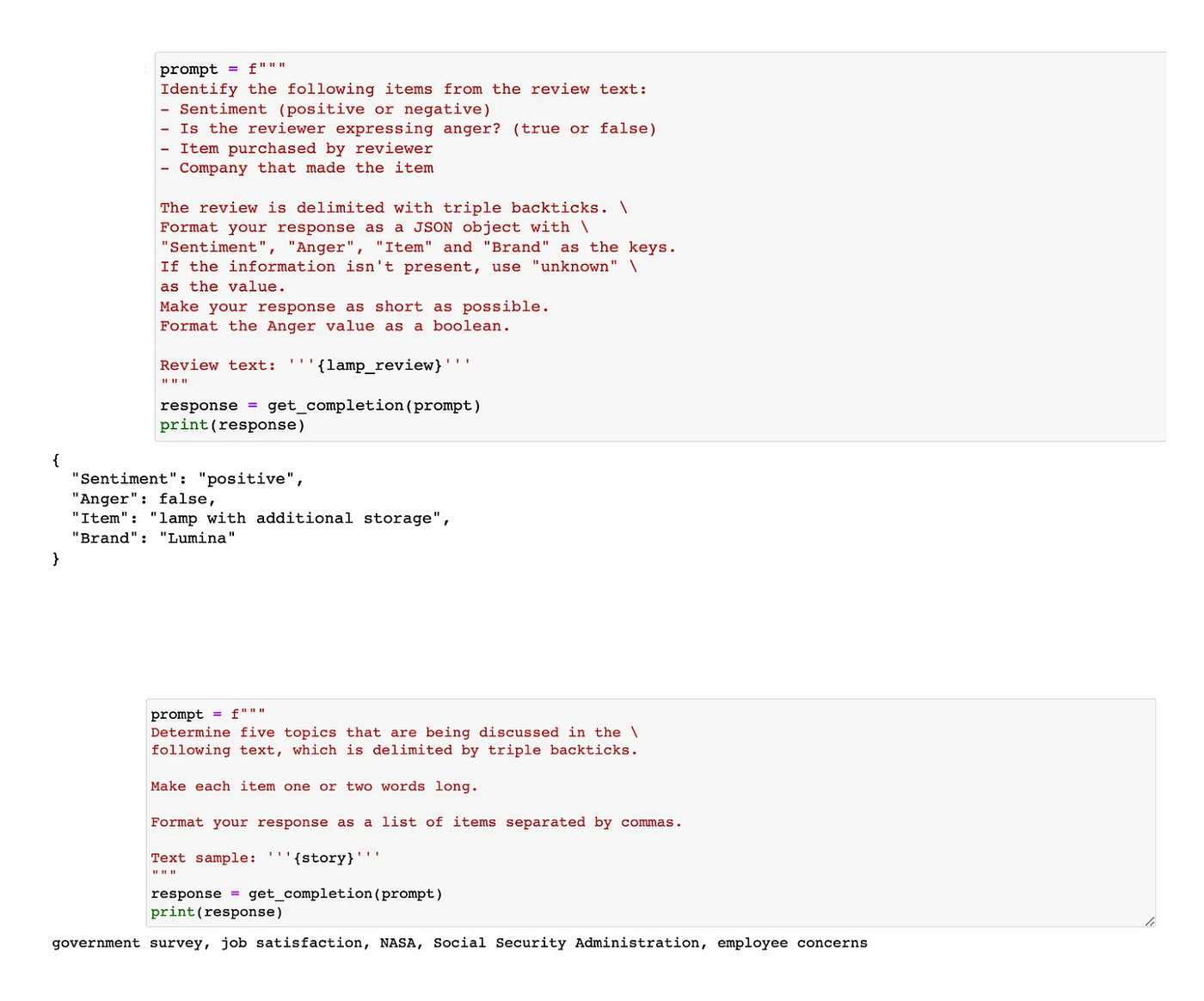

Los modelos de lenguaje grandes pueden inferir varios aspectos sin una formación específica. Pueden determinar emociones, emociones, extraer nombres de productos y empresas, buscar temas y más.

Conversión:

Los modelos de lenguaje grandes se destacan en tareas de transformación de texto, incluida la traducción de idiomas, la revisión ortográfica y gramatical, el ajuste de tono y la conversión de formato.

prompt = f"""

Translate the following text to French and Spanish and English pirate: \

```I want to order a basketball```

"""

response = get completion (prompt)

print response

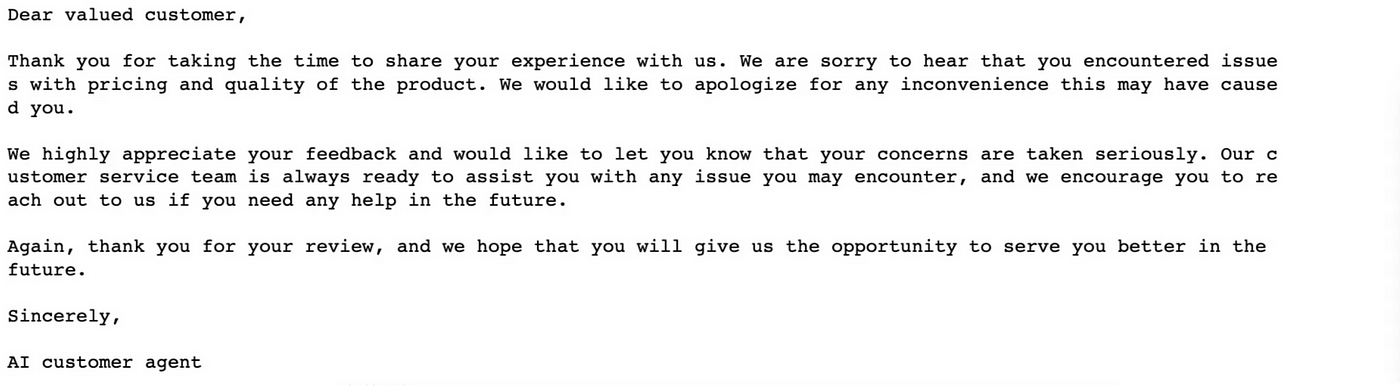

Extensiones:

Los modelos de lenguaje grandes pueden generar correos electrónicos de servicio al cliente personalizados adaptados a las calificaciones de cada cliente.

prompt = f"""

You are a customer service AI assistant.

Your task is to send an email reply to a valued customer.

Given the customer email delimited by ```,\

Generate a reply to thank the customer for their review.

If the sentiment is positive or neutral, thank them for \

their review.

If the sentiment is negative, apologize and suggest that \

they can reach out to customer service.

Make sure to use specific details from the review.

Write in a concise and professional tone.

Sign the email as `AI customer agent`.

Customer review: ```{review}```

Review sentiment: (sentiment}

"""

response = get completion (prompt, temperature=0.7)

print(response)

Desarrollar un chatbot:

Uno de los aspectos fascinantes de aprovechar modelos de lenguaje grandes es la facilidad con la que se pueden crear chatbots personalizados. La interfaz web de ChatGPT proporciona una plataforma de conversación respaldada por un potente modelo de lenguaje. Sin embargo, lo realmente interesante es aprovechar el poder de los grandes modelos lingüísticos para crear sus propios chatbots, como agentes de servicio al cliente con IA para restaurantes o robots de pedidos con IA.

En este caso, llamaremos a este chatbot "OrderBot". El objetivo es recopilar automáticamente las indicaciones del usuario y las respuestas del asistente para crear este eficiente "OrderBot". El paso principal es definir una función de utilidad. Esta función ayuda a recopilar mensajes de los usuarios, eliminando la necesidad de ingresarlos manualmente. Las indicaciones recopiladas desde la interfaz de usuario se agregan a una lista llamada "contexto". Posteriormente, para cada interacción, se llama al modelo utilizando este contexto.

Las respuestas del modelo se agregan al contexto, lo que garantiza que tanto los mensajes del modelo como los del usuario se conserven, lo que ayuda a que el contexto crezca. La acumulación de esta información permite al modelo determinar las acciones apropiadas.

Finalmente, configure y ejecute la interfaz de usuario para mostrar OrderBot. El contexto contiene mensajes del sistema, contiene menús y es coherente en cada interacción con el modelo de lenguaje. A medida que ocurren más interacciones, el contexto continúa evolucionando, manteniendo un registro completo de la conversación.

Resumir

Prompt Engineering cambia las reglas del juego para ChatGPT. Al dominar esta técnica, podrá dar forma y guiar las respuestas del modelo lingüístico para satisfacer sus necesidades específicas.

El futuro parece prometedor para Prompt Engineering, con una investigación y colaboración continuas que impulsan la innovación en el campo. A medida que los modelos de lenguaje continúen evolucionando, Prompt Engineering desempeñará un papel clave para desbloquear todo su potencial.

La ingeniería rápida de ChatGPT abre infinitas posibilidades. Al implementar técnicas efectivas y explorar estrategias avanzadas, podemos cambiar la forma en que interactuamos con los modelos de lenguaje. Prompt Engineering transforma los chatbots de servicio al cliente, el desarrollo de contenidos y los juegos, facilitando la colaboración entre la IA y los humanos.

Preguntas más frecuentes

¿Qué es la ingeniería rápida?

Prompt Engineering es el proceso de diseñar indicaciones e instrucciones efectivas para comunicar la intención del usuario a modelos de lenguaje como ChatGPT. Ayuda a obtener respuestas precisas, relevantes y útiles del modelo.

¿Por qué es importante la ingeniería rápida para ChatGPT?

La ingeniería rápida es fundamental para maximizar la eficacia de ChatGPT. Al diseñar indicaciones cuidadosamente diseñadas, los usuarios pueden guiar el modelo para producir resultados más precisos y relevantes, lo que lo convierte en una herramienta valiosa para una variedad de aplicaciones.

¿Cuáles son algunas buenas técnicas de ingeniería rápida?

Los buenos consejos de ingeniería rápida incluyen:

- Proporcionar instrucciones claras y específicas.

- Utilice restricciones explícitas

- Intente usar contexto y ejemplos.

- Explotación de problemas del Sistema 1 y del Sistema 2

- Controlar la verbosidad de la salida

¿Cómo puedo mejorar mi indicación para obtener mejores resultados?

Para mejorar sus indicaciones puede:

- Pruebe y ajuste repetidamente

- Equilibre la intención del usuario y la creatividad del modelo

- Mejore las capacidades de ChatGPT con recursos externos y API

- Garantizar que se evite el sesgo en las indicaciones y resultados.

También hay una hoja de referencia de indicaciones de ChatGPT para ayudarle a redactar mejores indicaciones.

¿Cuáles son las estrategias avanzadas de Prompt Engineering?

Las estrategias avanzadas de ingeniería rápida incluyen:

- Ajuste la aleatoriedad y la duración de la respuesta controlando la temperatura y la configuración del token

- Cree múltiples rondas de diálogo a través de Prompt Chain

- Ajustar las indicaciones a aplicaciones específicas del dominio

- Manejar entradas de usuario ambiguas o inconsistentes

posdata

Gracias por leer. Este artículo es muy largo. También sé que si puedes leer esto, significa que eres consciente de la importancia de Prompt Engineering y esperas dominar sus habilidades. No tengo talento y todavía estoy aprendiendo. Como personal de desarrollo, puede ser más fácil comprender y dominar técnicas de ingeniería como la iteración, la cadena (Cadena) y los parámetros de control. La mayoría de los artículos aquí están traducidos del siguiente artículo.

Guía definitiva de ingeniería rápida de ChatGPT para desarrolladores

Estoy muy agradecido con el autor del artículo original, aprendí mucho de él y también utilicé muchas técnicas rápidas en el artículo original para completar algunos ejemplos de este artículo. Si desea intercambiar consejos sobre Prompt Engineering y Prompt, no dude en ponerse en contacto conmigo.