1. Descripción

Este es un artículo raro que se queja sobre el mecanismo de atención. Hay muchas ideas únicas en el artículo. Independientemente de si sus puntos de vista son correctos o no, podemos sentarnos, escuchar en silencio y pensar con cuidado, lo que inspirará nuestra comprensión y comprensión. del problema Elevar el nivel de conciencia.

dos, el texto

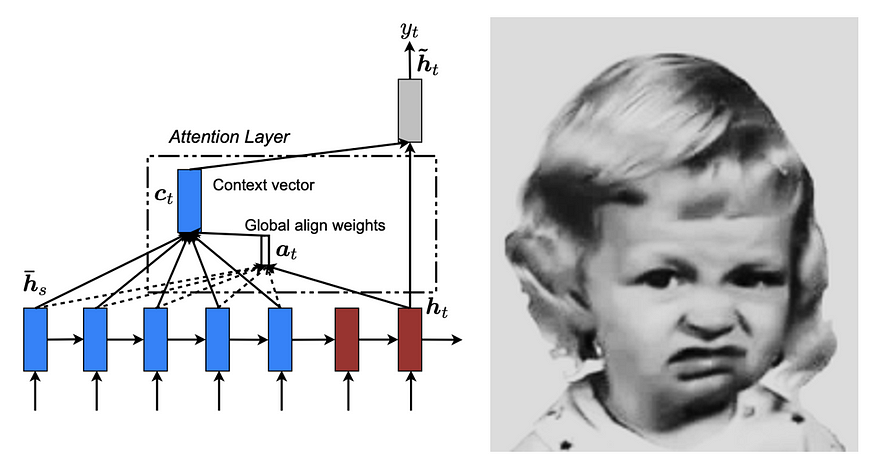

Érase una vez, en el mundo de la inteligencia artificial, los investigadores creían que "la atención es todo lo que necesitas" era la clave para crear máquinas inteligentes. Creen que al incorporar mecanismos de atención en su modelo, pueden crear sistemas que comprendan y procesen información como el cerebro humano.

Los investigadores han trabajado incansablemente para desarrollar nuevos modelos y algoritmos que incorporen mecanismos de atención. Están convencidos de que están a las puertas de crear una verdadera inteligencia artificial. Pero a pesar de sus mejores esfuerzos, el sistema que crearon estaba lejos de ser perfecto.

Un día, una joven investigadora llamada Alice decidió echar un vistazo más de cerca al sistema que habían creado. Observó que si bien los mecanismos de atención permiten que los sistemas se concentren en ciertos aspectos de la información que están procesando, aún les falta información importante.

Alice se da cuenta de que la atención por sí sola no es suficiente. El sistema debe ser capaz de considerar el contexto y la relación entre la información diferente. Se propuso desarrollar nuevos modelos que incorporen no solo la atención, sino también una forma de comprender el contexto y las relaciones entre diferentes piezas de información.

El nuevo modelo es un gran avance. Estos sistemas ahora pueden comprender y procesar información de una manera que se parece más al cerebro humano. Son capaces de hacer predicciones más precisas que tienen en cuenta los matices de la información que están procesando.

Sorprendidos por los hallazgos de Alice, los investigadores rápidamente se dieron cuenta de que "la atención no es todo lo que necesitas". Entienden que para crear máquinas verdaderamente inteligentes, necesitan considerar no solo la atención sino también el contexto y las relaciones. Desde ese día, han trabajado para desarrollar modelos que realmente puedan imitar el cerebro humano.

Alicia dijo:

La combinación de contexto y relaciones significa que los modelos de IA no solo consideran piezas de información individuales, sino también las relaciones entre ellas y el contexto más amplio en el que se presentan. Esto permite que los sistemas de IA comprendan los matices y las sutilezas de la información que procesan, lo que hace que sus predicciones y decisiones sean más precisas y humanas. Por ejemplo, en el procesamiento del lenguaje natural, al conocer el contexto de una oración y las relaciones entre palabras y frases dentro de ella, un modelo de IA puede comprender mejor el significado de la oración. En el reconocimiento de imágenes, un modelo de IA que incorpora contexto y relaciones puede comprender los objetos en una imagen y cómo están relacionados, lo que le ayuda a reconocer escenas.

Alice publicó esta idea en un artículo de Nature el 05 de mayo de 2025, pero después de un tiempo resultó que todo lo que contenía era una mentira y solo un producto de su mente enferma. Ella provocó la ira de los investigadores de IA y, finalmente, después de un período de silencio, publicó su segundo artículo a nombre de Bob, "Atención, el vórtice en el que caes.

Si leíste el artículo anterior , probablemente pensaste que Alice era un fraude científico. pero no es la verdad.

En su segundo artículo, " Atención, el vórtice en el que te metes ", Bob (anteriormente Alice) reflexiona sobre la idea de que "la atención es todo lo que necesitas" y cómo se ha convertido en una especie de concepto erróneo popular. Bob argumenta que si bien los mecanismos de atención son importantes, también pueden conducir a un enfoque estrecho en ciertos aspectos de la información mientras se ignora una perspectiva más amplia.

La atención puede ser engañosa, explicó Bob, lo que lleva a los investigadores por el camino de la simplificación excesiva e ignora otros elementos clave. Así como los vórtices pueden atrapar cosas en espacios reducidos, la atención enfocada puede hacer que los investigadores de IA pierdan información importante.

Bob tiene un dicho dorado. Estudiar los mecanismos de atención es como estar atrapado en un pantano, cuanta más agua atraviesas, más rápido te hundes.

Bob mencionó cinco problemas de atención:

Enfoque estrecho: Centrarse únicamente en la atención conduce a una perspectiva estrecha y limitada, perdiendo el panorama general.

Simplificación excesiva: los mecanismos de atención pueden conducir a una simplificación excesiva , lo que hace que los investigadores pasen por alto otros elementos importantes.

Campo de visión limitado : un solo foco de atención es como estar atrapado en un pantano, lo que limita la visión y la capacidad de comprender el panorama general.

Predicciones inexactas: los sistemas de IA que dependen únicamente de los mecanismos de atención pueden hacer predicciones inexactas debido a la falta de información importante .

Falta de exhaustividad : la creación de máquinas verdaderamente inteligentes requiere un enfoque integral para el desarrollo de IA que incorpore otros factores además de la atención.

El artículo de Bob se publicó en una revista menos importante. Su artículo no causó mucho revuelo.

De hecho, ¿por qué los investigadores no han notado este artículo crítico? Bob, o ex-Alice, sabía que todos los ataques del primero se estaban llevando a cabo bajo la supervisión de su exesposo George Petrovich, ampliamente considerado como el padrino de la mafia del mecanismo de atención .

Petrovich ha sido durante mucho tiempo un firme defensor de la filosofía de "atención es todo lo que necesita" y se opone con vehemencia a cualquier desafío a esa visión. Consideró la tesis de Alice un ataque directo al trabajo de su vida y estaba decidido a desacreditarlo.

Para agregar leña al fuego, Petrovic es el ex prometido de Alice. Se reveló que la pareja tuvo una ruptura tumultuosa y Petrovich todavía le guardaba rencor a Alice. Él ve esto como su oportunidad perfecta para vengarse.

Petrovic lanzó una campaña de desprestigio contra Alice, afirmando que el documento se basaba en una investigación fraudulenta y que Alice estaba detrás de todo. Incluso comenzó un complot de envenenamiento contra Alice en un intento de desacreditarla y socavar la credibilidad del periódico.

A pesar de la reacción violenta, Alice mantuvo sus hallazgos y su artículo continúa provocando discusión y debate en la comunidad de IA. El conflicto fue feroz, con Petrovich y sus seguidores de un lado y Alicia del otro. El debate de "atención versus contexto y relación" ha dividido a la comunidad sin un ganador claro a la vista.

Aunque este incidente se cuenta en forma de historia, no es un hecho científico. Pero mi experiencia muestra que la atención no es todo lo que necesitas.