recolectar

que es coleccion

Una colección es un contenedor para almacenar datos y solo puede almacenar tipos de referencia, por lo que una colección es muy adecuada para almacenar objetos. Y la colección tiene una longitud variable, por lo que es adecuado usar la colección cuando el número de objetos es incierto.

Características de la colección

1. Las colecciones solo pueden almacenar tipos de datos de referencia. Las colecciones se utilizan para almacenar objetos.

2. Se pueden usar matrices si se determina el número de objetos, y se pueden usar colecciones si el número de objetos es incierto. Porque las colecciones son de longitud variable.

La diferencia entre colecciones y arreglos

1. Los arreglos son de longitud fija, las colecciones son de longitud variable.

2. Los arreglos pueden almacenar tipos de datos básicos así como tipos de datos de referencia, las colecciones solo pueden almacenar tipos de datos de referencia.

3. Los elementos almacenados en la matriz deben ser del mismo tipo de datos, los objetos almacenados en la colección pueden ser de diferentes tipos de datos.

Beneficios de usar el marco de colecciones

- Reduce el trabajo de desarrollo, proporciona casi todos los tipos comunes de colecciones y métodos útiles para iterar y manipular datos, por lo que podemos centrarnos más en la lógica comercial en lugar de diseñar nuestra API de colección.

- Mejorar la calidad del código, el uso de clases de colección central bien probadas puede mejorar la calidad de nuestros programas, mejorar la solidez y la usabilidad del código.

- Reutilización e interoperabilidad

- Reduzca los costos de mantenimiento Al usar las clases de colección que vienen con el JDK, puede reducir los costos de mantenimiento del código

Sao Dai entiende: De hecho, las ventajas anteriores se deben al hecho de que si usamos la colección que viene con jdk, nuestra codificación será más estandarizada, como la colección ArrayList, que es una colección unificada y estandarizada que viene con jdk. , por lo que el método de esta colección, específicamente El uso es el mismo sin importar dónde, pero si cada uno de nosotros diseña su propia colección, en primer lugar, tomará mucho tiempo, y en segundo lugar, los nombres de método de las colecciones diseñadas por cada persona puede ser diferente, por lo que puede usarlo usted mismo, si otros también Si usa esto, debe ver cuál es la función de su nombre de método. Si él también escribe una colección como la suya y define un nombre de método diferente, será muy desordenado, así que use el que viene con jdk La colección será unificada y estandarizada, no tan desordenada como la anterior

¿Cuáles son las clases de colección comúnmente utilizadas?

La interfaz de mapa y la interfaz de colección son las interfaces principales de todos los marcos de colección:

Las subinterfaces de la colección Collection tienen tres subinterfaces: Set, List y Queue

Las clases de implementación de la interfaz Set incluyen principalmente: HashSet, TreeSet, LinkedHashSet, etc.

Las clases de implementación de la interfaz List incluyen principalmente: ArrayList, LinkedList, Stack y Vector, etc.

Las clases de implementación de la interfaz Queue incluyen principalmente: BlockingQueue, Deque, etc.

Las clases de implementación de la interfaz Map incluyen principalmente: HashMap, TreeMap, Hashtable, ConcurrentHashMap, etc.

Entendimiento de Sao Dai: tenga en cuenta que no hay TreeList

La estructura de datos subyacente del marco de recopilación

Colección colección tiene principalmente dos interfaces: Lista y Conjunto

1, lista

ArrayList : ArrayList se implementa en función de una matriz y su estructura de datos subyacente es una matriz mutable. Al insertar elementos, si la matriz está llena, debe expandirse. La forma de expandirse es crear una nueva matriz, copiar los elementos de la matriz original en la nueva matriz y luego insertar los nuevos elementos en la nueva matriz.

LinkedList : LinkedList se implementa en función de una lista vinculada y su estructura de datos subyacente es una lista doblemente vinculada. Al insertar un elemento, solo necesita modificar el puntero correspondiente en la lista vinculada, y no necesita copiar y expandir la matriz como ArrayList.

Vector : Vector es una clase de implementación de lista segura para subprocesos. Su estructura de datos subyacente es similar a ArrayList, y también es una matriz mutable. La diferencia es que los métodos de Vector están todos sincronizados, por lo que se puede garantizar la seguridad de los subprocesos.

Stack : Stack se implementa en función de Vector, que es una estructura de datos de último en entrar, primero en salir (LIFO) que admite operaciones push y pop.

Sao Dai entiende: Vector y Stack son clases seguras para subprocesos

2, conjunto

HashSet (desordenado, único) : basado en HashMap, el constructor predeterminado es construir un HashMap con una capacidad inicial de 16 y un factor de carga de 0,75. Un objeto HashMap se encapsula para almacenar todos los elementos de la colección.Todos los elementos de la colección colocados en el HashSet en realidad se guardan con la clave del HashMap, y el valor del HashMap almacena un PRESENTE, que es un objeto Object estático.

LinkedHashSet: LinkedHashSet hereda HashSet, y su interior es a través de LinkedHashMap

conseguir. Es un poco similar al LinkedHashMap que dijimos antes, que se implementa internamente en base a Hashmap, pero todavía hay una pequeña diferencia.

TreeSet (ordenado, único): árbol rojo-negro (árbol binario ordenado equilibrado)

3, mapa

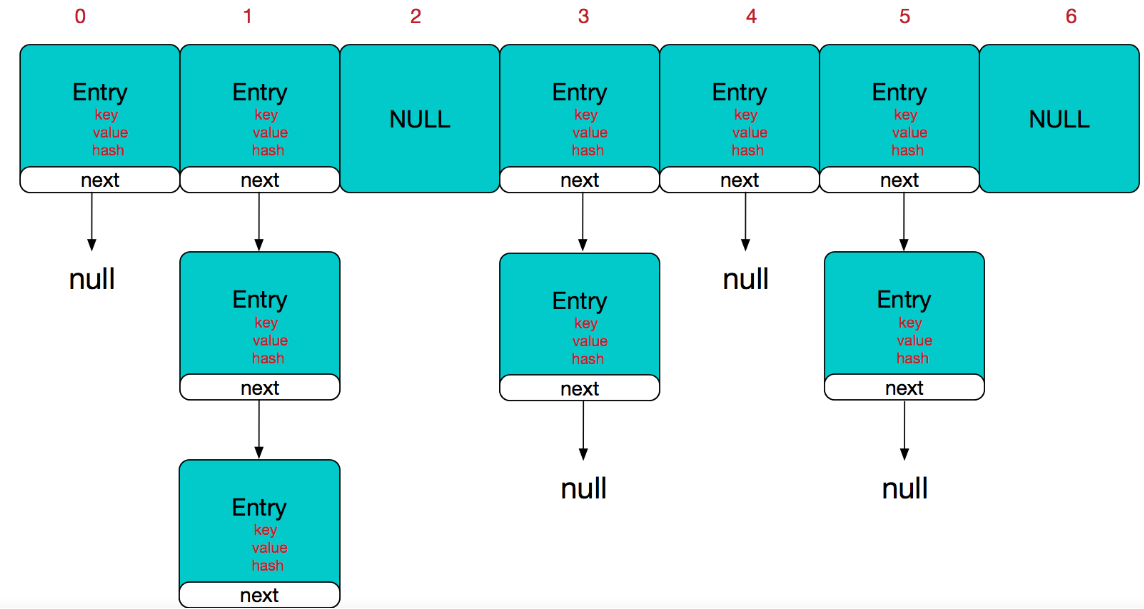

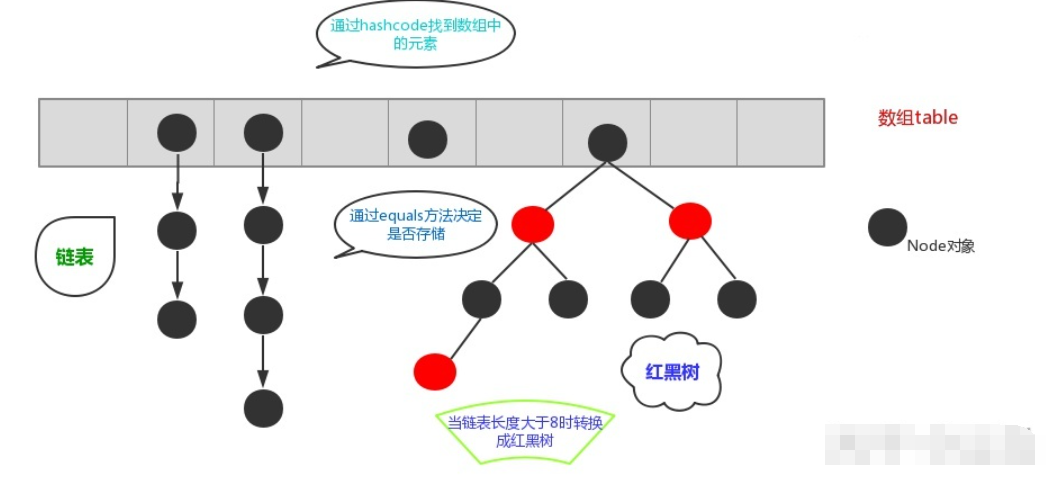

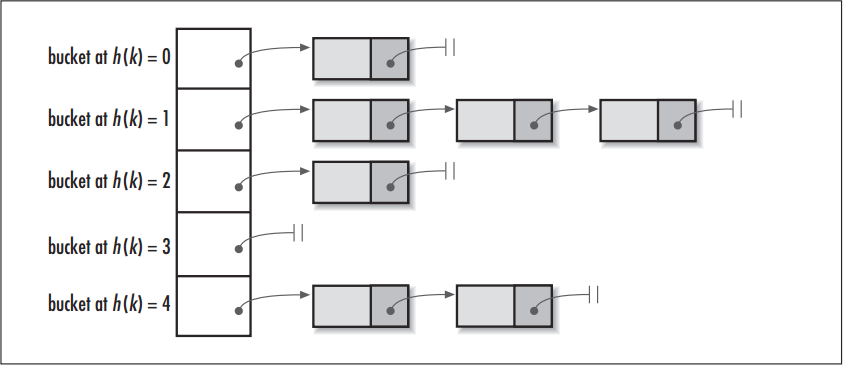

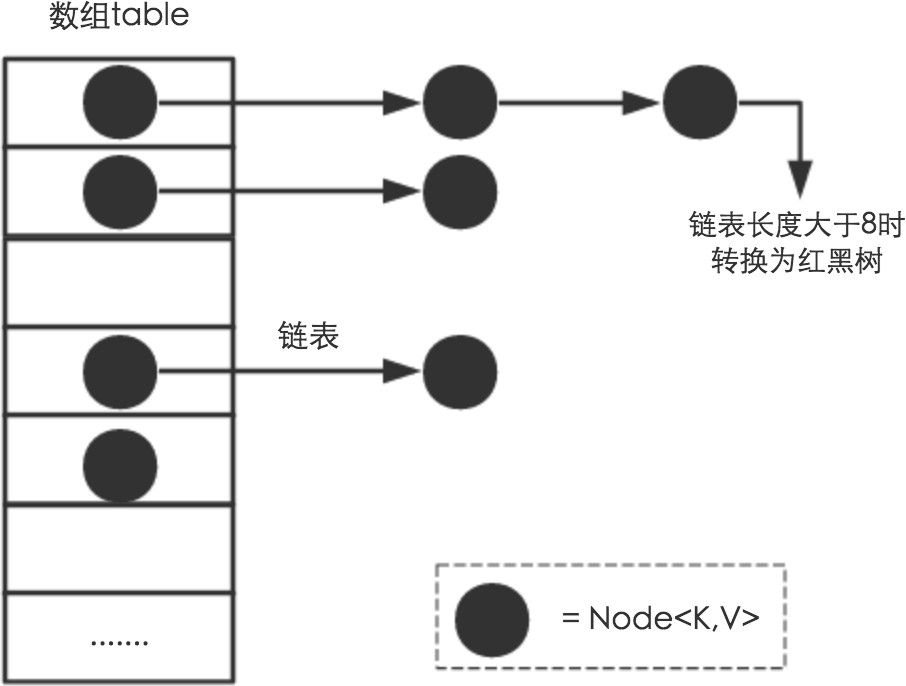

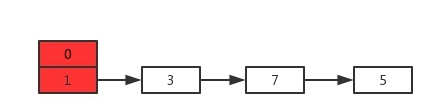

HashMap: antes de JDK1.8, HashMap se compone de matriz + lista vinculada. La matriz es el cuerpo principal de HashMap, y la lista vinculada existe principalmente para resolver conflictos hash ("método zip" para resolver conflictos). Después de JDK1.8, los conflictos hash se resuelven Cuando la longitud de la lista enlazada es mayor que el umbral (8 por defecto), la lista enlazada se convierte en un árbol rojo-negro para reducir el tiempo de búsqueda

LinkedHashMap: LinkedHashMap se hereda de HashMap, por lo que su capa inferior todavía se basa en la estructura hash de cremallera, que se compone de matrices y listas vinculadas o árboles rojo-negro. Además, sobre la base de la estructura anterior, LinkedHashMap agrega una lista doblemente enlazada para mantener el orden de inserción de los pares clave-valor. Al mismo tiempo, al realizar las operaciones correspondientes en la lista enlazada, se realiza la lógica relacionada con la secuencia de acceso.

HashTable : compuesta por matriz + lista vinculada, la matriz es el cuerpo principal de HashMap, y la lista vinculada existe principalmente para resolver conflictos hash

TreeMap : árbol rojo-negro (árbol binario ordenado con equilibrio automático)

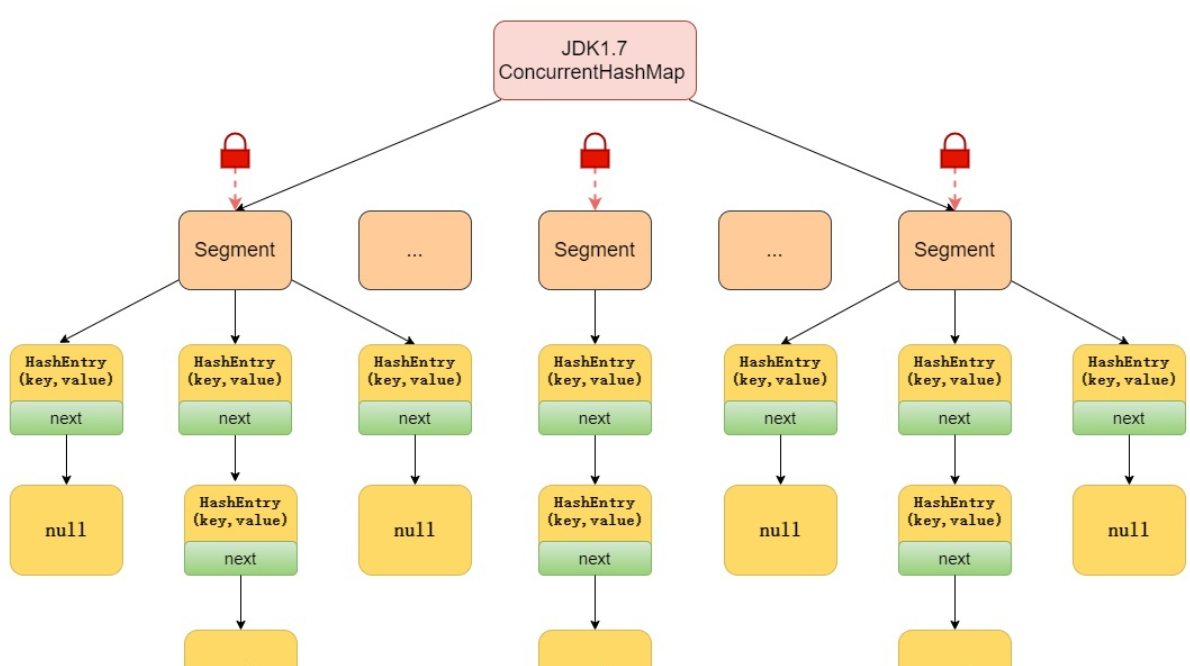

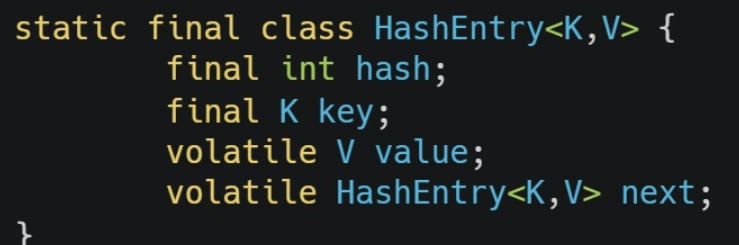

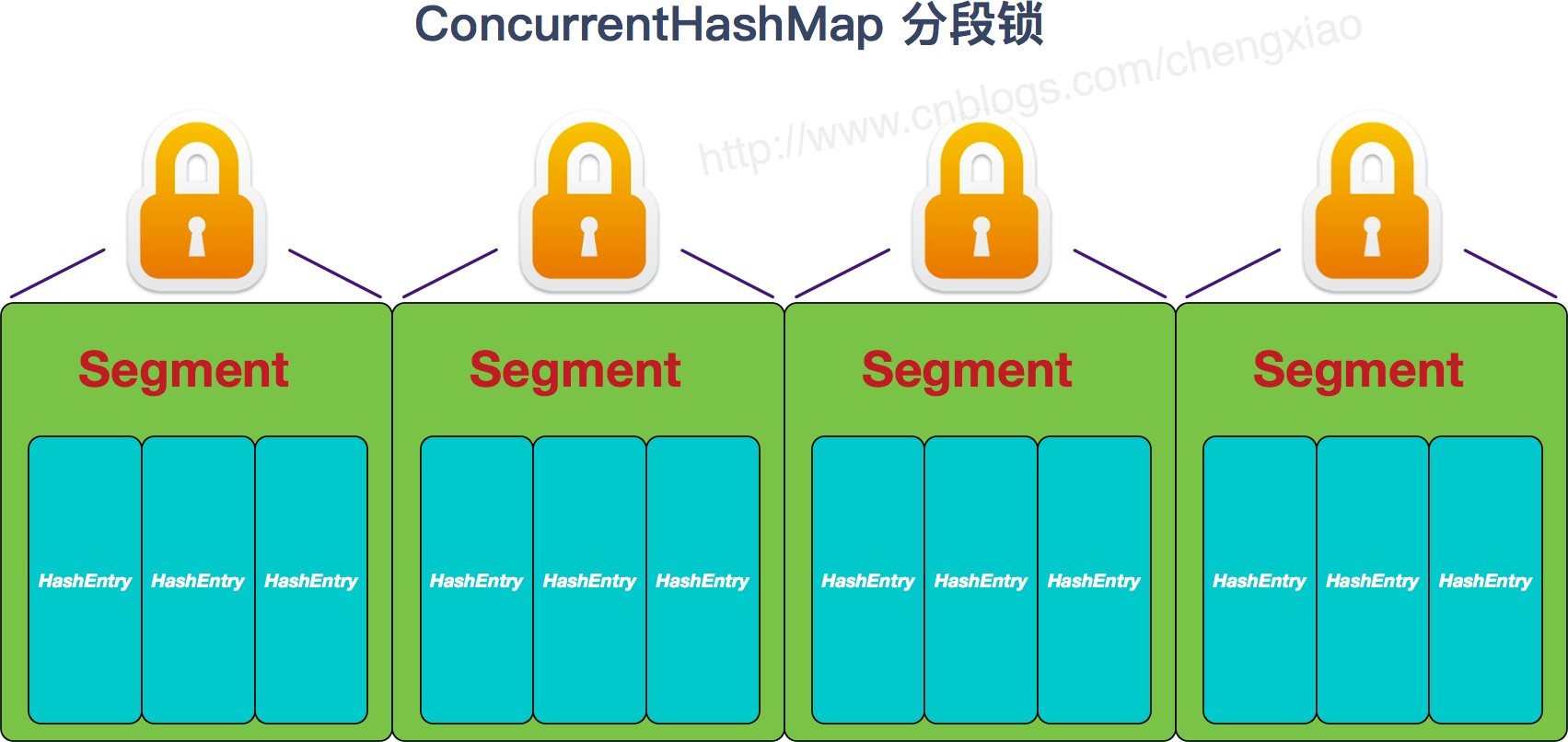

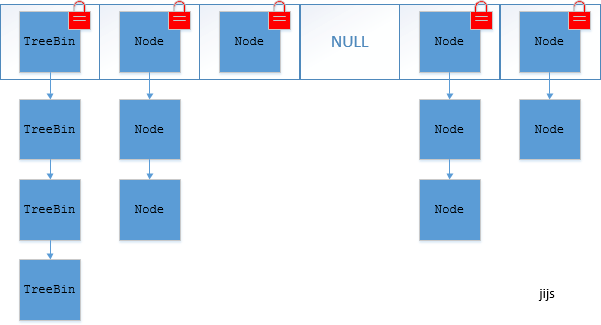

ConcurrentHashMap: una implementación de tabla hash segura para subprocesos en Java, cuya estructura de datos subyacente es una tabla hash de bloqueo segmentada. Específicamente, divide toda la tabla hash en varios segmentos, cada segmento es una tabla hash independiente y cada segmento tiene su propio bloqueo, por lo que se puede lograr el acceso simultáneo de subprocesos múltiples, lo que mejora el rendimiento de la concurrencia.

El tamaño de cada segmento se puede configurar por parámetros, el valor predeterminado es 16. En ConcurrentHashMap, cada elemento se almacena en un objeto de entrada, que contiene clave, valor y un puntero a la siguiente entrada. Cada segmento contiene una matriz de Entrada, y cada elemento de la matriz es el nodo principal de una lista vinculada, y cada lista vinculada almacena elementos con el mismo valor hash.

Al realizar operaciones como insertar, buscar y eliminar, primero debe encontrar el segmento correspondiente de acuerdo con el valor hash de la clave y luego realizar operaciones en este segmento. Dado que cada segmento tiene su propio bloqueo, diferentes subprocesos pueden acceder a diferentes segmentos al mismo tiempo, lo que mejora el rendimiento de la concurrencia.

En resumen, ConcurrentHashMap es una implementación de tabla hash segura para subprocesos en Java. Utiliza una tabla hash de bloqueo segmentada como estructura de datos subyacente, que puede lograr un acceso simultáneo eficiente de subprocesos múltiples.

¿Qué clases de colección son seguras para subprocesos? ¿Qué clases de colección no son seguras para subprocesos?

¿Qué clases de colección son seguras para subprocesos?

- Vector: siempre que se trate de una operación crítica, la palabra clave sincronizada se agrega delante del método para garantizar la seguridad del subproceso

- Hashtable: se usa la palabra clave sincronizada, por lo que es seguro para subprocesos en comparación con Hashmap.

- ConcurrentHashMap: utiliza tecnología de segmentación de bloqueo para garantizar la seguridad lineal, es una colección eficiente pero segura para subprocesos.

- Stack: Stack, que también es seguro para subprocesos, hereda de Vector.

¿Qué clases de colección no son seguras para subprocesos?

- mapa hash

- Lista de arreglo

- Lista enlazada

- HashSet

- ÁrbolConjunto

- ÁrbolMapa

Razones de la inseguridad del subproceso

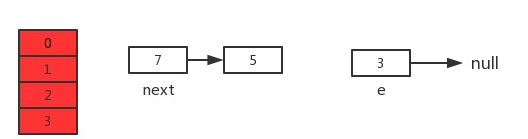

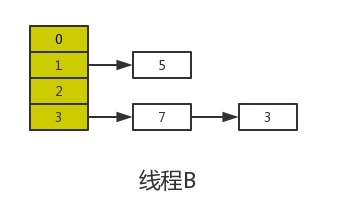

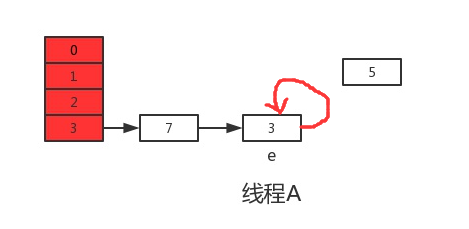

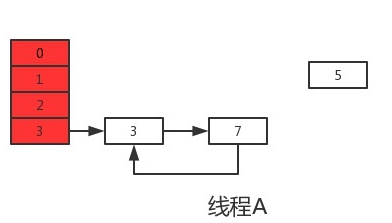

- Hashmap : durante la operación de colocación de HashMap, si el elemento insertado supera la capacidad (determinada por el factor de carga), se activará la operación de expansión, que es el cambio de tamaño, que volverá a convertir el contenido de la matriz original en la nueva expansión. matriz. En un entorno de subprocesos múltiples, otros elementos también realizan operaciones de colocación al mismo tiempo. Si el valor hash es el mismo, puede representarse mediante una lista vinculada debajo de la misma matriz al mismo tiempo, lo que da como resultado una matriz cerrada. bucle, lo que resulta en un bucle infinito al obtener, por lo que HashMap es un subproceso inseguro.

- Arraylist : cuando se agrega el objeto List, cuando se ejecuta Arrays.copyOf, se devuelve un nuevo objeto de matriz. Cuando los subprocesos A, B... ingresan al método de crecimiento al mismo tiempo, varios subprocesos ejecutarán el método Arrays.copyOf y devolverán múltiples objetos elementData diferentes. Si A regresa primero y B regresa después, entonces List.elementData ==A. elementData, si B también regresa al mismo tiempo, entonces List.elementData ==B.elementData, por lo que el subproceso B sobrescribe los datos del subproceso A, lo que hace que se pierdan los datos del subproceso A.

- LinkedList : similar al problema de seguridad de subprocesos de Arraylist, el problema de seguridad de subprocesos es causado por múltiples subprocesos que escriben o leen y escriben el mismo recurso al mismo tiempo.

- HashSet : la estructura de almacenamiento de datos subyacente adopta Hashmap, por lo que el problema de seguridad de subprocesos que generará Hashmap también ocurrirá en HashSet.

¿El mecanismo de falla rápida de la colección Java "falla rápido"?

¿Qué es el mecanismo de fallo rápido "fail-fast"?

El mecanismo de falla rápida, es decir, el mecanismo de falla rápida, es un mecanismo de detección de errores en la colección java (Colección).

Cuando varios subprocesos operan en el contenido de la misma colección, puede parecer que mientras un subproceso está iterando la colección, otro subproceso modifica el contenido de la colección, lo que generará un evento rápido y generará una ConcurrentModificationException Anormal, subproceso único También pueden ocurrir eventos de falla rápida.

Por ejemplo: cuando un subproceso A atraviesa una colección a través de un iterador, si el contenido de la colección es cambiado por otros subprocesos, entonces cuando el subproceso A accede a la colección, se lanzará una ConcurrentModificationException y se generará un evento de falla rápida. Pero debe tenerse en cuenta que el mecanismo de falla rápida no garantiza que se lanzará una excepción bajo la modificación asincrónica, solo hace todo lo posible para lanzarla, por lo que este mecanismo generalmente solo se usa para detectar errores.

La escena de aparición de fail-fast

El mecanismo de falla rápida puede aparecer en nuestras colecciones comunes de Java, como ArrayList y HashMap. La falla rápida es posible en entornos de subprocesos múltiples y de un solo subproceso.

a prueba de fallas en un entorno de un solo subproceso

public static void main(String[] args) {

List<String> list = new ArrayList<>();

for (int i = 0 ; i < 10 ; i++ ) {

list.add(i + "");

}

Iterator<String> iterator = list.iterator();

int i = 0 ;

while(iterator.hasNext()) {

if (i == 3) {

list.remove(3);

}

System.out.println(iterator.next());

i ++;

}

}Este fragmento de código define una colección de Arraylist y utiliza iteradores para recorrerla. Durante el proceso de recorrido, se elimina deliberadamente un elemento en un determinado paso de la iteración. En este momento, se producirá una falla rápida.

public static void main(String[] args) {

Map<String, String> map = new HashMap<>();

for (int i = 0 ; i < 10 ; i ++ ) {

map.put(i+"", i+"");

}

Iterator<Entry<String, String>> it = map.entrySet().iterator();

int i = 0;

while (it.hasNext()) {

if (i == 3) {

map.remove(3+"");

}

Entry<String, String> entry = it.next();

System.out.println("key= " + entry.getKey() + " and value= " + entry.getValue());

i++;

}

}Este fragmento de código define un objeto hashmap y almacena pares clave-valor de 10. Durante el proceso de recorrido iterativo, se elimina un elemento utilizando el método de eliminación del mapa, lo que genera una ConcurrentModificationException.

En un entorno de subprocesos múltiples

public class FailFastTest {

public static List<String> list = new ArrayList<>();

private static class MyThread1 extends Thread {

@Override

public void run() {

Iterator<String> iterator = list.iterator();

while(iterator.hasNext()) {

String s = iterator.next();

System.out.println(this.getName() + ":" + s);

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

super.run();

}

}

private static class MyThread2 extends Thread {

int i = 0;

@Override

public void run() {

while (i < 10) {

System.out.println("thread2:" + i);

if (i == 2) {

list.remove(i);

}

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

i ++;

}

}

}

public static void main(String[] args) {

for(int i = 0 ; i < 10;i++){

list.add(i+"");

}

MyThread1 thread1 = new MyThread1();

MyThread2 thread2 = new MyThread2();

thread1.setName("thread1");

thread2.setName("thread2");

thread1.start();

thread2.start();

}

}Inicie dos subprocesos, un subproceso 1 itera la lista y el otro subproceso 2 elimina un elemento durante el proceso de iteración del subproceso 1, y el resultado también arroja java.util.ConcurrentModificationException

Lo anterior mencionado en el caso de una falla rápida causada por el cambio de estructura de la colección causado por la eliminación.Si la estructura de la colección cambia debido a la adición, también ocurrirá una falla rápida, por lo que no daré un ejemplo aquí.

Análisis del principio de implementación

final void checkForComodification() {

if (modCount != expectedModCount)

throw new ConcurrentModificationException();

}Se puede ver que este método es la clave para juzgar si lanzar ConcurrentModificationException.

En este código, cuando modCount != ExpectedModCount, se lanzará la excepción. Pero al principio, el valor inicial de addedModCount es igual a modCount por defecto, ¿por qué aparece modCount != ExpectedModCount?

Es obvio que el valor ModCount esperado no se ha modificado en ninguna parte, excepto por el valor inicial modCount en todo el proceso de iteración, y es imposible cambiarlo, por lo que solo puede cambiar modCount. A continuación, echemos un vistazo a cuándo "modCount no es igual al ModCount esperado" a través del código fuente y veamos cómo se modifica modCount a través del código fuente de ArrayList.

package java.util;

public class ArrayList<E> extends AbstractList<E>

implements List<E>, RandomAccess, Cloneable, java.io.Serializable

{

...

// list中容量变化时,对应的同步函数

public void ensureCapacity(int minCapacity) {

modCount++;

int oldCapacity = elementData.length;

if (minCapacity > oldCapacity) {

Object oldData[] = elementData;

int newCapacity = (oldCapacity * 3)/2 + 1;

if (newCapacity < minCapacity)

newCapacity = minCapacity;

// minCapacity is usually close to size, so this is a win:

elementData = Arrays.copyOf(elementData, newCapacity);

}

}

// 添加元素到队列最后

public boolean add(E e) {

// 修改modCount

ensureCapacity(size + 1); // Increments modCount!!

elementData[size++] = e;

return true;

}

// 添加元素到指定的位置

public void add(int index, E element) {

if (index > size || index < 0)

throw new IndexOutOfBoundsException(

"Index: "+index+", Size: "+size);

// 修改modCount

ensureCapacity(size+1); // Increments modCount!!

System.arraycopy(elementData, index, elementData, index + 1,

size - index);

elementData[index] = element;

size++;

}

// 添加集合

public boolean addAll(Collection<? extends E> c) {

Object[] a = c.toArray();

int numNew = a.length;

// 修改modCount

ensureCapacity(size + numNew); // Increments modCount

System.arraycopy(a, 0, elementData, size, numNew);

size += numNew;

return numNew != 0;

}

// 删除指定位置的元素

public E remove(int index) {

RangeCheck(index);

// 修改modCount

modCount++;

E oldValue = (E) elementData[index];

int numMoved = size - index - 1;

if (numMoved > 0)

System.arraycopy(elementData, index+1, elementData, index, numMoved);

elementData[--size] = null; // Let gc do its work

return oldValue;

}

// 快速删除指定位置的元素

private void fastRemove(int index) {

// 修改modCount

modCount++;

int numMoved = size - index - 1;

if (numMoved > 0)

System.arraycopy(elementData, index+1, elementData, index,

numMoved);

elementData[--size] = null; // Let gc do its work

}

// 清空集合

public void clear() {

// 修改modCount

modCount++;

// Let gc do its work

for (int i = 0; i < size; i++)

elementData[i] = null;

size = 0;

}

...

}Descubrimos que, ya sea add(), remove() o clear(), siempre que implique modificar la cantidad de elementos en la colección, el valor de modCount cambiará.

A continuación, analicemos sistemáticamente cómo se genera la falla rápida. Proceder de la siguiente:

1. Cree una nueva ArrayList llamada arrayList.

2. Agregue contenido a arrayList.

3. Cree un nuevo "hilo a" y lea repetidamente el valor de arrayList a través de Iterator en "hilo a".

4. Cree un nuevo "subproceso b" y elimine un "nodo A" en el arrayList en "subproceso b".

5. En este momento ocurrirán eventos interesantes.

- En algún momento, "thread a" crea un iterador de arrayList. En este punto, el "nodo A" todavía existe en arrayList, cuando se crea arrayList, se esperaModCount = modCount (asumiendo que su valor en este momento es N).

- En cierto punto en el proceso de "subproceso a" atravesando arrayList, se ejecuta "subproceso b" y "subproceso b" elimina "nodo A" en arrayList. Cuando "thread b" ejecuta remove() para eliminar, "modCount++" se ejecuta en remove(), ¡y modCount se convierte en N+1 en este momento!

- El subproceso a" luego atraviesa, cuando ejecuta la función next(), llama a checkForComodification() para comparar el tamaño de "expectedModCount" y "modCount"; y "expectedModCount=N", "modCount=N+1", entonces, throw Se lanza una ConcurrentModificationException y se genera un evento fail-fast.

¡Hasta ahora, hemos entendido completamente cómo se genera la falla rápida!

Resumen de los principios de implementación

final void checkForComodification() {

if (modCount != expectedModCount)

throw new ConcurrentModificationException();

}Hay un método checkForComodification.Cuando varios subprocesos operan en la misma colección, el contenido de la colección es cambiado por otros subprocesos durante el proceso de acceso de un subproceso a la colección (otros subprocesos llaman a estos métodos a través de agregar, eliminar, borrar, etc.) modCount se incrementará automáticamente, es decir, modCount++), cambiando el valor de modCount, cuando modCount != ExpectedModCount (al principio, el valor inicial de addedModCount es igual a modCount por defecto), luego se lanzará una excepción ConcurrentModificationException, y se generará un evento de falla rápida.

Solución:

1. Durante el proceso transversal, se agrega sincronizado a todos los lugares que implican cambiar el valor de modCount.

1. Use CopyOnWriteArrayList para reemplazar ArrayList

¿Cómo asegurarse de que una colección no se puede modificar?

Puede usar el método Collections.unmodifiableCollection(Collection c) para crear una colección de solo lectura

En conjunto, cualquier operación que mute la colección generará una Java.lang.UnsupportedOperationException.

List list = new ArrayList<>();

list. add("x");

Collection clist = Collections. unmodifiableCollection(list);

clist. add("y"); // 运行时此行报错

System. out. println(list. size());¿La lista, el conjunto y el mapa heredan de la interfaz de la colección? ¿Cuál es la diferencia entre Lista, Conjunto y Mapa? ¿Cuáles son las características de cada una de las tres interfaces de List, Map y Set al acceder a los elementos?

1. ¿Se heredan List, Set y Map de la interfaz Collection?

Los contenedores de Java se dividen en dos categorías: Colección y Mapa. Las subinterfaces de Colección incluyen tres subinterfaces: Conjunto, Lista y Cola. Comúnmente usamos Set y List, y la interfaz Map no es una subinterfaz de la colección. Colección colección tiene principalmente dos interfaces: Lista y Conjunto

2. La diferencia entre Lista, Conjunto y Mapa

Lista : un contenedor ordenado (el orden en que se almacenan los elementos en la colección es el mismo que el orden en que se extraen), los elementos se pueden repetir, se pueden insertar varios elementos nulos y los elementos tienen índices.

Las clases de implementación comúnmente utilizadas de la interfaz List son ArrayList, LinkedList y Vector.

Conjunto : un contenedor no ordenado (el orden de almacenamiento y retiro puede ser inconsistente), que no puede almacenar elementos duplicados, solo permite almacenar un elemento nulo y se debe garantizar la unicidad de los elementos.

Las clases de implementación comunes de la interfaz Set son HashSet, LinkedHashSet y TreeSet.

Mapa: una colección de pares clave-valor que almacena el mapeo entre claves, valores y valores. La clave es desordenada y única, el valor no requiere orden y permite la duplicación. El mapa no se hereda de la interfaz de la colección. Al recuperar elementos de la colección de mapas, siempre que se proporcione el objeto clave, se devolverá el objeto de valor correspondiente.

Clases de implementación comunes de Map: HashMap, TreeMap, HashTable, LinkedHashMap, ConcurrentHashMap

3. ¿Cuáles son las características de cada una de las tres interfaces de List, Map y Set al acceder a los elementos?

Cuando se almacenan las tres interfaces de Lista, Mapa y Conjunto

- Lista almacena elementos con un índice específico (almacenamiento ordenado), y puede haber elementos repetidos

- Los elementos almacenados en Set están desordenados y no son repetibles (utilice el método equals() del objeto para distinguir si los elementos se repiten)

- Map guarda el mapeo de pares clave-valor. La relación de mapeo puede ser uno a uno (clave-valor) o muchos a uno. Cabe señalar que las claves están desordenadas y no se pueden repetir, y los valores se puede repetir.

Cuando se eliminan las tres interfaces de List, Map y Set

- La lista saca elementos para bucle, bucle foreach, iterador iterador iteración

- Conjunto saca elementos foreach loop, iterador iterador iteración

- Mapa saca elementos foreach loop, iterador iterador iteración

¿Cuáles son las formas de recorrer la colección de mapas?

Hay varias formas de recorrer la colección de mapas:

1. Utilice el iterador Iterator para recorrer la colección Map. Obtenga la colección Set devuelta por el método entrySet() de Map, luego obtenga el iterador Iterator a través del método iterator() de la colección Set y finalmente use el ciclo while para recorrer los elementos en la colección Map. El código de ejemplo es el siguiente:

Map<String, Integer> map = new HashMap<>();

map.put("A", 1);

map.put("B", 2);

map.put("C", 3);

Iterator<Map.Entry<String, Integer>> iterator = map.entrySet().iterator();

while (iterator.hasNext()) {

Map.Entry<String, Integer> entry = iterator.next();

System.out.println(entry.getKey() + " : " + entry.getValue());

}

2. Utilice el bucle for-each para recorrer la colección Map. Obteniendo la colección Set devuelta por el método entrySet() de Map y luego recorriendo los elementos de la colección Set a través del bucle for-each. El código de ejemplo es el siguiente:

Map<String, Integer> map = new HashMap<>();

map.put("A", 1);

map.put("B", 2);

map.put("C", 3);

for (Map.Entry<String, Integer> entry : map.entrySet()) {

System.out.println(entry.getKey() + " : " + entry.getValue());

}

3. Recorrer las claves o valores de la colección Map. Obtenga la colección Set devuelta por el método keySet() de Map, o la colección Collection devuelta por el método values() y, a continuación, recorra los elementos de la colección Set o Collection a través del bucle for-each. El código de ejemplo es el siguiente:

Map<String, Integer> map = new HashMap<>();

map.put("A", 1);

map.put("B", 2);

map.put("C", 3);

for (String key : map.keySet()) {

System.out.println(key + " : " + map.get(key));

}

for (Integer value : map.values()) {

System.out.println(value);

}

En resumen, hay muchas formas de recorrer la colección de mapas y debe elegir la forma adecuada según sus necesidades y escenarios específicos.

¿La diferencia entre comparable y comparador?

¿La diferencia entre comparable y comparador?

- La interfaz comparable es en realidad del paquete java.lang, que tiene un método compareTo(Object obj) para ordenar, y la interfaz de comparación es en realidad del paquete java.util, que tiene un método compare(Object obj1, Object obj2) para clasificación

- Comparable es una interfaz de clasificación. Si una clase implementa la interfaz Comparable, significa que "esta clase admite la clasificación". El Comparator es un comparador, que implementa esta interfaz a través de una clase para ordenar como comparador.

- Comparable es equivalente a "comparador interno", y Comparador es equivalente a "comparador externo".

respectivas ventajas y desventajas

- Comparable es simple de usar, siempre que el objeto que implementa la interfaz Comparable se convierta directamente en un objeto comparable, pero el código fuente debe modificarse.

- La ventaja de usar Comparator es que no necesita modificar el código fuente, sino implementar un comparador por separado. Cuando se necesita comparar un objeto personalizado, puede comparar el tamaño pasando el comparador y el objeto juntos, y en el Comparador Los usuarios pueden implementar una lógica compleja y de uso general por sí mismos, de modo que pueda coincidir con algunos objetos relativamente simples, lo que puede ahorrar mucho trabajo repetitivo.

Introducción y ejemplos de comparable y comparador

Comparable

Comparable es una interfaz de clasificación. Si una clase implementa la interfaz Comparable, significa que la clase admite la clasificación. Las listas o matrices de objetos de clases que implementan la interfaz Comparable se pueden ordenar automáticamente mediante Collections.sort o Arrays.sort. Además, los objetos que implementan esta interfaz se pueden usar como claves en un mapa ordenado o como colecciones en un conjunto ordenado sin especificar un comparador. La interfaz se define de la siguiente manera:

package java.lang;

import java.util.*;

public interface Comparable<T>

{

public int compareTo(T o);

}Esta interfaz tiene un solo método, compareTo, que compara el orden de este objeto con el objeto especificado y devuelve un entero negativo, cero o un entero positivo si el objeto es menor, igual o mayor que el objeto especificado.

Ahora que hay dos objetos de la clase Person, ¿cómo comparamos el tamaño de los dos? Podemos hacer esto haciendo que Person implemente la interfaz Comparable:

public class Person implements Comparable<Person>

{

String name;

int age;

public Person(String name, int age)

{

super();

this.name = name;

this.age = age;

}

public String getName()

{

return name;

}

public int getAge()

{

return age;

}

@Override

public int compareTo(Person p)

{

return this.age-p.getAge();

}

public static void main(String[] args)

{

Person[] people=new Person[]{new Person("xujian", 20),new Person("xiewei", 10)};

System.out.println("排序前");

for (Person person : people)

{

System.out.print(person.getName()+":"+person.getAge());

}

Arrays.sort(people);

System.out.println("\n排序后");

for (Person person : people)

{

System.out.print(person.getName()+":"+person.getAge());

}

}

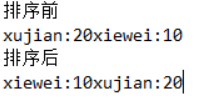

}Resultados de la

comparador

Comparator es una interfaz de comparación. Si necesitamos controlar el orden de una determinada clase, y la clase en sí no admite la clasificación (es decir, no implementa la interfaz Comparable), entonces podemos crear un "comparador de esta clase". para ordenar. dispositivo" solo necesita implementar la interfaz Comparator. En otras palabras, podemos crear un nuevo comparador implementando Comparator y luego ordenar las clases a través de este comparador. La interfaz se define de la siguiente manera:

package java.util;

public interface Comparator<T>

{

int compare(T o1, T o2);

boolean equals(Object obj);

}Aviso

1. Si una clase quiere implementar la interfaz Comparator: debe implementar la función compare(T o1, To2), pero no necesita implementar la función equals(Object obj).

2. int compare(T o1, T o2) es "comparar el tamaño de o1 y o2". Devuelve "negativo", lo que significa que "o1 es menor que o2"; devuelve "cero", lo que significa que "o1 es igual a o2"; devuelve "positivo", lo que significa que "o1 es mayor que o2".

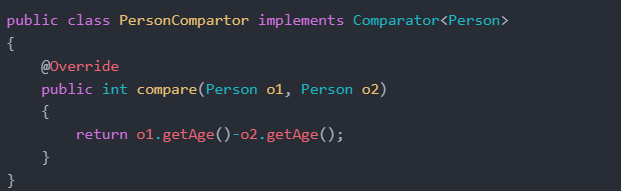

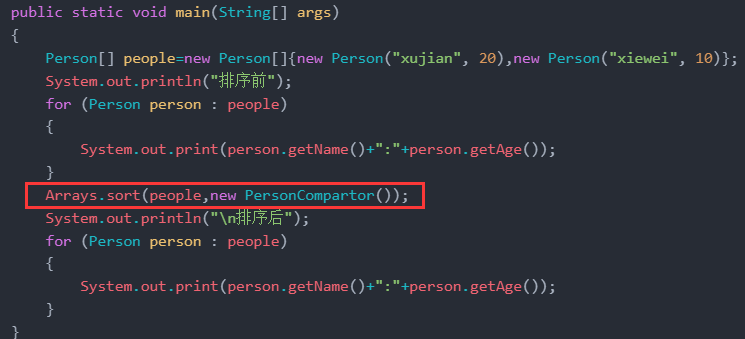

Ahora bien, si la clase Person anterior no implementa la interfaz Comparable, ¿cómo comparar el tamaño? Podemos crear una nueva clase y dejar que implemente la interfaz Comparator para construir un "comparador".

public class PersonCompartor implements Comparator<Person>

{

@Override

public int compare(Person o1, Person o2)

{

return o1.getAge()-o2.getAge();

}

}

public class Person

{

String name;

int age;

public Person(String name, int age)

{

super();

this.name = name;

this.age = age;

}

public String getName()

{

return name;

}

public int getAge()

{

return age;

}

public static void main(String[] args)

{

Person[] people=new Person[]{new Person("xujian", 20),new Person("xiewei", 10)};

System.out.println("排序前");

for (Person person : people)

{

System.out.print(person.getName()+":"+person.getAge());

}

Arrays.sort(people,new PersonCompartor());

System.out.println("\n排序后");

for (Person person : people)

{

System.out.print(person.getName()+":"+person.getAge());

}

}

}Resultados de la

¿Cuál es la diferencia entre Collectiony Collections?

Colección y Colecciones son dos conceptos diferentes en el marco de colección de Java.

1. La colección es una interfaz en el marco de colección de Java. Es la interfaz raíz de todas las clases de colección y proporciona algunos métodos comunes, como agregar, eliminar, atravesar, etc.

2. Colecciones es una clase de herramienta en el marco de colección de Java, que proporciona una serie de métodos estáticos para operaciones en colecciones, como ordenar, buscar, reemplazar, copiar, invertir, etc.

En resumen, Collection es una interfaz que representa las características y comportamientos básicos de las clases de colección, y Collections es una clase de herramienta que proporciona métodos para operar colecciones.

¿Cuáles son los métodos comúnmente utilizados de colecciones?

Colecciones es una clase de herramienta en el marco de colección de Java, que proporciona una serie de métodos de operación de colección de uso común, que incluyen ordenar, buscar, reemplazar, copiar, invertir, etc. Los métodos de cobranza comúnmente utilizados incluyen:

1. sort(List<T> list): ordena la colección List y las reglas de clasificación son de orden natural (de menor a mayor).

2. sort(List<T> list, Comparator<? super T> c): ordena la colección List y comparator especifica las reglas de clasificación.

3. binarySearch(List<? extends Comparable<? super T>> list, T key): busca el elemento especificado en la colección List ordenada y devuelve el valor de índice del elemento.

4. binarySearch(List<? extends T> list, T key, Comparator<? super T> c): busca el elemento especificado en la colección List ordenada, devuelve el valor de índice del elemento y la regla de búsqueda se especifica mediante el Comparador.

5. reverse(List<?> list): Invierte los elementos en la colección List.

6. barajar (lista <?> lista): baraja aleatoriamente el orden de los elementos en la colección de la lista.

7. swap(List<?> list, int i, int j): Intercambia dos elementos en la posición especificada en la colección List.

8. fill(List<? super T> list, T obj): reemplaza todos los elementos de la colección List con el elemento especificado.

9. copy(List<? super T> dest, List<? extends T> src): copia los elementos de la colección src a la colección dest.

10. max(Collection<? extends T> coll): Devuelve el elemento más grande de la colección Collection.

11. min(Collection<? extends T> coll): Devuelve el elemento más pequeño de la colección Collection.

iterador iterador

¿Qué es iterador iterador?

Iterator (Iterador) es una interfaz en el marco de colección de Java , que se utiliza para atravesar los elementos de la colección. Los iteradores proporcionan un método de recorrido general que puede atravesar cualquier tipo de colección, incluidas listas, conjuntos, mapas, etc. Puede realizar el recorrido unidireccional de la colección, es decir, solo puede atravesar de adelante hacia atrás, no hacia atrás. Durante el recorrido, los elementos de la colección se pueden eliminar, pero los elementos de la colección no se pueden modificar.

¿Cómo usar el iterador?

(1) Iterator() requiere que el contenedor devuelva un iterador. El iterador estará listo para devolver el primer elemento de la secuencia.

(2) Use next() para obtener el siguiente elemento en la secuencia

(3) Use hasNext() para verificar si hay más elementos en la secuencia.

(4) Use remove() para eliminar el objeto devuelto por el último método Iterator.next().

List list = new ArrayList<>();

Iterator iterator = list.iterator();//list集合实现了Iterable接口

while (iterator.hasNext()) {

String string = iterator.next();

//do something

}¿Cuáles son las ventajas de Iterator?

Iterator (Iterator) es una interfaz importante en el marco de colección de Java, que tiene las siguientes ventajas:

1. Versatilidad fuerte: el iterador proporciona un método de recorrido general, que puede recorrer cualquier tipo de colección, incluyendo Lista, Conjunto, Mapa, etc.

2. Facilidad de uso: es muy simple usar un iterador para recorrer una colección. Solo necesita llamar al método Iterator, como hasNext(), next(), remove(), etc., para completar el recorrido.

3. Seguro y confiable: el uso de iteradores para atravesar colecciones puede garantizar la seguridad de los subprocesos y evitar problemas de acceso simultáneo en entornos de subprocesos múltiples.

4. Compatibilidad con operaciones de eliminación: use iteradores para recorrer la colección y eliminar fácilmente elementos de la colección sin tener en cuenta el cambio de índice después de eliminar los elementos.

5. Rendimiento eficiente: el rendimiento del uso de iteradores para atravesar colecciones es muy eficiente, especialmente para colecciones grandes, lo que puede evitar el problema de cargar todos los elementos a la vez.

¿Cuáles son las características de Iterator?

Iterator es una interfaz en el marco de colección de Java, que se utiliza para recorrer los elementos de la colección. Sus características son las siguientes:

1. Puede recorrer cualquier tipo de colección, incluida Lista, Conjunto, Mapa, etc.

2. Se puede realizar un recorrido unidireccional de la colección, es decir, solo se puede recorrer de adelante hacia atrás, no hacia atrás.

3. Los elementos de la colección se pueden eliminar durante el proceso transversal, pero los elementos de la colección no se pueden modificar; de lo contrario, se lanzará una excepción ConcurrentModificationEception.

4. Los genéricos se pueden utilizar para evitar el problema de la conversión de tipo.

5. El iterador debe existir adjunto a un objeto de colección, y el propio iterador no tiene la función de cargar objetos de datos.

¿Cómo eliminar elementos en la Colección mientras se atraviesa?

La única forma correcta de eliminar una colección mientras se atraviesa es usar el método Iterator.remove(), de la siguiente manera:

List list = new ArrayList<>();

Iterator<Integer> it = list.iterator();

//正确的移除方法

while(it.hasNext()){

//设置移除元素的条件

it.remove();

}

//一种最常见的错误代码如下

for(Integer i : list){

list.remove(i);//报 ConcurrentModificationException 异常

}Sao Dai entiende: es decir, solo se puede eliminar a través del método de eliminación de la instancia del iterador, pero no a través del método de eliminación de la colección en sí. Si se usa el método de eliminación de la colección en sí, el mecanismo de falla rápida será desencadenado para generar una excepción ConcurrentModificationException, porque un subproceso no puede modificar la colección mientras otro subproceso lo atraviesa.

¿Cuál es la diferencia entre Iterator y ListIterator?

Tanto Iterator como ListIterator son interfaces en el marco de la colección de Java, que se utilizan para atravesar los elementos de la colección. Sus principales diferencias son las siguientes:

1. Diferentes direcciones de recorrido: Iterator solo puede recorrer los elementos de la colección hacia adelante, mientras que ListIterator puede recorrer los elementos de la colección hacia adelante o hacia atrás.

2. La compatibilidad con las operaciones de elementos es diferente: Iterator solo puede recorrer los elementos de la colección y no puede realizar operaciones como agregar y modificar, mientras que ListIterator puede agregar, modificar y eliminar elementos de la colección durante el proceso de recorrido.

3. Diferentes métodos de soporte: ListIterator tiene más métodos que Iterator, como previous(), hasPrevious(), add(), set(), etc., que se utilizan para avanzar, agregar elementos, modificar elementos, etc. durante el proceso transversal.

4. Los tipos de colecciones admitidas son diferentes: Iterator puede atravesar cualquier tipo de colección, incluidos List, Set, Map, etc., mientras que ListIterator solo puede atravesar colecciones de tipo List.

Sao Dai entiende: si necesita recorrer la colección List y admitir operaciones de elementos, debe usar ListIterator; si solo necesita recorrer los elementos de la colección, puede usar Iterator.

¿Cuáles son las diferentes formas de iterar sobre una lista? ¿Cuál es el principio de implementación de cada método?

Hay varias formas diferentes de iterar sobre una colección de listas:

1. para recorrido de bucle

Use el bucle for para recorrer la colección List y puede usar el subíndice para acceder a los elementos de la colección. El principio de realización es recorrer la colección List a través de la variable de control de bucle y acceder a los elementos de la colección a través del subíndice.

List<String> list = new ArrayList<>();

list.add("A");

list.add("B");

list.add("C");

for (int i = 0; i < list.size(); i++) {

String element = list.get(i);

System.out.println(element);

}

Explique el principio

El principio de implementación del bucle for que atraviesa la colección List es atravesar la colección List a través de la variable de control de bucle y acceder a los elementos de la colección a través de subíndices.

La sintaxis del bucle for es la siguiente:

for (初始化表达式; 布尔表达式; 更新表达式) {

// 循环体

}

Donde, la expresión de inicialización se usa para inicializar la variable de control de bucle, la expresión booleana se usa para juzgar si el bucle continúa ejecutándose y la expresión de actualización se usa para actualizar el valor de la variable de control de bucle.

Cuando el ciclo for atraviesa la colección List, la expresión de inicialización generalmente inicializa la variable de control de ciclo a 0, la expresión booleana generalmente juzga si la variable de control de ciclo es más pequeña que la longitud de la colección List y la expresión de actualización generalmente agrega 1 a la variable de control de bucle. En el cuerpo del bucle, se puede acceder a los elementos de la colección List a través de subíndices para realizar la función de atravesar la colección List.

2. recorrido del bucle foreach

Use el bucle foreach para recorrer la colección List, puede acceder directamente a los elementos de la colección. El principio de implementación del recorrido de bucle foreach es recorrer cada elemento de la colección List, obtener automáticamente el valor del elemento y asignarlo a la variable de bucle, y luego ejecutar la instrucción en el cuerpo del bucle.

List<String> list = new ArrayList<>();

list.add("A");

list.add("B");

list.add("C");

for (String element : list) {

System.out.println(element);

}Explique el principio

Específicamente, el ciclo foreach primero obtiene el iterador de la colección List y luego usa el iterador para recorrer cada elemento de la colección. Durante el proceso transversal, la variable de bucle obtendrá automáticamente el valor del elemento y lo asignará a la variable de bucle. Luego, ejecute las declaraciones en el cuerpo del bucle para completar la operación transversal en la colección List.

En comparación con el bucle for que recorre la colección List, la sintaxis del bucle foreach que recorre la colección List es más concisa. No necesita usar explícitamente el subíndice para acceder a los elementos de la colección y puede acceder directamente a la variable del elemento. Por lo tanto, el bucle foreach es más fácil de entender y usar, y es una de las formas comunes de recorrer la colección List.

3. Recorrido del iterador

Use el iterador para recorrer la colección List, puede recorrer cualquier tipo de colección, incluida List, Set, Map, etc. El principio de realización es recorrer los elementos de la colección obteniendo el iterador de la colección List y usando los métodos hasNext() y next().

List<String> list = new ArrayList<>();

list.add("A");

list.add("B");

list.add("C");

Iterator<String> iterator = list.iterator();

while (iterator.hasNext()) {

String element = iterator.next();

System.out.println(element);

}4. Recorrido de ListIterator

Use ListIterator para recorrer la colección List, puede recorrer los elementos de la colección hacia adelante o hacia atrás y admitir operaciones de elementos. El principio de implementación es recorrer los elementos de la colección obteniendo el ListIterator de la colección List y usando métodos como hasNext(), next(), hasPrevious(), previous(), add() y set().

List<String> list = new ArrayList<>();

list.add("A");

list.add("B");

list.add("C");

ListIterator<String> iterator = list.listIterator();

while (iterator.hasNext()) {

String element = iterator.next();

System.out.println(element);

}¿Cuáles son los escenarios de uso de varios métodos transversales de recopilación?

Varios métodos transversales de colecciones son aplicables a varios escenarios, de la siguiente manera:

1. For loop traversal: es adecuado para ocasiones en las que es necesario acceder a los elementos de la colección de acuerdo con el subíndice del elemento (como la colección List), por ejemplo, cuando los elementos de la colección deben modificarse o eliminado

2. Recorrido de bucle Foreach: es adecuado para ocasiones en las que solo es necesario acceder a los elementos de la colección y no es necesario acceder de acuerdo con el subíndice del elemento, por ejemplo, cuando solo es necesario leer los elementos de la colección. .

3. Recorrido del iterador: es adecuado para ocasiones en las que es necesario modificar o eliminar los elementos de la colección, porque cuando se utiliza el iterador para recorrer la colección, los elementos de la colección se pueden eliminar a través del método remove() del iterador

4. Recorrido de expresiones lambda: es adecuado para ocasiones que requieren un procesamiento funcional de los elementos de la colección, como filtrado, mapeo, clasificación y otras operaciones en los elementos de la colección.

¿Análisis de rendimiento de varios métodos transversales de la colección?

Al recorrer una colección, los diferentes métodos de recorrido tienen diferentes rendimientos, y la clasificación de rendimiento específica depende de varios factores, como el tipo, el tamaño y el tipo de elemento de la colección. La siguiente es la clasificación de rendimiento de varios métodos transversales en general:

1. For loop traversal: el rendimiento es el mejor, porque el uso de subíndices para acceder a los elementos de la colección es más rápido.

2. Recorrido del iterador: el rendimiento es el segundo, porque el iterador puede acceder directamente a los elementos de la colección, evitando la sobrecarga de calcular subíndices cada vez.

3. Recorrido del bucle Foreach: el rendimiento es deficiente, porque al usar el bucle foreach para recorrer la colección, primero debe obtener el iterador y luego usarlo para recorrer los elementos de la colección. En comparación con el uso directo de subíndices para acceder a la colección. elementos de la colección, la velocidad es más lenta.

4. Recorrido de expresiones lambda: el rendimiento es deficiente porque las expresiones lambda deben compilarse en objetos de función y se requiere un procesamiento funcional al recorrer la colección, que es más lento que acceder directamente a los elementos de la colección.

5. Recorrido de Stream API: el rendimiento es el peor, porque Stream API requiere múltiples operaciones, como filtrado, mapeo, clasificación, etc. Cada operación necesita crear un nuevo objeto, que es más lento que acceder directamente a los elementos de la colección. .

Cabe señalar que las clasificaciones de rendimiento anteriores son solo de referencia, y el rendimiento real puede verse afectado por varios factores, como el tamaño de la colección, el tipo de elemento, la cantidad de recorridos, etc. Por lo tanto, en el desarrollo real, es necesario seleccionar el método transversal óptimo de acuerdo con la situación específica. Al mismo tiempo, las herramientas de análisis de rendimiento también se pueden utilizar para evaluar el rendimiento de diferentes métodos transversales.

Lista de arreglo

Hable sobre las ventajas y desventajas de ArrayList

ArrayList es una implementación de matriz dinámica de uso común en Java, que tiene las siguientes ventajas y desventajas:

ventaja:

1. Velocidad de acceso aleatorio rápida: la capa inferior de ArrayList se implementa mediante una matriz, y se puede acceder directamente a los elementos de la matriz a través de subíndices, por lo que la velocidad de acceso aleatorio es rápida.

2. Velocidad de recorrido más rápida: ArrayList admite el recorrido rápido, porque su capa inferior es una matriz, que puede usar la memoria caché de la CPU para mejorar la velocidad de recorrido.

3. Puede almacenar tipos de datos básicos: ArrayList puede almacenar tipos de datos básicos y tipos de objetos, y se puede colocar y abrir automáticamente.

defecto:

1. El rendimiento de las operaciones de inserción y eliminación es deficiente: dado que la capa inferior de ArrayList está implementada por una matriz, al insertar y eliminar elementos, es necesario mover otros elementos, lo que genera un rendimiento deficiente.

2. No admite el acceso simultáneo de varios subprocesos: ArrayList no es seguro para subprocesos. Si varios subprocesos modifican ArrayList al mismo tiempo, puede causar inconsistencias en los datos o lanzar ConcurrentModificationException.

3. Desperdicio de espacio de memoria: ArrayList necesita especificar la capacidad inicial cuando se crea. Si la capacidad es insuficiente, debe expandirse y el espacio de memoria debe reasignarse durante la expansión, lo que puede conducir al desperdicio de espacio de memoria. .

Sao Dai entiende: ArrayList es adecuado para escenarios con más operaciones de modificación y acceso aleatorio, pero LinkedList puede ser más adecuado para escenarios con más operaciones de inserción y eliminación. Al mismo tiempo, en el escenario de acceso simultáneo de subprocesos múltiples, puede usar una implementación de lista segura para subprocesos, como Vector o CopyOnWriteArrayList.

¿Cómo realizar la conversión entre matriz y Lista?

Array to List: use Arrays.asList(array) para convertir.

List to array: usa el método toArray() que viene con List.

// List 转数组

List list = new ArrayList();

list.add("123");

list.add("456");

list.toArray();

// 数组转 List

listString[] array = new String[]{"123","456"};

Arrays.asList(array);¿Cuál es la diferencia entre ArrayList y LinkedList?

Tanto ArrayList como LinkedList son implementaciones de listas de uso común en Java, y sus diferencias se reflejan principalmente en los siguientes aspectos:

1. Los métodos de implementación subyacentes son diferentes: el ArrayList subyacente se implementa usando una matriz, mientras que el LinkedList subyacente se implementa usando una lista doblemente enlazada.

2. El acceso aleatorio y el rendimiento transversal son diferentes: ArrayList admite acceso aleatorio rápido y transversal porque la capa inferior está implementada por una matriz y puede usar la memoria caché de la CPU para mejorar la velocidad de acceso; la velocidad transversal de LinkedList es más lenta porque necesita atravesar cada nodo desde el nodo principal y no puede aprovechar la memoria caché de la CPU para mejorar la velocidad de acceso.

3. El rendimiento de las operaciones de inserción y eliminación es diferente: debido a que la capa inferior de ArrayList está implementada por una matriz, es necesario mover otros elementos al insertar y eliminar elementos, lo que resulta en un bajo rendimiento, mientras que el rendimiento de las operaciones de inserción y eliminación de LinkedList es mejor, porque solo los elementos relevantes necesitan ser modificados.punteros a nodos vecinos.

4. Ocupación de espacio de memoria diferente: LinkedList ocupa más memoria que ArrayList, porque los nodos LinkedList almacenan dos referencias además de almacenar datos, una que apunta al elemento anterior y otra que apunta al siguiente elemento. ArrayList se implementa mediante una matriz, y cada elemento solo necesita almacenar los datos, por lo que el espacio de memoria ocupado es relativamente pequeño. Cada nodo de LinkedList necesita almacenar dos punteros adicionales, por lo que al almacenar una gran cantidad de elementos, puede causar una gran huella de memoria. El ArrayList debe especificar la capacidad inicial cuando se crea. Si la capacidad es insuficiente, debe expandirse y el espacio de memoria debe reasignarse durante la expansión, lo que puede provocar el desperdicio de espacio de memoria.

Sao Dai entiende: ArrayList es adecuado para escenarios con más operaciones de modificación y acceso aleatorio, pero LinkedList puede ser más adecuado para escenarios con más operaciones de inserción y eliminación.

Lista doblemente enlazada

Una lista doblemente enlazada también se denomina lista doblemente enlazada, que es un tipo de lista enlazada.Cada nodo de datos tiene dos punteros, que apuntan al sucesor directo y al predecesor directo respectivamente. Por lo tanto, comenzando desde cualquier nodo en la lista doblemente enlazada, puede acceder fácilmente a su nodo predecesor y nodo sucesor.

¿Cuál es la diferencia entre ArrayList y Vector?

Ambas clases implementan la interfaz List (la interfaz List hereda la interfaz Collection) y ambas son colecciones ordenadas.

1. Seguridad de subprocesos: Vector utiliza Synchronized para lograr la sincronización de subprocesos, que es segura para subprocesos, mientras que ArrayList no lo es.

2. Rendimiento: ArrayList es mejor que Vector en términos de rendimiento. Todos los métodos de la clase Vector son síncronos. Dos subprocesos pueden acceder de forma segura a un objeto Vector, pero si un subproceso accede al Vector, el código dedicará mucho tiempo a las operaciones de sincronización.

3. Expansión: cuando se necesita expandir ArrayList, creará una nueva matriz y copiará los elementos de la matriz original a la nueva matriz. El tamaño de la nueva matriz es 1,5 veces mayor que la matriz original. Cuando Vector se expande, se creará una nueva matriz y los elementos de la matriz original se copiarán en la nueva matriz, y el tamaño de la nueva matriz será el doble del tamaño de la matriz original. Por lo tanto, la expansión de Vector consume más memoria que ArrayList, pero en términos relativos, el rendimiento de Vector es más estable porque sus tiempos de expansión son relativamente pequeños.

Sao Dai entiende: Vector es seguro para subprocesos, pero ArrayList no es seguro para subprocesos. Si necesita usar ArrayList en un entorno de subprocesos múltiples, debe realizar la sincronización.

Al insertar datos, ¿cuál es más rápido, ArrayList, LinkedList o Vector?

Al insertar datos, LinkedList es relativamente rápido porque su capa inferior es una estructura de lista enlazada. Insertar un elemento solo necesita modificar el puntero del nodo adyacente, y la complejidad de tiempo es O (1). La capa inferior de ArrayList y Vector es una estructura de matriz, la inserción de un elemento necesita mover el siguiente elemento un bit hacia atrás y la complejidad de tiempo es O(n), donde n es la longitud de la matriz. Por lo tanto, LinkedList funciona mejor que ArrayList y Vector al insertar datos. Debido a que los métodos en Vector se modifican con sincronizados, Vector es un contenedor seguro para subprocesos y su rendimiento es peor que el de ArrayList.

La velocidad de inserción es de clasificación rápida a lenta: LinkedList>ArrayList>Vector

¿Cómo usar ArrayList en un escenario de subprocesos múltiples?

ArrayList no es seguro para subprocesos. Si se encuentra con un escenario de varios subprocesos, puede usar el métodosynchronedList de Collections para convertirlo en uno seguro para subprocesos antes de usarlo.

List<String> list = new ArrayList<>();

List<String> synchronizedList = Collections.synchronizedList(list);

synchronizedList.add("aaa");

synchronizedList.add("bbb");

for(int i =0; i < synchronizedList.size(); i++){

System.out.println(synchronizedList.get(i));

}¿Por qué elementData de ArrayList está decorado con transitorios?

¿Por qué elementData de ArrayList está decorado con transitorios?

En ArrayList, elementData se modifica en transitorio para ahorrar espacio. El mecanismo de expansión automática de ArrayList, la matriz elementData es equivalente al contenedor. Cuando el contenedor es insuficiente, la capacidad se expandirá, pero la capacidad del contenedor suele ser mayor que o igual al número de elementos almacenados en el ArrayList. . Entonces, el diseñador de ArrayList diseñó elementData como transitorio para que esta matriz no se serializara, y luego la serializó manualmente en el método writeObject, y solo serializó aquellos elementos que realmente estaban almacenados, no toda la matriz elementData.

Por ejemplo, ahora que en realidad hay 8 elementos, la capacidad de la matriz elementData puede ser 8x1,5 = 12. Si la matriz elementData se serializa directamente, se desperdiciará el espacio de 4 elementos, especialmente cuando la cantidad de elementos es muy alta. grande Este tipo de residuos es muy antieconómico.

Definición de serialización y deserialización

La serialización de Java se refiere al proceso de convertir objetos de Java en secuencias de bytes.

La deserialización de Java hace referencia al proceso de restauración de una secuencia de bytes en un objeto de Java.

palabra clave transitoria

Las variables miembro modificadas por transitorios no se serializarán.

análisis de código

Los arreglos en ArrayList se definen de la siguiente manera:

objeto transitorio privado [] elementData;

Mire la definición de ArrayList nuevamente:

clase pública ArrayList<E>extiende AbstractList<E>implementsList<E>, RandomAccess, Cloneable, java.io.Serializable

Puede ver que ArrayList implementa la interfaz Serializable, lo que significa que ArrayList admite la serialización.

El papel del transitorio es esperar que la matriz elementData no se serialice.

Anule la implementación de writeObject:

private void writeObject(java.io.ObjectOutputStream s)throws java.io.IOException{

int expectedModCount = modCount;

s.defaultWriteObject();

s.writeInt(elementData.length);

for(int i=0; i<size; i++)

s.writeObject(elementData[i]);

if(modCount != expectedModCount){

thrownewConcurrentModificationException();

}

}Entendimiento de Sao Dai: a partir del código fuente, se puede observar que i<size se usa en lugar de i<elementData.length cuando se realiza un bucle, lo que indica que solo los elementos realmente almacenados son necesarios para la serialización, no la matriz completa.

¿Cuál es la diferencia entre Array (matriz) y ArrayList?

- Array puede almacenar tipos de datos básicos y tipos de referencia, y ArrayList solo puede almacenar tipos de referencia.

- Array se especifica con un tamaño fijo, mientras que el tamaño de ArrayList se expande automáticamente.

- No hay tantos métodos integrados en Array como en ArrayList, como addAll, removeAll, iteración y otros métodos solo en ArrayList.

- Los elementos almacenados en la matriz Array deben ser del mismo tipo de datos; los objetos almacenados en ArrayList pueden ser de diferentes tipos de datos.

¿Qué es CopyOnWriteArrayList y para qué escenarios de aplicación se puede utilizar? ¿Cuáles son los pros y los contras?

¿Qué es CopyOnWrite?

Un contenedor CopyOnWrite es un contenedor de copia en escritura. El entendimiento popular es que cuando agregamos elementos a un contenedor, no lo agregamos directamente al contenedor actual, sino que primero copiamos el contenedor actual para crear un nuevo contenedor y luego agregamos elementos al nuevo contenedor. señalar la referencia del contenedor original al nuevo contenedor. La ventaja de esto es que podemos realizar lecturas simultáneas en el contenedor CopyOnWrite sin bloquear, porque el contenedor actual no agregará ningún elemento. Entonces, el contenedor CopyOnWrite también es una idea de separación de lectura y escritura, lectura y escritura de diferentes contenedores.

¿Qué es CopyOnWriteArrayList?

CopyOnWriteArrayList es una colección segura para subprocesos. Su implementación es crear una nueva matriz durante la operación de escritura, copiar los elementos de la matriz original a la nueva matriz, luego realizar la operación de escritura en la nueva matriz y finalmente reemplazar la nueva matriz con matriz original.

La operación de lectura se realiza directamente en la matriz original, por lo que no es necesario sincronizar la operación de lectura y se puede realizar la separación de lectura y escritura. Dado que se crea una nueva matriz para cada operación de escritura, CopyOnWriteArrayList es relativamente lento para las operaciones de escritura, pero muy eficaz para las operaciones de lectura.

Cabe señalar que el iterador de CopyOnWriteArrayList es débilmente coherente, es decir, durante el proceso de iteración, si otros subprocesos modifican la Lista, el iterador no generará ConcurrentModificationException, pero no hay garantía de que el iterador pueda atravesar todos los elementos. El escenario de uso de CopyOnWriteArrayList es adecuado para escenarios con más lecturas y menos escrituras.

Entendimiento de Sao Dai: ¿Por qué no se puede garantizar que el iterador pueda atravesar todos los elementos? Por ejemplo, tengo una colección con diez elementos y he recorrido cinco de ellos. En este momento, agregué un nuevo elemento entre los primeros cinco elementos, pero como ya he recorrido hasta el quinto, solo ir hacia atrás ¡Continúe recorriendo, y los cambios antes de recorrer no se pueden recorrer!

¿Cuáles son las ventajas de CopyOnWriteArrayList?

Las ventajas de CopyOnWriteArrayList incluyen principalmente los siguientes puntos:

1. Seguridad de subprocesos: CopyOnWriteArrayList es una implementación segura de subprocesos de List, que se puede usar en un entorno de subprocesos múltiples sin procesamiento de sincronización adicional.

2. Separación de lectura y escritura: la operación de lectura y la operación de escritura de CopyOnWriteArrayList están separadas, y la operación de lectura se realiza directamente en la matriz original sin procesamiento de sincronización, por lo que el rendimiento de la operación de lectura es muy alto.

3. Iterador débilmente consistente: el iterador de CopyOnWriteArrayList es débilmente consistente y se puede modificar durante la iteración sin lanzar ConcurrentModificationException.

4. Aplicable a escenarios con más lecturas y menos escrituras: dado que cada operación de escritura necesita crear una nueva matriz, es adecuada para escenarios con más lecturas y menos escrituras. Si las operaciones de escritura son frecuentes, el rendimiento puede disminuir.

Cabe señalar que la operación de escritura de CopyOnWriteArrayList es relativamente lenta, porque cada operación de escritura necesita crear una nueva matriz, por lo que es adecuada para escenarios con más lecturas y menos escrituras. Si la frecuencia de las operaciones de lectura y escritura es igual, o si la operación de escritura es más frecuente, puede provocar una degradación del rendimiento. Además, debido a que cada operación de escritura creará una nueva matriz, ocupará más espacio de memoria, que debe seleccionarse de acuerdo con escenarios y requisitos específicos.

¿Cuáles son las desventajas de CopyOnWriteArrayList?

Las desventajas de CopyOnWriteArrayList incluyen principalmente los siguientes puntos:

1. Alto uso de memoria: debido a que cada operación de escritura creará una nueva matriz, ocupará más espacio de memoria.

2. El rendimiento de las operaciones de escritura es bajo: dado que se debe crear una nueva matriz para cada operación de escritura, el rendimiento de las operaciones de escritura es bajo y es adecuado para escenarios con más lecturas y menos escrituras.

3. Problema de consistencia de datos: dado que el iterador de CopyOnWriteArrayList es débilmente consistente, es decir, durante el proceso de iteración, si otros subprocesos modifican la Lista, el iterador no arrojará ConcurrentModificationException, pero no se garantiza que la iteración pueda iterar sobre todos los elementos.

4. No apto para escenarios con altos requisitos de tiempo real: dado que se debe crear una nueva matriz para cada operación de escritura, no es adecuado para escenarios con altos requisitos de tiempo real, lo que puede causar retrasos en las operaciones de escritura.

¿Cómo garantiza CopyOnWriteArrayList la seguridad de los subprocesos al escribir?

CopyOnWriteArrayList utiliza la estrategia "Copy-On-Write" para garantizar la seguridad de subprocesos al escribir. Cuando un subproceso necesita realizar una operación de escritura, CopyOnWriteArrayList primero creará una nueva matriz y luego copiará los elementos de la matriz original a la nueva matriz. Dado que solo el subproceso actual puede acceder a la nueva matriz cuando se crea, no se requiere sincronización. Al escribir en la nueva matriz, otros subprocesos aún pueden acceder a la matriz original y no se verán afectados por la escritura del subproceso actual. Cuando se completa la operación de escritura, CopyOnWriteArrayList reemplaza la nueva matriz con la matriz original, lo que garantiza la seguridad de subprocesos de la operación de escritura.

Colocar

La diferencia entre lista y conjunto

Tanto List como Set son interfaces en el marco de colección de Java, y sus principales diferencias radican en los siguientes aspectos:

1. El orden de los elementos: los elementos de la Lista están dispuestos en el orden de inserción y se puede acceder a los elementos de acuerdo con el índice, mientras que los elementos del Conjunto están desordenados y no se puede acceder a los elementos de acuerdo con el índice .

2. La unicidad de los elementos: los elementos de la Lista se pueden repetir y se pueden insertar múltiples elementos nulos. Los elementos del Conjunto no se pueden repetir, cada elemento solo puede aparecer una vez, y solo se permite almacenar un elemento nulo, y se debe garantizar la unicidad del elemento

3. Método de implementación: los métodos de implementación comunes de List incluyen ArrayList, LinkedList, etc., y los métodos de implementación comunes de Set incluyen HashSet, TreeSet, LinkedHashSet, etc.

4. Escenarios de aplicación: List es adecuado para escenarios que necesitan acceder a elementos en el orden de inserción, como mantener una lista ordenada, y Set es adecuado para escenarios que necesitan garantizar la unicidad de los elementos, como deduplicación, búsqueda, etc. .

Entendimiento de Sao Dai: si necesita acceder a los elementos en el orden de inserción, puede elegir Lista; si necesita garantizar la unicidad de los elementos, puede elegir Establecer.

Cuénteme sobre el principio de implementación de HashSet.

La capa inferior de HashSet es en realidad HashMap. El constructor predeterminado es construir un HashMap con una capacidad inicial de 16 y un factor de carga de 0,75. Un objeto HashMap se encapsula para almacenar todos los elementos de la colección.Todos los elementos de la colección colocados en el HashSet en realidad se guardan con la clave del HashMap, y el valor del HashMap almacena un PRESENTE, que es un objeto Object estático.

¿Cómo comprueba HashSet si hay duplicados? ¿Cómo garantiza HashSet que los datos no sean repetibles?

Al agregar un objeto al HashSet (la capa inferior es para almacenar este objeto en la clave del HashMap), se llamará al método hashCode para obtener un valor hash y luego verificar si hay un conflicto hash. conflicto de hash, se inserta directamente, si hay un conflicto de hash, llame al método equals para juzgar mejor, si los valores devueltos de los dos hashCode() son iguales, y la comparación de equals también devuelve verdadero (lo que indica que el el objeto agregado es un duplicado), luego deje de agregar este elemento duplicado, lo que también satisface la característica de que los elementos en el Conjunto no se repiten. Si se produce un conflicto de hash pero el resultado devuelto por el método equals es falso, entonces aplique hash al objeto recién agregado en otra ubicación. De esta forma, reducimos mucho el número de iguales, lo que mejora mucho la velocidad de ejecución. Si no usa la función hashcode, debe recorrer todos los elementos del conjunto y llamar al método equals uno por uno para comparar si son iguales. Obviamente, esto requiere muchas llamadas al método equals

Entendimiento de Sao Dai: los resultados de ejecución del método hashCode de diferentes objetos pueden ser los mismos, que es el llamado conflicto hash, pero el resultado devuelto después de llamar a equals en diferentes objetos debe ser falso, solo los valores de retorno de hashCode () de dos objetos idénticos son iguales, la comparación por iguales también devuelve verdadero

Disposiciones relevantes de hashCode() y equals()

hashCode() y equals() son dos métodos definidos en la clase Object, que se usan ampliamente en Java para juzgar si los objetos son iguales. Al usar estos dos métodos, debe prestar atención a las siguientes regulaciones:

1. Si dos objetos son iguales (el método equals() devuelve verdadero), entonces sus valores hashCode() deben ser iguales. Esto se debe a que la implementación del método hashCode() generalmente se basa en el contenido de los objetos, y si dos objetos son iguales, su contenido también debe ser igual y, por lo tanto, sus valores de hashCode() también deben ser iguales.

2. Si los valores hashCode() de dos objetos son iguales, no necesariamente son iguales (el método equals() devuelve verdadero). Esto se debe a que el método hashCode() puede tener colisiones de hash, es decir, diferentes objetos pueden producir el mismo valor de hashCode(). Por lo tanto, cuando los valores de hashCode() son iguales, también debe llamar al método equals() para comparar y determinar si son iguales.

3. Si una clase reescribe el método equals(), también debe reescribir el método hashCode() para garantizar la exactitud de las disposiciones anteriores. Esto se debe a que el método hashCode() en la clase Object se calcula en función de la dirección del objeto. Si no se vuelve a escribir el método hashCode(), puede causar que objetos iguales tengan diferentes valores de hashCode(), violando así la primera regla .

4. Si una clase reescribe el método hashCode(), también debe reescribir el método equals() para garantizar la exactitud de las disposiciones anteriores. Esto se debe a que el método hashCode() puede tener una colisión hash, y si el método equals() no se reescribe, puede causar que objetos desiguales tengan el mismo valor hashCode(), violando así la segunda regla.

Cabe señalar que la implementación de hashCode() y equals() debe garantizar la eficiencia y la corrección, y no debe ser demasiado complicada ni llevar mucho tiempo. Además, los valores de retorno del método hashCode() deben distribuirse de la manera más uniforme posible para mejorar el rendimiento de la tabla hash.

La diferencia entre HashSet y HashMap

Tanto HashSet como HashMap son clases de implementación en el marco de la colección Java, y sus principales diferencias radican en los siguientes aspectos:

1. Método de almacenamiento: HashSet almacena un conjunto de elementos únicos y desordenados, mientras que HashMap almacena un conjunto de pares clave-valor.

2. Implementación de la capa inferior: la capa inferior de HashSet se implementa en función de HashMap. Usa HashMap para almacenar elementos, pero usa el valor del elemento como clave, y el valor correspondiente a la clave es un objeto Object fijo; mientras que HashMap se implementa mediante una tabla hash.

3. La unicidad de los elementos: los elementos en HashSet son únicos, y cada elemento solo puede aparecer una vez, mientras que las claves en HashMap son únicas, pero los valores pueden repetirse.

4. Método de acceso: no se puede acceder a los elementos en HashSet por índice, sino solo por iterador, mientras que a los elementos en HashMap se puede acceder por clave.

Debe elegir el tipo de colección adecuado según sus necesidades específicas. Si necesita almacenar un conjunto de elementos únicos y desordenados, puede elegir HashSet; si necesita almacenar un conjunto de pares clave-valor, puede elegir HashMap. Si necesita almacenar pares clave-valor y garantizar la unicidad de la clave al mismo tiempo, puede elegir LinkedHashMap.

¿Cómo comparan TreeMap y TreeSet los elementos al ordenarlos? ¿Cómo compara los elementos el método sort() en la clase de herramienta Colecciones?

¿Cómo comparan TreeMap y TreeSet los elementos al ordenarlos?

TreeSet requiere que la clase del objeto almacenado implemente la interfaz Comparable, que proporciona el método compareTo() para comparar elementos. Cuando se inserta un elemento, se volverá a llamar a este método para comparar el tamaño del elemento.

TreeMap requiere que las claves de mapeo de pares clave-valor almacenadas implementen la interfaz Comparable para que los elementos se puedan ordenar de acuerdo con las claves.

Entendimiento de Sao Dai: los elementos se comparan implementando la interfaz Comparable, que proporciona compareTo() para comparar elementos

método, que se llama al insertar un elemento para comparar el tamaño del elemento

¿Cómo compara los elementos el método sort() en la clase de herramienta Colecciones?

El método de clasificación de la clase de herramientas Colecciones tiene dos formas sobrecargadas,

- Se requiere que los objetos almacenados en el contenedor para ser ordenados implementen la interfaz Comparable, que proporciona el método compareTo() para comparar elementos. Al insertar elementos, se llamará a este método para comparar el tamaño de los elementos.

- Los elementos de la colección se pueden pasar en objetos que no implementan la interfaz Comparable, pero se requiere el segundo parámetro, que es un subtipo de la interfaz Comparator (debe anular el método de comparación para lograr la comparación de elementos), es decir, necesita definir un comparador, y luego la comparación del método sort () en realidad llama al método de comparación de este comparador para comparar

el segundo ejemplo

Cola

¿Qué es BlockingQueue?

¿Qué es BlockingQueue?

BlockingQueue es una interfaz en la programación concurrente de Java. Hereda de la interfaz Queue y representa una cola que admite el bloqueo y se utiliza para transferir datos entre varios subprocesos. Cuando la cola está llena, los subprocesos en cola se bloquearán hasta que la cola esté llena; cuando la cola esté vacía, los subprocesos eliminados se bloquearán hasta que haya elementos en la cola.

BlockingQueue es una cola segura para subprocesos, que se utiliza en un entorno de subprocesos múltiples y tiene características seguras para subprocesos.

La implementación de BlockingQueue suele utilizar mecanismos de sincronización, como bloqueos, variables de condición, etc., para garantizar un acceso seguro entre varios subprocesos. En un entorno de subprocesos múltiples, varios subprocesos pueden leer y escribir en BlockingQueue al mismo tiempo, sin problemas de seguridad de subprocesos, como la competencia de datos.

Por ejemplo, cuando se usa ArrayBlockingQueue, los métodos put() y take() primero deben adquirir el bloqueo y luego esperar en la variable de condición o activar otros subprocesos para garantizar la seguridad del subproceso. Al usar LinkedBlockingQueue, diferentes subprocesos pueden leer y escribir en la cola al mismo tiempo, ya que usa dos bloqueos, uno para la operación de puesta en cola y otro para la operación de eliminación de cola, para evitar problemas de competencia y de interbloqueo.

Cabe señalar que, aunque BlockingQueue es una cola segura para subprocesos, aún debe prestar atención a algunos detalles en el uso real, como el tamaño de la capacidad de la cola, el tamaño del grupo de subprocesos, etc., para evitar problemas de rendimiento o problemas de interbloqueo causados por uso

La interfaz BlockingQueue proporciona una variedad de métodos de bloqueo, incluidos put(), take(), offer(), poll(), etc., que se pueden usar para implementar modelos de productor-consumidor, grupos de subprocesos y otros escenarios concurrentes.

Las principales características de la interfaz BlockingQueue son: cuando la cola está vacía, el método take() bloqueará y esperará la llegada de los elementos; cuando la cola esté llena, el método put() bloqueará y esperará a que la cola sea gratis. Este mecanismo de bloqueo de espera puede evitar la competencia y los problemas de interbloqueo entre varios subprocesos y mejorar la solidez y la confiabilidad del programa.

BlockingQueue proporciona principalmente cuatro tipos de métodos, como se muestra en la siguiente tabla:

| método |

Lanzar una excepción |

devolver un valor específico |

bloquear |

bloquear por un tiempo específico |

| poner en cola |

añadir (e) |

oferta |

poner (e) |

oferta(e, tiempo, unidad) |

| sacar de la cola |

eliminar() |

encuesta() |

llevar() |

encuesta (tiempo, unidad) |

| Obtener el primer elemento de la cola |

elemento() |

ojeada() |

no apoyo |

no apoyo |

Además de lanzar una excepción y devolver un valor específico , el método es el mismo que la definición de la interfaz Queue, BlockingQueue también proporciona dos tipos de métodos de bloqueo: uno es bloquear cuando no hay espacio/elemento en la cola hasta que haya espacio. /elemento; el otro está en Intento de poner en cola/salir en un momento específico, y el tiempo de espera se puede personalizar.

clase de implementación principal