1. Para construir zookeeper primero, luego construya hbase y cuando construya hbase

HBASE_MANAGES_ZK = false en hbase_env.sh no puede ser igual a verdadero, porque hbase viene con zookeeper, por lo que tienes que desactivar zookeeper en hbase.

2. En algunos confs de configuración, algunos tienen dos bins y sbins, ¡así que escríbalos todos cuando configure las variables de entorno! ! !

export SPARK_HOME = / usr / local / spark

export PATH = $ PATH: $ SPARK_HOME / sbin: $ SPARK_HOME / bin

3. Configurar Spark: ¡Este es un gran trabajo!

Verá un error como este:

en io.netty.channel.AbstractChannelHandlerContext $ WriteAndFlushTask.write (AbstractChannelHandlerContext.java:1116)

en io.netty.channel.AbstractChannelHandlerContext $ AbstractWriteTask.run (AbstractChannelHandlerContext.java:1051)

en (SingleThreadEventExecutor.java:399)

Es todo tipo de en, no se asuste, esto es Python encontrando una biblioteca, informa un error de este tipo si no puede encontrar la biblioteca

q Primero determine si la versión de Java ,,, #Java -version #javac -version es la misma

No es lo mismo: https://blog.csdn.net/Vast_Wang/article/details/81249038

Luego, ejecute pyspark primero. Si se informa de un error, la biblioteca local generalmente no se encuentra: asegúrese de que anaconda (u otras bibliotecas) esté instalada en cada nodo y que las variables de entorno también estén configuradas

再 运行 HADOOP_CONF_DIR = / usr / local / bd / hadoop / etc / hadoop pyspark --master yarn --deploy-mode client

Si se informa un error, entonces si es un error:

18/08/09 16:02:46 ERROR cluster.YarnSchedulerBackend $ YarnSchedulerEndpoint:

El envío de RequestExecutors (0,0, Map (), Set ()) a AM no tuvo éxito

java.io.IOException: no se pudo enviar RPC 8631251511338434358 a

java.nio.channels. ClosedChannelException

La solucion es

修改 yarn-site.xml , 添加 下列 property

<property>

<name> yarn.nodemanager.pmem-check-enabled </name>

<value> false </value>

</property>

<property>

<name> yarn.nodemanager .vmem-check-enabled </name>

<value> false </value>

</property>

Asegúrese de asegurarse de que cada nodo esté modificado ,,,,, apague el clúster ,,, inicie el clúster ,,, inicie la chispa

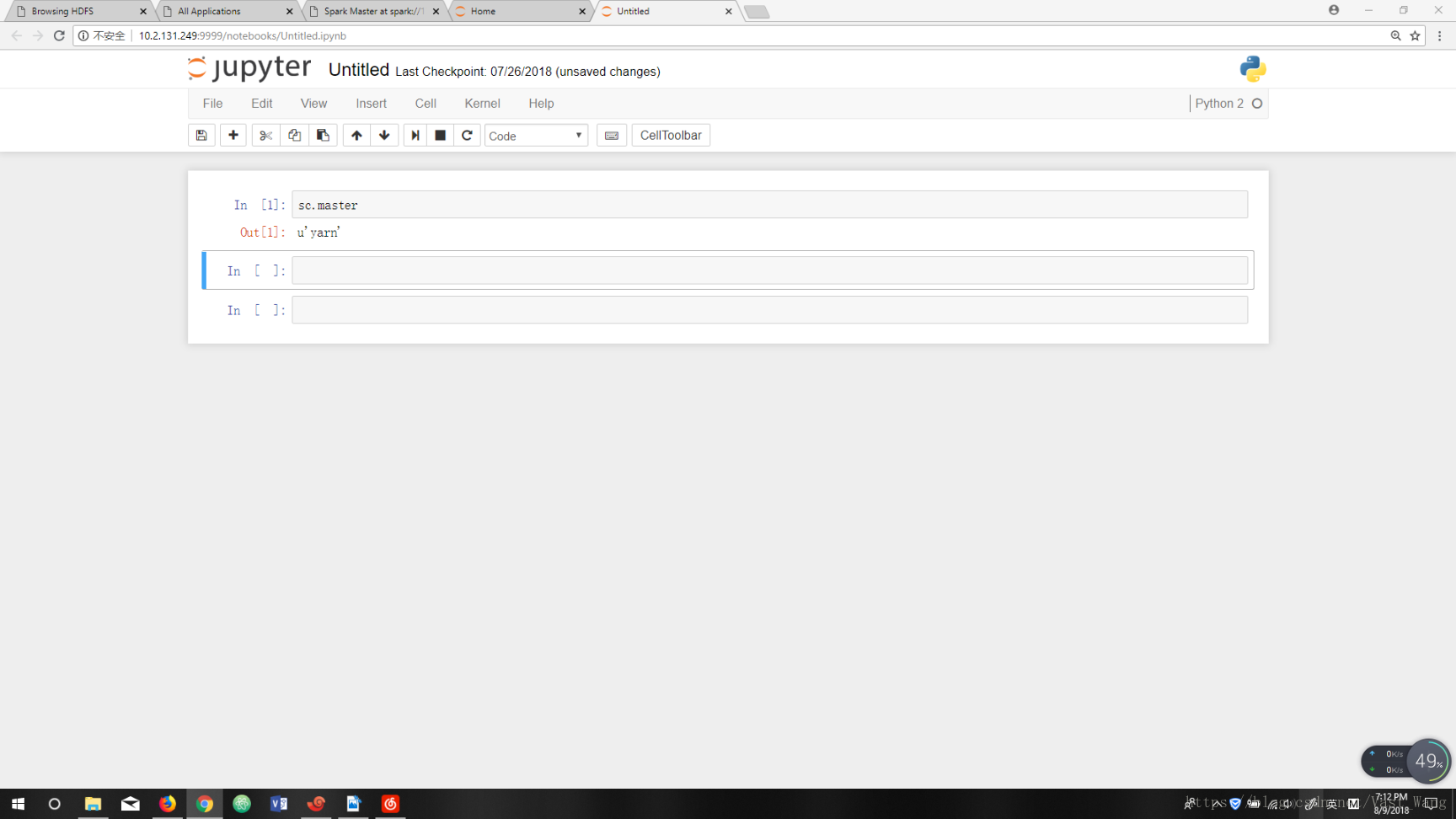

¡Al final esto es un éxito!