1. Was ist Hadoop?

Hadoop ist ein Open-Source-Framework für die verteilte Datenverarbeitung, das für die Verarbeitung großer Datensätze und die Erzielung hoher Leistung und Zuverlässigkeit auf gängigen Hardware-Clustern entwickelt wurde. Es gibt hauptsächlich drei Komponenten:

Hadoop Distributed File System (HDFS) : Dies ist ein skalierbares, fehlertolerantes Dateisystem, das speziell für die Speicherung und den Zugriff auf Daten in großen Clustern entwickelt wurde.

Hadoop YARN : YARN (Yet Another Resource Negotiator) ist ein Ressourcenmanager für Hadoop. Es ist für die Verwaltung von Cluster-Ressourcen und die Jobplanung verantwortlich, sodass mehrere Anwendungen Cluster-Ressourcen gemeinsam nutzen können.

MapReduce : Dies ist das Rechenmodell und Programmier-Framework von Hadoop. Es verarbeitet große Datensätze, indem es Eingabedaten in kleine Stücke schneidet und parallele Rechenaufgaben auf verteilten Knoten ausführt.

2. Wie viele Konstruktionsmodi gibt es für Hadoop?

a. Lokaler Modus ----- Er muss nur dekomprimiert werden und kann ausgeführt werden. Er wird im Allgemeinen zum Testen verwendet.

b. Pseudoverteilt ----- Es simuliert nur den Hadoop-Cluster und es gibt verschiedene Daemon-Prozesse. Diese Prozesse werden nur auf einem Knoten gehalten.

c. Vollständig verteilt ---- Auf mehreren Knoten aufgebaut, vollständig im Einklang mit der tatsächlichen Unternehmensentwicklung

3. Hadoops Pseudoverteilungskonstruktionsprozess

3.1. Hadoop-Installation (ähnlich der JDK-Installation)

1. Laden Sie das komprimierte Paket von hadoop2.7.3 nach /software hoch

2. Entpacken Sie das komprimierte Paket nach /opt

tar -zxvf /software/hadoop-2.7.3.tar.gz -C /opt

3. Benennen Sie die Datei um

mv /opt//hadoop-2.7.3 /opt/hadoop

4. Fügen Sie Hadoop zu den Umgebungsvariablen hinzu

vi /etc/profile

Am Ende der Datei hinzufügen

export HADOOP_HOME=/opt/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

5. Umgebungsvariablen aktualisieren

Quelle /etc/profile

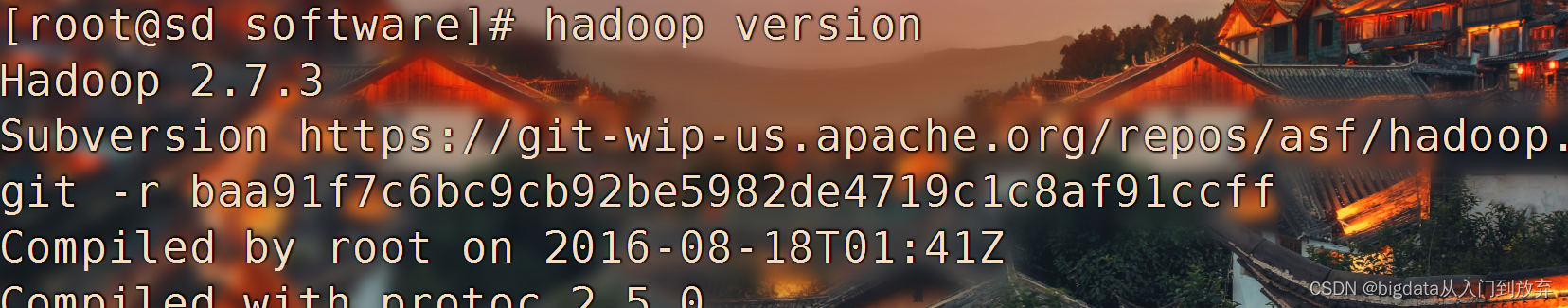

6. Befehl „Version erkennen“.

Hadoop-Version

Die Testergebnisse sind wie folgt:

3.2. Pi Hadoop kleiner Test

Im Hadoop-Installationspaket werden offiziell Beispiele für MapReduce-Programme bereitgestellt, um Ihnen den schnellen Einstieg in MapReduce zu erleichtern. Jeder kennt Pi und π. Wie schätzt man den Wert von Pi?

Wenn das zu lösende Problem die Wahrscheinlichkeit eines bestimmten Zufallsereignisses oder der erwartete Wert einer Zufallsvariablen ist, wird mithilfe einer „experimentellen“ Methode die Wahrscheinlichkeit des Zufallsereignisses auf der Grundlage der Häufigkeit des Ereignisses oder des Zufalls geschätzt Erhalten Sie ein Ereignis . Einige numerische Eigenschaften einer Variablen werden verwendet und als Lösung für das Problem verwendet.

Unter der Annahme, dass die Seitenlänge des Quadrats 1 und der Radius des Kreises ebenfalls 1 beträgt, beträgt die Fläche eines Viertelkreises:

Verteilen Sie Punkte zufällig im Quadrat. Es wird angenommen, dass die innerhalb des Viertelkreises verteilte Zahl a ist, die außerhalb des Kreises verteilte Zahl b ist und N die erzeugte Gesamtzahl ist: N=a+b.

Dann sollte das Verhältnis der Menge a zu N proportional zur Fläche eines Viertelkreises und der Fläche des Quadrats sein, dann:

hadoop jar /opt/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.3.jar pi 10 5

Der erste Parameter pi: gibt an, dass das MapReduce-Programm eine Pi-Berechnung durchführt; der zweite Parameter: wird verwendet, um die Anzahl der in der Kartenphase auszuführenden Aufgaben und den Grad der Parallelität anzugeben, der 10 beträgt; der dritte Parameter: wird verwendet, um die Stichprobe anzugeben Rate jeder Kartenaufgabe Die Zahl ist hier 5.

3.3. Hadoop-Pseudoverteilungskernkonfiguration

Die Kernkonfigurationsdatei von Hadoop befindet sich unter /opt/hadoop/etc/hadoop und ändert hauptsächlich core-site.xml, hdfs-site.xml, mapred-site.xml (kopiert aus mapred-site.xml.template) und Yarn -Fünf Dateien: site.xml und Slaves

1. Geben Sie den Speicherort der Kerndatei ein

cd /opt/hadoop/etc/hadoop/

Ändern Sie hadoop-env.sh

[root@sjz1 hadoop]# vi /opt/hadoop/etc/hadoop/hadoop-env.sh

und fügen Sie den Speicherort von jdk in Zeile 25 hinzuexportieren Sie JAVA_HOME=/opt/jdk

2. Ändern Sie core-site.xml (der Hostname unten muss durch Ihren eigenen Hostnamen ersetzt werden).

vi core-site.xml

Fügen Sie die folgenden Dateien zur Datei <configuration> <configuration>

<

!-- namenode communication address -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hostname:9000</value > hinzu

</property>

<!-- Hadoop-Standardbasispfad -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/tmp/hadoop</value>

</property>

</ Konfiguration >3. Ändern Sie die Datei hdfs-site.xml

vi hdfs-site.xml

Fügen Sie der Datei <Konfiguration> die folgenden Dateien hinzu

<configuration>

<!-- Pseudoverteilt nur einen Knoten -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>4. Ändern Sie die Datei „mapred-site.xml“. Mapred-site.xml wird kopiert.

cp mapred-site.xml.template mapred-site.xml

vi mapred-site.xml

Fügen Sie der Datei <Konfiguration> die folgenden Dateien hinzu

<configuration>

<!-- mapreduce默认执行框架是yarn -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>5. Ändern Sie die Datei „garn-site.xml“.

<configuration>

<!-- 服务配置 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>6. Ändern Sie die Slaves-Datei

Ändern Sie localhost darin in Ihren eigenen Hostnamen

7. Formatieren Sie im Hadoop-Home-Verzeichnis

cd /opt/hadoop

Hadoop-Namensknotenformat

8. Starten

start-all.sh

Wenn der Start erfolgreich ist, führt jps die folgenden Prozesse aus

[root@hadoop01 hadoop]# jps

100721 NameNode

101780 DataNode

103689 Jps

103224 NodeManager

101246 SecondaryNameNode

102542 ResourceManager

Sie können auf die Webseite von hadooop im folgenden Browser zugreifen, Adresse Host-IP: 50070

ps: Wenn der Prozess vorhanden ist und nicht darauf zugegriffen werden kann, überprüfen Sie bitte die Firewall. Wenn der Prozess fehlt, überprüfen Sie bitte das Protokoll.