文章目录

Guo, Z., et al. (2019). Attention Guided Graph Convolutional Networks for Relation Extraction. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics.

原文code,基于pytorch

abstract

依赖树传递丰富的结构信息,这些信息对于提取文本中实体之间的关系非常有用。然而,如何有效利用相关信息而忽略依赖树中的无关信息仍然是一个具有挑战性的研究问题。现有的方法使用基于规则的硬剪枝策略来选择相关的部分依赖结构,可能并不总是产生最佳结果。在这项工作中,我们提出了注意引导图卷积网络(AGGCNs),这是一种直接以全依赖树作为输入的新模型。我们的模型可以理解为一种软修剪方法,自动学习如何有选择地关注对关系提取任务有用的相关子结构。在包括跨句n元关系提取和大规模句子级关系提取在内的各种任务上的大量结果表明,我们的模型能够更好地利用全依赖树的结构信息,其结果显著优于以前的方法。

- 以前:

- 已经证明依赖树有用

- 挑战:如何有效利用相关信息而忽略依赖树中的无关信息

- 硬剪枝策略:不能得到最优结果

-

- 基于规则的硬剪枝会消除树中的部分重要的信息。

-

- 我们:AGGCNs(注意引导图卷积网络)

- 输入:全依赖树( full dependency trees

- 特点

- 端到端

-

软剪枝方法

- 基于规则的硬剪枝会消除树中的部分重要的信息。

- 给所有边分配权重,权重以端到端的形式学习得到–>自动学习剪枝

- 自动学习如何有选择地关注对re有用的相关子结构。

- 效果好

- 可并行地用于依赖树

- tips

- GCN+dense connection

- 目的:对一个大的全连通图进行编码

- 可得到局部和非局部依赖信息

- 2层GCN效果最好(经验)

- 可以学到更好的图形表示

- GCN+dense connection

- 可用于

- n元关系提取

- 大规模句子级别语料

- 效果更好

1.introduction

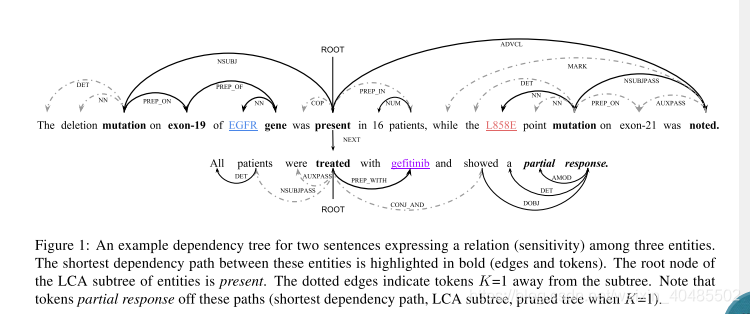

- 图中是一个依赖树

- 关系抽取用于

- biomedical knowledge discovery (Quirk and Poon, 2017),

- knowledge base population (Zhang et al., 2017)

- question answering (Yu et al., 2017).

为了进一步提高性能,本文还提出了多种裁剪策略来提取依赖信息。

Xu等人(2015b,c)只在全树实体之间的最短依赖路径上应用神经网络。

Miwa和Bansal(2016)将整个树缩减为实体的最低共同祖先**(LCA)**之下的子树。

Zhang等(2018)将graph convolutional networks **(GCNs) (**Kipf and Welling, 2017)模型应用于修剪过的树。这棵树包含从LCA子树的依赖路径到K的标记。

然而,基于规则的修剪策略可能会消除整个树中的一些重要信息。图1显示了一个跨句n元关系提取的例子,如果模型只考虑修剪树,那么键标记部分响应将被排除。理想情况下,模型应该能够学会如何在全树中包含和排除信息之间保持平衡。

在本文中,我们提出了一种新的注意引导图卷积网络(AGGCNs),它直接作用于全树。直观地,我们开发了一种软修剪策略,将原始依赖树转换为完全连接的边加权图。这些权重可以被视为节点之间的关联强度,可以通过使用自我注意机制以端到端的方式学习(Vaswani et al., 2017)。

- 硬剪枝:

- 基于规则的修剪策略可能会消除整个树中的一些重要信息

- 所以提出自动学习的软剪枝

- 关系抽取的模型可以分为两类

- sequence-based(基于序列的)

- 只对单词序列进行操作(Zeng et al.,2014; Wang et al., 2016)

- dependency-based(基于依赖的)

- 然而基于依赖的模型将依赖树合并到模型中(Bunescu和Mooney, 2005;Peng等人,2017)

- 依赖树+剪枝

- 比较:与基于顺序的模型相比,基于依赖的模型能够捕获仅从表面形式难以理解的非局部句法关系(Zhang et al., 2018)。

- eg:

- AGGCNs(软剪枝)

- 剪枝策略(硬剪枝)

- Xu等人(2015b,c)只在全树实体之间的最短依赖路径上应用神经网络。

- Miwa和Bansal(2016)将整个树缩减为实体的最低共同祖先(LCA)之下的子树。

- Zhang等(2018)将 (GCNs) (Kipf and Welling, 2017)模型应用于修剪过的树。

- 这棵树包含从LCA子树的依赖路径到K的标记。

- sequence-based(基于序列的)

1.1 dense connection+GCN

目的:对一个大的全连通图进行编码

我们接下来将稠密连接(Huang et al., 2017)引入GCN模型(Guo et al.,2019)

对于GCNs,L层将被需要为了捕获L跳跃离开到达的邻居的信息。浅层的GCN模型可能无法捕获大型图的非局部交互。有趣的是,虽然较深的GCNs可以捕获图的更丰富的邻域信息,但从经验上可以观察到,使用2层模型可以获得最佳性能(Xu et al., 2018)。在密集连接的帮助下,我们能够对深度的AGGCN模型进行训练,允许捕获丰富的局部地和非局部依赖信息。

- 2层GCNs最好

- dense connnection帮助下可以对深度AGGCN进行训练

- 可得到局部和非局部依赖信息

1.2 效果突出

实验表明,该模型能够较好地完成各种任务。对于跨句关系提取任务,我们的模型在多类三元关系和二元关系提取方面分别比现有模型的准确率高出8%和6%。对于大型句子级提取任务(TACRED数据集),我们的模型也始终优于其他模型,这表明了该模型在大型训练集上的有效性

1.3 contribution

我们提出了一种新颖的AGGCNs,它以端到端的方式学习一种“软修剪”策略,学习如何选择和丢弃信息。结合密集连接,我们的AGGCN模型能够学习更好的图形表示。

我们的模型在不增加额外的计算量的情况下与以前的GCNs相比获得了最新的结果。与树结构模型(如TreeLSTM (Tai et al., 2015))不同,它可以有效地并行地应用于依赖树。

2.Attention Guided GCNs

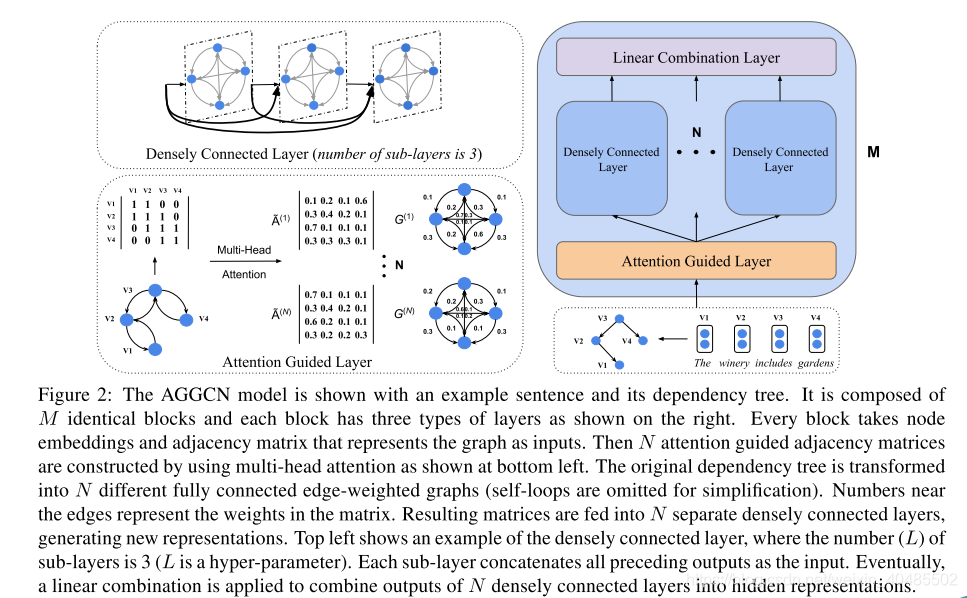

- AGGCN模型显示了一个示例语句及其依赖树。

- 它由M个相同的块组成,每个块有三种层,如图所示。

- 注意引导层

- 密集连接层

- 线性组合层

- 输入:每个块以表示图的节点嵌入和邻接矩阵作为输入。

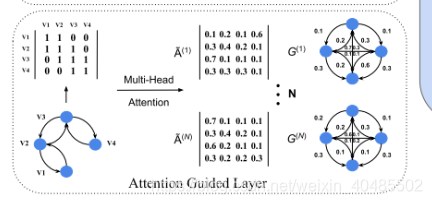

- 注意引导层:multi-head attention:然后利用左下所示的多头注意构造N个注意引导邻接矩阵。

- 原始的依赖树被转换成N个不同的完全连接的边加权图(为了简化,省略了自循环)。

- 靠近边的数字表示矩阵中的权值。

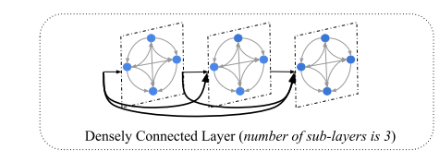

- 密集连接层得到的矩阵被送入N个单独的dense connection的层,产生新的表示。

- 左上角显示了一个密集连接层的例子,其中子层的数量(L)是3 (L是超参数)。

- 每个子层将所有前面的输出连接起来作为输入。

- 线性组合层:最后,应用线性组合将N个紧密连接的层的输出组合成隐藏的表示。

- 基本组件

- GCNs

- Attention Guided Layer

2.1 GCNs

- GCNs是直接作用于图结构的神经网络(Kipf和Welling, 2017)。

- 工作原理

- 图:给出一个有n个节点的图,我们可以用一个n×n邻接矩阵A来表示图。

- 加方向:使得GCNs对依赖树进行编码。(Marcheggiani和Titov(2017))

- 它们为树中的每个节点添加一个自循环。

- 还包括一个依赖弧的反方向,即

- 边i->j:

- 有则

- 无则

- 边i->j:

- l层节点i的卷积运算

- 输入:

- 输出:

- 公式:

- 表示全连接图的邻接矩阵的大小和原始树的大小一样

2.2 Attention Guided Layer

- 如前:硬剪枝的缺点

- 硬剪枝->硬-attention

正如我们在第1节中讨论的,大多数现有的修剪策略都是预定义的。他们将整棵树修剪成一个子树,并在此基础上构造邻接矩阵。事实上,这样的策略也可以被视为一种硬注意的形式(Xu et al., 2015a),其中连接不在结果子树上的节点的边将被直接分配零权重(无人值守)。这样的策略可能会从原始依赖树中删除相关信息。

我们没有使用基于规则的剪枝,而是在注意引导层开发了一种“软剪枝”策略,它为所有边缘分配权重。这些权重可以由模型以端到端方式学习。

- 我们:软剪枝

- 给所有边分配权重,权重以端到端的形式学习得到

- 实现自动学习剪枝

- 原:树

- 注意力引导层:将一个树->多个全连接有权图

- 从第二个块开始有这层

- 方法:构造注意引导邻接矩阵

- self-attention mechanism (Cheng et al., 2016)来得到

- 可以捕获单个序列的任意位置之间的交互。

- 本文:用multi-head attention 计算

- 它允许模型联合处理来自不同表示子空间的信息。

- 计算:包括一个查询和一组键值对。

- 输出:计算为值的加权和,其中的

- 权重:由具有相应键的查询函数计算。

- 公式

- self-attention mechanism (Cheng et al., 2016)来得到

-

和A尺寸相同

- 所以没有增加计算消耗

- 关键思想

- 使用注意力来诱导节点之间的关系,

- 特别是那些通过间接的多跳路径连接的节点。

- 图卷积层(在其后):

- 输入:

图2给出了将原始邻接矩阵转换为多个注意引导邻接矩阵的示例。因此,输入依赖树被转换成多个完全连接的边缘加权图。在实践中,我们将原始邻接矩阵作为初始化处理,以便在节点表示中捕获依赖项信息,以便以后进行注意计算。注意力引导层从第二个块开始。

2.3 Densely Connected Layer

- 优点

- 我们将稠密连接(Huang et al., 2017)引入AGGCN模型,

- 目的:在大图上捕获更多的结构信息。

- 在密集连接的帮助下,我们能够训练更深的模型,

- 允许捕获丰富的局部和非局部信息,从而学习更好的图表示。

- 做法:

- 直接连接从任何层引入到它前面的所有层。

- 超参数L:L个子层

- 子层的维度:输入维度d和L共同决定

- 输入维度:d->h_j的维度

- 子层是什么?

- 输出:每个子层的输出又会被连接起来->仍是d维

- 随子层数增加而缩小隐层size–>提高效率

与隐藏维度大于或等于输入维度的GCN模型不同,AGGCN模型随着层数的增加而缩小隐藏维度,以提高与DenseNets类似的参数效率(Huang et al., 2017)。

- N个注意力头–>N个分离的densely connection

- 原来GCN:

- 计算变为

2.4 线性层

2.5 AGGCN for RE

在依赖树上应用AGGCN模型之后,我们获得了所有令牌的隐藏表示。根据这些表示,关系提取的目标是预测实体之间的关系。接下来(Zhang et al., 2018),我们将句子表示和实体表示连接起来,得到最终的分类表示。

- 首先,我们需要获得

句子表示。它可以被计算为

- 相似地得到实体表示

- 最终:

- 由前馈神经网络得到最终表示(连接实体表示和句子表示)

- 最终表示输入到logistic regression classifier分类器中做预测。

3.实验

3.1 数据集

我们评估了该模型在两个任务上的性能,即

- 跨句n元关系提取

- 句子级关系提取

- TACRED数据集(收费)

- (Zhang et al., 2018)

- Semeval-10 Task 8

- (Hendrickx et al., 2010)

- TACRED数据集(收费)

3.2 设置

我们根据开发集的结果调整超参数。对于跨句nary关系提取任务,我们使用与(Song et al., 2018b)4相同的数据分割,而对于句子级关系提取任务,我们使用与(Zhang et al., 2018)5相同的开发集。

- n-ary

- 与(Song et al., 2018b)4相同的数据分割

- 句子级

- (Zhang et al., 2018)相同的开发集

- embedding:840B-300d-glove

- 超参数

- N(attention head数目)

- {1,2,3,4}

- L(densely connected中每层的维度)

- {2,3,4,5,6}

- M(块数)

- {1,2,3}

- N(attention head数目)

- 测试得到最好的超参数:

- cross-sentence n-ary

- {N=2,M=2,L=5,d_{hidden}=340}

- {N=3,M=2,L=5,d_{hidden}=300}

- cross-sentence n-ary

- 度量

- 和(Song et al., 2018b; Zhang et al., 2018).一样

- n-ary

- test:5-fold cross validation

- 句子

- micro-F1 score

- TACRED

- SemEval

- micro-F1 score

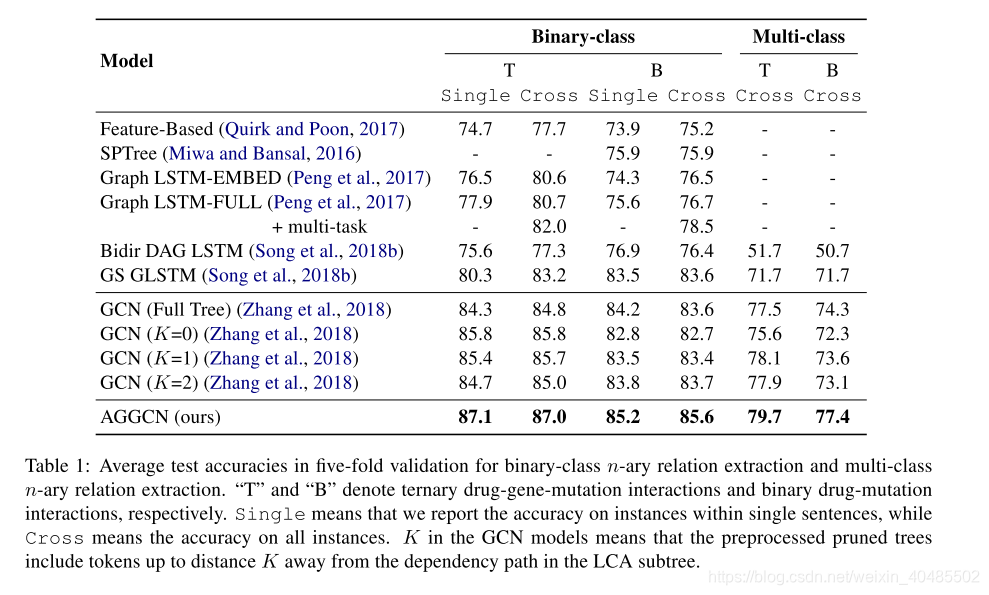

3.3 n-ary

- 三种模型

- a feature-based classifier (Quirk and Poon, 2017) based on shortest dependency paths between all entity pairs,

- Graph-structured LSTM methods,

- including Graph LSTM (Peng et al., 2017),

- bidirectional DAG LSTM (Bidir DAG LSTM) (Song et al., 2018b) and

- Graph State LSTM (GS GLSTM) (Song et al., 2018b).

- These methods extend LSTM to encode graphs constructed from input sentences with dependency edges,

- Graph convolutional networks (GCN) with pruned trees, which have shown efficacy on the relation extraction task (Zhang et al., 2018)

- the tree-structured LSTM method (SPTree) (Miwa and Bansal, 2016) on drug-mutation binary relation extraction.

- 本文结果好,因为

- 能用图卷积从树中得到更多信息:AGGCN is able to extract more information from the underlying graph structure to learn a more expressive representation through graph convolutions

- 比GCN好,因为

- densely connection

- 使之可在大图中信息传递

- 使之可有效地学习到长距离依赖

- attention

- 可筛去噪音,得到相关信息

- 本文的模型可从全树中得到更好的表达

- densely connection

3.4 句子级

- model

- dependency-based models,

- the logistic regression classifier (LR) (Zhang et al., 2017),

- Shortest Path LSTM (SDPLSTM) (Xu et al., 2015c),

- Tree-structured neural model (Tree-LSTM) (Tai et al., 2015),

- GCN

- Contextualized GCN (C-GCN) (Zhang et al., 2018).

- (Both GCN and C-GCN models use the pruned trees.)

- sequence-based models

- Position Aware LSTM (PA-LSTM) (Zhang et al., 2017).–最新成果

- dependency-based models,

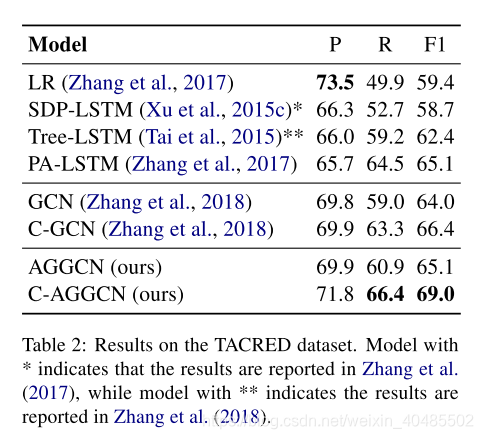

- TACRED

表2所示,logistic回归分类器(LR)的精度得分最高。我们假设这背后的原因是由于数据不平衡的问题。这种基于特征的方法倾向于预测一个频繁出现的标签之间的关系(例如,“per:title”)。因此,它具有较高的查全率,但查全率相对较低。另一方面,神经模型能够更好地平衡精度和回忆分数。

由于GCN和C-GCN已经显示出它们相对于其他基于依赖的模型和PA-LSTM的优越性,我们主要将我们的AGGCN模型与它们进行比较。我们可以观察到AGGCN比GCN多1.1个F1点。我们推测这种有限的改进是由于缺乏有关词序或消歧的上下文信息。

- 比GCN好

- GCN:这种有限的改进是由于缺乏有关词序或消歧的上下文信息。

与C-GCN类似(Zhang et al., 2018),我们使用双向LSTM网络扩展AGGCN模型,以捕获随后被送入AGGCN层的上下文表示。我们将修改后的模型称为C-AGGCN。我们的C-AGGCN模型F1得分为69.0,比目前最先进的C-GCN模型高出2.6分。我们也注意到AGGCN和C-AGGCN分别比GCN和C-GCN获得更好的精确度和回忆分数。

- 经验表明,AGGCN模型能够更好地区分相关和不相关信息,从而获得更好的图表示。

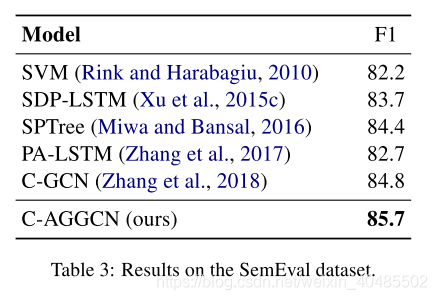

- SemEval

我们还在与(Zhang et al., 2018)相同的设置下,在SemEval数据集上评估我们的模型(Zhang et al., 2018)。结果如表3所示。这个数据集比TACRED小得多(仅为TACRED的1/10)。我们的C-AGGCN模型(85.7)始终优于C-GCN模型(84.8),具有良好的泛化能力。

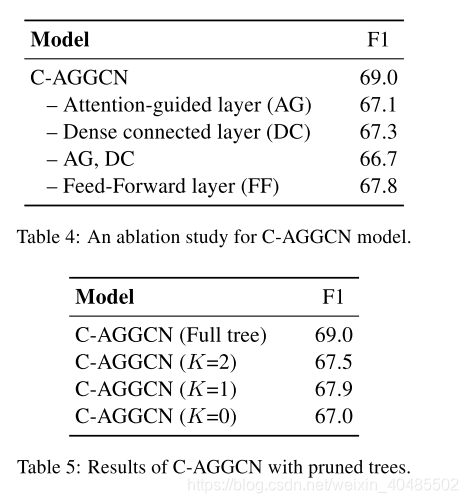

4.ablation Study

- 各组件的贡献

- AG>DG>FF

- AG,DG更重要

- 这两层可以帮助GCNs更好地学习信息聚合,产生更好的图形表示

烧蚀研究。

我们使用TACRED数据集上性能最好的C-AGGCN模型,研究了两个主要组件的贡献,即密集连接层和注意力引导层。表4显示了结果。我们可以观察到添加注意力引导层或者密集连接的层提高了模型的性能。这表明,这两层可以帮助GCNs更好地学习信息聚合,产生更好的图形表示,其中注意力引导层似乎发挥了更重要的作用。我们也注意到前馈层在我们的模型中是有效的。没有前馈层,结果下降到F1得分67.8。

- 自己相比较AGGCN

- 软修剪”策略在充分利用树信息方面优于硬修剪策略。

修剪树木的表现。

表5显示了使用修剪树的C-AGGCN模型的性能,其中K表示修剪后的树包含距离LCA子树中的依赖路径K以内的标记。我们可以看到,所有具有不同K值的C-AGGCN模型都能够超越最先进的C-GCN模型(Zhang et al., 2018)(见表2)F1成绩1.5分。这说明,在密集连接层和注意力引导层的结合下,C-AGGCN可以比C-GCN更好地学习下游任务的图形表示。此外,我们注意到全树的C-AGGCN性能优于所有修剪过的C-AGGCNs。这些结果进一步证明了“软修剪”策略在充分利用树信息方面优于硬修剪策略。

- C-AGGCN可以从更大的图(全树)中获益更多。

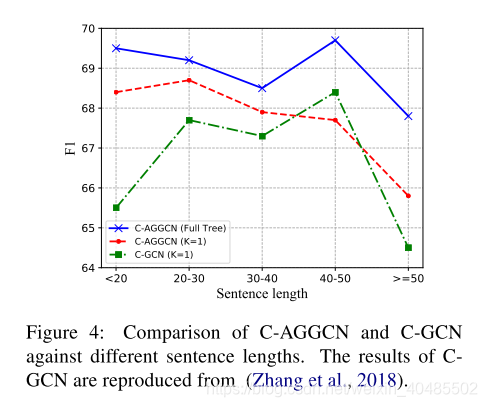

句子长度的性能。

图4显示了三个模型在不同句子长度下的F1得分。我们将句子长度划分为5类(< 20,[20,30],[30,40),[40,50),50)。一般来说,在不同的句子长度下,有完整树的C-AGGCN比有修剪过的树的C-AGGCN和C-GCN表现更好。我们还注意到,在大多数情况下,经过修剪的C-AGGCN比C-GCN表现得更好。此外,C-AGGCN对修剪后的树的改进效果随着句子长度的增加而减弱。这种性能下降可以通过使用全树来避免,全树提供了有关底层图结构的更多信息。直观地说,随着句子长度的增加,包含的节点越多,依赖关系图就越大。

- 我们的模型在使用训练资源方面更加有效。

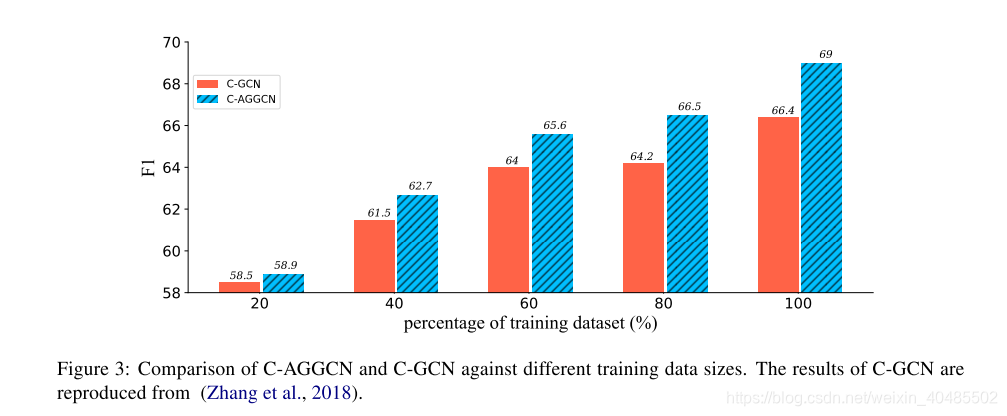

性能与训练数据大小的对比。图3显示了C-AGGCN和C-GCN在不同训练设置下的性能,训练数据量不同。我们考虑五种培训设置(20%、40%、60%、80%、100%的培训数据)。C-AGGCN持续优于C-GCN

当训练数据量增加时,我们可以观察到绩效差距变得更加明显。具体来说,使用80%的训练数据,C-AGGCN模型可以获得66.5的F1分,高于完整训练集上训练的C-GCN。这些结果表明,我们的模型在使用训练资源方面更加有效。

4.相关工作

4.1RE

- 早期的研究工作是基于统计方法。

- 研究了基于树的内核(Zelenko et al., 2002)和

- 基于依赖路径的内核(Bunescu and Mooney, 2005),以提取这种关系。

- McDonald等人(2005)构建最大的实体团来预测关系。

- Mintz等人(2009)在统计分类器中包含语法特征。

- 基于序列的模型利用不同的神经网络来提取关系,包括

- 卷积神经网络(Zeng et al., 2014;Nguyen和Grishman, 2015年;(Wang et al., 2016),

- 递归神经网络(Zhou et al., 2016;Zhang et al., 2017)

- 两者的结合(Vu et al., 2016)和

- transformer (Verga et al., 2018)。

- 基于依赖的方法还试图将结构信息合并到神经模型中。

- Peng et al.(2017)首先将依赖关系图分成两个dag,

- 然后将树LSTM模型(Tai et al., 2015)扩展到这两个图上进行n元关系提取。

- Song等人(2018b)使用图递归网络(Song等人,2018a)直接对整个依赖图编码,而不破坏它。

- AGGCN:和他们的模型的对比让人联想到CNN和RNN的对比。

- 为了进一步提高性能,还提出了各种各样的裁剪策略来提取依赖信息。

- Xu等(2015b,c)采用神经模型编码最短依赖路径。

- Miwa和Bansal(2016)将LSTM模型应用于两个实体的LCA子树。Liu等(2015)将最短依赖路径与依赖子树相结合。

- Zhang等人(2018)采用了一种以路径为中心的修剪策略。

- AGGCNs:与这些在预处理中去除边缘的策略不同,我们的模型以端到端的方式学会给每个边缘分配不同的权重

- Peng et al.(2017)首先将依赖关系图分成两个dag,

4.2GCN

- Gori等人(2005)布鲁纳(2014)介绍了尝试扩展神经网络以处理任意结构图的早期工作。

- 随后的工作通过局部谱卷积技术提高了计算效率(Henaff et al., 2015;Defferrard等人,2016)。

- AGGCN:与GCNs (Kipf和Welling, 2017)密切相关,GCNs将过滤器限制在每个节点周围的一阶邻域上运行。

- Velickovic等人(2018)提出了图形注意网络(GATs),利用掩蔽的自注意层来总结邻域状态(Vaswani等人,2017)。

- 与AGGCN相比,他们的动机和网络结构是不同的。

- 特别地,GATs中的每个节点只关心它的邻居,而AGGCNs则度量所有节点之间的关联性。

- GATs中的网络拓扑结构保持不变,而AGGCNs中将构建完全连接的图,以捕获长期的语义交互。

- 与AGGCN相比,他们的动机和网络结构是不同的。

5.结论

介绍了一种新的注意引导图卷积网络(AGGCNs)。实验结果表明,AGGCNs在各种关系提取任务上都取得了较好的效果。与以前的方法不同,AGGCNs直接对整个树进行操作,并学习以端到端方式从其中提取有用的信息。未来的工作有多个场所。我们想要问的一个很自然的问题是,如何利用所提出的框架对与图相关的任务执行改进的图表示学习(Bastings et al., 2017)。