回归模型,比如说线性回归模型和逻辑回归模型,比较常见的特征选择方法有两种,分别是最优子集和逐步回归。

1,最优子集(Best Subset Selection):从零号模型(null model)开始,这个模型只有截距项而没有任何自变量。然后用不同的特征组合进行拟合,从中分别挑选出一个最好的模型(RSS最小或R2最大),然后在这总共p+1个模型上交叉验证,选出其中最好的模型(Cp或BIC或adjusted R2)。这个最好模型所配置的特征就是筛选出的特征。

优点:因为遍历了所有可能的特征组合,因此筛选出的特征必定是最优的。

缺点:总共要拟合2p个模型,计算量非常大。

2,逐步回归(Stepwise Selection)

在特征较多的情况下,适用逐步回归法来进行特征选择。

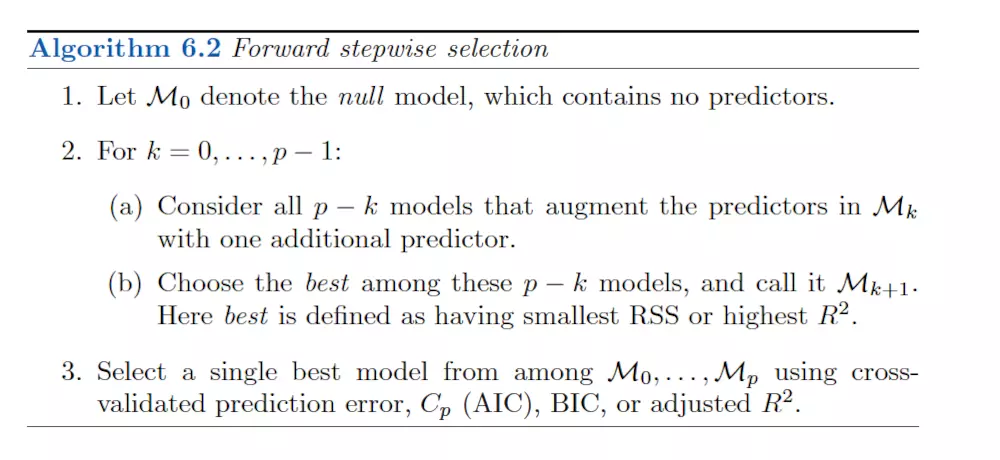

a. 前进法(Forward Selection):从零号模型(null model)开始,这个模型只有截距项而没有任何自变量。然后一个个地加入p个特征,保留RSS最小或R2最大的那个特征。然后再在这个模型的基础上一个个地加入剩余的p-1个特征,仍然保留RSS最小或R2最大的那个特征。这样重复操作,直至满足满足某个停止规则, 比如说剩余的自变量的p值都大于某个阈值。

b. 后退法(Backward Selection): 从包含所有自变量的模型开始,然后移除p值最大的那个特征,现在是包含p-1个特征的模型,继续移除p值最大的那个特征。这样重复操作,直至满足某个停止规则, 比如说模型中剩余的自变量的p值都小于某个阈值。

c. 混合法(Mixed Selection):从零号模型(null model)开始,这个模型只有截距项而没有任何自变量。和前进法一样加入特征,区别在于当某个特征的p值大于某个阈值时,移除该特征。重复这样的操作,直至模型中所有的特征都有足够低的p值,并且如果其余的特征加入其中会有超过某个阈值的p值。

前进法和后退法都属于贪心算法,能够局部达到最优,但是从全局来看不一定是最优的。前进法虽然每一次都能选取最显著的一个自变量,但在实际情况下,很可能有的自变量在开始时是显著的,但是在其余自变量添加进去之后,它就变得不显著了,而前进法却没有提供“剔除”该变量的选项。而后退法则很有可能会遗漏一些很重要的变量,虽然刚开始它可能并不显著。