背景

许多现有的NAS方法通过在小规模数据库上进行结构搜索,然后针对大规模数据库对深度和宽度进行手动调整。这一机制广泛的应用于NAS领域。但是由于大规模数据库与小规模数据库之间域的不同,在小规模数据库上的模型搜索算法应用于大规模数据库时,并不能保证其效果。

共享与创新

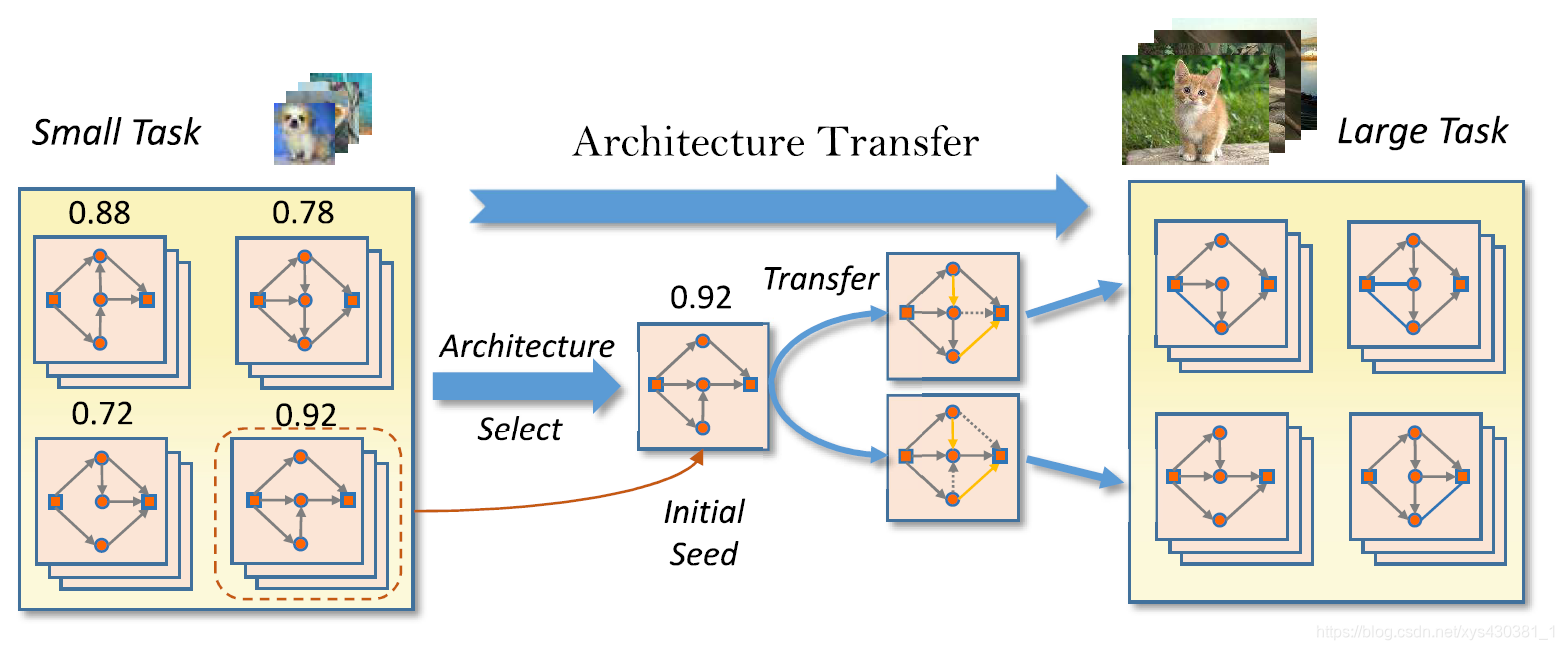

在这篇论文中,作者针上述的限制,提出了一种更合理的解决方案。作者使用迁移学习的方法从将针对小规模任务的结构应用到大规模任务上并进行微调。更详细地,作者使用了基于弹性框架的NAS方法——联赛选择,即首先使用现有的方法在小数据库上搜索神经框架,然后将上一步得到的框架作为初始化种子再在大型数据库上进行搜索。

总得来说,这篇文章的亮点主要可概括为:

- 提出一种弹性结构迁移机制(Elastic Architecture Transfer Machanism)用来弥补大规模任务和小型任务上进行结构搜索的差异。

- 由于使用了小规模数据库上的最优模型作为大型任务的初始化种子,该方法有效节省了在大规模数据库上进行模型搜索的时间。

- 在节省了计算资源的情况下,最终的模型仍然能达到不错的性能。

算法

EAT-NAS的基本思想如上图所示,首先使用进化算法在小型任务上搜索最优模型,然后将其作为第二阶段的初始化种子,再使用进化算法对大规模任务进行搜索。由于使用了小任务上的最佳模型对大任务的初始种群做初始化,在大规模任务上的搜索进程明显会比从零开始的收敛速度快得多。

- 作者使用了种群质量判别函数(Population Quality)以便在进化过程中对模型种群做出更好的评价。

- 此外,作者在第二阶段使用了后代结构生成器(offspring architecture generator)来产生新的结构。(主要是定义了一个新的变换函数,通过添加一些扰动,使得输入框架可以更加轻量并同质化)

- 为了同时对模型的准确度和尺寸进行优化,作者使用了Pareto优化进行求解,Pareto优化是多目标优化问题中一种求最优解集的方法。