1.Learning Deep Transformer Models for Machine Translation

https://arxiv.org/pdf/1906.01787.pdf

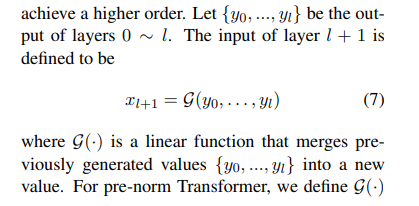

主要说明为如何训练一个深层的transformer,问题在于深层的梯度消失问题,采用的方法是对前面所有层的输出进行oncat, 利用线性层对结果进行维度修改后再喂给下一层,

和残差的思想类似,但是可以利用前面所有曾的结果,同时线性层的的矩阵是可以进行训练的。

同时还讨论了前项正则和后项正则的影响,后项正则再深度很深的情况下回产生梯度消失的情况,前项不会,但是增加了线性的连接之后就不存在这个问题了。后项也可以训练

图是前后向的差异:

2.RBF神经网络