目录

1.准确率(Accuracy)

准确率是一个用于评估分类模型的指标。通俗来说,准确率是指我们的模型预测正确的结果所占的比例。

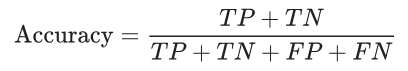

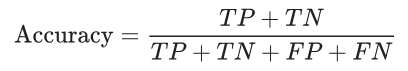

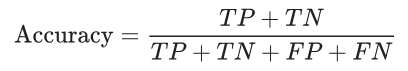

正式点说,准确率的定义如下:

对于二元分类,也可以根据正类别和负类别按如下方式计算准确率:

其中,TP = 真正例,TN = 真负例,FP = 假正例,FN = 假负例。

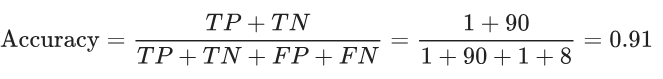

让我们来试着计算一下以下模型的准确率,该模型将 100 条流分为Tor (正类别)或no-Tor(负类别):

| 预测 | |||

| 1 | 0 | ||

| 实际情况 | 1 | 真正例 (TP):

|

假负例 (FN):

|

| 0 | 假正例 (FP):

|

真负例 (TN):

|

|

准确率为 0.91,即 91%(总共 100 个样本中有 91 个预测正确)。这表示我们的流量分类器在识别Tor流量方面表现得非常出色,对吧?

但只要我们仔细分析一下正类别和负类别,就可以更好地了解我们模型的效果。

在 100 个流量样本(实际情况)中,91 个为Tor(90 个 TN 和 1 个 FP),9 个为no-Tor(1 个 TP 和 8 个 FN)。

在 91 个no-Tor流量中,该模型将 90 个正确识别为no-Tor。这很好。不过,在 9 个Tor流量中,该模型仅将 1 个正确识别为Tor。这是多么可怕的结果!9 个Tor流量中有 8 个未被识别出来!

虽然 91% 的准确率可能乍一看还不错,但如果另一个Tor流量分类器模型总是预测no-Tor,那么这个模型使用我们的样本进行预测也会实现相同的准确率(100 个中有 91 个预测正确)。换言之,我们的模型与那些没有预测能力来区分Tor和no-Tor的模型差不多。

当您使用分类不平衡的数据集(比如正类别标签和负类别标签的数量之间存在明显差异)时,单单准确率一项并不能反映全面情况。

在2、3部分中,我们将介绍两个能够更好地评估分类不平衡问题的指标:召回率和精确率。

参考:https://developers.google.com/machine-learning/crash-course/classification/accuracy?hl=zh-cn

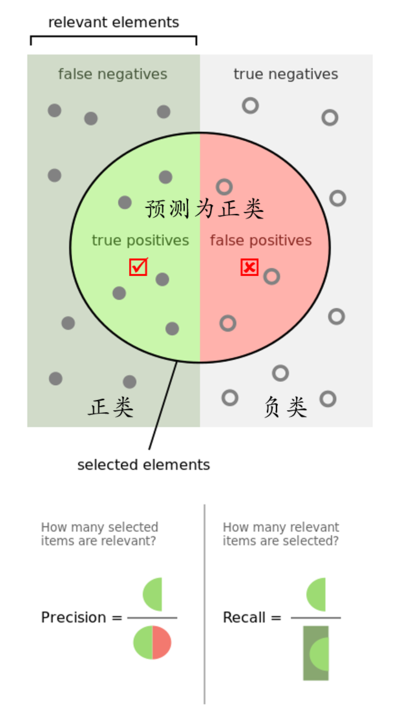

2.召回率(Recall=TPR)

召回率尝试回答以下问题:

在所有正类别样本中,被正确识别为正类别的比例是多少?

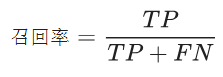

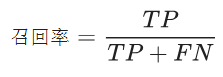

从数学上讲,召回率的定义如下:

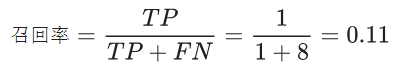

让我们来计算一下流量分类器的召回率:

该模型的召回率是 0.11,也就是说,该模型能够正确识别出所有Tor流量的百分比是 11%。

3.精确率(Precision)

精确率指标尝试回答以下问题:

在被识别为正类别的样本中,确实为正类别的比例是多少?

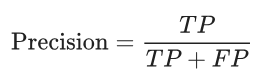

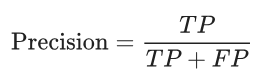

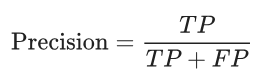

精确率的定义如下:

让我们来计算一下流量分类器的精确率:

该模型的精确率为 0.5,也就是说,该模型在预测Tor流量方面的正确率是 50%。

例1:如果我们试图识别对高度敏感材料的访问(例如关于特定抗议活动的特定网页)并且有兴趣收集访问该网页的嫌疑人列表。

事实证明,误报对这次攻击尤其具有破坏性,甚至可能比大多数其他应用程序领域更具破坏性。在网站流量指纹识别攻击中,误报结果是世界的内置属性:如果一个或多个页面的流量模式与目标页面的模式足够相似以触发误报,则这些页面集将始终被错误分类每次出现流量模式时作为目标页面。与端到端时序相关性不同,对手不会从重复访问得到的信息中受益(除了我们将在下面的文献综述中提到的狭隘,人为的情景)。

更重要的是,这也意味着小世界规模直接影响误报率。随着您增加世界大小,包含与目标网页的流量流匹配的网页的可能性也会增加。

那么:

N个独立加载的web page都没有误报的概率为,即

N个独立加载的web page至少有一个误报的概率为

即使精确率高达98%(这是该文献的典型值,并且由于世界规模较小而再次低于现实),在仅执行N = 100次不同的页面加载后,18%的用户群将是被错误地指控至少访问一次目标材料。在每个用户执行N = 1000个不同的页面加载之后,该用户群的86.5%将被错误地指责至少访问目标页面一次。事实上,这些用户中的许多人将被错误地指责(根据二项分布)。

简单来说,一个用户通过Tor访问N个web page,当N变多时,低精确率(98%也算低)即高误报率,将导致大量无关用户将受到影响。

例2:(暂时没有理解)如果对手试图干扰某些网页的流量模式,重要的评估指标也是精确度(或者说误报率)。

事实证明,误报对这次攻击尤其具有破坏性,甚至可能比大多数其他应用程序领域更具破坏性。在网站流量指纹识别攻击中,误报结果是世界的内置属性:如果一个或多个页面的流量模式与目标页面的模式足够相似以触发误报,则这些页面集将始终被错误分类每次出现流量模式时作为目标页面。与端到端时序相关性不同,对手不会从重复访问得到的信息中受益。

在低审查的条件下(0.1% - 例如当Tor流量成功地与大量无害的互联网流量混合,或当Tor用于审查规避和一般隐私时),TPR=0.6和FPR=0.005,我们有:

简单来说,很多用户(流量,包括Tor与no-Tor)访问指定网站,

4.召回率与精确率的关系

| 预测 | ||||

| 1 | 0 | |||

| 实际情况 | 1 | 真正例 (TP):

|

假负例 (FN):——漏报

|

|

| 0 | 假正例 (FP):——误报

|

真负例 (TN):

|

||

|

|

|||

在信息检索领域,召回率和精确率又被称为查全率和查准率:

- 查全率=检索出的相关信息量 / 系统中的相关信息总量

- 查准率=检索出的相关信息量 / 检索出的信息总量

由此可以理解:

- 假负例 (FN)又叫漏报

- 假正例 (FP)又叫误报

参考:机器学习性能评估指标

5.误报率(FPR)与漏报率(FNR)

| 预测 | ||||

| 1 | 0 | |||

| 实际情况 | 1 | 真正例 (TP):

|

假负例 (FN):——漏报

|

|

| 0 | 假正例 (FP):——误报

|

真负例 (TN):

|

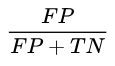

误报率= |

|

|

漏报率= |

|

||