一篇最近阅读复现的论文。GETNET: A General End-to-End 2-D CNN Framework for Hyperspectral Image Change Detection,这是一篇今年发表在TGRS上的论文,主要工作是提出了一个基于端到端的2D卷积网络的高光谱遥感影像的变化检测框架;并且开源了一个包含2幅 波段遥感影像的变化检测数据集。

算法介绍

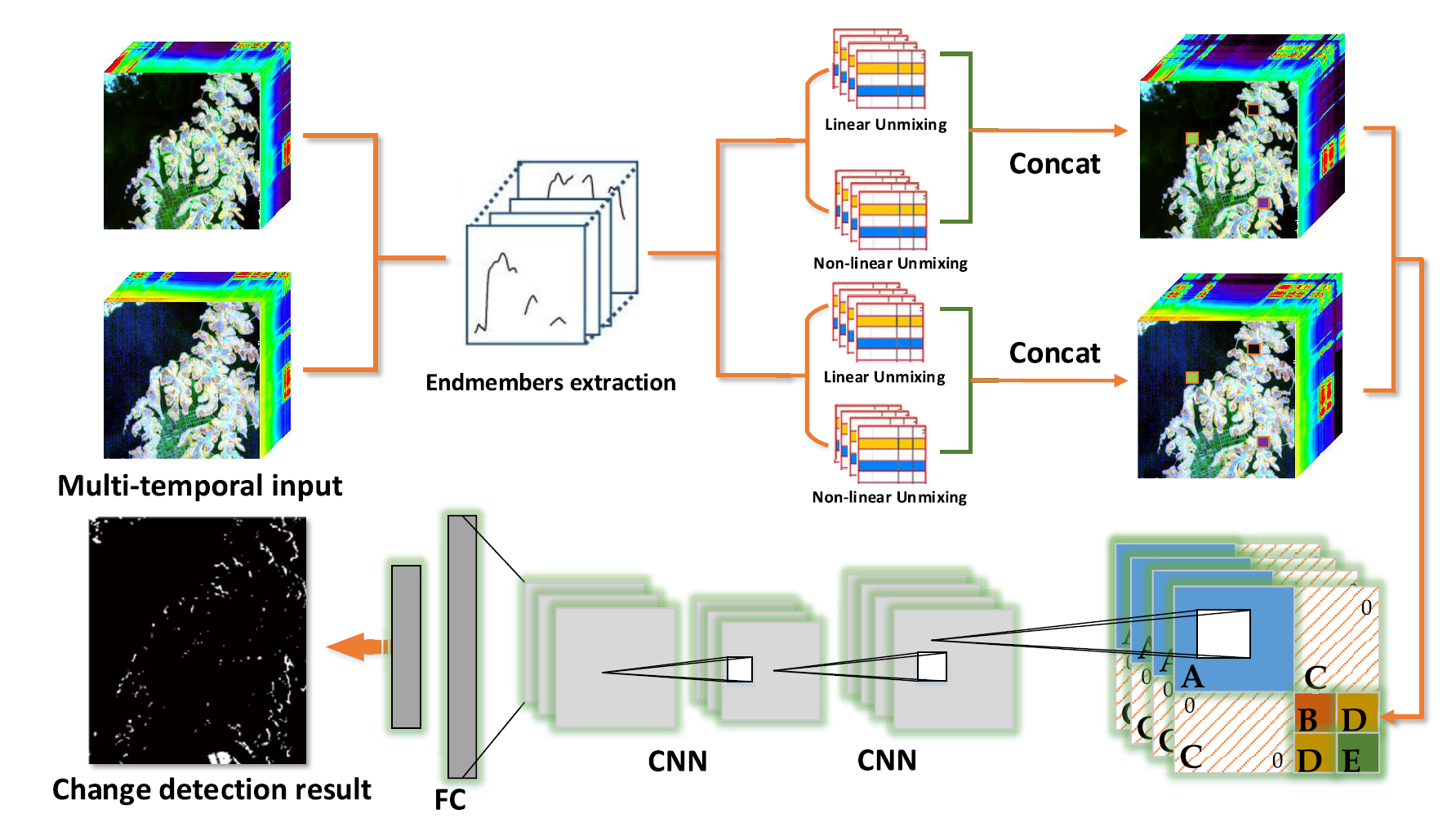

论文首先总结了变化检测的一般性质和过程,然后指出了高光谱影像变化检测的独特之处以及面临的主要难点。包括(1)混合像素问题、(2)数据维度较高和(3)数据集有限三个问题。所以论文的目的就是针对上述三个挑战,提出了一个基于深度神经网络和深度分析混合像素的高光谱变化检测网络框架GETNET。其网络框架图如下:

图1:GETNET流程框架图

主要过程为,对于多时相的高光谱影像,首先进行端元提取;根据提取到的端元进行线性和非线性的解混;解混的结果和原图像进行拼接;计算两个时相影像像素之间的混合亲和矩阵;以混合亲和矩阵作为像素不同时相之间相关性的特征图,经过CNN分类得到变化和未变化的类别;其中,值得注意的是,CNN对特征图的不同区域采用了不同的卷积核。算法的主要步骤和细节如下:

亚像素级别的Hybrid-Unmixing

为了获得亚像素级的信息,提高泛化能力,提出的网络结构中采用了光谱分解(spectral unmixing)的方法。首先使用ATGP算法[1]进行端元提取,假设提取到的端元为 ,其中 是高光谱图像的波段, 是端元数目。我们使用两种模型:线性的和非线性的来评价abundance(丰度?)。

线性的混合模型认为每一个像素都是端元的线性组合,所以一个像素的reflectance就可以表示为:

就是要求的reflectance系数,是一个 的向量, 是一个 的线性abundances系数。文章中采用的是FCLS模型[2]进行求解线性模型的系数。

非线性的混合模型公式化表示为:

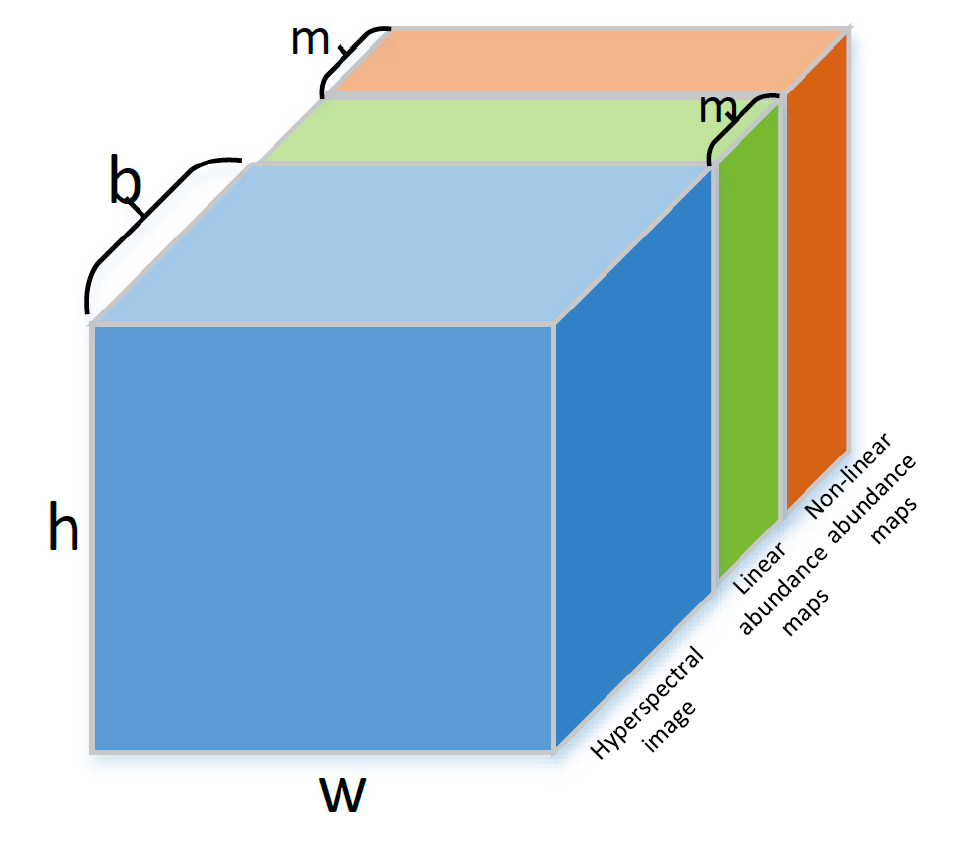

是点乘运算符。非线性混合模型的求解方式是基于bilinear-Fan model (BFM)[3]模型的。获得这两个模型的结果之后,我们对reflectance系数 进行拼接到原始高光谱影像上,如下图所示:

图2:拼接后的高光谱影像

蓝色、绿色、橙色的部分分别是原始的高光谱图像、线性abundance图、非线性abundance图。abundance图对应像素位置是他们的reflectance系数 。这样一个 的高光谱影像就可以扩展为 。

为信息融合生成混合亲和矩阵(Mixed-Affinity Matrix)###

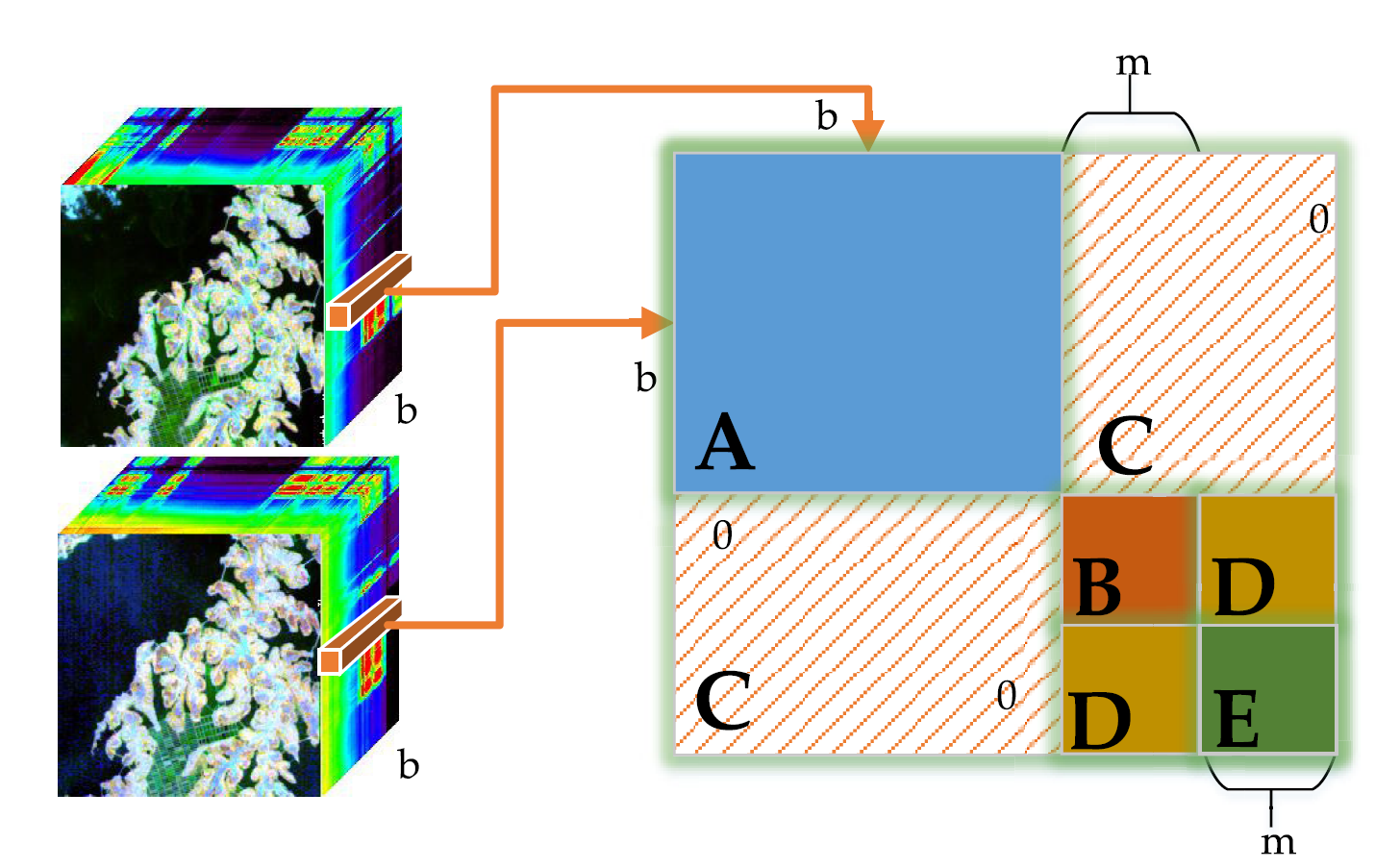

论文提出了一种新颖的特征表达方式。具体而言就是两个对应位置像素的向量来求一个2D混合亲和矩阵(Mixed-Affinity Matrix),作为该像素位置变化还是未变化类别的特征图。矩阵的计算方式如下:

其中 。 是时相1中的一个像素, 是时相2对应位置的像素。具体而言,二维矩阵 形式分为以下5个部分,如下图所示

图3:一个像素的Mixed-Affinity Matrix

A部分是像素层级的差异信息,大小为 ;B、E、D部分是亚像素级别的差异信息,大小都是 ;原始的高光谱数据和abundance之间的关系没有意义,所以C部分值都是0.

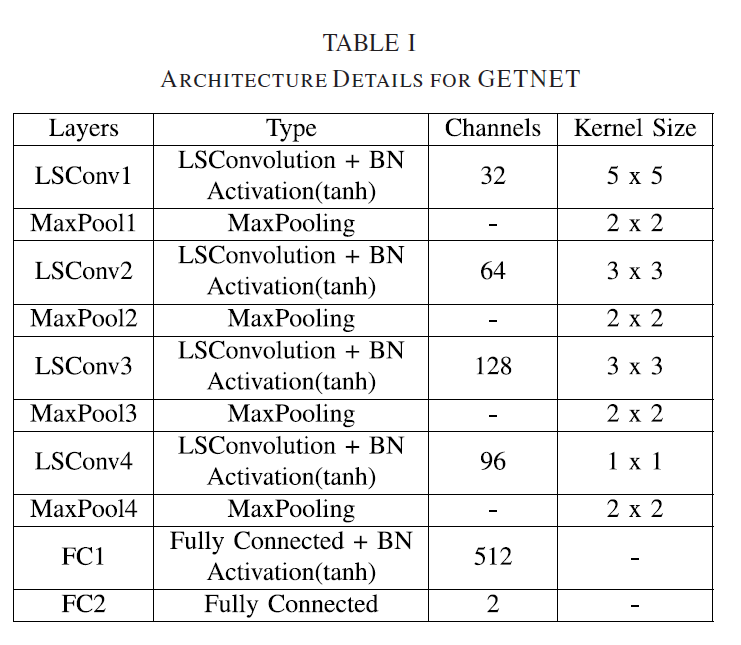

结合Separation and Combination的GETNET网络

每个像素点都可以表示为一个Mixed-Affinity Matrix之后,我们可以用一个卷积神经网络来对其进行分类,得到变化和未变化的像素类别。卷积网络具体架构以及各个层次的信息如下表所示:

复现实验

待续 /// 无

参考:

【1】H. Ren and C.-I. Chang, “Automatic spectral target recognition in hyperspectral imagery,” IEEE Trans. Aerosp. Electron. Syst., vol. 39, no. 4, pp. 1232–1249, Oct. 2003.

【2】D. C. Heinz and C.-I. Chang, “Fully constrained least squares linear spectral mixture analysis method for material quantification in hyperspectral imagery,” IEEE Trans. Geosci. Remote Sens., vol. 39, no. 3, pp. 529–545, Mar. 2001.

【3】J. Yu, D. Chen, Y. Lin, and S. Ye, “Comparison of linear and nonlinear spectral unmixing approaches: A case study with multispectral TM imagery,” Int. J. Remote Sens., vol. 38, no. 3, pp. 773–795, 2017.