前言:

英伟达的Jetson TX2使得很多人认为深度学习模型终于可以像嵌入式开发平台那样做到小型化了,不用再跑在高配计算机或者服务器上面了,但是实际上Jetson TX2开发板的性能和深度学习常用到的1080(Ti)以及2080 还有一定的差距,接下来英伟达又出了一个Jetson Xavier,可以说是Jetson TX2的升级版,性能自然是强了很多,并且个人很喜欢的是英伟达把他封装成了一个小黑盒子,非常便携。

下面就具体的数据对比说明其性能的差别

1、常见的GPU:RTX 2080 Ti、RTX 2080、GTX 1080 Ti、Titan V和Tesla V100

下表中的数据为FP32(单精度),batchsize=32时的测试结果,数字代表吞吐量(即每秒处理的图片的数量 img/s )

(FP16 或int 8 时吞吐量数值会更大)

| 模型/GPU | 2080 | 2080 Ti | Titan V | V100 | 1080 Ti |

|---|---|---|---|---|---|

| RESNET-50 | 209.89 | 286.05 | 298.28 | 368.63 | 203.99 |

| RESNET-152 | 82.78 | 110.24 | 110.13 | 131.69 | 82.83 |

| InceptionV3 | 141.9 | 189.31 | 204.35 | 242.7 | 130.2 |

| InceptionV4 | 61.6 | 81 | 78.64 | 90.6 | 56.98 |

| VGG16 | 123.01 | 169.28 | 190.38 | 233 | 133.16 |

| AlexNet | 2567.38 | 3550.11 | 3729.64 | 4707.67 | 2720.59 |

| SSD300 | 111.04 | 148.51 | 153.55 | 186.8 | 107.71 |

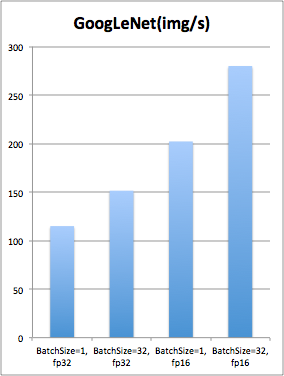

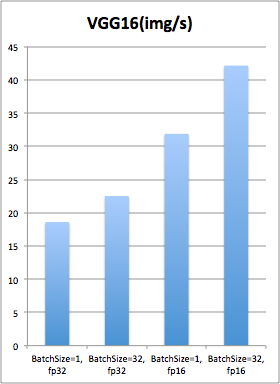

2、Jetson TX2 深度学习性能测试

以GoogleNet 、VGG16说明,Jetson TX2暂时不支持int 8 格式的数据。

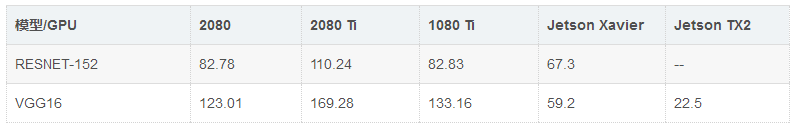

3、Jetson Xavier 性能测试

batchsize=32

4、Jetson Xavier、Jetson TX2、 1080(Ti)、2080 在VGG16深度学习模型运行性能的对比

FP32(单精度)格式数据,batchsize=32,数据为吞吐量(img/s)

可以看出来Jetson Xavier 虽然有一定的差距,但是随着模型层数(复杂度)的增加,其和1080ti的差距越来越小,实际的性能已经超越了1080 显卡了,因此具有一定的实用性。

注:Xavier和TX2 中使用的为TensorRT框架,其预先为开发者做了大量繁重的准备工作,使他们能充分利用GPU中的Tensor Core(张量计算核心)和DLA单元(Deep Learning Accelerator,深度学习加速器),所以当你使用自己训练的TensorFlow模型或者caffe模型,需要进行转换一下,然后才可以运行,当然你也可以直接安装TensorFlow,但是这样你就有可能舍弃了张量核和DLA,开发板的性能有可能得不到充分的发挥。

参考资料:

NVIDIA Jetson Xavier性能首测:https://www.leiphone.com/news/201901/yOo41XffEuB1QwHy.html

TensorFlow 各常用GPU基准测试:https://www.jqr.com/article/000528

Jetson TX2 测试:https://yq.aliyun.com/articles/160369?utm_content=m_28033

开发板开发者实际自测对比1:https://blog.csdn.net/maxhn0/article/details/86630230

开发板开发者实际自测对比2:https://blog.csdn.net/weixin_40755306/article/details/81710417