centos7 单机spark的安装与配置详解

1.yum进行更新

yum upgrade

saprk的安装需要安装jdk、scala、spark

2. jdk安装与配置

安装

sudo yum install java-1.8.0-openjdk-devel.x86_64

配置

我们需找到jdk文件路径

命令:

rpm -ql java-1.8.0-openjdk-devel-1.8.0.191.b12-1.el7_6.x86_64

打开配置文件

vim /etc/profile

进行环境变量配置(文件路径要自己进行查看 路径是否正确)

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.191.b12-1.el7_6.x86_64

export JRE_HOME=$JAVA_HOME/jre

export PATH=$PATH:$JAVA_HOME/bin

环境变量生效

source /etc/profile

3. scala安装与配置

安装

wget http://www.scala-lang.org/files/archive/scala-2.11.8.tgz

对下载文件进行解压

tar -zxf scala-2.11.8.tgz

将文件移入lib文件下

mv scala-2.11.8 /usr/lib

配置

vim /etc/profile

export SCALA_HOME=/usr/lib/scala-2.11.8

export PATH=$PATH:$SCALA_HOME/bin

source /etc/profile

4. spark安装与配置

安装

wget http://d3kbcqa49mib13.cloudfront.net/spark-2.0.0-bin-hadoop2.7.tgz

476

解压

tar -zxf spark-2.0.0-bin-hadoop2.7.tgz

配置

vim /etc/profile

export SPARK_HOME=$HOME/spark-2.0.0-bin-hadoop2.7

export PYTHONPATH=$PATH:$SPARK_HOME/python

source /etc/profile

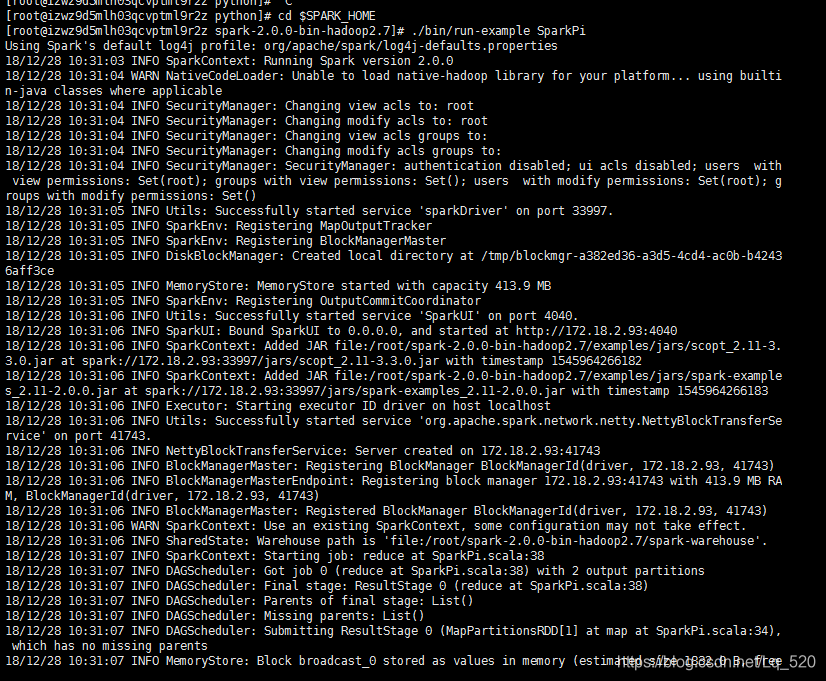

- 启动spark

进入spark文件

cd $SPARK_HOME

启动spark自带求π程序

./bin/run-example SparkPi

上面有π的输出结果,Pi is roughly 3.144… 代表成功,如果报no command ,就是环境变量配置错误,可以进行环境变量测试,看环境变量是否正确。