版权声明:博客转载,请标注 来自 丁磊_ml博客 网址为 blog.csdn.net/MosBest https://blog.csdn.net/MosBest/article/details/79783036

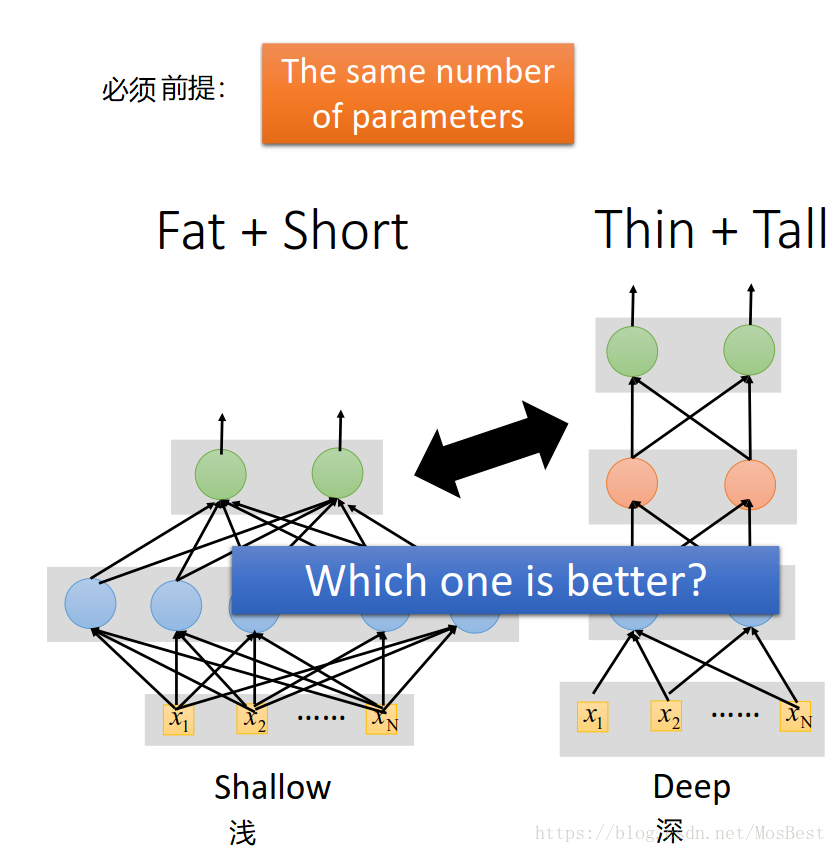

1. 模型深且瘦,要优于 矮且胖?

在参数一样的前提下,是模型深且瘦好些,还是矮且胖好些???

**

答案:在参数一样的前提下,模型越深越好

。**

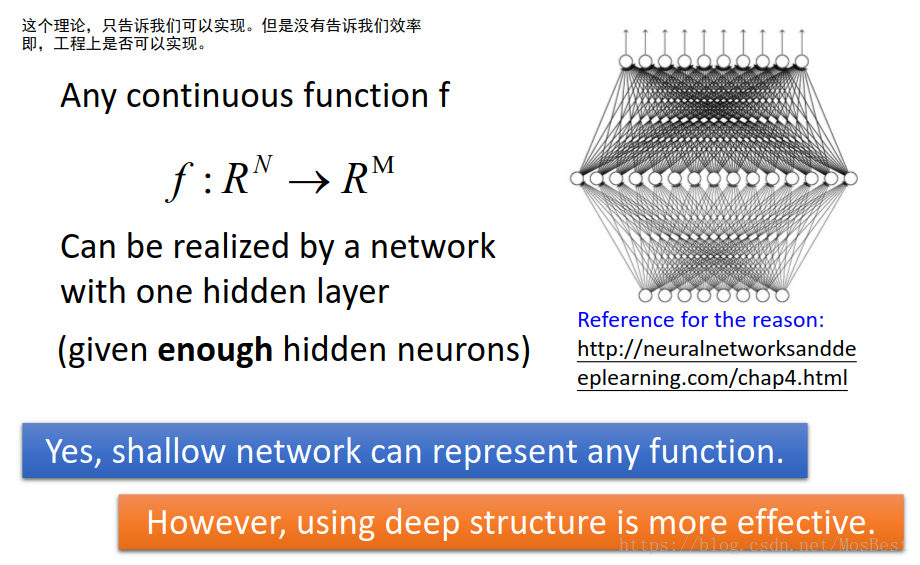

2. 在参数不变前提下,为什么模型越深越好???

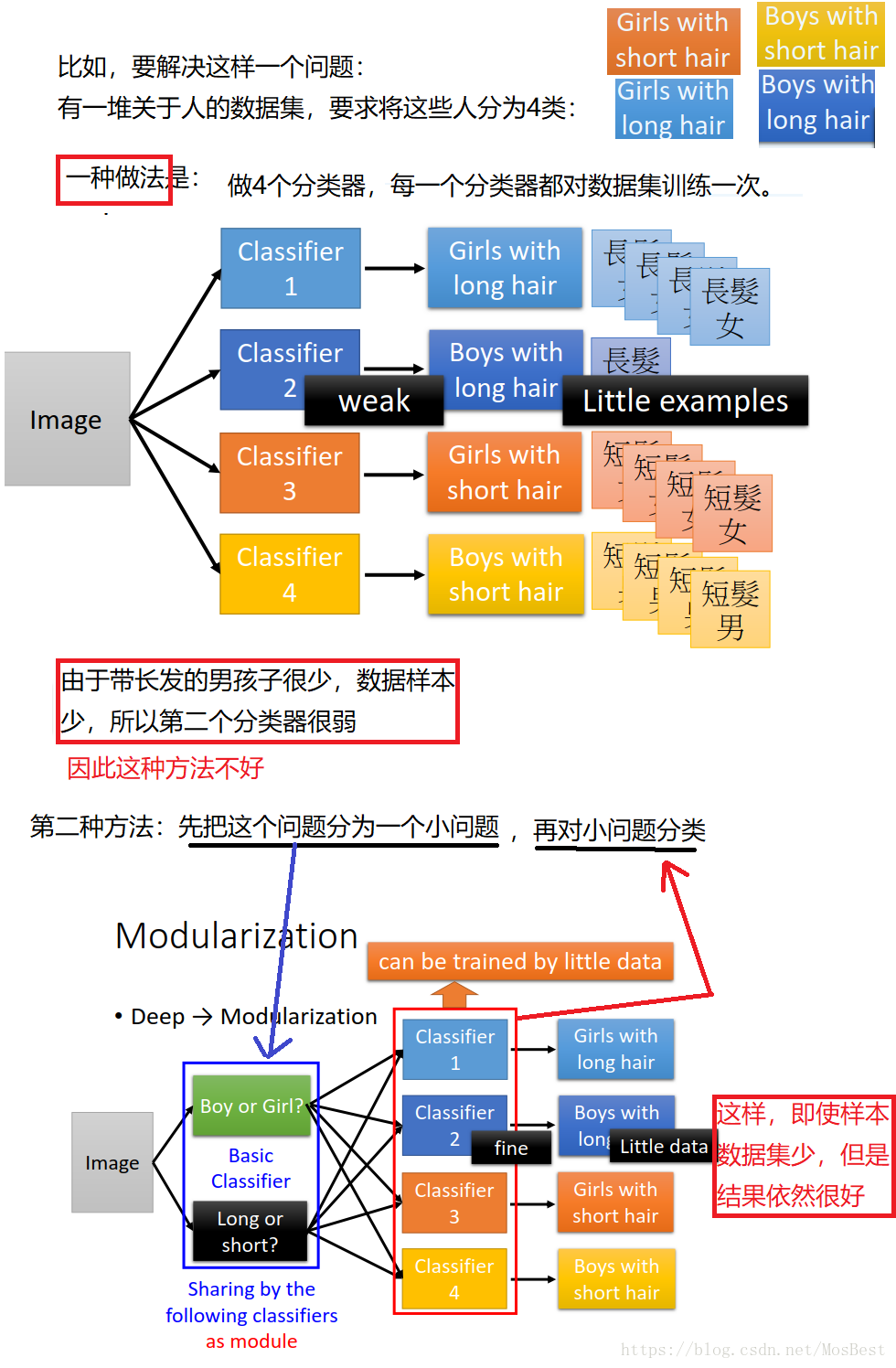

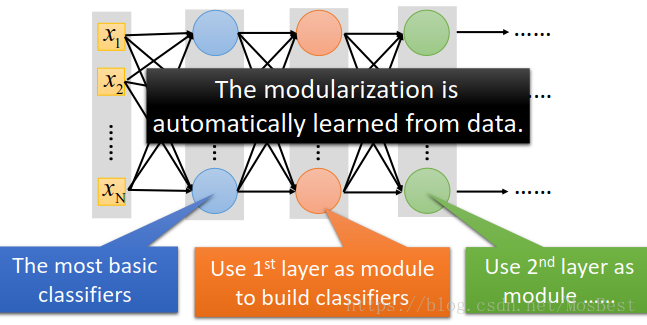

其实,“加大深度”就相当于函数中的模块化。

也就是“并不急于解决问题,而是把问题切成比较小的问题,再解决”。

而且这样的好处是:“数据集要求低,并不需要太多的数据”

比如:

而“加大深度”就 相当于 模块化。每一层的神经元,就相当于进行了一次“将问题划分为几个小问题。”后面的一层网络就相当于前面一层网络的小问题划分结果。

那么根据上面所说,可得:

deep 就相当于 模块化 。模块化就可以减少数据的需求量。所以deep 只需要比较少的需求量。

为什么我们要做deep learning ,就是因为我们没有足够的data,才会考虑deep learning。

很多人认为玩deep learning 就需要很多很多的数据,其实并不是,deep learning 需要少的数据也可以达到很好的效果。