基于图像成对相关关系图模型的姿态估计

Articulated Pose Estimation by a Graphical Model with Image Dependent Pairwise Relations

原文地址:https://arxiv.org/abs/1407.3399 引用请注明其出处。

Xianjie Chen

加州大学洛杉矶分校,CA 90024

[email protected]

Alan Yuille

加州大学洛杉矶分校,CA 90024

[email protected]

摘要

作者提出了一种基于图模型从单个静态图像估计人体姿态的方法,该图模型具有新颖的成对关系,其使得自适应地使用局部图像测量。更确切地说,作者指定了人体姿态的图模型,其利用了局部图像测量,它既可用于检测部件(或关节)以及预测它们之间的空间关系(图像依赖成对关系)的事实。这些空间关系由混合模型表示。作者使用深度卷积神经网络(DCNN)来学习图像块内部件的存在及其空间关系的条件概率。本文模型将图模型的表征灵活性与DCNN的效率和统计功效相结合。作者的方法明显优于LSP和FLIC数据集上的最新技术方法,并且在没有任何训练的情况下在Buffy数据集上也表现得非常好。

1 介绍

关节姿态估计是计算机视觉中的基本挑战之一。该领域的进展可以立即应用于重要的视觉任务,如人体跟踪[2],行动识别[25] 和视频分析。

大多数关于姿态估计的工作都是基于图模型[8,6,27,1,10,2,4]。图节点表示身体部位(或关节),边缘模拟部件之间的成对关系。模型的得分函数或能量在每个节点处包含单元项,以捕获部件的局部外观线索,以及在边上定义的成对项,以捕获部件之间的局部上下文关系。最近,DeepPose[23] 提倡以整体方式对姿态进行建模,基于回归在深度卷积神经网络(DCNN)中捕捉所有身体部位的完整背景[12] 。

图1 动机。图像块中的关节周围的局部图像可以可靠地预测其所有邻居的相对位置(及检测关节)。

中间:以肘部为中心的局部图像块可以可靠地预测肩部和腕部的相对位置,以腕部为中心的局部图像块可以可靠地预测肘部的相对位置。

左右:作者为每对相邻关节定义不同类型的成对空间关系(即混合模型)。左侧表现了肘部与其邻居(即肩部和手腕)之间可能具有的典型空间关系。右侧面板表现了手腕与其邻居(即肘部)之间可能具有的典型空间关系。

在本文中,作者基于图像相关的成对关系(IDPRs)提出了一个图像模型。如 图1 所示,通过观察周围的局部图像块,作者可以可靠地预测部件的邻居的相对位置(以及部件本身的存在)。因此,在作者的模型中,局部图像块为单元和成对项提供输入。这提供了更强的成对项,因为数据独立关系通常要么太宽松而不能有用,要么太严格来模拟高度可变的姿态。

作者提出一种方法可以从局部图像块中提取关于成对部件关系以及部件存在的信息。此方法高效并在不同部件和部件关系之间共享功能。为此,作者训练DCNN输出作者的得分函数的单元、成对项中使用的部件存在和空间关系的估计。使用结构化支持向量机(S-SVM)训练模型中不同项的权重参数[24]。总之,作者的模型结合了图模型的表征灵活性,包括表示空间关系的能力,以及DCNN的数据驱动能力。

作者在两个标准姿态估计基准数据集上进行实验:LSP数据集[10] 和FLIC数据集[20]。作者的方法在两个数据集上都优于已有技术方法。作者还对Buffy数据集进行跨数据集评估[7] (没有对此数据集进行训练)并获得强大的结果,表现了模型泛化的能力。

2 模型

图模型及其变量: 作者通过图模型表示人体姿态 ,其中节点指定部件(或关节)的位置,边缘指示哪些部件在空间上相关。为简单起见,作者把图构造成 节点树,其中 。部件的位置用 表示,其中 指定部件 的像素位置, 。对于图中的每个边 ,作者指定一个由 索引的离散空间关系集,它对应于不同空间关系的混合(见 图1 )。作者用 表示空间关系集。图像写为 .作者用单元和成对项的和定义得分函数 。

单元项: 单元项为部件

提供定位置信度,使其位于位置

并且基于图像块定位

。它们的形式如下:

其中

是(标量)外观项,其中

作为其参数(在下一节中指定),

是标量权重参数。

图像相关成对关系(IDPR)项: 这些IDPR术语捕获了作者的直觉,相邻部件 可以仅使用定位信息粗略预测其相对空间位置(参见 图1 )。在作者的模型中,部件 和 的相对位置分为几种类型 (即不同关系的混合)包含对应的平均相对位置加上由标准二次曲线建模的小形变量 。更正式地说,每条边的成对关系得分 由下式给出:

其中 是标准的二次变形特征, 是图像相关成对关系(IDPR)项,其中 为其参数(在下一节中指定)。 是权重参数。符号 表示点积。

整体得分: 满分 是部件位置 ,成对关系类型 和输入图像 的函数。它表示为单元和成对项的总和:

其中 是常数1的标量权重(即偏差项)。

该模型由三组参数组成:平均相对位置 是不同的成对关系类型;外观项和IDPR项的参数 ;和权重参数 。

2.1 图像相关项和DCNN

外观项和IDPR项取决于图像块。换句话说,局部图像块 不仅给出了部分 的存在的置信度,而且还给出了它与它的邻居 之间的关系 ,其中 当且仅当 。这要求作者学习以图像块 为条件的状态变量 , 的分布。为了指定这种分布,必须更精确地定义状态空间,因为成对空间关系的数量因不同部分的不同而具有不同的邻居数量(参见 图1 ),作者还考虑了块不包含部分的可能性。

作者将 定义为随机变量,表示对于 ,哪个部分存在 。如果没有部件(即背景)则 。作者将 定义为确定 的空间关系类型的随机变量,并取 中的值。如果 有一个邻居 (例如,手腕),那么 。如果 有两个邻居 和 (例如,肘部),那么 。如果c = 0,那么作者定义 。

整个空间表示为:

空间的大小是 。此空间中的每个元素对应于一个部分所有类型的成对关系,或背景。

作者使用DCNN [12] 学习条件概率分布

。DCNN适用于此任务,因为它非常高效并且使作者能够共享功能。更多细节见第四章。

作者用

来指定外观项和IDPR项,用

指定边缘化的

:

2.2 与其他模型的关系

作者现在简要讨论作者的方法如何与标准模型相关。

图片结构: 作者通过仅允许一种关系类型(即

)恢复图像结构模型 [6] 。在这种情况下,作者的IDPR项不传达任何信息。作者的模型减少到标准单元和(图像无关)成对项。唯一的细微差别是作者使用DCNN来学习单元项而不是使用HOG滤波器。

部件的混合: [27] 描述了每个部件混合使用模板的模型,其中每个模型称为部件的“类型”。每个部分的“类型”由其相对于其父部分的相对位置来定义。这可以通过将作者模型中的每个部分限制为仅预测其父亲的相对位置来获得(即,如果 不是 的父亲,则 )。在这种情况下,每个部分只与一个信息IDPR项相关联,可以与每个部分的外观项合并,以定义部分的不同“类型” [27]。此方法也不使用DCNN。

条件随机场(CRF): 作者的模型还与数据相关先验的条件随机场文献有关[18,13,15,19]。数据相关的先验和单元项通常在CRF中单独建模。在本文中,作者通过利用局部图像测量可靠地预测零件的存在和零件的成对关系这一事实,在单个DCNN中有效地模拟所有图像相关项(即单元项和IDPR项)与邻居。

3 推理

为了检测每个人的最佳配置,作者搜索最大化得分函数的位置 和类型 的配置: 。由于作者的关系图是树,因此可以通过动态规划有效地完成。

设 是图( ,如果 是叶子)中部分 的子集, 是根的子树在部分 的最大分数,部分 位于 。每个子树的最大分数可以计算如下:

使用方程式7,作者可以递归地计算模型的总体最佳得分,并且可以通过动态规划的标准后向传递来恢复位置和类型的最佳配置。

计算: 由于作者的成对项是位置的二次函数, 和 ,方程中的最大运算超过 ,那么公式7 可以通过使用广义距离变换来加速[6],得到的方法非常有效,一旦计算出图像相关项,就取 时间,其中 是关系类型的数量, 是位置的总数, 是在模型中部分的总数。该分析假设所有成对的空间关系具有相同数量的类型,即 。

图像相关项的计算也是有效的。它们由单个DCNN在所有位置上计算。以滑动方式应用DCNN本质上是有效的,因为重叠区域共有的计算自然是共享的[22]。

4 学习

现在作者考虑从带有标记的零件位置的图像中学习模型参数的问题,这是大多数人体姿态数据集中可用的数据[17,7,10,20]。作者从部分位置标注中导出类型标签 ,并采用监督方法来学习模型。

作者的模型由三组参数组成:不同成对关系类型的平均相对位置 ;图像相关项的参数 ;和权值参数 。它们通过K-means算法用于 ,DCNN用于 ,S-SVM用于 。

平均相对位置和类型标签: 给定标记的正图像 , 是从部分 到其邻居 的相对位置。作者聚集了相对位置训练集 来获得 聚类(在实验中 ,用于所有成对关系)。每个聚类对应于部分 的一组实例,其与其相邻部分 共享相似的空间关系。因此,作者在模型中将每个聚类定义为从部分 到j 的成对关系类型 ,并使用每个群集的中心作为与每个群集相关的平均相对位置 。以这种方式,学习不同成对关系类型的平均相对位置,并且基于其聚类索引导出每个训练实例的类型标签 。作者在实验中使用K-means,设置 来进行聚类。

图像相关术语的参数: 在导出类型标签后,每个局部图像块 以标注的部分位置为中心,用类别标签 标记哪个部分存在,以及类型标签 表明其关系类型所有的邻居。通过这种方式,作者从正例图像获得了一组标记的块 图像(每个正图像提供 个部分的块),以及一组从负例图像中采样背景块 。

给定标记的部分块和背景块,作者使用softmax损失通过标准随机梯度下降训练多类DCNN分类器。DCNN由五个卷积层,2个max pooling层和三个完全连接的层组成,最终是 维softmax输出,它被定义为条件概率分布,即 。作者的网络架构如图2所示。

权重参数: 正图像中的每个姿态现在用标注的部分位置和派生的类型标签标记 。作者使用S-SVM来学习权重参数 。通过使用0 1损失简化了结构预测问题,即所有训练示例或者其标签的所有维度都正确或者其标签的所有维度都是错误的。作者将前者表示为正例,将后者表示为负例。由于整体函数(方程式3) 在权重参数 中是线性的,作者将优化函数写为:

其中 与 是表示第 个示例的稀疏特征向量,并且是(根据学习的DCNN)图像相关项、空间变形特征和常数1的串联。如果 ,则 ,如果 ,则 。

5 实验

本节介绍数据集,阐明评估指标,描述作者的实验设置,提供比较评估结果并提供诊断实验。

5.1 数据集和评估指标

作者在两个公开可用的人体姿态估计基准数据集上进行实验:(i)“利兹体育姿态”(LSP)数据集[10],包含来自体育活动的1000个训练和1000个测试图像,带有标注的全身人体姿态;(ii)“标记在电影中的帧”(FLIC)数据集[20] ,包含3987个训练和1016个来自好莱坞电影的图像测试数据,标注了上半身人体姿态。

作者遵循以前的工作,并在两个基准上使用以观察者为中心的标注。为了训练作者的模型,作者还使用INRIAPerson数据集中的负样例[3](这些图像不包含人物)。

作者使用最流行的评估指标来与之前的工作进行比较。正确部件的百分比(PCP)是包括LSP数据集在内的几个基准测试的标准评估指标。但是,如[27]中讨论的那样,PCP有几种可供选择的解释,可能导致严重不同的结果。在论文中,除非另有说明,否则使用更严格的版本,即仅评估一个测试图像的单个得分最高的估计结果,并且如果两个段端点(关节)都在ground truth标注端点长度50%以内,则认为身体部位正确(LSP数据集上的每个测试图像仅包含一个带标注的人)。作者将这个版本的PCP称为严格的PCP。

在FLIC数据集上,作者使用严格的PCP和使用[20]指定的评估指标:检测到的关节百分比(PDJ)。PDJ通过改变定位精度阈值,使用正确定位关节的百分比曲线来测量性能。定位精度阈值通过每个ground truth姿态的比例(定义为左肩和右臀之间的距离)来标准化,以使其尺度不变。FLIC图像中有多个人,所以每个人地面真相人也用躯干检测盒标注。在评估期间,作者通过限制作者的颈部局部定位在由提供的躯干盒定义的窗口内,为每个地面真实人返回单个得分最高的估计结果。

5.2 实施细节

数据增强: 作者的DCNN拥有数百万个参数,而只有数千个训练图像可用。为了减少过度拟合,作者通过360度旋转正训练图像来增加训练数据。这些图像也水平翻转,使其翻倍训练图像。这增加了具有不同空间的身体部位的训练样本的数量与邻居的关系(见图1中左侧对角线的肘部)。作者提供随机正片作为DCNN训练的验证集。此外,在该保持装置上训练重量参数w以减少过度拟合到训练数据。

请注意,作者的DCNN使用局部零件块和背景块而不是整个图像进行训练。这自然地将训练样本的数量增加了K倍(部件的数量)。尽管DCNN最终输出的尺寸数量也随着部件数量线性增加,但参数的数量仅在最后一个完全连接的层中略微增加。这是因为大多数参数在不同部分之间共享,因此通过每个参数具有更多训练示例,作者可以从更大的 中受益。在作者的实验中,作者通过在标注部分之间添加中间点来增加 ,这导致LSP数据集上的26个部分和FLIC数据集上的18个部分。用更多部件覆盖人也减少了相邻部件之间的距离,这有利于建模缩短[27]。

图结构: 作者为LSP数据集定义了一个全体图结构,并分别为FLIC数据集定义了一个上半身图结构。该图连接带标注的部分及其中间点以形成树(参见 图5 中的骨架)。

设置: 为简单起见,作者对所有邻居对使用相同数量的类型。作者在所有数据集上将其设置为11类(即, ),这可以产生11个具有一个邻居(例如手腕)的部分的空间关系类型, 个具有两个邻居(例如,肘)的部分的空间关系类型。由于FLIC图像具有更高的分辨率,LSP数据集上每个部分的块大小设置为36×36像素,FLIC数据集上设置为54×54个像素。作者在两个数据集上使用类似的DCNN架构,由于输入块大小不同,第一层的数据集不同。 图2 可视化作者使用的架构。作者使用Caffe[9] 在实验中实施DCNN。

图2 DCNN的结构。LSP数据集上每个部分的块大小设置为36×36像素,FLIC数据集上设置为54×54个像素。DCNN由五个卷积层、两个最大池化层、三个全连接层组成,最终是Sigmoid输出。作者使用了[12]中的dropout、本地响应规范化、overlapping polling。

5.3 基准测试结果

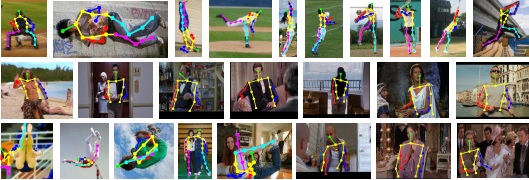

作者在表1中的LSP数据集上展示了严格的PCP结果,以及表2中展示了FLIC数据集的结果。作者还在图3中表现了FLIC数据集上PDJ结果。如图所示,作者的方法在两个数据集上都优于现有技术方法。 图5 表现了LSP和FLIC数据集的一些姿态估计样例。

| 方法 | 躯干 | 头 | 上臂 | 下臂 | 大腿 | 小腿 | 平均 |

|---|---|---|---|---|---|---|---|

| 作者的 | 92.7 | 87.8 | 69.2 | 55.4 | 82.9 | 77.0 | 75.0 |

| Pishchulin等 [16] | 88.7 | 85.6 | 61.5 | 44.9 | 78.8 | 73.4 | 69.2 |

| 欧阳等 [14] | 85.8 | 83.1 | 63.3 | 46.6 | 76.5 | 72.2 | 68.6 |

| DeepPose [23] | - | - | 56 | 38 | 77 | 71 | - |

| Pishchulin等 [15] | 87.5 | 78.1 | 54.2 | 33.9 | 75.7 | 68.0 | 62.9 |

| Eichner&Ferrari [4] | 86.2 | 80.1 | 56.5 | 37.4 | 74.3 | 69.3 | 64.3 |

| Yang&Ramanan [26] | 84.1 | 77.1 | 52.5 | 35.9 | 69.5 | 65.6 | 60.8 |

表1: LSP数据集上严格PCP结果的比较。作者的方法在很大程度上改善了所有部分,并且优于以前发布的最佳结果[16] 5.8%。要注意的是,DeepPose使用以人为中心的标注,并使用额外的10000个图像进行训练。

| 方法 | 上臂 | 下臂 | 平均 |

|---|---|---|---|

| 作者的 | 97 | 86.8 | 91.9 |

| MODEC [20] | 84.4 | 52.1 | 68.3 |

表2:FLIC数据集上严格PCP结果的比较。作者的方法明显优于MODEC[20]。

图3 FLIC数据集上肘部和手腕的PDJ曲线比较。图例表现的结果中PDJ数字的阈值为0.2。

5.4 诊断实验

作者进行诊断实验以表现模型的跨数据集泛化能力,并更好地理解作者模型中每个项的影响。

跨数据集推广: 作者直接将FLIC数据集上的训练模型应用于Buffy数据集的官方测试集 [7] (即,没有关于Buffy数据集的训练),其也包含上身人体姿态。Buffy测试集包括可以检测其上半身的人的子集。作者从中获得最新的检测窗口[5] ,并将作者的结果与此子集上之前发布的工作进行比较。

之前的大多数工作都是使用Buffy的官方评估工具包进行评估的,该工具包使用不太严格的PCP实现1。作者将此版本的PCP称为Buffy PCP,并将其与 表3 中严格的PCP一起报告。作者还在 图4 中表现了PDJ曲线正如两个标准所示,作者的方法明显优于当时state of art 的工作,这表明作者的方法具有良好的泛化能力。另请 DeepPose[23]作者的方法是在FLIC数据集上训练的。与 图3 相比作者的方法与DeepPose之间的差距在 图4 中显著增加。这意味着作者的模型更好地泛化了Buffy数据集。

项分析: 作者设计了两个实验,以更好地理解作者模型中每个术语的影响。在第一个实验中,作者仅使用单元项,因此所有部分都是独立定位的。在第二个实验中,作者用独立于图像的先验替换IDPR术语(即方程式2中, 和 被分别同捷替换为标量先验项 和 ,并重新训练重量参数以及新的先验项。在这在这种情况下,作者的成对关系项不依赖于图像,而是高斯变形与图像无关偏差的混合。作者将第一个实验称为只有单元项的实验,第二个实验称为No IDPR项的实验。使用相同的外观项在LSP数据集上进行实验以进行比较。作者在表4中表现了严格的PCP结果。如图所示,作者模型中的所有项都显着提高了性能。

表3 Buffy测试子集上的交叉数据集PCP结果。PCP编号为Buffy PCP。作者的方法是在FLIC数据集上训练的。

图4 Buffy测试子集上的交叉数据集PDJ曲线。图例PDJ的阈值为0.2。本文方法和DeepPose[23] 都在FLIC数据集训练。

| 方法 | 躯干 | 头 | 上臂 | 下臂 | 大腿 | 小腿 | 平均 |

|---|---|---|---|---|---|---|---|

| 只有单元项 | 56.3 | 66.4 | 28.9 | 15.5 | 50.8 | 45.9 | 40.5 |

| NO-IDPRs | 87.4 | 74.8 | 60.7 | 43.0 | 73.2 | 65.1 | 64.6 |

| 完整模型 | 92.7 | 87.8 | 69.2 | 55.4 | 82.9 | 77.0 | 75.0 |

表4 对LSP数据集的诊断项分析严格PCP结果。即使它是由DCNN分类器训练的,单元项仍然不足以获得好的结果。No-IDPRs方法,其成对术语不依赖于图像(参见章节5.4中的术语分析),可以获得与最新技术相媲美的性能,并且添加IDPR条款可以将作者的最终性能提升至75.0%。

图5 LSP和FLIC数据集的结果。作者展示了零件定位结果以及作者在模型中使用的图骨架。最后一行表现了一些失败案例,通常是由于巨大的透视缩短、遮挡、衣服或重叠人群。

6 结论

作者提出了一个人体姿态的图模型,它利用了局部图像测量可用于检测部分(或关节)以及预测它们之间的空间关系(图像相关成对关系)这一事实。这些空间关系由关系混合模型表示。作者使用DCNN来学习图像块中部件的存在及其空间关系的条件概率。因此,作者的模型将图模型的表征灵活性与DCNN的效率和统计功效相结合。作者的方法在LSP和FLIC数据集上优于最先进的方法,并且在没有任何训练的情况下在Buffy数据集上表现得非常好。

7 致谢

该研究得到了ONR MURI N000014-10-1-0933,ONR N00014-12-1-0883 和 ARO 62250-CS.的资助。本研究中使用的GPU由NVIDIA公司捐赠。

参考文献

[1] X. Chen, R. Mottaghi, X. Liu, S. Fidler, R. Urtasun, and A. Yuille. Detect what you can: Detecting and representing objects using holistic models and body parts. In Computer Vision and Pattern Recognition (CVPR), 2014.

[2] N.-G. Cho, A. L. Yuille, and S.-W. Lee. Adaptive occlusion state estimation for human pose tracking under self-occlusions. Pattern Recognition, 2013.

[3] N. Dalal and B. Triggs. Histograms of oriented gradients for human detection. In Computer Vision and Pattern Recognition (CVPR), 2005.

[4] M. Eichner and V. Ferrari. Appearance sharing for collective human pose estimation. In Asian Conference on Computer Vision (ACCV), 2012.

[5] M. Eichner, M. Marin-Jimenez, A. Zisserman, and V. Ferrari. 2d articulated human pose estimation and retrieval in (almost) unconstrained still images. International Journal of Computer Vision (IJCV), 2012.

[6] P. F. Felzenszwalb and D. P. Huttenlocher. Pictorial structures for object recognition. International Journal of Computer Vision (IJCV), 2005.

[7] V. Ferrari, M. Marin-Jimenez, and A. Zisserman. Progressive search space reduction for human pose estimation. In Computer Vision and Pattern Recognition (CVPR), 2008.

[8] M. A. Fischler and R. A. Elschlager. The representation and matching of pictorial structures. IEEE Transactions on Computers, 1973.

[9] Y. Jia. Caffe: An open source convolutional architecture for fast feature embedding. http://caffe.berkeleyvision.org/, 2013.

[10] S. Johnson and M. Everingham. Clustered pose and nonlinear appearance models for human pose estimation. In British Machine Vision Conference (BMVC), 2010.

[11] L. Karlinsky and S. Ullman. Using linking features in learning non-parametric part models. In European Conference on Computer Vision (ECCV), 2012.

[12] A. Krizhevsky, I. Sutskever, and G. E. Hinton. Imagenet classification with deep convolutional neural networks. In Neural Information Processing Systems (NIPS), 2012.

[13] J. Lafferty, A. McCallum, and F. C. Pereira. Conditional random fields: Probabilistic models for segmenting and labeling sequence data. In International Conference on Machine Learning (ICML), 2001.

[14] W. Ouyang, X. Chu, and X. Wang. Multi-source deep learning for human pose estimation. In Computer Vision and Pattern Recognition (CVPR), 2014.

[15] L. Pishchulin, M. Andriluka, P. Gehler, and B. Schiele. Poselet conditioned pictorial structures. In Computer Vision and Pattern Recognition (CVPR), 2013.

[16] L. Pishchulin, M. Andriluka, P. Gehler, and B. Schiele. Strong appearance and expressive spatial models for human pose estimation. In International Conference on Computer Vision (ICCV), 2013.

[17] D. Ramanan. Learning to parse images of articulated bodies. In Neural Information Processing Systems (NIPS), 2006.

[18] C. Rother, V. Kolmogorov, and A. Blake. Grabcut: Interactive foreground extraction using iterated graph cuts. In ACM Transactions on Graphics (TOG), 2004.

[19] B. Sapp, C. Jordan, and B. Taskar. Adaptive pose priors for pictorial structures. In Computer Vision and Pattern Recognition (CVPR), 2010.

[20] B. Sapp and B. Taskar. Modec: Multimodal decomposable models for human pose estimation. In Computer Vision and Pattern Recognition (CVPR), 2013.

[21] B. Sapp, A. Toshev, and B. Taskar. Cascaded models for articulated pose estimation. In European Conference on Computer Vision (ECCV), 2010.

[22] P. Sermanet, D. Eigen, X. Zhang, M. Mathieu, R. Fergus, and Y. LeCun. Overfeat: Integrated recognition, localization and detection using convolutional networks. In International Conference on Learning

Representations (ICLR), 2014.

[23] A. Toshev and C. Szegedy. Deeppose: Human pose estimation via deep neural networks. In Computer Vision and Pattern Recognition (CVPR), 2014.

[24] I. Tsochantaridis, T. Hofmann, T. Joachims, and Y. Altun. Support vector machine learning for interdependent and structured output spaces. In International Conference on Machine Learning (ICML), 2004.

[25] C. Wang, Y. Wang, and A. L. Yuille. An approach to pose-based action recognition. In Computer Vision and Pattern Recognition (CVPR), 2013.

[26] Y. Yang and D. Ramanan. Articulated pose estimation with flexible mixtures-of-parts. In Computer Vision and Pattern Recognition (CVPR), 2011.

[27] Y. Yang and D. Ramanan. Articulated human detection with flexible mixtures of parts. IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI), 2013.