深度学习技巧(Relu)

深度学习中我们总结出5大技巧:本节我们就从新的激活函数Relu谈起。

1.新的激活函数 new activation function

我们知道,激活函数在基于神经网络的深度学习中将线性变换,转换为非线性变换。是神经网络能够学到东西的重要一环。常用的激活函数有sigma, tanh 等。

从辛顿大神在2012年imagenet 中的CNN网络中引入relu,这个神奇的看上去是线性的激活函数进入我们的视野,以后扮演者非常重要的作用。

那问什么要引入relu,sigma、tanh 函数有什么缺点呢?

最主要的问题在于deep learning 无法真正deep:

如图所示,训练上8层之后,正确率急速下降。 这是为什么呢?

主要原因在于梯度消失Vanishing Gradient Problem

如图所示:传统的激活函数,数据变化后,输出的变化比输入小,而且根据ChainRule, 层数越深,梯度值相乘的结果越小,小到接近于0的时候,就无法学习了。

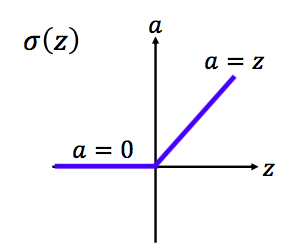

所以,我们引入Relu,他的特点是:

- (1) 计算快速(导数是1)

- (2)生物学原理(貌似是大脑回路,不太了解)

- (3)linear piece 可以模拟任何函数(在以后的深度学习理论会讲)

- (4)重点是:可以解决梯度消失的问题

Relu 可以简化神经网络:

虽然Relu看起来很好(有严格数学证明,以后会深入讲),但是在小于0的时候导数为0,对于参数学习是不利的:所以我们引入Relu的变种:leaky Relu, Parametirc Relu, 以后还会谈到 Selu

本专栏图片、公式很多来自台湾大学李弘毅老师、斯坦福大学cs229,斯坦福大学cs231n 、斯坦福大学cs224n课程。在这里,感谢这些经典课程,向他们致敬!