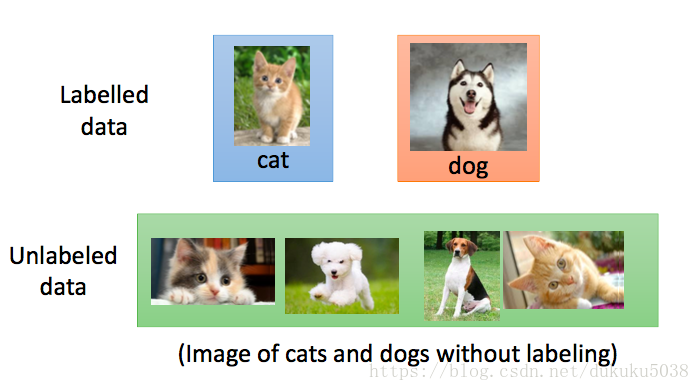

在实际数据收集的过程中,带标签的数据远远少于未带标签的数据。 我们据需要用带label 和不带label的数据一起进行学习,我们称作半监督学习。

- Transductive learning:没有标签的数据是测试数据

- Inductive learning:没有标签的数据不是测试数据

为什么没有标签的数据会帮助我们学习呢? 是因为没有标签数据的分布可能会告诉我们一些潜在的规律。

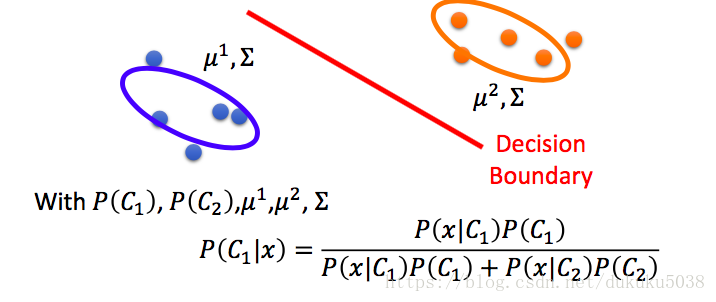

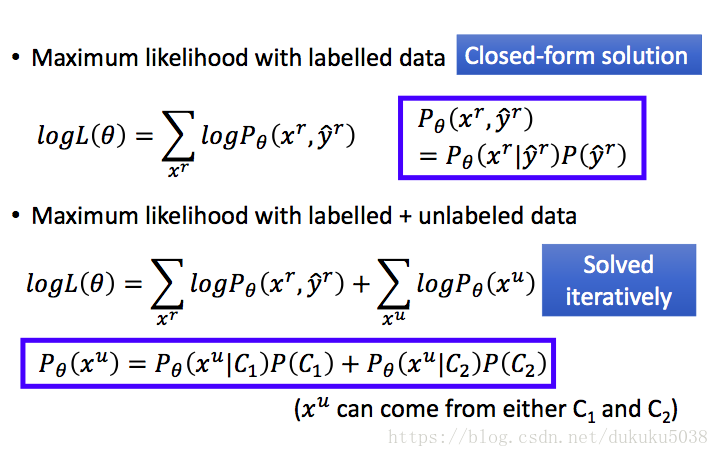

1.半监督生成模型 Semi-supervised Learning for Generative Model

我们回忆一下监督学习的生成模型,计算先验概率,然后通过概率模型估计,计算分类概率。

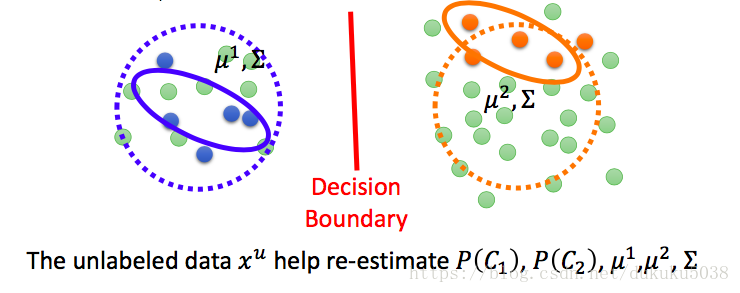

那半监督的概率生成模型是:

- 寻找概率最大的 和

-

符合高斯分布

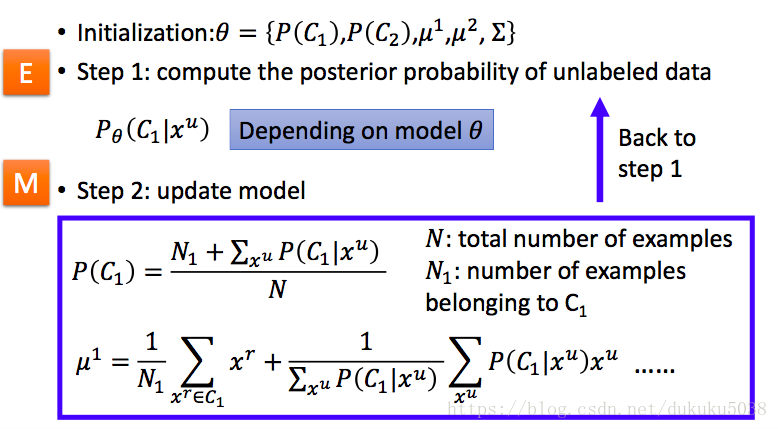

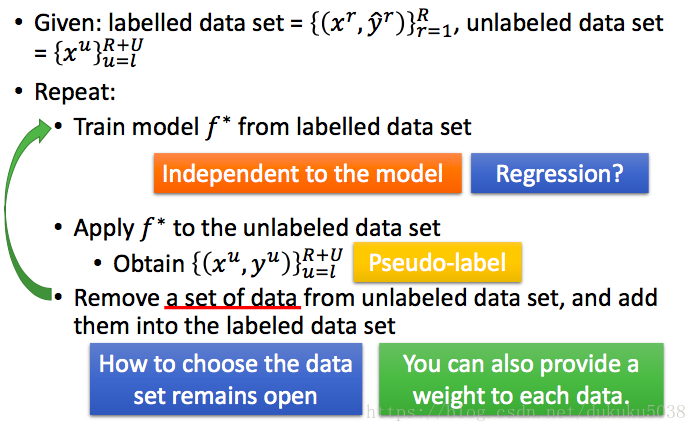

算法流程如下,但是最后的结果影响与初始值的初始化,结构和EM算法类似

2. 低密度分割 Low-density Separation

大原则:非黑即白

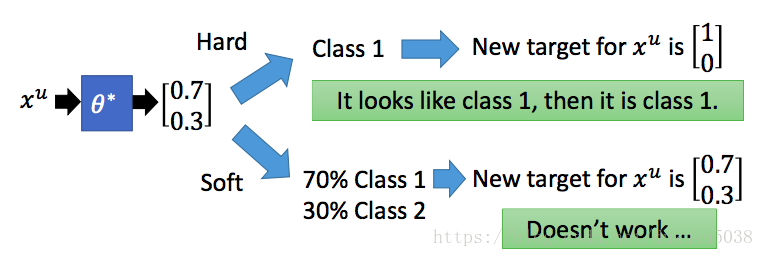

(1)Self-training

(2)Entropy-based Regularization

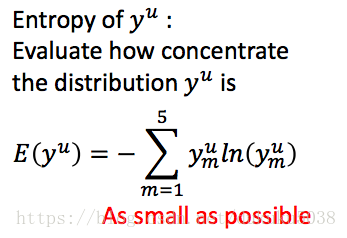

我们估计的分布函数,如何衡量他的好坏

所以我们让他越小越好:

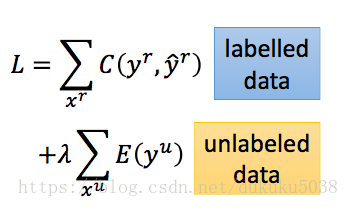

考虑到了Entropy因素,Loss函数最后可以写成

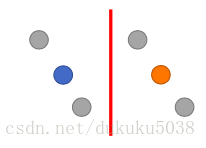

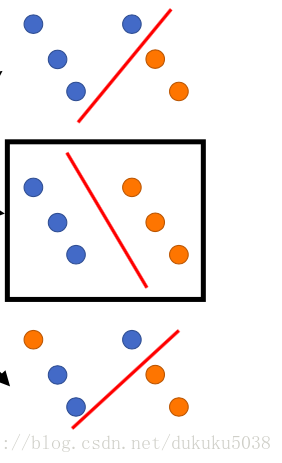

(3)Semi-supervised SVM

semi-SVM 中,我们假设没有标签的数据可以任意标注

我们取margin 最大的和error最小的

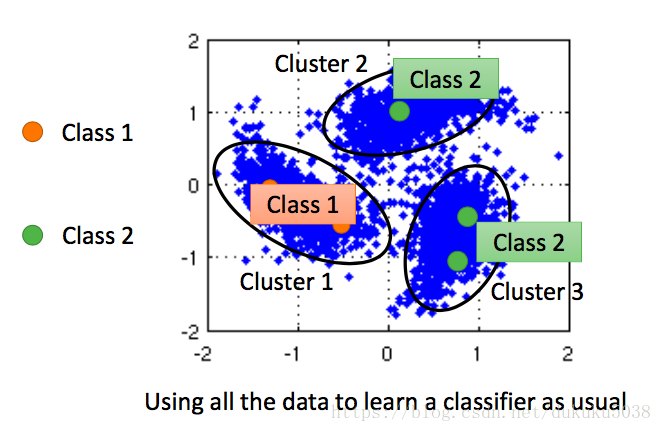

3. 平滑性假设 Smoothness Assumption

近朱者赤,近墨者黑

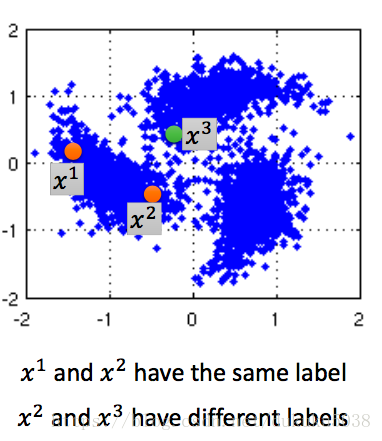

假设:相似的x 有着相同的分类

- x 并不是uniform 统一的

- 如果 和 在高密度区域中相似,那么他们的结果也就y_{1} y_{2}$一致

(1)聚类,然后标注 Cluster and then Label

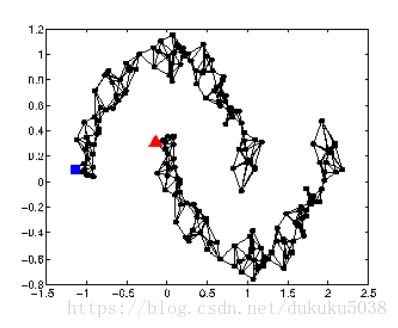

(2)以图为基础的方法 Graph-based Approach

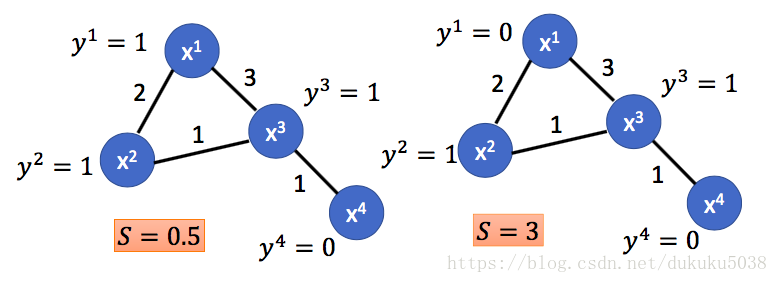

很显然,当图中的点能走通,说明是一类。

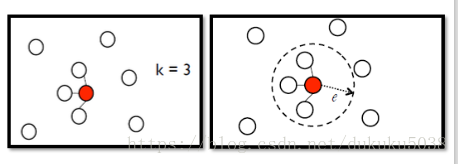

创建图的方法( Graph Construction):

- 定义 和 的相似度s( , )

- 加入边edge

K Nearest Neighbor

e-Neighborhood

- edge 的权重 与s( , )称比例

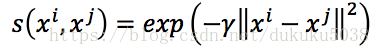

s(

,

)一般表示为Gaussian Radial Basis Function::

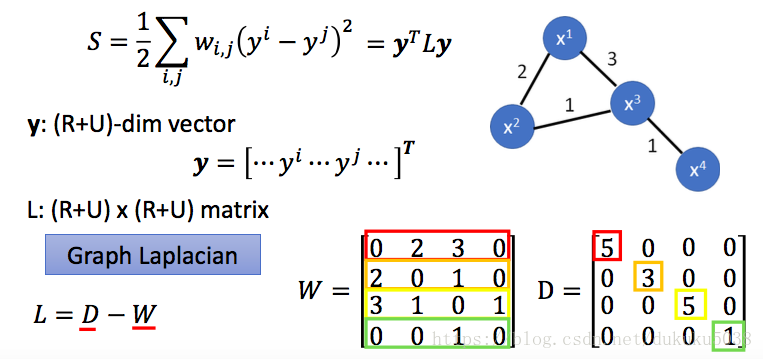

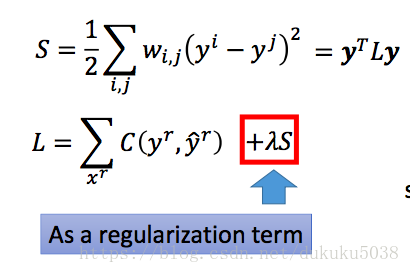

- 定义图的平滑程度 Define the smoothness of the labels

s 越小越平滑:

如果我们定义s为:

4. Better Representation

去芜存菁,化繁为简 具体内容我们再降维的章节介绍。(下一节)