摘要:谷歌最近就目前世界上最大的图像数据集“Google Landmarks”举办了一次检索比赛“Google Landmark Retrieval Challenge”。我们综合了不同的图像检索技术,提出了自己的检索模型,并在比赛中获得了第七名的成绩。本文将介绍我们的检索模型和结果,以及我们在竞赛中所克服的挑战

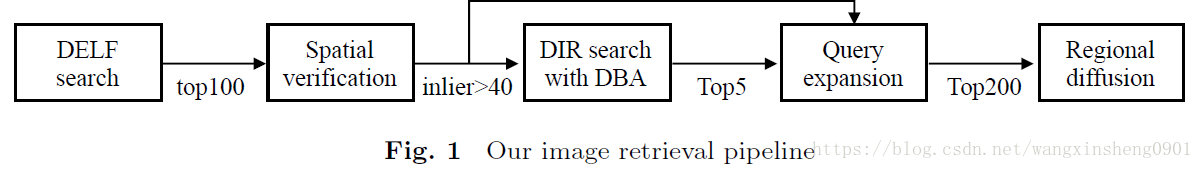

查询系统的整个流程如上图所示,其主要包含五个步骤:

1) 深度局部特征(DELF)搜索

2) 对第一步查询得到的前100张图像进行空间确认(RANSAC)

3) 利用数据端特征增强(DBA)进行深度图像检索(DIR)

4) 利用(3) top-5的结果和(2) inlier>40的结果进行扩展查询(QE)

5) 通过区域扩散进行重排序

图像特征

对于每张图像提取了两种特征:

DELF—[ 2017CVPR _Large-scale image retrieval with attentive deep local features]:提取的特征表示为 ,Xn是第n张图像的局部特征的集合,其中第i个特征

。一并保存的还有每一个特征点的坐标(x,y).

DIR—[2017_IJCV_End-to-end Learning of Deep Visual Representations for Image Retrieval]:全局特征。

DELF搜索

我们利用k-NN对DELF特征进行了搜索。作为预处理,所有的DELF特征被存储在一个索引结构中,在此我们利用了Faiss library (https://github.com/facebookresearch/faiss)中的HNSW+IVFPQ框架。

数据增强

DBA—[2012_CVPR_Three Things Every- one Should Know to Improve Object Retrieval]:在DIR搜索的过程中采用了DBA。将每一张索引图像的特征与其临近图像的特征进行融合以代替原来的特征: