请不要随意复制粘贴,请尊重本博主,千辛万苦的总结心血,谢谢您的支持!

建议收藏,一直更新!!!!!

切记:要想学好深度学习,一定要看原汁原味的论文!!!!

视频链接:听着歌曲《成都》三分钟看遍主流的深度神经网络的发展框架(1950~2018)——Jason niu

相关文章:

CNN:关于深度学习之CNN经典论文原文(1950~2018)简介总结框架结构图(非常有价值)之持续更新(吐血整理)——Jason niu

DL:听着歌曲《成都》三分钟看遍主流的深度学习的神经网络的发展框架(1950~2018)——Jason niu

CNN:关于深度学习之CNN经典论文原文(1950~2018)简介、下载地址大全(非常有价值)之持续更新(吐血整理)——Jason niu

1986《Learning representations by back-propagating errors》

http://www.iro.umontreal.ca/~pift6266/A06/refs/backprop_old.pdf

Geoffrey Hinton等人在1986年发表在Nature上的关于反向传播原始论文。

1998《Gradient-Based Learning Applied to Documnet Recognition》

http://yann.lecun.com/exdb/publis/pdf/lecun-01a.pdf

2006《Reducing the Dimensionality of Data with Neural Networks》

2006年Hinton他们的Science Paper,当时提到,2006年虽然Deep Learning的概念被提出来了,但是学术界的大家还是表示不服。当时有流传的段子是Hinton的学生在台上讲paper时,台下的机器学习大牛们不屑一顾,质问你们的东西有理论推导吗?有数学基础吗?搞得过SVM之类吗?回头来看,就算是真的,大牛们也确实不算无理取闹,是骡子是马拉出来遛遛,不要光提个概念。时间终于到了2012年,Hinton的学生Alex Krizhevsky在寝室用GPU死磕了一个Deep Learning模型,一举摘下了视觉领域竞赛ILSVRC 2012的桂冠,在百万量级的ImageNet数据集合上,效果大幅度超过传统的方法,从传统的70%多提升到80%多。个人觉得,当时最符合Hinton他们心境的歌非《我不做大哥好多年》莫属。

2012《ImageNet Classification with Deep Convolutional Neural Networks》

http://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks

2013年

2013.11《Visualizing and Understanding Convolutional Networks》

https://link.springer.com/chapter/10.1007/978-3-319-10590-1_53

AlexNet在2012年大出风头之后,2013年随即出现了大量的CNN模型。当年的的ILSVRC比赛胜者是来自纽约大学NYU的Matthew Zeiler以及Rob Fergus设计的模型,叫做ZF Net。它达到了11.2%的错误率。ZF Net的架构不仅对之前的AlexNet进行了进一步的优化,而且引入了一些新的关键技术用于性能改进。另外一点,文章作者用了很长的篇幅讲解了隐藏在卷积网络ConvNet之下的直观含义以及该如何正确地将滤波器及其权重系数可视化。

2013.12《OverFeat: Integrated Recognition, Localization and Detection using Convolutional Networks》

https://arxiv.org/pdf/1312.6229v2.pdf

这篇paper把图片分类、定位、检测一起搞。OverFeat说的简单一点就是特征提取算子,就相当于SIFT,HOG等这些算子一样。Along with this paper, we release a feature extractor named “OverFeat”,这是文献对overfeat定义的原话。 这篇文献最牛逼的地方,在于充分利用了卷积神经网络的特征提取功能,它把分类过程中,提取到的特征,同时又用于定位检测等各种任务,牛逼哄哄啊。只需要改变网络的最后几层,就可以实现不同的任务,而不需要从头开始训练整个网络的参数。 其主要是把网络的第一层到第五层看做是特征提取层,然后不同的任务共享这个特征提取层。基本用了同一个网络架构模型(特征提取层相同,分类回归层根据不同任务稍作修改、训练)、同时共享基础特征。

2014年

2014.03.17《DeepFace: Closing the Gap to Human-Level Performance in Face Verification》

http://www.dis.uniroma1.it/~bloisi/seminars/Vision-Perception-for-HRI-2015/papers/deepface.pdf

2014年3月17日,Facebook 在计算机视觉和模式识别领域达成了一项重大成就,他们开发的 DeepFace 面部识别算法能够以 97.25%的准确率正确识别人的面孔 ,这几乎达到了人类的平均水平(97.5%准确率)。DeepFace使用1.2亿参数来识别这些人脸,该软件借助4030个Facebook用户近440万个标记面孔来进一步强化其面部识别能力。

2014.09.12,《Very Deep Convolutional Networks for Large-Scale Image Recognition》

https://arxiv.org/pdf/1409.1556.pdfhttp://www.robots.ox.ac.uk/~vgg/research/very_deep/

http://www.robots.ox.ac.uk/~karen/pdf/ILSVRC_2014.pdf

VGG全称是Visual Geometry Group 属于牛津大学科学工程系,其发布了一些列以 VGG 开头的卷积网络模型,可以应用在人脸识别、图像分类等方面,分别从 VGG16 ~ VGG19 。

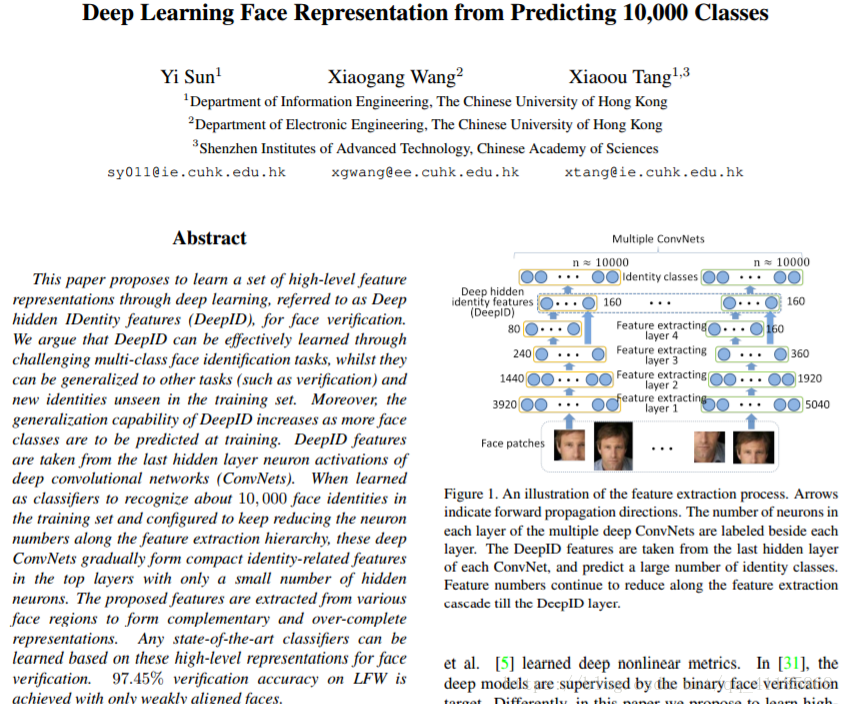

2014.06《Deep Learning Face Representation from Predicting 10,000 Classes》

https://www.cv-foundation.org/openaccess/content_cvpr_2014/papers/Sun_Deep_Learning_Face_2014_CVPR_paper.pdf

香港中文大学汤晓鸥团队,提出的DeepID系列是一组非常有代表性的工作。

DeepID1:《DeepID: Deep Learning for Face Recognition》2014年CVPR。使用四层卷积,最后一层为Softmax,中间为Deep Hidden Identity Features,是学习到的人脸特征表示,并使用Multi-patch分别训练模型最后组合成高维特征,人脸验证阶段使用联合贝叶斯的方法;通过学习一个多类(10000类,每个类大约有20个实例)人脸识别任务来学习特征,文中指出,随着训练时要预测的人脸类越多,DeepID的泛化能力就越强。

DeepID2:《Deep Learning Face Representation by Joint Identification-Verification》2014NIPS会议(机器学习领域的顶级会议)。在DeepID1的基础上对损失函数部分做了改进,在原有Identification Loss基础上,增加了Verification Loss,其中Verification主要是增加类内的紧致度,而Identification是反应类间的变化。 通过提升类间差距,降低类内差距,是训练出来的特征更加适合类似人脸识别的任务。这一思想同样源于早期的LDA算法。

DeepID3:《DeepID3: Face Recognition with Very Deep Neural Networks》2015年的CVPR。提出了用于人脸识别的两个非常深的神经网络结构(基于VGG和GoogleNet),但识别结果与DeepID2一样,或许当有更多的训练数据时,能够提高性能,需要进一步研究。

2014.06.10《Generative Adversarial Nets》

2014.09.17《Going Deeper with Convolutions》

https://arxiv.org/pdf/1409.4842.pdf

这是GoogLeNet的最早版本,出现在2014年的《Going deeper with convolutions》。之所以名为“GoogLeNet”而非“GoogleNet”,文章说是为了向早期的LeNet致敬。

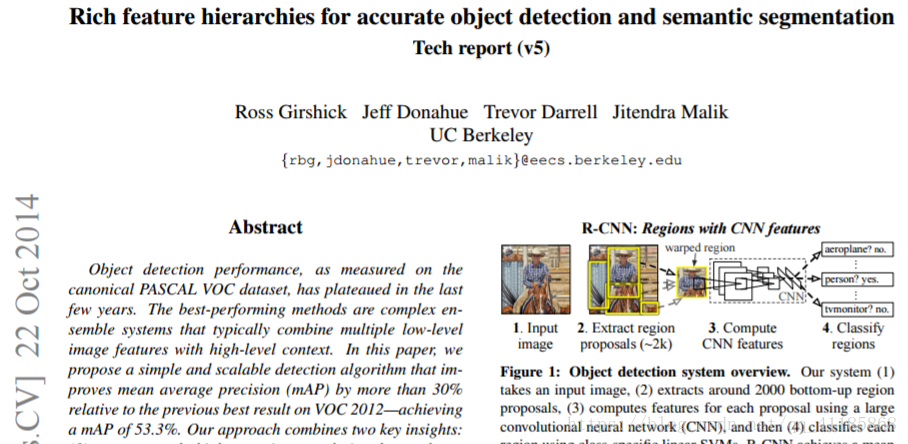

2014.10 RNN《Rich feature hierarchies for accurate object detection and semantic segmentation Tech report (v5)》

https://arxiv.org/pdf/1311.2524v5.pdf

2015年

2015.《Going Deeper with Convolutions》

https://www.cv-foundation.org/openaccess/content_cvpr_2015/papers/Szegedy_Going_Deeper_With_2015_CVPR_paper.pdf

Google公司基于ImageNet的ILSVRC比赛做的识别图像的深度卷积神经网——深达22层的Inception实例GoogLeNet《Going Deeper with Convolutions》。它以6.7%的错误率赢得了2014年度ILSVRC的冠军。据我所知,这是第一个跟传统方法,也就是卷积层与池化层简单叠加以形成序列结构的方法不同的一种CNN的新架构。文章作者强调,他们的新模型也特别重视内存与计算量的使用(这是之前我们没有提到的:多层堆积以及大量滤波器的使用会耗费很多计算与存储资源,同样也会提升过拟合的几率)。

2015.04《VERY DEEP CONVOLUTIONAL NETWORKS FOR LARGE-SCALE IMAGE RECOGNITION》

https://arxiv.org/pdf/1409.1556v6.pdf

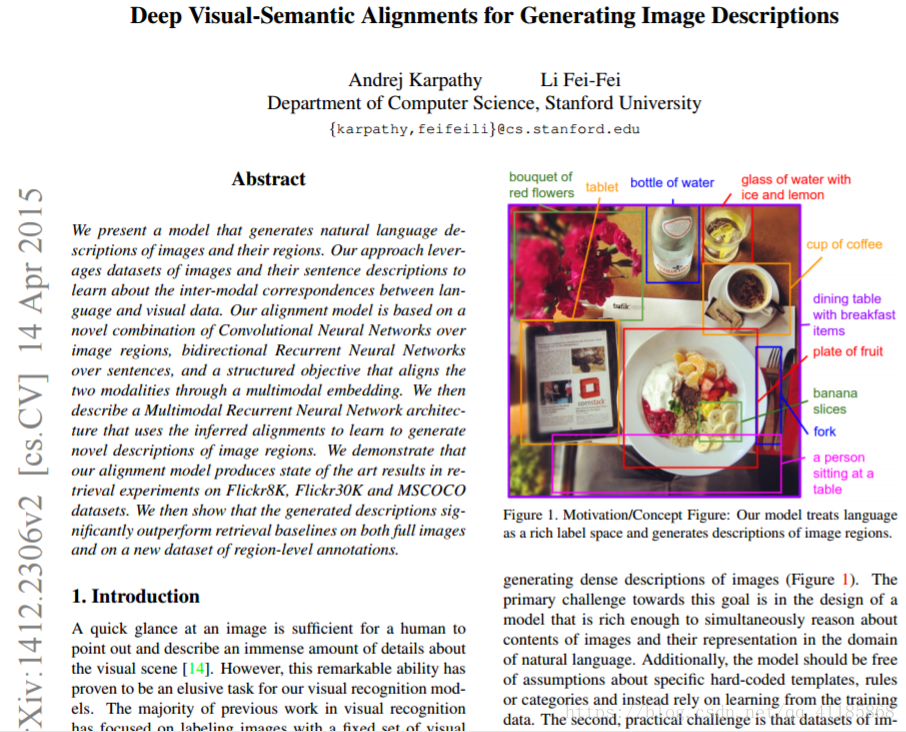

2015.04《Deep Visual-Semantic Alignments for Generating Image Descriptions》

https://arxiv.org/pdf/1412.2306v2.pdf

当你把CNN和RNN(循环神经网络)结合在一起会产生什么?抱歉,别想错了,你并不能得到R-CNN;-);但确实能得到一个很不错的模型。Andrej Karpathy(我个人最喜欢的作者之一)和Fei-Fei Li所写的这篇文章就是着重于研究将CNN与双向RNN bidirectional RNN相结合生成用于描述图像区域的自然语言描述器。

2015.04《Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition》

https://arxiv.org/pdf/1406.4729.pdf

2015.06《Spatial Transformer Networks》

https://arxiv.org/pdf/1506.02025.pdf

https://arxiv.org/pdf/1506.02025v1.pdf

2015.06,Google DeepMind提出的Spatial Transformer Networks空间转换网络,相当于在传统的一层Convolution中间,装了一个“插件”,可以使得传统的卷积带有了裁剪、平移、缩放、旋转等特性;理论上,作者希望可以减少CNN的训练数据量,以及减少做data argument,让CNN自己学会数据的形状变换。这篇论文我相信会启发很多新的改进,也就是对卷积结构作出更多变化,还是比较有创意的。

它提出了一种空间变形模块Spatial Transformer module。模块将输入图像进行某种变形从而使得后续层处理时更加省时省力。比起修改CNN的主要结构,作者更关注于对输入图像进行改造。它进行的改造主要有两条:姿态正规化pose normalization(主要指图像场景中的物体是否倾斜、是否拉伸)以及空间聚焦spatial attention(主要指在一个拥挤的图像中如何聚焦某个物体)。在传统CNN中,如果想要保证模型对尺度和旋转具有不变性,那么需要对应的大量训练样本。

2015.09 《Fast R-CNN》

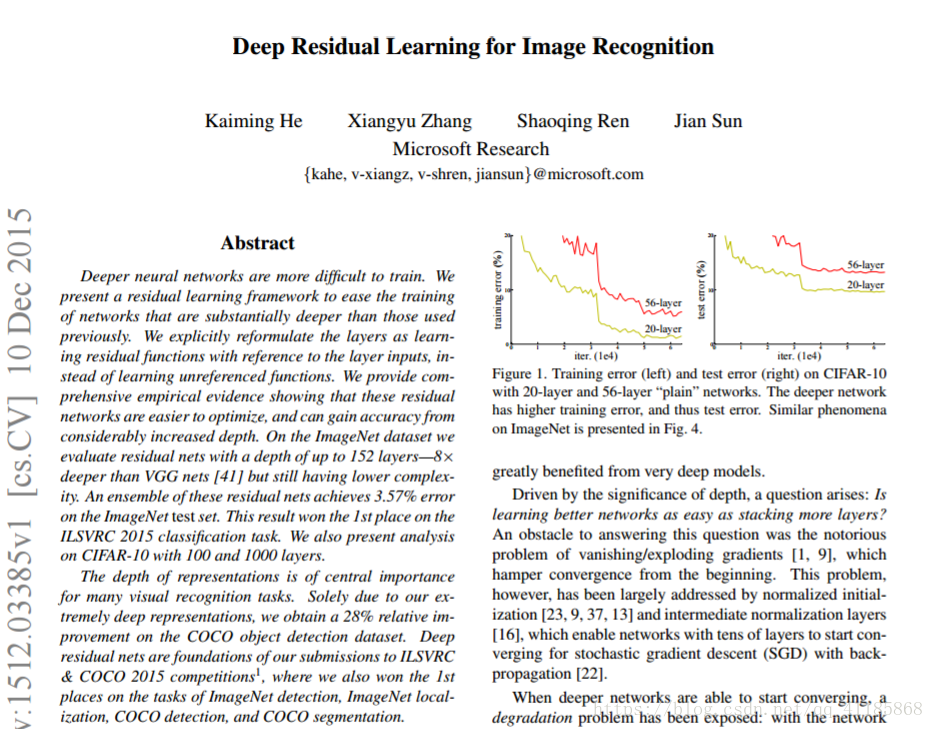

2015.12《Deep Residual Learning for Image Recognition》

https://arxiv.org/pdf/1512.03385v1.pdf

微软亚研MRA在2015年提出的架构。ResNet是一个拥有152层网络架构的新秀,它集分类、检测与翻译功能于一身。除开层数破了纪录,ResNet自身的表现也破了ILSVRC2015的记录,达到了不可思议的3.6%(通常人类也只能达到5~10%的出错率,跟专业领域和技能相关。

2016年

2016.01《Faster R-CNN: Towards Real-Time ObjectDetection with Region Proposal Networks》

https://arxiv.org/pdf/1506.01497v3.pdf

Faster R-CNN用于解决在R-CNN和Fast R-CNN中的一些复杂的训练流程。作者在最后一层卷积层后插入了一个区域标定网络region proposal network(RPN)。RPN能够从其输入的特征图层中生成标定区域region proposals。之后流程则跟R-CNN一样(ROI池化、全连通、分类以及回归)。

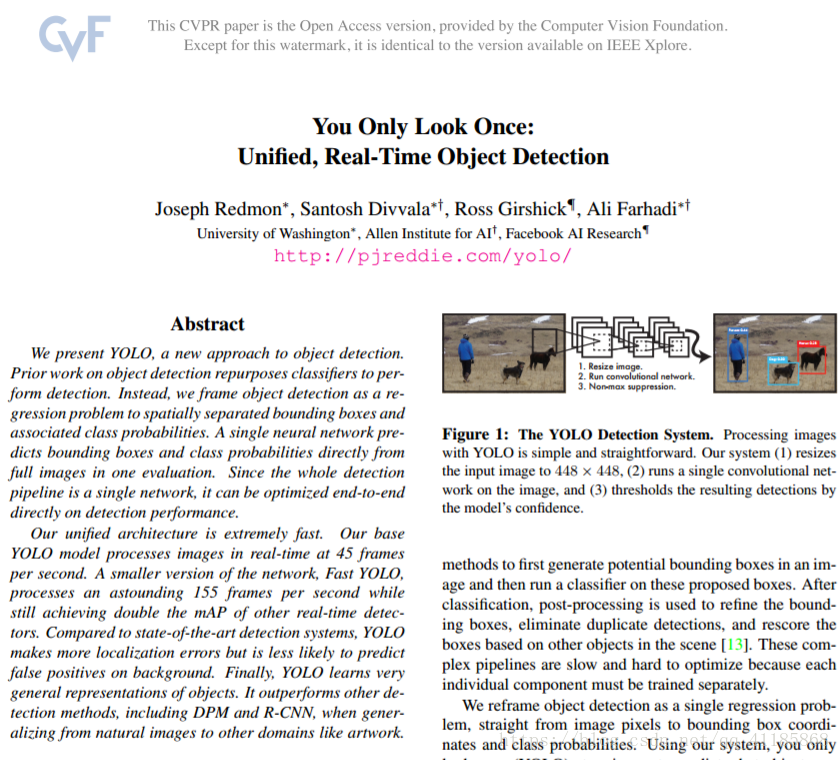

2016.05.09,《You Only Look Once:Unified, Real-Time Object Detection》

https://arxiv.org/pdf/1506.02640v1.pdfhttps://arxiv.org/abs/1506.02640v1

随着YOLO算法的出现,深度学习目标检测算法开始有了两步(two-stage)和单步(single-stage)之分。区别于R-CNN系列为代表的两步检测算法,YOLO舍去了候选框提取分支(Proposal阶段),直接将特征提取、候选框回归和分类在同一个无分支的卷积网络中完成,使得网络结构变得简单,检测速度较Faster R-CNN也有近10倍的提升。这使得深度学习目标检测算法在当时的计算能力下开始能够满足实时检测任务的需求。

2016.05.20《R-FCN: Object Detection via Region-based Fully Convolutional Networks》

https://arxiv.org/pdf/1605.06409v1.pdf

https://arxiv.org/abs/1605.06409v1

2016.05.20,MSRA的Jifeng Dai、Kaiming He等人提出了R-FCN,通过position-positive score maps(位置敏感得分图)来解决这个矛盾。位置敏感得分图通过预测RoI中不同部位的类别投票表决产生该RoI的类别预测。

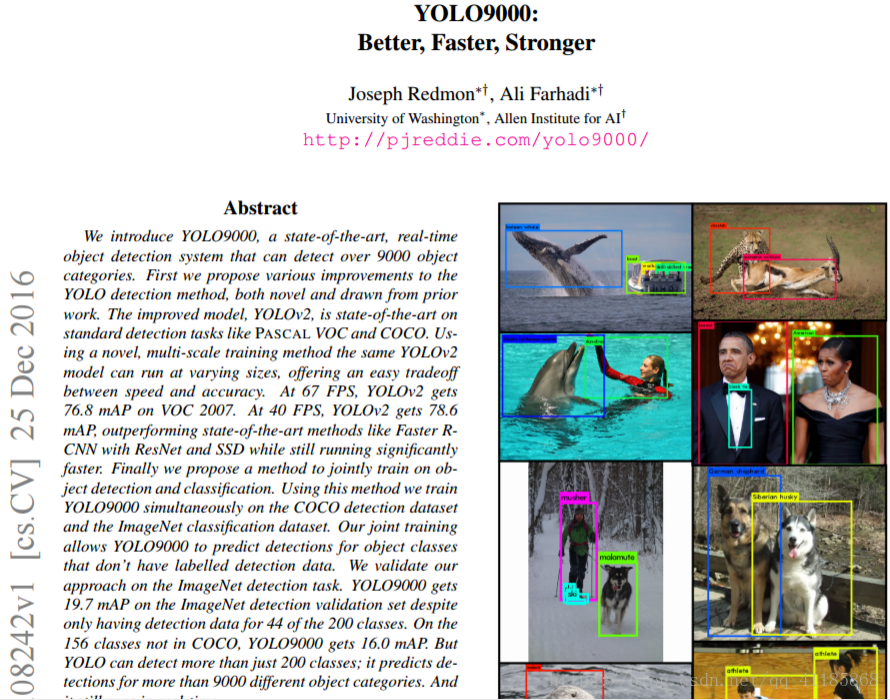

2016.12.25,《YOLO9000: Better, Faster, Stronger》

https://arxiv.org/abs/1612.08242

https://arxiv.org/pdf/1612.08242.pdf

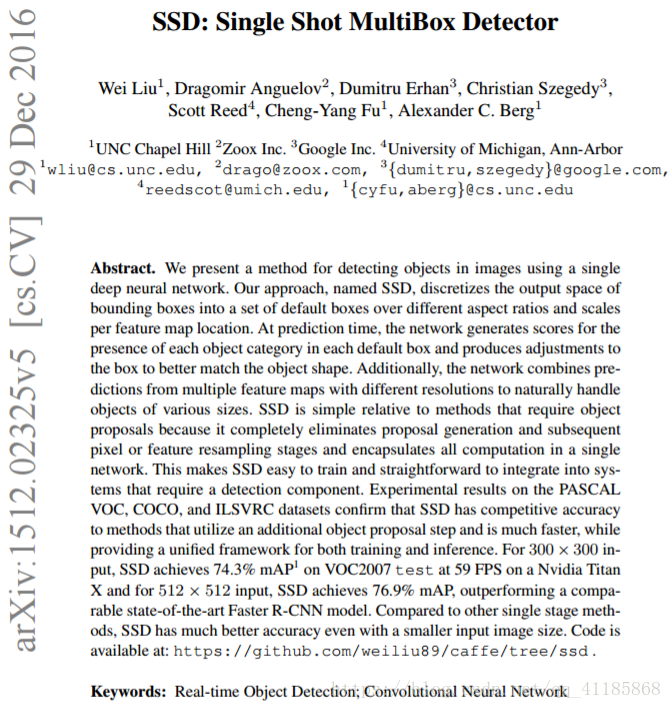

2016.12.29,《SSD:Single Shot MultiBox Detector》

YOLO 有一些缺陷:每个网格只预测一个物体,容易造成漏检;对于物体的尺度相对比较敏感,对于尺度变化较大的物体泛化能力较差。针对 YOLO 中的这些不足,该论文提出的方法 SSD 在这两方面都有所改进,同时兼顾了 mAP 和实时性的要求。

2016.12.29,SSD对YOLO进行了改进,达到了和两阶段方法相当的精度,同时又保持了较快的运行速度。

2017年

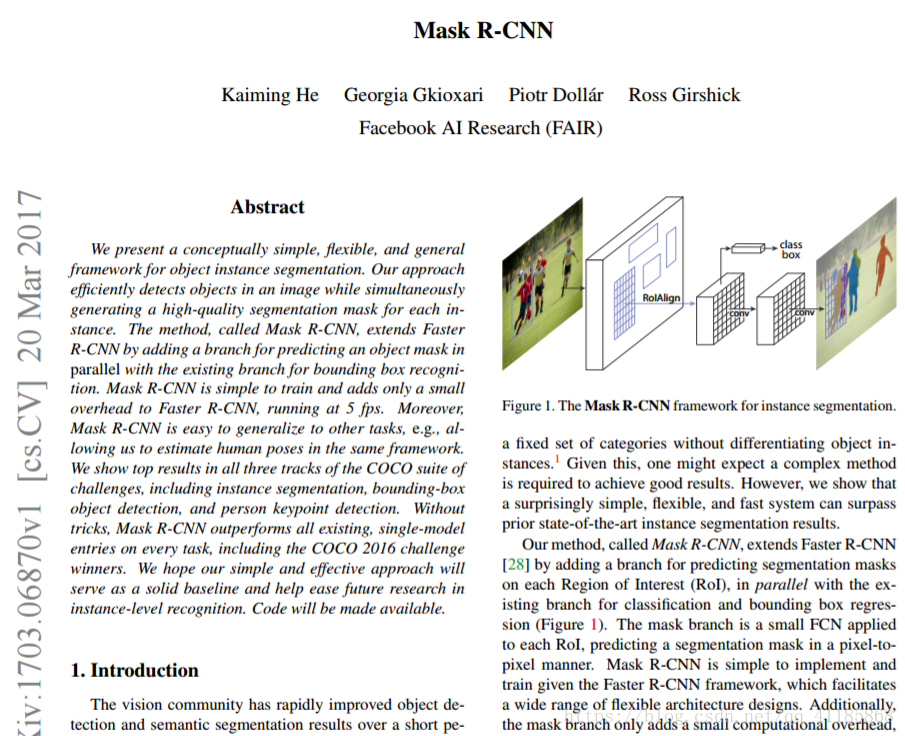

2017.03.20,《Mask R-CNN》

https://arxiv.org/pdf/1703.06870.pdf

https://arxiv.org/abs/1703.06870

Kaiming He等提出了Mask R-CNN ,并获得ICCV2017 Best Paper Award。

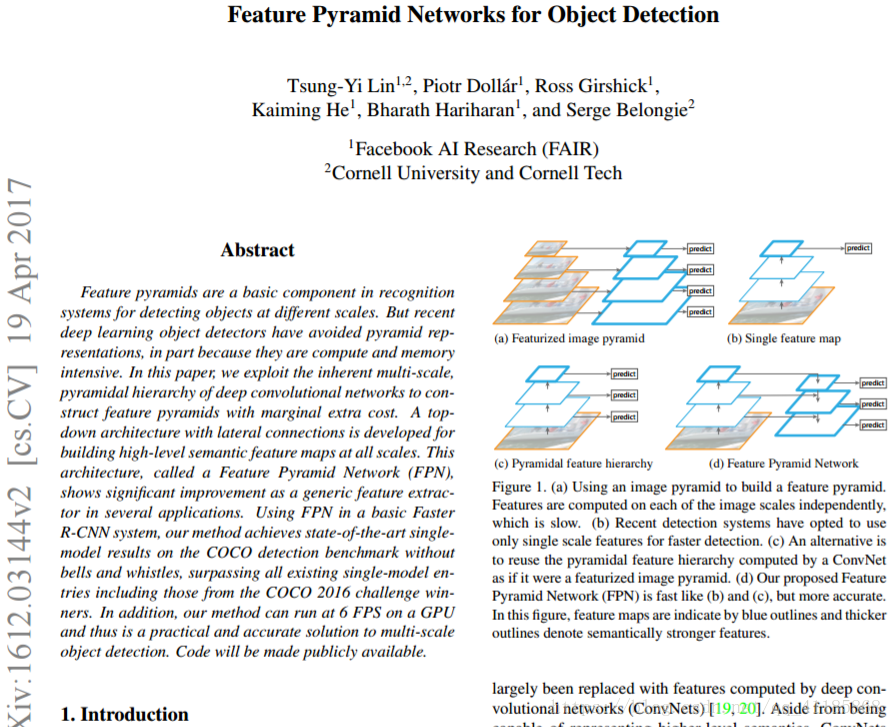

2017.04.09,《Feature Pyramid Networks for Object Detection》

https://arxiv.org/abs/1612.03144

https://arxiv.org/pdf/1612.03144.pdf

2017.04.09,Tsung-Yi Lin、Piotr Dollar, Ross Girshick, Kaiming He齐聚Facebook,又在Faster RCNN的基础上提出了Feature Pyramid Networks(FPN)检测算法。原有的目标检测算法通常都是只采用顶层特征做检测,原因是网络顶层特征的语义信息比较丰富。FPN的主要思想就是在网络前馈结束后,又将网络中最顶层的特征图像逐层地反馈并与前层的特征图进行融合,在此基础上,再从网络中不同深度的位置引出多个检测端口对其中的不同尺度的目标进行检测。由于网络在前馈过程中天然形成了金字塔形状的特征图,所以FPN对小目标以及尺度分布较大的目标具有天然的检测优势。

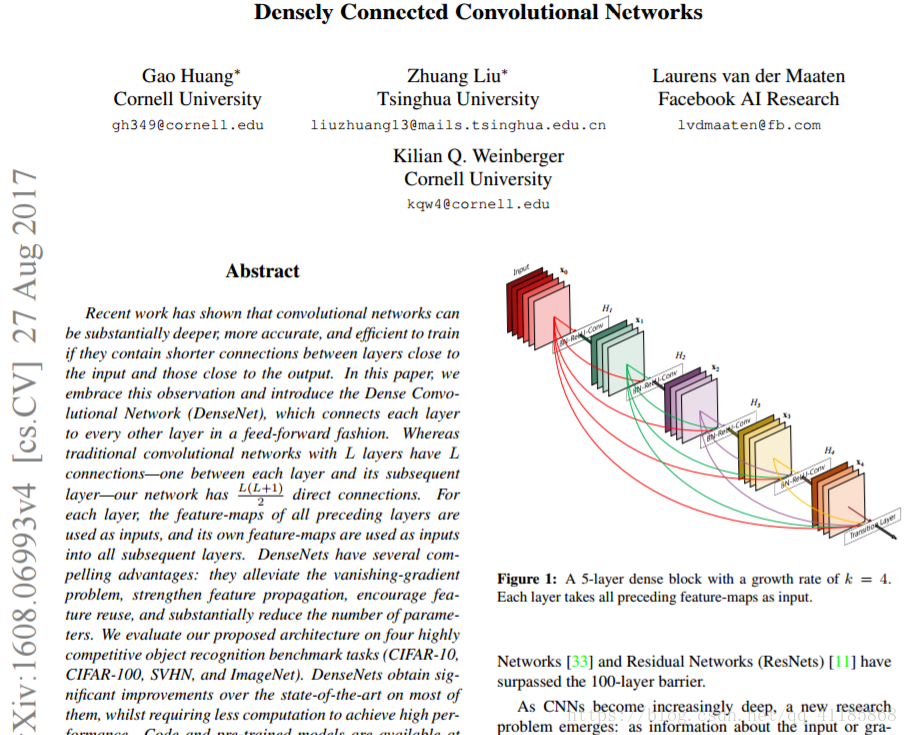

2017.08.27《Densely Connected Convolutional Networks》

https://arxiv.org/pdf/1608.06993.pdf

CVPR 2017上,康奈尔大学博士后黄高博士(Gao Huang)、清华大学本科生刘壮(Zhuang Liu)、Facebook 人工智能研究院研究科学家 Laurens van der Maaten 及康奈尔大学计算机系教授 Kilian Q. Weinberger 所作论文《Densely Connected Convolutional Networks》当选 CVPR 2017 最佳论文,与苹果的首篇公开论文《Learning From Simulated and Unsupervised Images through Adversarial Training》共获这一殊荣。

2017.11.07《Dynamic Routing Between Capsules》

https://arxiv.org/abs/1710.09829

https://arxiv.org/pdf/1710.09829.pdf

2017.11.07,Hinton认为反省传播和传统神经网络有缺陷,提出Capsule Net胶囊网络。但是目前在cifar等数据集上效果一半,这个思路还需要继续验证和发展。

2018年

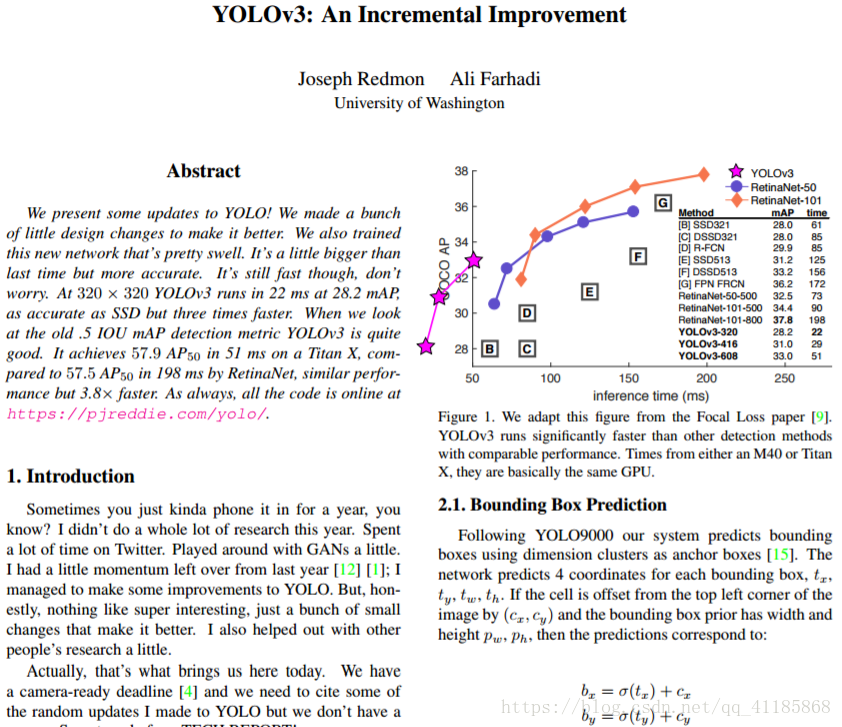

2018.04.08,《YOLOv3: An Incremental Improvement》

https://arxiv.org/abs/1804.02767

https://arxiv.org/pdf/1804.02767.pdf

建议收藏,正在更新!!!!!