2018年论文

[1]Flow Guided Feature: A Fast and Robust Motion Representation for Video Action Recognition[CVPR2018]

题目:光流引导特征:快速,稳健的视频运动表示(OFF)

摘要:运动表示在视频人体行为识别中扮演者重要角色.在本研究中,我们介绍一种新的紧凑的运动表征方法用于视频行为识别,叫做光流引导特征(OFF),它使得网络能够快速鲁棒的提取时间信息.OFF来自光流的定义并且与光流正交.推导也为使用两帧之间的差异提供了理论支持.通过直接计算深度特征图中每个像素上的光流梯度,OFF仅仅使用轻微的代价就可以嵌入到任何已近存在的基于视频行为识别的CNN网络中.它使得CNN同时去提取时空信息,尤其是两帧之间的时间信息.这个简单但是有效的方法通过实验得到验证.使用OFF的网络,仅仅使用RGB图像作为输入在UCF101数据集上可以达到有竞争力的准确度(93.3%)---效果可以比得上双流神经网络,速度却比双流快了15倍).实验结果表明,OFF对于其他运动模态是互补的,例如,光流.当提出的方法引入到最新的识别框架中(双流+ResNet),在UCF-101和HMDB-51上可以达到96.0%和74.2%的准确度.项目源码为:https://github.com/kevin-ssy/Optical-Flow-Guided-Feature.

提出该算法的背景:提取密集光流的低效性,浪费了双流网络90%的运行时间,为此,有研究仅仅在训练阶段使用光流或者是剔除运动向量作为光流的简化版本,降低了一些光流的影响。C3D网络受限于网络设计,训练样本,和参数正则化,无法像OFF一样学习到运动表征,最先进的C3D网络也必须与传统的光流相结合。

文章的贡献总共有两个:提出了快速且鲁棒的运动表征方法;将OFF添加到网络中可以实现端到端的训练.

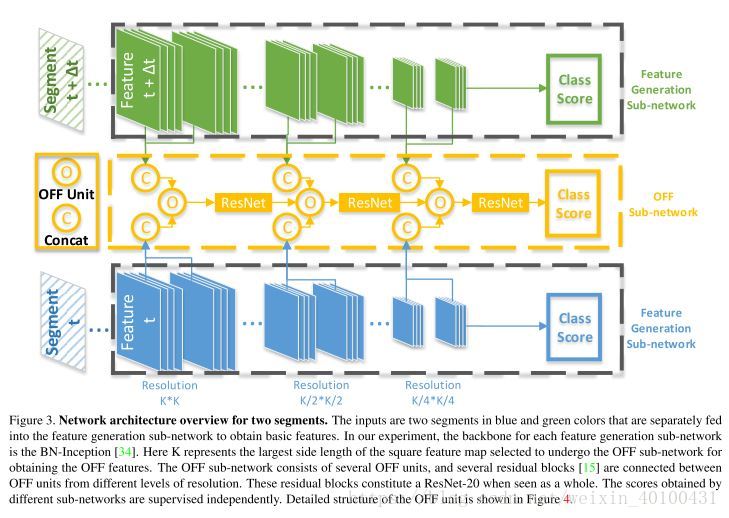

光流引导特征:貌似就是连续两帧相减

在文章中的第3节给出了推导:

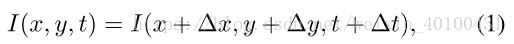

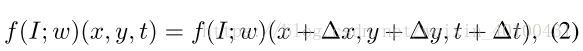

光流基于亮度不变性的假设,I代表亮度(图片),其他代表空间和时间。

f代表从图像I中提取特征。映射函数,可以代表任何可微函数。接下来领p=(x,y,t),推出:

可以看出,上述分别表示的是空间x,y方向上的梯度,以及时间上的梯度。如果上述f(I:w)(p)=I(p),则(Vx,Vy)就是光流。把其当做RGB图像之间的差分,就是这篇文章的OFF。后来提到了本文的差分与光流正交(相乘为0),数学上,正交表明了他们他们能够表示相同的特征向量。说明如果光流能够代表特征,那么OFF也能够提取特征。

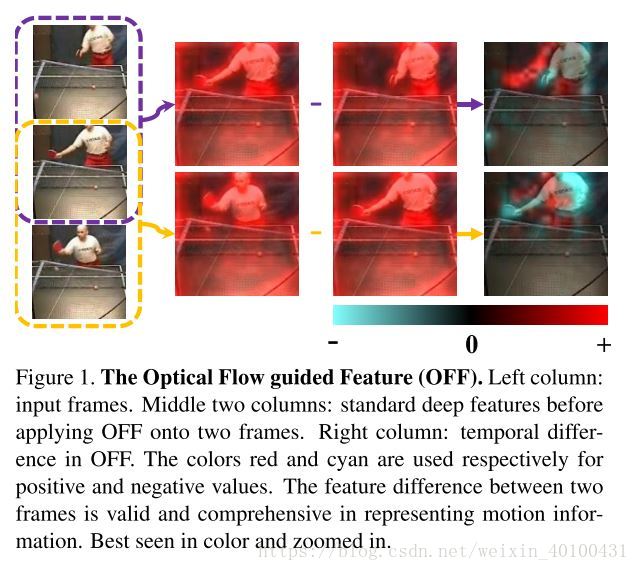

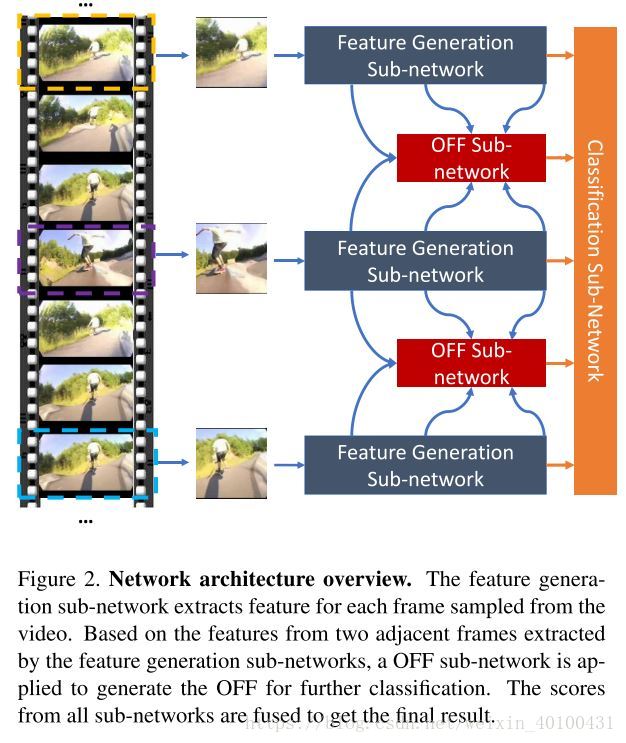

网络结构整体结构是由三个子网络组成的。(特征提取使用的基础的CNN网络,BN-inception)

下图展示了由双流网络组成的更加详细的结构。