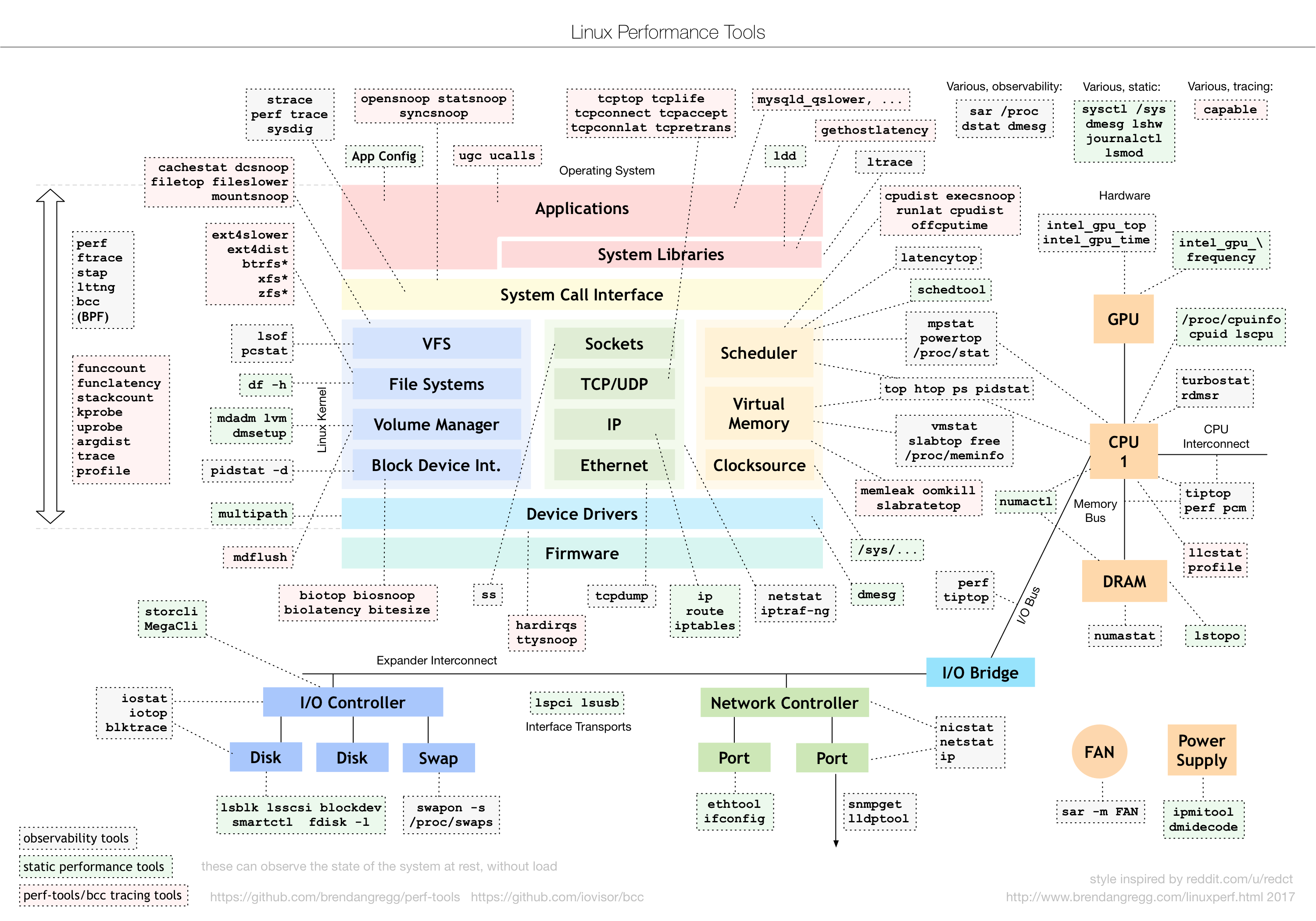

- 有监控的情况下, 首先去看看监控大盘, 看看有没有异常报警, 如果初期还没有监控的情况我会按照下面步骤去看看系统层面有没有异常

- 首先会去看看系统的平均负载, 使用top或者htop命令查看,平均负载体现的是系统的一个整体情况, 他应该是cpu、内存、磁盘性能的一个综合, 一般是平均负载的值大于机器cpu的核数, 这时候说明机器资源已经紧张了

- 平均负载高了以后, 接下来就要看看具体是什么资源导致, 我首先会在top中看cpu每个核的使用情况, 如果占比很高, 那瓶颈应该是cpu,接下来就要看看是什么进程导致的

- 如果cpu没有问题, 那接下来我会去看内存, 首先是用free去查看内存的是用情况, 但不直接看他剩余了多少, 还要结合看看cache和buffer, 然后再看看具体是什么进程占用了过高的内存, 我也是是用top去排序

- 内存没有问题的话就要去看磁盘了, 磁盘我用iostat去查看, 我遇到的磁盘问题比较少

- 还有就是带宽问题, 一般会用iftop去查看流量情况, 看看流量是否超过的机器给定的带宽

- 涉及到具体应用的话, 就要根据具体应用的设定参数来查看, 比如连接数是否查过设定值等

- 如果系统层各个指标查下来都没有发现异常, 那么就要考虑外部系统了, 比如数据库、缓存、存储等

一、CPU

1.1 Load Average 平均负载

平均负载是指单位时间内, 系统处于可运行状态、和不可中断状态的 平均进程数, 也就是平均活跃进程数, 它和 CPU 使用率并没有直接关系.

- 可运行状态的进程:指正在使用 CPU 或正在等待 CPU 的进程, 即 ps 命令中处于 R 状态(Running 或 Runnable)的进程

- 不可中断状态的进程:则是正处于内核态关键流程中的进程, 并且这些流程是不可打断的, 如最常见的是等待硬件设备的 I/O 响应, 即在 ps 命令中的 D 状态(Uninterruptible Sleep, 也称为 Disk Sleep)的进程.

- 比如, 当一个进程向磁盘读写数据时, 为了保证数据的一致性, 在得到磁盘回复前, 它是不能被其他进程或者中断打断的, 这个时候的进程就处于不可中断状态. 如果此时的进程被打断了, 就容易出现磁盘数据与进程数据不一致的问题. 所以, 不可中断状态实际上是系统对进程和硬件设备的一种保护机制.

因此, 你可以简单理解为, 平均负载其实就是平均活跃进程数. 平均活跃进程数, 直观上的理解就是单位时间内的活跃进程数, 但它实际上是活跃进程数的指数衰减平均值. (这个“指数衰减平均”的详细含义你不用计较, 这只是系统的一种更快速的计算方式, 你把它直接当成活跃进程数的平均值也没问题. )

既然平均的是活跃进程数, 那么最理想的, 就是每个 CPU 上都刚好运行着一个进程, 这样每个 CPU 都得到了充分利用. 比如当平均负载为 2 时, 意味着什么呢?

- 在只有 2 个 CPU 的系统上, 意味着所有的 CPU 都刚好被完全占用.

- 在 4 个 CPU 的系统上, 意味着 CPU 有 50% 的空闲.

- 而在只有 1 个 CPU 的系统中, 则意味着有一半的进程竞争不到 CPU.

结论:

- 平均负载高有可能是 CPU 密集型进程导致的;

- 平均负载高并不一定代表 CPU 使用率高, 还有可能是 I/O 更繁忙了;

- 当发现负载高的时候, 你可以使用 mpstat、pidstat 等工具, 辅助分析负载的来源.

uptime # 输出23:01:47 up 69 days, 15:32, 2 users, load average: 1.73, 3.09, 3.40

NAME

uptime - Tell how long the system has been running.

DESCRIPTION

uptime gives a one line display of the following information. The current time, how long the system has been running, how many users are currently logged on, and the system load averages for the past 1, 5, and 15 minutes.

This is the same information contained in the header line displayed by w(1).

System load averages is the average number of processes that are either in a runnable or uninterruptable state. A process in a runnable state is either using the CPU or waiting to use the CPU. A process in uninterrupt‐

able state is waiting for some I/O access, eg waiting for disk. The averages are taken over the three time intervals. Load averages are not normalized for the number of CPUs in a system, so a load average of 1 means a

single CPU system is loaded all the time while on a 4 CPU system it means it was idle 75% of the time.

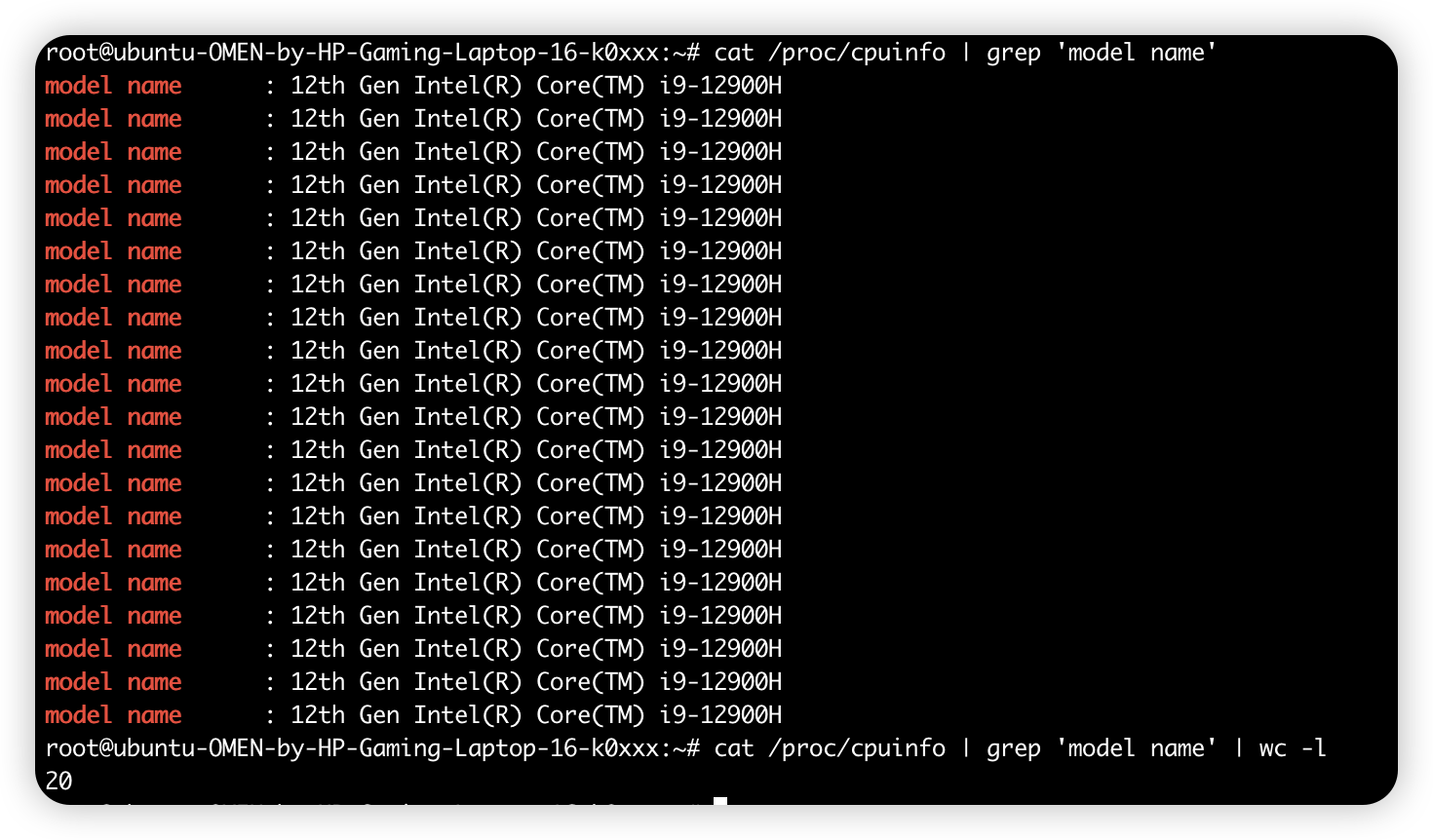

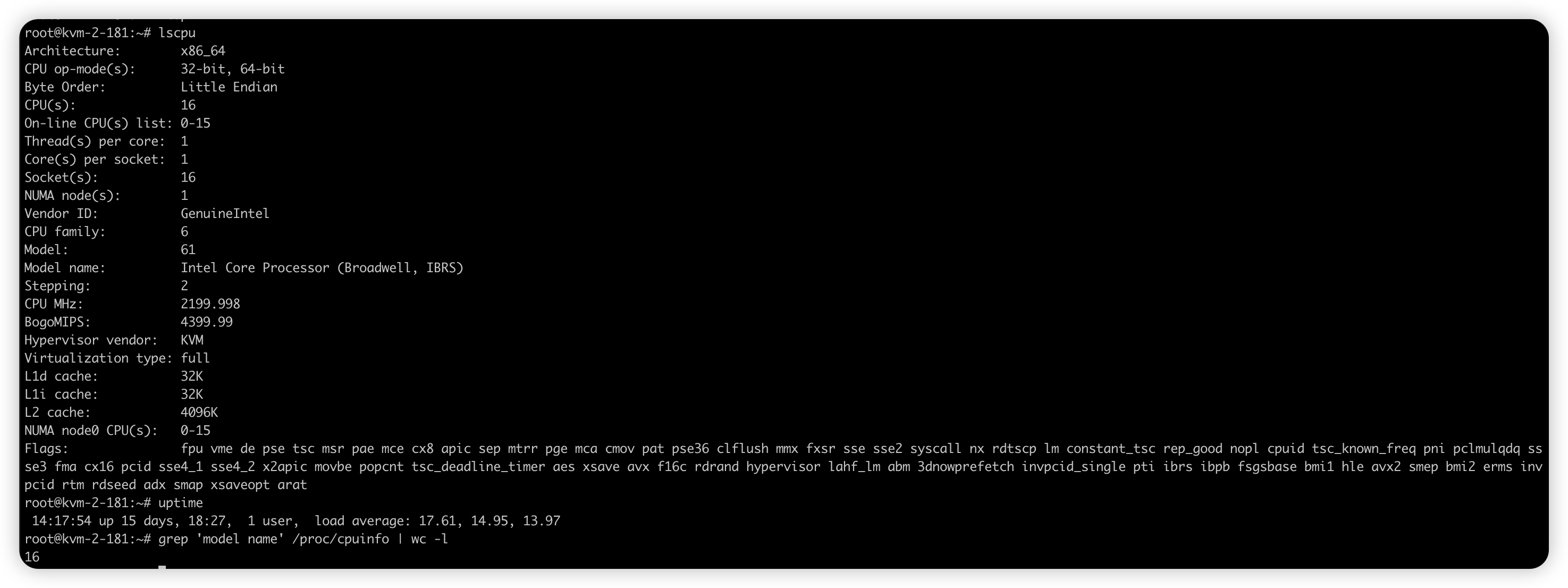

通过下文可得到 CPU 逻辑个数, 若 load average 大于 cpu 逻辑个数 * 70% 则视为超载:

grep 'model name' /proc/cpuinfo | wc -l

三个负载时间段:

- 如果 1 分钟、5 分钟、15 分钟的三个值基本相同, 或者相差不大, 那就说明系统负载很平稳.

- 但如果 1 分钟的值远小于 15 分钟的值, 就说明系统最近 1 分钟的负载在减少, 而过去 15 分钟内却有很大的负载.

- 反过来, 如果 1 分钟的值远大于 15 分钟的值, 就说明最近 1 分钟的负载在增加, 这种增加有可能只是临时性的, 也有可能还会持续增加下去, 所以就需要持续观察. 一旦 1 分钟的平均负载接近或超过了 CPU 的个数, 就意味着系统正在发生过载的问题, 这时就得分析调查是哪里导致的问题, 并要想办法优化了.

- 例如:假设我们在一个单 CPU 系统上看到平均负载为 1.73, 0.60, 7.98, 那么说明在过去 1 分钟内, 系统有 73% 的超载, 而在 15 分钟内, 有 698% 的超载, 从整体趋势来看, 系统的负载在降低.

在实际生产环境中, 平均负载多高时, 需要我们重点关注呢?

- 当平均负载高于 CPU 逻辑数量 70% 的时候, 你就应该分析排查负载高的问题了. 一旦负载过高, 就可能导致进程响应变慢, 进而影响服务的正常功能. 但 70% 这个数字并不是绝对的.

- 最推荐的方法, 还是把系统的平均负载监控起来, 然后根据更多的历史数据, 判断负载的变化趋势. 当发现负载有明显升高趋势时, 比如说负载翻倍了, 你再去做分析和调查.

1.1.1 CPU 使用率

平均负载是指单位时间内, 处于可运行状态和不可中断状态的进程数. 所以, 它不仅包括了正在使用 CPU 的进程, 还包括等待 CPU 和等待 I/O 的进程.

而 【CPU 使用率】, 是单位时间内 CPU 繁忙情况的统计, 跟【平均负载】并不一定完全对应. 比如:

- CPU 密集型进程, 使用大量 CPU 会导致平均负载升高, 此时这两者是一致的;

- I/O 密集型进程, 等待 I/O 也会导致平均负载升高, 但 CPU 使用率不一定很高;

- 大量等待 CPU 的进程调度也会导致平均负载升高, 此时的 CPU 使用率也会比较高.

1.1.1.1 CPU 使用率高,定位哪个具体应用导致的

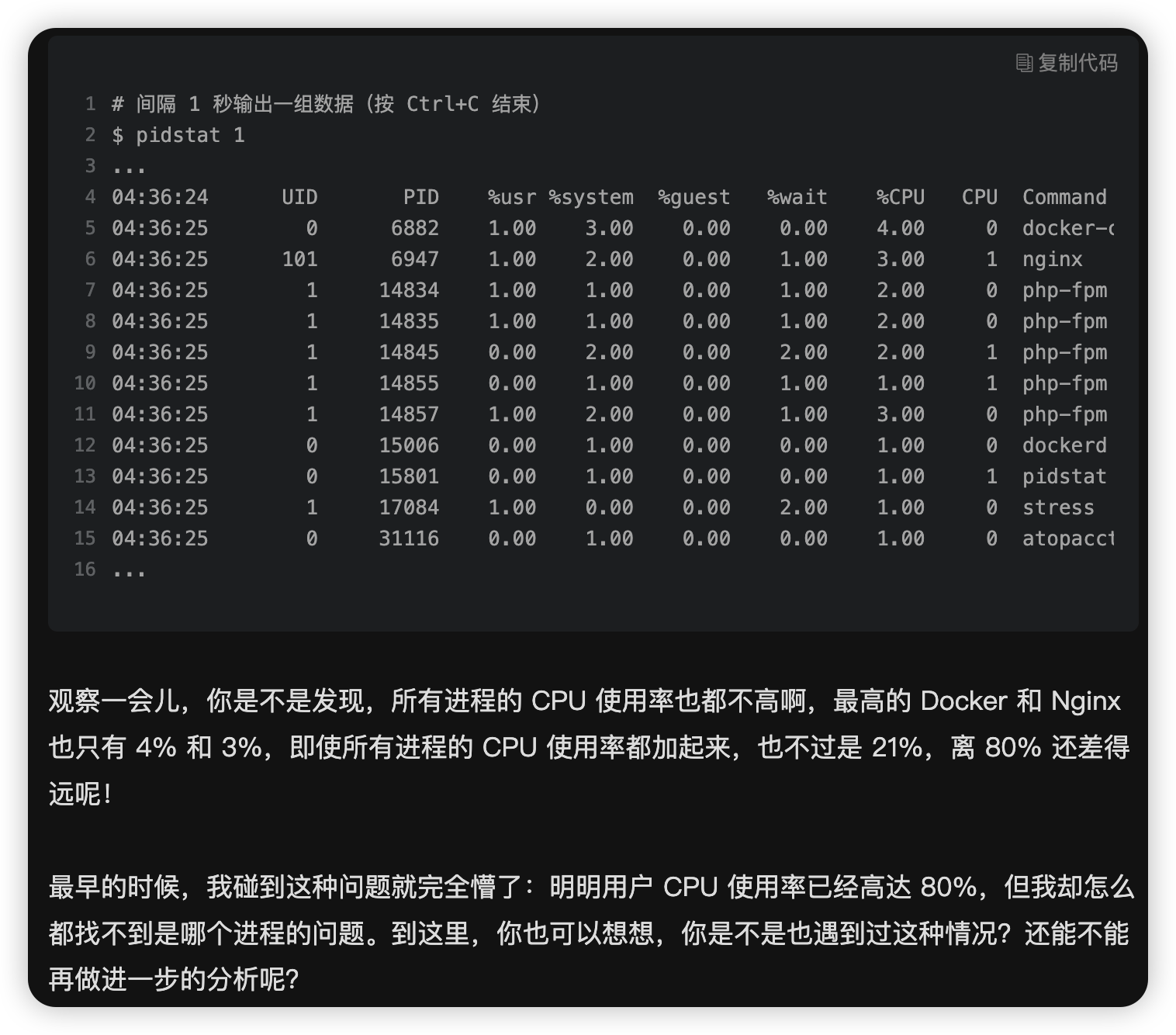

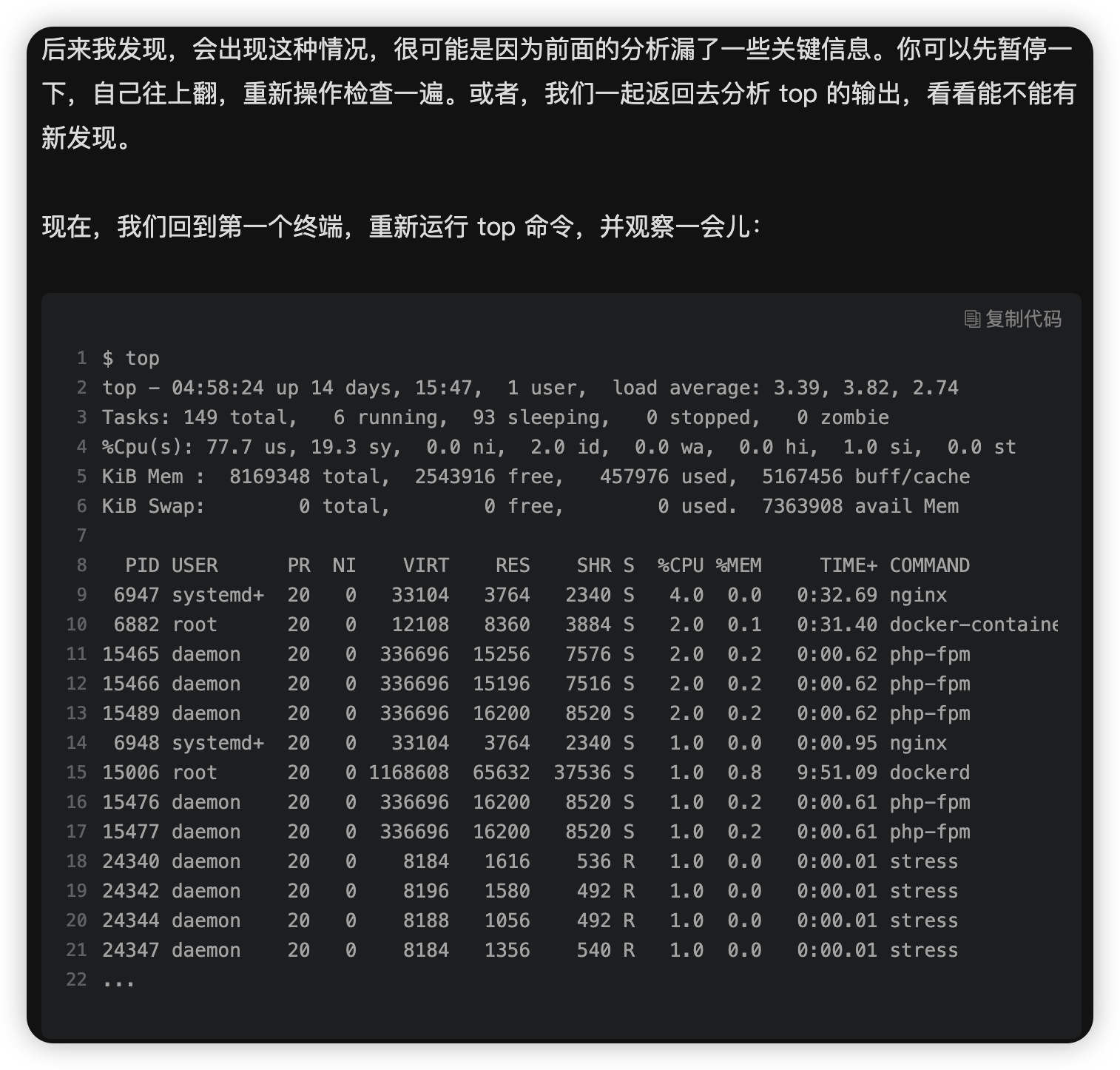

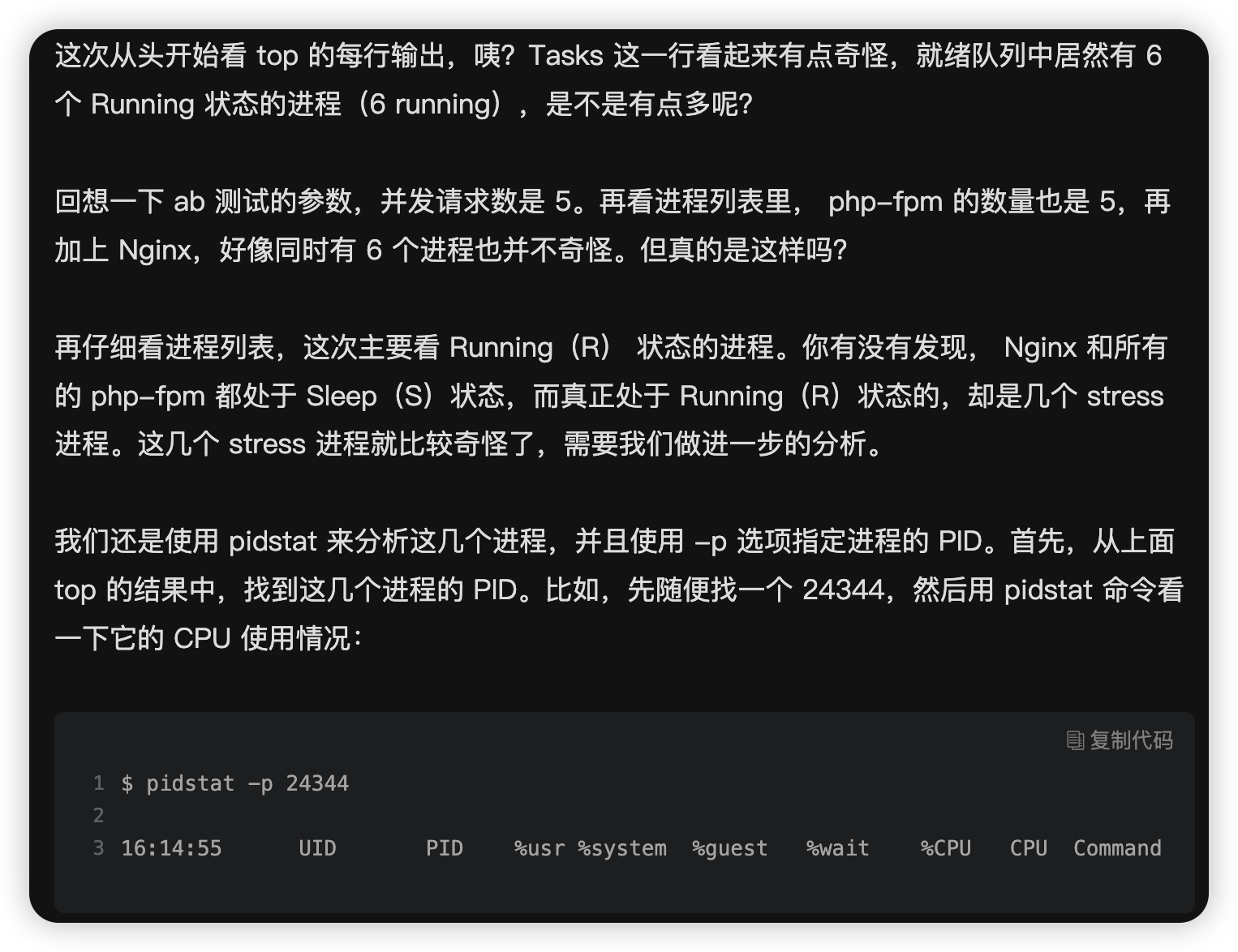

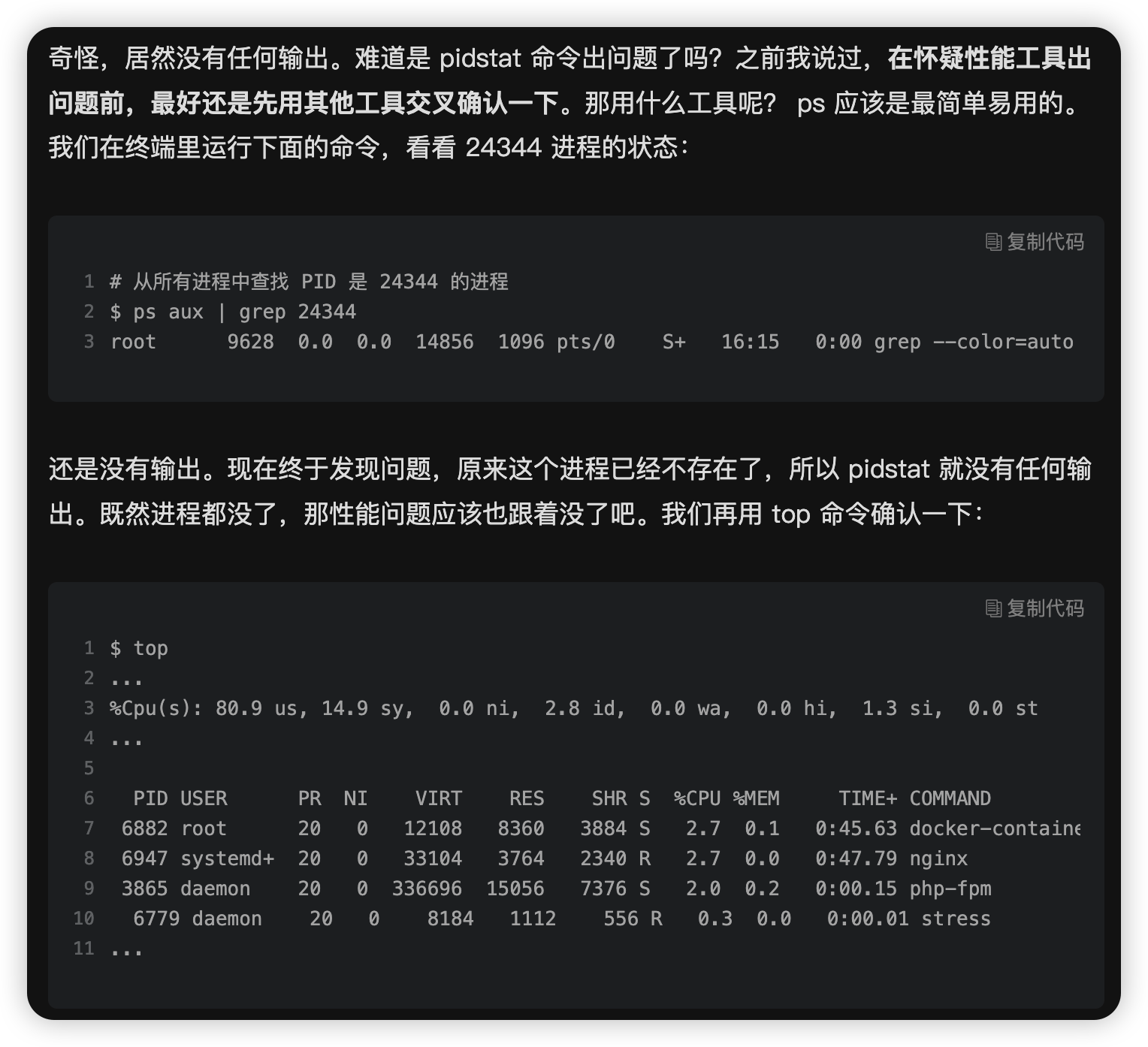

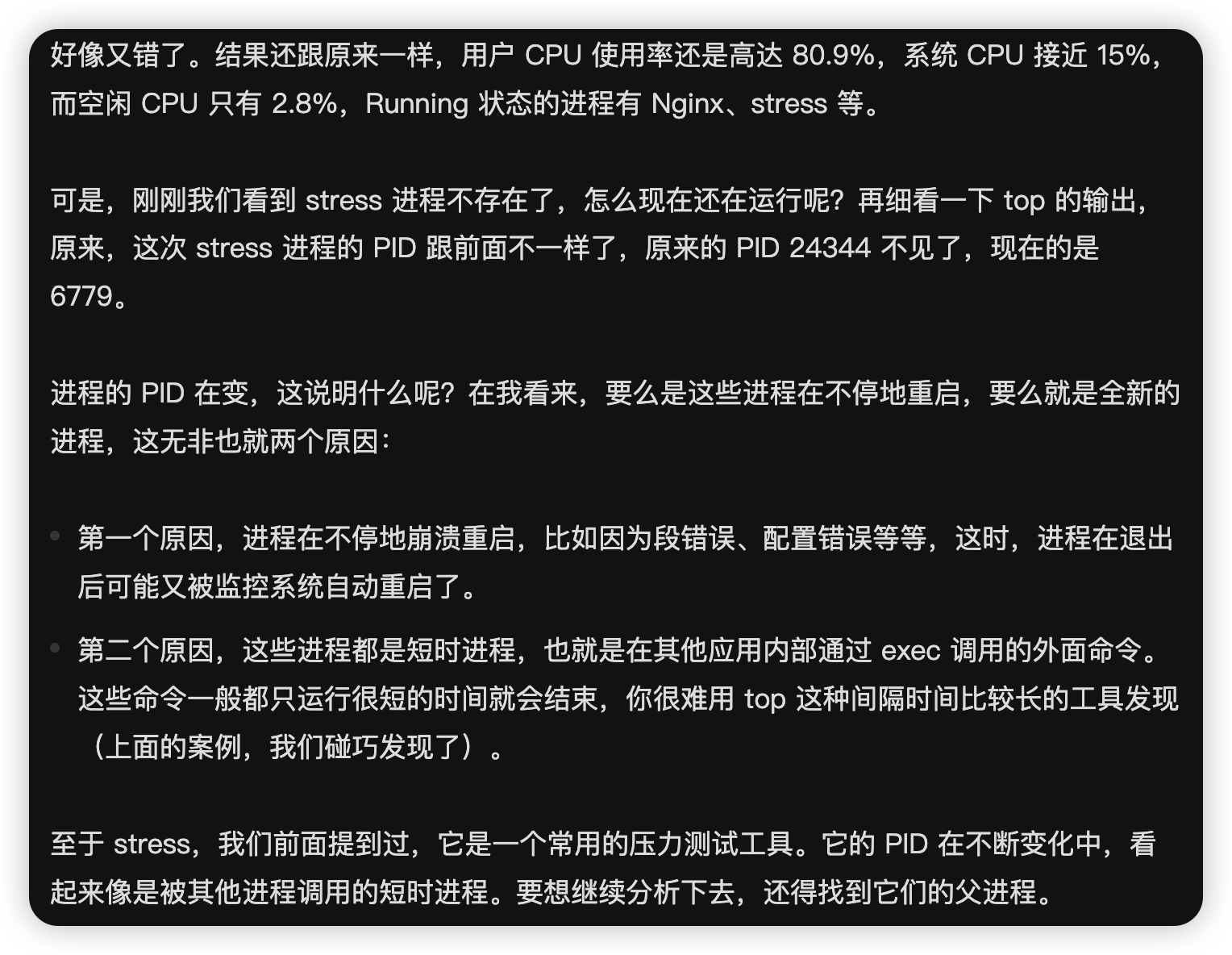

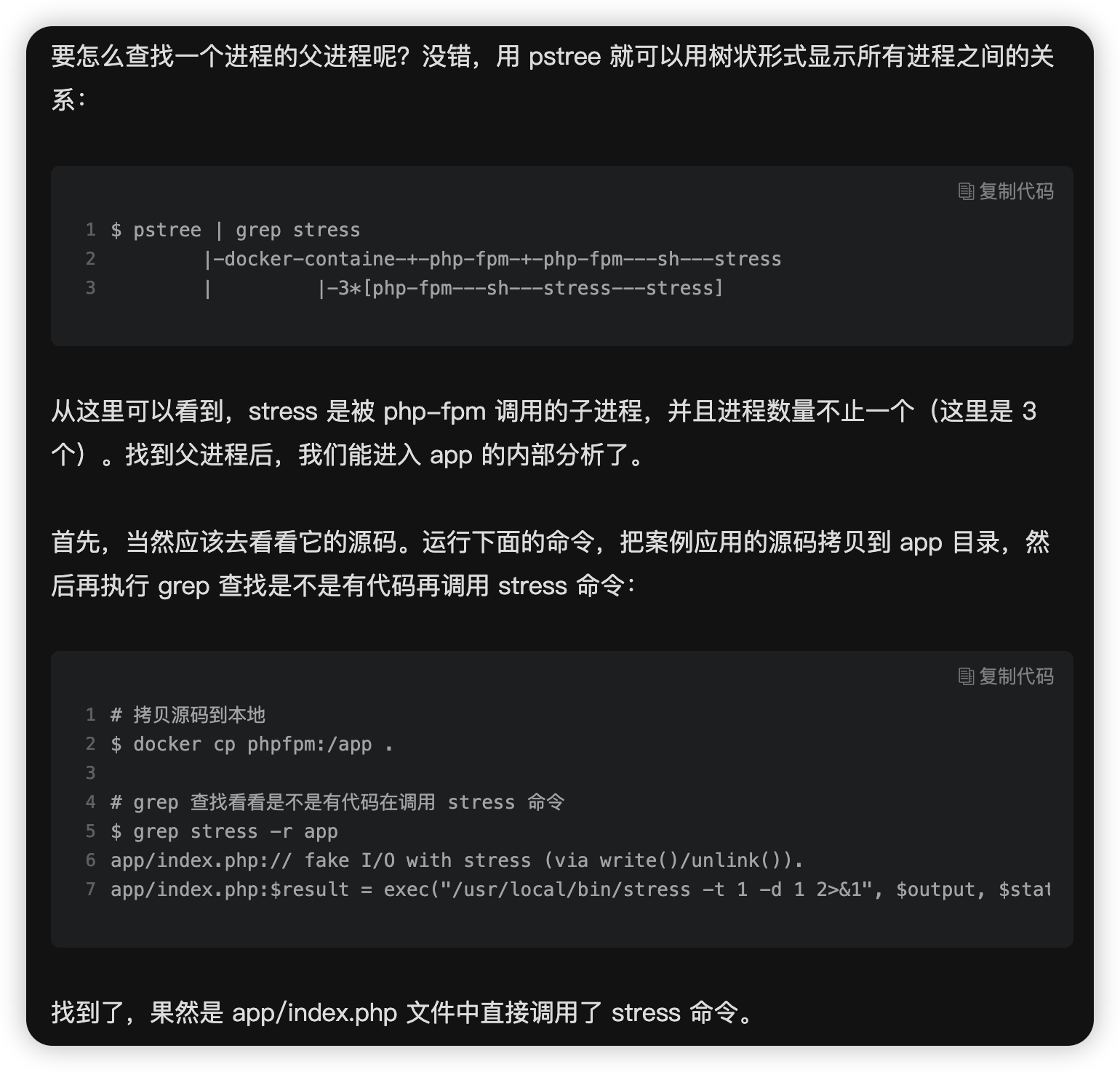

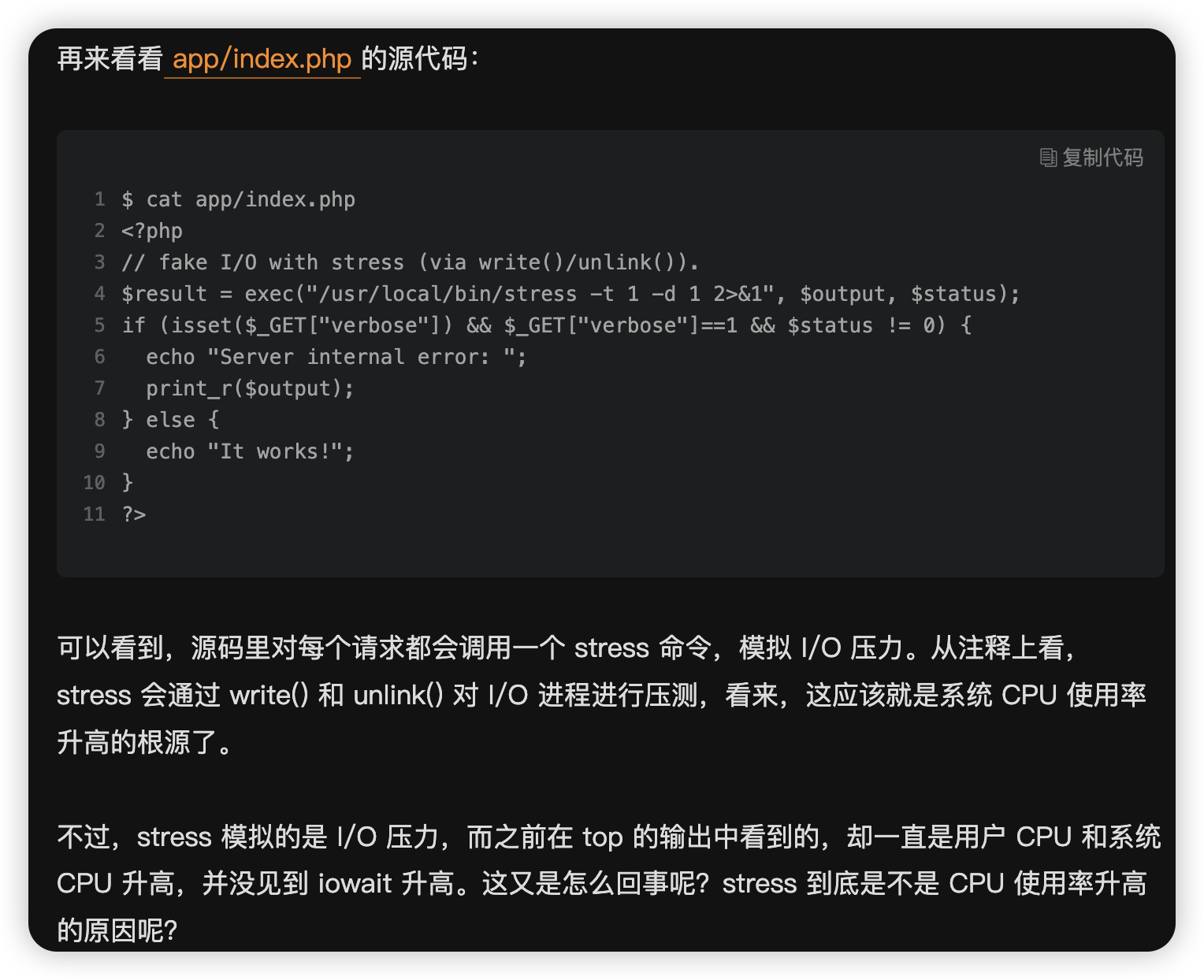

上一节我讲了 CPU 使用率是什么,并通过一个案例教你使用 top、vmstat、pidstat 等工具,排查高 CPU 使用率的进程,然后再使用 perf top 工具,定位应用内部函数的问题。不过就有人留言了,说似乎感觉高 CPU 使用率的问题,还是挺容易排查的。

那是不是所有 CPU 使用率高的问题,都可以这么分析呢?我想,你的答案应该是否定的。

回顾前面的内容,我们知道,系统的 CPU 使用率,不仅包括进程用户态和内核态的运行,还包括中断处理、等待 I/O 以及内核线程等。所以,当你发现系统的 CPU 使用率很高的时候,不一定能找到相对应的高 CPU 使用率的进程。

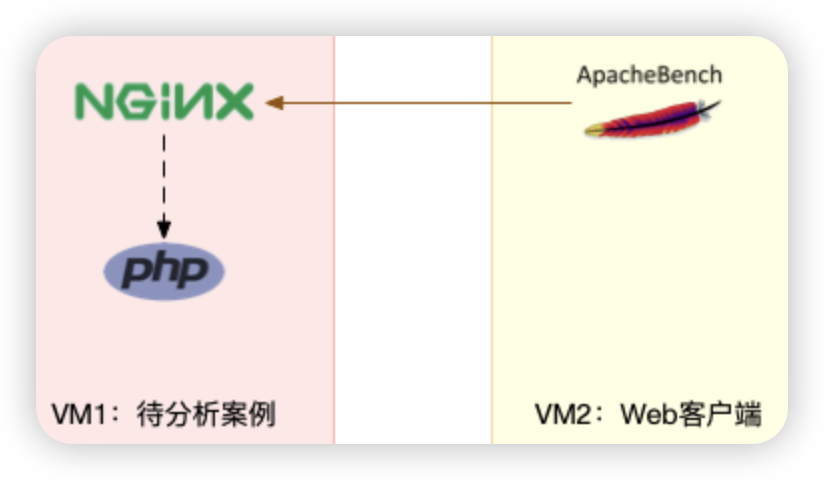

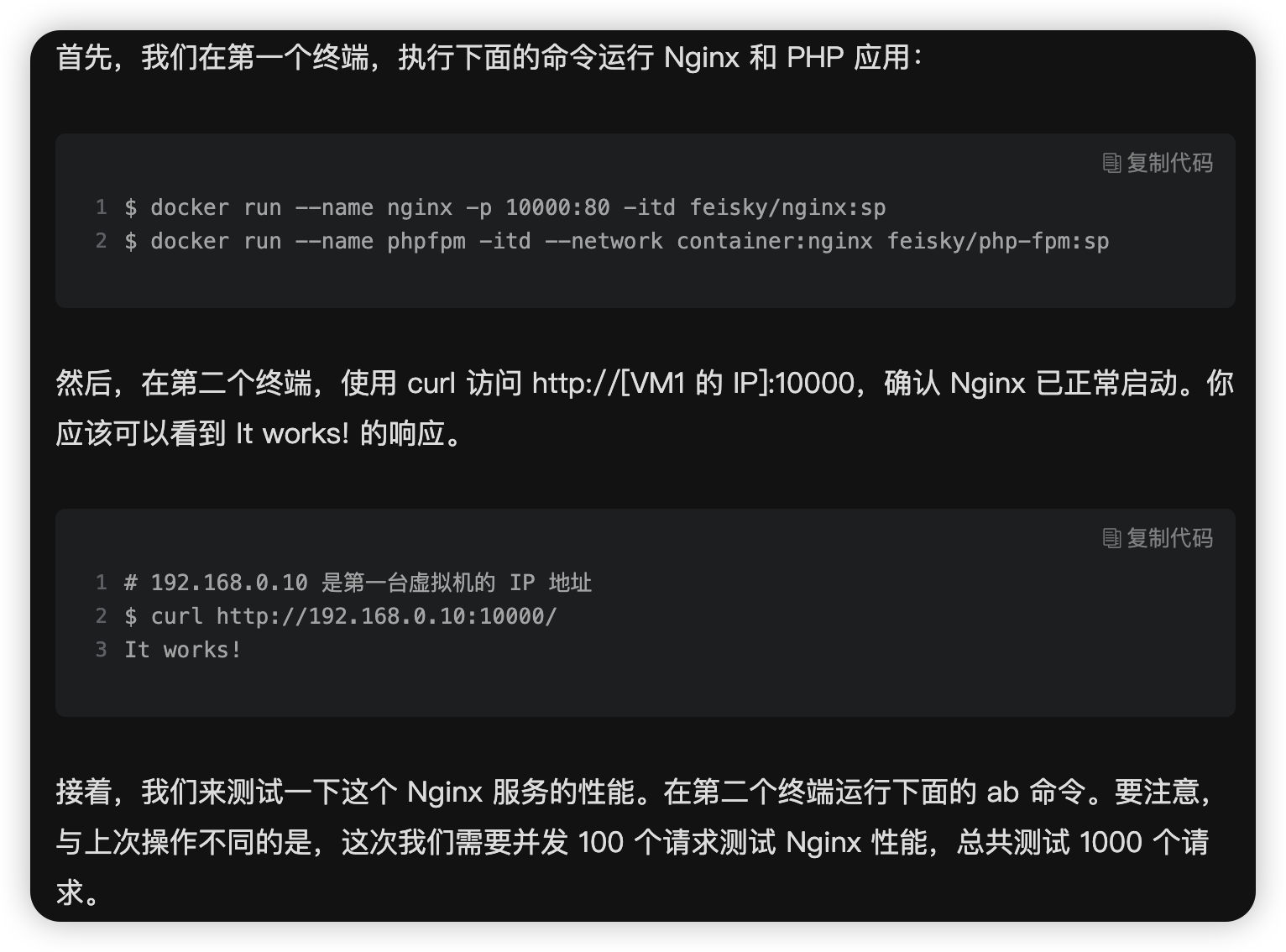

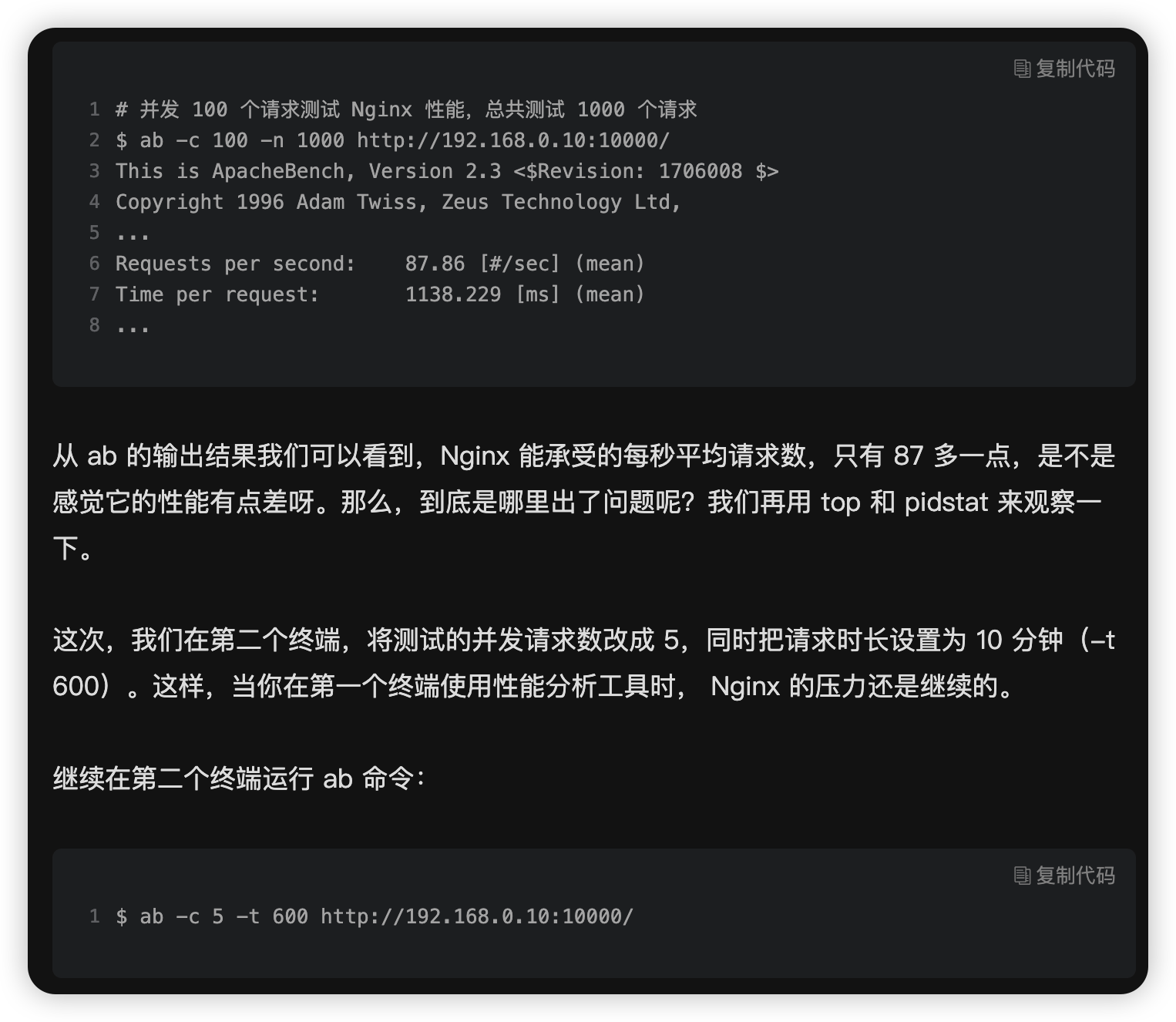

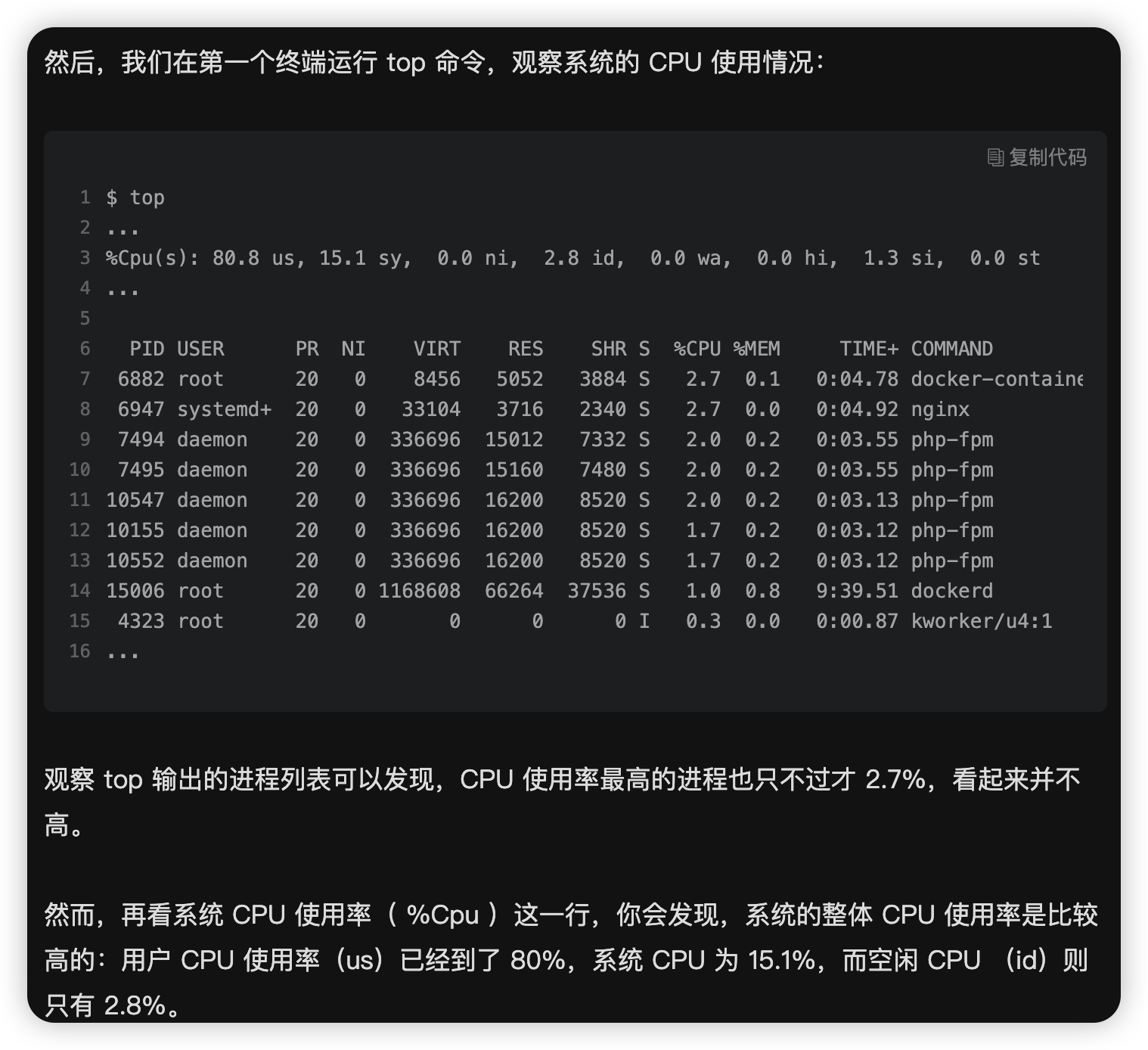

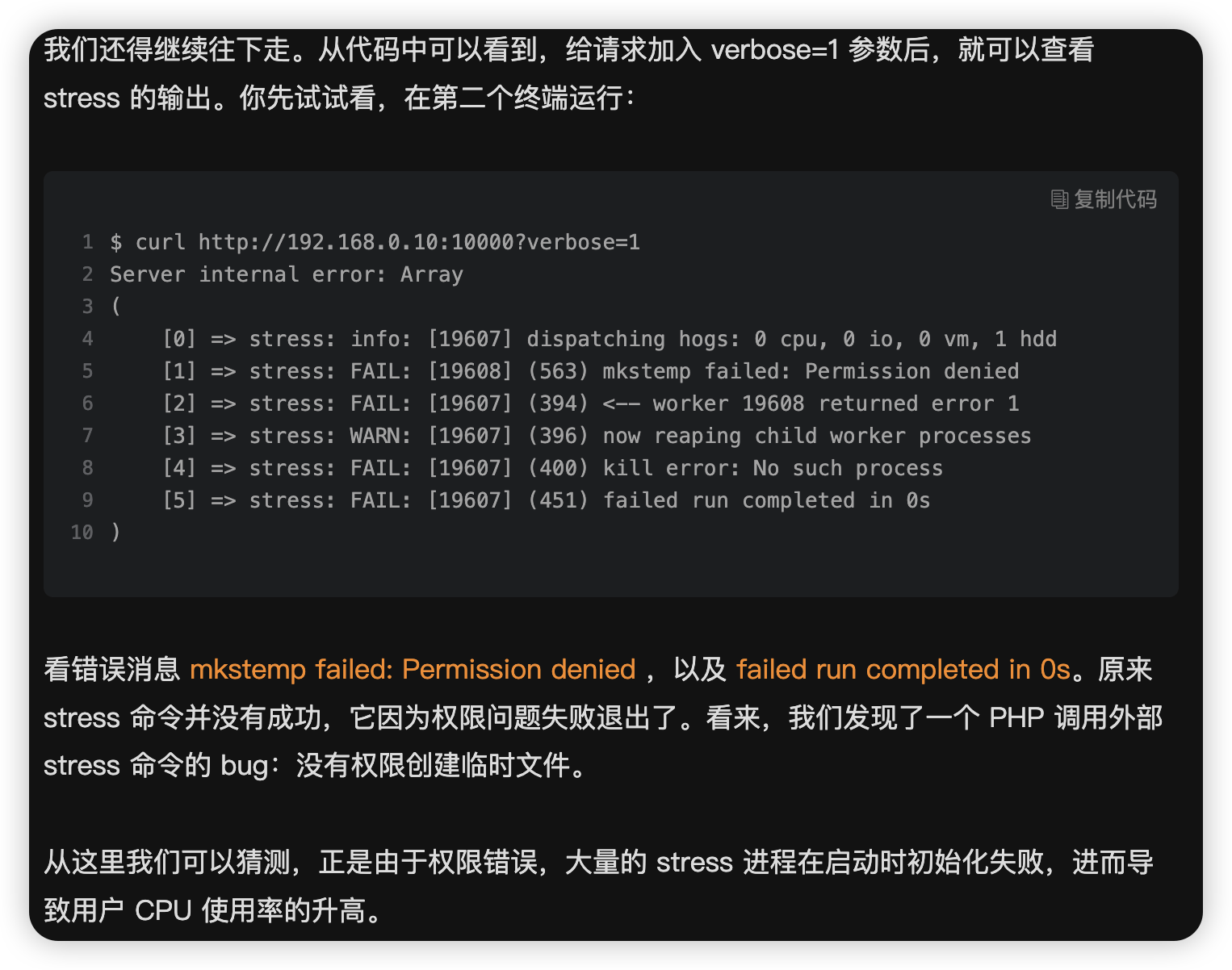

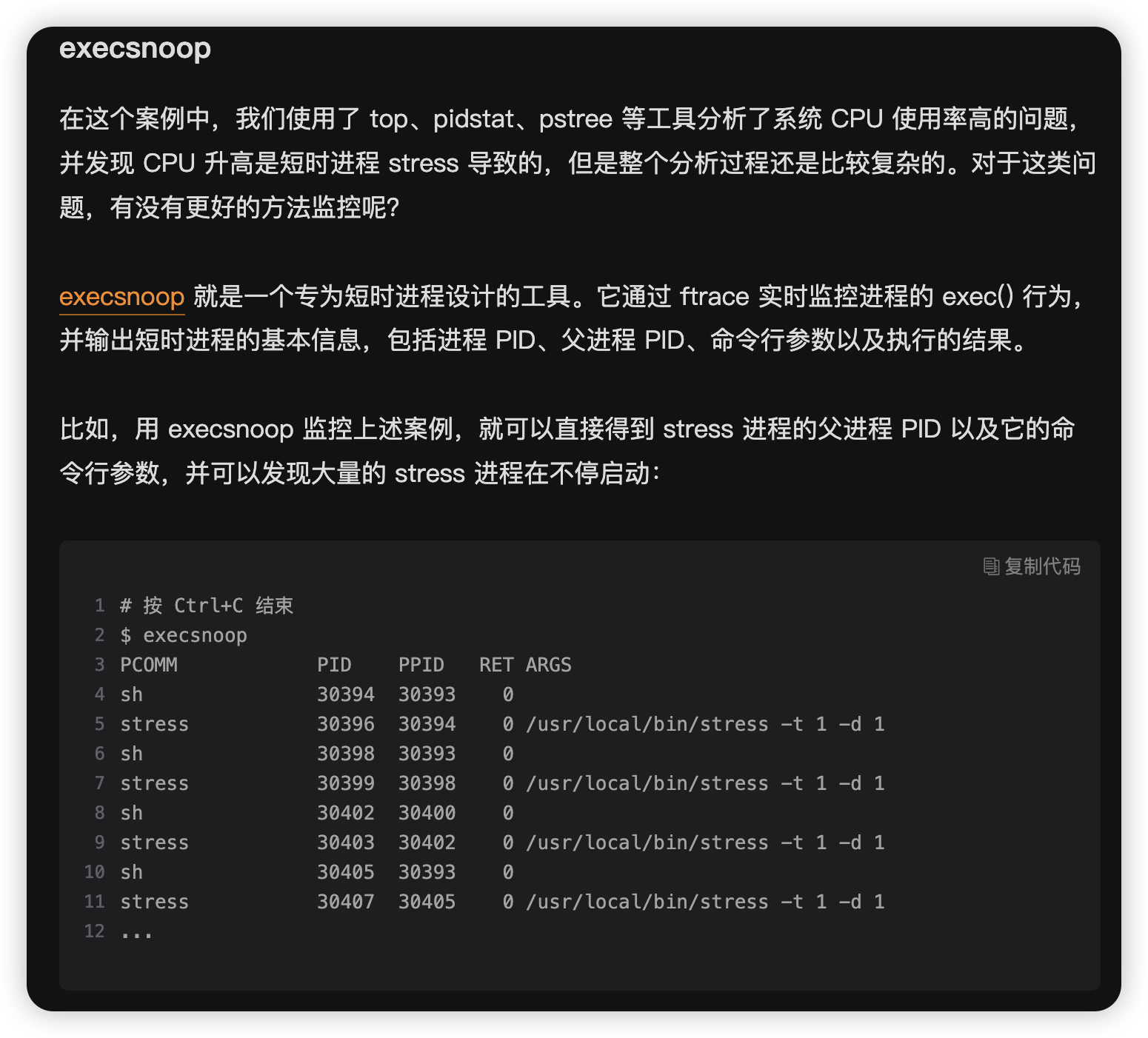

今天,我就用一个 Nginx + PHP 的 Web 服务的案例,带你来分析这种情况。

环境准备:

机器配置:2 CPU,8GB 内存

预先安装 docker、sysstat、perf、ab 等工具,如 apt install docker.io sysstat linux-tools-common apache2-utils

其中一台用作 Web 服务器,来模拟性能问题;另一台用作 Web 服务器的客户端,来给 Web 服务增加压力请求。使用两台虚拟机是为了相互隔离,避免“交叉感染”。

接下来,我们打开两个终端,分别 SSH 登录到两台机器上,并安装上述工具。

1.1.1.1.1 操作和分析

也可用 perf record -ag -- sleep 2;perf report 一步到位生成报告。

sar -w 或者 sar -w 1 也能直观的看到每秒生成线程或者进程的数量。

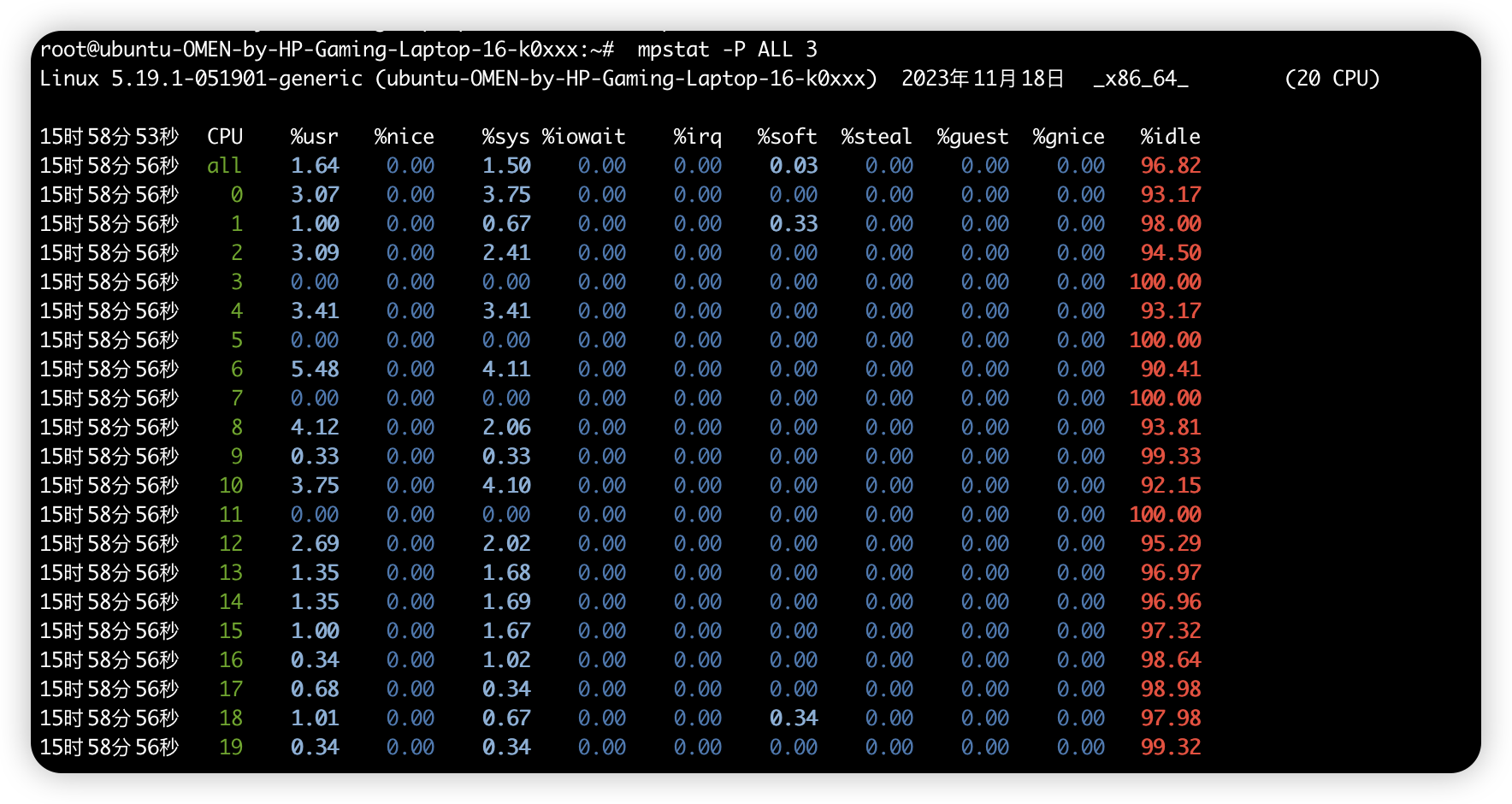

1.1.2 案例:uptime、mpstat、pidstat

机器配置:ubuntu 18.04、2 CPU、8GB 内存, 预装了 apt install stress sysstat

- stress 是一个 Linux 系统压力测试工具, 这里我们用作异常进程模拟平均负载升高的场景.

- sysstat 包含了常用的 Linux 性能工具, 用来监控和分析系统的性能. 我们的案例会用到这个包的两个命令 mpstat 和 pidstat.

- mpstat 是一个常用的多核 CPU 性能分析工具, 用来实时查看每个 CPU 的性能指标, 以及所有 CPU 的平均指标.

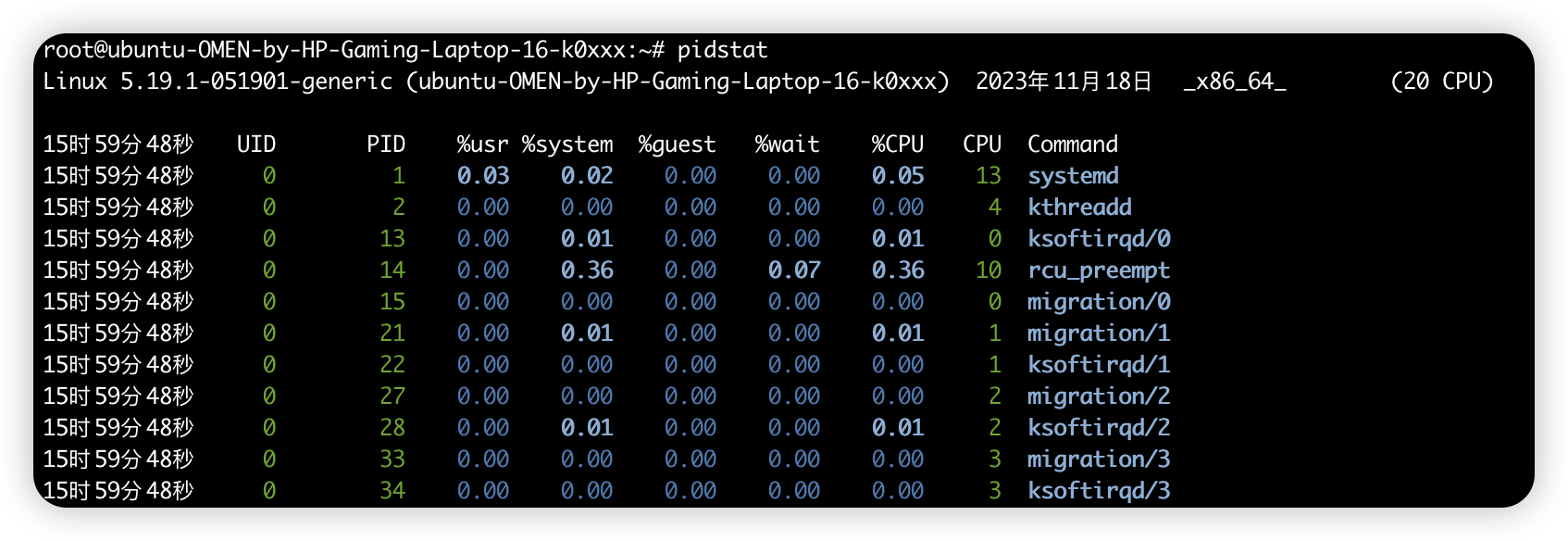

- pidstat 是一个常用的进程性能分析工具, 用来实时查看进程的 CPU、内存、I/O 以及上下文切换等性能指标.

每个场景都需要在同一个机器开三个终端:

# 先 uptime 看一下最初的平均负载基本都为0:

uptime # load average: 0.11, 0.15, 0.09

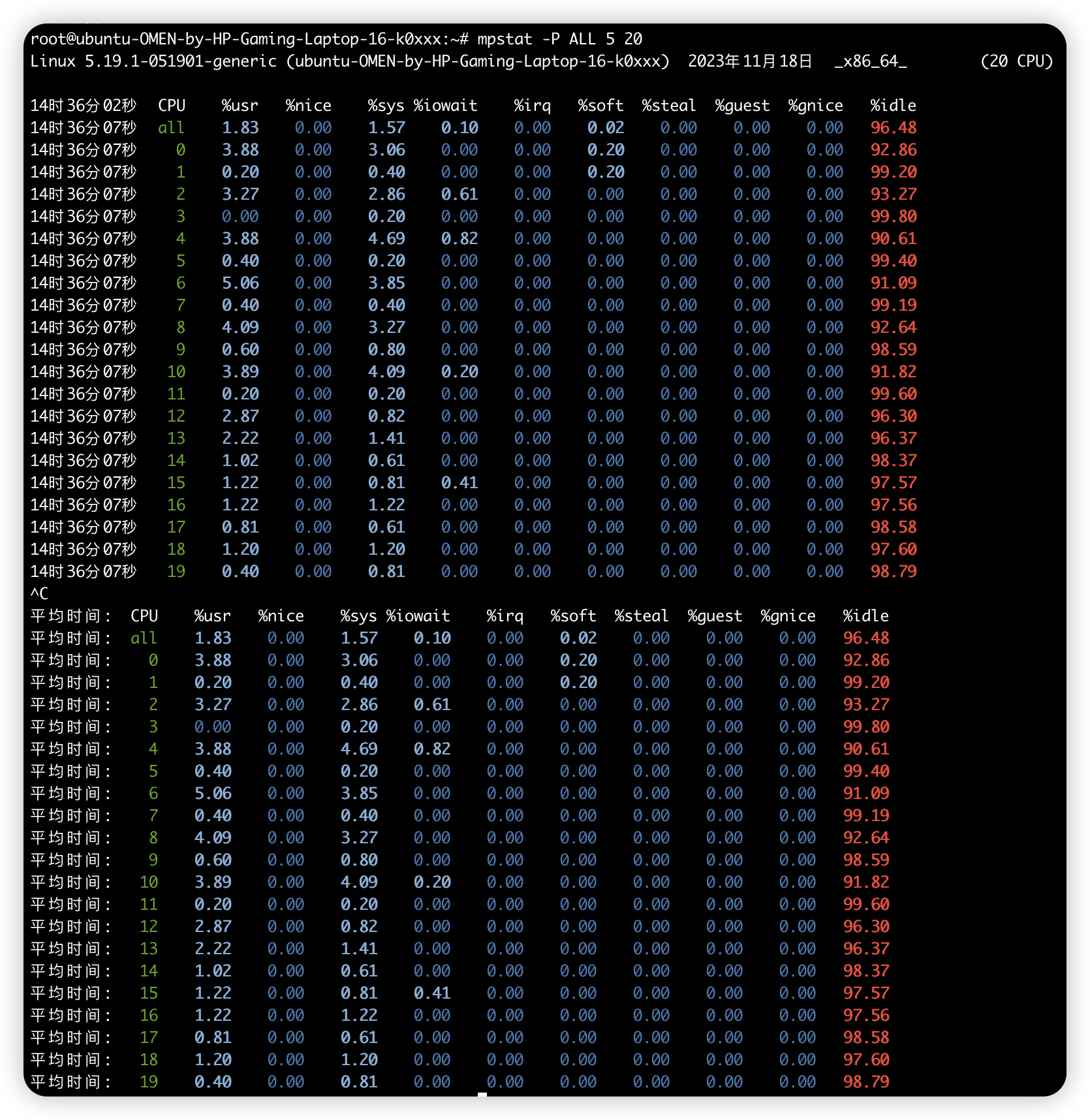

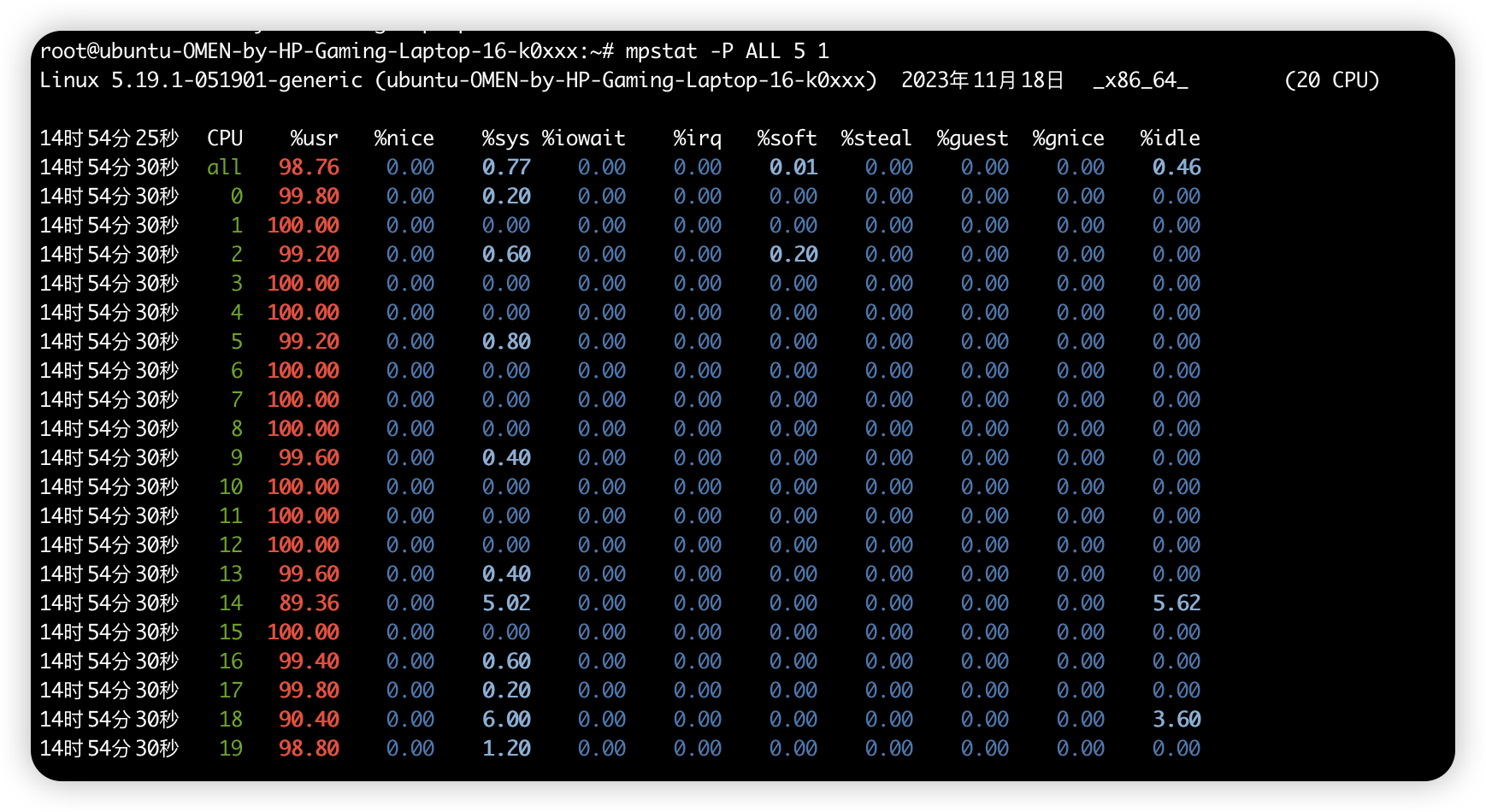

# mpstat -P ALL 5 20 (-P ALL 表示监控所有 CPU, 后面数字 5 表示间隔 5 秒后输出一组数据, 观测20次)

Linux 4.15.0 (ubuntu) 09/22/18 _x86_64_ (2 CPU)

13:30:06 CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

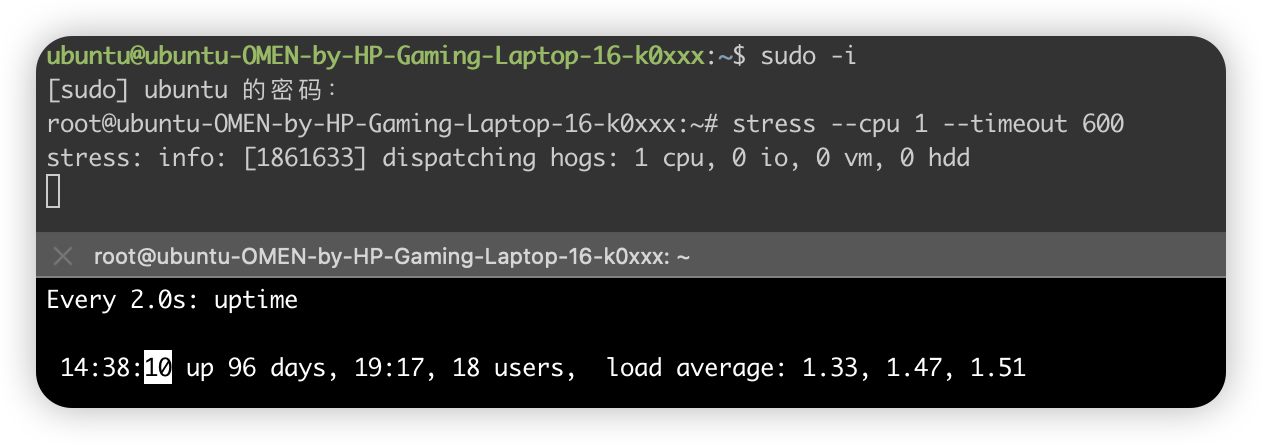

1.1.2.1 CPU 密集型进程

# 第一个终端: 先运行 stress 模拟 CPU 使用率 100% 的场景

stress --cpu 1 --timeout 600

# 第二个终端运行 uptime 查看平均负载的变化情况:

watch -d uptime # load average: 1.00, 0.75, 0.39 # 近1min cpu 负载高

# 第三个终端运行 mpstat 查看 CPU 使用率的变化情况:

# mpstat -P ALL 5

Linux 4.15.0 (ubuntu) 09/22/18 _x86_64_ (2 CPU)

13:30:06 CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

13:30:11 all 50.05 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 49.95

13:30:11 0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

13:30:11 1 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 # %usr高达100%

从终端二中可以看到, 1 分钟的平均负载会慢慢增加到 1.00

而从终端三中还可以看到, 正好有一个 CPU 的使用率为 100%, 但它的 iowait 只有 0

这说明, 平均负载的升高正是由于 CPU 使用率为 100%

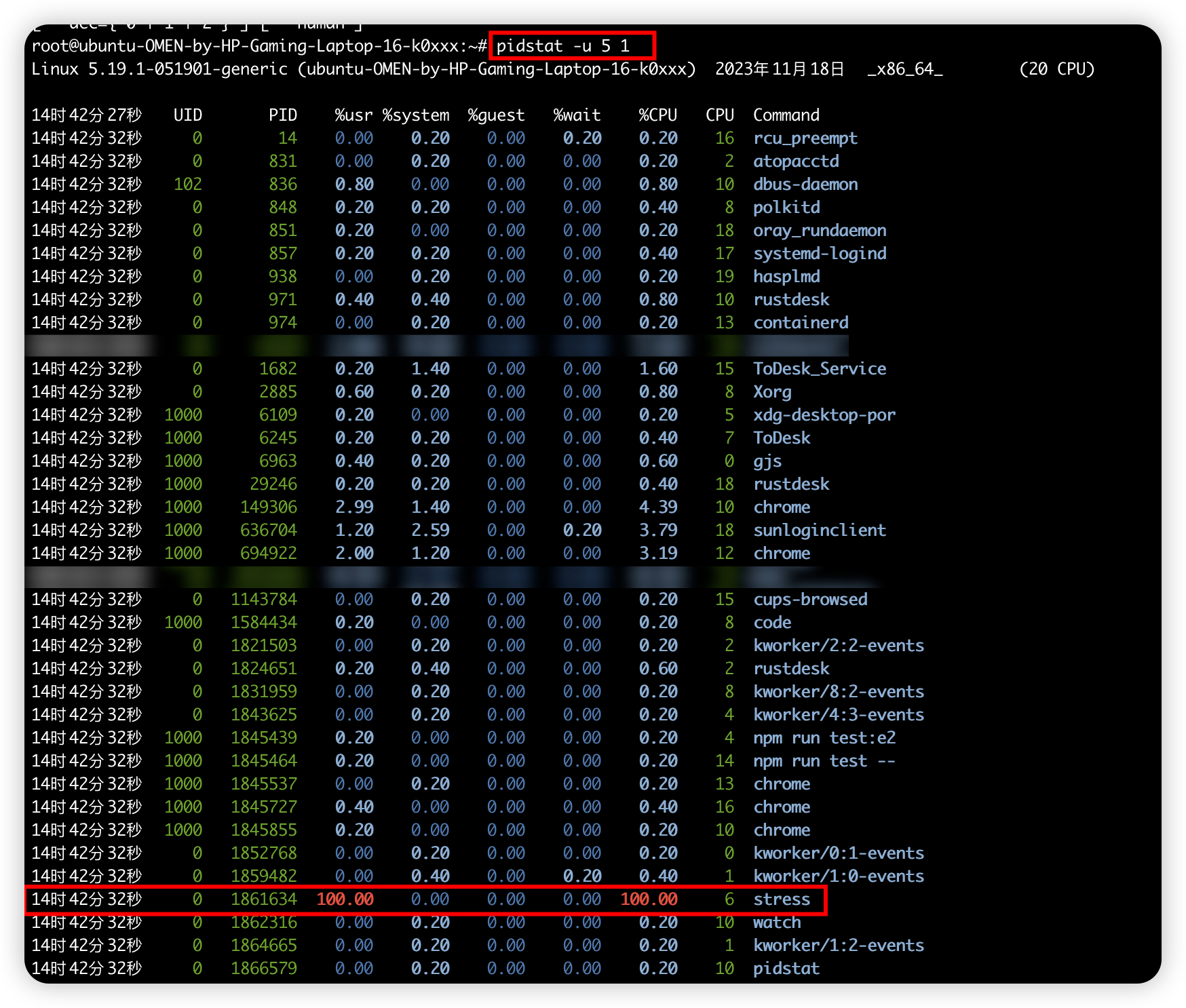

那么, 到底是哪个进程导致了 CPU 使用率为 100% 呢? 你可以用 pidstat 来查询:

$ pidstat -u 5 1 # 间隔 5 秒后输出一组数据

13:37:07 UID PID %usr %system %guest %wait %CPU CPU Command

13:37:12 0 2962 100.00 0.00 0.00 0.00 100.00 1 stress # %usr高

从这里可以明显看到, stress 进程的 CPU 使用率为 100%.

1.1.2.2 IO 密集型进程

# 首先还是运行 stress 命令, 但这次模拟 I/O 压力, 即不停地执行 sync

stress-ng -i 1 --hdd 1 --timeout 600 # --hdd表示读写临时文件, stress-ng 是下一代的stress, 支持更丰富的参数

# 在第二个终端运行 uptime 查看平均负载的变化情况:

watch -d uptime # load average: 1.06, 0.58, 0.37

# 第三个终端运行 mpstat 看 CPU 使用率的变化情况:

$ mpstat -P ALL 5 1 # 显示所有 CPU 的指标, 并在间隔 5 秒输出一组数据

Linux 4.15.0 (ubuntu) 09/22/18 _x86_64_ (2 CPU)

13:41:28 CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

13:41:33 all 0.21 0.00 12.07 32.67 0.00 0.21 0.00 0.00 0.00 54.84

13:41:33 0 0.43 0.00 23.87 67.53 0.00 0.43 0.00 0.00 0.00 7.74 # %sys高, %iowait高

13:41:33 1 0.00 0.00 0.81 0.20 0.00 0.00 0.00 0.00 0.00 98.99

从这里可以看到, 1 分钟的平均负载会慢慢增加到 1.06, 其中一个 CPU 的【系统CPU使用率】升高到了 23.87, 而 iowait 高达 67.53%. 这说明平均负载的升高是由于 iowait 的升高.

那么到底是哪个进程, 导致 iowait 这么高呢?还是用 pidstat 查询:

$ pidstat -u 5 1 # 间隔5秒后输出1次数据, -u 表示 CPU 指标

Linux 4.15.0 (ubuntu) 09/22/18 _x86_64_ (2 CPU)

13:42:08 UID PID %usr %system %guest %wait %CPU CPU Command

13:42:13 0 104 0.00 3.39 0.00 0.00 3.39 1 kworker/1:1H

13:42:13 0 109 0.00 0.40 0.00 0.00 0.40 0 kworker/0:1H

13:42:13 0 2997 2.00 35.53 0.00 3.99 37.52 1 stress # %system高, %wait有, %CPU高

13:42:13 0 3057 0.00 0.40 0.00 0.00 0.40 0 pidstat

可以发现, 还是 stress 进程导致的.

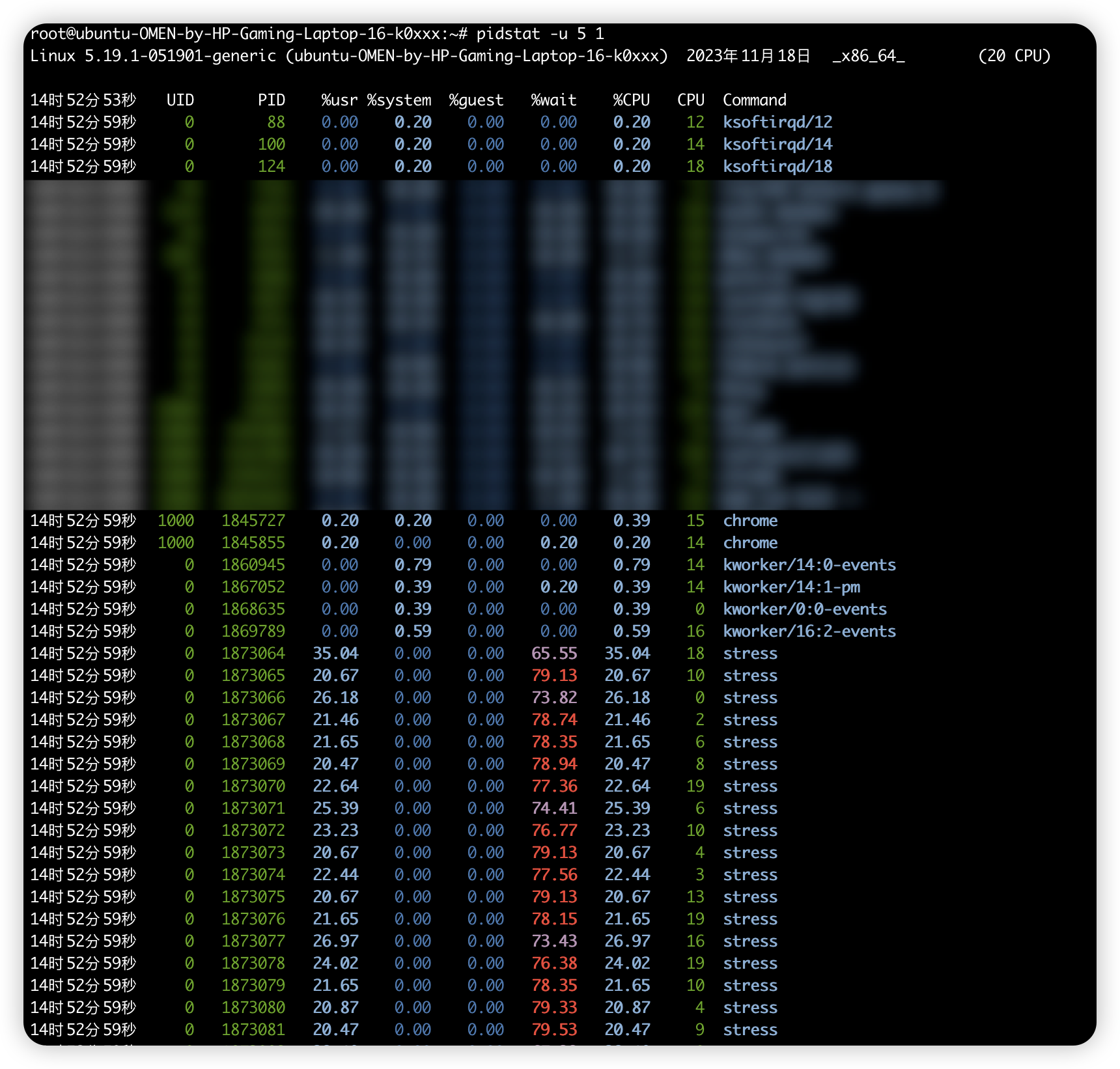

1.1.2.3 大量进程

当系统中运行进程超出 CPU 运行能力时, 就会出现等待 CPU 的进程.

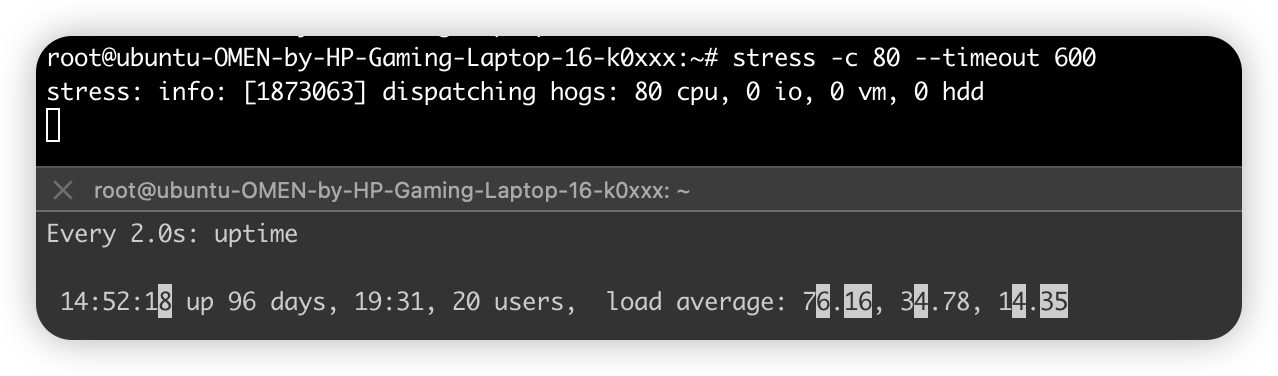

# 比如, 我们还是使用 stress, 但这次模拟的是 80 个进程:

stress -c 80 --timeout 600

# 由于系统只有 2 个 CPU, 明显比 8 个进程要少得多, 因而, 系统的 CPU 处于严重过载状态, 平均负载高达 7.97

uptime # 17.97, 5.93, 3.021

$ pidstat -u 5 1 # 间隔 5 秒后输出一组数据

14:23:25 UID PID %usr %system %guest %wait %CPU CPU Command

14:23:30 0 3190 25.00 0.00 0.00 74.80 25.00 0 stress # %wait高

14:23:30 0 3191 25.00 0.00 0.00 75.20 25.00 0 stress # %wait高

14:23:30 0 3192 25.00 0.00 0.00 74.80 25.00 1 stress # %wait高

14:23:30 0 3193 25.00 0.00 0.00 75.00 25.00 1 stress # %wait高

14:23:30 0 3194 24.80 0.00 0.00 74.60 24.80 0 stress # %wait高

14:23:30 0 3195 24.80 0.00 0.00 75.00 24.80 0 stress # %wait高

14:23:30 0 3196 24.80 0.00 0.00 74.60 24.80 1 stress # %wait高

14:23:30 0 3197 24.80 0.00 0.00 74.80 24.80 1 stress # %wait高

14:23:30 0 3200 0.00 0.20 0.00 0.20 0.20 0 pidstat

可以看出, 8 个进程在争抢 2 个 CPU, 每个进程等待 CPU 的时间(也就是代码块中的 %wait 列)高达 75%. 这些超出 CPU 计算能力的进程, 最终导致 CPU 过载.

1.1.3 htop、atop

htop看负载, 因为它更直接(在F2配置中勾选所有开关项, 打开颜色区分功能), 不同的负载会用不同的颜色标识. 比如cpu密集型的应用, 它的负载颜色是绿色偏高, iowait的操作, 它的负载颜色是红色偏高等等, 根据这些指标再用htop的sort就很容易定位到有问题的进程.

atop命令, 好像是基于sar的统计生成的报告, 直接就把有问题的进程标红了, 更直观

1.2 CPU 上下文切换

Linux 是多任务 os, 支持远大于 CPU 数量的任务同时运行. 其实这些任务并不是真的同时运行, 而是因为os在短时间内将 CPU 轮流分配给他们, 造成多任务同时运行的错觉.

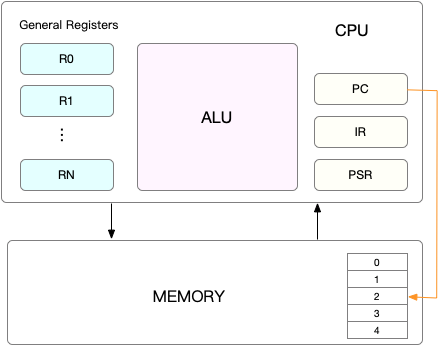

每个任务运行前, CPU 需知道【当前正在执行或待执行的指令】(来自程序计数器 Program Counter, PC), 和【数据】(来自CPU 的寄存器), 这二者都是任务依赖的环境, 也被称作【CPU 上下文】.

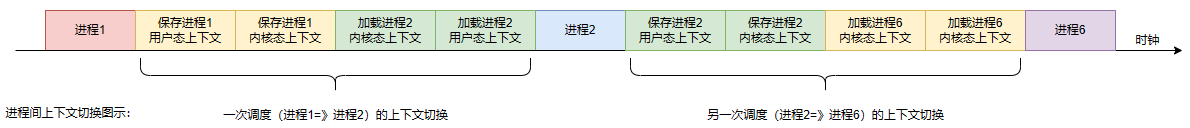

CPU 的上下文切换:先保存【前一个任务的 CPU 上下文】, 再加载【新任务的 CPU 上下文】并跳转到【新任务 PC 程序计数器】所指向的新位置运行新任务, 如下图:

而 CPU 的任务有如下三种:进程、线程、中断.

CPU 上下文切换的影响:

- 其是保证 Linux 系统正常工作的核心功能之一, 一般情况下不需要我们特别关注.

- 但过多的上下文切换, 会把 CPU 时间消耗在寄存器、内核栈以及虚拟内存等数据的保存和恢复上, 从而缩短进程真正运行的时间, 导致系统的整体性能大幅下降.

1.2.1 进程上下文切换

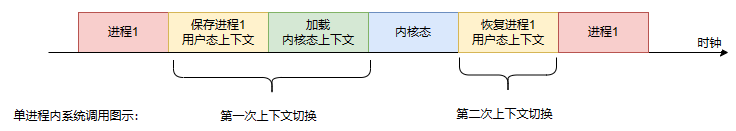

分为【进程内系统调用的特权模式切换】和【进程间的CPU上下文切换】两种

1.2.1.1 进程内系统调用:特权模式切换

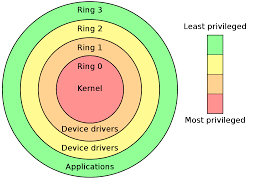

Linux 划分了Ring 0、1、2、3四种特权等级(可理解为四种状态枚举, 每种状态有自己的约束), 其中 Ring1、2很少使用:

- 内核空间为 Ring0, 有最高权限, 可直接访问全部资源.

- 用户空间为 Ring3, 只能访问受限资源, 而不能直接访问内存等硬件设备. 其必须通过【系统调用】陷入到内核中才能访问这些受限资源.

即进程即可在用户空间执行(用户态)、也可在内核空间执行(内核态), 需通过【系统调用】才能从用户态到内核态. 例如查看文件时, 需调用 open() 打开文件、read() 读文件、write() 写文件、close() 关闭文件等系统调用.

而【系统调用】时发生两次【特权模式切换】(而不称为CPU 上下文切换:因为始终在一个进程内部(不会切换进程), 也不涉及虚拟内存等进程用户态的资源), 如下图:

- 第一次:CPU 将【原来用户态的指令位置】保存到寄存器里, 加载【待执行的内核态的指令位置】到寄存器, 并跳转到内核态执行内核任务.

- 第二次:CPU 【恢复】【原来用户态的指令位置】, 切换到用户空间继续运行进程.

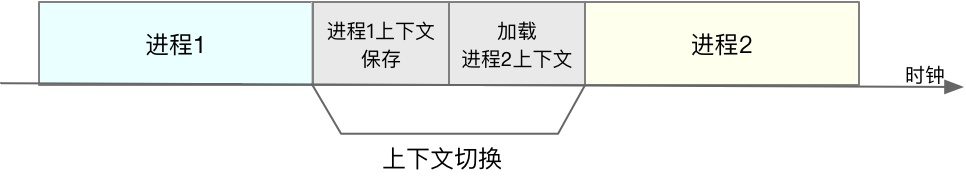

1.2.1.2 进程间:CPU上下文切换

因为进程是内核管理调度的, 所以进程间切换只能发生在【内核态】. 所以进程间的上下文, 不仅包括虚拟内存、栈、全局变量等【用户空间的状态】, 还包括内核堆栈、寄存器等【内核空间的状态】.

因此【进程间上下文切换】就比【系统调用】时多了一步:需要先保存【当前进程用户态的:虚拟内存、栈、全局变量】、再保存【当前进程的内核态的:CPU 寄存器】、再加载了下一进程的【内核态的:CPU寄存器】、再加载下一进程的【用户态的:虚拟内存、栈、全局变量】. 如下图:

CPU 上下文切换有潜在的性能问题:

- 每次上下文切换都需要几十纳秒到数微秒的 CPU 时间, 当切换次数较多时很容易导致 CPU 将大量时间耗费在寄存器、内核栈以及虚拟内存等资源的保存和恢复上, 进而大大缩短了真正运行进程的时间.

- 另外 Linux 通过 TLB(Translation Lookaside Buffer)来管理虚拟内存到物理内存的映射关系. 当虚拟内存更新后, TLB 也需要刷新, 内存的访问也会随之变慢. 特别是在多处理器系统上, 缓存是被多个处理器共享的, 刷新缓存不仅会影响当前处理器的进程, 还会影响共享缓存的其他处理器的进程.

CPU 上下文切换的时机:当且仅当进程切换时才需要切换 CPU 上下文. Linux 为每个 CPU 都维护了一个就绪队列, 将活跃进程(即正在运行和正在等待 CPU 的进程) 按照优先级和等待 CPU 的时间 排序, 然后选最需要 CPU 的进程(即优先级最高和等待 CPU 时间最长的进程)来运行.

进程在什么时候才会被调度到 CPU 上运行呢?

- 最容易想到的一个时机, 就是进程执行完终止了, 它之前使用的 CPU 会释放出来, 这个时候再从就绪队列里, 拿一个新的进程过来运行.

- 但其实还有很多其他场景, 也会触发进程调度:

- 其一, 为了保证所有进程可以得到公平调度, CPU 时间被划分为一段段的时间片, 这些时间片再被轮流分配给各个进程. 这样, 当某个进程的时间片耗尽了, 就会被系统挂起, 切换到其它正在等待 CPU 的进程运行.

- 其二, 进程在系统资源不足(比如内存不足)时, 要等到资源满足后才可以运行, 这个时候进程也会被挂起, 并由系统调度其他进程运行.

- 其三, 当进程通过睡眠函数 sleep 这样的方法将自己主动挂起时, 自然也会重新调度.

- 其四, 当有优先级更高的进程运行时, 为了保证高优先级进程的运行, 当前进程会被挂起, 由高优先级进程来运行.

- 最后, 发生硬件中断时, CPU 上的进程会被中断挂起, 转而执行内核中的中断服务程序.

1.2.2 线程上下文切换

线程是调度的基本单位, 而进程则是资源拥有的基本单位.

即内核中的任务调度, 实际上的调度对象是线程;而进程只是给线程提供了虚拟内存、全局变量等资源. 所以可以这么理解:

- 当进程只有一个线程时, 可以认为进程就等于线程.

- 当进程拥有多个线程时, 这些线程会共享相同的虚拟内存和全局变量等资源. 这些资源在上下文切换时是不需要修改的.

- 另外, 线程也有自己的私有数据, 比如栈和寄存器等, 这些在上下文切换时也是需要保存的.

所以线程的上下文切换其实就可以分为两种情况:

- 第一种, 前后两个线程属于不同进程:因为资源不共享, 所以切换过程就跟进程上下文切换是一样.

- 第二种, 前后两个线程属于同一个进程:因为虚拟内存是共享的, 所以在切换时, 虚拟内存这些资源就保持不动, 只需要切换线程的私有数据、寄存器等不共享的数据.

因此虽然同为上下文切换, 但同进程内的线程切换, 要比多进程间的切换消耗更少的资源, 而这也正是多线程代替多进程的一个优势.

1.2.3 中断上下文切换

为了快速响应硬件的事件, 中断处理会打断进程的正常调度和执行, 转而调用中断处理程序, 响应设备事件. 而在打断其他进程时, 就需要将进程当前的状态保存下来, 这样在中断结束后, 进程仍然可以从原来的状态恢复运行.

跟进程上下文不同, 中断上下文切换并不涉及到进程的用户态. 所以即便中断过程打断了一个正处在用户态的进程, 也不需要保存和恢复这个进程的虚拟内存、全局变量等用户态资源. 所以中断上下文, 其实只包括内核态中断服务程序执行所必需的状态, 包括 CPU 寄存器、内核堆栈、硬件中断参数等.

对同一个 CPU 来说, 中断处理比进程拥有更高的优先级, 所以中断上下文切换并不会与进程上下文切换同时发生. 同样道理, 由于中断会打断正常进程的调度和执行, 所以大部分中断处理程序都短小精悍, 以便尽可能快的执行结束.

另外, 跟进程上下文切换一样, 中断上下文切换也需要消耗 CPU, 切换次数过多也会耗费大量的 CPU, 甚至严重降低系统的整体性能. 所以, 当你发现中断次数过多时, 就需要注意去排查它是否会给你的系统带来严重的性能问题.

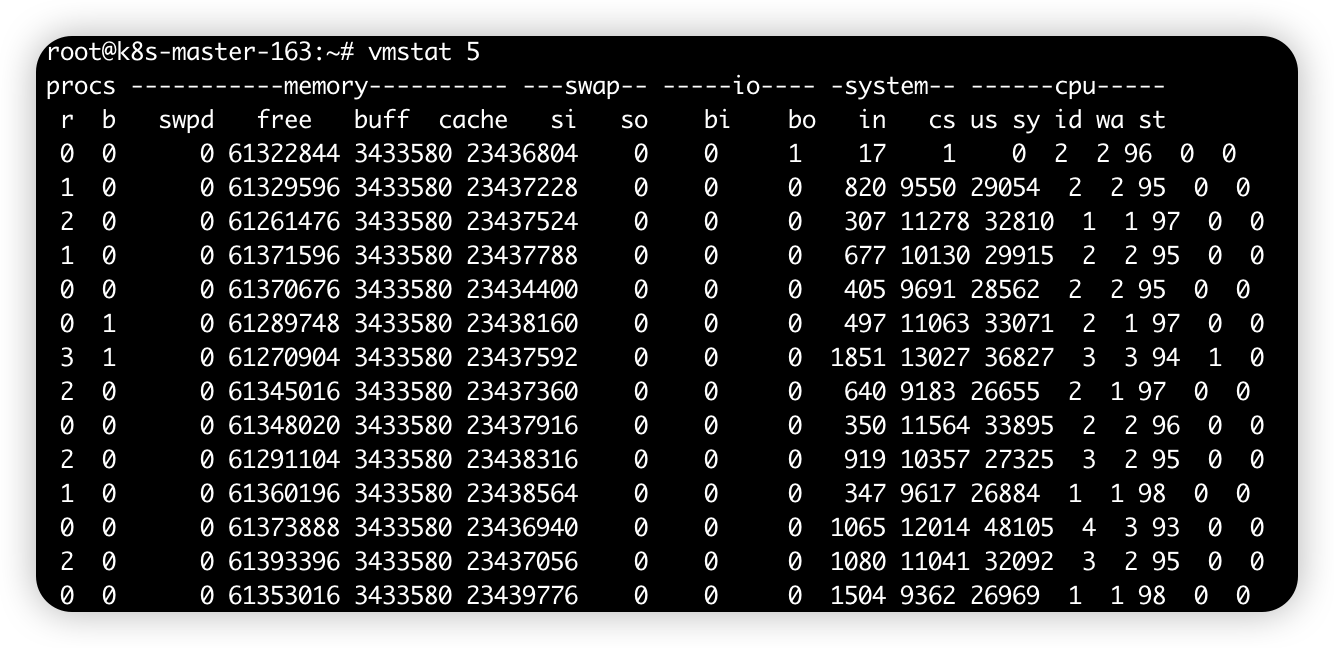

1.2.4 vmstat 查看上下文切换情况

vmstat 是一个常用的系统性能分析工具, 主要用来分析系统的内存使用情况, 也常用来分析 CPU 上下文切换和中断的次数.

# 每隔 5 秒输出 1 组数据

$ vmstat 5

procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st

0 0 0 7005360 91564 818900 0 0 0 0 25 33 0 0 100 0 0

cs(context switch)是每秒上下文切换的次数.

in(interrupt)则是每秒中断的次数.

r(Running or Runnable)是就绪队列的长度, 也就是正在运行和等待 CPU 的进程数.

b(Blocked)则是处于不可中断睡眠状态的进程数.

可以看到, 这个例子中的上下文切换次数 cs 是 33 次, 而系统中断次数 in 则是 25 次, 而就绪队列长度 r 和不可中断状态进程数 b 都是 0.

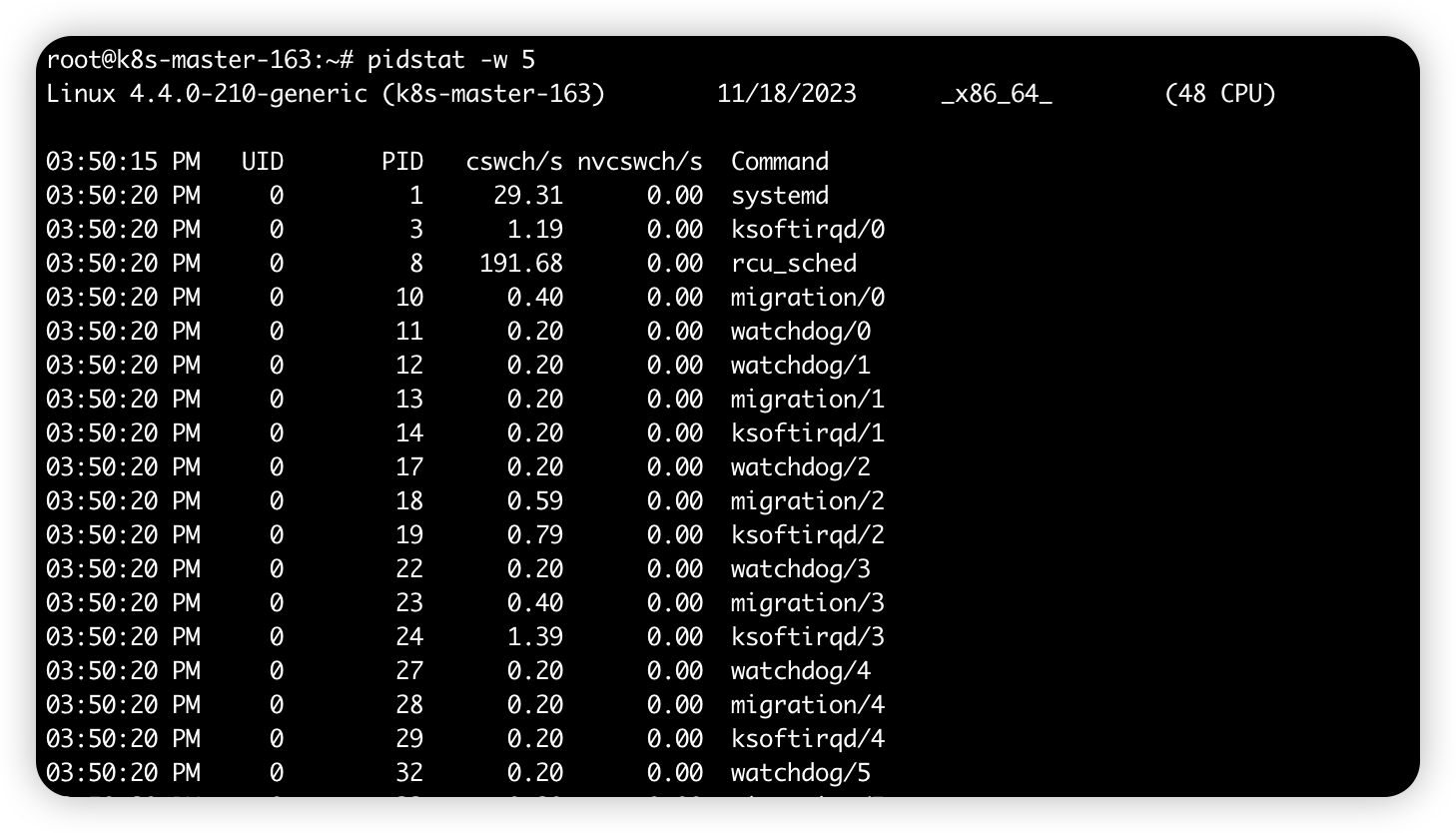

vmstat 只给出了系统总体的上下文切换情况, 要想查看每个进程的详细情况, 就需 pidstat -w 可以查看每个进程上下文切换情况.

- cswch , 表示每秒自愿上下文切换(voluntary context switches)的次数. 是指进程无法获取所需资源, 导致的上下文切换. 如 I/O、内存等系统资源不足时, 就会发生自愿上下文切换.

- nvcswch , 表示每秒非自愿上下文切换(non voluntary context switches)的次数. 则是指进程由于时间片已到等原因, 被系统强制调度, 进而发生的上下文切换. 如大量进程都在争抢 CPU 时, 就容易发生非自愿上下文切换.

# 每隔 5 秒输出 1 组数据

$ pidstat -w 5

Linux 4.15.0 (ubuntu) 09/23/18 _x86_64_ (2 CPU)

08:18:26 UID PID cswch/s nvcswch/s Command

08:18:31 0 1 0.20 0.00 systemd

08:18:31 0 8 5.40 0.00 rcu_sched

...

1.2.4.1 案例:sysbench 模拟多线程调度切换

知道了怎么查看这些指标, 另一个问题又来了, 上下文切换频率是多少次才算正常呢? 别急着要答案, 同样的, 我们先来看一个上下文切换的案例. 通过案例实战演练, 你自己就可以分析并找出这个标准了.

sysbench 是一个多线程的基准测试工具, 一般用来评估不同系统参数下的数据库负载情况. 当然, 在这次案例中, 我们只把它当成一个异常进程来看, 作用是模拟上下文切换过多的问题.

下面的案例基于 Ubuntu 18.04, 当然, 其他的 Linux 系统同样适用. 我使用的案例环境如下所示:

- 机器配置:2 CPU, 8GB 内存

- 预装 sysbench 和 sysstat 包, 如 apt install sysbench sysstat

- 正式操作开始前, 你需要打开三个终端, 登录到同一台 Linux 机器中

# 首先观察空闲系统的上下文切换次数, 间隔 1 秒后输出 1 组数据, column -t 使输出表格对齐方便阅读

$ vmstat 1 | column -t

procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st

0 0 0 6984064 92668 830896 0 0 2 19 19 35 1 0 99 0 0 # r低, in低, cs低, us低, sy低

# 然后以 10 个线程运行 5 分钟的基准测试, 模拟多线程切换的问题

$ sysbench --threads=10 --max-time=300 threads run

# 接着, 在第二个终端运行 vmstat , 观察上下文切换情况:

# 每隔 1 秒输出 1 组数据(需要 Ctrl+C 才结束)

$ vmstat 1 | column -t

procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st

6 0 0 6487428 118240 1292772 0 0 0 0 9019 1398830 16 84 0 0 0 # r高, in高, cs高, us高, sy高

8 0 0 6487428 118240 1292772 0 0 0 0 10191 1392312 16 84 0 0 0

可以发现, cs 列的上下文切换次数从之前的 35 骤然上升到了 139 万. 同时注意观察其他几个指标:

r 列:就绪队列的长度已经到了 8, 远远超过了系统 CPU 的个数 2, 所以肯定会有大量的 CPU 竞争.

us(user)和 sy(system)列:这两列的 CPU 使用率加起来上升到了 100%, 其中系统 CPU 使用率(sy 列)高达 84%, 说明 CPU 主要被内核占用了.

in 列:中断次数也上升到了 1 万左右, 说明中断处理也是个潜在的问题.

综合这几个指标可知, 系统的就绪队列r(即正在运行和等待 CPU 的进程数过多)太多, 导致了大量的上下文切换(cs), 而上下文切换又导致了系统 CPU 的占用率(uptime)升高.

那么到底是什么进程导致了这些问题呢? 继续分析, 在第三个终端 pidstat 看一下, CPU 和进程上下文切换的情况:

$ pidstat -w -u 1 # 每隔 1 秒输出 1 组数据, -w 参数表示输出进程切换指标, -u 参数表示输出 CPU 使用指标

08:06:33 UID PID %usr %system %guest %wait %CPU CPU Command

08:06:34 0 10488 30.00 100.00 0.00 0.00 100.00 0 sysbench # %CPU高(来自%system)

08:06:34 0 26326 0.00 1.00 0.00 0.00 1.00 0 kworker/u4:2

08:06:33 UID PID cswch/s nvcswch/s Command

08:06:34 0 8 11.00 0.00 rcu_sched

08:06:34 0 16 1.00 0.00 ksoftirqd/1

08:06:34 0 471 1.00 0.00 hv_balloon

08:06:34 0 1230 1.00 0.00 iscsid

08:06:34 0 4089 1.00 0.00 kworker/1:5

08:06:34 0 4333 1.00 0.00 kworker/0:3

08:06:34 0 10499 1.00 224.00 pidstat # nvcswch/s高

08:06:34 0 26326 236.00 0.00 kworker/u4:2 # cswch/s高

08:06:34 1000 26784 223.00 0.00 sshd # cswch/s高

从 pidstat 的输出可发现:

- CPU 使用率的升高(已达 100%)果然是由 sysbench 导致的

- 但上下文切换则是来自其他进程

- 包括非自愿上下文切换频率最高的 pidstat

- 以及自愿上下文切换频率最高的内核线程 kworker 和 sshd

不过细心的你肯定也发现了一个怪异的事儿:pidstat 输出的上下文切换次数, 加起来也就几百(1+224), 比 vmstat 的 139w 明显小了太多. 因为上文只显示了进程, 而未显示线程. 其实 pidstat -t 即可显示【线程】的指标, 如下:

$ pidstat -wt 1 # 每隔 1 秒输出一组数据, -wt 参数表示输出线程的上下文切换指标

08:14:05 UID TGID TID cswch/s nvcswch/s Command

...

08:14:05 0 10551 - 6.00 0.00 sysbench

08:14:05 0 - 10551 6.00 0.00 |__sysbench

08:14:05 0 - 10552 18911.00 103740.00 |__sysbench

08:14:05 0 - 10553 18915.00 100955.00 |__sysbench

08:14:05 0 - 10554 18827.00 103954.00 |__sysbench

...

现在你就能看到了, 虽然 sysbench 进程(也就是主线程)的上下文切换次数看起来并不多, 但它的子线程的上下文切换次数却有很多. 看来上下文切换的罪魁祸首还是过多的 sysbench 线程. 即共10个sysbench线程, 每个上下文切换次数大致为(cswch/s + nvcswch/s = 12w个), 所以共120w个, 大致和上文vmstat的cs列的上下文切换次数139w吻合(因为还未计入其他占用不高的进程)

我们已经找到了上下文切换次数增多的根源, 那是不是到这儿就可以结束了呢?

当然不是, 前面观察系统指标时, 除了上下文切换频率骤然升高, 还有一个中断次数(vmstat的in列)指标也上升到了 1 万, 但到底是什么类型的中断上升了, 仍需按如下方法排查:

既然是中断, 我们都知道, 它只发生在内核态, 而 pidstat 只是一个进程的性能分析工具, 并不提供任何关于中断的详细信息, 怎样才能知道中断发生的类型呢?

没错, 那就是从 /proc/interrupts 这个只读文件中读取. /proc 实际上是 Linux 的一个虚拟文件系统, 用于内核空间与用户空间之间的通信. /proc/interrupts 就是这种通信机制的一部分, 提供了一个只读的中断使用情况.

还是在第三个终端里, 运行下面的命令, 观察中断的变化情况:

$ watch -d 'cat /proc/interrupts | grep RES' # -d 参数表示高亮显示变化的区域

CPU0 CPU1

...

RES: 2450431 5279697 Rescheduling interrupts

...

观察一段时间可发现, 变化速度最快的是重调度中断(RES), 此中断类型表示唤醒空闲状态的 CPU 来调度新的任务运行.

这是多处理器系统(SMP)中, 调度器用来分散任务到不同 CPU 的机制, 也常被称为处理器间中断(Inter-Processor Interrupts, IPI)

所以这里的中断升高, 还是因为过多任务的调度问题, 跟前面上下文切换次数的分析结果是一致的.

1.2.4.2 总结:上下文切换的观测方法

每秒上下文切换多少次才算正常呢?这个数值其实取决于系统本身的 CPU 性能:

- 通常如果系统的上下文切换次数比较稳定, 那么从数百到一万以内, 都应该算是正常的.

- 但当上下文切换次数超过一万次, 或者切换次数出现数量级的增长时, 就很可能已经出现了性能问题.

这时还需要根据上下文切换的类型, 再做具体分析. 比方说:

- 自愿上下文切换变多了, 说明进程都在等待资源, 有可能发生了 I/O 等其他问题;

- 非自愿上下文切换变多了, 说明进程都在被强制调度, 也就是都在争抢 CPU, 说明 CPU 的确成了瓶颈;

- 中断次数变多了, 说明 CPU 被中断处理程序占用, 还需要通过查看 /proc/interrupts 文件来分析具体的中断类型.

常用套路:

-

首先 uptime 看系统负载

-

然后 mpstat -P ALL 3 看每个cpu当前的整体状况,可以重点看用户态、内核态、以及io等待三个参数

-

pidstat 初步判断到底是 cpu 计算量大、还是进程争抢过大、或 io 过多

-

vmstat 1:分析内存使用情况、cpu上下文切换和中断的次数。(cs每秒上下文切换的次数,in每秒中断的次数,r运行或等待cpu的进程数,b中断睡眠状态的进程数。)来进一步判断到底是 io 过多导致问题、还是进程争抢激烈导致问题

- pidstat -w(进程切换指标)/-u(cpu使用指标)/-wt(线程上下文切换指标) 看具体情况

- cswch(每秒自愿)上下文切换次数,如 IO 等系统资源不足导致

- nvcswch每秒非自愿上下文切换次数,如cpu时间片用完或高优先级线程

- pidstat -w(进程切换指标)/-u(cpu使用指标)/-wt(线程上下文切换指标) 看具体情况