简介

论文

引入了一个通用框架,用于在假设标量量化的情况下对非线性变换代码的率失真性能进行端到端优化。

传统图像压缩往往经过可逆变换、量化、熵编码、反转变换实现近似的重构图像。其中熵编码是无损编码(如哈夫曼、算术编码等),量化的目的是为产生熵编码可处理离散信号。

传统方法往往对各个部分分别优化,本文在图像压缩领域提出一个端到端优化的框架。

介绍

传统的变换编码都是线性的,而且整体流程比较繁琐,通常针对不同的目标单独研究和优化操作,然后必须根据平均码率和失真对任何建议的编码工具组合进行经验验证。近年来端到端的这一个架构的优点体现了出来,可以针对整个系统进行联合优化。

基于端到端优化,作者开发了一个非线性变换编码优化框架,它概括了传统的变换编码范例。

分析变换 y = ga(x; φ)将图像向量x转化到编码域(隐层变量),将y量化得到 。之后经过合成变换返回到信号域得到重构图像

。之后经过合成变换返回到信号域得到重构图像 ,其中分析变换和合成变换都是可微分的。

,其中分析变换和合成变换都是可微分的。

编码率(rate)通过离散概率分布 的熵来评估(熵代表信息量的大小,直观来看,经过量化之后的离散分布要经过熵编码,概率越大的熵编码长度越短,反之越长,因此熵

的熵来评估(熵代表信息量的大小,直观来看,经过量化之后的离散分布要经过熵编码,概率越大的熵编码长度越短,反之越长,因此熵 可以衡量平均编码长度)

可以衡量平均编码长度)

失真(distortion)通过x和 间的MSE或者PSNR来衡量。本论文提出使用感知变换

间的MSE或者PSNR来衡量。本论文提出使用感知变换 将信号域变换到感知域,提供比PSNR更好的主观视觉失真近似。

将信号域变换到感知域,提供比PSNR更好的主观视觉失真近似。

优化框架

在上面给出的变换编码框架中,需要寻求调整,分析和合成变换 ga 和 gs 以最小化率失真函数:

第一项表示量化指标向量q的离散熵,第二项测量在感知表示中参考图像z与其重建图像z之间的失真。

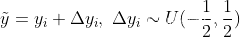

目标可优化(反向传播)依赖于框架中操作的可微性,其中量化操作不可微,它的导数处处为0或者无穷大。使用在训练的时候将量化替换为加均匀噪声、推理的时候使用round量化的方法解决这个问题。

标量量化器为:

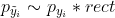

边缘分布如下:

边缘分布如下:

其中 为狄拉克函数(积分为1,在0处无限高,其他处为0)。

为狄拉克函数(积分为1,在0处无限高,其他处为0)。 是第n个量化区间的概率(量化区间

是第n个量化区间的概率(量化区间 曲线包围的面积),*代表卷积,rect是在

曲线包围的面积),*代表卷积,rect是在 上的均匀分布。

上的均匀分布。

给 添加均匀噪声

添加均匀噪声 满足

满足 ,

, 和

和 在整数位置上相同,并且提供了连续的中间值 :

在整数位置上相同,并且提供了连续的中间值 :

使用优化可微分的熵 替代离散熵

替代离散熵 。为了优化这一项,还需要有对

。为了优化这一项,还需要有对 的估计,这个估计不需要任意精确,因为

的估计,这个估计不需要任意精确,因为 被与rect的卷积所限制(band-limited),这里使用无参数、分段线性函数(一阶样条插值)作为熵模型估计

被与rect的卷积所限制(band-limited),这里使用无参数、分段线性函数(一阶样条插值)作为熵模型估计 。总体优化目标如下:

。总体优化目标如下:

参数变换的选择

传统压缩中分析变换和合成变换是线性的而且互逆,通常来说,这一点并不需要严格满足,只要能够最小化率失真函数就行。

分析变换与合成变换分别使用泛化分裂归一化GDN和它的近似逆IGDN,对于感知变换,使用归一化的拉普拉斯金字塔NLP。

A. GDN描述如下:

其中H代表线性变换(该工作中貌似使用全连接,之后的工作使用卷积层作为线性分解)。分析变换模型参数

B. 基于一轮定点迭代的方法得到IGDN,描述如下:

模型参数:

(之后在端到端图像压缩中一般将GDN当做非线性组件来用,其中线性变换H用卷积层代替)

C. NLP描述如下(之后的工作中少有人用):

使用拉普拉斯金字塔分解图像,该金字塔减去多个尺度下平均亮度的局部估计。然后将每个金字塔系数除以局部幅度估计(常数加上邻居绝对值的加权总和)。通过评估此感知域中参考和重建之间差异的范数来评估感知质量。参数(用于幅度的常数和权重)经过优化,以最适合 TID2008 数据库中的感知数据,其中包括因块变换压缩产生的伪影而损坏的图像。这种简单的失真测量提供了近线性适合数据库中的人类感知判断,优于广泛使用的 SSIM 和 MS-SSIM质量指标。

实验结果

考虑使用16×16的DCT、线性变换(θ和Φ各自包含256×256个滤波器系数)、16×16的GDN变换进行比较。分别针对MSE和NLP域范数优化,评价使用PSNR与NLP两种指标。在下面的图像中,对于端到端模型,曲线每一个点,对应一个模型,不同模型需要通过调整λ获得。实验结果如下图:

参考hahalidaxin