文章目录

- 一、检测相关(13篇)

-

- 1.1 Localization-Guided Track: A Deep Association Multi-Object Tracking Framework Based on Localization Confidence of Detections

- 1.2 Drawing the Same Bounding Box Twice? Coping Noisy Annotations in Object Detection with Repeated Labels

- 1.3 Moving Object Detection and Tracking with 4D Radar Point Cloud

- 1.4 Mutual Information-calibrated Conformal Feature Fusion for Uncertainty-Aware Multimodal 3D Object Detection at the Edge

- 1.5 RIDE: Self-Supervised Learning of Rotation-Equivariant Keypoint Detection and Invariant Description for Endoscopy

- 1.6 Object2Scene: Putting Objects in Context for Open-Vocabulary 3D Detection

- 1.7 Chasing Day and Night: Towards Robust and Efficient All-Day Object Detection Guided by an Event Camera

- 1.8 Detection and Localization of Firearm Carriers in Complex Scenes for Improved Safety Measures

- 1.9 Efficient Pyramid Channel Attention Network for Pathological Myopia Detection

- 1.10 Robust Backdoor Attacks on Object Detection in Real World

- 1.11 Semantics-aware LiDAR-Only Pseudo Point Cloud Generation for 3D Object Detection

- 1.12 Privacy-preserving Early Detection of Epileptic Seizures in Videos

- 1.13 Rethinking Cross-Domain Pedestrian Detection: A Background-Focused Distribution Alignment Framework for Instance-Free One-Stage Detectors

一、检测相关(13篇)

1.1 Localization-Guided Track: A Deep Association Multi-Object Tracking Framework Based on Localization Confidence of Detections

定位引导跟踪:一种基于检测定位置信度的深度关联多目标跟踪框架

https://arxiv.org/abs/2309.09765

在目前可用的文献中,没有基于检测跟踪(TBD)范式的跟踪方法考虑了检测框的定位置信度。在大多数基于TBD的方法中,认为低检测置信度的对象被高度遮挡,因此直接忽略这样的对象或降低它们的匹配优先级是正常的做法。此外,外观相似性不是匹配这些对象要考虑的因素。然而,在融合分类定位的检测置信度方面,低检测置信度的目标定位不准确,但外观清晰;类似地,高检测置信度的对象可能具有不准确的定位或不清晰的外观;然而这些物体没有被进一步分类。鉴于这些问题,我们提出了定位引导跟踪(LG-Track)。首先,首次将定位置信度应用于MOT中,综合考虑了检测框的外观清晰度和定位精度,设计了一种有效的深度关联机制;其次,基于分类置信度和定位置信度,选择和使用更合适的成本矩阵;最后,在MOT 17和MOT 20数据集上进行了大量的实验。结果表明,我们提出的方法优于比较国家的最先进的跟踪方法。为了社区的利益,我们的代码已在https://github.com/mengting2023/LG-Track公开发布。

1.2 Drawing the Same Bounding Box Twice? Coping Noisy Annotations in Object Detection with Repeated Labels

是否绘制相同的边界框两次?重复标签目标检测中的噪声应对

https://arxiv.org/abs/2309.09742

监督机器学习系统的可靠性取决于地面真相标签的准确性和可用性。然而,人类注释的过程,容易出错,引入噪声标签的可能性,这可能阻碍这些系统的实用性。虽然使用噪声标签进行训练是一个重要的考虑因素,但测试数据的可靠性对于确定结果的可靠性也至关重要。解决这个问题的常见方法是重复标记,其中多个注释器标记相同的示例,并且它们的标记被组合以提供真实标记的更好估计。在本文中,我们提出了一种新的定位算法,适应良好的地面实况估计方法的对象检测和实例分割任务。我们的方法的关键创新在于它的能力,将组合的定位和分类任务转化为分类的问题,从而使应用的技术,如期望最大化(EM)或多数投票(MJV)。虽然我们的主要关注点是测试数据的独特地面真相的聚合,我们的算法在TexBiG数据集的训练期间也表现出优异的性能,超过了噪声标签训练和使用加权框融合(WBF)的标签聚合。我们的实验表明,重复标签的好处出现在特定的数据集和注释配置。关键因素似乎是(1)数据集复杂性,(2)注释器一致性,以及(3)给定的注释预算约束。

1.3 Moving Object Detection and Tracking with 4D Radar Point Cloud

基于四维雷达点云的运动目标检测与跟踪

https://arxiv.org/abs/2309.09737

移动自主依赖于对动态环境的精确感知。因此,在3D世界中鲁棒地跟踪移动对象对于轨迹预测、避障和路径规划等应用起着关键作用。虽然大多数当前的方法利用LiDAR或相机进行多目标跟踪(MOT),但4D成像雷达的能力在很大程度上仍然未被探索。认识到4D雷达数据中雷达噪声和点稀疏性所带来的挑战,我们推出了RaTrack,这是一款专为基于雷达的跟踪量身定制的创新解决方案。绕过对特定对象类型和3D边界框的典型依赖,我们的方法侧重于运动分割和聚类,丰富的运动估计模块。在View of Delft数据集上进行评估,RaTrack展示了对移动对象的卓越跟踪精度,在很大程度上超过了最先进的性能。

1.4 Mutual Information-calibrated Conformal Feature Fusion for Uncertainty-Aware Multimodal 3D Object Detection at the Edge

基于互信息校正的边缘多模式三维目标检测的共形特征融合

https://arxiv.org/abs/2309.09593

在不断扩大的人工智能机器人领域,预测不确定性的鲁棒量化非常重要。三维(3D)对象检测,一个关键的机器人操作,已经看到了显著的进步;然而,目前的大多数工作只关注准确性而忽略了不确定性的量化。解决这一差距,我们的新研究整合了保形推理(CI)的原则与信息论措施,以执行轻量级的,蒙特卡罗无不确定性估计的多模态框架。通过在变分自动编码器(VAE)中的潜变量的多变量高斯乘积,融合来自RGB相机和LiDAR传感器数据的特征以提高预测精度。归一化互信息(NMI)被用作调制器,用于校准基于加权损失函数从CI导出的不确定性界限。我们的模拟结果表明,内在的预测不确定性和NMI之间的逆相关性在整个模型的训练。该框架在KITTI 3D对象检测基准中表现出与不具有不确定性的类似方法相比或更好的性能,使其适用于实时边缘机器人。

1.5 RIDE: Self-Supervised Learning of Rotation-Equivariant Keypoint Detection and Invariant Description for Endoscopy

RIDE:内窥镜旋转等变关键点检测与不变描述的自监督学习

https://arxiv.org/abs/2309.09563

与自然图像不同,在内窥镜检查中,没有关于直立相机取向的明确概念。因此,内窥镜视频通常包含大的旋转运动,这需要关键点检测和描述算法对这些条件具有鲁棒性。虽然大多数经典方法通过设计实现旋转等变检测和不变描述,但许多基于学习的方法只能在一定程度上学习鲁棒性。同时,基于学习的方法在适度旋转下的性能往往优于经典方法。为了解决这个缺点,在本文中,我们提出了RIDE,一种基于学习的旋转等变检测和不变描述方法。随着群体等变学习的最新进展,RIDE模型的旋转等变隐含在其架构。RIDE以自我监督的方式训练大量内窥镜图像,不需要手动标记训练数据。我们测试RIDE的上下文中的手术组织跟踪的SuPeR数据集,以及在相对姿态估计的SCARED数据集的一个重新设计的版本的上下文中。此外,我们进行明确的研究表明其鲁棒性大旋转。我们对最近的学习为基础的和经典的方法的比较表明,RIDE设置一个新的国家的最先进的性能匹配和相对姿态估计任务和分数有竞争力的手术组织跟踪。

1.6 Object2Scene: Putting Objects in Context for Open-Vocabulary 3D Detection

Object2Scene:将物体放在上下文中进行开放词汇的3D检测

https://arxiv.org/abs/2309.09456

基于点云的开放词汇3D对象检测旨在检测训练集中没有地面实况注释的3D类别。由于3D场景的有限数据和注释(带有类标签或文本描述的边界框),这是一项极具挑战性的工作。以前的方法利用大规模的丰富注释的图像数据集作为3D和类别语义之间的桥梁,但需要一个额外的2D图像和3D点之间的对齐过程,限制了3D检测器的开放词汇能力。而不是利用2D图像,我们提出Object 2Scene,第一种方法,利用大规模的大词汇量的3D对象数据集,以增加现有的3D场景数据集的开放词汇量的3D对象检测。Object 2Scene将来自不同来源的对象插入到3D场景中,以丰富3D场景数据集的词汇表,并为新插入的对象生成文本描述。我们进一步介绍了一个框架,统一的3D检测和视觉接地,命名为L3 Det,并提出了一个跨域类别级的对比学习方法,以减轻来自不同数据集的3D对象之间的领域差距。在现有的开放词汇表3D对象检测基准上进行的大量实验表明,Object 2Scene比现有方法具有更好的性能。我们进一步验证了Object 2Scene在一个新的基准测试OV-ScanNet-200上的有效性,通过举行所有罕见的类别作为新的类别在训练过程中没有看到。

1.7 Chasing Day and Night: Towards Robust and Efficient All-Day Object Detection Guided by an Event Camera

追逐白天和黑夜:由事件摄像机引导的健壮和高效的全天目标检测

https://arxiv.org/abs/2309.09297

在所有照明中检测物体的能力(即,传统的基于RGB的探测器在这种变化的光照条件下常常失效。因此,最近的工作利用新颖的事件相机来补充或引导RGB模态;然而,这些方法通常采用主要依赖于RGB模态的非对称网络结构,导致全天检测的鲁棒性有限。在本文中,我们提出了EOLO,一种新的对象检测框架,实现了强大的和高效的全天检测融合RGB和事件模态。我们的EOLO框架是建立在一个轻量级的尖峰神经网络(SNN)的基础上,以有效地利用事件的异步属性。在此基础上,我们首先引入了一个事件时间注意(ETA)模块来学习事件的高时间信息,同时保留关键的边缘信息。其次,由于不同的模态在不同的照明条件下表现出不同的重要性水平,我们提出了一种新的对称RGB事件融合(SREF)模块,以有效地融合RGB事件的功能,而不依赖于特定的模态,从而确保一个平衡和自适应的融合全天检测。此外,为了弥补全天训练和评估的成对RGB-Event数据集的缺乏,我们提出了一种基于随机光流的事件合成方法,该方法允许直接从单次曝光图像生成事件帧。我们进一步建立了两个新的数据集,E-MSCOCO和E-VOC的基础上流行的基准测试MSCOCO和PASCAL VOC。大量的实验表明,我们的EOLO优于最先进的检测器,例如,RENet,在所有照明条件下均大幅提高(+3.74%mAP50)。我们的代码和数据集可在https://vlislab22.github.io/EOLO/上获得

1.8 Detection and Localization of Firearm Carriers in Complex Scenes for Improved Safety Measures

用于改进安全措施的复杂场景中枪支载体的检测和定位

https://arxiv.org/abs/2309.09236

检测枪支并在图像或视频中准确定位携带枪支的个人在安全、监控和内容定制中至关重要。然而,由于枪支的杂乱和不同形状,该任务在复杂环境中提出了重大挑战。为了解决这个问题,我们提出了一种新的方法,利用人与枪支的互动信息,这提供了有价值的线索,定位枪支载体。我们的方法包括一个注意机制,通过关注相关领域,有效地区分人类和枪支与背景。此外,我们引入了一个显着性驱动的局部保留约束学习的基本功能,同时保留在输入图像中的前景信息。通过结合这些组件,我们的方法在新提出的数据集上取得了优异的结果。为了处理不同大小的输入,我们通过一个深度网络,利用自适应平均池化层,将具有注意力面具的配对人类枪支实例作为通道,以进行特征计算。我们广泛地评估我们的方法对现有的方法在人-物体交互检测,并取得显着的结果(AP= 77.8%)相比,基线方法(AP= 63.1%)。这证明了利用注意力机制和显著性驱动的局部保持准确的人-枪交互检测的有效性。我们的研究结果有助于推进安全和监视领域,在不同的场景中实现更高效的枪支定位和识别。

1.9 Efficient Pyramid Channel Attention Network for Pathological Myopia Detection

用于病理性近视检测的高效金字塔通道注意网络

https://arxiv.org/abs/2309.09196

病理性近视(PM)是世界范围内导致视力受损和失明的主要眼病。尽早检测PM的关键是检测全局和局部病变区域中的信息特征,例如眼底镶嵌、萎缩和黄斑病变。然而,应用经典的卷积神经网络(CNN)来有效地突出特征图中的全局和局部病变背景信息是相当具有挑战性的。为了解决这个问题,我们的目标是充分利用潜在的全球和局部病变信息与注意模块设计。在此基础上,我们提出了一个有效的金字塔通道注意力(EPCA)模块,动态地探索全球和局部病变背景信息的相对重要性的特征图。然后将EPCA模块与骨干网络相结合,构建EPCA-Net,用于眼底图像的PM自动检测。此外,我们通过从公开可用的数据集(例如,PALM数据集和ODIR数据集)。在三个数据集上进行了全面的实验,表明我们的EPCA-Net在检测PM方面优于最先进的方法。此外,最近的预训练和微调范式的动机,我们试图适应预训练的自然图像模型的PM检测冻结他们和处理EPCA模块和其他注意模块的适配器。结果表明,我们的方法与预训练和微调范式实现了有竞争力的性能,通过比较,与传统的微调方法的可调参数较少。

1.10 Robust Backdoor Attacks on Object Detection in Real World

现实世界中目标检测的强健后门攻击

https://arxiv.org/abs/2309.08953

深度学习模型被广泛部署在许多应用中,例如各种安全领域的对象检测。然而,这些模型很容易受到后门攻击。大多数后门攻击都集中在分类模型上,而对目标检测的研究较少。以往的研究主要集中在数字世界中的后门攻击,而忽视了现实世界中的后门攻击。特别是现实世界中后门攻击的效果很容易受到距离、光照等物理因素的影响。本文提出了一种可变尺寸后门触发器,以适应不同尺寸的攻击对象,克服了观察点与攻击对象之间距离的干扰。此外,我们提出了一种称为恶意对抗训练的后门训练,使后门对象检测器能够学习物理噪声触发的特征。实验结果表明,这种鲁棒后门攻击(RBA)可以提高现实世界中的攻击成功率。

1.11 Semantics-aware LiDAR-Only Pseudo Point Cloud Generation for 3D Object Detection

基于语义感知的基于激光雷达的三维目标检测伪点云生成

https://arxiv.org/abs/2309.08932

虽然LiDAR传感器由于提供精确的深度信息而对自主系统至关重要,但由于数据稀疏和不均匀,它们难以捕获精细的物体细节,特别是在一定距离处。最近的进展引入了伪LiDAR,即,合成密集点云,使用诸如相机的附加模态来增强3D对象检测。我们提出了一种新的激光雷达的框架,增加了原始扫描与密集的伪点云仅仅依靠激光雷达传感器和场景语义,省略了对相机的需要。我们的框架首先利用分割模型提取场景语义从原始点云,然后采用多模态域翻译器生成合成图像片段和深度线索,而无需真正的相机。这产生了富含语义信息的密集伪点云。我们还引入了一种新的语义引导投影方法,该方法通过只保留相关伪点来提高检测性能。我们将我们的框架应用于不同的高级3D对象检测方法,并报告了高达2.9%的性能提升。我们还在KITTI 3D物体检测数据集上获得了与其他最先进的仅使用LiDAR的探测器相比具有可比性的结果。

1.12 Privacy-preserving Early Detection of Epileptic Seizures in Videos

保护隐私的视频中癫痫发作的早期检测

https://arxiv.org/abs/2309.08794

在这项工作中,我们通过引入一种新的框架(SETR-PKD),可以实现隐私保护的早期检测视频中的癫痫发作,从而促进基于视频的癫痫发作分类的发展。具体来说,我们的框架有两个重要组成部分-(1)它建立在从癫痫发作的视频中提取的光流特征上,其在保护患者隐私的同时编码癫痫发作运动符号学;(2)它利用基于Transformer的渐进式知识蒸馏,其中知识从在视频样本的较长部分上训练的网络逐渐蒸馏到将在较短部分上操作的网络。因此,我们提出的框架解决了目前的方法的局限性,这些方法通过直接操作的RGB视频的癫痫发作以及阻碍癫痫发作的实时检测,通过利用完整的视频样本进行预测。我们的SETR-PKD框架可以以隐私保护的方式检测强直-阵挛性癫痫发作(TCS),准确率为83.9%,而它们只是进展到一半。我们的数据和代码可在https://github.com/DevD1092/seizure-detection获得

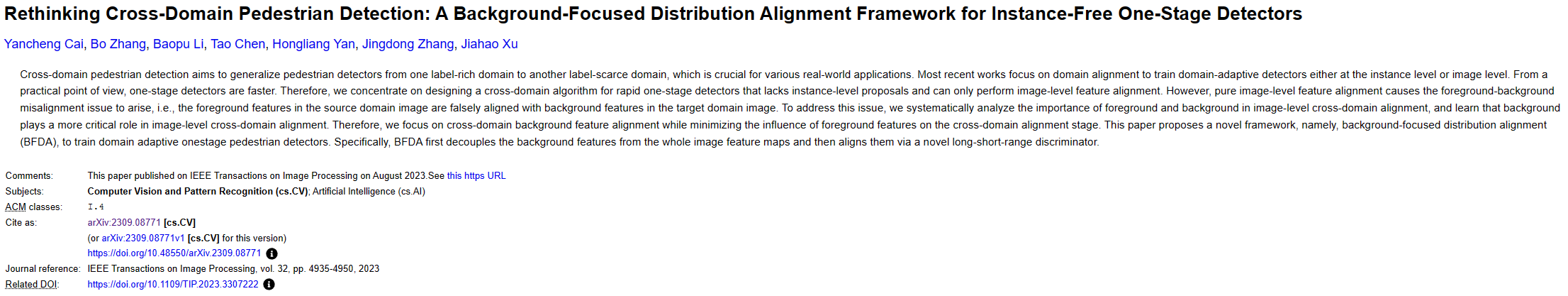

1.13 Rethinking Cross-Domain Pedestrian Detection: A Background-Focused Distribution Alignment Framework for Instance-Free One-Stage Detectors

对跨域行人检测的再思考:一种无实例一级检测器的背景聚焦分布对齐框架

https://arxiv.org/abs/2309.08771

跨域行人检测的目的是将行人检测器从一个标签丰富的域推广到另一个标签稀缺的域,这对于各种现实世界的应用至关重要。最近的工作集中在域对齐训练域自适应检测器无论是在实例级或图像级。从实用的角度来看,单级检测器更快。因此,我们专注于设计一个跨域算法的快速一阶段检测器,缺乏实例级的建议,只能执行图像级的功能对齐。然而,纯图像级特征对准导致出现前景-背景未对准问题,即,源域图像中的前景特征与目标域图像中的背景特征错误地对准。为了解决这个问题,我们系统地分析了前景和背景在图像级跨域对齐中的重要性,并了解到背景在图像级跨域对齐中起着更关键的作用。因此,我们专注于跨域背景特征对齐,同时最大限度地减少前景特征对跨域对齐阶段的影响。本文提出了一种新的框架,即背景聚焦分布对齐(BFDA),训练域自适应onstage行人检测器。具体地说,BFDA首先解耦的背景特征从整个图像的特征映射,然后通过一种新的长短距离鉴别器对齐它们。