文章目录

图像模型是为下游任务(例如分类和对象检测)构建图像表示的方法。 最流行的子类别是卷积神经网络。 您可以在下面找到不断更新的图像模型列表。

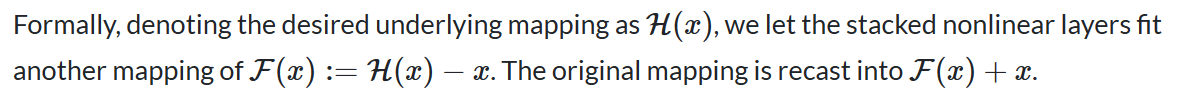

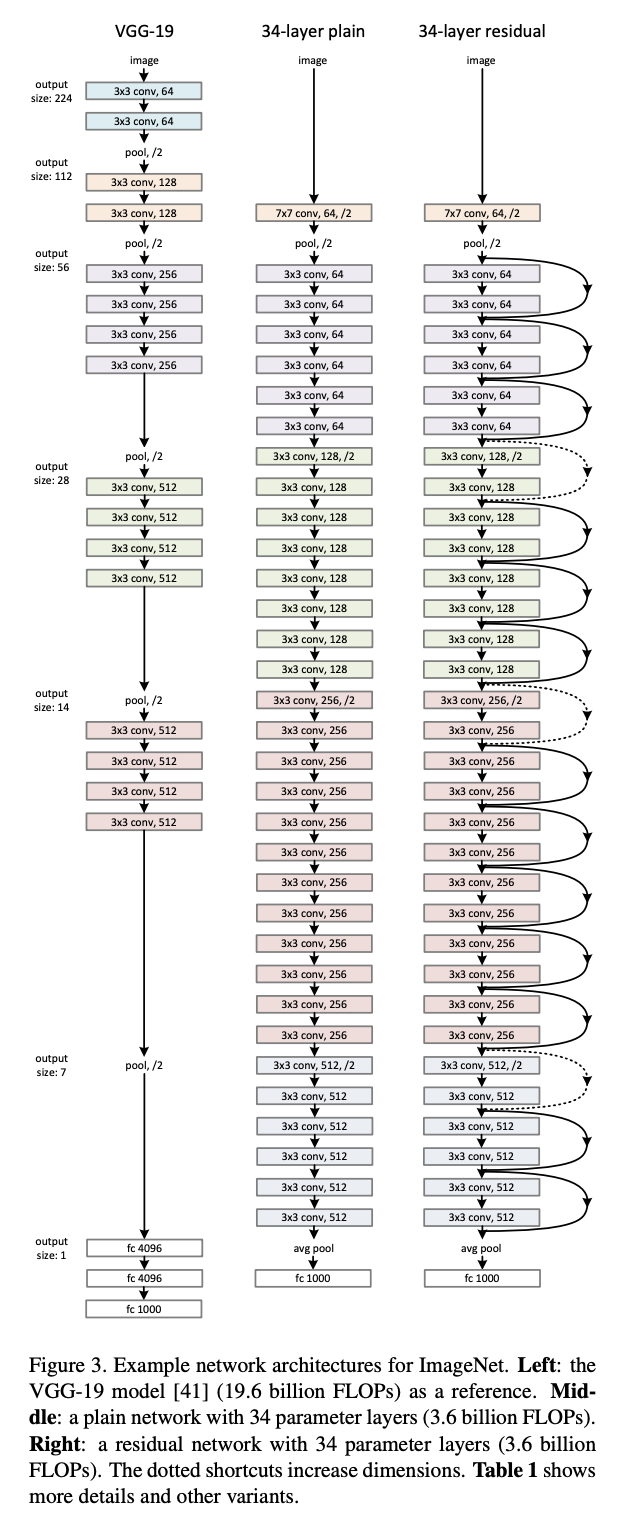

一、Residual Network

残差网络(ResNet)参考层输入来学习残差函数,而不是学习未引用的函数。 残差网络并不希望每几个堆叠层都直接适合所需的基础映射,而是让这些层适合残差映射。 它们将剩余块堆叠在一起形成网络:例如 ResNet-50 有 50 个使用这些块的层。

有经验证据表明,这些类型的网络更容易优化,并且可以通过显着增加的深度来获得准确性。

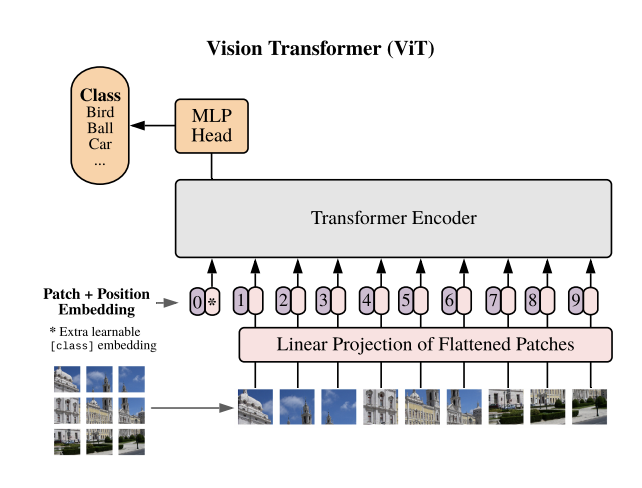

二、Vision Transformer

Vision Transformer(ViT)是一种图像分类模型,它在图像块上采用类似 Transformer 的架构。 将图像分割成固定大小的块,然后将每个块线性嵌入,添加位置嵌入,并将所得向量序列馈送到标准 Transformer 编码器。 为了执行分类,使用了向序列添加额外的可学习“分类标记”的标准方法。

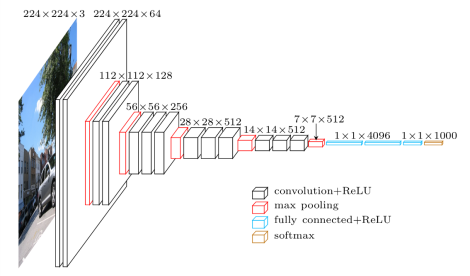

三、VGG

VGG是一种经典的卷积神经网络架构。 它基于对如何增加此类网络深度的分析。 该网络使用小型 3 x 3 滤波器。 除此之外,网络的特点是简单:唯一的其他组件是池化层和全连接层。

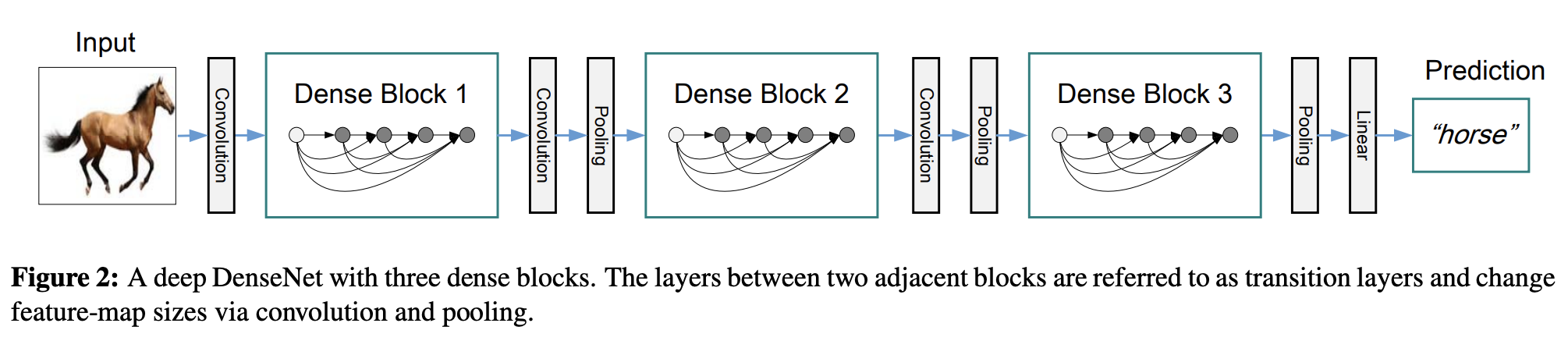

四、DenseNet

DenseNet 是一种卷积神经网络,它通过密集块利用层之间的密集连接,其中我们将所有层(具有匹配的特征图大小)直接相互连接。 为了保持前馈性质,每个层从所有前面的层获取额外的输入,并将其自己的特征图传递到所有后续层。

五、VGG-16

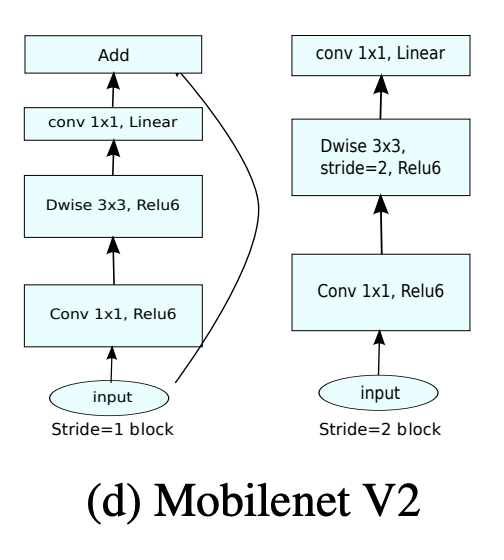

六、MobileNetV2

MobileNetV2 是一种卷积神经网络架构,旨在在移动设备上表现良好。 它基于反向残差结构,其中残差连接位于瓶颈层之间。 中间扩展层使用轻量级深度卷积来过滤作为非线性源的特征。 总体而言,MobileNetV2 的架构包含具有 32 个滤波器的初始全卷积层,后面是 19 个残余瓶颈层。

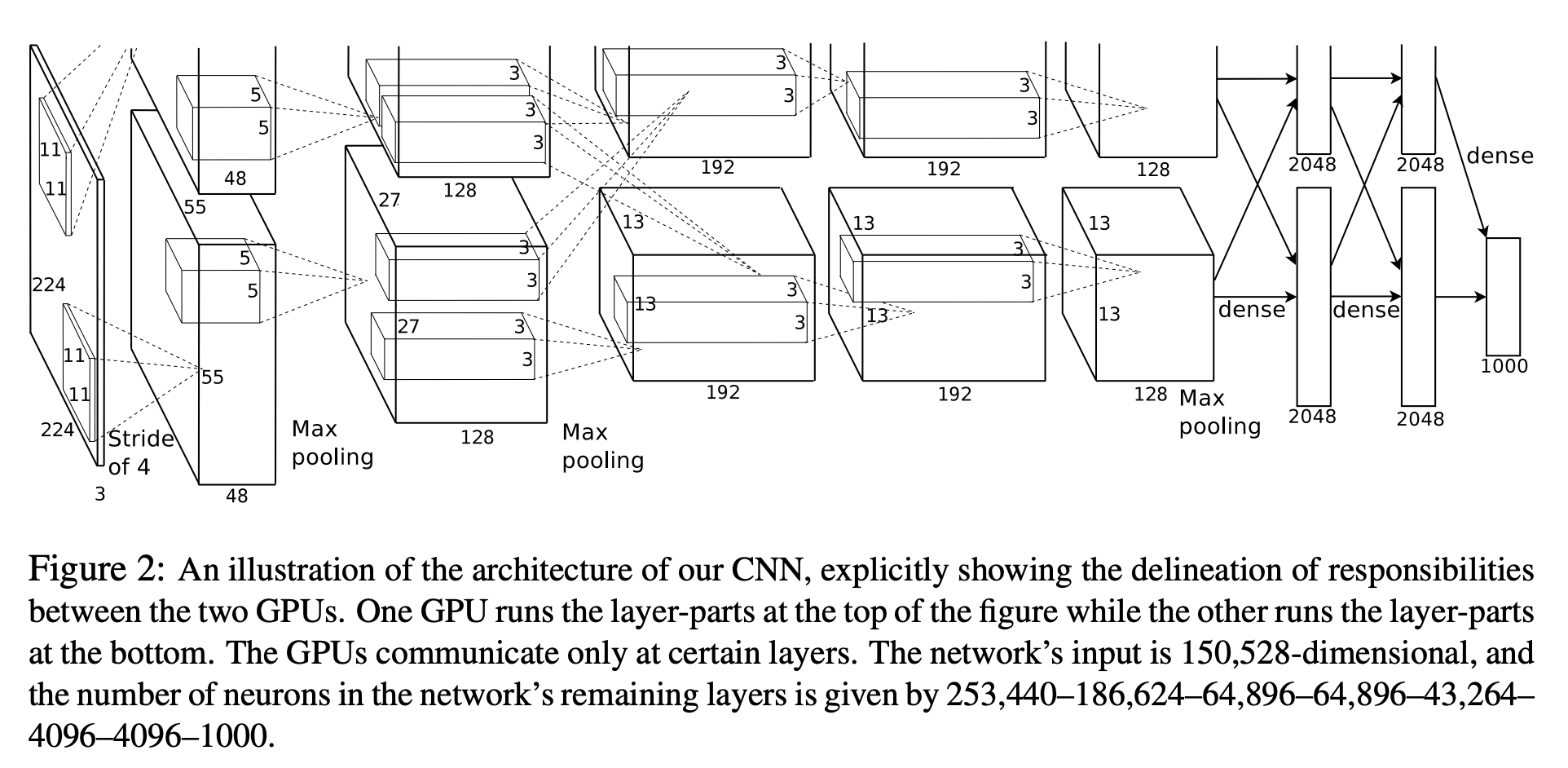

七、AlexNet

AlexNet 是一种经典的卷积神经网络架构。 它由卷积、最大池化和密集层作为基本构建块组成。 使用分组卷积来适应两个 GPU 上的模型。

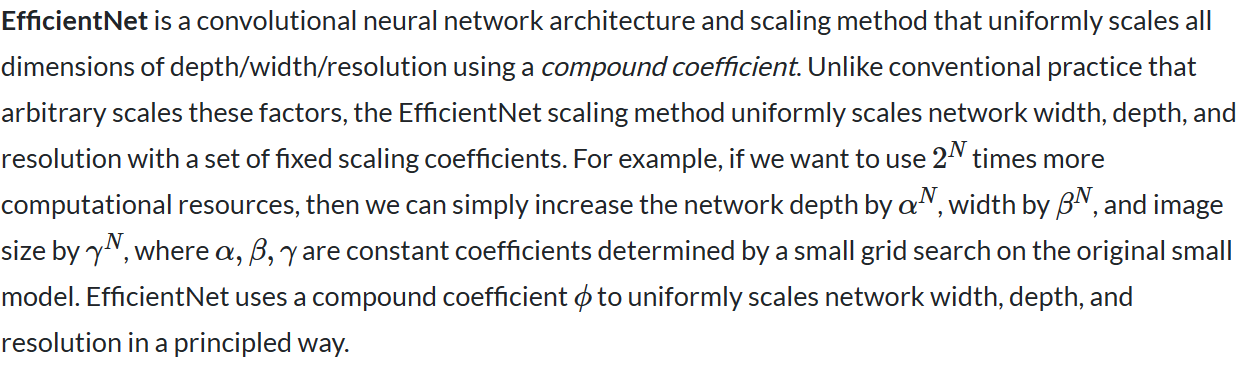

八、EfficientNet

复合缩放方法的直觉是,如果输入图像更大,那么网络需要更多层来增加感受野,并需要更多通道来捕获更大图像上更细粒度的模式。

除了挤压和激励块之外,基础 EfficientNet-B0 网络还基于 MobileNetV2 的反向瓶颈残差块。

EfficientNet 在 CIFAR-100 (91.7%)、Flowers (98.8%) 和其他 3 个迁移学习数据集上也能很好地迁移并达到最先进的准确率,参数数量少了一个数量级。

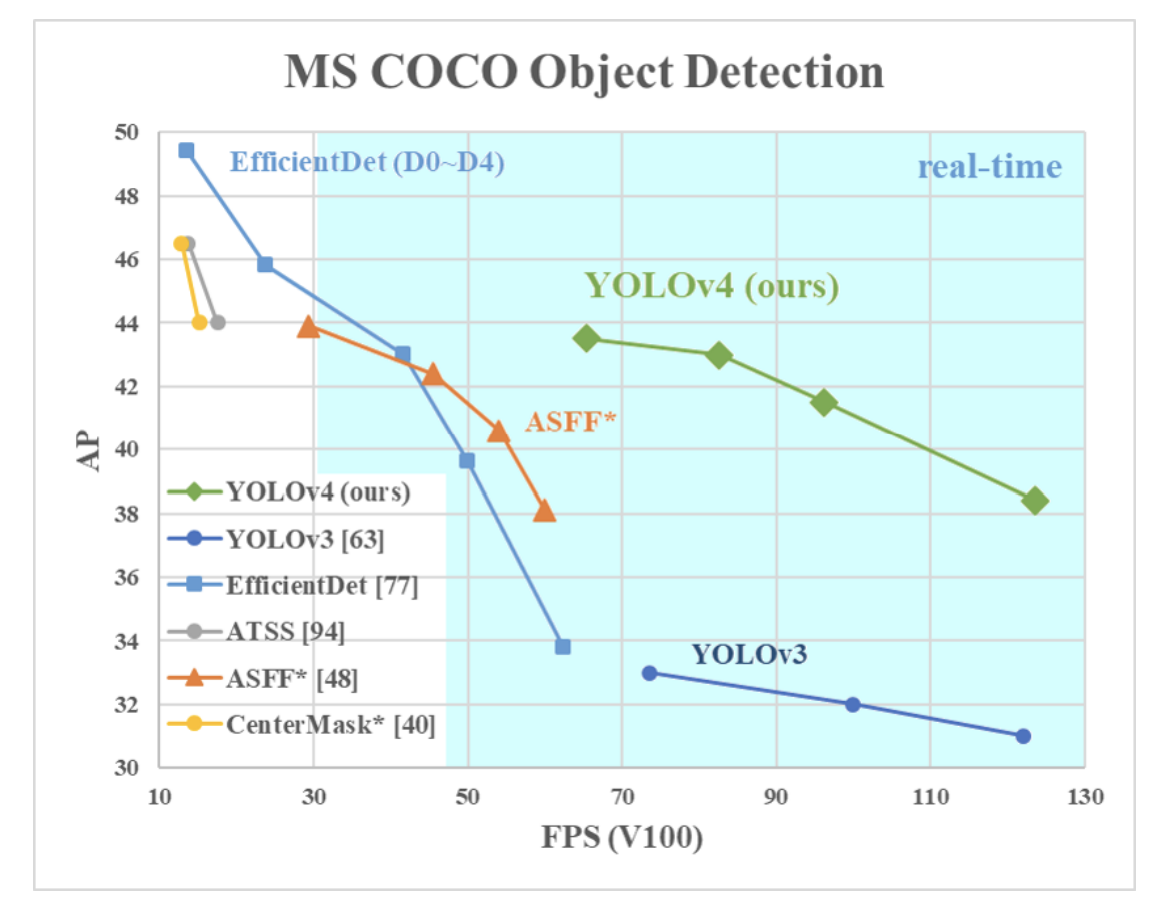

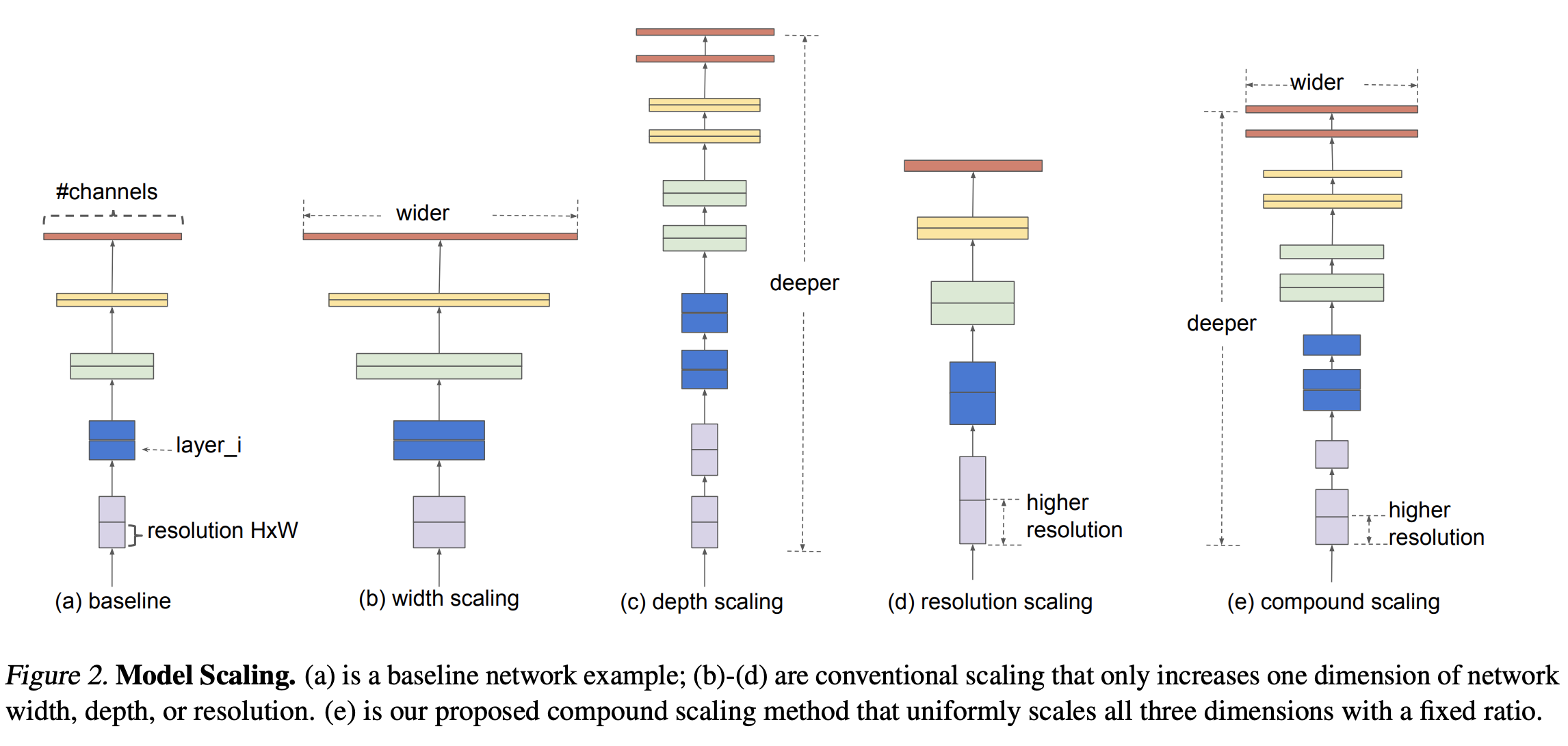

九、Darknet-53

Darknet-53 是一种卷积神经网络,充当 YOLOv3 对象检测方法的骨干网络。 对其前身 Darknet-19 的改进包括使用残差连接以及更多层。

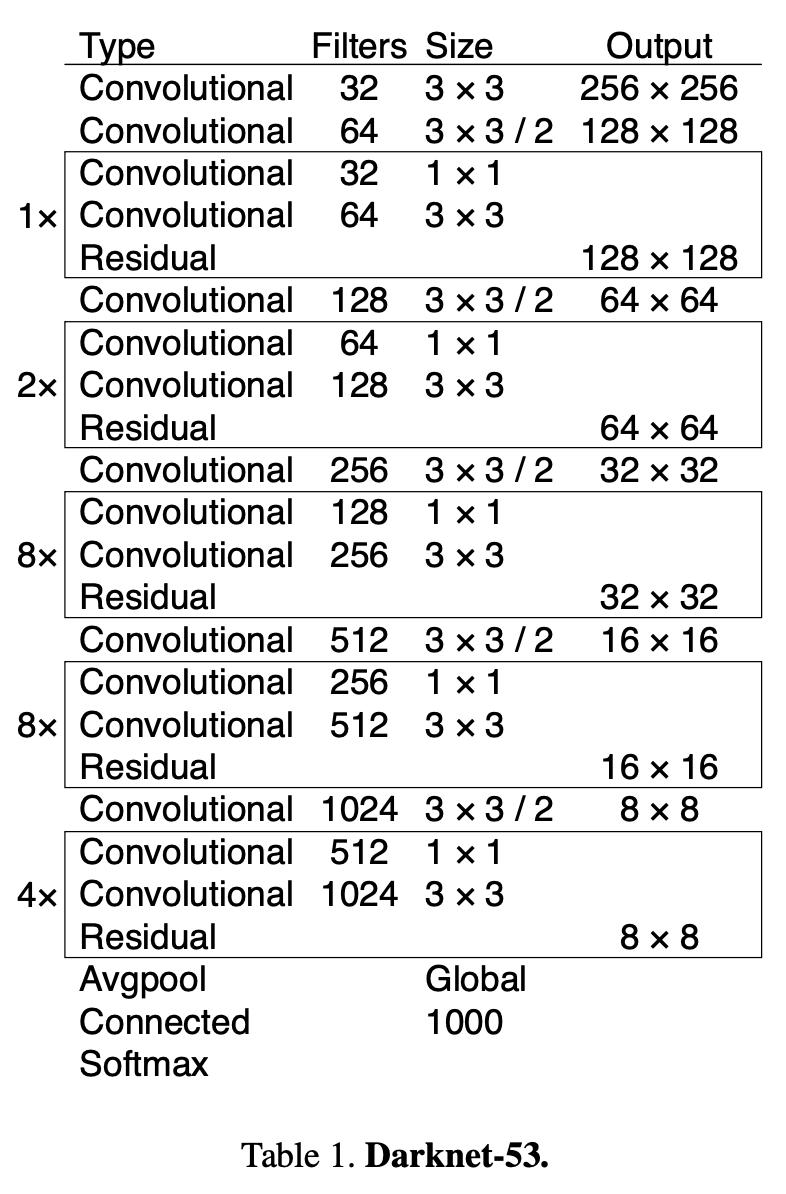

十、Swin Transformer

Swin Transformer 是视觉变压器的一种。 它通过合并更深层中的图像块(以灰色显示)来构建分层特征图,并且由于仅在每个局部窗口(以红色显示)内计算自注意力,因此具有输入图像大小的线性计算复杂性。 因此,它可以作为图像分类和密集识别任务的通用主干。 相比之下,以前的视觉 Transformer 会生成单个低分辨率的特征图,并且由于全局自注意力的计算,输入图像大小的计算复杂度是二次方的。

十一、Xception

Xception 是一种卷积神经网络架构,仅依赖于深度可分离的卷积层。

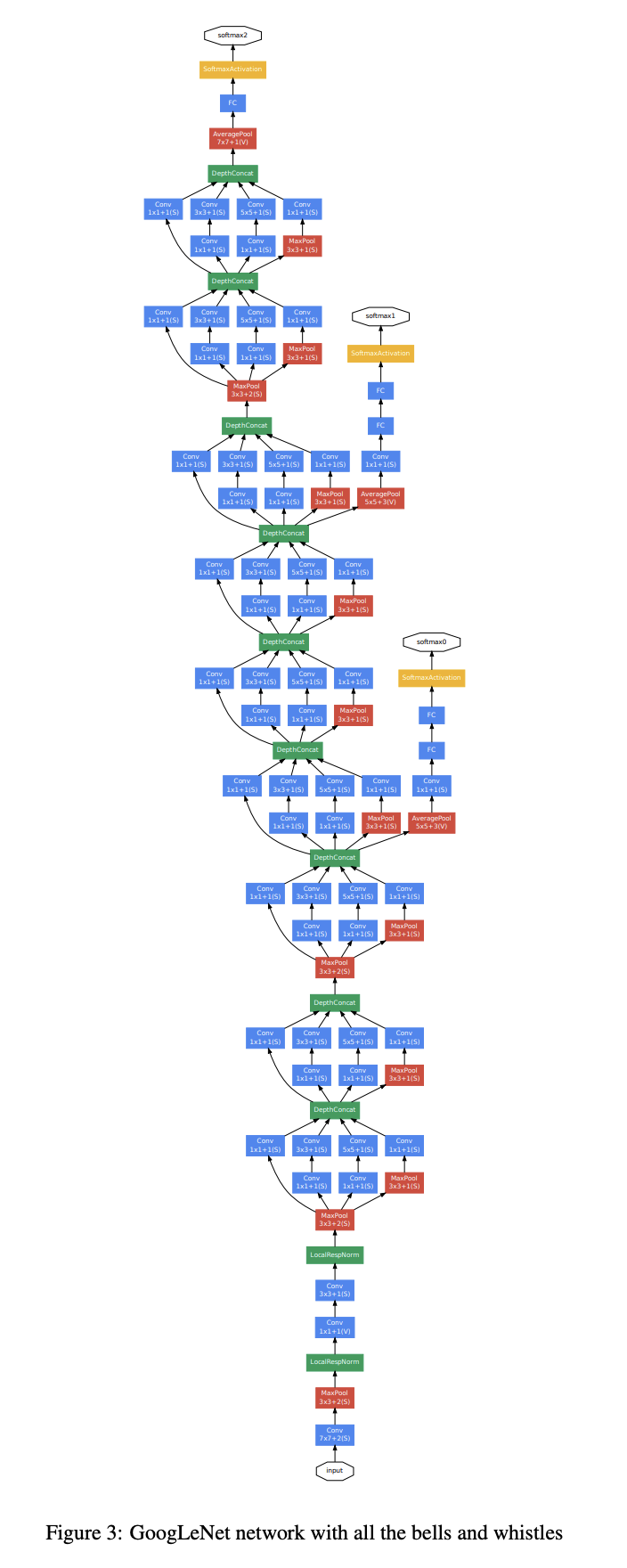

十二、GoogLeNet

GoogLeNet 是一种基于 Inception 架构的卷积神经网络。 它利用 Inception 模块,允许网络在每个块中的多个卷积滤波器大小之间进行选择。 Inception 网络将这些模块堆叠在一起,偶尔使用步长为 2 的最大池化层,将网格的分辨率减半。

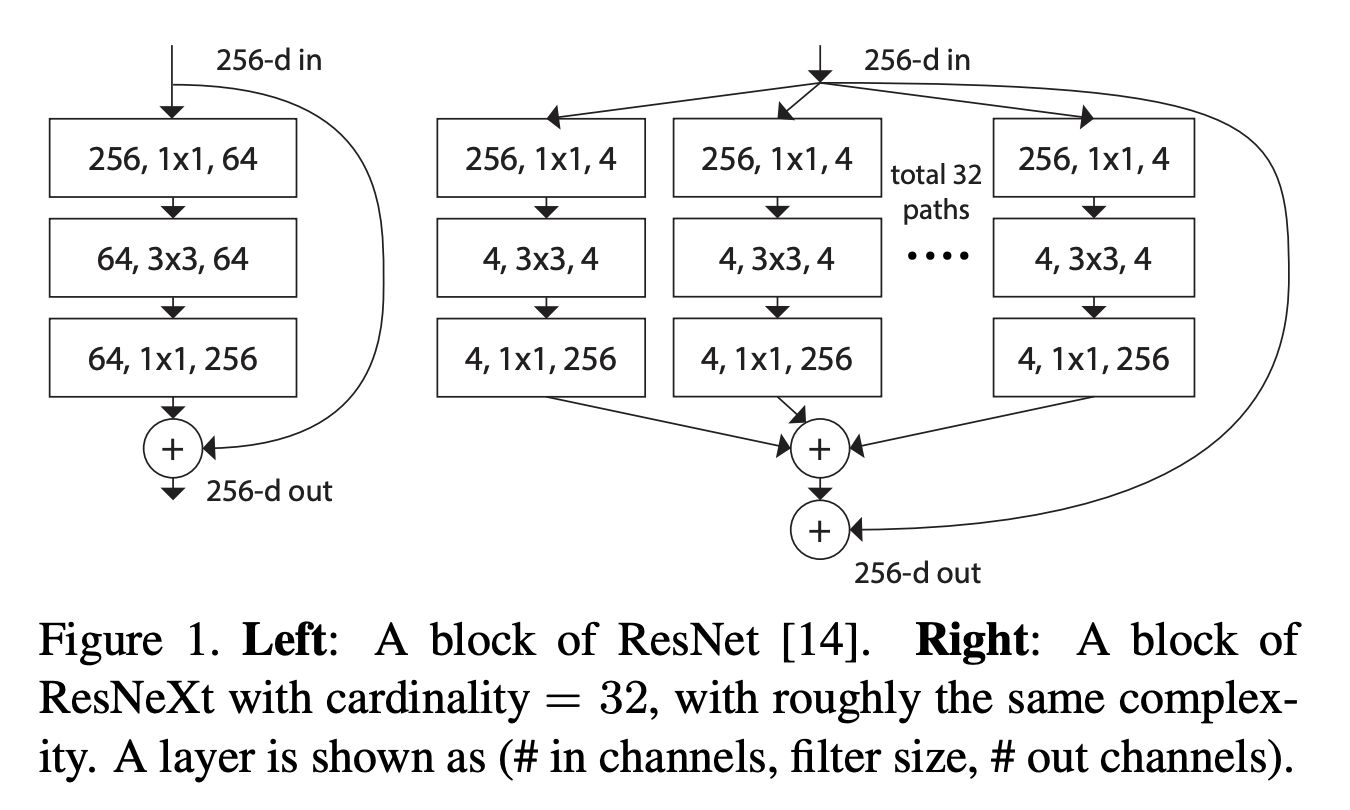

十三、ResNeXt

ResNeXt 重复一个构建块,该构建块聚合了一组具有相同拓扑的转换。 与 ResNet 相比,它暴露了一个新的维度:基数(变换集的大小)C,作为除深度和宽度尺寸之外的重要因素。

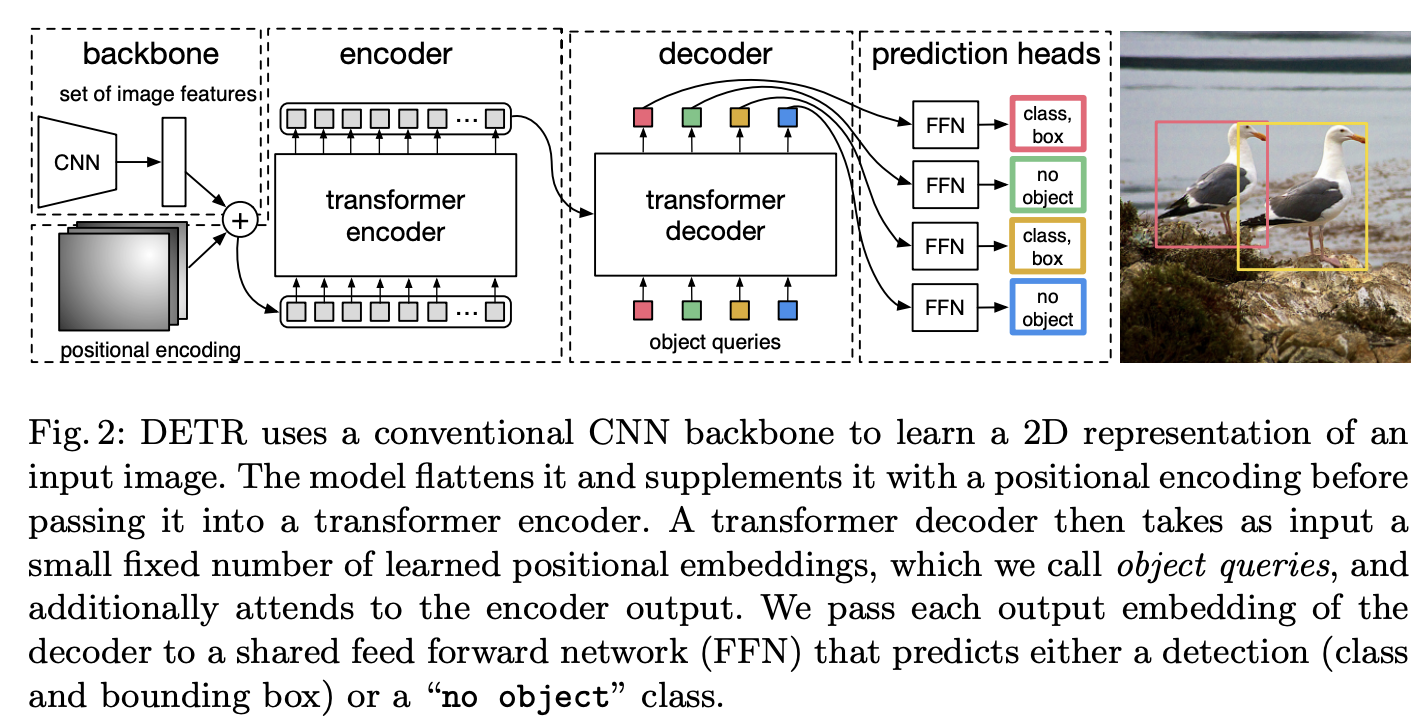

十四、Detection Transformer

Detr(即检测变压器)是一种基于集合的目标检测器,在卷积主干之上使用变压器。 它使用传统的 CNN 主干来学习输入图像的 2D 表示。 该模型将其展平并用位置编码对其进行补充,然后将其传递到变压器编码器。 然后,变压器解码器将少量固定数量的学习位置嵌入(我们称之为对象查询)作为输入,并另外关注编码器输出。 我们将解码器的每个输出嵌入传递到共享前馈网络(FFN),该网络预测检测(类和边界框)或“无对象”类。

十五、CSPDarknet53

CSPDarknet53 是一种卷积神经网络和使用 DarkNet-53 进行对象检测的主干网络。 它采用 CSPNet 策略将基础层的特征图划分为两部分,然后通过跨阶段层次结构将它们合并。 使用拆分和合并策略允许更多的梯度流通过网络。

该 CNN 用作 YOLOv4 的骨干网。