一、LSTM

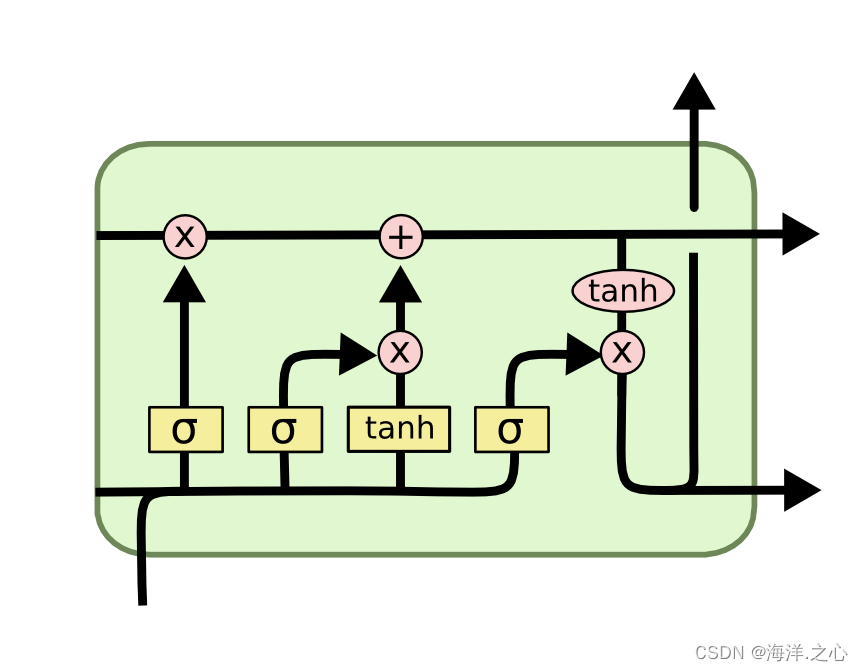

长短时记忆网络(Long Short-Term Memory,LSTM)是一种特殊的循环神经网络(RNN),专门设计用于解决传统RNN在处理长序列数据时出现的梯度消失和长期依赖问题。LSTM引入了门控机制,允许网络有选择地记忆、遗忘和更新信息,从而更好地捕捉序列中的长期依赖关系。以下是LSTM模型的详细解释:

-

细胞状态(Cell State): LSTM的核心是细胞状态,用来存储长期记忆信息。细胞状态在整个序列中持续传递,通过门控机制的调节来更新、遗忘和添加新的信息。这使得LSTM能够有效地处理长序列数据。

-

门控机制: LSTM引入了三个门控单元,分别是遗忘门(Forget Gate)、输入门(Input Gate)和输出门(Output Gate)。这些门控单元基于sigmoid激活函数来输出在0到1之间的值,用于控制信息流的保留和遗忘。具体来说:

- 遗忘门决定哪些细胞状态中的信息要被遗忘。

- 输入门决定哪些新的信息要被加入到细胞状态中。

- 输出门决定输出的隐藏状态和细胞状态中的信息。

-

候选值和细胞状态更新: 在每个时间步,LSTM首先计算一个候选值,用于更新细胞状态。候选值的计算包括tanh激活函数,将输入特征和前一个时间步的隐藏状态结合起来。然后,输入门的输出用于调整候选值的权重,进而更新细胞状态。

-

隐藏状态(Hidden State): LSTM的输出包括隐藏状态和细胞状态。隐藏状态是当前时间步的信息,可以用于后续的任务,如分类、预测等。隐藏状态的计算取决于细胞状态和输出门的输出。

总之,LSTM通过门控机制和细胞状态的管理,使得它能够在处理长序列数据时更好地捕捉长期依赖关系,避免了传统RNN中的梯度消失问题。LSTM在许多序列数据处理任务中表现出色,如自然语言处理、时间序列预测等。同时,LSTM的变体,如门控循环单元(GRU),也在一定程度上解决了类似的问题,为序列建模任务提供了更多的选择。

二、为什么LSTM模型中既存在sigmoid又存在tanh两种激活函数,而不是选择统一一种sigmoid或者tanh?

LSTM模型中使用不同的激活函数(如sigmoid和tanh)是为了充分利用它们各自的特点,以实现更好的序列数据建模和长期依赖捕捉。这种组合的激活函数在LSTM的门控机制中发挥着不同的作用,允许LSTM模型更加灵活地处理输入、遗忘和输出信息。下面解释了为什么LSTM中同时使用sigmoid和tanh激活函数:

-

Sigmoid激活函数: 在LSTM中,遗忘门(Forget Gate)、输入门(Input Gate)和输出门(Output Gate)中通常使用sigmoid激活函数。Sigmoid函数将输入值映射到0到1之间的范围,适用于门控机制的目的,因为它可以控制信息的流动程度。在门控机制中,sigmoid激活函数的输出决定了信息的保留或遗忘程度,使得模型能够灵活地控制细胞状态中的信息流。

-

tanh激活函数: 在LSTM的细胞状态更新中,通常使用tanh激活函数。tanh函数将输入值映射到-1到1之间的范围,具有中心化的特性,适用于捕捉正负信息。细胞状态更新需要结合新的候选值和先前的细胞状态,以便更好地处理输入信息。

通过同时使用sigmoid和tanh激活函数,LSTM可以更好地平衡门控、信息保留和信息更新的需求,从而实现对长期依赖关系的更好捕捉。这种结合允许模型在不同的门控单元中分别处理不同类型的信息,并在整个序列中有效地传播和维持重要的信息。

总之,LSTM中同时使用sigmoid和tanh激活函数是为了充分利用它们在门控机制和细胞状态更新中的不同特点,以实现更好的序列数据建模和长期依赖捕捉。