一、室内场景(ADE20K)

1.1 背景介绍

ADE20K 数据集是 2016 年 MIT 开放的场景理解的数据集,可用于实例分割,语义分割和零部件分割。利用图像信息进行场景理解 scene understanding 和 scene parsing。

语义分割 Semantic Segmentation 即最常见的任务,将图像的不同像素按对象类别 object category进行分类,实例分割 Instance Segmentation 不仅要识别不同物体所属的类别,还需识别出同类的不同物体。零部件分割 Part Segmentation是在识别出的物体上分割出不同部分所属的零部件类别,这对于理解场景帮助机器人与环境交互十分重要,如在某个 scene 中分割出来 chair 或者 cup,为了坐下或者拿起杯子需要找到 objects 中对应的 parts,如 chair 可以坐的部分, cup 的杯柄, 以实现机器人与知行特定的任务。

已有分割公开数据集的现状:

- 类别有限, 且有些数据类别在实际生活中并不常见如 COCO 和 PASCAL 数据集;

- 包含的场景过少,如 Cityscapes 仅包含城市街区的场景数据;

- Pascal-Context 和 SUN 还不错, 但 Pascal-Context 主要包含其20个对象类的场景, 而 SUN 在对象级别的标注是不准确的。

1.2 数据集的介绍

ADE20K的官网:

https://groups.csail.mit.edu/vision/datasets/ADE20K/index.html

ADE20K 由 27000 张图像组成,这些图像来自于 SUN (2010 年普林斯顿大学公开的数据集) 和 Places (2014 年 MIT 公开的数据集)数据集,ADE20K 中由超过 3000 个物体类别 category,其中很多图像组成物体的零部件的类别,以及组成零部件的零部件的类别,如汽车的零部件 门,门上面的零部件窗户。ADE20K 中还标注了实例的 id,可用于实例分割。数据中的图像都进行了匿名化处理,做了人脸和车牌号的模糊,去除了隐私信息。

ADE20K 的数据分布:

- 训练集 Training set 包含 25574 张完整标注图像;

- 验证集 Validation set 包含 2000 张完整标注图像;

- 测试集 Test set 还没有发布。

ADE20K 的数据组成:

- 共包含 27574 张图像;

- 3688 个类,类名取自WordNet(WordNet是由普林斯顿大学认识科学实验室在心理学教授乔治·A·米勒的指导下建立和维护一个词与词之间存在各种关系的英语字典);

- 707868 个对象;

- 193238 个零部件。

数据文件目录结构:

.

└── ADE20K_2021_17_01

└── images

└── ADE

└── training

└── urban

└── street

├── ADE_train_00016869

│ ├── instance_000_ADE_train_00016869.png

│ ├── instance_001_ADE_train_00016869.png

│ ├── instance_..._ADE_train_00016869.png

├── ADE_train_00016869.jpg

├── ADE_train_00016869.json

├── ADE_train_00016869_parts_1.png

├── ADE_train_00016869_parts_2.png

├── ADE_train_00016869_seg.png

├── ADE_train_00016964

│ ├── instance_000_ADE_train_00016964.png

│ ├── instance_001_ADE_train_00016964.png

│ ├── instance_..._ADE_train_00016964.png

├── ADE_train_00016964.jpg

├── ADE_train_00016964.json

├── ADE_train_00016964_parts_1.png

└── ADE_train_00016964_seg.png

- image_name.jpg原始图像,如ADE_train_00016869.jpg;

- {image_name}_seg.png图像 image_name.jpg对应的类别和实例的标注信息,存储在其每个像素的 RGB通道中,借助 toolkit中的代码utils_ade20k.py可以实现标注信息的解析;

- {image_name}parts{i}.png图层 i中包含的零部件,如ADE_train_00016869_parts_1.png;

- {image_name},以文件名命名的文件夹,其中的每个图像分别是一个实例标注信息对应原图的掩码,由 0,1组成。如ADE_train_00016869;

- {image_name}.json包含了图像对应的标注信息,如实例和类别标注信息的多边形,标注的时间,标注实例或对象的属性,如ADE_train_00016869.json。

二、驾驶场景(BDD100K)

目前,自动驾驶的公开数据集主要由视频和图片组成,近两年也增加了许多雷达数据。

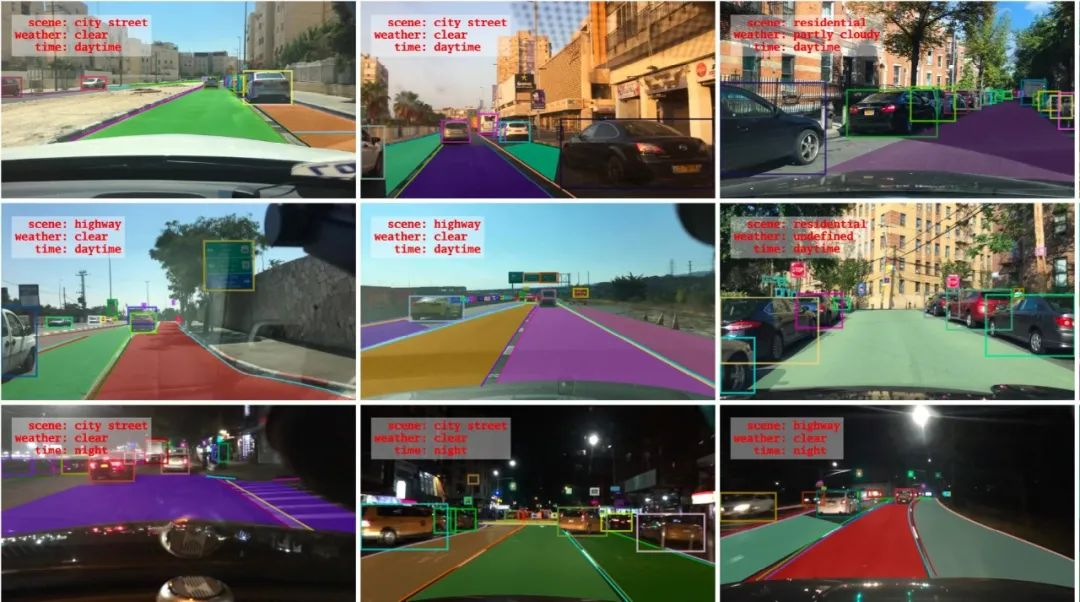

加州大学伯克利分校发布的 BDD100K 数据集,该数据集为迄今规模最大、最多样的自动驾驶数据集之一。BDD100K 数据集,是加州大学伯克利分校 AI 实验室(BAIR)于 2018 年发布的,迄今为止最大规模、内容最具多样性的公开驾驶数据集之一。其包含的 10 万个高清视频序列,时长超过 1100 小时。其中,每个视频大约 40 秒长、720p、30 fps,还附有手机记录的 GPS/IMU 信息和时间戳,以显示大概的驾驶轨迹。BAIR 还对每个视频的第 10 秒对关键帧进行采样,得到 10 万张图片(图片尺寸:1280*720 ),并进行标注。

这些图片还被标记了:图像标记、道路对象边界框、可驾驶区域、车道标记线和全帧实例分割。这些注释有助于理解不同场景中数据和对象统计的多样性。数据集中的视频是从美国各地收集的,涵盖不同时间、不同天气条件(包括晴天、阴天和雨天,以及白天和晚上的不同时间)和驾驶场景。

收集数据集的地理位置分布在纽约、伯克利、旧金山等地。数据集中,道路目标检测是为公共汽车、交通灯、交通标志、人、自行车、卡车、摩托车、汽车、火车和乘车人等 100000 张图片上标注 2D 边界框;实例分割被用于探索具有像素级和丰富实例级注释,相关图像超过 10000 张;引擎区域是从 10 万张图片中学习复杂的可驾驶决策;车道标记是在 10 万张行车指南图片上的多种车道标注。车道标记类图片中,标注了实线、虚线、双线、单线等。

该数据集由相关论文有《BDD100K: A Diverse Driving Video Database with Scalable Annotation Tooling》,该项目由伯克利 DeepDrive 产业联盟组织和赞助,该联盟研究计算机视觉和机器学习在汽车应用上的最新技术。

三、室外场景(Cityscapes)

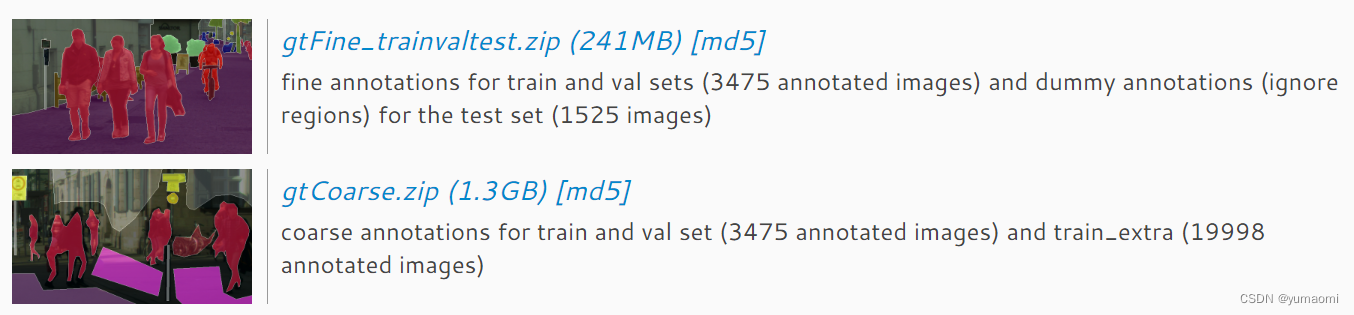

Cityscapes 大致有两个数据集,分别为精细的标注数据集(3475 张训练图像,1525 张测试图像)和粗糙的标注数据集(3475 + 19888 张额外的粗糙标注)

一般只需要用到精细的部分,也就是4375+1525张图像,在官网直接下载即可,一共5000张。

数据集的原始图片为图2中所示,左边摄像头拍到的图像。共11GB。