用语言引导的diffusion作为通用图像先验的单视角NeRF合成

Overview

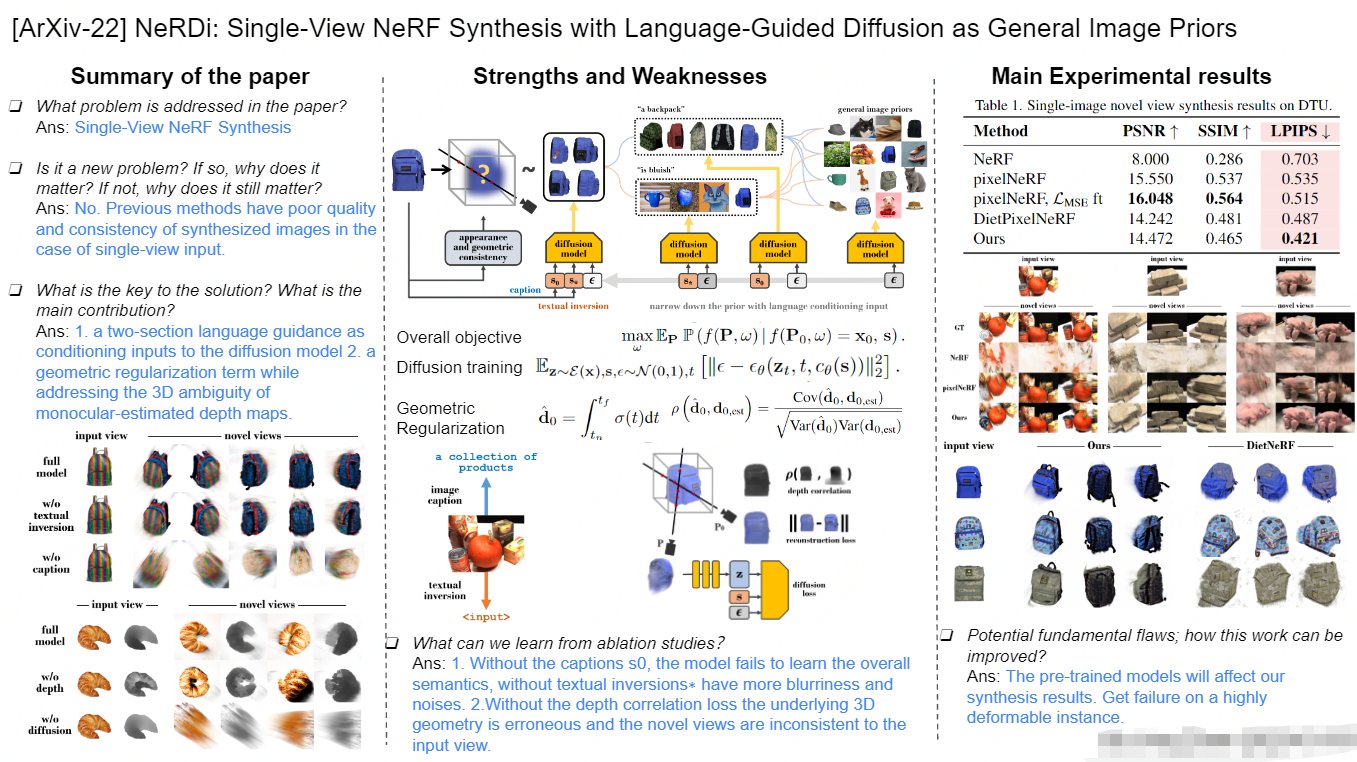

What problem is addressed in the paper?

we propose NeRDi, a single-view NeRF synthesis framework with general image priors from 2Ddiffusion models. (视角合成)

Is it a new problem? If so, why does it matter? If not, why does it still matter?

why matter? : our method can synthesize novel views with higher quality even compared to existing methods trained on this dataset (与在该数据集上训练的现有方法相比,我们的方法可以以更高的质量合成新的视图)

What is the key to the solution?

- . Given an input image, we optimize for a NeRF by minimizing an image distribution loss for arbitrary-view renderings with the diffusion model conditioned on the input image

- We design a two-section semantic feature as the conditioning input to the diffusion model. Our two-section semantic feature provides an appropriate image prior, allowing the synthesis of a realistic NeRF coherent to the input image.

- The first section is the image caption s0 which carries the overall semantics;

- the second section is a text embedding s∗ extracted from the input image with textual inversion, which captures additional visual cues.

What is the main contribution?

- We formulate single-view reconstruction as a conditioned 3D generation problem and propose a single-image NeRF synthesis framework without 3D supervision, using 2D priors from diffusion models trained on large image datasets. (我们将单视图重建作为一个有条件的3D生成问题,并提出了一个没有3D监督的单幅图像NeRF合成框架,使用在大型图像数据集上训练的扩散模型的2D先验。)

- We design a two-section semantic guidance to narrow down the general prior knowledge conditioned on the input image, enforcing synthesized novel views to be semantically and visually coherent. (我们设计了一个两节语义引导,以缩小输入图像为条件的一般先验知识,强制合成的新视图在语义和视觉上一致。)

- We introduce a geometric regularization term on estimated depth maps with 3D uncertainties. (本文在具有3D不确定性的估计深度图上引入了几何正则化项)

- We validate our zero-shot novel view synthesis results on the DTU MVS [13] dataset, achieving higher quality than supervised baselines. We also demonstrate our capability of generating novel-view renderings with high visual quality on in-the-wild images. (在DTU MVS[13]数据集上验证了零样本新视图合成结果,实现了比监督基线更高的质量。展示了在野外图像上生成具有高视觉质量的新视角渲染的能力。)

What can we learn from ablation studies?

- Without the captions s0, the model fails to learn the overall semantics, without textual inversions∗ have more blurriness and noises.

- Without the depth correlation loss the underlying 3D geometry is erroneous and the novel views are inconsistent to the input view.

Potential fundamental flaws; how this work can be improved?

The pre-trained models will affect our synthesis results. Get failure on a highly deformable instance.

Introduction

启发: Given a specific image, they can quickly narrow down their prior knowledge to the visual input. This makes humans good at solving ill-posed perception problems like single-view 3D reconstruction

Methods

Figure 2 Method overview

我们将基础3D场景表示为NeRF,并对其参数进行了优化,一共三个损失:

- a reconstruction loss at the fixed input view;

- a diffusion loss at arbitrarily sampled views which also takes a conditioning text input generated from the input image with our two-section feature extraction;

- a depth correlation loss at the input view regularizing the 3D geometry.

流程描述

在指定输入 x 0 x_0 x0的情况下,学习一个NERF模型来作为它的3d重构。 模型表示如下:

rendering过程和传统方法保持一致。

简化后的表达为:

其中,P表示指定渲染的视角信息,w是NeRF的网络参数。

我们将现在的问题描述为一个有条件3D生成问题:

我们优化NeRF以遵循3D场景分布,条件是其在给定视图P0处的渲染f(P0,ω)应为输入图像x0。

我们利用2D图像先验,并将目标重新表述为:

f(P,ω)在任意采样视图上渲染,促使它们遵循先验P,既满足约束x0=f(P0,ω)。

总体目标可以写为最大化条件概率:

其中s是一个附加的语义指导项,我们应用它来进一步限制先验图像分布以适应生成内容。

3.1. Novel View Distribution Loss

DDPM 基础: We build our method upon the recent Latent Diffusion Model (LDM) [35] for its high quality and efficiency in image generation.

- an encoder ε ( x ) = z \varepsilon(x) = z ε(x)=z mapping images x into latent codes

- a decoder D ( ε ( x ) ) = x D(\varepsilon(x)) = x D(ε(x))=x recovering the images

然后通过最小化目标在潜在空间中训练扩散过程:

其中t是diffusion的时间步, ϵ \epsilon ϵ 是随机采样的噪声, zt 是用时间t 和 ϵ \epsilon ϵ加噪后的潜码, θ \theta θ是diffusion模型的参数, ε θ \varepsilon_{\theta} εθ是diffusion模型预测的噪声。 c θ ( s ) c_{\theta}(s) cθ(s) 是条件输入s 的嵌入编码,用于引导去噪过程, c θ ( ⋅ ) c_{\theta}(\cdot) cθ(⋅)是一个预先训练的大型语言模型,用于编码条件文本.

x=f(P,ω)是我们在任意采样视图P下的NeRF渲染,我们可以将梯度反向传播到NeRF参数ω,从而获得ω上的随机梯度下降

3.2. Semantics-Conditioned Image Priors

这是一个根据输入图像x0预测对应的文本描述s0的网络S,用(img,text)的数据集训练得到。

然而,尽管文本描述可以概括图像的语义,但它留下了巨大的歧义空间,使得很难在图像中包含所有视觉细节,尤其是在提示长度有限的情况下。

在图3的顶行中,我们显示了从左侧的输入图像中生成的带有标题“产品集合”的图像。虽然它们的语义相对于语言描述是高度准确的,但是生成的图像在其视觉模式中具有非常高的方差,并且与输入图像的相关性很低。

Figure 3 Image generation with different semantic guidance.

首行:虽然它们的语义相对于语言描述是高度准确的,但是生成的图像在其视觉模式中具有非常高的方差,并且与输入图像的相关性很低。

第二行:输入图像的颜色和视觉线索被很好地捕捉(橙色元素、食物,甚至是品牌标识)。然而,宏观层面的语义有时是错误的(第二列是一个人在运动)。

底行:使用组合的图像标题和文本反转生成的图像。解决了输入图像的语义和视觉特征。

我们可以优化输入图像x0 的文本嵌入s* 通过下面的公式:

为了在新视图合成任务中反映输入图像的语义和视觉特征,我们将这两种方法结合起来,将它们的文本嵌入连接起来,形成一个联合特征s = [s0, s *],并将其作为方程5中扩散过程的指导。

3.3. Geometric Regularization

虽然图像扩散形成了NeRF的外观,但由于即使在相同的图像渲染下,基础3D几何结构也可能不同,因此难以实现多视图一致性[15,24],使得梯度反向传播(从图像扩散到NeRF参数ω)高度不可控。

使用预训练模型DPT,为每个输入图像x0 机型深度估计, d 0 , e s t d_{0,est} d0,est. 然后我们使用这个估计的深度来正则化 输入视角P0对应渲染的图像深度:

由于估计深度(包括尺度、位移、相机内部)和估计误差(图4)的模糊性,我们无法将深度像素投影到3D并直接计算正则化。

因此,我们最大化了估计深度图和NeRF渲染深度之间的皮尔逊相关性

度量渲染深度分布和噪声估计深度分布是否线性相关。

4. Experiments

4.1. Synthetic Scenes

设置:

- 我们在DTU MVS数据集[13]上评估我们的方法,并使用[52]中指定的15个测试场景。

- 对于每个输入图像,我们使用GPT-2[31] 生成标题。

- 我们使用来自[35]的文本引导扩散模型,该模型在LAION400M数据集[38]上进行了预训练。

Baselines:

我们比较了两种最先进的单视图NeRF重建算法,PixelNeRF[52]及其由DietNeRF[12]提出的带有CLIP[30]特征一致性损失的微调模型,这两种算法都是在DTU MVS数据集的训练集数据上进行训练的。

结果:

我们强调,这两个指标在我们的场景中不太具有指示性,因为它们是合成的新视图和地面真实图像之间的局部像素对齐的相似性指标,但单视图3D推断自然存在不确定性。 图5中第一个场景的中间一列显示了这种不确定性的一个例子。输入图像中最高的零食袋的高度无法推断,因为它的顶部超出了相机的视野。第三个场景左列玩具猪的宽度是另一个不能从输入侧视图推断的例子。在这两种情况下,我们的方法都在合理的意义上猜测它的新观点(底部行),但与基本事实(顶部行)不同。

LPIPS与基线相比,该方法在这一指标上有显著的改进,因为扩散模型有助于提高图像质量,而语言指导保持了多视图语义一致性。

Figure 5 DTU测试场景下单幅图像新颖视图合成结果

虽然pixelNeRF可以从类似场景的DTU训练集中推断出具有先验的新视图图像,但其合成的渲染仍然存在噪声和模糊。通过pixelNeRF初始化,我们的方法能够合成具有真实几何和外观的更干净的新视图,尽管从未在此数据集上进行过训练。

4.2. Images in the Wild

(自然场景)

Figure 6 来自谷歌扫描对象数据集的对象上的新颖视图合成结果。

与我们的相似,DietNeRF[12]使用输入视图约束的NeRF优化技术,其中他们最小化任意视图渲染之间的CLIP[30]特征。虽然CLIP特性强制保持一致的外观,但它们无法捕获对象的全局语义。SS3D[45]是一种用于3D几何图形的前向预测模型,它通过知识蒸馏将在合成数据集上学习到的先验信息转移到野外图像中。虽然它生成了更结构化的全局几何图形,但它无法捕获输入图像的精细几何细节。底部几排帽子的几何形状也不正确,只保留了剪影形状,但没有“帽子”形状的结构。

Figure 7 Results on images in the wild.

图7a显示了我们对来自互联网的物体图像的结果。文本提示是用于搜索图像的单词或短语。背景使用[29]中现成的二分图像分割网络进行屏蔽。对于每个输入,我们显示了3个不同的新视图,它们都远离输入视图。

图7b显示了我们对来自COCO数据集[17]的具有更复杂内容和背景的图像的结果,该数据集包含**(图像,标题)对**。在靠近输入的相机视图中,我们的模型仍然能够生成逼真的效果图。但是由于NeRF场景框的容量有限,它很难推广到远处的视图。

4.3. Ablation Studies

我们进行了消融研究,以显示我们的two-section semantic guidance和几何正则化的有效性。

Semantic guidance (Figure 8)

第一排:完整模型。

中间一行:只有字幕引导,没有文本反转。该模型仍然能够严格按照语义和输入视图外观和几何约束生成形状,但在综合细节方面更加困难。

底部一行:只有文本反转,没有标题。文本反转无法捕获全局语义

Geometric regularization

渲染图像和深度图上的输入视图重建和新视图的可视化。

顶部一行:完整的模型能够在保持几何一致性的同时合成现实的新视图。

中间行:没有深度相关损失,扩散模型仍然能够生成合理的外观,但底层的3D几何结构是错误的,新视图与输入视图不一致。

底部一行:由于三维模糊,如果没有扩散模型,输入-视图深度估计本身无法指导新视图合成。

5. Conclusions

本文提出一种新的框架,用于在没有3D监督的情况下对自然图像进行零样本单视图NeRF合成。利用二维扩散模型中的一般图像先验,并将其应用于以输入图像为条件的3D NeRF生成。为了有效地利用这些先验来合成一致的视图,设计了一个two-section的语言指导,作为扩散模型的条件输入,统一了输入图像的语义和视觉特征。

本文首次在文本嵌入空间中结合语义和视觉特征,并将其应用于新视图合成。

引入了一个几何正则化项,同时解决了单目估计深度图的3D模糊。

实验结果表明,在精心设计的指导和约束下,可以利用特定图像到3d之前的通用图像,使我们能够建立可泛化和自适应的重建框架。

Limitations and future work.

由于我们的方法依赖于多个预先训练好的大型图像模型[29,31,33,35],这些模型中的任何偏差都会影响我们的合成结果。

图10a显示了一个例子,图像扩散模型[35]可以生成两只鞋,即使文本提示是“一只鞋”,导致我们合成的NeRF显示了多只鞋的特征。我们的方法对于高度变形的实例的健壮性也较差,因为我们的语言指导侧重于语义和样式,但缺乏物理状态和动态的全局描述。图10b显示了这样一个失败案例。来自每个独立视图的渲染在视觉上是合理的,但表示相同实例的不同状态。

虽然公式化的优化适用于任何场景,但它更适合于以物体为中心的图像,因为它采取的基本假设是,场景从任何视图都具有完全相同的语义,这对于由于视图变化和遮挡而具有复杂配置的大型场景来说是不正确的。从文本倒置中学习到的文本嵌入是单世界嵌入的维度,限制了它在表示微妙复杂内容方面的表现力。