目录

认识爬虫

爬虫的概念

网络爬虫也被称为网络蜘蛛、网络机器人,是一个自动下载网页的计算机程序或自动化脚本。

网络爬虫就像一只蜘蛛一样在互联网上沿着URL的丝线爬行,下载每一个URL所指向的网页,分析页面内容。

爬虫的原理

1. 通用网络爬虫

通用网络爬虫又称为全网爬虫,其爬行对象由一批种子URL扩充至整个Web,该类爬虫比较适合为搜索引擎搜索广泛的主题,主要由搜索引擎或大型Web服务提供商使用。

深度优先策略:按照深度由低到高的顺序,依次访问下一级网页链接,直到无法再深入为止。

广度优先策略:按照网页内容目录层次的深浅来爬行,优先爬取较浅层次的页面。当同一层中的页面全部爬行完毕后,爬虫再深入下一层。

2. 聚焦网络爬虫

聚焦网络爬虫又被称作主题网络爬虫,其最大的特点是只选择性地爬行与预设的主题相关的页面。 基于内容评价的爬行策略:该种策略将用户输入的查询词作为主题,包含查询词的页面被视为与主题相关的页面。

基于链接结构评价的爬行策略:该种策略将包含很多结构信息的半结构化文档Web页面用来评价链接的重要性,其中一种广泛使用的算法为PageRank算法。

基于增强学习的爬行策略:该种策略将增强学习引入聚焦爬虫,利用贝叶斯分类器对超链接进行分类,计算出每个链接的重要性,按照重要性决定链接的访问顺序。

基于语境图的爬行策略:该种策略通过建立语境图学习网页之间的相关度,计算当前页面到相关页面的距离,距离越近的页面中的链接优先访问。

3. 增量式网络爬虫

增量式网络爬虫只对已下载网页采取增量式更新或只爬行新产生的及已经发生变化的网页,需要通过重新访问网页对本地页面进行更新,从而保持本地集中存储的页面为最新页面。 常用的更新方法如下。

统一更新法:以相同的频率访问所有网页,不受网页本身的改变频率的影响。

个体更新法:根据个体网页的改变频率来决定重新访问各页面的频率。

基于分类的更新法:爬虫按照网页变化频率分为更新较快和更新较慢的网页类别,分别设定不同的频率来访问这两类网页。

4. 深层网络爬虫

Web页面按照存在方式可以分为表层页面和深层页面两类。表层页面指以传统搜索引擎可以索引到的页面,深层页面为大部分内容无法通过静态链接获取,隐藏在搜索表单后的,需要用户提交关键词后才能获得的Web页面。

深层爬虫的核心部分为表单填写,包含以下两种类型。

基于领域知识的表单填写:该种方法一般会维持一个本体库,通过语义分析来选取合适的关键词填写表单。

基于网页结构分析的表单填写:这种方法一般无领域知识或仅有有限的领域知识,将HTML网页表示为DOM树形式,将表单区分为单属性表单和多属性表单,分别进行处理,从中提取表单各字段值。

爬虫的合法性与robot.txt协议

1. 爬虫的合法性

目前,多数网站允许将爬虫爬取的数据用于个人使用或者科学研究。但如果将爬取的数据用于其他用途,尤其是转载或者商业用途,严重的将会触犯法律或者引起民事纠纷。

以下两种数据是不能爬取的,更不能用于商业用途。

个人隐私数据:如姓名、手机号码、年龄、血型、婚姻情况等,爬取此类数据将会触犯个人信息保护法。

明确禁止他人访问的数据:例如用户设置了账号密码等权限控制,进行了加密的内容。

还需注意版权相关问题,有作者署名的受版权保护的内容不允许爬取后随意转载或用于商业用途。

2. robot.txt协议

当使用一个爬虫爬取一个网站的数据时,需要遵守网站所有者针对所有爬虫所制定的协议,这便是robot.txt协议。

该协议通常存放在网站根目录下,里面规定了此网站那些内容可以被爬虫获取,及哪些网页是不允许爬虫获取的。

认识反爬虫

网站反爬虫的目的与手段

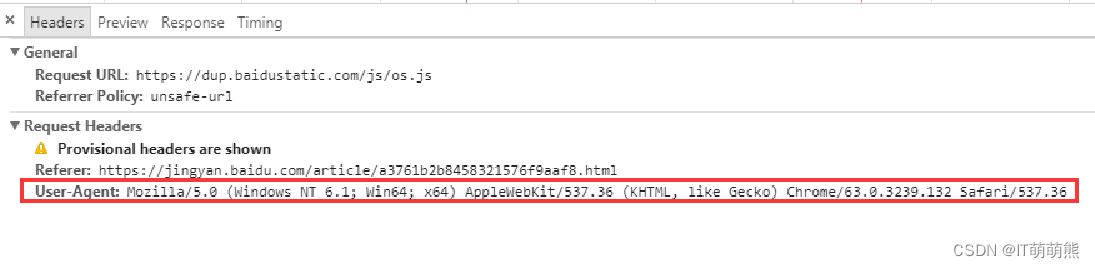

1. 通过User-Agent校验反爬

浏览器在发送请求的时候,会附带一部分浏览器及当前系统环境的参数给服务器,服务器会通过User-Agent的值来区分不同的浏览器。

2. 通过访问频度反爬

普通用户通过浏览器访问网站的速度相对爬虫而言要慢的多,所以不少网站会利用这一点对访问频度设定一个阈值,如果一个IP单位时间内访问频度超过了预设的阈值,将会对该IP做出访问限制。 通常需要经过验证码验证后才能继续正常访问,严重的甚至会禁止该IP访问网站一段时间。

3. 通过验证码校验反爬

有部分网站不论访问频度如何,一定要来访者输入验证码才能继续操作。例如12306网站,不管是登陆还是购票,全部需要验证验证码,与访问频度无关。

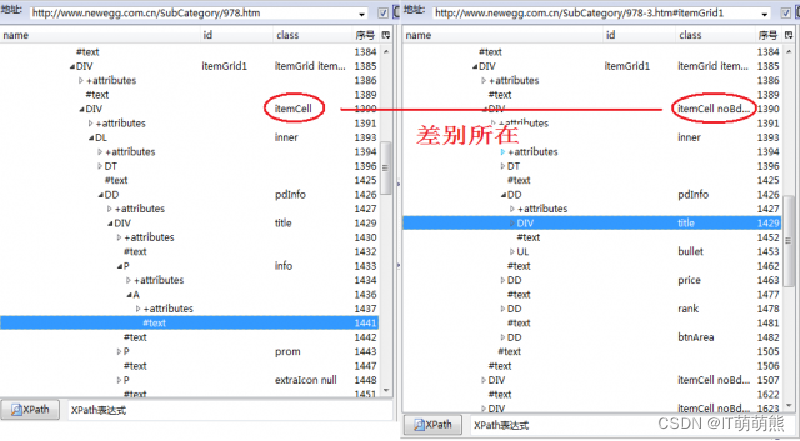

4. 通过变换网页结构反爬

一些社交网站常常会更换网页结构,而爬虫大部分情况下都需要通过网页结构来解析需要的数据,所以这种做法也能起到反爬虫的作用。在网页结构变换后,爬虫往往无法在原本的网页位置找到原本需要的内容。

5. 通过账号权限反爬

部分网站需要登录才能继续操作,这部分网站虽然并不是为了反爬虫才要求登录操作,但确实起到了反爬虫的作用。 例如微博查看评论就需要登录账号。

针对之前介绍的常见的反爬虫手段,可以制定对应的爬取策略如下。

发送模拟User-Agent:通过发送模拟User-Agent来通过检验,将要发送至网站服务器的请求的User-Agent值伪装成一般用户登录网站时使用的User-Agent值。

调整访问频度:通过备用IP测试网站的访问频率阈值,然后设置访问频率比阈值略低。这种方法既能保证爬取的稳定性,又能使效率又不至于过于低下。

通过验证码校验:使用IP代理,更换爬虫IP;通过算法识别验证码;使用cookie绕过验证码。

应对网站结构变化:只爬取一次时,在其网站结构调整之前,将需要的数据全部爬取下来;使用脚本对网站结构进行监测,结构变化时,发出告警并及时停止爬虫。

通过账号权限限制:通过模拟登录的方法进行规避,往往也需要通过验证码检验。

通过代理IP规避:通过代理进行IP更换可有效规避网站检测,需注意公用IP代理池是 网站重点监测对象。

配置Python爬虫环境

Python爬虫相关库介绍与配置

Python爬虫相关库,目前Python有着形形色色的爬虫相关库,按照库的功能,整理如下。

| 类型 |

库名 |

简介 |

| 通用 |

urllib |

Python内置的HTTP请求库,提供一系列用于操作URL的功能 |

| requests |

基于urllib,采用Apache2 Licensed开源协议的HTTP库 |

|

| urllib 3 |

提供很多Python标准库里所没有的重要特性:线程安全,连接池,客户端SSL/TLS验证,文件分部编码上传,协助处理重复请求和HTTP重定位,支持压缩编码,支持HTTP和SOCKS代理,100%测试覆盖率 |

|

| 框架 |

scrapy |

一个为了爬取网站数据,提取结构性数据而编写的应用框架 |

| HTML/XML解析器 |

lxml |

C语言编写高效HTML/XML处理库。支持XPath |

| BeautifulSoup 4 |

纯Python实现的HTML/XML处理库,效率相对较低 |

配置MySQL数据库

1. Windows下MySQL配置

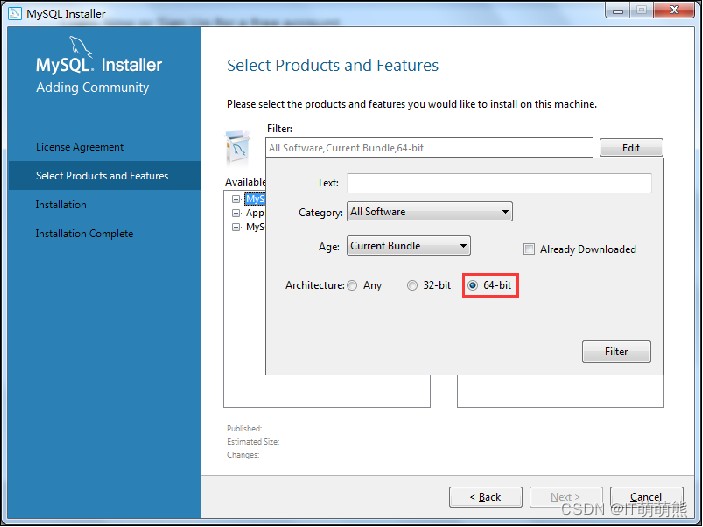

MySQL版本为社区版本mysql-installer-community-5.6.39.0,在64位的Windows系统上,安装该版本的MySQL具体步骤如下。

双击打开msi安装包,勾选接受许可条款, 单击“Next”按 钮后进入产品安装选择。

在弹出框中选择64位版本。

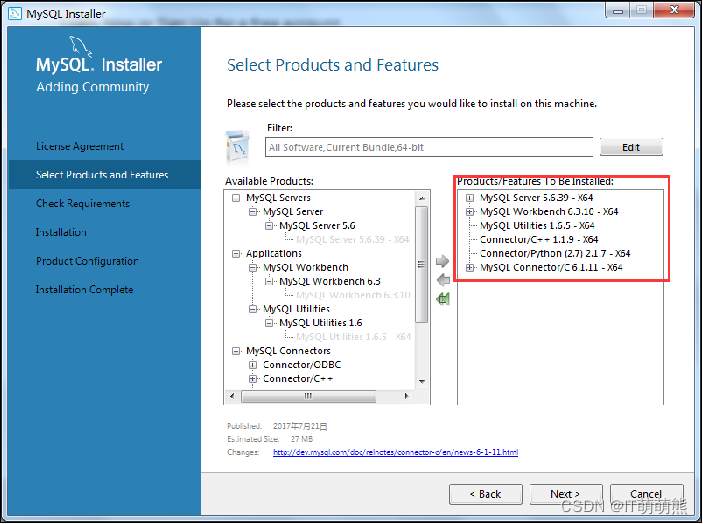

在下方左侧栏内选择需要安装的程序,单击右箭头移至安装栏内。

在下方左侧栏内选择需要安装的程序,单击右箭头移至安装栏内。

单击 “Next”按钮后,会检测系统上是否安装有相关依赖的软件,若没有安装,则会出现类似下图所示的界面。

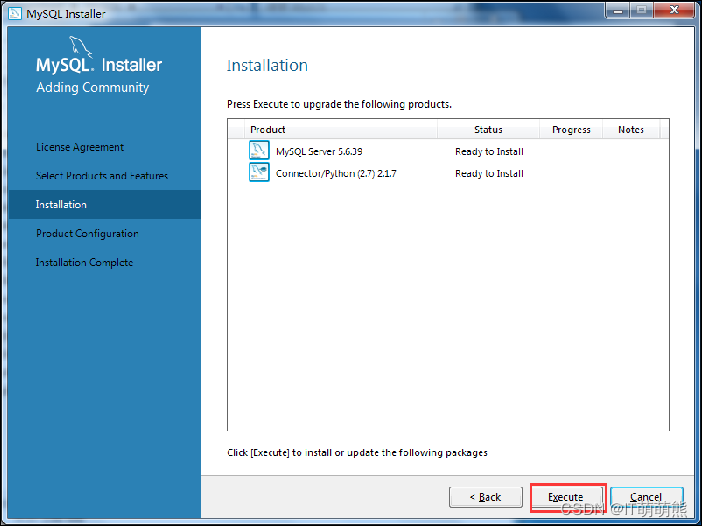

单击 “Next”按钮后,进入安装确认步骤,将被安装的程序会显示在框内,单击“Execute”按钮将开始安装过程。

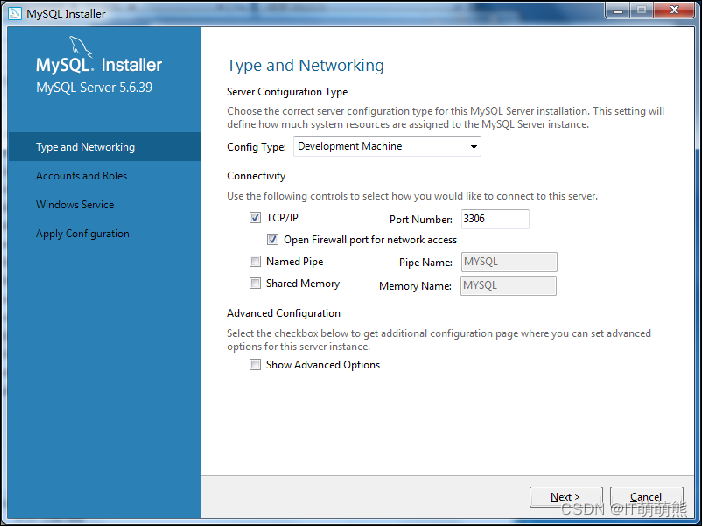

安装完成后,还需配置服务,一般用户类型选择“Development Machine”,MySQL的默认端口为3306。

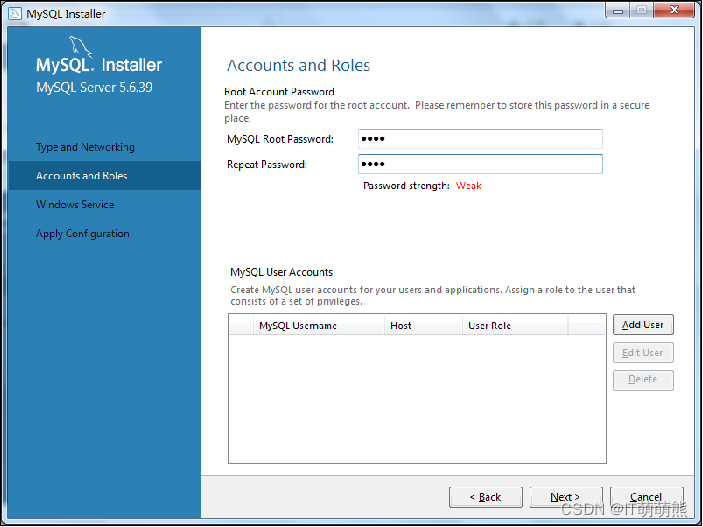

设置root账户的密码,可添加一个具有普通用户权限的MySQL用户账户,也可不添加。

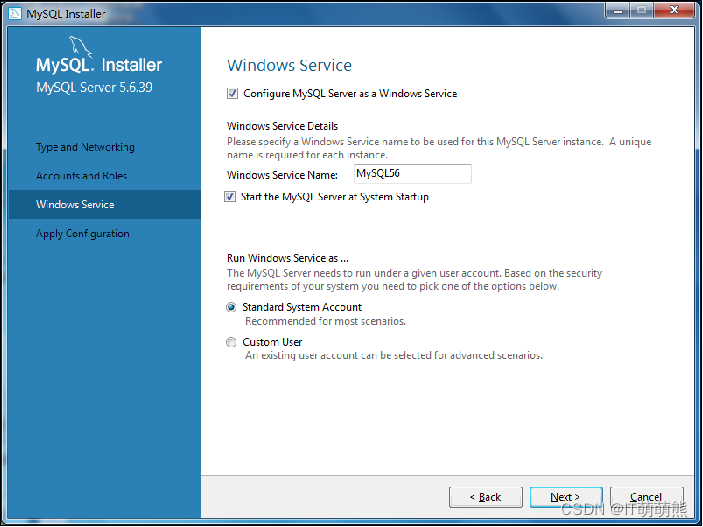

勾选“Configure MySQL Server as a Windows Service”后将以系统用户运行windows服务,在Windows下MySQL默认服务名为mysql56。

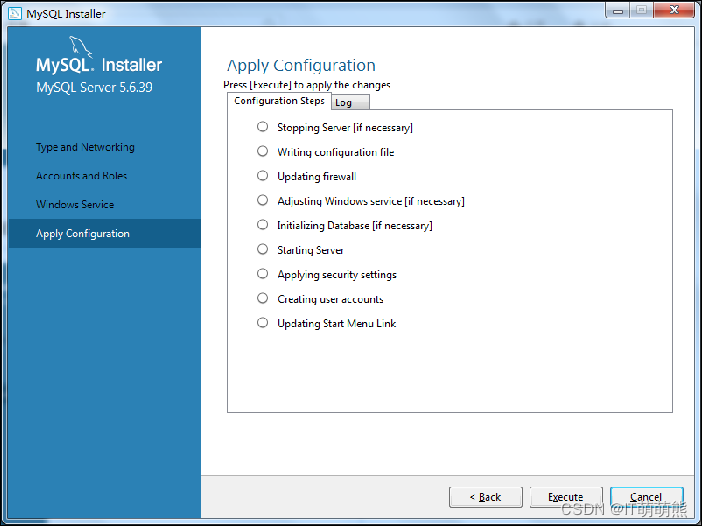

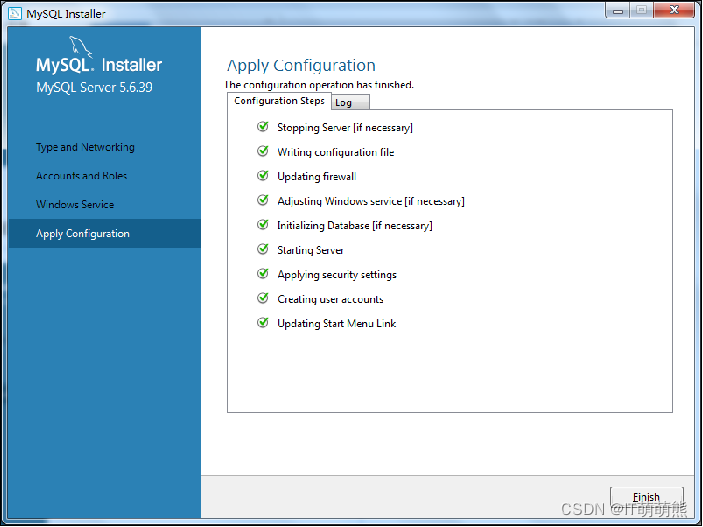

最后进入服务配置应用步骤,单击“Execute”按钮将开始执行。

执行成功的服务配置将变为绿色的勾选状态,单击 “Finish”按钮完成配置过程。

安装完成后还需要配置MySQL的环境变量,步骤如下。

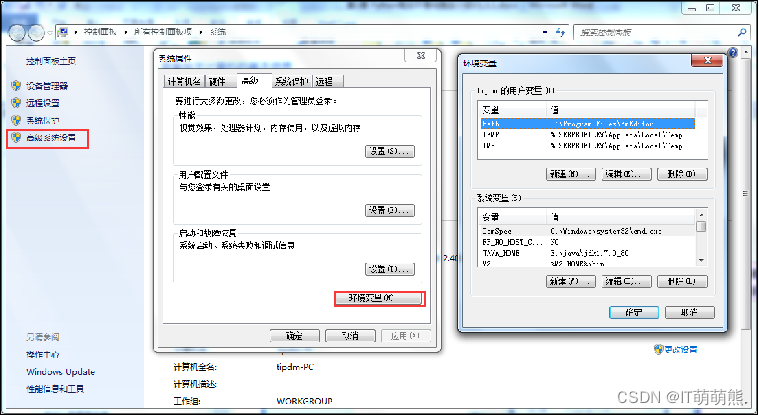

打开“环境变量”对话框。右键单击“我的电脑”图标,单击“高级系统设置”按钮,在弹出的“系统属性”对话框中单击“环境变量”按钮,即可弹出的“环境变量”对话框。

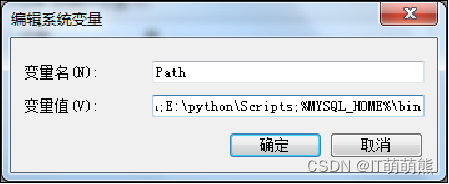

设置MySQL的环境变量:设置环境变量有两种方法,以下为第一种。 新建环境变量“MYSQL_HOME”,变量值填写“C:\Program Files\MySQL\MySQL Server 5.6”,其中MySQL默认安装在C:\Program Files路径下。

在“Path”变量后面添加“%MYSQL_HOME%\bin”。

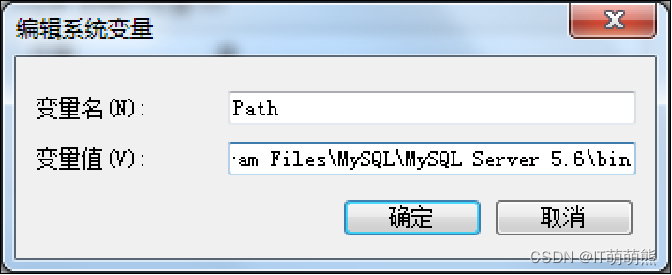

设置MySQL的环境变量:第二种设置环境变量的方法。 直接在“Path”变量中添加“C:\Program Files\MySQL\MySQL Server 5.6\bin”。

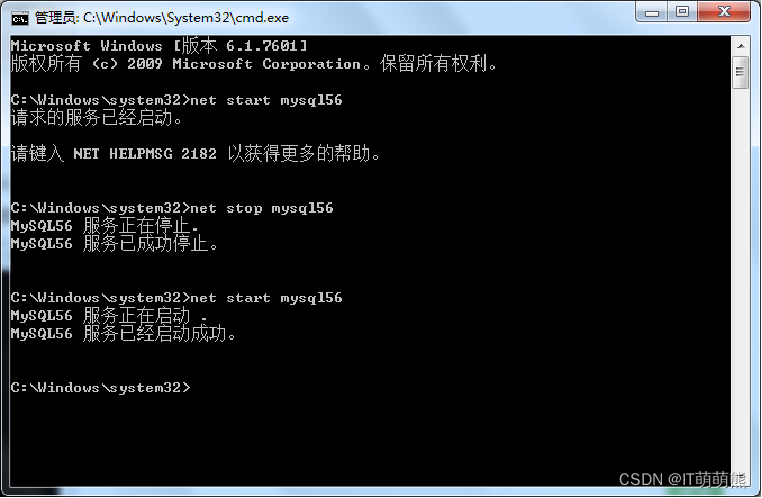

使用管理员权限运行命令提示符,使用“net start mysql56”命令启动MySQL服务,使用“net stop mysql56”可关闭MySQL服务。

2. Linux下MySQL配置

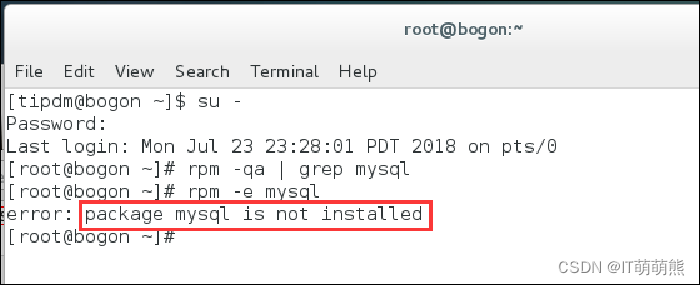

Linux版本为CentOS 7,使用“yum”命令安装mysql-community-5.6.40版本的MySQL数据库。 切换至root用户,使用“rpm -qa | grep mysql”命令查看是否已经安装MySQL数据库,没有安装将没有显示,若原本有安装也可使用“rpm -e mysql”命令进行卸载。

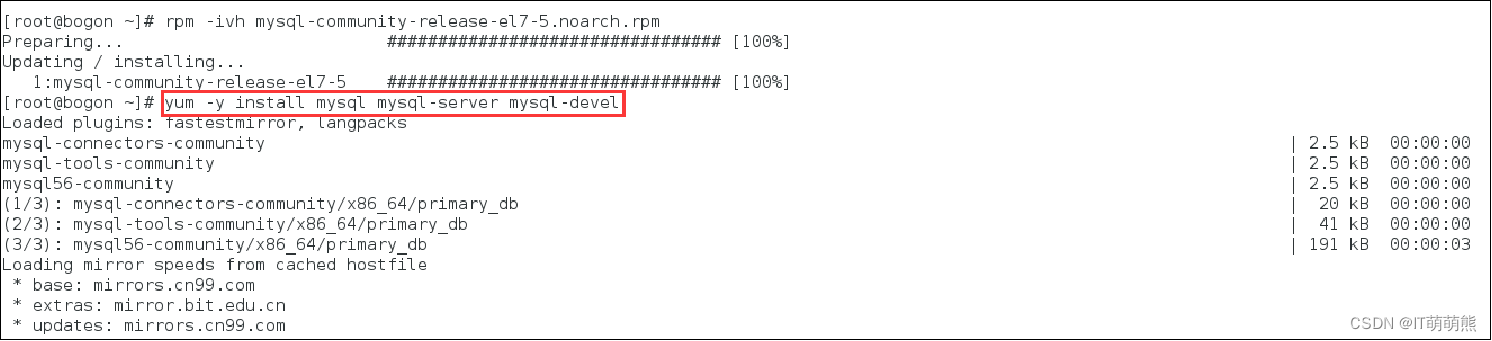

CentOS 7上将MySQL从默认软件列表中移除,用MariaDB来代替,所以必须要去官网上进行下载,在官网上找到下载链接,用“wget”命令打开。

使用“rpm -ivh mysql-community-release-el7-5.noarch.rpm”命令进行加载,之后运行“yum -y install mysql mysql-server mysql-devel” 命令进行安装。

安装完成后再次运行“yum -y install mysql mysql-server mysql-devel” 命令和“rpm -qa | grep mysql”命令进行确认。

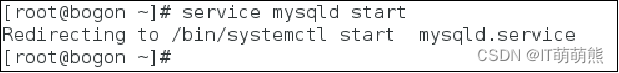

使用“service mysqld start”命令启用MySQL服务。

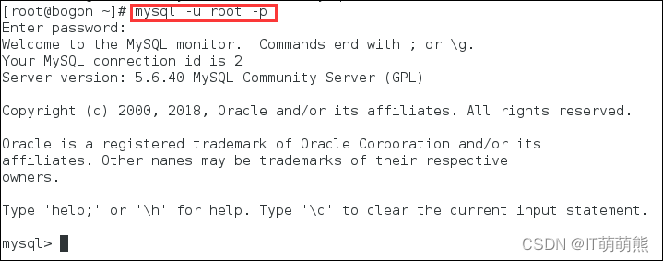

运行“mysql -u root -p”命令进入MySQL客户端,密码默认为空,可使用“help”或“\h”命令查看帮助。

配置MongoDB数据库

1. Windows下MongoDB配置

使用64位的3.4版本的MongoDB: mongodb-win32-x86_64-2008plus-ssl-v3.4-latest-signed.msi,安装及具体配置过程如下。

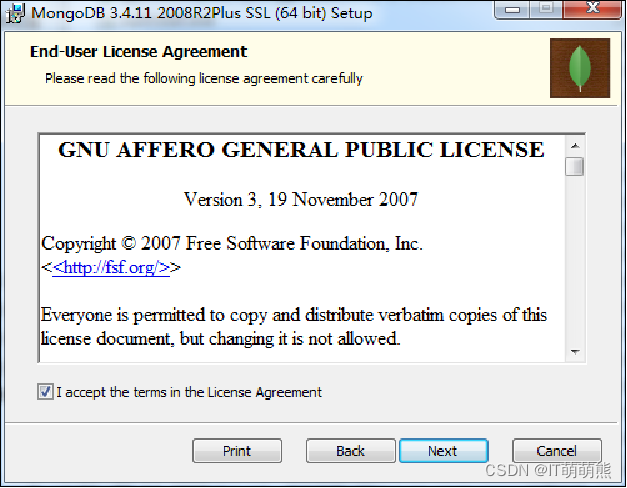

打开msi安装包,勾选同意许可条款, 单击“Next”按钮。

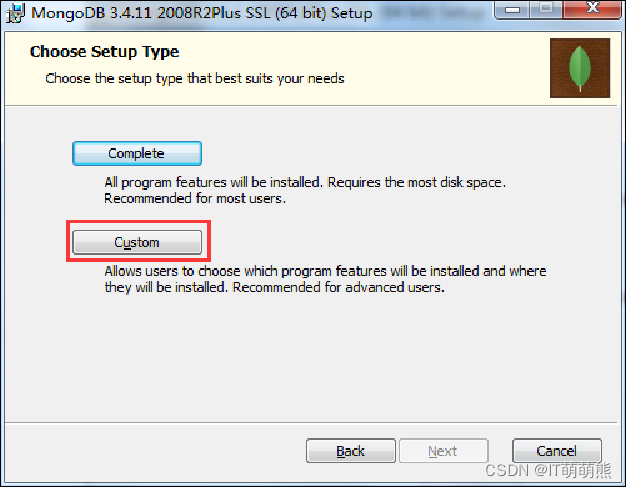

安装程序提供两种安装模式,完整(Complete)模式会将全部内容安装在C盘路径且无法更改,若要更改安装路径则需要选择下图中的定制(Custom)模式。

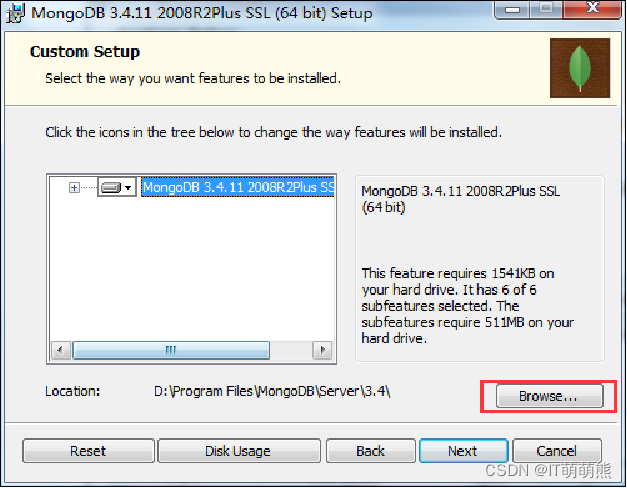

在定制模式下可选择安装路径和需要安装的部件,单击“Next”按钮开始安装过程。

安装完成后,需进入安装目录,建立data和log文件夹分别存放数据和log文件,还需创建一个mongo.conf配置文件。

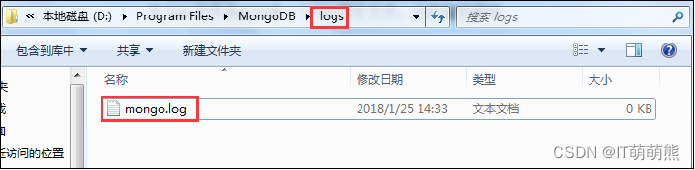

在logs文件夹内创建一个名为mongo.log的日志文件,内容留空即可。

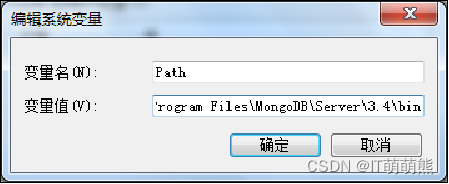

在系统变量“Path”中添加MongoDB的路径,如D:\Program Files\MongoDB\Server\3.4\bin。

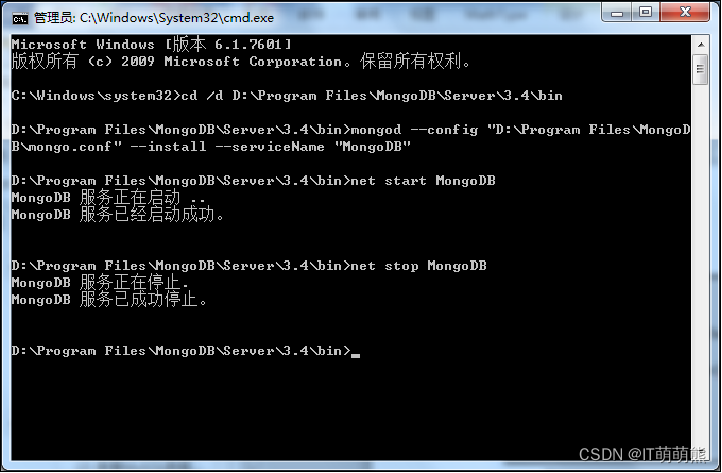

还需安装MongoDB服务,使用管理员权限打开cmd启动控制台,安装服务完毕后可使用命令对服务进行开启和关闭。

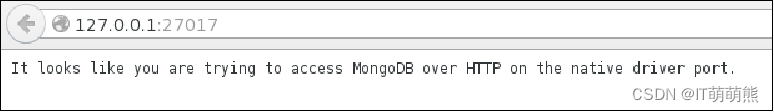

服务启动后,在浏览器输入http://127.0.0.1:27017,若出现下图所示的字样,则说明启动成功。

2.Linux下MongoDB配置

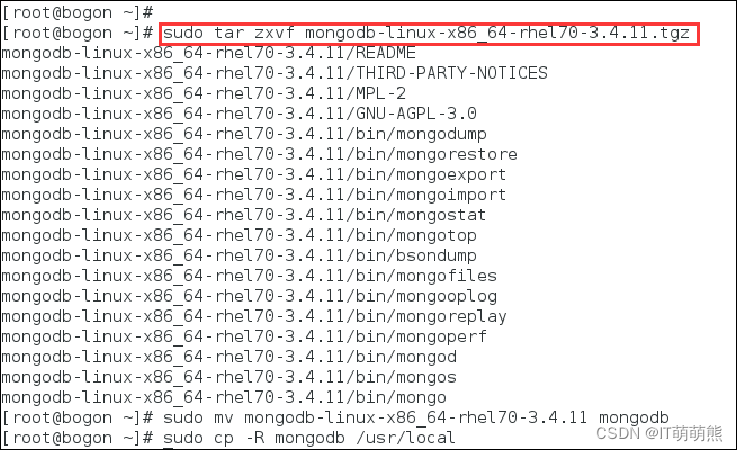

在Linux环境下,选用mongodb-linux-x86_64-rhel70-3.4.11版本的MongoDB数据库,安装步骤如下。 使用“wget”命令从官网获取MongoDB数据库的tar包。

将tar包进行解压缩,并复制到“/usr/local/”路径下。

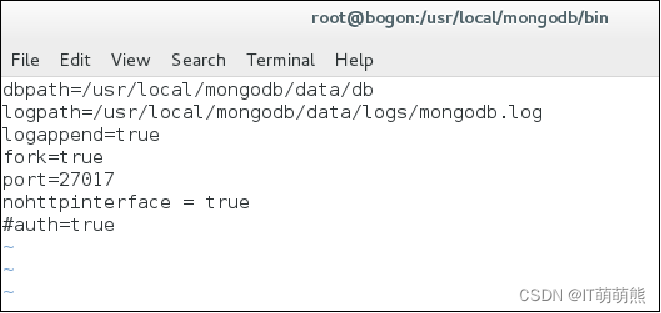

切换至“/usr/local/mongodb/bin”路径下,使用 “sudo vim mongodb.conf” 命令创建MongoDB数据库配置文件。

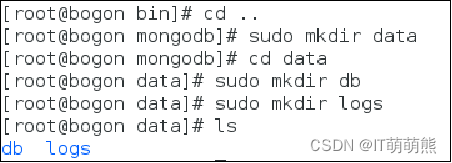

切换回“/usr/local/mongodb”路径下,依次运行“sudo mkdir data”、“cd data”、“sudo mkdir db”、“sudo mkdir logs”命令创建文件夹。

再次切换至“/usr/local/mongodb/bin”路径下,运行“sudo ./mongod -f mongodb.conf”命令启动MongoDB。

打开浏览器输入“http://127.0.0.1:27017”,出现下图中的信息,说明启动成功。

小结:爬虫是一种可以自动下载网页的脚本或计算机工具,可大致分为4种运作原理,用于个人或学术研究的爬虫通常是合法的。 反爬虫为网站针对爬虫进行检测和限制的过程,爬虫需针对反爬虫手段制定对应的爬取策略。 Python常用的爬虫库包含urllib、requests、urllib 3、scrapy、lxml和BeautifulSoup 4等库,通常需要配套数据库用于存储爬取的数据。