IJCAI 2022 || 图结构学习最新综述论文:A Survey on Graph Structure Learning: Progress and Opportunities

目录

Abstract

图数据广泛用于描述现实中的实体及其他们之间的联系。图神经网络高度敏感于给定的图结构,因此噪声和不完备的图会得到不满意的表示并且妨碍模型全面理解潜在的机理。图结构学习GSL旨在联合学习最优的图结构和对应的图表示。在本篇工作中,我们广泛回顾了GSL最近的进展

1、Introdcution

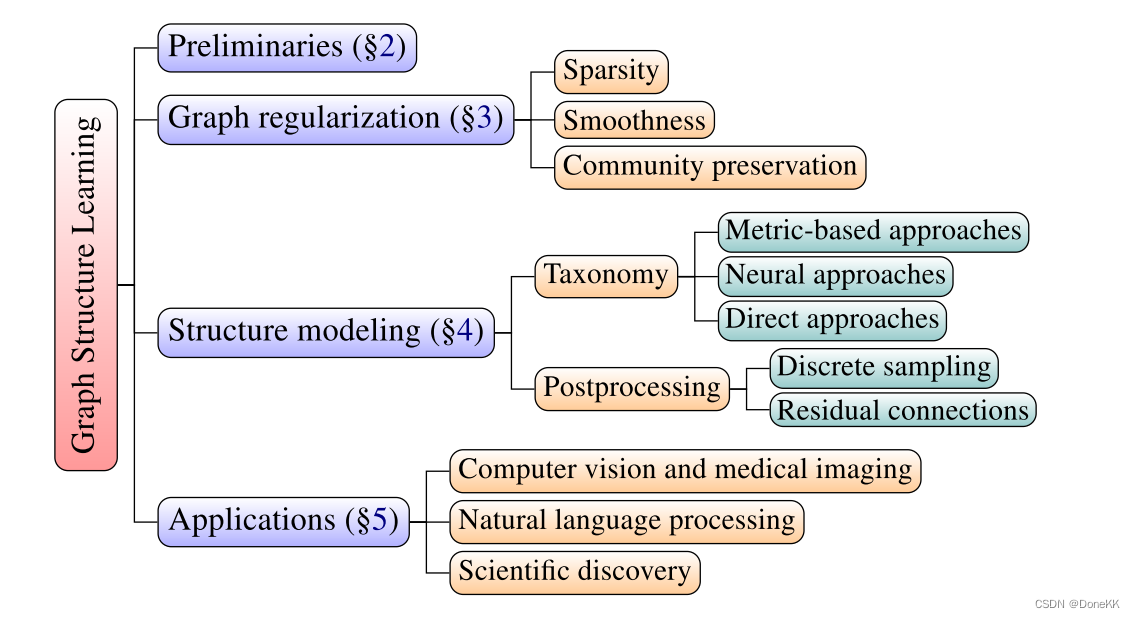

图神经网络的成功归功于它同时探索图结构和属性中的丰富信息,但是给定的图数据不可避免的会包含噪声和不完备,这样会阻碍GNN在现实问题中的应用。从表示学习的角度来讲,GNN是通过聚合邻居信息来学习节点表示的。这种迭代方式存在一个级联效果即当一个小的噪声传递给邻居节点后,许多其他的节点的表示质量也会下降。在一些工作中提到,对图结构的轻微攻击会导致GNN做出错误的预测。因此,对于GNN,高质量的图结构是必要的。文章结构如图

2、Preliminaries

G=(A,X)表示一个图,其中A为邻接矩阵,X为节点特征矩阵。图结构学习的目标是在给定一个图(可能不完备)后为确定的下游任务同时学习最优的邻接矩阵A*和对应的图表示Z。

graph generation目的是生成多个结构多样的图

graph learning目的是根据给定节点属性重建同质图的拉普拉斯矩阵

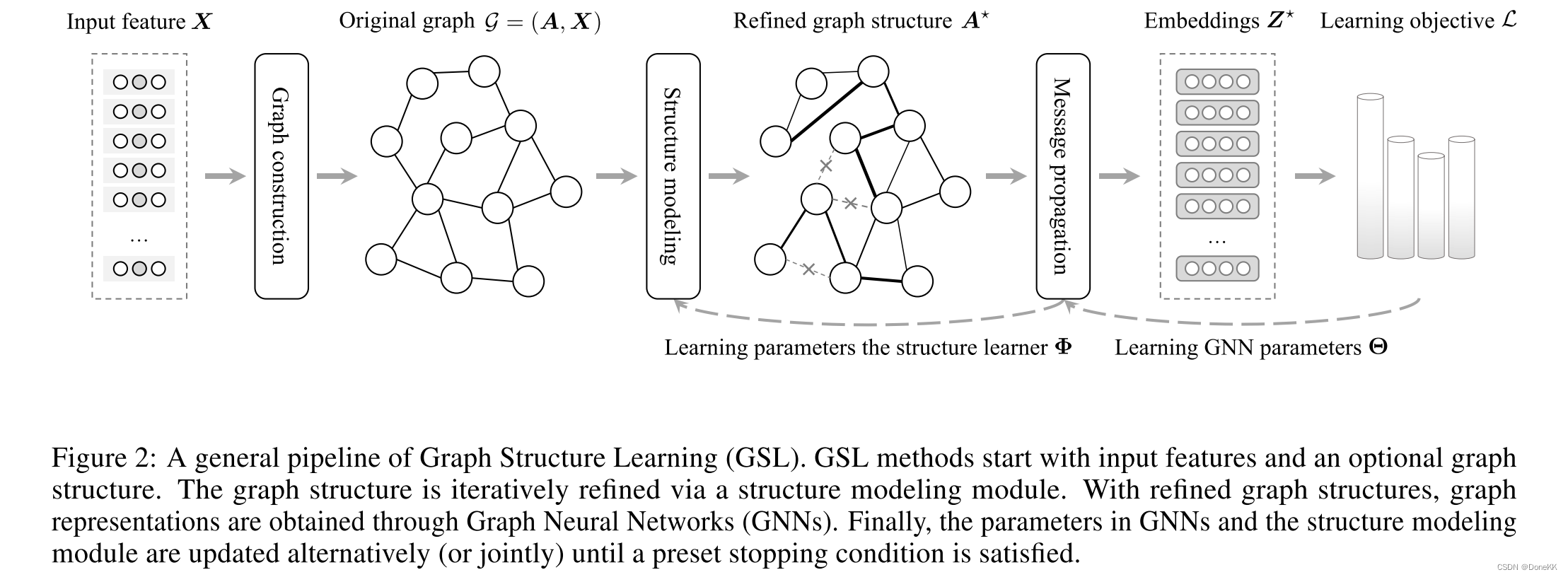

2.1 GSL pipline

经典的GSL模型包含两个部分:GNN编码器和结构学习器

1、GNN encoder输入为一张图,然后为下游任务计算节点嵌入

2、structure learner用于建模图中边的连接关系

现有的GSL模型遵从三阶段的pipline

1、graph construction

2、graph structure modeling

3、message propagation

2.1.1 Graph construction

如果数据集没有给定图结构,或者图结构是不完整的,我们会构建一个初始的图结构,构建方法主要有两种

1、KNN 构图

2、e-阈值构图

2.1.2 Graph structure modeling

GSL的核心是结构学习器。通过建模边的连接关系优化原始图。本文将现有的结构学习方法分为三类

1、Metric-based approaches:采用一个度量函数,输入节点对的嵌入来计算节点对之间的边的权重

2、Neural approaches:通过神经网络在给定节点表示条件下推测边的权重

3、Direct approaches:把邻接矩阵视作一个可学习的参数,在训练GNN是直接优化学习

不同于直接的方法,metric-based和neural approaches是通过一个参数化的网络来学习边的连接性的。输入节点的表示生成一个最优的关系矩阵A*。结构学习器生成的图结构还可以进一步采用一些后续的额外操作如离散采样等方法进一步获取最终的图结构。

2.1.3 Message propagation

在获得最优的图结构的领接矩阵A*,可以在该结构上使用图编码器聚合节点特征计算节点表示Z*。

3、Graph Regularization

我们希望得到的图满足一些性质,因此在介绍这些方法之前,先回顾一下三种图正则化(规范化)方法:

3.1 Sparsity

Sparsity:考虑到现实世界的图一般都是稀疏的,我们会要求得到的邻接矩阵是比较稀疏的,直观地,我们可以利用 L0 norm:,但是 L0 norm 是一个非凸问题(同时也是 NP-hard),通常我们会求其近似解 L1 norm,或者利用 continuous relaxation 进行求解。

3.2 Smoothness

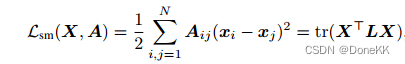

Smoothness:通常,我们会假设邻接节点的信号变化是平缓的,为了实现这一目的,通常最小化下面的式子:

通常进行联合优化。

3.3 Community Preservation

Community Preservation:现实生活中的图,不同拓扑集群中的节点往往有不同的标签。因此,跨越多个群落的边缘可以被视为噪声。从图谱理论我们知道,一个邻接矩阵的秩与该图中连通分量的数量有关,低秩图具有密集连通分量。为了去除潜在的噪声边缘并最好地保留社区结构,我们引入了低秩正则化。

4、Graph Structure Modeling

4.1 Model Taxonomy

4.1.1 Metric-based Approaches

这类方法会使用一些核函数用来计算节点对的相似度,并作为边权。常使用的核函数有

1、高斯核函数

2、内积

3、余弦相似度

4、扩散核函数

5、结合多种核函数。

4.1.2 Neural Approaches

和 metric-based 的方法不同,这类方法会使用神经网络来预测边权。除了使用简单的神经网络,还有许多工作利用 attention 来建模边权。最近有一些利用 transformer 的工作,它们和之前 GNN 的架构不一样,之前的方法都只考虑一阶邻接,然后通过堆叠实现多跳,但是 transformer 将所有的节点都视为邻居,将结构信息编码进 graph transformer,通过 attention 给边赋权,由于图数据的特殊性,位置和结构编码十分关键。

4.1.3 Direct Approaches

直接式方法是将目标图的邻接矩阵视作随机变量来学习的,并不依赖于节点的表示。大量的直接式方法使用图正则化来优化邻接矩阵的。这样显示的指定了最优图的属性。因为联合优化邻接矩阵和模型参数经常会引入不可导的操作,因此无法使用基于梯度的优化方法。一些工作将初始图结构和正则整合到混合的目标函数中,另外一些操作时整合低阶先验或者交替的优化邻接矩阵和学习参数。除了常见的正则器,GNNExplainer引入了一个基于互信息的可扩展的生成损失为最终任务识别最频繁的子图结构。还有一些工作是从概率的角度来建模邻接矩阵的即假设图的结构是从某个确定的分布中采样得到的。

4.2 Postprocessing Graph Structures

4.2.1 Discrete Sampling

GSL模型会使用一个采样步骤即假设提纯的图是从一个确定的离散分布中通过额外的采样过程生成的。不直接把邻接矩阵视作边的连接权重,而是采用额外的采样步骤恢复图的离散特性,给结构学习器更多的灵活性来控制最终图的属性如稀疏性。

需要注意的是从离散分布中采样是不可微的。除了先前在直接式方法中提到的特定优化方法外,我们讨论传统的梯度下降,通过使用复参数化方法允许梯度可以在采样操作中传递。一个常见的方法是Gumbel-Softmax,通过从Gumbel分布中采样生成不同的图。

4.2.2 Residual Connections

初始的图结构如果存在的话通常会在拓扑结构上携带一些先验信息。那么很自然就可以假设最优的图结构是从原始图中简单转化而来的。其中A为原始图结构,A~为学习到的图结构。

5、Applications

5.1 Natural language processing

在自然语言处理领域,GSL技术被广泛应用于获取细粒度语言表示,该技术通过将单词作为节点,并根据语义和句法模式连接它们来构建图结构。对于信息检索,Yu等人[2021]通过丢弃文档图中不重要的单词来学习分层查询-文档匹配模式。在关系提取中,Tian等人[2021]基于语言依赖树构造了一个图,并通过学习不同依赖关系的不同权重来细化结构。对于情感分析,Li等[2021a]通过计算单词表示之间的自我注意创建了语义图,并基于依赖树创建了语法图。然后,他们通过微分正则化器优化这两个图结构,使它们捕获不同的信息。在回答问题时,Yasunaga等人[2021]使用基于语言模型的编码器来学习每个节点的分数,以便在知识图中突出与问题最相关的路径。对于假新闻检测,Xu等[2022]提出了一种语义结构细化方案来区分有益片段和冗余片段,从而获得证明新闻真实性的细粒度证据。

5.2 Computer vision and medical imaging

在计算机视觉中,wDAE-GNN [Gidaris和Komodakis, 2019]使用类特征的余弦相似度创建图形,以捕获不同类之间的相互依赖关系,用于少镜头学习;DGCNN [Wang et al, 2019b]利用GSL恢复了点云数据的拓扑结构,从而丰富了对点云数据分类和分割的表示能力。将GSL应用于成像数据的另一个突出例子是场景图生成,其目的是学习物体之间的关系。Qi等人[2018]建议使用卷积作为结构学习器或用于时空数据集的卷积lstm。后一种方法提出了基于能量的目标,以合并场景图的结构[Suhail等人,2021]或推理过程中更一般的约束[Liu等人,2022a]。对于医学图像分析,GPNL [Cosmo等人,2020]利用基于度量的图结构建模来学习表示成对患者相似性的总体图,用于疾病分析。FBNetGen [Kan等人,2022]提出学习一种针对下游预测任务优化的功能性大脑网络结构。

5.3 Scientific discovery

在科学发现领域,例如生物学、化学,图结构通常是人为的,以表示系统内的结构化相互作用。例如,通过阈值对所有氨基酸的成对距离图构建蛋白质的图结构[Guo等人,2021;Jumper等,2021]。在这种情况下,在构建图形时通常忽略远程接触[Jain等人,2021]。

为了优化分子图的性质,我们需要学会对描述具有最佳性质的化合物的基本结构的分子骨架进行加权[Fu等人,2022]。类似地,在模拟小分子时很少考虑非键相互作用[Leach, 2001;Luo等,2021b;Satorras等,2021],这对于理解系统的关键机制可能具有重要意义。

图结构学习允许学习数据的更全面的表示,以最小的信息损失和科学发现的可解释性。

6、Challenges and Future Directions

1、不止同质图:现有的方法主要聚焦在同质图的结构生成,异质图的结构生成还是under exploration。

2、不止同配图:现有的方法大都在同配性假设下做的,然后在现实生活中存在大量异配图,比如化学分子图。设计不同的学习策略来学习异质图结构方面还有很大的发展空间。

3、在缺少 rich attributes 的时候如何学习图结构:在推荐系统中于经常遇到这类问题,节点的表征可能只有不具语义信息的id,我们如何在这样的数据集下学习到比较好的图结构。

4、缺少可扩展性:现在的大部分工作涉及到大量的 pairwise similarity 的计算,这会限制在大图上的使用。

5、任务无关的结构学习:现有的工作绝大多数都需要任务相关的监督信号进行训练。但是在现实生活中,收集高质量的标签往往是耗时的,而有限的监督会恶化学习到的图结构的质量。最近有一些自监督的工作在解决这类问题,在无标签的情况下,也能学到比较好的图结构

7、Words

1、Sparsity

①sparsity(稀疏性)是指在数据或矩阵中,绝大部分元素都是0或非常接近于0的现象。在数据或矩阵中,如果非零元素只占总元素的一小部分,那么这个数据或矩阵就是稀疏的。相反,如果非零元素占了绝大部分,那么这个数据或矩阵就是密集的。

②稀疏性在很多领域都非常重要,例如在机器学习中,许多算法都利用了数据的稀疏性来减少计算量和存储空间。例如,在自然语言处理中,文本数据往往是稀疏的,因为一个文本只包含很少的单词或短语。因此,为了降低计算复杂度,可以使用稀疏矩阵来表示文本数据。

③在计算机科学和数学领域,稀疏性也是一个非常重要的研究方向。例如,在矩阵分解和图处理中,稀疏性被广泛应用。通过利用稀疏性,可以大幅降低计算和存储的复杂度,提高算法的效率和可扩展性。

2、Smoothness

①Smoothness(平滑性)是指数据或函数在空间或时间上的变化率相对较小,变化较为缓慢的特征。在计算机科学和数学中,平滑性是一个非常重要的概念,广泛应用于信号处理、图像处理、优化、机器学习等领域。

②在机器学习中,平滑性通常指学习模型的参数或函数值变化相对较小的性质。平滑性在机器学习中被广泛用于正则化方法,例如L1和L2正则化。在L1正则化中,平滑性被表达为参数向量的L1范数,因为L1范数会将参数向量中的一些元素变成0,从而使模型更加稀疏。在L2正则化中,平滑性被表达为参数向量的L2范数,因为L2范数会将参数向量中的元素压缩到一个小范围内,从而使模型更加平滑。

③在图像处理中,平滑性通常指图像中像素值的变化相对较小的特征。平滑性在图像处理中被广泛用于平滑滤波器的设计,例如高斯滤波器和中值滤波器。在平滑滤波器中,像素值的平滑性被用于抑制图像中的噪声和细节信息,从而使图像更加清晰和易于分析。

④在优化中,平滑性通常指目标函数的变化率相对较小的性质。平滑性在优化中被广泛用于梯度下降等优化算法的设计,因为梯度下降算法需要目标函数是可导和平滑的。如果目标函数不是平滑的,那么梯度下降算法可能会陷入局部最优解或无法收敛

3、community preservation

①Community preservation(社区保护)是指在社交网络或复杂网络中保护和维护不同社区或群体之间的结构和关系。在社交网络或复杂网络中,每个节点都有自己的社区或群体归属,不同社区或群体之间的联系通常比较弱,而同一社区或群体内的节点之间联系通常比较紧密。

②社区保护是网络分析和图论中的一个重要研究方向。社区保护的目标是在网络中找到不同社区或群体,并保护不同社区或群体之间的结构和联系。社区保护在现实生活中有着广泛的应用,例如社交网络分析、推荐系统、广告投放、舆情分析等。

③在社交网络分析中,社区保护可以用于识别不同的社区或群体,从而可以更好地理解社交网络中的人际关系和社区结构。在推荐系统中,社区保护可以用于识别用户的兴趣爱好和偏好,从而可以更好地推荐相关的产品或服务。在广告投放中,社区保护可以用于针对不同社区或群体投放广告,从而可以更好地吸引目标受众。在舆情分析中,社区保护可以用于分析不同社区或群体的观点和情感,从而可以更好地了解公众的反应和态度。

4、Metric-based approaches

Metric-based approaches(基于度量的方法)是指一类机器学习算法,其中的学习过程依赖于度量学习(metric learning)方法。度量学习是一种通过学习距离度量函数来构建新的特征空间,从而提高数据分类或聚类效果的方法。

在度量学习中,度量函数被用来衡量两个数据点之间的距离或相似度,通常采用欧几里得距离、余弦相似度等常见距离度量函数。度量学习的目标是学习一个优秀的度量函数,使得相似的数据点之间的距离较小,而不相似的数据点之间的距离较大。通过学习距离度量函数,可以有效地提高机器学习任务的性能,例如图像分类、人脸识别、目标跟踪等。

①基于度量的方法通常包括以下步骤:

1、选择或学习一个距离度量函数,例如欧几里得距离或余弦相似度等。

2、通过度量函数计算数据点之间的距离或相似度,将数据映射到新的特征空间。

3、在新的特征空间中,使用分类器或聚类算法对数据进行分类或聚类。

②基于度量的方法通常具有以下优点:

1、可以减少特征维数,提高模型的泛化能力。

2、可以处理非线性关系和高维数据,提高模型的鲁棒性。

3、可以适应不同的任务和数据类型,具有广泛的应用场景。

常见的基于度量的方法包括K近邻算法(KNN)、支持向量机(SVM)、流形学习(manifold learning)等。

5、Neural approaches

Neural approaches(神经网络方法)是指一类机器学习算法,其中的学习过程依赖于神经网络模型。神经网络是一种模拟人脑神经元网络结构的计算模型,它可以通过大量的训练数据和反向传播算法来自动学习数据之间的关系,从而实现分类、回归、聚类等机器学习任务。

神经网络通常包括输入层、隐藏层和输出层。输入层接收原始数据,隐藏层通过一系列非线性变换将数据映射到新的特征空间,输出层对映射后的数据进行分类、回归等操作。

①神经网络方法通常具有以下优点:

1、可以处理大量复杂的非线性数据,具有很好的泛化性能。

2、可以通过分层的特征学习来自动提取数据的高层次特征,从而避免了手动特征提取的复杂性。

3、可以通过反向传播算法进行训练,从而实现端到端的自动化学习。

4、可以适应不同的任务和数据类型,具有广泛的应用场景。

常见的神经网络方法包括卷积神经网络(CNN)、循环神经网络(RNN)、长短时记忆网络(LSTM)、生成对抗网络(GAN)等。这些方法在图像识别、语音识别、自然语言处理、推荐系统等领域取得了很好的成果。

6、Direct approaches

Direct approaches(直接方法)是指一类图结构学习方法,它们通过直接对图结构进行建模和优化来学习节点的表示。与传统的基于特征工程的方法不同,直接方法不需要手动提取节点的特征,而是通过学习节点之间的关系来自动提取节点的特征,从而实现更加准确和高效的学习。

①直接方法通常包括以下步骤:

1、建立图结构:通过构建节点和边来建立图结构,可以使用邻接矩阵或邻接列表等方式表示。

2、学习节点表示:通过神经网络或其他学习算法,学习节点的低维向量表示,通常称为嵌入(embedding)。

3、应用:将节点的嵌入用于各种图结构学习任务,例如节点分类、链路预测、社区检测等。

②直接方法通常具有以下优点:

1、不需要手动提取节点的特征,减少了特征工程的复杂度。

2、能够处理大规模的复杂图结构,具有很好的泛化性能。

3、能够自适应地学习节点的表示,具有更强的适应性和灵活性。

常见的直接方法包括基于图卷积神经网络(GCN)、图注意力网络(GAT)、图自编码器(GAE)等。这些方法在节点分类、链路预测、社区检测、图表征学习等领域取得了很好的成果。

7、discrete sampling

在概率统计中,discrete sampling(离散采样)是指从离散概率分布中随机抽取一个样本的过程。离散分布是一种离散的概率分布,即随机变量只能取离散的取值。离散采样的过程是通过按照分布函数生成一个随机数,然后将该随机数与每个离散取值对应的概率进行比较,从而确定采样结果。

在机器学习中,离散采样常常用于生成模型中的采样过程,例如隐马尔可夫模型(HMM)、潜在狄利克雷分配(LDA)等。在这些模型中,离散采样被用来生成隐含状态或主题,从而实现对数据的建模和分析。

离散采样通常涉及到一些常用的概率分布,例如伯努利分布、多项式分布、泊松分布等。常见的离散采样算法包括逆变换采样、拒绝采样、重要性采样等。

8、Residual connections

Residual connections(残差连接)是一种在深度神经网络中广泛应用的技术。它的作用是在网络的不同层之间建立直接的连接,从而使得信息可以更加快速地在网络中传递,同时可以有效地缓解梯度消失和梯度爆炸等问题。

Residual connections的核心思想是通过将网络的输入直接连接到网络的输出上,将网络的变化量与输入保持一致,从而使得网络可以更加容易地学习到残差。在深层网络中,由于网络层数的增加,信号会经过多次的非线性变换,会导致信号的弱化或消失。而残差连接可以使得信号可以直接在网络中传递,从而避免了信号的丢失。

具体来说,Residual connections是通过在网络中添加shortcut connections(快捷连接)来实现的。在每个残差块(residual block)中,输入信号被首先传递到一个子网络中进行变换,然后与输入信号进行相加操作,最后输出到下一层网络中。因此,残差块的输出可以表示为:

y=x+F(x)

其中 x \mathbf{x} x是输入信号, F \mathcal{F} F是残差块中的变换操作, y \mathbf{y} y是输出信号。这种直接连接的方式可以有效地加速信息的传递,使得网络可以更加容易地学习到残差。在实践中,Residual connections已经被广泛应用于各种深度神经网络的设计中,例如ResNet、DenseNet等。