说明:这是一个机器学习实战项目(附带数据+代码+文档+视频讲解),如需数据+代码+文档+视频讲解可以直接到文章最后获取。

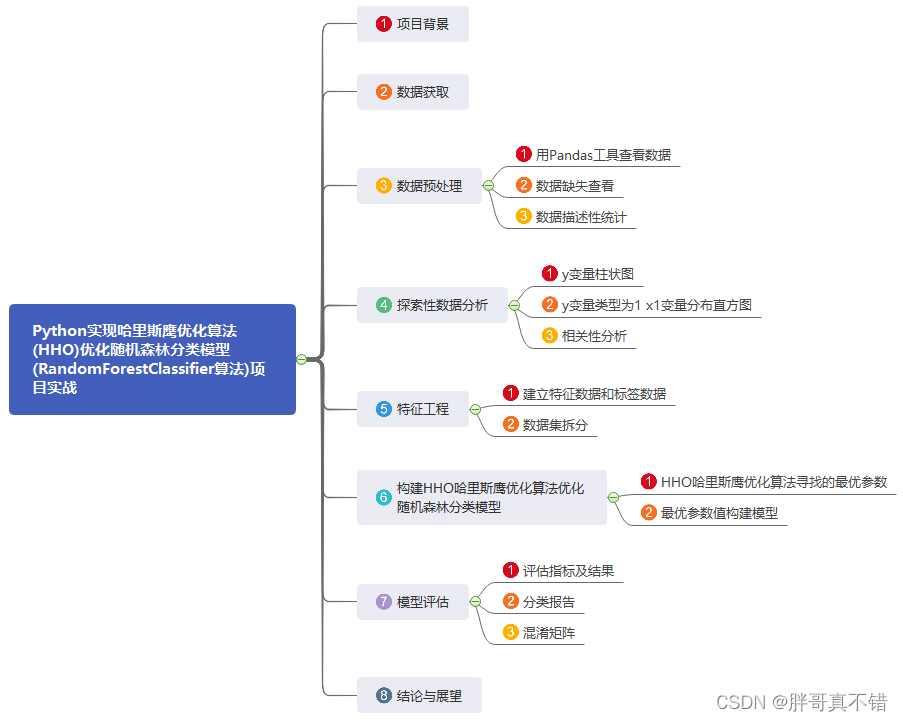

1.项目背景

2019年Heidari等人提出哈里斯鹰优化算法(Harris Hawk Optimization, HHO),该算法有较强的全局搜索能力,并且需要调节的参数较少的优点。

本项目通过HHO哈里斯鹰优化算法寻找最优的参数值来优化随机森林分类模型。

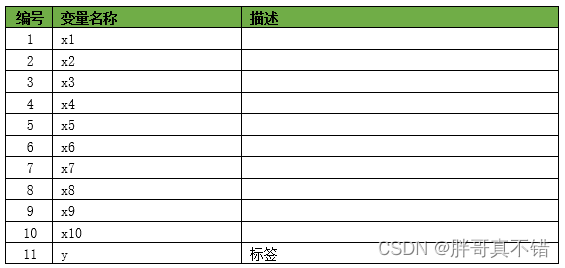

2.数据获取

本次建模数据来源于网络(本项目撰写人整理而成),数据项统计如下:

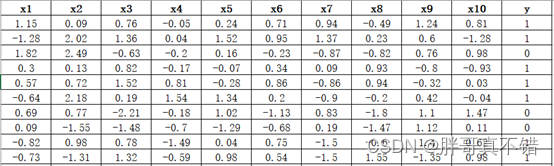

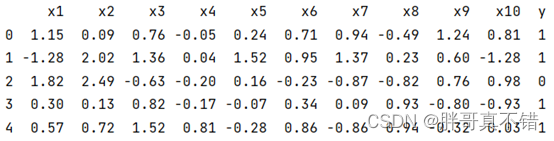

数据详情如下(部分展示):

3.数据预处理

3.1 用Pandas工具查看数据

使用Pandas工具的head()方法查看前五行数据:

关键代码:

3.2数据缺失查看

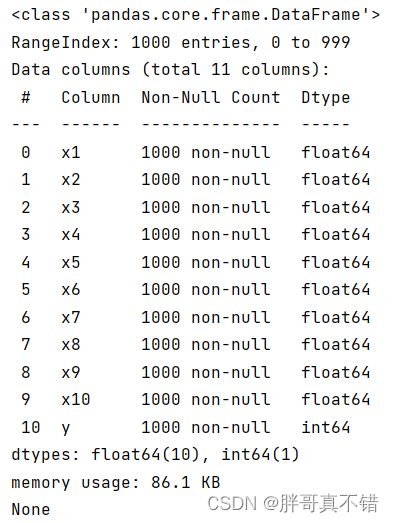

使用Pandas工具的info()方法查看数据信息:

从上图可以看到,总共有11个变量,数据中无缺失值,共1000条数据。

关键代码:

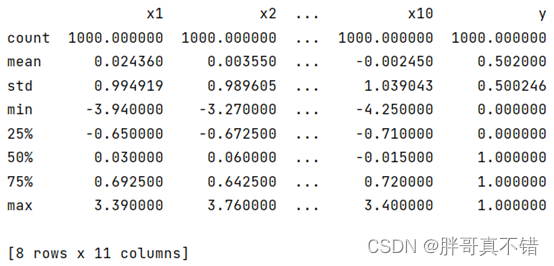

3.3数据描述性统计

通过Pandas工具的describe()方法来查看数据的平均值、标准差、最小值、分位数、最大值。

关键代码如下:

4.探索性数据分析

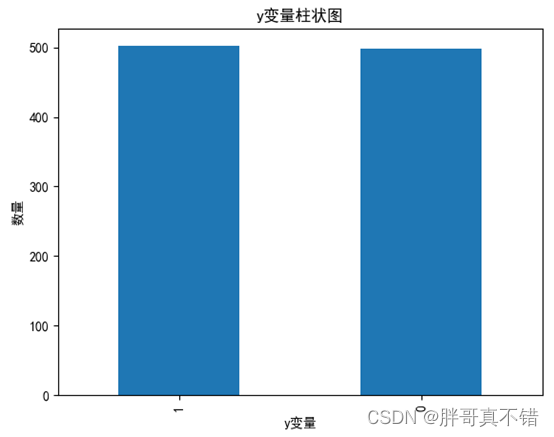

4.1 y变量柱状图

用Matplotlib工具的plot()方法绘制直方图:

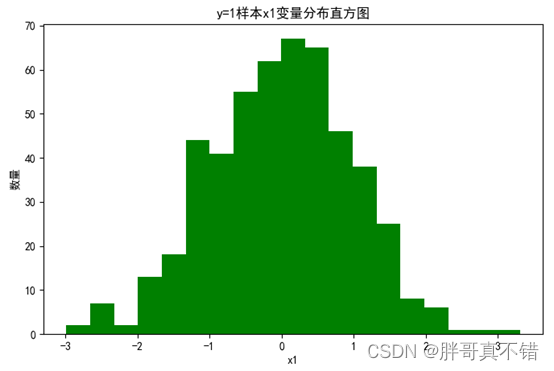

4.2 y=1样本x1变量分布直方图

用Matplotlib工具的hist()方法绘制直方图:

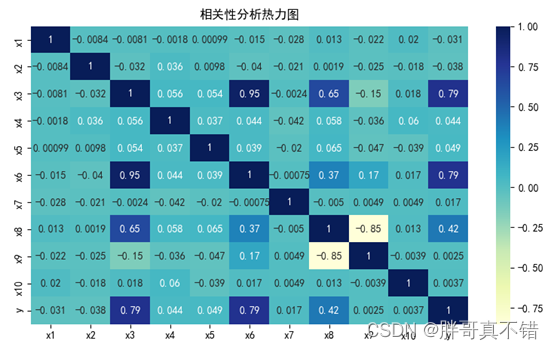

4.3 相关性分析

从上图中可以看到,数值越大相关性越强,正值是正相关、负值是负相关。

5.特征工程

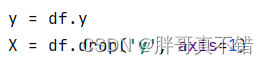

5.1 建立特征数据和标签数据

关键代码如下:

5.2 数据集拆分

通过train_test_split()方法按照80%训练集、20%测试集进行划分,关键代码如下:

![]()

6.构建HHO哈里斯鹰优化算法优化随机森林分类模型

主要使用HHO哈里斯鹰优化算法优化随机森林分类算法,用于目标分类。

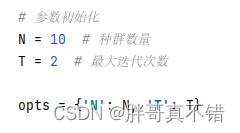

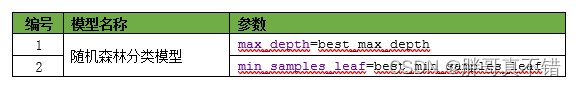

6.1 HHO哈里斯鹰优化算法寻找的最优参数

关键代码:

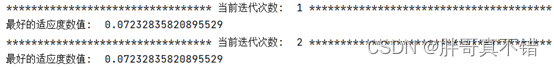

每次迭代的过程数据:

最优参数:

6.2 最优参数值构建模型

7.模型评估

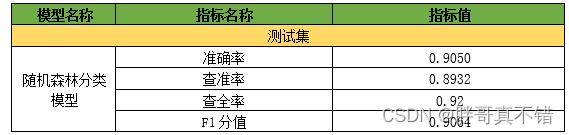

7.1 评估指标及结果

评估指标主要包括准确率、查准率、查全率、F1分值等等。

从上表可以看出,F1分值为0.9064,说明模型效果较好。

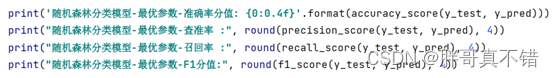

关键代码如下:

7.2 分类报告

从上图可以看出,分类为0的F1分值为0.90;分类为1的F1分值为0.91。

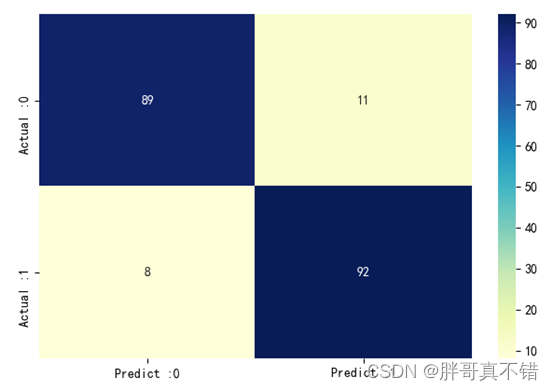

7.3 混淆矩阵

从上图可以看出,实际为0预测不为0的 有11个样本;实际为1预测不为1的 有8个样本,整体预测准确率良好。

8.结论与展望

综上所述,本文采用了HHO哈里斯鹰优化算法寻找随机森林分类模型的最优参数值来构建分类模型,最终证明了我们提出的模型效果良好。此模型可用于日常产品的预测。

# Sigma计算赋值

nume = math.gamma(1 + beta) * np.sin(np.pi * beta / 2) # 计算

deno = math.gamma((1 + beta) / 2) * beta * 2 ** ((beta - 1) / 2) # 计算

sigma = (nume / deno) ** (1 / beta) # Sigma赋值

# Parameter u & v

u = np.random.randn(dim) * sigma # u参数随机赋值

v = np.random.randn(dim) # v参数随机赋值

# 计算步骤

step = u / abs(v) ** (1 / beta) # 计算

LF = 0.01 * step # LF赋值

# ******************************************************************************

# 本次机器学习项目实战所需的资料,项目资源如下:

# 项目说明:

# 链接:https://pan.baidu.com/s/1c6mQ_1YaDINFEttQymp2UQ

# 提取码:thgk

# ******************************************************************************

# 定义目标函数

def Fun(X_train, y_train, X_test, y_test, x, opts):

# 参数

alpha = 0.99 # 赋值

beta = 1 - alpha # 赋值

# 原始特征数

max_feat = len(x)

# 选择特征数

num_feat = np.sum(x == 1)

# 无特征选择判断

if num_feat == 0: # 判断

cost = 1 # 赋值

else:

# 调用错误率计算函数

error = error_rate(X_train, y_train, X_test, y_test, x, opts)

# 目标函数计算

cost = alpha * error + beta * (num_feat / max_feat)

return cost # 返回数据

更多项目实战,详见机器学习项目实战合集列表:

机器学习项目实战合集列表_机器学习实战项目_胖哥真不错的博客-CSDN博客