IMGpedia: A Linked Dataset with Content-Based Analysis of Wikimedia Images

ps:(IMGpedia: 2017年5月6日向公众发布)

1.摘要

IMGPedia是一个大规模的链接数据集,包含来自Wikimedia Commons数据集的图像的视觉信息:它汇集了1500万图像的视觉内容描述符、这些图像之间的4.5亿个视觉相似关系、与DBpedia Commons中的图像元数据相链接,以及与单个图像关联的DBpedia资源相链接。在本文中,描述了IMGpedia 数据集的创建,概述了其模式及其内容的统计信息,提供了结合图像语义和视觉信息的示例查询,并讨论了该数据集的其他设想用例。

2.文章目录结构

3.介绍(Introduction)

此部分内容大致看看就好

许多数据集已经按照语义Web标准和链接数据原则发布在Web上。在由此产生的“数据网”的核心,可以找到

- 链接的数据集,如DBpedia(其中包含从Wikipedia自动提取的结构化数据),还有WIKIDATA(它允许用户直接以结构化格式添加和管理数据)。

- 与多媒体相关的各种数据集,如描述电影的LINKEDMDB、描述乐队和流派的BBC MUSIC等等。最近,DBpedia Commons发布了从Wikimedia Commons中提取的元数据,其中的Wikimedia Commons是一个丰富的多媒体资源,包含3800万个可自由使用的媒体文件(图像、音频和视频)。

相关工作:在描述多媒体的可用数据集中,重点是捕获多媒体文件的高级元数据(例如,作者、创建日期、文件大小、宽度、持续时间),而不是多媒体内容本身的音频或视频特征。然而,在之前的相关工作中提到,将结构化元数据与基于多媒体内容的描述符相结合可能会带来多种应用,例如语义增强多媒体发布、检索、保存等。虽然这些工作已经提出了以语义Web格式描述多媒体文件音频或视频内容的方法,但我们不知道有任何包含基于内容的多媒体文件描述符的公共链接数据集。例如,DBpedia commons 没有直接从Wikimedia Commons的多媒体文件中提取任何音频/视频特征,而是只从描述文件的文档中捕获元数据。

贡献:沿着这些思路,创建了IMGPedia:一个链接的数据集,它包含了Wikimedia Commons图像的视觉描述符和视觉相似关系,它与DBpedia Commons数据集(为图像提供元数据,如作者、许可证等)和DBpedia数据集(提供有关与图像关联的资源的元数据)相链接。

4.图像分析(Image Analysis)

这一部分主要弄清楚三个问题:

- 图像从哪来?

- 获得了图像后怎么计算描述符?

- 描述符又可以用来做什么?具体实现的过程又是什么?

-

首先是图像来源

其实和上篇文章(IMGpedia: Enriching the Web of Data with Image Content Analysis)一样,都是从WIKIMEDIA COMMONS数据集中下载,总共下载了21TB,用了40天时间; -

在获取图像后,继续计算不同的视觉描述符,它们是高维向量,用于捕获图像内容的不同元素(例如颜色分布或形状/纹理信息)。需要计算的视觉描述符有:Gray Histogram Descriptor(灰度直方图描述符GHD)、Histogram of Oriented Gradients Descriptor(定向梯度直方图描述符HOG)、以及Color Layout Descriptor(颜色布局描述符CLD),这些描述符的计算在Debian 4.1.1:一个2.2 GHz 24-core Intel® Xeon® 120GB of RAM.的处理器上执行,分别花费了43h、107h和127h;(插一嘴,其实这里的描述符计算和上一篇文章的一样,写下来印象深刻点…)

-

然后,将使用这些描述符来计算图像之间的视觉相似性,如果描述符之间的距离较低,则两个图像在视觉上相似;具体步骤:

step1 : 为了避免 P(n,2)蛮力比较,使用近似搜索法,根据每个视觉描述符计算每个图像的10个最近邻;step2 : 将图像分成16个存储桶,其中对于每个图像,初始化16个线程以搜索每个存储桶中的10个最近邻居;

step3 : 执行结束时,有 160 个候选作为全局 10 个最近邻,因此选择其中距离最小的 10 个以获得最终结果。

这一整个过程使用上述硬件设备(120GB of RAM.的处理器上)来完成大概花费13小时。

5.本体和数据(Ontology and Data)

图像的视觉描述符和相似性关系形成了IMGpedia数据集的核心,为了将这些关系表示成RDF,建立一个自定义的轻量型的IMGpedia本体,如下图所示:

An imo: Image 是一种抽象资源,表示Wikimedia Commons数据集的图像,描述图像(高度和宽度)的维度、Wikimedia Commons中的图像URL,和指向DBpedia Commons中补充资源的owl:sameAs 链接;

An imo: Descriptor(描述符):通过imo:descripes关系与图像链接。为了保证输出三元组数量的可控性,将描述符的向量存储为字符串;将单个维度存储为 (192-288) 个单个对象会使输出三元组膨胀到无法管理的数量;另外,不预期对描述符的各个值进行SPARQL 查询;

An imo: ImageRelation(图像关系):虽然曼哈顿距离是对称的,但这些关系是基于k近邻(k-nn)搜索实现的,k-nn中,图像a是图像b的k近邻并不意味a和b有着反向关系;因此,图像关系捕获源和目标图像,其中目标位于源的k近邻中。我们还添加了从源图像到目标 k-nn 图像的 imo:similar 关系。

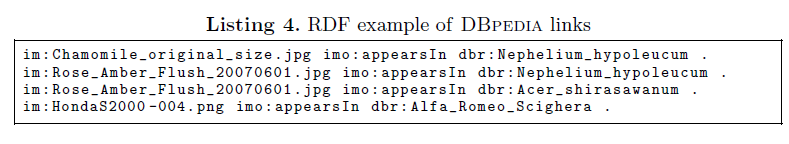

最后,除了指向DBpedia Commons的链接外,我们还提供指向DBpedia的链接,该链接为图像提供了上下文。为了创建这些链接,我们使用English Wikipedia的SQL转储,并在所有图像的表和所有文章的表之间执行联接,因此如果图像出现在文章中,我们可以有(image_name,article_name)对。在下表清单4中,给出了DBpedia的一些示例链接,而DBpedia commons 中不提供此类链接。

6.用例(提供一些IMGpedia可以回答的查询示例:)

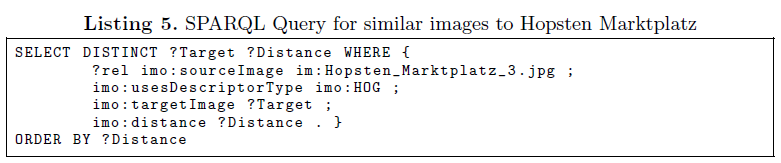

用例一:可以查询视觉相似关系,根据最近邻计算找到颜色、边缘和/或强度相似的图像; 例如,使用HOG描述符(捕获边缘的视觉相似性)请求Hopsten Marktplatz图像的最近邻居。查询语句与查询结果分别如下:

用例二:可以使用联邦SPARQL查询执行图像的视觉语义检索,通过链接到DBpedia将图像的视觉相似性与语义元数据结合起来;在清单6中,展示了一个使用DBpedia SPARQL端点的联邦SPARQL查询示例,该端点从分类为“欧洲罗马天主教大教堂”的文章中获取图像,并从分类为“博物馆”的文章中查找类似图像。在图3中,展示出了检索到的图像。为了获得更准确的结果,可以使用SPARQL属性路径来包括层次分类,例如,dcterms:subject/skos:broader* 可用于第一个 SERVICE 子句中获取所有标记为欧洲大教堂子类别的大教堂,例如法国大教堂 。

7.总结

在本文中,介绍了IMGpedia:一个链接数据集,为Wikimedia Commons的图像提供视觉描述符和相似关系;该数据集还与DBpedia和DBpedia commons链接,以提供语义上下文和进一步的元数据。描述了数据集的构造、数据的结构和来源、数据集的统计信息以及可用的支持资源。最后,展示了一些由数据集支持的可视化语义查询示例,并讨论了潜在的用例。