前言

作为当前先进的深度学习目标检测算法YOLOv8,已经集合了大量的trick,但是还是有提高和改进的空间,针对具体应用场景下的检测难点,可以不同的改进方法。此后的系列文章,将重点对YOLOv8的如何改进进行详细的介绍,目的是为了给那些搞科研的同学需要创新点或者搞工程项目的朋友需要达到更好的效果提供自己的微薄帮助和参考。由于出到YOLOv8,YOLOv7、YOLOv5算法2020年至今已经涌现出大量改进论文,这个不论对于搞科研的同学或者已经工作的朋友来说,研究的价值和新颖度都不太够了,为与时俱进,以后改进算法以YOLOv7为基础,此前YOLOv5改进方法在YOLOv7同样适用,所以继续YOLOv5系列改进的序号。另外改进方法在YOLOv5等其他算法同样可以适用进行改进。希望能够对大家有帮助。

一、解决问题

清华团队提出了一种新颖的局部注意力模块Slide Attention,它利用常见的卷积操作实现高效性、灵活性和通用性。对此前SEnet注意力机制进行了升级改进。提升目标检测效果。

二、基本原理

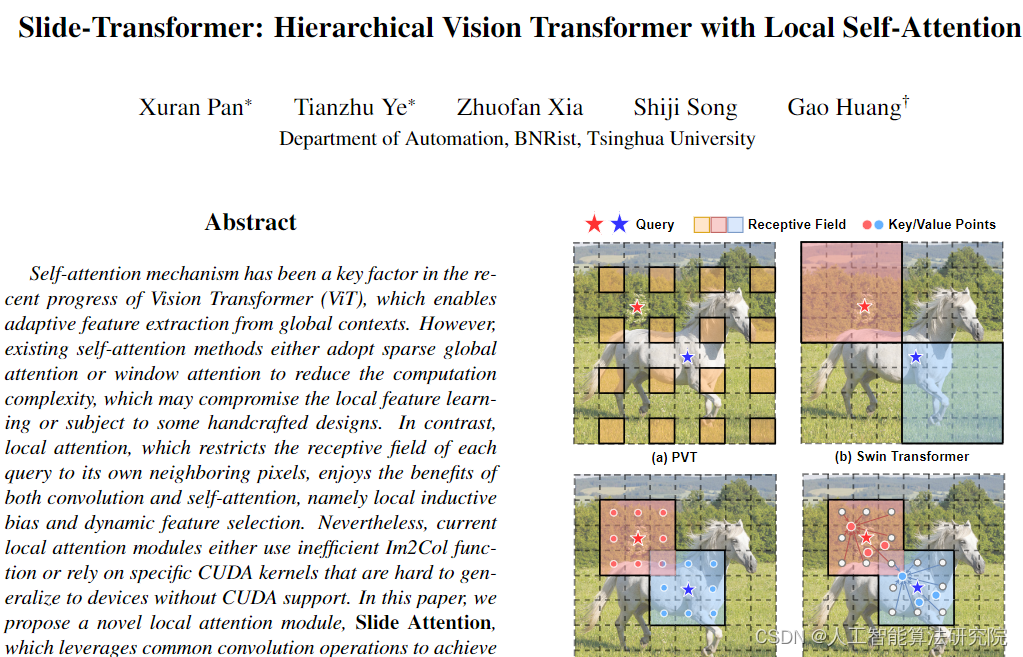

Paper:Slide-Transformer: Hierarchical Vision Transformer with Local Self-Attention

Code:https://github.com/LeapLabTHU/Slide-Transformer

摘要:自注意机制一直是视觉转换器(ViT)进步的关键因素,它能够从全局上下文中进行自适应特征提取。然而,现有的自注意方法要么采用稀疏全局注意,要么采用窗口注意来降低计算复杂度,这可能会影响局部特征学习,或者受到一些手工设计的影响。相比之下,局部注意力将每个查询的感受野限制在其自己的相邻像素,它同时享受卷积和自注意力的好处,即局部归纳偏差和动态特征选择。尽管如此,当前的局部注意力模块要么使用效率低下的Im2Col功能,要么依赖于特定的CUDA内核,这些内核在没有CUDA支持的情况下很难扩展到设备。在本文中,我们提出了一种新的局部注意力模块Slide attention,它利用常见的卷积运算来实现高效率、灵活性和可推广性。具体来说,我们首先从一个新的基于行的角度重新解释基于列的Im2Col函数,并使用Depthwise卷积作为一种有效的替代。在此基础上,我们提出了一种基于重新参数化技术的变形移位模块,该模块进一步放宽了局部区域中变形特征的固定键/值位置。通过这种方式,我们的模块以高效和灵活的方式实现了局部注意力范式。大量实验表明,我们的幻灯片注意力模块适用于各种先进的视觉转换器模型,并可与各种硬件设备兼容,并在综合基准上实现了持续改进的性能。

摘要:自注意机制一直是视觉转换器(ViT)进步的关键因素,它能够从全局上下文中进行自适应特征提取。然而,现有的自注意方法要么采用稀疏全局注意,要么采用窗口注意来降低计算复杂度,这可能会影响局部特征学习,或者受到一些手工设计的影响。相比之下,局部注意力将每个查询的感受野限制在其自己的相邻像素,它同时享受卷积和自注意力的好处,即局部归纳偏差和动态特征选择。尽管如此,当前的局部注意力模块要么使用效率低下的Im2Col功能,要么依赖于特定的CUDA内核,这些内核在没有CUDA支持的情况下很难扩展到设备。在本文中,我们提出了一种新的局部注意力模块Slide attention,它利用常见的卷积运算来实现高效率、灵活性和可推广性。具体来说,我们首先从一个新的基于行的角度重新解释基于列的Im2Col函数,并使用Depthwise卷积作为一种有效的替代。在此基础上,我们提出了一种基于重新参数化技术的变形移位模块,该模块进一步放宽了局部区域中变形特征的固定键/值位置。通过这种方式,我们的模块以高效和灵活的方式实现了局部注意力范式。大量实验表明,我们的幻灯片注意力模块适用于各种先进的视觉转换器模型,并可与各种硬件设备兼容,并在综合基准上实现了持续改进的性能。

三、添加方法

相关代码如下:具体改进方法,关注后私信。

四、总结

预告一下:下一篇内容将继续分享深度学习算法相关改进方法。有兴趣的朋友可以关注一下我,有问题可以留言或者私聊我哦

PS:该方法不仅仅是适用改进YOLOv5,也可以改进其他的YOLO网络以及目标检测网络,比如YOLOv7、v6、v4、v3,Faster rcnn ,ssd等。

最后,有需要的请关注私信我吧。关注免费领取深度学习算法学习资料!