说明该总结主要是针对自动驾驶

《Simultaneous Localization And Mapping: A Survey of Current Trends in Autonomous Driving》。

1 引言

SLAM问题被认为是实现真正自主机器人的关键之一,因此是自动驾驶汽车的一个重要方面。然而,许多问题仍然阻碍着将SLAM算法用于应该能够在非常不同的条件下行驶数百公里的车辆。最后一条陈述包含了在处理自动驾驶汽车的SLAM时出现的两个主要问题:定位往往会随着时间的推移而漂移,并且地图不一定在每种驾驶条件下都是可行的。前一个问题在SLAM社区中是众所周知的。随着行进距离的增加,SLAM算法给出的局部和增量定位估计趋于偏离真实轨迹。在没有先验知识或绝对信息的情况下,几乎不可能确保正确定位几公里。这导致了第二个问题,即无论条件如何,地图都足以完成定位任务。地图绘制方面最近引起了很多关注,其目的是提供必要的信息以在不同的季节、天气或交通条件下定位车辆。已经设想了许多解决方案来解决这两个问题,例如通过仔细选择独特信息来构建地图,以便以后重新使用它或利用新的通信系统来共享和增强其他道路用户构建的地图。

2 SLAM问题

SLAM问题由Smith和Cheeseman[1]于1986年发起,在1990年代随着许多结构化工作(如[2]或[3])而流行起来。多年来,出现了使用不同传感器(相机、激光、雷达等)的新方法,创建了新的数据表示形式,从而产生了新的地图类型。同样,在SLAM领域也出现了各种估计技术。10年前在[4]和[5]中制作了一张快速全景图。寻求全局SLAM问题的读者也可以参考[6]和[7]来全面介绍该主题,并参考[8]来全面了解SLAM当前面临的挑战。

SLAM方法需要广泛的算法来确保所提供定位的鲁棒性。因此,传感器数据提取、原始搜索[9]、数据关联[10]或地图存储和更新[11]也是与SLAM相关主题的一部分。然而,在这篇文献综述中,我们将首先关注现有的主要估计方法,然后再介绍自动驾驶汽车应用领域的当前趋势。

SLAM问题通常以概率方式给出。整个目标是能够同时估计车辆的状态和正在构建的地图。车辆状态可以根据应用进行不同的定义:2D位置和方向、6D姿态、速度、加速度等。我们将xk表示为时间k的车辆姿态估计,m表示环境地图。为了估计这些变量,可以利用我们所说的控制输入uk,它表示对k-1和k之间的运动的估计。它们通常来自车轮编码器或任何能够初步了解位移的传感器。SLAM方法的特殊性是考虑来自传感器读数并表示为zk的测量值。它们有助于构建和改进地图,并间接地估计车辆姿态。

SLAM问题可以用两种方式表述。在第一个中,目标是在给定所有控制输入和所有测量值的情况下估计车辆的整个轨迹和地图。图形表示可以在图1中看到。这个被称为完整SLAM的问题,根据整个传感器数据计算所有姿势和地图的联合后验:

![]()

完整的SLAM问题可能难以实时处理,因为问题的复杂性随着所考虑变量的数量而增加。在线SLAM的思想是估计车辆的当前位置,通常基于最后的传感器信息。图形表示如图2所示。问题的增量性质可以使用贝叶斯规则获得:

估计技术可以分为两大类:基于过滤器的方法和基于优化的方法。前者对应于迭代过程,因此适用于在线SLAM,而后者重新组合了执行批处理的方法,因此通常用于解决完整的SLAM问题,即使这种趋势在过去十年中发生了变化。

A 基于滤波的SLAM

基于过滤器的方法源自贝叶斯过滤,并作为两步迭代过程工作。

第一步,使用演化模型和控制输入uk对车辆和地图状态进行预测。

在第二步中,来自传感器数据的当前观测值zk与地图进行匹配,以提供对先前预测状态的校正。将观察与地图相关联的模型称为观测模型。

这两个步骤迭代并因此增量集成传感器数据以估计车辆姿态和地图。

1)扩展卡尔曼滤波器

基于滤波器的方法的第一个分支涉及卡尔曼滤波器(KF)[12]的相关延伸方法。这些基于卡尔曼滤波器的方法首先假设数据受到高斯噪声的影响,这在我们的例子中不一定是正确的。就其基本形式而言,KF旨在处理线性系统,虽然它们具有很好的收敛性[13][14],但它们很少用于SLAM。另一方面,扩展卡尔曼滤波器(EKF)[15]是非线性滤波和SLAM中的常用工具。EKF为非线性模型添加了线性化步骤。通过一阶泰勒展开围绕当前估计执行线性化。只要围绕状态向量的真实值进行线性化,就已经证明了EKF的最优性。在实践中,它是要估计的值,因此不可用。这可能会导致一致性问题:真实值可能超出估计的不确定性[16][17]。

KF适合处理线性系统,对于slam不适用

卡尔曼滤波(Kalman filter)

- 一种利用线性系统状态方程,通过系统输入输出观测数据,对系统状态进行最优估计的算法。由于观测数据中包括系统中的噪声和干扰的影响,所以最优估计也可看作是滤波过程。

- 线性系统的卡尔曼滤波方法:

运动方程和观测方程都是线性方程,卡尔曼滤波假设了马尔可夫性,我们知道了k-1时刻的后验分布估计当前时刻的后验分布。可以分为一下几步:

第一步:利用k-1的均值和协方差预测当前时刻的先验均值跟协方差

第二步:利用先验的均值和协方差的卡尔曼增益稀疏

第三步:更新后验的均值和协方差- 一般SLAM系统不是线性系统,我们一般将系统做运动方程在k-1时刻的一阶泰勒展开,将观测方程在预测出的k时刻先验处一阶泰勒展开近似为线性系统,计算步骤跟线性系统一致。

- EKF的局限性:

- 假设了马尔可夫性,当前数据可能跟之前的数据有关。

- EKF在距离工作点的地方一阶泰勒展开可能不准,只相当于进行了一次迭代更新,没有优化的方法准,优化是每优化一次再在优化之后的点处展开。

- 需要存储状态量的均值和协方差,存储量太大,不适合大型场景。

- EKF系统没有异常检测机制,遇到异常值可能会发散。

拓展:EKF(扩展卡尔曼滤波)把卡尔曼滤波扩展到非线性系统中,通常的做法是,在某个点附近考虑运动方程及观测方程的一阶泰勒展开,只保留一阶项,即线性的部分,然后按照线性系统进行推导。

EKF和BA的区别:

(1)EKF假设了马尔可夫性,k时刻的状态只与k-1时刻有关。

(2)非线性优化使用所有的历史数据,全局slam。

(3)EKF做了线性化处理,在工作点处用一阶泰勒展开式近似整个函数,工作点较远处不一定成立。(4)非线性优化每迭代一次,状态估计发生改变,会对新的估计点做泰勒展开。

- 总而言之,EKF可被看作是只有一次迭代的BA。

然而,大多数情况下,估计值足够接近事实以允许使用EKF。例如,提供范围信息的传感器(例如激光扫描仪)特别适用[18][19]。声纳是最早用于水下应用的EKF SLAM方法之一[20][21]。在[22]中,这两种传感器都结合在EKF SLAM方法中。在[23]中也提出了视觉和激光的耦合。单眼方法也得到了广泛的研究。在[24]中,只有在足够准确的情况下,构成地图的地标才会插入到EKF中。在[25]中,提出了一种特定的地标参数化。在[26]中,作者研究了卡尔曼增益对更新的影响,以限制线性化误差。

估计值足够接近事实以允许使用EKF

[22] P. Newman, J. Leonard, J. D. Tard´os, and J. Neira, “Explore and return:Experimental validation of real-time concurrent mapping and localization,” in Proc. IEEE Int. Conf. Robot. Autom., 2002, vol. 2, pp. 1802–1809.

[23] P. Newman, D. Cole, and K. Ho, “Outdoor SLAM using visual appearance and laser ranging,” in Proc. IEEE Int. Conf. Robot. Autom., 2006,pp. 1180–1187.

[24] A. J. Davison, “Real-time simultaneous localisation and mapping with a single camera,” in Proc. IEEE Int. Conf. Comput. Vis., 2003, pp. 1403–1410.

[25] J. Montiel, J. Civera, and A. J. Davison, “Unified inverse depthparametrization for monocular SLAM,” in Proc. Robot., Sci. Syst.,2006, p. 8.

[26] G. Bresson, T. F´eraud, R. Aufr`ere, P. Checchin, and R. Chapuis, “Realtime monocular SLAM with low memory requirements,” IEEE Trans.Intell. Transp. Syst., vol. 16, no. 4, pp. 1827–1839, Aug. 2015.

不断增长的地图大小使得EKF无法支持大规模SLAM,因为更新时间以二次方式取决于状态向量的大小。为了克服这个问题,创建了子图的概念。每次地图变得太大时(可以使用各种标准来决定),新的空白地图会替换旧地图。更高级别的地图跟踪子地图之间的链接,以免丢失信息。在第一个基于子图的方法中,我们可以引用[27]的约束相对子图过滤器,其中子图彼此去相关,但很难执行闭环(基于对先前访问过的地方识别的漂移校正)。恒定时间SLAM[28]和网络耦合特征图[29]以类似的方式工作,只是保留了子图之间共有的地标以简化从一个到另一个的变化,但这些方法忽略了相关数据。Atlas框架[30]利用了一个图结构,其中节点是子图,顶点是两个子图之间的转换。闭环只能离线应用。埃斯特拉达等人通过维护两个高级地图[31]来解决这个问题,但仍然在多个子地图中使用地标。[32]中提出了条件独立的子图作为该问题的解决方案。这个想法是边缘化两个子图不共有的信息,以便在给定公共部分的情况下使它们独立。在[33]中选择了一种不同的方法。提出了一种分而治之的方法来加入创建的局部地图以恢复精确的全局地图。还提出了决定何时创建子图的新标准,例如[34]中同时可观察的地标的数量或[35]中地标之间的相关性。子图的替代方案,压缩EKF SLAM,已在[19]中提出。在这项工作中,状态向量被分为一个活跃的(和更新的)部分和另一个被压缩成一个光辅助系数矩阵的部分。

2)Unscented Kalman 滤波器

为了补偿具有高度非线性系统的EKF的弱点,Julier等人引入了无迹卡尔曼滤波器(UKF)[36],它避免了雅可比行列式的计算。这个想法是对称为sigma点的粒子进行采样,由于似然函数,这些粒子在预期值周围进行了思考。然后将这些sigma点传递给非线性函数并重新计算估计值。这种方法的主要缺点是它的计算时间。大多数使用UKF的工作发生在2000年代初期[37][38]。在[39]中已经证明了对单目情景中的实时应用。

3)信息滤波器

卡尔曼滤波器的另一个变体是信息滤波器(IF)[40],它是卡尔曼滤波器的逆形式。其特殊性是将信息矩阵定义为协方差矩阵的逆矩阵。一个主要优点是更新步骤变得可加,并且不依赖于整合观察的顺序[41]。也可以通过打破数据[42]之间的弱链接来使信息矩阵更稀疏,从而确保接近恒定时间的更新[43]。尽管在[44][45][46]中有一些应用,但IF在单车SLAM中不如EKF流行,因为有必要将每个度量转换为其逆形式,这可能是昂贵的。然而,IF被更多地用于多车辆SLAM(参见第V节)。

4)粒子过滤器

过滤SLAM算法的第二个主要分支是基于粒子过滤器(PF)。它们的原理如下:用一组粒子根据其概率密度对状态进行采样。然后,与每个过滤器一样,完成对每个粒子位移的预测,并根据观察结果进行更新。在更新阶段,粒子根据它们关于度量的可能性进行加权。最有可能的粒子被保留,其他的被消除并产生新的[3]。将此方法直接应用于SLAM很难处理,因为它需要每个地标一组粒子。然后出现了PF的变体,例如分布式粒子方法DP-SLAM[47]和DP-SLAM 2.0 [48],它们提出使用最小祖先树作为数据存储结构。它通过引导PF来实现快速更新,同时减少后者的迭代次数。然而,最著名的PF算法是FastSLAM[49],它在该主题上受到了先前工作[50][51]的极大影响。使用EKF估计每个地标,并且粒子仅用于轨迹。FastSLAM已在[52]中实时应用。PFs的主要优点是它们不需要高斯噪声假设并且可以适应任何分布。尽管如此,PFs也存在长期不一致的问题[53]。在[54]中,这个问题是通过将FastSLAM与IF相结合来解决的,但结果计算量很大。在[55]中,FastSLAM被应用于激光数据,其中匹配给出了里程计测量,然后用于在重采样阶段对粒子进行加权。仍然关于FastSLAM,其贝叶斯基础在[56]中扩展到可转移信念模型框架(TBM),从而允许在所使用的网格图中表示冲突。

当涉及到视觉传感器[24]和带有激光数据的2D占用网格时,基于过滤器的方法现在往往依赖于3D点。后者在[57]和[58]中介绍,特别适合SLAM,因为由于网格本身导致的空间离散化允许在更新步骤期间测试有限数量的候选位置。地标不确定性由单元的占用概率表示,这使得地图部分的更新成为可能。在更新步骤中,经典方法是最大化测量值与地图之间的相似性,如贝叶斯形式主义中的[59]或TBM环境中的[60]中的相似性。尚未提及,在[61][62][63]中使用基于滤波器的方法已经证明了雷达在SLAM中的使用。然而,由于信号的噪声性质,它们在大规模实验中的使用仍然有限。它们通常用于障碍物检测。

B 基于优化的SLAM

面向优化的SLAM方法通常由两个子系统组成,如基于滤波器的SLAM。第一个是通过查找新观测值与地图之间的对应关系,根据传感器数据识别问题的约束条件。第二个子系统计算或细化车辆姿态(和过去的姿态)和给定约束的地图,以便拥有一个连贯的整体。至于过滤器,我们可以将这些方法分为两个主要分支:捆集 调整和图SLAM。

1)BA(Bundle Adjustment)

捆集调整是一种联合优化3D结构和相机参数(位姿)的视觉技术。大多数早期的工作都集中在3D重建[64],但从那时起它就被应用于SLAM。主要思想是通常使用Levenberg-Marquardt算法[65]优化一个目标函数。后者将重投影误差(图像中的观察值与重投影的过去特征之间的距离)最小化,从而提供最佳相机和地标位置。然而,核心捆绑调整算法的计算量可能很大,因为它会同时考虑所有变量以进行优化。

BA优化

Bundle Adjustment : 从视觉重建中提炼出最优的3D模型和相机参数(内参和外参),好似每一个特征点都会反射几束光线,当把相机位姿和特征点位置做出最优的调整后,这些光线都收束到相机相机光心。也就是根据相机的投影模型构造构造代价函数,利用非线性优化(比如高斯牛顿或列文伯格马夸而尔特)来求最优解,利用雅克比矩阵的稀疏性解增量方程,得到相机位姿和特征点3D位置的最优解。

(通俗解释)流程:先按照正常的步骤计算出3D点的坐标;然后重投影(按理说一个正向计算,一个反向计算,误差是0才对),但是由于各种原因(不清楚具体是啥)存在了重投影(像素坐标)误差。因此需要求MIN的误差。求的过程中需要不断调整3D点位置与相机外参,因此求出MIN误差的时候,也获取了最优的3D点位置与相机姿态。

如何对匹配好的点做进一步的处理,更好保证匹配效果

- 暴力匹配是,确定匹配最小距离,汉明距离要小于最小距离的两倍才是正确的匹配。(工程经验,当描述子的距离大于最小距离的两倍时,认为匹配有误)。

- 使用KNN-matching算法,令K=2。则每个match得到两个最接近的descriptor,然后计算最接近距离和次接近距离之间的比值,当比值小于阈值时,才作为最终match。

- RANSAC(随机抽样一致),利用RANSAC找到最好的对极约束D

1.从匹配好的点中找八对点,然后计算其他匹配点到极线的距离,当距离小于内点时看作内点。

2.当内点的数目占95或者到达迭代次数k时把当前的本质矩阵作为最好的模型。

3.以当前的本质矩阵求解出相机的运动。(使用RANSAC找到最佳单应性矩阵。由于这个函数使用的特征点同时包含正确和错误匹配点,因此计算的单应性矩阵依赖于二次投影的准确性)

从那时起,已经提出了许多方法来执行局部优化。在[66][67]中,提出了一种处理较小块的分层方法。然后以分层方式合并获得的部分3D模型。为了降低复杂性,在所有帧中选择或创建两个虚拟关键帧来表示给定部分。这减少了要优化的变量数量。在[68]中,类似的方法已应用于自动驾驶,具有准确的定位结果,但需要离线地图构建。

在[69]中,提出了一种仅对新信息进行优化的增量方法。在最坏的情况下,它相当于一个完整的捆绑调整。在[70]中,作者在关键帧三元组上使用滑动窗口来局部最小化重投影误差。在优化阶段考虑两个视图之间的共同点。三组图像的原理在捆绑调整社区中很常见。与每一种优化技术一样,当给出一个好的粗略估计时,捆绑调整效果很好。从这个意义上说,过滤异常值很重要。Niste ́retal。[71]提出了一种基于抢先式RANSAC的选择方法[72]。尽管它允许实时应用(13Hz),但结果不如[68]中的准确。在[11]中提出了一种局部捆绑调整。目标是根据最后N帧(N≥n)中点的2D重投影局部优化最后n个摄像机位置。可以调整这些参数以获得具有良好结果的实时方法。在[73]中提出了惯性测量的整合。由于机器学习方法,双目标函数(视觉和惯性目标函数)使用系数集进行加权。另一种选择是仅优化一组帧以解决闭环问题。这是[74]中提出的想法,作者保留主要架框架并边缘化过程中的大部分特征和框架。这种方法非常接近于图SLAM技术。

2)图SLAM

贝叶斯SLAM的图形表示(见图2)特别适合通过优化方法解决。图3显示了一个来自[75]的示例。基于此图形表示,可以轻松地构建描述地标和车辆姿态之间关系的矩阵并在优化框架中使用。

许多定位问题可以使用图形表示进行建模,并通过找到遵循以下形式的代价函数的最小值来解决:

其中x是包含不同车辆姿态的向量,m是地图,eij是计算预测和观察之间距离的误差函数,Ωij是相关信息矩阵。

最优值x∗和m∗可以通过优化得到:

通常,非线性函数F(x,m)的最小化通常通过使用流行方法(例如Gauss-Newton、Levenberg-Marquardt、Gauss-Seidel松弛或梯度下降)的局部近似来简化。这些方法既可以通过优化整个轨迹来工作,也可以通过小位移增量来实时使用。与过滤方法类似,最小化的成功取决于初始化。

TORO算法[76]在图中应用具有新颖节点参数化的随机梯度下降变体。这种参数化采用树结构的形式,在每次迭代时定义和更新局部区域。一个不同的想法是不考虑欧几里得空间,而是考虑流形。它是算法HOG-MAN[77]的基础,其中提出了对流形的分层优化。最低级别代表原始数据,而最高级别捕获环境的结构信息。在g2o[78]中,采用了类似的表示。g2o使用Hessian矩阵的结构来降低系统的复杂度进行优化。COP-SLAM[79]优化了位姿图。后者考虑位移和相关的不确定性来构建一系列姿势。在另一种方法中,TreeMap[80]利用地图的树结构并制作地标的拓扑组,以使信息矩阵更稀疏,从而加快处理速度(n个地标的O(logn))。即使没有利用图结构,iSAM(增量平滑和映射)[81][82]也简化了信息矩阵以加速底层优化。这里,目标是这个稀疏信息矩阵的QR分解。

基于过滤器的技术和优化方法的SLAM应用对比是困难的,因为它们通常在不同的范围内考虑。这种比较工作已在[83]中提出,然后在[84]中扩展到单目方法。结果是优化往往比更容易受到线性化问题的过滤器提供更好的结果。然而,作者得出结论,“如果有少量处理预算,基于过滤器的SLAM框架可能是有益的,但BA优化在其他地方优于资源有限的地方”[83]。

C 相关综述和存在数据集

由于SLAM是移动机器人和现在自动驾驶的中心话题,它继续引起许多研究人员的关注。在本节中,我们将引导读者阅读最近的调查文章,这些文章涵盖了此处未涉及的方面。我们还描述了用于对当前方法进行基准测试的不同现有数据集。

如前所述,[4]和[5]对该领域进行了很好的介绍,并概述了SLAM涉及的不同方面。在[85]中,对最常见的基于滤波器的估计技术进行了简要调查,并列出了每个主要范式的优缺点。Dissanayake等人对SLAM提出了一个有趣的看法。在[86]中,并在[87]中进行了扩展,讨论了SLAM的可观察性、收敛性、一致性以及计算效率。在[7]中,回顾了三种估计技术:EKF-SLAM、PF-SLAM和基于图的SLAM。还回顾了最近使用视觉的SLAM 作品。特别关注室内SLAM和RGB-D相机。由于传感器的成本及其信息丰富性,社区对基于视觉的SLAM有着浓厚的兴趣。一些作品在[88]中进行了回顾。在[89]和[90]中,作者涵盖了视觉里程计(VO)的主题,其中重点是定位(和轨迹)而不是地图。视觉SLAM也是[91]的核心,其中解决了特征选择、匹配和地图表示。最近,Ros等人在[92]中提出了无人驾驶汽车的视觉SLAM挑战:构建长寿命地图、如何在车辆之间共享地图以及处理高级特征以简化识别的必要性。最近还发表了一份关于视觉位置识别的非常完整的调查[93]。作者介绍了该领域必不可少的不同模块:图像处理(描述符等)、地图(表示)和称为信念生成的估计部分。虽然这项调查还将探讨位置识别,因为它是SLAM的一个重要方面,但我们将关注其在自动驾驶汽车中的应用以及现有方法的成熟度。前面已经提到过Cadena等人的大量工作。在[8]中,对SLAM主题进行了整体审查。某些方面,不一定适用于自动驾驶,这里不会涉及(例如主动SLAM)。再次,我们将坚持关于自动驾驶汽车的关键主题和当前最先进方法的实验结果。最后,在[94]中,作者回顾了多机器人SLAM方法,并描述了基础数学公式。在我们的专门部分中,我们将使用基于云的方法完成这项调查,并就该领域的当前结果以及自动驾驶的预期未来方向提供一些见解。

最近已经做出了很大的努力来提供可以用来对不同的SLAM算法进行基准测试的数据集。Rawseeds项目是最早提出基准测试工具[95]的项目之一,该工具包含具有基本事实的室外和室内数据集。以类似的方式,New College数据集[96] 是在室外环境中使用相机和激光的2.2公里轨迹。最著名的是KITTI数据库 [97],其中包含从城市和城市周边环境中的汽车获取的各种数据集。它的受欢迎程度与数据集的多样性(车辆配备立体摄像头和3D激光扫描仪)以及网站提供的评估可能性有关。它是目前评估SLAM算法定位精度(平移和旋转误差)的主要工具。表 I 根据[98]提出的比较表提供了不同可用数据集的摘要。

我们现在将通过分析KITTI上排名靠前的方法来展示SLAM方法在自动驾驶方面的限制,然后讨论如何减轻这些限制。

3 经典方法在自动驾驶中的局限性

A 问题识别

KITTI数据库提供了一个有趣的向量来评估自动驾驶的里程计/SLAM算法的当前状态,因为提供的数据集是使用装备好的车辆进行的,主要是在城市和城郊道路上,预计这些方法将是最有效的。KITTI里程计数据集上排名第一的定位方法是V-LOAM[105],它将用于运动估计的视觉里程计与较慢的3D激光里程计相结合。3D激光用于创建视觉特征的深度图,并提取与之前的3D扫描相匹配的几何特征点(边缘点和平面点)。获得的变换用于初始化与地图匹配的ICP。这种方法能够在KITTI基准上达到0.68%的平移误差和0.0016deg.m-1的旋转误差。KITTI上最好的立体方法是一种名为SOFT[106]的视觉里程计。该算法基于精细的特征选择和跟踪。在两个图像中都提取了类似角的特征。通过小窗口上的SAD(绝对差异和)寻找对应关系。这些特征必须在两个连续的图像中匹配才能可行。执行归一化互相关(NCC)测试以去除最后的异常值。使用不同的算法分别估计帧到帧的运动以进行旋转和平移。在[107]中选择了类似的方法。基于对地标重投影误差的分析的异常值去除方案用于定义拒绝异常值的标准。[108]中描述了另一种有趣的方法。作者使用最先进的单目技术,但应用于立体系统。这再次意味着对内点识别和跟踪的强烈关注。这些视觉方法的性能达到平移误差约1%和低于0.003deg.m-1的旋转误差。

这四种方法在KITTI上排名较好。尽管结果令人印象深刻,但影响它们的漂移使它们无法长距离使用。例如,仅1%的平移漂移(无旋转误差)意味着100米后,车辆距离其真实的绝对定位只有1米。因此,必须考虑限制、纠正或避免这种长期漂移的方法。自动驾驶所涉及的大规模环境是一个重要的问题,因为在几公里内必须保持分米精度(通常推荐20厘米的精度[109])。因此,找到解决方案至关重要,无论是在绝对约束的形式下,还是通过研究漂移是如何发生并建模的。

显然,SLAM算法中使用的模型(车辆模型和观察模型)的非线性主要是由旋转引起的(参见图4示例),对定位的散度有很大的影响。然而,重要的是要提到收敛特性已经在SLAM的线性案例[14]中得到证明,在该领域使用卡尔曼滤波器就是一个很好的例子。

关于过滤方法,EKF SLAM的发散问题已被多次陈述。在[17]中,作者表明,当执行的线性化远离真实值时,滤波器往往会给出有偏差的估计。这意味着与状态(车辆或地图)相关的不确定性太小:估计是不一致的,真实值超出了估计的不确定性。定位逐渐漂移,过滤器计算有偏差的车辆姿态和地图[110]。非线性模型不是漂移的唯一来源。朱利尔等人在[16]中补充说,数据之间被忽略的相关性也会引起分歧。卡尔曼滤波器产生乐观的结果,这意味着他们认为来自传感器的一段数据是全新的,因此与其余数据在时间上去相关(白噪声假设),但事实并非如此,因此会导致不一致。

最后一段中提出的问题也适用于在本地环境中工作的优化方法,这是实时估计的必要条件。之前引用的优化SLAM工作也清楚地表明了旋转在该漂移中的重要性。多位作者都观察到了这一点[111]。它也在[112]和[113]中被实验证明。在[114]中,作者表明SLAM问题的2D公式不是凸的,因此具有可以陷入优化的局部最小值。然而,在不包括旋转误差的情况下,问题接近二次函数,因此变得凸。

许多实际原因也会影响SLAM算法的行为。例如,当静态世界假设是先决条件时,动态障碍的存在就是一个因素。场景中少量的地标或缺乏足够显着的特征也会导致错误的关联,从而导致系统发散。当然,对于嘈杂的真实传感器数据所使用的模型的准确性是另一个可能对计算定位的完整性产生强烈影响的因素。大多数直接解决这种不一致问题的工作都倾向于找到局部避免或减少漂移的方法。

B 避免或减少漂移的影响

避免或至少减少分歧的第一种可能性是将地图划分为子地图[31]。之前介绍的这些方法将全局地图分解为子地图,每个子地图都有自己的参考框架。通过这样做,可以通过只允许每个子图的短轨迹来在局部级别避免漂移。因此,必须校准子图的大小,并在减少漂移和处理引起的信息丢失之间做出折衷。然而,即使有适当的大小(例如参见[35]),也不能保证定位的一致性会得到保留。事实上,每一项措施都会导致系统不一致,即使只有几条数据也可能发生这种现象。此外,即使在子地图中避免了分歧,在全局地图中也不会跟踪子地图的连接方式。因此,它更多地是问题的局部解决方案。

以类似的方式,以机器人为中心的方法大大减少了分歧[115]。估计总是与车辆位置相关,而不是具有固定的世界框架。不一致问题不太常见,因为它们不像通常情况那样累积。该框架中的估计允许比经典EKF SLAM[116]更好的一致性。然而,与子图一样,分歧并没有完全解决,因为地标可能在少数测量的情况下发散。一些SLAM方法已经成功地使用了以机器人为中心的框架[117][118]。地标一旦不可见就会被遗忘,这将这些方法与视觉里程计联系起来,因此是完全合适的。

其他实际原因可能会造成漂移和不一致,例如在预期静态世界时存在移动障碍物。这个问题已经在SLAMMOT(移动对象跟踪)或SLAM-DATMO(移动对象检测和跟踪)方法[119][120][121]中得到解决。这个想法是利用地图构建过程通过分析与车辆位移不一致的观察结果来直接检测和跟踪障碍物。或者,代表模糊信息的可信方法[60]可以间接处理动态障碍。他们不检测或跟踪这些障碍物,而是将它们视为冲突,这允许算法在估计车辆位移时对这些观察结果影响非常低的权重。

更一般地说,SLAM过程中选定地标的质量和数量对系统的行为方式有明显的影响。歧义会导致匹配错误,从而导致产生的估计不一致。与这个问题相关,故障检测和隔离(FDI)系统建议利用信息冗余来测量不同来源(传感器、模型等)的一致性,并检测其中一个来源的错误或故障。通过这样做,可以知道系统是否处于容易出错的情况,从而拒绝虚假措施以避免漂移。在[122]中,作者建议使用阈值分析一组卡尔曼滤波器的残差,以确定一个滤波器是否发散。[123]中描述了一种类似的方法,但决策部分交给了神经网络。Sundvall和Jensfelt在[124]中添加了不同估计之间的一致性度量。在[125]中,使用归一化创新平方(NIS)测试将故障检测应用于GPS。[126]中使用神经网络通过使用近似器进行测量预测来检测传感器故障。在[127]中,作者提出了一种视觉里程计,其中在最小化步骤中考虑了光度相机校准,以减少由镜头衰减、伽马校正等影响引起的漂移。与更简单的相机模型相比观测质量得到了提升。

在SLAM算法中经常被认为可以对抗漂移的一个方面是多源的使用和融合。与前面描述的FDI方法相反,其想法不是拒绝虚假测量,而是让各种传感器相互补偿。根据罗等人的说法[128],可以识别三个级别的信息融合:原始数据的低级,特征的中级和对象的高级。在[129]中,作者建议将激光与相机数据相结合。融合是在里程碑级别完成的(激光估计,然后是相机细化)。在[130]中,相机、激光和GPS基于信息相干性进行融合。之前已经讨论过,[105]中描述的方法结合了视觉和3D激光数据以产生低漂移算法。然而,即使耦合信息可以使算法的准确性和一致性受益,它也不能保证它不会漂移。它仅部分纠正了由一个传感器引起的漂移。

即使这些方法已被证明可以减少或部分避免漂移,它也不允许在长时间内进行无漂移估计。以可靠的方式校正漂移涉及到关于车辆相对于先前已知的、局部或绝对的参考的位置的限制应该被固定考虑。

C SLAM在自动驾驶中的评估准则

虽然前面描述的方法可以成功地应用于具有专用探索方案的自主室内移动机器人,但对于自主驾驶环境的大规模环境来说还不够。这意味着有必要依赖先前的知识(绝对或本地信息)或能够随着时间的推移改进构建的地图,直到它足够准确(例如闭环)。因此,地图方面是自动驾驶汽车的核心,并为如何构建或使用紧凑、相关、可靠和不断发展的地图提出了重要挑战。

我们已经确定了6个标准,我们认为SLAM方法必须满足这些标准才能使自动驾驶可行。它们描述如下:

• 准确性:指的是车辆定位的准确性,无论是在世界坐标中还是相对于现有地图。理想情况下,准确度应始终低于阈值(通常约为20厘米[109])。当然,在直线中,纵向定位可能不太准确,但不会产生重大后果。

• 可扩展性:指车辆处理大规模自动驾驶的能力。SLAM算法应该能够在恒定的时间和恒定的内存使用情况下工作。它意味着在需要时使用地图管理器来加载数据。第二个方面是构建和/或使用的地图必须是轻量级的(或存储在远程服务器上并即时检索),以便该方法易于在长距离上推广。

• 可用性:指SLAM算法直接提供足够准确的定位的可能性,如果足够准确,可以立即用于自动驾驶。换句话说,构建环境地图不需要算法的第一次通过,这意味着该方法能够利用现有的地图资源(或更一般地集成绝对信息)。这一标准对于不限制自动驾驶汽车可以在哪里运行(全球地图绘制过程成本高昂且需要专用手段)。

• 恢复性:指对车辆在一张大地图里面进行定位的能力。最初,车辆不知道它在哪里,并且大多数时候需要一个专门的过程来大致了解它在地图中的位置。这也是一种从故障中恢复的方法(被绑架的机器人问题)。

• 可更新性:指识别地图和当前观测之间的永久变化。它还包括集成这些持久更改而不是临时更改所需的更新策略。长期的自动驾驶需要地图更新的自动化。

• 动态性:指SLAM方法如何能够处理动态环境和变化。这包括可能扭曲定位估计的动态障碍。它还整合了可能变化的天气条件以及季节变化(树木落叶等)。长期SLAM的挑战之一是找到足够区分的特征或方法,以便对这些变化具有鲁棒性。

我们现在将研究现有的单车和多车SLAM方法,并将它们与之前定义的标准进行比较,以便全面了解自动驾驶SLAM方法的成熟度。

4 单车SLAM

从上面详述的标准中出现的所有挑战都指向构建更好地图的必要性,旨在度量和拓扑级别的环境表示和识别方面。为了涵盖这个广泛的主题,我们将作品分为三类,这反映了SLAM社区通常如何考虑他们的贡献。第一个涉及闭环(识别先前建图的位置),这是SLAM的重要组成部分,因为它允许校正地图并使它们连贯。一个有趣的方面是这些算法通常适用于在其环境中重新定位车辆,从而为恢复标准提供答案。第二类处理先前构建的地图中的本地化。如前所述,这是一种约束漂移的直接方法。从理论上讲,每个SLAM方法都可以重用其地图,但我们将重点关注明确这样做的文章以及解决重用地图的长期挑战的文章。第三部分侧重于利用现有数据的定位方法,以避免专门配备的车辆的第一次通过。对于本节的每个部分,我们将提供所讨论方法的综合,它们如何响应先前建立的标准,并简要讨论剩余的挑战。

A 重定位与回环检测

识别先前地图的位置,从而减少SLAM算法引起的漂移,被认为是SLAM的重要组成部分。主要困难来自于估计过程不一致并且不能被信任找到那些循环的事实。这意味着,在大多数情况下,这个问题是通过一种始终运行的专用算法来解决的,独立于估计过程。这种专用算法还经常用于在先前构建的地图(被绑架的机器人问题)中重新定位车辆,这在考虑自动驾驶车辆时是最重要的。

由于视觉信息的丰富性,大多数方法使用相机来查找循环。威廉姆斯等人[131]已经确定了可以将这些算法分开的3类:

1)图像到图像的方法[132]

在图像到图像的方法中,环路检测发生在传感器空间中。基于视觉线索的词袋方法[132][135]属于这一类。这个想法是建立一个字典,其中每个单词代表相似的描述符。SIFT[136]通常用于查找描述符并比较它们,因为它对图像中的缩放、旋转或视点变化具有良好的鲁棒性。可以以冗余方式(SURF、CenSurE等)考虑许多视觉描述符,以便拥有尽可能大的数据库和有代表性的字典。一旦构建了后者,它就可以用来检查某些图像是否可以用相同的词来描述,从而有资格代表同一个地方。

诸如FAB-MAP(基于快速外观的地图)[99](及其扩展FAB-MAP 2.0 [137])和PIRF-Nav(位置不变鲁棒特征导航)[138]等算法是基于地标外观的SLAM解决方案的两个示例用于闭环。在第一个中,具有强依赖性的信息被提取以避免错误识别,这通常会影响闭环算法。该方法已在1000公里的室外数据集上进行了评估,结果表明,使用离线构建的字典,该算法可以提供适当的拓扑闭环并使地图更加连贯(未评估准确性的增益)。在[138]中,目标是相同的,但允许对动态变化具有鲁棒性的特征受到青睐(PIRF)。与FAB-MAP的一个主要区别是整个过程是在线的和增量的。然而,它不能很好地扩展(图像检索的二次复杂度),因此没有应用于车辆对比FAB-MAP方法。

仍然为了减少误报的数量,SeqSLAM[139]建议减少对单个图像的区分,而是分析序列以确保正确匹配。22公里和8公里数据集的结果证明了SeqSLAM在FAB-MAP所处的不同天气条件下实时处理日/夜匹配的能力(即使计算时间与数据集的大小成线性关系)无法正常运行。SeqSLAM被证明是一种纯粹的位置识别方法,即使有可能,它也不会应用回环来纠正先前的测量。SeqSLAM甚至已经扩展到通过使用表示潜在道路的图形结构和粒子滤波器来集成匹配之间的运动估计,以保持定位的一致性[140]。这种方法SMART PF 显示出比SeqSLAM 更好的结果。[141]中显示了另一种有趣的方法,其中测试了算法以找到不同季节的闭环。为此,还通过使用图像序列解决了该问题。构建了一个流网络(一个具有开始和结束遍历节点的有向图),并用于将图像匹配制定为最小成本流问题。在建议的数据集(夏季/冬季匹配)上,该方法优于SeqSLAM。处理每张图像需要几秒钟。[142]中介绍了这种方法的演变。作者用来自深度卷积神经网络的全局图像特征图替换了用于表示图像的HOG特征。他们能够获得更好的表现。在具有里程计约束的基于图的方法(g2o[78])中考虑了找到的循环,而没有提供关于达到的准确性的见解。该方法在GPU上运行,因此比之前的实现更快(实时数据集包含48,000张图像),尽管它的速度仍然取决于数据集的大小。

2)地图到地图的方法[133]

地图到地图的方法完全基于地图中包含的信息。[143]中提出的GCBB算法(几何约束分支定界)就是这种情况。原理是定义地图中地标对与当前观测值之间的几何约束。建立关联树以便找到对应地图中地标的几何组织的最可能的关联假设。即使未测量结果地图的准确性,它也已在[133]中以分层方法成功应用于户外实验。

Li等人在[144]和[145]中提出通过使用遗传算法来合并占用网格以找到可能的最佳对齐方式。低成本GPS用于将搜索空间限制在较小的区域。与前面的示例类似,地图的一致性得到了显着提高,但其准确性没有被测量。在可以近似估计漂移的情况下,JCBB算法(Joint Compatibility Branch and Bound)[146]根据其不确定性选择兼容的地标。

地图到地图的方法很难在没有任何提示的情况下应用,因为地图要么太稀疏而无法足够区分(例如单目SLAM),要么太复杂而无法实时进行完整的探索。在这种情况下,像[145]中那样使用GPS是有意义的,因为它允许系统大大减少探索空间。

3)图像到地图的方法[134]

最后一类,称为图像到地图(或更一般的传感器到地图),从传感器空间中提取信息并将其直接与地图进行比较。[134]中描述的方法基于在检测到的地标上训练的分类器。闭环阶段在图像上使用这些分类器来检查是否存在匹配。然后,RANSAC算法采用相应的3D位置来计算车辆的新姿态。单个摄像头的结果表明地图在户外场景中变得连贯。

关闭循环或重新定位车辆的另一种可能性是使用分层技术来加快处理速度。低分辨率地图首先用于识别车辆的粗略定位,然后随着地图分辨率的增加对其进行细化。这些方法特别适用于占用网格,并已成功应用于[147]中带有激光传感器的自动车辆。在此示例中,使用从粗到细的方法在地图内重新定位车辆,而不是执行回环。实验表明该方法效果很好,但地图的大小是一个关键方面。

4)讨论

我们专注于如何在SLAM算法中应用闭环。近年来,人们清楚地关注如何应对季节性或天气变化,我们向读者推荐本调查[93],以获取该领域的详细视图,与闭环无关。

即使看起来图像到图像的方法受到青睐,最近的方法也倾向于结合不同的方法来确保正确识别一个地方。例如,可以在[148]中找到具有视觉里程计的FAB-MAP应用。作者依靠密集立体建图并使用FAB-MAP来指示闭环。它们的度量积分是在图形公式中完成的,并使用观测值和先前构建的地图之间的迭代最近点(ICP)算法[149]进行计算。即使不直接测量精度,构建的地图也表示一致的地图。在[150]中,首先采用词袋方法生成候选者,然后使用条件随机场(CRF)进行检查,其中约束确保地标之间的几何一致性。整个方法应用于视觉SLAM框架。在表II中,我们简要概述了此处描述的与自动驾驶问题相关的主要方法。

基于既定标准,我们可以看到这些方法提出了恢复问题的解决方案。然而,闭环最初被视为一种纠正漂移的方法。虽然它产生了更连贯的地图,但这里引用的文章并没有清楚地揭示准确性的提高。在[151]中,作者解释说关闭循环可以抵消循环内部的漂移,但结果总是过于自信。[152]中提出了另一种方法,当识别出循环时,错误以概率方式围绕过去的轨迹重新分布。它避免了前面提到的过度自信问题,但不保证定位的一致性。

它还解释了为什么社区不一定专注于提高准确性,而是专注于解决困难的条件和构建一致的地图。即使结果令人印象深刻,尤其是在季节性变化和晴雨条件下,这里引用的方法,当考虑自动驾驶时,可以被视为更好的GPS,但在给定区域内。因此,它为未来带来了两个主要挑战:这些方法是否可以通过使用已有信息(地图、图像等)来推广以避免区域限制?能否将这些方法扩展并集成到SLAM框架中,以提供对自动驾驶可行的非常有弹性的方法?

B 在建好的地图中定位

在先前构建的地图中对车辆进行定位与上一节中介绍的关于闭环和重新定位的方法紧密相关。事实上,第一个必要的行动是全局识别车辆在地图中的位置。一旦完成这第一步,就可以使用更经典的数据关联算法。如果通过闭环无法完全消除漂移,则将定位限制在给定地图内是自动驾驶的可行解决方案。然而,构建一个可伸缩的、可以更新的或在任何条件下都可以工作的地图并不是一项简单的任务。我们将介绍现有的方法,这些方法表明在没有或使用专门的地图构建过程的情况下重复使用地图是可能的。

1)首次建图与即时定位的一致方法

任何SLAM算法的逻辑扩展都是重用构建的地图以约束定位。虽然它仍然需要第一次通过,但地图可以立即使用,不需要专门的离线处理。然而,并非所有方法都证明它们在涉及不断构建或丰富地图的情况下是可行的。

地图管理被所有涉及子地图的方法广泛覆盖,这使得SLAM算法能够以近乎恒定的时间和内存消耗工作[28]。但是,这些方法不一定要考虑重用地图。在[59]中,PML-SLAM被提出来使用激光扫描仪和占用网格来解决这些问题(基于车辆位置的RAM和硬盘驱动器之间的地图加载和卸载等)。这种方法已被证明在某些领域的[153]中可用于自动驾驶。地图也可以持续更新,但没有专门的进程处理它,这意味着临时更改也将被集成。

在[154]中,作者描述了一个长期的制图过程,其中新的测量改进了地图。该方法基于视觉和惯性传感器,并使用姿势图表示来集成新数据。由于姿态图的减少,已知区域的可扩展性得以实现。不控制更新是否对应于永久更改。之前已经提到,麦当劳等人的工作在[150]中,使用锚节点将在不同会话期间获取的姿势图链接在一起。这样,生成的视觉SLAM地图都可以考虑在内。与[154]类似,所有地图都没有区别地集成。[155]的作者提出了一种单目方法,该方法使用少量的地标及其视觉斑块来表征它们。地标在图像中被重新投影并通过归一化互相关[156]的补丁进行匹配。

即使这种方法资源非常少,也没有专门的机制能够处理不再需要的地图部分。图像存储器的使用非常普遍[157][158][159]。原理是将当前图像与存储在内存中的参考数据库进行比较,这可能是昂贵的并且是地图的限制因素。在这种情况下,数据关联也可能是一个问题。在[160]中,作者提出数据关联图作为建模和解决此问题的一种方式。

构建能够演变并跟随永久变化的地图是一项主要在室内环境中解决的挑战。动态姿势图[161]维护两个地图:一个活动地图和一个动态地图。标记激光扫描点以识别移动障碍物,然后可以相应地更新两个地图。位姿图表示允许系统删除不活动的节点并保持更易于处理的表示。在[162]中,视觉里程计方法与位置识别机制相结合,以拼接在不同时间获取的地图。当旧视图不再相关时,旧视图将被删除,从而允许系统维护最新的地图,即使也集成了临时更改。

在[163]中提出了一个为期3个月的户外实验,其中作者引入了塑料地图的概念,作为一种随着时间的推移整合视觉体验的方式。这个想法是视觉里程计试图与过去的经验相关联。如果不存在,则创建一个新的。体验可以沿着轨迹是部分的,以便仅将更改存储在专用部分而不是整个地图上。作者通过实验表明,所需经验的数量往往会随着时间的推移而受到限制。这个概念的主要优点是它允许以统一的方法检测突然和长期的变化。收集所有需要的经验需要多次穿越同一条道路,而这只能在世界范围内使用探测车完成。

2)精简地图构建处理

计算机容量的不断增加,再加上使用SLAM进行自动驾驶需要第一次遍历这一事实,导致研究人员专注于如何构建可能用于在线开发的最佳地图。

大多数时候,地点识别方法也属于这一类,因为它们需要先前的段落来构建特定的数据库,然后再利用这些数据库。在[164]中,每个特征一个SVM在多个图像上进行训练。通过丢弃相邻图像中不够准确或不够独特的检测器来确保鲁棒性。这些分类器及其时间连接可以看作是地图。作者证明了定位失败的显着减少,但没有直接评估该方法的准确性。[165]中的PoseNet算法训练卷积网络以将图像与相应的位置和方向相关联。然后应用CNN来实时定位图像。这些方法确实将车辆定位在地图内,但不能像更经典的方法那样确保定位服务的连续性。

随着时间的推移,许多方法也选择了改进地图。在[166]中,作者认为,在未来,地图将来自集中收集服务。因此,他们提出了一个系统,其中通过优化2D-3D关联使用视觉构建的地图用于为数据库提供数据。离线过程利用所有这些信息来生成包含所有有意义数据(最常见的地标)的摘要地图。在各种条件下,定位精度都在30 cm以下。提到了这种方法的可扩展性问题,但没有解决。在[167]中,作者考虑了一个初始度量和语义图,并提出了一种无监督方法,使它们在停车环境中随时间演变。度量图使用姿势图松弛算法以考虑多个通道。由于机器学习技术,语义部分得到了更新。[168]中维护了多个时间尺度,以便选择最适合当前观察的时间尺度。执行第一次运行以获得初始地图。之后,本地地图通过短期记忆在线维护,而离线更新允许系统构建更一致的全球地图。室内实验表明,地图会慢慢适应长期变化。

在[169]和[170]中提出了一种不同的方法,其中球形图像(强度、深度、显着性和采样球体)是由多个图像构建的。球体的主要优点是覆盖给定区域,而不仅仅是一个位置。基于单目输入的在线注册方法用于定位车辆。在[171]中,提出了一个两步过程。在第一阶段(教学),使用SURF关键点和子图技术构建数据库。然后,重复阶段根据构建的地图对机器人进行定位,以使其遵循与之前相同的路径。类似地,在[172]中,首先使用分层束调整方法离线构建视觉数据库。然后,车辆实时将自身定位在地图内。这两种方法都不允许系统在构建后修改地图。在[172]中,结果显示出令人印象深刻的精度(大约2厘米,路径完全相同)。但是,地图仍然很重(大约100 Mb一公里)。仍然与视觉有关,在[173]中,提出了一种地理参考视觉地图方法。该地图首先是在基于图形的优化框架内使用SURF特征和GPS约束离线构建的。在线,不使用GPS,仅使用地图和立体视觉。地图内存是作者引用的问题之一(1公里有500,000个地标),平均精度为30厘米。

[174]中提出了拓扑定位。在第一个通道期间,GPS与视觉和距离传感器相结合,以创建紧凑特征的数据库(每张图像的描述符以及每张图像之间的距离和标准偏差值)。然后使用贝叶斯过滤器进行在线定位。已经进行了广泛的实验(超过4个月),以显示特征对各种条件的弹性。平均定位误差约为1米。仍然在多传感器环境中,从图像和激光网格图[176]中提取最大稳定极值区域(MSER)[175]。与GPS-RTK相结合,它们可以在第一次通过时建立数据库。然后粒子过滤器在线跟踪车辆姿态。对于50厘米以下的平均误差,7公里需要2574个地标。最后,一种有趣的方法,首先在[177]中提出,然后在[178]中扩展,专注于使用3D激光构建高质量的路面地图。提出了一种反射率值的校准方法,然后使用具有惯性和GPS约束的图形方法计算地图。直方图过滤器用于地图内的在线定位。结果已在6公里以上的自动驾驶中得到了证明,精度不到10厘米。地图管理器确保恒定的内存使用。1.6公里需要10MB。作者指出,在复杂的天气环境中,对所建地图的依赖可能会产生不恰当的后果。Napier和Newman在[179]中没有使用激光构建的地图,而是通过视觉里程计方法构建路面的正交图像。在在线定位阶段,生成基于预测姿态的合成图像,并使用互信息与地图进行比较,以优化定位。该方法目前无法实时工作,其准确性尚未直接评估。

3)讨论

表III概述了本节讨论的主要方法以及它们如何满足我们的自动驾驶标准。

我们可以看到,几乎所有方法都提出了一个恢复系统(除了没有提到的[173]之外),这对于先前构建的地图中的定位是有意义的。仅视觉就足够了,需要密集的表示或大量的地标。还值得注意的是,所有这些方法之间的实验条件并不相同,因此一种方法无法在不同的环境中达到适当的精度。构建长期地图仍然是一项艰巨的任务,并且始终不清楚是否总是更新地图是好的策略。我们还注意到,这种方法的缺点是不限制地图的大小(即使这种效果是有限的),从长远来看这可能是有问题的。许多方法没有提出存储部分地图的特定机制,因为实验范围不一定需要它。然而,大多数方法所需的信息密度使得目前难以设想在全球范围内进行部署。地图的直接可用性是主要问题,但值得注意的是,[166]提到探测车(配备多个传感器的车辆)作为未来减少此问题的方法。这将在第五节中进一步讨论。

从这个简短的分析来看,构建能够以有限的方式考虑永久变化以及季节和天气的终身地图的问题似乎仍然是一个挑战。关于准确性,即使显示了一些令人印象深刻的结果,也很难预测一个地图表示将如何在不同的环境中工作。由于没有明确的方法来评估这一点,因此需要在各种条件下进行更多测试。最后一个更大的问题是这些地图的创建如何在世界范围内推广?目前尚不清楚它是否会发生,因为全球范围内的原始传感器数据可能永远无法获得。

C 在已存在的地图中定位(更强调不同源)

即使没有全球范围内的原始传感器数据,也存在许多已经提供大规模信息的不同来源。为了促进自动驾驶汽车的部署,许多研究人员提出了利用这些地理信息源的方法。在这一部分中,我们将首先关注新的地图(或可能是新的)格式及其应用,因为它可能会在不久的将来推动信息的收集方式。然后,我们将讨论已经整合现有广泛可用的数据来构建先前地图的定位方法。

1)构建和使用未来地图

近年来,研究人员提出了自定义地图格式,以满足自动驾驶先验知识的需求。一些人考虑了以自动方式构建全球地图的实际挑战。

在[180]中,作者提出了一种自定义格式Emap(增强型地图),可用于车道级定位。基于GNSS和航位推算测量,车道表示为一系列直线、圆或回旋曲线。这种地图格式已在[181]中进行了30分钟的实验,其中车道准确度达到了(大多数时间误差低于1米)。最初由DARPA指定的路由网络定义文件格式(RNDF)的扩展在[182]中进行了讨论。这种新格式RNDFGraph通过包含车道关系和车道变更信息克服了原始定义的一些限制。这可以通过使用图形表示来实现。样条线也基于航路点生成,以确保平滑的轨迹。这种格式已在德国高速公路中用于路径规划,但不直接用于定位目的。准确的车道级地图生成也是[183]中追求的目标。在这里,作者将从3D激光和图形SLAM方法中提取的线段特征与OpenStreet Map地图相结合。粒子滤波器用于获得车道估计,然后将其集成到地图中。作者表明,他们能够达到5厘米的平均精度。文章中没有提出定位算法中的地图利用。仍然关于自动车道级地图生成,Guo等人在[184]中(并在[185]中扩展)提出了一种基于OSM地图、INS、GPS和相机生成的正交图像的低成本方法。这个想法是这样的系统可以被探测车使用,并且可以概括地图构建过程。首先,将INS和GNSS测量一起优化以获得车辆定位。执行使用视觉里程计的第二次优化。然后根据从OSM提取的局部地图片段对齐图像。最后从正交图像中提取车道。仍然以路径规划使用为中心,在[186]中提出了lanelets。该格式建议使用从卫星视图手动创建地图的工具。该地图表示已在[109]中使用,但也构建了用于定位的专用地图。最后,在[187]中,提出了一种基于高精度GNSS、3D激光和向下摄像头的系统来构建地图。根据GNSS生成并定位鸟瞰图像。然后从中提取车道标记和路缘石并进行人工审查。提出了一种定位应用程序LaneLoc,其中使用估计的车辆位置在图像中重新投影地图(在定位阶段不使用激光)。它简化了车道标记和路缘石的后续提取。定位大部分时间都能够达到地图精度(大约10厘米)。

目前,所有先前引用的方法都将几何信息引入仅拓扑图。因此,利用这种先验信息的方法在不久的将来可能是可行的。在[188]中提出了一种地图辅助定位,它利用了关于车道和停车线的先验知识。检测这些车道并将它们与地图进行比较的视觉系统在粒子过滤器中实现,该过滤器还集成了IMU和GPS测量。该照明系统能够达到50厘米的精度。在[189]中,作者仅使用路段并将它们集成到FastSLAM中。这种道路约束方法的想法是通过将横向偏差和角度误差与从地图计算的预期值匹配来限制它们。后者是使用差分GPS构建的。达到车道精度,平均误差为1.4m。同样,在[190]中构建并使用了车道标记的准确数字地图。与GPS和本体感受信息融合后,车道检测允许将定位限制在沿横轴10厘米的范围内。然而,纵向上,误差在1米左右。一般来说,车道方法很难应用在更复杂的环境中,如交叉路口和环形交叉路口,其中准确性是一个重要问题。

[191]的作者没有使用车道,而是使用包含周围墙壁的地图。贝叶斯网络决定使用激光扫描仪检测最合适的墙壁,以便以自上而下的方式达到定义的精度目标。使用构成场景的墙壁的精确地图可以达到20厘米的精度。先前构建的极点数据库在[192]中用作参考地图。精度取决于磁极的频率,但平均约为1米。在[193]中,作者利用了整个杆状基础设施。首先使用立体视觉和高精度DGPS/INS组合构建地图。在定位阶段,与地图的立体匹配以及里程计和GPS都集成在粒子滤波器中。精度不是直接测量的,但作者声称横向精度约为20厘米。

2)平衡当前地图资源

世界各地已经收集了大量数据(拓扑图、全景图等),可用于创建不需要特定车辆事先通过的特定地图。然而,利用手头的可用资源来制作高质量的地图并不容易。

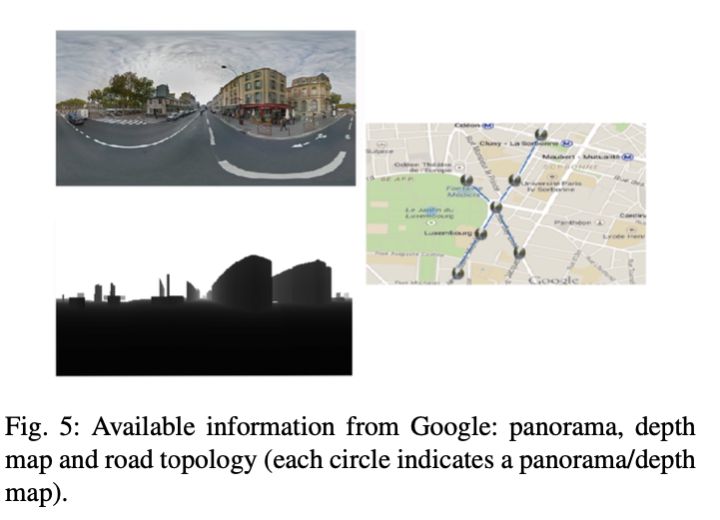

一些方法开始使用Google街景图像(参见图5)或等效方法。在[194]中,飞行器利用街景来定位自己。创建人工视图以克服视点的差异,然后使用近似最近邻对提取的特征进行比较。目标是用飞行器解决城市环境中的地点识别问题。在[195]中,从街景图像中提取SIFT描述符并在树结构中进行索引,然后使用最近邻算法从当前图像的描述符中进行浏览。然后完成对候选人的投票以选择最接近的图像。这项工作已在[196]中使用贝叶斯跟踪滤波器进行了扩展,以确保定位的连续性。即使过滤器允许更平滑的轨迹,仍然会发生围绕位置的突然跳跃。这种城市规模的定位精度从1米到12米不等。在[197]中,视觉词袋方法用于使用SIFT和MSER(最大稳定极值区域)检测器从街景图像构建两个字典,以便同时具有局部和区域特征描述符。基于这些,可以恢复与真实图像最近的街景。物理上接近的全景图之间的关系有助于加快匹配过程。对于所有这些方法,困难的任务是找到足够区分的特征以增加匹配率,如 [198] 中所述。因此,这些方法与城市环境中出现的新描述符有着密切的关系[199][200][201]。改善结果的另一种方法是处理序列,然后可以将其与[202]中提出的环境拓扑进行匹配。通过在多个图像中考虑来自查询图像的视觉词,而不是仅仅考虑一个图像,可以获得更好的性能。作者将问题表述为图像图上的回归。仅通过将街景匹配在一起并根据算法检索正确图像的能力来评估该方法。

上述方法解决了街景中的地点识别问题。但是,它们无法达到自动驾驶的足够精度。由于街景全景图的稀疏性质,这个问题更加困难。在[203]中,作者建议创建合成视图以提高匹配的连续性,从而提高定位的连续性。与街景相关的深度用于3D到2D匹配,该匹配被注入到优化框架中,以最大限度地减少重投影误差。他们最多能够获得大约60厘米的精度。在[204]中,姿势估计是通过将当前图像的特征与最佳街景(与查询图像匹配的最高数量)进行比较来执行的。通过评估所有匹配的相应变换的残差来识别正确的对应关系。然后在最佳的两个参考视图之间估计姿势。系统的精度在不到2米到16米之间波动。[205]中描述了一种具有两个分离模块的方法。在第一个中,从短时间跟踪的特征点应用视觉里程计算法。在第二个中,计算将这些点与街景全景图联系起来的变换,以获得精度低于1.5m的全局定位。在原始方法中,[206]的作者提出了一种基于文本的地理定位方法,该方法使用相机从可用的商店标志中提取文本内容。然后将其与根据街景全景图构建的注释地图进行比较,以估计相机的姿势,平均误差约为10米。

除了街景图像,在[207]中,作者表明可以将交通标志视为来自现有地图的地理参考地标。这些交通标志的3D模型在图像中匹配,并且车辆的位置在捆绑调整方法中进行了优化。结果大部分时间低于0.5m,但取决于交通标志的数量。但是,使用的数据库需要非常精确,并且是由移动地图系统构建的。使用更传统的交通标志数据库,[208]的作者通过在贝叶斯滤波器中结合视觉、GPS和INS能够达到5米的精度。如[209]中提出的,道路图的结构也可以用来粗略地定位车辆。在本文中,粒子滤波器仅由里程信息提供,通过匹配地图上的轨迹,逐渐收敛到车辆的真实位置。结果是大型网络中的平均误差为5.8m。[210]的作者将视觉里程计系统与从卫星图像中提取的特征(车道标记)相结合。航拍图像使用支持向量机和聚类算法进行离线预处理,以识别道路标记。后者然后用于在线约束定位。系统的准确性没有被测量,但作者表明他们能够将卫星图像特征与当前图像对齐。

3)讨论

我们提供了表IV中涵盖的与既定标准相关的主要方法的综合。

基于现有地图的定位方法的现状表明,它们尚不适合自动驾驶。精度不够或需要比当前可用的更精确的地图。一个有趣的观察结果是,即使使用更精确的车道图(手动构建)的算法也无法达到自动驾驶的临界精度(大约20厘米[109])。当然,根据即将发布的高精度地图中提供的信息,事情可能会在不久的将来发生变化。然而,利用当前数据库是一个不断发展的趋势,可能是一个有趣的前景。然而,即使理论上可以通过这些方法实现可扩展性,也需要专门的预处理算法以正确的格式转换数据(例如,根据区域创建词袋)。表 IV 中描述的所有方法都能够恢复它们在地图内的姿态,大多数时候使用标准GNSS,这在密集的城市环境中可能会更加困难。

本部分介绍的定位方法的主要挑战是如何通过构建更相关、更准确的地图来提高准确性。一种解决方案可能会自然而然地出现在新的全球资源(新地图等)中。一个关键方面仍然是来源的信息密度。街景虽然很有趣,但就目前而言,其物理间隔太大,无法单独使用。这就是为什么生成合成数据可能是一个可能的答案。作者倾向于专注于特定类型的数据,并找到一个同时利用所有可用资源的框架和估计方法可能是一个有趣的前景。还应提前了解必须寻找的地图元素是什么,以便在没有直接体验的情况下预先评估车辆,如果就其容量而言,可以达到自动驾驶的足够准确度。本节中提到的方法不考虑这些共享资源的更新。虽然用不准确的地图近似车辆位置更新并非易事,但它显然有助于逐步改进这些地图,直到它们可用于自动驾驶。

5多车SLAM

在世界范围内为定位目的创建或利用地图的复杂性表明,可能需要车辆之间的合作来改进现有地图或简化大规模数据收集以构建适当的地图。但是,这样做并非易事,因为多辆车的协作会影响如何设计有效的方法。一个重要的初始区别涉及如何处理合作。存在两种系统:集中式方法和分散式方法。在第一种情况下,通信都针对一个实体,该实体在将结果发送回车辆之前聚合和融合所有数据。去中心化系统假设每辆车能够构建自己的去中心化地图,同时与车队中的其他车辆进行通信。这意味着必须控制信息流以避免在这种情况下通常发生的带宽爆炸和估计问题(例如重复计算测量值)。值得注意的是,这个领域仍然是相当新的领域,目前主要关注移动机器人技术。我们将讨论这两个系统(集中式和分散式)以及如何将它们应用于自动驾驶。

A 集中SLAM

集中式SLAM似乎是单车SLAM算法的自然扩展,其中部分计算被卸载到远程服务器。但是,根据目标,有很多方法可以集中方式共享SLAM任务。可以做出的主要区别是集中部分是应该实时运行还是离线运行。

1)在线集中式SLAM

这个组织使得SLAM算法的扩展非常直接。Fenwick等人提出了有关该主题的首批作品之一。在[211]中,扩展卡尔曼滤波器用于整合所有车辆的状态向量(姿势和地标)。该论文涵盖了更多的理论方面,仅显示了模拟结果。在[212]中,子图是由机器人使用激光扫描仪检测到的圆柱形物体特征单独构建的。所有这些子图都以集中方式从附近的服务器融合。必须知道机器人的相对位置。该方法通过两个机器人的非常简单的实验来演示。据我们所知,[213]中提出的工作是第一个提出多机器人视觉SLAM的工作。观察和视觉描述符被发送到一个中央代理,该代理建立一个在所有机器人之间共享的地图。车辆的初始位置必须大致已知,以便在这张通用地图中定位每个人。该独特地图中不同轨迹的估计由Rao-Blackwellized粒子滤波器执行。该方法仅在仿真中进行了测试,结果表明计算正确地图和车辆定位所需的处理能力不足以满足实时约束。

最近的趋势已将这种处理从一个车辆或近距离实体转移到云端,以利用可用的处理能力。一个著名的例子可以在[214]中找到。在本文中,作者公开了一个云框架C2TAM,它在云服务器和机器人之间共享工作负载。所有要求高的任务都转移到云端,只在机器人上执行需要高频率的部分。所提出的应用程序在远程计算机上执行RGB-D SLAM的所有建图方面,并且仅在本地完成位姿跟踪。即使该方法被提议为云框架,实验也使用具有无线连接的台式计算机。他们展示了系统在地图上执行协作更新以及在线地图合并的能力。在[215]中,提出了DAvinCi架构。它的目标是卸载云系统上的所有计算。该软件架构使异构代理能够在云上共享和上传通用数据。基于网格的FastSLAM已经适应这种云方法的需求。每个负责姿态估计的粒子都可以在不同的节点上运行。实验证明了单车FastSLAM的执行时间更快,但作者没有考虑这些外包计算在实时方法上引起的延迟。Rapyuta[216]是另一个为云机器人设计的框架。它的使用通过RGB-D里程计来演示。评估不同的设置:将计算完全卸载到云端,仅卸载建图过程的组合以及两个机器人的协作建图。发送到云端的关键帧被压缩以减少所需的带宽。在他们的实验中,使用了亚马逊云服务。尽管进行了压缩,但信息的完全卸载需要太多的带宽。然而,混合方法(只有一部分计算是在云上完成的)是可行的。然而,作者并未在这些实验中讨论延迟对地图构建的影响。

基于云的机器人应用相当新,并且具有很大的潜力,至少可以减少未来自动驾驶汽车的计算需求。感兴趣的读者可以参考[217]对这一最近的实践进行简短调查,并参考[218]对机器人技术中的云方法进行更一般的回顾。

2)离线集中式SLAM

云计算所涉及的延迟和延迟可能会阻止在自动驾驶汽车中使用先前引用的方法。然而,为了简化全球地图的创建,对车队白天收集的数据进行离线计算可以成为构建一致的大比例地图的一种方式。SLAM数据的离线计算可以被视为一种自然的方式。多会话SLAM算法的扩展。多会话SLAM是SLAM算法可以考虑重叠区域中的多个通道,从而扩展最初构建的地图。两个地图之间的共同点的识别通常涉及位置识别算法,该算法循环闭合约束以计算更连贯的地图。提出多会话建图的方法是基于图形表示的,该表示在添加新的约束和节点进行优化时具有灵活性的优势。我们建议读者参考第四节中对以下工作的描述,这些工作可以被多个车辆在云计算中使用:[148][150][154][161][163][166][167][168]。虽然这些方法仅适用于单一车辆,但扩展到车队是很简单的。在[166]中,作者提到长期目标是在探测车中部署这样的系统,该系统将收集数据并将它们融合到云中,然后将地图作为服务提供。主要困难是必须按部门划分地图,以便在合理的时间内仍然可以优化,并限制地图的增长方式以避免具有难以处理的环境表示。第一个问题已经在使用子建图技术的单车SLAM中得到解决,第二个问题仍然是一个开放的挑战。最后,一个实际问题是在一组探测车中具有共同的表示,以便能够构建和利用相同的地图。

推出此类应用所涉及的资源使其更像是一个工业挑战而不是研究问题。这是地图创建者HERE的目标,它打算通过从探测车收集数据来构建HAD(高度自动驾驶)地图。这些数据用于为特定服务提供不同的地图,这些地图是在云端离线计算的。在[219]中可以找到一项值得注意的研究工作,其中提出了一种可以收集、存储和共享数据的云服务。之前提到的大多数基于云的方法都与该服务相关联,它可能成为未来试验大规模多车辆离线地图构建的一种方式。

B 分散式SLAM

自动驾驶汽车与基础设施(Vehicle To Infrastructure,V2I)和其他汽车(Vehicle To Vehicle,V2V)的连接能力不断提高,带来了定位方法如何利用它们的问题。一个主要方面,与其他多车辆接近,是一种以更快的方式绘制新区域的可能性。集中式方法的主要区别在于,数据可以直接在车辆之间交换,无需专用基础设施。车辆可以从直接通信中受益,以在突然变化或预测动态条件的情况下快速更新地图(例如,预加载适应降雨条件的地图)。

然而,完全去中心化的SLAM很难实现,因为必须考虑许多新的约束。因此,目前最接近的应用涉及移动机器人,而不是直接自动驾驶汽车。因此,在讨论如何将它们集成到自动驾驶应用中之前,我们将在本节中关注它们。有兴趣的读者可以参考[94]以获得对该领域的完整概述。

关于这个问题的第一个工作来自数据融合社区,其中一项任务被分配在几个CPU之间以加快计算速度。例如,Nettleton 等人提出的多车定位算法。[220]中的数据来源于[221]和[222]中提出的分散数据融合的进展。在讨论主要实验结果之前,我们将重点关注此类方法的主要设计困难:数据乱伦、数据关联和通信问题。

1) 数据乱伦

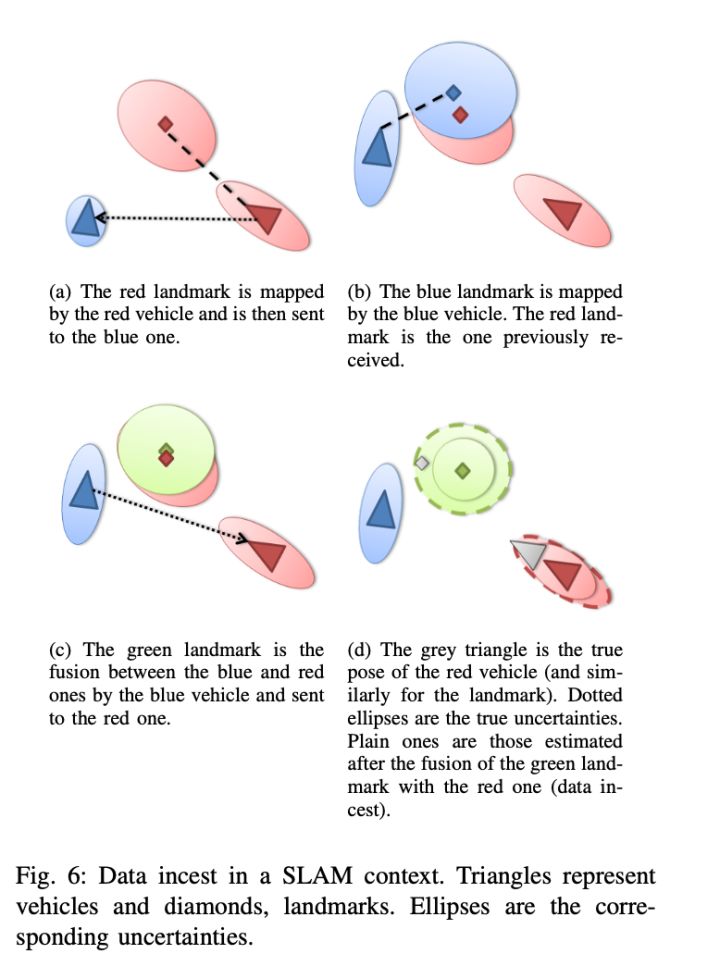

共享信息的应用程序之间的一个常见困难是数据乱伦,这会导致估计过程中重复计算数据的不一致。分散式SLAM(或整体分散式定位)特别容易出现这种现象,因为观察和地图是由车辆共享、中继和融合的[223][224]。SLAM上下文中的数据乱伦现象如图6所示。在此示例中,红色车辆从蓝色车辆接收到融合状态,该状态已经集成了自己的地图。由于它不知道,它会将这个地标融合到它的地图中,从而重复计算它自己的地标并变得过度自信(不一致)。跟踪交换的内容对于少数车辆来说是可能的,但对于大型车队来说不能很好地扩展。

为了在SLAM环境中解决这个问题,Nettleton等人在[220]中提出了一种专用的网络架构来避免重复计算。只允许点对点通信,从而迫使信息在到达目标之前通过几个节点。在[225]中,公开了一种仅在关闭时交换子图的方法。拓扑全局地图将所有子地图放在一个公共框架中。主要限制来自子图无法更新且仅在网络上发送一次这一事实。Vidal-Calleja等人的工作在[226]中还提出了子图SLAM的扩展,更具体地说,是[31]中引入的分层方法。只有拓扑图在车队内部交换,全局度量图无法即时恢复。在[227]中,介绍了一种基于多机器人图的SLAM。每辆车的地图被压缩并发送给邻居。数据缓存过滤掉已经收到的信息。类似地,在[228]和[229]中,在邻居之间寻求共识,以便找到可能避免重复计算信息的最佳地图。在[113]中,每个车辆状态(姿势和地图)都与其他车辆状态分开存储。每辆车都可以通过将所有接收到的状态与自己的状态融合来获得一张全球地图。在[230]中,由Julier等人发起的拆分协方差交叉滤波器(SCIF)。在[231]中,应用于多车辆环境。该过滤器基于协方差交集,即使数据之间的相关性未知,也能产生一致的估计。

2)数据关联

多车辆环境中的数据关联可能非常复杂,因为车辆之间的相对位置不一定是已知的,并且可以传达的信息受到带宽的限制。一些方法选择考虑车辆之间的初始距离是事先已知的[232][220]。[233]中介绍的另一种可能性是定义一个集合点,车辆将汇聚到该集合点直接观察自己。

在专门为多车辆应用设计的数据关联算法中,我们可以引用[234],其中每个地标的特征是与其他近距离地标的度量(距离和角度)。然后在来自不同车辆的地图中寻找类似的地标配置。在[235]中,地标按3分组,并应用Delaunay三角测量来获得唯一的地图。这些三角形的周长和面积被提供给 RANSAC 算法,以便找到来自两个不同车辆的两个地图块之间的最佳对应关系。在[236]中,作者分析了潜在的多车对应的分布。假设Inliers在两辆车之间产生与异常值相反的相同转换。聚类算法用于找到初始候选者,然后可以使用更经典的方法进一步分析。李等人的作品。[144][145]在受限搜索空间中使用低成本GPS和遗传算法解决来自不同车辆的地图的初始对齐问题

3)通信问题

去中心化SLAM中经常忽略带宽需求。例如,在 [225] 中,直接发送子图。在 [237] 中,交换了图表(节点包括原始数据),这仅适用于小型车队。在[238]中,作者建议仅在车辆可以相互检测到时交换地图,这意味着将准时发送大量数据。仅通信拓扑图的方法,如 [226] 和 [227] 中的方法,通过提供非常轻的图来避免这个问题。

交换策略还应该能够应对潜在的损失和延误。如果不考虑,暂时的饱和或故障可能导致信息彻底丢失[237][225]。围绕与邻居交互构建的算法通常能够识别和询问丢失的数据[227]。 [239] 中描述的另一种可能性是惰性信念传播,它将观察结果整合到粒子滤波器中,不依赖于将数据添加到滤波器的时间顺序。因此,丢失或迟到的信息仍然可以在以后毫无问题地集成。但是,必须能够识别缺失值。更一般地,所有基于卡尔曼滤波器的逆形式的方法,即信息滤波器,都在本地处理延迟。实际上,更新变得可加,并且不依赖于任何时间顺序。它已成为多车社区的常见选择[234][240][241]。

4)实验结果

在前面引用的文章中进行的实验清楚地说明了这种方法在自动驾驶中的潜在部署。实际上,大多数方法仅在模拟实验中得到证明[220][225][227][235][239][240]。主要原因是解决本节中提到的所有问题以进行真实数据实验可能很困难,因为它们并非都与估计问题直接相关。一些方法已经在室内实时展示[242][233]。在 [226] 中,作者展示了室外环境中的空中/地面合作。该地图以与视觉地标合作的方式构建。精度尚未测量。在 [113] 中,进行了两辆或三辆汽车的户外实验。该方法依赖于视觉地标的交换。精度在 50 厘米到几米之间波动,具体取决于车辆识别常见地标的能力。最后,在 [145] 中,2 辆配备激光的车辆在户外实验中将它们的地图合并在一起。该方法平均能够达到 3 米的误差。

对最近结果的这项简短调查表明,我们距离将分散式 SLAM 用于自动驾驶还很远。然而,通信本身意味着不断改进,带宽限制在未来几年可能不再是一个问题。尽管如此,分散式 SLAM 能力的大规模演示仍有待证明,将前面描述的方法应用于自动驾驶是 SLAM 即将面临的挑战之一

C 讨论

多机器人 SLAM 方法的概述表明,这种自动驾驶方法的成熟度因处理数据的方式(以集中式或分散式方式)而有很大差异。在线集中式 SLAM 系统已在小规模实验中得到证明,该系统使用经典计算机作为收集观测数据的集线器或使用云处理。从移动机器人到无人驾驶汽车的扩展提出了未来汽车可用的带宽容量问题,但最重要的是车辆中互联网连接的可用性。将关键处理完全卸载到云端可能不够安全。然而,在合理的时间内委派更新从几辆车收集的地图的任务是一个有趣的前景。对可能发生变化的地图部分进行实时更新可以帮助无人驾驶汽车以更快的方式适应。此外,可以预先警告具有低动态性的环境条件,以便车辆通过选择更适应的特征等进行预测。为了实现这一目标,需要涉及实际数量的车辆的大规模实验。这也意味着一个主要的前景仍然是设计能够处理数据流和正确分段更新的软件架构。使基于云的在线方法可行的一个关键因素是选择能够集成所有传入信息的地图表示。

从这个意义上说,完全去中心化的方法有着相似的目标。主要区别在于,通过接收来自附近汽车的信息,自我车辆可以选择将哪些信息集成到其地图中。因此,一个有趣的挑战变成了建立标准,以评估信息增益,该信息增益可以带来来自不同车辆的地图,与自我车辆的目标(目的地、能量约束等)相关。然而,去中心化方法的所有实际影响是要解决的第一个挑战。与处理能力不受限制的云方法相反,最终解决方案的易处理性也将是一个需要考虑的重要因素。为了清楚地展示分散式 SLAM 对自动驾驶汽车的好处,大规模实验也是一个重要的里程碑。

离线集中式方法可能是自动驾驶最成熟的方法,主要是因为这一挑战非常接近多会话 SLAM。虽然未来的 HAD 地图可能无法提供在各种条件下可靠地定位车辆所需的所有信息,但探测车可能是一种快速收集足够数据以构建此类地图的方法。关于车辆检测长期变化的能力,这也是一个有趣的观点。事实上,不同观点的聚合应该可以缓解这一过程。能够限制这些地图的增长仍然是一个障碍。最后,一个相当大的挑战是构建足够强大的软件架构来集成和处理所有这些数据。这种基础设施的成本将这种方法的大规模实验导向工业公司,而不是小型研究团队。

6 大规模自动驾驶车辆实验

The DARPA Urban Challeng;Grand Cooperative Driving Challenge;the VisLab team;the Stadpilot project;The V-Charge project;CityMobil2 project;the Stanford’s vehicle from the Urban Challenge;BMW;Waymo;

简单列举一些项目和做自动驾驶实验的研究团队,感兴趣的可以进行详细的调查。

7 讨论与结论

在本次调查中,我们重点关注了应根据所选择的方法考虑的个别挑战。为了结束本文,我们现在将讨论一些更一般的方面如何对自动驾驶汽车的定位产生影响。

在第 23 届 ITS 世界大会期间,提出了定位竞赛。基于 HERE 提供的地上物体和车道的低分辨率体素图,参与者被要求提出一种准确的定位算法。由于未达到目标准确度,比赛没有获胜者而告终。目前尚不清楚未来几年将提供的 HAD 地图是否将为定位算法提供足够强大的先验知识。根据结果,社区肯定会调整SLAM 中使用什么样的先验知识。这些地图还旨在用作局部动态地图(LDM)的一部分,该地图收集 SLAM 可以贡献的静态和动态信息。因此,需要标准化[272]。

不经常讨论的一个方面是传感器放置。它会对定位系统的性能产生巨大影响。例如,车顶上的激光可以清楚地看到基础设施并避开大部分移动障碍物,而起落架中的激光可能会受到屏蔽信息的影响。同样,定位所需的最小传感器集尚未明确定义(即使激光和相机似乎受到青睐)。这样的定义应该与将用作先验知识的地图表示结合起来。当然,这方面也与这些传感器的成本密切相关。从这个意义上说,一个有趣的观点是多模态,其中地图可以由昂贵的3D激光构建,然后由[273]中提出的简单相机利用。另一个有趣的挑战是构建灵活的架构,其中决策系统可以根据上下文选择要使用的传感器、检测器或地图。

上下文本身是自动驾驶的重要组成部分,对它的理解将有助于放置识别算法,甚至可以直接集成以使SLAM更加健壮。目前,开展的大部分工作都与室内定位有关。它们是由Chatila等人发起的。在[274]中,语义(对象)图用于高级决策。从那时起,SLAM方法经常被考虑用于语义地图构建。在[275]和[276]中,作者利用3D激光来识别天花板、地板和物体。在[277]中,基于三个不同的地图提出了概念空间表示:度量(来自SLAM系统)、导航(自由空间)和拓扑(门分隔区域之间的连接)。概念图允许机器人对房间和物体进行语义表示,以帮助与用户进行交互。在[278]中,作者将众所周知的对象集成到单目SLAM中。SLAM++[279] 采用了类似的方法,在通用定位框架中检测和优化对象。在这最后两部作品中,对象之间的上下文和关系并未直接用于推理。从这个意义上说,户外环境中的语义SLAM仍然是一个需要解决的挑战。

然而,仅来自图像的语义映射是最近发展起来的一个领域[280][281]。深度卷积神经网络在很大程度上促成了这一趋势,SegNet[281]等方法显示出令人印象深刻的结果。它们在定位方法中的应用仍然是一个开放的挑战,但直接的用途是移除可能干扰SLAM算法正确行为的移动或暂时静止的障碍物。更一般地说,CNN可以通过使用来自这些网络的特征图来改变位置识别的执行方式,如[142]中所示。CNN在自动驾驶定位中的影响和使用肯定会在未来几年发生变化。最近的一个例子,如[282]表明,甚至可能不需要定位。在本文中,Nvidia展示了直接学习应该从相机线索中应用的转向角的可能性。然而,这些方法的可扩展性还有待证明。

近年来,实验范围扩大,数公里和长时间的自动驾驶更为普遍。穿梭实验也在各个城市开始。即使在这种情况下,SLAM方法可以使用以前构建的地图而不会出现可伸缩性问题,但这是一种长时间测试它们并应对环境变化的好方法。在大多数路线图[283]中,实际上预计交通系统的自动化比其他车辆的期限更短,因为它具有限制覆盖区域的优势。

最后,定位算法的安全性是一个需要考虑的重要问题。应该设想多个来源,并且必须设计在它们之间安全切换的策略。考虑到故障及其对定位系统的影响,有助于创建降级的定位模式,以确保车辆能够安全地到达停车点。

9 some thing to say

后面没怎么仔细看,放几张图吧~~

图如有侵权,删之

参考文献

- Google翻译

- Guillaume Bresson, Zayed Alsayed, Li Yu, Sébastien Glaser. Simultaneous Localization And Mapping: A Survey of Current Trends in Autonomous Driving. IEEE Transactions on Intelligent Vehicles, Institute of Electrical and Electronics Engineers, 2017, XX, pp.1. 10.1109/TIV.2017.2749181 . hal- 01615897

[1] R. Smith and P. Cheeseman, “On the representation and estimation ofspatial uncertainty,” Int. J. Robot. Res., vol. 5, no. 4, pp. 56–68, 1986.

[2] J. J. Leonard and H. Durrant-Whyte, “Simultaneous map building andlocalization for an autonomous mobile robot,” in Proc. IEEE/RSJ Int.Conf. Intell. Robots Syst., 1991, pp. 1442–1447.

[3] F. Dellaert, D. Fox, W. Burgard, and S. Thrun, “Monte Carlo localizationfor mobile robots,” in Proc. IEEE Int. Conf. Robot. Autom., 1999, vol. 2,pp. 1322–1328.

[4] T. Bailey and H. Durrant-Whyte, “Simultaneous localization and mapping (SLAM): Part II,” IEEE Robot. Autom. Mag., vol. 13, no. 3, pp. 108–117, Sep. 2006.

[5] H. Durrant-Whyte and T. Bailey, “Simultaneous localization and mapping: Part I,” IEEE Robot. Autom. Mag., vol. 13, no. 2, pp. 99–110, Jun.2006.Authorized licensed use limited to: Qilu University of Technology. Downloaded on July 11,2022 at 01:17:10 UTC from IEEE Xplore. Restrictions apply.BRESSON et al.: SIMULTANEOUS LOCALIZATION AND MAPPING: A SURVEY OF CURRENT TRENDS IN AUTONOMOUS DRIVING 215

[6] S. Thrun, W. Burgard, and D. Fox, Probabilistic Robotics. Cambridge,MA, USA: MIT Press, 2005, ch. 3, pp. 279–484.

[7] C. Stachniss, J. J. Leonard, and S. Thrun, Springer Handbook of Robotics.New York, NY, USA: Springer-Verlag, 2016, ch. 46, pp. 1153–1176.

[8] C. Cadena et al., “Past, present, and future of simultaneous localizationand mapping: Toward the robust-perception age,” IEEE Trans. Robot.,vol. 32, no. 6, pp. 1309–1332, Dec. 2016.

[9] C. Schmid, R. Mohr, and C. Bauckhage, “Evaluation of interest pointdetectors,” Int. J. Comput. Vis., vol. 37, no. 2, pp. 151–172, 2000.

[10] J. Civera, O. G. Grasa, A. J. Davison, and J. M. M. Montiel, “1-PointRANSAC for EKF filtering. Application to real-time structure from motion and visual odometry,” J. Fields Robot., vol. 27, no. 5, pp. 609–631,2010.

[11] E. Mouragnon, M. Lhuillier, M. Dhome, F. Dekeyser, and P. Sayd, “Realtime localization and 3D reconstruction,” in Proc. IEEE Comput. Soc.Conf. Comput. Vis. Pattern Recognit., 2006, pp. 363–370.

[12] R. E. Kalman, “A new approach to linear filtering and prediction problems,” J. Basic Eng., vol. 82, no. 1, pp. 35–45, 1960.

[13] M. W. M. G. Dissanayake, P. Newman, H. F. Durrant-Whyte, S. Clark,and M. Csorba, “An experimental and theoretical investigation into simultaneous localization and map building,” in Proc. 6th Int. Symp. Exp.Robot. VI, 2000, pp. 265–274.

[14] M. W. M. G. Dissanayake, P. Newman, H. F. Durrant-Whyte, S. Clark,and M. Csorba, “A solution to the simultaneous localization and mapbuilding (SLAM) problem,” IEEE Trans. Robot. Autom., vol. 17, no. 3,pp. 229–241, Jun. 2001.

[15] R. E. Kalman and R. S. Bucy, “New results in linear filtering and prediction theory,” J. Basic Eng., vol. 83, no. 3, pp. 95–108, 1961.

[16] S. J. Julier and J. K. Uhlmann, “A counter example to the theory ofsimultaneous localization and map building,” in Proc. IEEE Int. Conf.Robot. Autom., 2001, pp. 4238–4243.

[17] Y. Bar-Shalom, X. R. Li, and T. Kirubarajan, Estimation With Applications to Tracking and Navigation. Hoboken, NJ, USA: WileyInterscience, 2001.

[18] J. Guivant, E. Nebot, and S. Baiker, “Autonomous navigation and mapbuilding using laser range sensors in outdoor applications,” J. Robot.Syst., vol. 17, no. 10, pp. 565–583, 2000.

[19] J. Guivant and E. Nebot, “Optimization of the simultaneous localizationand map building algorithm for real-time implementation,” IEEE Trans.Robot. Autom., vol. 17, no. 3, pp. 242–257, Jun. 2001.

[20] J. J. Leonard and H. J. S. Feder, “A computationally efficient methodfor large-scale concurrent mapping and localization,” in Proc. Int. Symp.Robot. Res., 2000, vol. 9, pp. 169–178.

[21] P. Newman and J. J. Leonard, “Pure range-only sub-sea SLAM,” in Proc.IEEE Int. Conf. Robot. Autom., 2003, vol. 2, pp. 1921–1926.

[22] P. Newman, J. Leonard, J. D. Tard´os, and J. Neira, “Explore and return:Experimental validation of real-time concurrent mapping and localization,” in Proc. IEEE Int. Conf. Robot. Autom., 2002, vol. 2, pp. 1802–1809.

[23] P. Newman, D. Cole, and K. Ho, “Outdoor SLAM using visual appearance and laser ranging,” in Proc. IEEE Int. Conf. Robot. Autom., 2006,pp. 1180–1187.

[24] A. J. Davison, “Real-time simultaneous localisation and mapping with asingle camera,” in Proc. IEEE Int. Conf. Comput. Vis., 2003, pp. 1403–1410.

[25] J. Montiel, J. Civera, and A. J. Davison, “Unified inverse depthparametrization for monocular SLAM,” in Proc. Robot., Sci. Syst.,2006, p. 8.

[26] G. Bresson, T. F´eraud, R. Aufr`ere, P. Checchin, and R. Chapuis, “Realtime monocular SLAM with low memory requirements,” IEEE Trans.Intell. Transp. Syst., vol. 16, no. 4, pp. 1827–1839, Aug. 2015.

[27] S. B. Williams, G. Dissanayake, and H. Durrant-Whyte, “An efficientapproach to the simultaneous localisation and mapping problem,” inProc. IEEE Int. Conf. Robot. Autom., 2002, pp. 406–411.

[28] J. J. Leonard and P. Newman, “Consistent, convergent and constant-timeSLAM,” in Proc. Int. Joint Conf. Artif. Intell., 2003, pp. 1143–1150.

[29] T. Bailey, “Mobile robot localisation and mapping in extensive outdoorenvironments,” Ph.D. dissertation, Aust. Centre Field Robot., Univ. Sydney, Sydney, NSW, Australia, 2002.

[30] M. Bosse, P. Newman, J. Leonard, M. Soika, W. Feiten, and S. Teller,“An atlas framework for scalable mapping,” in Proc. IEEE Int. Conf.Robot. Autom., 2003, vol. 2, pp. 1899–1906.

[31] C. Estrada, J. Neira, and J. D. Tard´os, “Hierarchical SLAM: Real-timeaccurate mapping of large environments,” IEEE Trans. Robot., vol. 21,no. 4, pp. 588–596, Aug. 2005.

[32] P. Pini´es and J. D. Tard´os, “Large scale SLAM building conditionallyindependent local maps: Application to monocular vision,” IEEE Trans.Robot., vol. 24, no. 5, pp. 1094–1106, Oct. 2008.

[33] L. M. Paz, J. D. Tard´os, and J. Neira, “Divide and Conquer: EKFSLAM in O(n),” IEEE Trans. Robot., vol. 24, no. 5, pp. 1107–1120,Oct. 2008.

[34] J. L. Blanco, J. Gonz´alez, and J.-A. Fern´andez-Madrigal, “Subjectivelocal maps for hybrid metric-topological SLAM,” Robot. Auton. Syst.,vol. 57, no. 1, pp. 64–74, 2009.

[35] M. Chli and A. J. Davison, “Automatically and efficiently inferring thehierarchical structure of visual maps,” in Proc. IEEE Int. Conf. Robot.Autom., 2009, pp. 387–394.

[36] S. J. Julier and J. K. Uhlmann, “New extension of the Kalman filter tononlinear systems,” in Proc. AeroSense, 1997, pp. 182–193.

[37] E. A. Wan and R. V. D. Merwe, “The unscented Kalman filter for nonlinear estimation,” in Proc. Adapt. Syst. Signal Process., Commun. ControlSymp., 2000, pp. 153–158.

[38] S. J. Julier and J. K. Uhlmann, “Unscented filtering and nonlinear estimation,” Proc. IEEE, vol. 92, no. 3, pp. 401–422, Mar. 2004.

[39] D. Checklov, M. Pupilli, W. Mayol-Cuevas, and A. Calway, “Real-timeand robust monocular SLAM using predictive multi-resolution descriptors,” Adv. Visual Comput., vol. 4292, pp. 276–285, 2006.

[40] P. S. Maybeck, Stochastic Models, Estimation and Control. Amsterdam,The Netherlands: Elsevier, 1982.

[41] Y. Liu and S. Thrun, “Results for outdoor-SLAM using sparse extendedinformation filters,” in Proc. IEEE Int. Conf. Robot. Autom., 2003, vol. 1,pp. 1227–1233.

[42] S. Thrun, Y. Liu, D. Koller, A. Y. Ng, Z. Ghahramani, and H. DurrantWhyte, “Simultaneous localization and mapping with sparse extendedinformation filters,” Int. J. Robot. Res., vol. 23, no. 7/8, pp. 693–716,2004.

[43] R. Eustice, M. Walter, and J. J. Leonard, “Sparse extended informationfilters: Insights into sparsification,” in Proc. IEEE/RSJ Int. Conf. Intell.Robots Syst., 2005, pp. 3281–3288.

[44] I. Mahon, S. B. Williams, O. Pizarro, and M. Johnson-Roberson, “Effi-cient view-based SLAM using visual loop closures,” IEEE Trans. Robot.,vol. 24, no. 5, pp. 1002–1014, Oct. 2008.

[45] M. R. Walter, R. M. Eustice, and J. J. Leonard, “Exactly sparse extendedinformation filters for feature-based SLAM,” Int. J. Robot. Res., vol. 26,no. 4, pp. 335–359, 2007.

[46] J.-S. Gutmann, E. E. nad Philip Fong, and M. E. Munich, “A constanttime algorithm for vector field SLAM using an exactly sparse extendedinformation filter,” in Robotics: Science and Systems. Cambridge, MA,USA: MIT Press, 2010.

[47] A. Eliazar and R. Parr, “DP-SLAM: Fast, robust simultaneous localization and mapping without predetermined landmarks,” in Proc. Int. JointConf. Artif. Intell., 2003, vol. 3, pp. 1135–1142.

[48] A. Eliazar and R. Parr, “DP-SLAM 2.0,” in Proc. IEEE Int. Conf. Robot.Autom., 2004, pp. 1314–1320.

[49] M. Montemerlo, S. Thrun, D. Koller, and B. Wegbreit, “FastSLAM: Afactored solution to the simultaneous localization and mapping problem,”in Proc. AAAI/IAAI Nat. Conf. Artif. Intell., 2002, pp. 593–598.

[50] K. P. Murphy, “Bayesian map learning in dynamic environments,” inProc. Neural Inf. Process. Syst., 1999, pp. 1015–1021.

[51] S. Thrun, W. Burgard, and D. Fox, “A real-time algorithm for mobilerobot mapping with applications to multi-robot and 3D mapping,” inProc. IEEE Int. Conf. Robot. Autom., 2000, vol. 1, pp. 321–328.

[52] E. Eade and T. Drummond, “Scalable monocular SLAM,” in Proc.IEEE Comput. Soc. Conf. Comput. Vis. Pattern Recognit., 2006, vol. 1,pp. 469–476.

[53] T. Bailey, J. Nieto, and E. Nebot, “Consistency of the FastSLAM algorithm,” in Proc. IEEE Int. Conf. Robot. Autom., 2006, pp. 424–429.

[54] M. Mohan and K. K. Madhava, “Mapping large scale environmentsby combining particle filter and information filter,” in Proc. Int. Conf.Control, Autom., Robot. Vis., 2010, pp. 1000–1005.

[55] D. Hahnel, W. Burgard, D. Fox, and S. Thrun, “An efficient FastSLAMalgorithm for generating maps of large-scale cyclic environments fromraw laser range measurements,” in Proc. IEEE/RSJ Int. Conf. Intell.Robots Syst., 2003, vol. 1, pp. 206–211.

[56] T. Reineking and J. Clemens, “Evidential FastSLAM for grid mapping,”in Proc. 16th Int. Conf. Inf. Fusion, 2013, pp. 789–796.

[57] H. P. Moravec, “Sensor fusion in certainty grids for mobile robots,” AIMag., vol. 9, no. 2, pp. 61–74, 1988.

[58] A. Elfes, “Using occupancy grids for mobile robot perception and navigation,” Computer, vol. 6, no. 22, pp. 46–57, 1989.Authorized licensed use limited to: Qilu University of Technology. Downloaded on July 11,2022 at 01:17:10 UTC from IEEE Xplore. Restrictions apply.216 IEEE TRANSACTIONS ON INTELLIGENT VEHICLES, VOL. 2, NO. 3, SEPTEMBER 2017

[59] Z. Alsayed, G. Bresson, F. Nashashibi, and A. Verroust-Blondet, “PMLSLAM: A solution for localization in large-scale urban environments,”in Proc. IEEE/RSJ Int. Conf. Intell. Robots Syst. Workshop PerceptionNavig. Auton. Veh. Human Environ., 2015, pp. 13–18.

[60] G. Trehard, Z. Alsayed, E. Pollard, B. Bradai, and F. Nashashibi, “Credibilist simultaneous localization and mapping with a LIDAR,” in Proc.IEEE/RSJ Int. Conf. Intell. Robots Syst., 2014, pp. 2699–2706.

[61] R. Rouveure, P. Faure, and M. Monod, “Radar-based SLAM withoutodometric sensor,” in Proc. Robot. 2010, Int. Workshop Mobile Robot.Environ./Agriculture, 2010, p. 9.

[62] D. Vivet, P. Checchin, and R. Chapuis, “Localization and mapping usingonly a rotating FMCW radar sensor,” Sensors, vol. 13, pp. 4527–4552,2013.

[63] E. Jose and M. D. Adams, “An augmented state SLAM formulation formultiple line-of-sight features with millimetre wave RADAR,” in Proc.IEEE/RSJ Int. Conf. Intell. Robots Syst., 2005, pp. 3087–3092.

[64] B. Triggs, P. F. McLauchlan, R. I. Hartley, and A. W. Fitzgibbon, “Bundleadjustment: A modern synthesis,” in Vision Algorithms: Theory andPractice. New York, NY, USA: Springer-Verlag, 2000, pp. 298–372.

[65] W. Press, S. Keukolsky, W. Vettering, and B. Flannery, “LevenbergMarquardt method,” Numerical Recipes in C: The Art of Scientific Computation. Cambridge, U.K.: Cambridge Univ. Press, 1992,pp. 542–547.

[66] H.-Y. Shum, Q. Ke, and Z. Zhang, “Efficient bundle adjustment withvirtual key Frames: A hierarchical approach to multi-frame structurefrom motion,” in Proc. IEEE Comput. Soc. Conf. Comput. Vis. PatternRecognit., 1999, p. 543.

[67] R. Hartley and A. Zisserman, Multiple View Geometry in Computer Vision. Cambridge, U.K.: Cambridge Univ. Press, 2000, ch. 18,pp. 434–457.

[68] E. Royer, M. Lhuillier, M. Dhome, and T. Chateau, “Localization in urbanenvironments: Monocular vision compared to a differential GPS sensor,”in Proc. IEEE Comput. Soc.Conf. Comput. Vis. Pattern Recognit., 2005,pp. 114–121.

[69] D. Steedly and I. Essa, “Propagation of innovative information in nonlinear least-squres structure from motion,” in Proc. IEEE Int. Conf. Comput. Vis., 2001, pp. 223–229.

[70] Z. Zhang and Y. Shan, “Incremental motion estimation through modifiedbundle adjustment,” in Proc. Int. Conf. Image Process., 2003, pp. 343–346.

[71] D. Nist´er, O. Naroditsky, and J. Bergen, “Visual odometry for groundvehicle applications,” J. Fields Robot., vol. 23, no. 1, pp. 3–20,2006.

[72] M. A. Fischler and R. C. Bolles, “Random sample consensus: Aparadigm for model fitting with applications to image analysis andautomated cartography,” Commun. ACM, vol. 24, no. 6, pp. 381–395,1981.

[73] J. Michot, A. Bartoli, and F. Gaspard, “Bi-objective bundle adjustmentwith application to multi-sensor SLAM,” in Proc. 5th Int. Symp. 3D DataProcess., Vis. Transmiss., 2010, p. 9.

[74] K. Konolige and M. Agrawal, “FrameSLAM: From bundle adjustment toreal-time visual mapping,” IEEE Trans. Robot., vol. 24, no. 5, pp. 1066–1077, Oct. 2008.

[75] S. Thrun and J. J. Leonard, “Simultaneous localization and mapping,” inSpringer Handbook of Robotics. New York, NY, USA: Springer-Verlag,2008, pp. 871–889.

[76] G. Grisetti, S. Grzonka, C. Stachniss, P. Pfaff, and W. Burgard, “Effi-cient estimation of accurate maximum likelihood maps in 3D,” in Proc.IEEE/RSJ Int. Conf. Intell. Robots Syst., 2007, pp. 3472–3478.

[77] G. Grisetti, R. Kummerle, C. Stachniss, U. Frese, and C. Hertzberg,“Hierarchical optimization on manifolds for online 2D and 3D mapping,”in Proc. IEEE Int. Conf. Robot. Autom., 2010, pp. 273–278.

[78] R. Kummerle, G. Grisetti, H. Strasdat, K. Konolige, and W. Burgard,“g2o: A general framework for graph optimization,” in Proc. IEEE Int.Conf. Robot. Autom., 2011, pp. 3607–3613.

[79] G. Dubbelman and B. Browning, “Closed-form online pose-chainSLAM,” in Proc. IEEE Int. Conf. Robot. Autom., 2013, pp. 5190–5197.

[80] U. Frese and L. Schroder, “Closing a million-landmarks loop,” in Proc.IEEE/RSJ Int. Conf. Intell. Robots Syst., 2006, pp. 5032–5039.

[81] M. Kaess, A. Ranganathan, and F. Dellaert, “iSAM: Incremental smoothing and mapping,” IEEE Trans. Robot., vol. 24, no. 6, pp. 1365–1378,Dec. 2008.

[82] M. Kaess and F. Dellaert, “Covariance recovery from a square rootinformation matrix for data association,” Robot. Auton. Syst., vol. 57,no. 12, pp. 1198–1210, 2009.

[83] H. Strasdat, J. M. M. Montiel, and A. J. Davison, “Real-time monocularSLAM: Why filter?” in Proc. IEEE Int. Conf. Robot. Autom., 2010,pp. 2657–2664.

[84] H. Strasdat, J. M. M. Montiel, and A. J. Davison, “Visual SLAM: Whyfilter?” Image Vis. Comput., vol. 30, no. 2, pp. 65–77, 2012.

[85] J. Aulinas, Y. Petillot, J. Salvi, and X. Llad´o, “The SLAM problem:A survey,” in Proc. 11th Int. Conf. Catalan Assoc. Artif. Intell., 2008,pp. 363–371.

[86] G. Dissanayake, S. Huang, Z. Wang, and R. Ranasinghe, “A review ofrecent developments in simultaneous localization and mapping,” in Proc.IEEE 6th Int. Conf. Ind. Inf. Syst., 2011, pp. 477–482.

[87] S. Huang and G. Dissanayake, “A critique of current developments insimultaneous localization and mapping,” Int. J. Adv. Robot. Syst., vol. 13,no. 5, pp. 1–13, 2016.

[88] Z. Chen, J. Samarabandu, and R. Rodrigo, “Recent advances in simultaneous localization and map-building using computer vision,” Adv. Robot.,vol. 21, no. 3/4, pp. 233–265, 2007.

[89] D. Scaramuzza and F. Fraundorfer, “Visual odometry: Part I: The first30 years and fundamentals,” IEEE Robot. Autom. Mag., vol. 18, no. 4,pp. 80–92, Dec. 2011.

[90] F. Fraundorfer and D. Scaramuzza, “Visual odometry: Part II: Matching,robuRobust, optimization, and applications,” IEEE Robot. Autom. Mag.,vol. 19, no. 2, pp. 78–90, Jun. 2012.

[91] J. Fuentes-Pacheco, J. Ruiz-Ascencio, and J. M. Rend´on-Mancha, “Visual simultaneous localization and mapping: A survey,” Artif. Intell. Rev.,vol. 43, no. 1, pp. 55–81, 2012.

[92] G. Ros, A. D. Sappa, D. Ponsa, and A. M. Lopez, “Visual SLAM fordriverless cars: A brief survey,” in Proc. IEEE Intell. Veh. Symp. Workshops, 2012, pp. 1–6.

[93] S. Lowry et al., “Visual place recognition: A survey,” IEEE Trans. Robot.,vol. 32, no. 1, pp. 1–19, Feb. 2016.

[94] S. Saeedi, M. Trentini, M. Seto, and H. Li, “Multiple-robot simultaneouslocalization and mapping: A review,” J. Field Robot., vol. 33, no. 1,pp. 3–46, 2016.

[95] A. Bonarini, W. Burgard, G. Fontana, M. Matteucci, D. G. Sorrenti,and J. D. Tard´os, “RAWSEEDS: Robotics advancement through webpublishing of sensorial and elaborated extensive data sets,” in Proc.IEEE/RSJ Int. Conf. Intell. Robots Syst. Workshop Benchmarks in Robot.Res., 2006, p. 5.

[96] M. Smith, I. Baldwin, W. Churchill, R. Paul, and P. Newman, “The newcollege vision and laser data set,” Int. J. Robot. Res., vol. 28, no. 5,pp. 595–599, 2009.

[97] A. Geiger, P. Lenz, and R. Urtasun, “Are we ready for autonomous driving? The KITTI vision benchmark suite,” in Proc. IEEE Conf. Comput.Vis. Pattern Recognit., 2012, pp. 3354–3361.

[98] J.-L. Blanco-Claraco, F.-A. Moreno-Duenas, and J. Gonz´alez-Jim´enez,“The Malaga Urban dataset: High-rate stereo and lidars in a realisticurban scenario,” Int. J. Robot. Res., vol. 33, no. 2, pp. 207–214, 2014.

[99] M. Cummins and P. Newman, “FAB-MAP: Probabilistic localization andmapping in the space of appearance,” Int. J. Robot. Res., vol. 27, no. 6,pp. 647–665, 2008.

[100] J.-L. Blanco, F.-A. Moreno, and J. Gonzalez, “A collection of outdoorrobotic datasets with centimeter-accuracy ground truth,” Auton. Robots,vol. 27, no. 4, pp. 327–351, 2009.

[101] A. S. Huang et al., “A high-rate, heterogeneous data set from the DARPAurban challenge,” Int. J. Robot. Res., vol. 29, no. 13, pp. 1595–1601, 2010.

[102] T. Peynot, S. Scheding, and S. Terho, “The marulan data sets: Multisensor perception in natural environment with challenging conditions,”Int.J. Robot. Res., vol. 29, no. 13, pp. 1602–1607, 2010.

[103] A. Geiger, J. Ziegler, and C. Stiller, “StereoScan: Dense 3d reconstructionin real-time,” in Proc. IEEE Intell. Veh. Symp., 2011, pp. 963–968.

[104] G. Pandey, J. R. McBride, and R. M. Eustice, “Ford campus vision andlidar data set,” Int. J. Robot. Res., vol. 30, no. 13, pp. 1543–1552, 2011.

[105] J. Zhang and S. Singh, “Visual-Lidar odometry and mapping: Low-drift,robust, and fast,” in Proc. IEEE Int. Conf. Robot. Autom., 2015, pp. 2174–2181.

[106] I. Cvisiˇ ´c and I. Petrovi´c, “Stereo odometry based on careful featureselection and tracking,” in Proc. 2015 Eur. Conf. Mobile Robot., 2015,pp. 1–6.

[107] M. Buczko and V. Willert, “How to distinguish inliers from outliers invisual odometry for high-speed automotive applications,” in Proc. IEEEIntell. Veh. Symp., 2016, pp. 478–483.

[108] M. Persson, T. Piccini, M. Felsberg, and R. Mester, “Robust stereo visualodometry from monocular techniques,” in Proc. IEEE Intell. Veh. Symp.,2015, pp. 686–691.Authorized licensed use limited to: Qilu University of Technology. Downloaded on July 11,2022 at 01:17:10 UTC from IEEE Xplore. Restrictions apply.BRESSON et al.: SIMULTANEOUS LOCALIZATION AND MAPPING: A SURVEY OF CURRENT TRENDS IN AUTONOMOUS DRIVING 217

[109] J. Ziegler et al., “Making bertha drive: An autonomous journey on ahistoric route,” IEEE Intell. Transp. Syst. Mag., vol. 6, no. 2, pp. 8–20,Summer 2014.

[110] S. Huang and G. Dissanayake, “Convergence and consistency analysisfor extended kalman filter based SLAM,” IEEE Trans. Robot., vol. 23,no. 5, pp. 1036–1049, Oct. 2007.

[111] T. Bailey, J. Nieto, J. Guivant, M. Stevens, and E. Nebot, “Consistency ofthe EKF-SLAM algorithm,” in Proc. IEEE/RSJ Int. Conf. Intell. RobotsSyst., 2006, pp. 3562–3568.

[112] U. Frese, “A Discussion of simultaneous localization and mapping,”Auton. Robots, vol. 20, no. 1, pp. 25–42, 2006.

[113] G. Bresson, R. Aufr`ere, and R. Chapuis, “A general consistent decentralized SLAM solution,” Robot. Auton. Syst., no. 74, pp. 128–147, 2015.

[114] S. Huang, Y. Lai, U. Frese, and G. Dissanayake, “How far is SLAM froma linear least squares problem?” in Proc. IEEE/RSJ Int. Conf. Intell.Robots Syst., 2010, pp. 3011–3016.

[115] J. A. Castellanos, J. Neira, and J. D. Tard´os, “Limits to the consistency ofEKF-Based SLAM,” in Proc. 5th IFAC Symp. Intell. Auton. Veh., 2004,pp. 716–721.

[116] J. A. Castellanos, R. Martinez-Cantin, J. D. Tard´os, and J. Neira, “Robocentric map joining: Improving the consistency of EKF-SLAM,” Robot.Auton. Syst., vol. 55, no. 1, pp. 21–29, 2007.

[117] J. Civera, O. G. Grasa, A. J. Davison, and J. M. M. Montiel, “1-PointRANSAC for EKF-based structure from motion,” in Proc. IEEE/RSJ Int.Conf. Intell. Robot Syst., 2009, pp. 3498–3504.

[118] B. P. Williams and I. D. Reid, “On combining visual SLAM and visualodometry,” in Proc. IEEE Int. Conf. Robot. Autom., 2010, pp. 3494–3500.

[119] T.-D. Vu, “Vehicle perception: Localization, mapping with detection,classification and tracking of moving objects,” Ph.D. dissertation, Inst.Nat. Polytechnique de Grenoble-INPG, Grenoble, France, 2009.

[120] C.-C. Wang, C. Thorpe, and A. Suppe, “Ladar-based detection and tracking of moving objects from a ground vehicle at high speeds,” in Proc.IEEE Intell. Veh. Symp., 2003, pp. 416–421.

[121] C.-C. Wang, C. Thorpe, and S. Thrun, “Online simultaneous localizationand mapping with detection and tracking of moving objects: Theory andresults from a ground vehicle in crowded urban areas,” in Proc. IEEEInt. Conf. Robot. Autom., 2003, pp. 842–849.

[122] S. I. Roumeliotis, G. S. Sukhatme, and G. A. Bekey, “Sensor fault detection and identification in a mobile robot,” in Proc. IEEE/RSJ Int. Conf.Intell. Robots Syst., 1998, pp. 1383–1388.

[123] P. Goel, G. Dedeoglu, S. I. Roumeliotis, and G. S. Sukhatme, “Faultdetection and identification in a mobile robot using multiple model estimation and neural network,” in Proc. IEEE Int. Conf. Robot. Autom.,2000, pp. 2302–2309.

[124] P. Sundvall and P. Jensfelt, “Fault detection for mobile robots usingredundant positioning systems,” in Proc. IEEE Int. Conf. Robot. Autom.,2006, pp. 3781–3786.

[125] Y. Morales, E. Takeuchi, and T. Tsubouchi, “Vehicle localization inoutdoor woodland environments with sensor fault detection,” in Proc.IEEE Int. Conf. Robot. Autom., 2008, pp. 449–454.

[126] A. Jabbari, R. Jedermann, and W. Lang, “Application of computationalintelligence for sensor fault detection and isolation,” World Acad. Sci.,Eng. Technol., vol. 33, pp. 265–270, 2007.

[127] J. Engel, V. Koltun, and D. Cremers, “Direct sparse odometry,” IEEETrans. Pattern Anal. Mach. Intell., vol. PP. no. 99, pp. 1–1, 2017,10.1109/TPAMI.2017.2658577.

[128] R. C. Luo, C.-C. Yih, and K. L. Su, “Multisensor fusion and integration:Approaches, applications, and future research directions,” IEEE SensorsJ., vol. 2, no. 2, pp. 107–119, Apr. 2002.

[129] J. A. Castellanos, J. Neira, and J. D. Tard´os, “Multisensor fusion forsimultaneous localization and map building,” IEEE Trans. Robot. Autom.,vol. 17, no. 6, pp. 908–914, Dec. 2001.

[130] L. Wei, C. Cappelle, and Y. Ruichek, “Camera/laser/GPS fusionmethod for vehicle positioning under extended NIS-based sensor validation,” IEEE Trans. Instrum. Meas., vol. 62, no. 11, pp. 3110–3122,Nov. 2013.

[131] B. Williams, M. Cummins, J. Neira, P. Newman, I. Reid, and J. Tard´os,“A comparison of loop closing techniques in monocular SLAM,” Robot.Auton. Syst., vol. 57, no. 12, pp. 1188–1197, 2009.

[132] E. Eade and T. Drummond, “Unified loop closing and recovery for realtime monocular SLAM,” in Proc. Brit. Mach. Vis. Conf., 2008, pp. 6.1–6.10.

[133] L. A. Clemente, A. J. Davison, I. D. Reid, J. Neira, and J. D. Tard´os,“Mapping large loops with a single hand-held camera,” in Proc. Robot.,Science and Syst., 2007, p. 8.

[134] B. Williams, M. Cummins, J. Neira, P. Newman, I. Reid, and J. Tard´os,“An image-to-map loop closing method for monocular SLAM,” in Proc.IEEE/RSJ Int. Conf. Intell. Robots Syst., 2008, pp. 2053–2059.

[135] J. Sivic and A. Zisserman, “Efficient visual search of videos cast astext retrieval,” IEEE Trans. Pattern Anal. Mach. Intell., vol. 31, no. 4,pp. 591–606, Apr. 2009.

[136] D. G. Lowe, “Distinctive image features from scale-invariant keypoints,”Int. J. Comput. Vis., vol. 60, no. 2, pp. 91–110, 2004.

[137] M. Cummins and P. Newman, “Appearance-only SLAM at large scalewith FAB-MAP 2.0,” Int. J. Robot. Res., vol. 30, no. 9, pp. 1100–1123,2011.

[138] A. Kawewong, N. Tongprasit, S. Tangruamsub, and O. Hasegawa, “Online and incremental appearance-based SLAM in highly dynamic environments,” Int. J. Robot. Res., vol. 30, no. 1, pp. 33–55, 2010.

[139] M. J. Milford and G. F. Wyeth, “SeqSLAM: Visual route-based navigation for sunny summer days and stormy winter nights,” in Proc. IEEEInt. Conf. Robot. Autom., 2012, pp. 1643–1649.

[140] E. Pepperell, P. Corke, and M. Milford, “Routed roads: Probabilistic vision-based place recognition for changing conditions, split streetand varied viewpoints,” Int. J. Robot. Res., vol. 35, pp. 1057–1179,2016.

[141] T. Naseer, L. Spinello, W. Burgard, and C. Stachniss, “Robust visualrobot localization across seasons using network flows,” in Proc. AAAIConf. Artif. Intell., 2014, pp. 2564–2570.

[142] T. Naseer, M. Ruhnke, C. Stachniss, L. Spinello, andW. Burgard, “Robustvisual SLAM across seasons,” in Proc. IEEE/RSJ Int. Conf. Intell. RobotsSyst., 2015, pp. 2529–2535.

[143] J. Neira, J. D. Tard´os, and J. A. Castellanos, “Linear time vehicle relocation in SLAM,” in Proc. IEEE Int. Conf. Robot. Autom., 2003, vol. 1,pp. 427–433.

[144] H. Li and F. Nashashibi, “A new method for occupancy grid maps merging: Application to multi-vehicle cooperative local mapping and movingobject detection in outdoor environment,” in Proc. Int. Conf. Control,Autom., Robot. Vis., 2012, pp. 632–637.

[145] H. Li and F. Nashashibi, “Multi-vehicle cooperative localization usingindirect vehicle-to-vehicle relative pose estimation,” in Proc. IEEE Int.Conf. Veh. Electron. Safety, 2012, pp. 267–272.

[146] J. Neira and J. D. Tard´os, “Data association in stochastic mapping usingthe joint compatibility Test,” IEEE Trans. Robot. Autom., vol. 17, no. 6,pp. 890–897, Dec. 2002.

[147] J. Xie, F. Nashashibi, M. Parent, and O. G. Favrot, “A real-time robustglobal localization for autonomous mobile robots in large environments,”in Proc. Int. Conf. Control, Autom., Robot. Vis., 2010, pp. 1397–1402.

[148] P. Newman et al., “Navigating, recognising and describing urban spaceswith vision and laser,” Int. J. Robot. Res., vol. 28, no. 11-12, pp. 1406–1433, 2009.

[149] P. Besl and N. McKay, “Method for registration of 3-D shapes,” IEEETrans. Pattern Anal. Mach. Intell., vol. 14, no. 2, pp. 239–256, Feb. 2002.

[150] J. McDonald, M. Kaess, C. Cadena, J. Neira, and J. J. Leonard, “6-DOFmulti-session visual SLAM using anchor nodes,” in Proc. Eur. Conf.Mobile Robot., 2011, pp. 69–76.

[151] A. Martinelli, N. Tomatis, and R. Siegwart, “Some results on SLAM andthe closing the loop problem,” in Proc. IEEE/RSJ Int. Conf. Intell. RobotsSyst., 2005, pp. 2917–2922.

[152] D. M. Cole and P. M. Newman, “Using laser range data for 3D SLAMin outdoor environments,” in Proc. IEEE Int. Conf. Robot. Autom., 2006,pp. 1556–1563.

[153] G. Bresson, M.-C. Rahal, D. Gruyer, M. Revilloud, and Z. Alsayed, “Acooperative fusion architecture for robust localization: Application toautonomous driving,” in Proc. IEEE 19th Int. Conf. Intell. Transp. Syst.,2016, pp. 859–866.

[154] H. Johannsson, M. Kaess, M. Fallon, and J. J. Leonard, “Temporallyscalable visual SLAM using a reduced pose graph,” in Proc. IEEE Int.Conf. Robot. Autom., 2013, pp. 54–61.

[155] T. F´eraud, P. Checchin, R. Aufr`ere, and R. Chapuis, “Communicatingvehicles in convoy and monocular vision-based localization,” in Proc.7th Symp. Intell. Auton. Veh., 2010, vol. 7, pp. 73–78.

[156] J. P. Lewis, “Fast normalized cross-correlation,” in Proc. Vis. Interface,1995, pp. 120–123.

[157] E. Menegatti, T. Maeda, and H. Ishiguro, “Image-based memory forrobot navigation using properties of omnidirectional images,” Robot.Auton. Syst., vol. 47, no. 4, pp. 251–267, 2004.

[158] A. Remazeilles, F. Chaumette, and P. Gros, “Robot motion control from avisual memory,” in Proc. IEEE Int. Conf. Robot. Autom., 2004, pp. 4695–4700.Authorized licensed use limited to: Qilu University of Technology. Downloaded on July 11,2022 at 01:17:10 UTC from IEEE Xplore. Restrictions apply.218 IEEE TRANSACTIONS ON INTELLIGENT VEHICLES, VOL. 2, NO. 3, SEPTEMBER 2017

[159] M. Jogan and A. Leonardis, “Robust localization using panoramic viewbased recognition,” in Proc. 15th Int. Conf. Pattern Recognit., 2000,pp. 136–139.

[160] O. Vysotka and C. Stachniss, “Lazy data association for image sequencesmatching under substantial appearance change,” IEEE Robot. Autom.Lett., vol. 1, no. 1, pp. 213–220, Jan. 2016.

[161] A. Walcott-Bryant, M. Kaess, H. Johannsson, and J. J. Leonard, “Dynamic pose graph SLAM: Long-term mapping in low dynamic environments,” in Proc. IEEE/RSJ Int. Conf. Intell. Robots Syst., 2012,pp. 1871–1878.

[162] K. Konolige and J. Bowman, “Towards lifelong visual maps,” in Proc.IEEE/RSJ Int. Conf. Intell. Robots Syst., 2009, pp. 1156–1163.

[163] W. Churchill and P. Newman, “Practice makes perfect? managing andleveraging visual experiences for lifelong navigation,” in Proc. IEEE Int.Conf. Robot. Autom., 2012, pp. 4525–4532.

[164] C. Linegar, W. Churchill, and P. Newman, “Made to measure: Bespokelandmarks for 24-hour, all-weather localisation with a camera,” in Proc.IEEE Int. Conf. Robot. Autom., 2016, pp. 787–794.

[165] A. Kendall, M. Grimes, and R. Cipolla, “PoseNet: A convolutional network for real-time 6-DOF camera relocalization,” in Proc. IEEE Int.Conf. Comput. Vis., 2015, pp. 2938–2946.

[166] P. Muhlfellner, M. Brki, M. Bosse, W. Derendarz, R. Philippsen, andP. Furgale, “Summary maps for lifelong visual localization,” J. FieldRobot., vol. 33, no. 5, pp. 561–590, 2015.

[167] H. Grimmett et al., “Integrating metric and semantic maps for visiononly automated parking,” in Proc. IEEE Int. Conf. Robot. Autom., 2015,pp. 2159–2166.

[168] P. Biber and T. Duckett, “Experimental analysis of sample-based mapsfor long-term SLAM,” Int. J. Robot. Res., vol. 28, no. 1, pp. 20–33, 2009.

[169] A. I. Comport, M. Meilland, and P. Rives, “An asymmetric real-timedense visual localisation and mapping system,” in Proc. IEEE Int. Conf.Comput. Vis. Workshops, 2011, pp. 700–703.

[170] M. Meilland, A. I. Comport, and P. Rives, “Dense visual mapping oflarge scale environments for real-time localisation,” in Proc. IEEE/RSJInt. Conf. Intell. Robots Syst., 2011, pp. 4242–4248.

[171] P. Furgale and T. D. Barfoot, “Visual teach and repeat for long-rangerover autonomy,” J. Field Robot., vol. 27, no. 5, pp. 537–560, 2010.

[172] E. Royer, M. Lhuillier, M. Dhome, and J.-M. Lavest, “Monocular visionfor mobile robot localization and autonomous navigation,” Int. J. Comput.Vis., vol. 74, no. 3, pp. 237–260, 2007.

[173] H. Lategahn and C. Stiller, “City GPS using stereo vision,” in Proc. IEEEInt. Conf. Veh. Electron. Safety, 2012, pp. 1–6.

[174] H. Badino, D. Huber, and T. Kanade, “Real-time topometric localization,” in Proc. IEEE Int. Conf. Robot. Autom., 2012, pp. 1635–1642.

[175] J. Matas, O. Chum, M. Urban, and T. Pajdla, “Robust wide-baselinestereo from maximally stable extremal regions,” Image Vis. Comput.,vol. 22, no. 10, pp. 761–767, 2004.

[176] H. Deusch, J. Wiest, S. Reuter, D. Nuss, M. Fritzsche, and K. Dietmayer,“Multi-sensor self-localization based on maximally stable extremal regions,” in Proc. IEEE Intell. Veh. Symp., 2014, pp. 555–560.

[177] J. Levinson, M. Montemerlo, and S. Thrun, “Map-based precision vehiclelocalization in urban environments,” in Robotics: Science and Systems,vol. 4. Cambridge, MA, USA: MIT Press, 2007.

[178] J. Levinson and S. Thrun, “Robust vehicle localization in urban environments using probabilistic maps,” in Proc. IEEE Int. Conf. Robot. Autom.,2010, pp. 4372–4378.

[179] A. Napier and P. Newman, “Generation and exploitation of local orthographic imagery for road vehicle localisation,” in Proc. IEEE Intell. Veh.Symp., 2012, pp. 590–596.

[180] D. Betaille and R. Toledo-Moreo, “Creating enhanced maps for lanelevel vehicle navigation,” IEEE Trans. Intell. Transp. Syst., vol. 11,no. 4, pp. 786–798, Dec. 2010.

[181] R. Toledo-Moreo, D. Betaille, and F. Peyret, “Lane-level integrity provision for navigation and map matching with GNSS, dead reckoning,and enhanced maps,” IEEE Trans. Intell. Transp. Syst., vol. 11, no. 1,pp. 100–112, Mar. 2010.

[182] P. Czerwionka, M. Wang, and F. Wiesel, “Optimized route network graphas map reference for autonomous cars operating on German autobahn,”in Proc. IEEE 5th Int. Conf. Autom., Robot. Appl., 2011, pp. 78–83.

[183] A. Joshi and M. R. James, “Generation of accurate lane-level maps fromcoarse prior maps and lidar,” IEEE Intell. Transp. Syst. Mag., vol. 7,no. 1, pp. 19–29, Spring 2015.

[184] C. Guo, J.-I. Meguro, Y. Kojima, and T. Naito, “Automatic lane-levelmap generation for advanced driver assistance systems using low-costsensors,” in Proc. IEEE Int. Conf. Robot. Autom., 2014, pp. 3975–3982.

[185] C. Guo, K. Kidono, J. Meguro, Y. Kokima, M. Ogawa, and T. Naito, “Alow-cost solution for automatic lane-level map generation using conventional in-car sensors,” IEEE Trans. Intell. Transp. Syst., vol. 17, no. 8,pp. 2355–2366, Aug. 2016.

[186] P. Bender, J. Ziegler, and C. Stiller, “Lanelets: Efficient map representation for autonomous driving,” in Proc. IEEE Intell. Veh. Symp., 2014,pp. 420–425.

[187] M. Schreiber, C. Knoppel, and U. Franke, “LaneLoc: Lane markingbased localization using highly accurate maps,” in Proc. IEEE Intell.Veh. Symp., 2013, pp. 449–454.

[188] I. Miller, M. Campbell, and D. Huttenlocher, “Map-aided localization insparse global positioning system environments using vision and particlefiltering,” J. Field Robot., vol. 28, no. 5, pp. 619–643, 2011.

[189] K. K. Lee, S. Wijesoma, and J. Ibanez-Guzm´an, “A constrainedSLAM approach to robust and accurate localisation of autonomousground vehicles,” Robot. Auton. Syst., vol. 55, no. 7, pp. 527–540,2007.

[190] Z. Tao, P. Bonnifait, V. Fr´emont, and J. Ibanez-Guzm´an, “Mapping andlocalization using GPS, lane markings and proprioceptive sensors,” inProc. IEEE/RSJ Int. Conf. Intell. Robots Syst., 2013, pp. 406–412.

[191] L. Delobel, C. Aynaud, R. Aufr`ere, R. Chapuis, T. Chateau, and C.Bernay-Angeletti, “Robust localization using a top-down approach withseveral LIDAR sensors,” in Proc. IEEE Int. Conf. Robot. Biomimetics,2015, pp. 2374–2376.

[192] C. Brenner, “Vehicle localization using landmarks obtained by a LIDARmobile mapping system,” Int. Arch. Photogramm., Remote Sens. SpatialInf. Sci., vol. 38, pp. 139–144, 2010.

[193] R. Spangenberg, D. Goehring, and R. Rojas, “Pole-based localization forautonomous vehicles in urban scenarios,” in Proc. IEEE/RSJ Int. Conf.Intell. Robots Syst., 2016, pp. 2161–2166.

[194] A. Majdik, Y. Albers-Schoenberg, and D. Scaramuzza, “MAV urbanlocalization from google street view data,” in Proc. IEEE/RSJ Int. Conf.Intell. Robots Syst., 2013, pp. 3979–3986.

[195] A. R. Zamir and M. Shah, “Accurate image localization based on googlemaps street view,” in Proc. 11th Eur. Conf. Comput. Vis., 2010, pp. 255–268.

[196] G. Vaca-Castano, A. R. Zamir, and M. Shah, “City scale geo-spatialtrajectory estimation of a moving camera,” in Proc. IEEE Conf. Comput.Vis. Pattern Recognit., 2012, pp. 1186–1193.

[197] L. Yu, C. Joly, G. Bresson, and F. Moutarde, “Monocular urban localization using street view,” in Proc. 14th Int. Conf. Control, Autom., Robot.Vis., 2016, pp. 1–6.

[198] G. Schindler, M. Brown, and R. Szeliski, “City-scale location recognition,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2007,pp. 1–7.

[199] G. Baatz, K. K¨oser, D. Chen, R. Grzeszczuk, and M. Pollefeys, “Leveraging 3D city models for rotation invariant place-of-interest recognition,”Int. J. Comput. Vis., vol. 96, no. 3, pp. 315–334, 2012.

[200] T. Yeh, K. Tollmar, and T. Darrell, “Searching the web with mobile images for location recognition,” in Proc. IEEE Conf. Comput. Vis. PatternRecognit., 2004, vol. 2, pp. II-76–II-81.

[201] G. Fritz, C. Seifert, M. Kumar, and L. Paletta, “Building detection frommobile imagery using informative SIFT descriptors,” in Proc. 14th Scandinavian Conf. Image Analysis, 2005, pp. 629–638.

[202] A. Torii, J. Sivic, and T. Pajdla, “Visual localization by linear combinationof image descriptors,” in Proc. IEEE Int. Conf. Comput. Vis. Workshops,2011, pp. 102–109.

[203] L. Yu, C. Joly, G. Bresson, and F. Moutarde, “Improving robustnessof monocular urban localization using augmented street view,” in Proc.IEEE 19th Int. Conf. Intell. Transp. Syst., 2016, pp. 513–519.

[204] W. Zhang and J. Kosecka, “Image based localization in urban environments,” in Proc. 3rd Int. Symp. 3D Data Process., Vis., Transmiss., 2006,pp. 33–40.

[205] P. Agarwal, W. Burgard, and L. Spinello, “Metric localization usinggoogle street view,” in Proc. 2015 IEEE/RSJ Int. Conf. Intell. RobotsSyst., 2015, pp. 3111–3118.

[206] N. Radwan, G. D. Tipaldi, L. Spinello, and W. Burgard, “Do you see theBakery? Leveraging geo-referenced texts for global localization in publicmaps,” in Proc. IEEE Int. Conf. Robot. Autom., 2016, pp. 4837–4842.

[207] X. Qu, B. Soheilian, and N. Paparoditis, “Vehicle localization usingmono-camera and geo-referenced traffic signs,” in Proc. IEEE Intell.Veh. Symp., 2015, pp. 605–610.

[208] A. Welzel, P. Reisdorf, and G. Wanielik, “Improving urban vehicle localization with traffic sign recognition,” in Proc. IEEE Int. Conf. Intell.Transp. Syst., 2015, pp. 2728–2732.Authorized licensed use limited to: Qilu University of Technology. Downloaded on July 11,2022 at 01:17:10 UTC from IEEE Xplore. Restrictions apply.BRESSON et al.: SIMULTANEOUS LOCALIZATION AND MAPPING: A SURVEY OF CURRENT TRENDS IN AUTONOMOUS DRIVING 219

[209] P. Merriaux, Y. Dupuis, P. Vasseur, and X. Savatier, “Fast and robustvehicle positioning on graph-based representation of drivable maps,” inProc. IEEE Int. Conf. Robot. Autom., 2015, pp. 2787–2793.

[210] O. Pink, F. Moosmann, and A. Bachmann, “Visual features for vehiclelocalization and ego-motion estimation,” in Proc. IEEE Intell. Veh. Symp.,2009, pp. 254–260.

[211] J.W. Fenwick, P. M. Newman, and J. J. Leonard, “Cooperative concurrentmapping and localization,” in Proc. IEEE Int. Conf. Robot. Autom., 2002,vol. 2, pp. 1810–1817.

[212] T. Tao, Y. Huang, J. Yuan, F. Sun, and X. Wu, “Cooperative simultaneous localization and mapping for multi-robot: Approach & experimentalvalidation,” in Proc. 8th World Congr. Intell. Control Autom., 2010,pp. 2888–2893.

[213] A. Gil, O. Reinoso, M. Ballesta, and M. Juli´a, “Multi-robot visual SLAMusing a Rao-Blackwellized particle filter,” Robot. Auton. Syst., vol. 58,no. 1, pp. 68–80, 2010.

[214] L. Riazuelo, J. Civera, and J. M. M. Montiel, “C2TAM: A cloud framework for cooperative tracking and mapping,” Robot. Auton. Syst., vol. 62,no. 4, pp. 401–413, 2014.

[215] R. Arumugam et al., “DAvinCi: A cloud computing framework for service robots,” in Proc. IEEE Int. Conf. Robot. Autom., 2010, pp. 3084–3089.

[216] G. Mohanarajah, D. Hunziker, R. D’Andrea, and M. Waibel, “Rapyuta:A cloud robotics platform,” IEEE Trans. Autom. Sci. Eng., vol. 12,no. 2, pp. 481–493, Apr. 2015.

[217] R. Doriya, P. Sao, V. Payal, V. Anand, and P. Chakraborty, “A review oncloud robotics based frameworks to solve simultaneous localization andmapping (SLAM) problem,” Int. J. Adv. Comput. Sci. Cloud Comput.,vol. 3, pp. 40–45, 2015.

[218] B. Kehoe, S. Patil, P. Abbeel, and K. Goldberg, “A survey of research oncloud robotics and automation,” IEEE Trans. Autom. Sci. Eng., vol. 12,no. 2, pp. 398–409, Apr. 2015.

[219] M. Waibel et al., “RoboEarth,” IEEE Robot. Autom. Mag., vol. 18, no. 2,pp. 69–82, Jun. 2011.

[220] E. Nettleton, S. Thrun, H. Durrant-Whyte, and S. Sukkarieh, “Decentralised SLAM with low-bandwidth communication for teams of vehicles,” in Proc. Field Service Robot., 2006, pp. 179–188.

[221] E. Nettleton, H. Durrant-Whyte, and S. Sukkarieh, “A robust architecture for decentralised data fusion,” in Proc. Int. Conf. Adv. Robot.,2003, p. 6.

[222] H. Durrant-Whyte, “A beginner’s guide to decentralised data fusion,”Australian Centre Field Robot., Univ. Sydney, Sydney, NSW, Australia,Tech. Rep., 2000, pp. 1–27.

[223] S. P. McLaughlin, R. J. Evans, and B. Krishnamurthy, “Data incestremoval in survivable estimation fusion architecture,” in Proc. Int. Conf.Inf. Fusion, 2003, vol. 1, pp. 229–236.

[224] M. Hua, T. Bailey, P. Thompson, and H. Durrant-Whyte, “Decentralised solutions to the cooperative multi-platform navigation problem,”IEEE Trans. Aerosp. Electron. Syst., vol. 47, no. 2, pp. 1433–1449,Apr. 2010.

[225] S. B. Williams, G. Dissanayake, and H. Durrant-Whyte, “Towards multivehicle simultaneous localisation and mapping,” in Proc. IEEE Int. Conf.Robot. Autom., 2002, pp. 2743–2748.

[226] T. A. Vidal-Calleja, C. Berger, J. Sol`a, and S. Lacroix, “Large scalemultiple robot visual mapping with heterogeneous landmarks in semistructured terrain,” Robot. Auton. Syst., vol. 59, no. 9, pp. 654–674, 2011.

[227] A. Cunningham, M. Paluri, and F. Dellaert, “DDF-SAM: Fully distributed SLAM using constrained factor graphs,” in Proc. IEEE/RSJInt. Conf. Intell. Robots Syst., 2010, pp. 3025–3030.

[228] R. Aragues, J. Cortes, and C. Sagues, “Dynamic consensus for mergingvisual maps under limited communications,” in Proc. IEEE Int. Conf.Robot. Autom., 2010, pp. 3032–3037.

[229] R. Aragues, E. Montijano, and C. Sagues, “Consistent data associationin multi-robot systems with limited communications,” in Proc. Robot.,Sci. Syst., 2010, pp. 51–58.

[230] H. Li and F. Nashashibi, “Cooperative multi-vehicle localization usingsplit covariance intersection filter,” IEEE Intell. Transp. Syst. Mag., vol. 5,no. 2, pp. 33–44, Summer 2013.

[231] S. Julier and J. Uhlmann, General Decentralized Data Fusion With Covariance Intersection, D. Hall and J. Llinas, Eds. Boca Raton, FL, USA:CRC Press, 2001, ch. 12.

[232] W. Burgard, M. Moors, C. Stachniss, and F. Schneider, “Coordinatedmulti-robot exploration,” IEEE Trans. Robot., vol. 21, no. 3, pp. 376–386, Jun. 2005.

[233] X. S. Zhou and S. I. Roumeliotis, “Multi-robot SLAM with unknowninitial Correspondence: The robot rendezvous case,” in Proc. IEEE/RSJInt. Conf. Intell. Robots Syst., 2006, pp. 1785–1792.

[234] S. Thrun and Y. Liu, “Multi-robot SLAM with sparse extended information filters,” in Proc. 11th Int. Symp. Robot. Res., 2003, pp. 254–266.

[235] A. Cunningham and F. Dellaert, “Large scale experimental design fordecentralized SLAM,” in Proc. Unmanned Syst. Technol. XIV, 2012,Paper 83870O.

[236] V. Indelman, E. Nelson, N. Michael, and F. Dellaert, “Multi-robot posegraph localization and data association from unknown initial relativeposes via expectation maximization,” in Proc. IEEE Int. Conf. Robot.Autom., 2014, pp. 593–600.

[237] M. Pfingsthorn, B. Slamet, and A. Visser, “A scalable hybrid multi-robotSLAM method for highly detailed maps,” in Proc. RoboCup 2007, RobotSoccer World Cup XI, 2007, pp. 457–464.

[238] H. J. Chang, C. S. G. Lee, Y. C. Hu, and Y.-H. Lu, “Multi-robot SLAMwith topological/metric maps,” in Proc. IEEE/RSJ Int. Conf. Intell.Robots Syst., 2007, pp. 1467–1472.

[239] A. Martin and M. R. Emami, “Just-in-time cooperative simultaneouslocalization and mapping,” in Proc. Int. Conf. Control, Autom., Robot.Vis., 2010, pp. 479–484.

[240] J. V. Diosdado and I. T. Ruiz, “Decentralised simultaneous localisationand mapping for AUVs,” in Proc. 2nd SEAS DTC Tech. Conf., 2007,Paper A14.

[241] R. H. Deaves et al., “Multiple robot system for decentralized SLAMinvestigations,” in Proc. Sensor Fusion Decentralized Control Robot.Syst. III, 2000, vol. 4196, pp. 360–369.

[242] H. S. Lee and K. M. Lee, “Multi-robot SLAM using ceiling vision,” inProc. IEEE/RSJ Int. Conf. Intell. Robots Syst., 2009, pp. 912–917.

[243] E. D. Dickmanns, B. Mysliwetz, and T. Christians, “An integrated spatiotemporal approach to automatic visual guidance of autonomous vehicles,” IEEE Trans. Syst., Man, Cybern., vol. 20, no. 6, pp. 1273–1284,Nov./Dec. 1990.