项目介绍

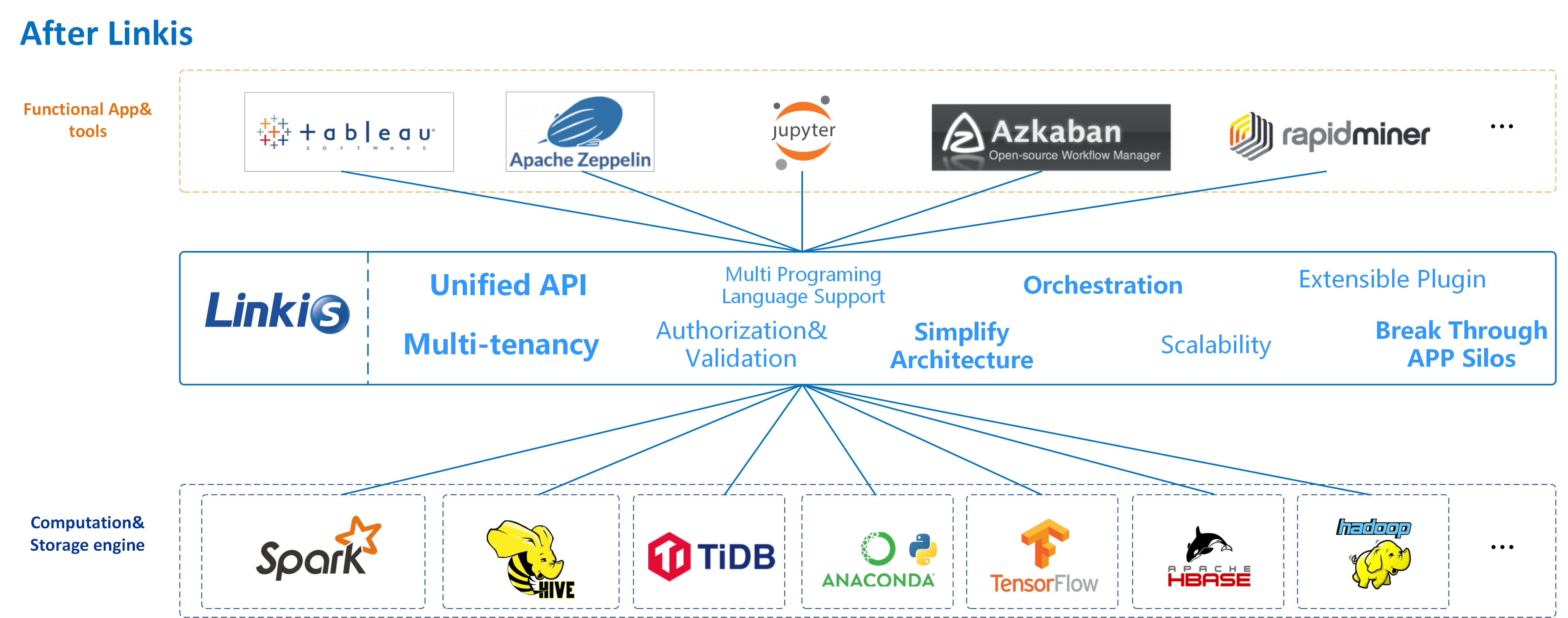

Linkis 有助于轻松连接各种后端计算/存储引擎(Spark、Python、TiDB...),公开各种接口(REST、JDBC、Java...),具有多租户、高性能和资源控制。

介绍

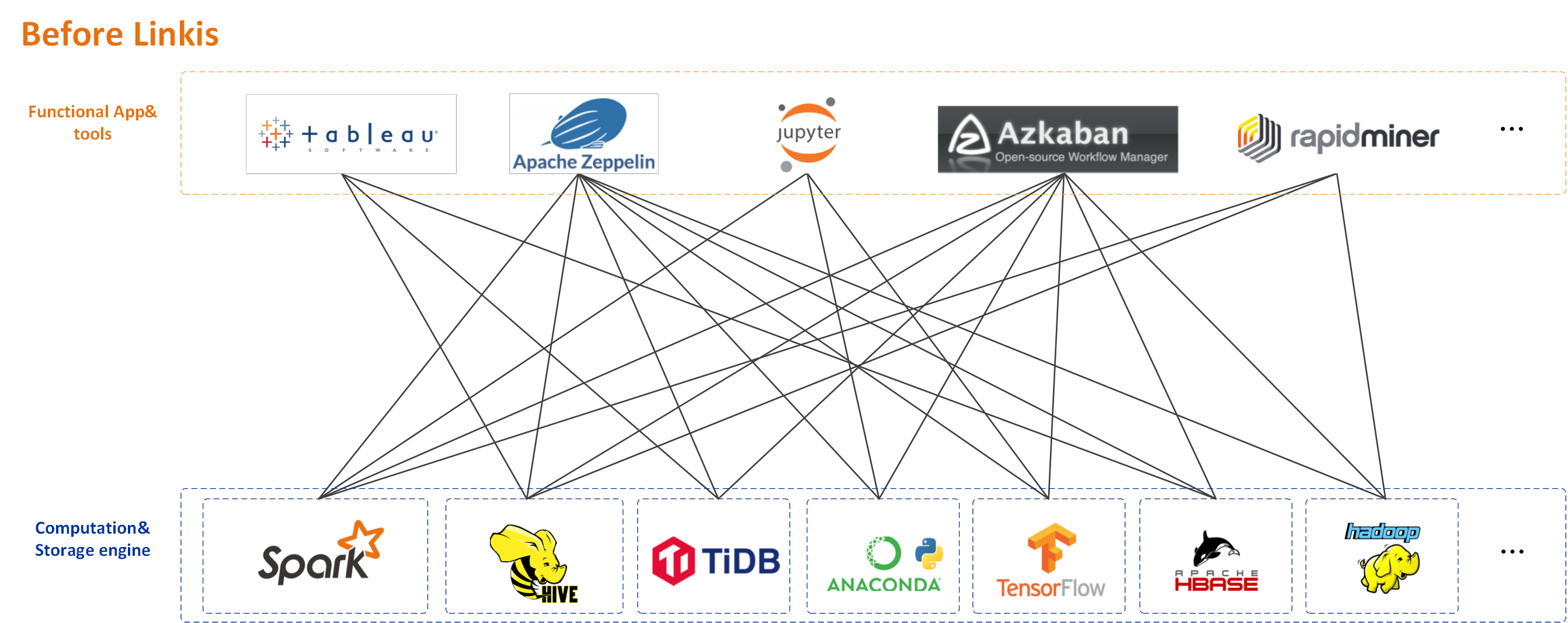

Linkis 在上层应用和底层引擎之间构建了一层计算中间件。通过使用Linkis提供的REST/WS/JDBC等标准接口,上层应用可以方便的接入MySQL/Spark/Hive/Presto/Flink等底层引擎,实现统一变量等用户资源的互通,脚本、UDF、函数和资源文件。

作为计算中间件,Linkis 提供了强大的连接、复用、编排、扩展和治理能力。通过解耦应用层和引擎层,简化了复杂的网络调用关系,从而降低了整体的复杂度,也节省了开发和维护成本。

Linkis自2019年首次发布以来,已经积累了700多家试用公司和1000+沙盒试用用户,涉及金融、银行、电信、制造业、互联网公司等多个行业。很多公司已经将Linkis作为大数据平台底层计算和存储引擎的统一入口。

特征

- 支持多种底层计算存储引擎

- 目前支持的计算/存储引擎:Spark、Hive、Flink、Python、Pipeline、Sqoop、openLooKeng、Presto、ElasticSearch、JDBC、Shell等

- 支持的计算/存储引擎:Trino(计划 1.3.1)、SeaTunnel(计划 1.3.1)等

- 支持的脚本语言:SparkSQL、HiveQL、Python、Shell、Pyspark、R、Scala和JDBC等

- 强大的任务/请求治理能力通过Orchestrator、Label Manager和定制的Spring Cloud Gateway等服务,Linkis能够提供基于多级标签、跨集群/跨IDC的细粒度路由、负载均衡、多租户、流量控制、资源控制、双活、主备等编排策略

- 支持全栈计算/存储引擎作为计算中间件,它将接收、执行和管理各种计算存储引擎的任务和请求,包括批处理任务、交互式查询任务、实时流式任务和存储任务

- 资源管理能力 ResourceManager 不仅可以对 Yarn 和 Linkis EngineManger 进行资源管理,还可以提供基于标签的多级资源分配和回收,使其拥有强大的跨 Yarn 集群和多种计算资源类型的资源管理能力

- 统一上下文服务为每个任务/请求生成上下文 ID,关联和管理用户和系统资源文件(JAR、ZIP、属性等)、结果集、参数变量、函数等,跨用户、系统和计算引擎. 一处设置,处处自动引用

- 统一素材系统和用户级统一素材管理,可跨用户、跨系统共享和传输

支持的引擎类型

| 引擎名称 | 支持组件版本 (默认依赖版本) | Linkis 版本要求 | ** 默认包含在发布包中** | 描述 |

|---|---|---|---|---|

| 火花 | Apache 2.0.0~2.4.7, CDH >= 5.4.0, (默认 Apache Spark 2.4.3) | >=1.0.3 | 是的 | Spark EngineConn,支持 SQL、Scala、Pyspark 和 R 代码 |

| 蜂巢 | Apache >= 1.0.0, CDH >= 5.4.0, (默认 Apache Hive 2.3.3) | >=1.0.3 | 是的 | Hive EngineConn,支持 HiveQL 代码 |

| Python | Python >= 2.6, (默认 Python2*) | >=1.0.3 | 是的 | Python EngineConn,支持python代码 |

| 壳 | 重击 >= 2.0 | >=1.0.3 | 是的 | Shell EngineConn,支持 Bash shell 代码 |

| JDBC | MySQL >= 5.0,Hive >=1.2.1, (默认 Hive-jdbc 2.3.4) | >=1.0.3 | 不 | JDBC EngineConn,已经支持 MySQL 和 HiveQL,可以快速扩展支持其他带有 JDBC Driver 包的引擎,例如 Oracle |

| 弗林克 | Flink >= 1.12.2, (默认 Apache Flink 1.12.2) | >=1.0.3 | 不 | Flink EngineConn,支持FlinkSQL代码,也支持以Flink Jar Application的形式启动一个新的Yarn |

| 管道 | - | >=1.0.3 | 不 | Pipeline EngineConn,支持文件导入导出 |

| 开路坑 | openLooKeng >= 1.5.0, (默认 openLookEng 1.5.0) | >=1.1.1 | 不 | openLooKeng EngineConn,支持用Sql查询数据虚拟化引擎 openLooKeng |

| Sqoop | Sqoop >= 1.4.6, (默认 Apache Sqoop 1.4.6) | >=1.1.2 | 不 | Sqoop EngineConn,支持数据迁移工具Sqoop engine |

| 急速 | Presto >= 0.180, (默认 Presto 0.234) | >=1.2.0 | - | Presto EngineConn,支持 Presto SQL 代码 |

| 弹性搜索 | ElasticSearch >=6.0, (默认 ElasticSearch 7.6.2) | >=1.2.0 | - | ElasticSearch EngineConn,支持 SQL 和 DSL 代码 |

| 黑斑羚 | 黑斑羚 >= 3.2.0,CDH >=6.3.0 | 进行中 | - | Impala EngineConn,支持 Impala SQL 代码 |

| MLSQL | MLSQL >=1.1.0 | 进行中 | - | MLSQL EngineConn,支持 MLSQL 代码。 |

| Hadoop | 阿帕奇 >=2.6.0, CDH >=5.4.0 | 进行中 | - | Hadoop EngineConn,支持 Hadoop MR/YARN 应用 |

| TiSpark | 1.1 | 进行中 | - | TiSpark EngineConn,支持使用 SparkSQL 查询 TiDB |

下载

请到Linkis 发布页面下载 Linkis 的编译发行版或源代码包。

编译和部署

有关更详细的指导,请参阅:

Note: If you want use `-Dlinkis.build.web=true` to build linkis-web image, you need to compile linkis-web first.

## compile backend

### Mac OS/Linux

# 1. When compiling for the first time, execute the following command first

./mvnw -N install

# 2. make the linkis distribution package

# - Option 1: make the linkis distribution package only

./mvnw clean install -Dmaven.javadoc.skip=true -Dmaven.test.skip=true

# - Option 2: make the linkis distribution package and docker image

# - Option 2.1: image without mysql jdbc jars

./mvnw clean install -Pdocker -Dmaven.javadoc.skip=true -Dmaven.test.skip=true

# - Option 2.2: image with mysql jdbc jars

./mvnw clean install -Pdocker -Dmaven.javadoc.skip=true -Dmaven.test.skip=true -Dlinkis.build.with.jdbc=true

# - Option 3: linkis distribution package and docker image (included web)

./mvnw clean install -Pdocker -Dmaven.javadoc.skip=true -Dmaven.test.skip=true -Dlinkis.build.web=true

# - Option 4: linkis distribution package and docker image (included web and ldh (hadoop all in one for test))

./mvnw clean install -Pdocker -Dmaven.javadoc.skip=true -Dmaven.test.skip=true -Dlinkis.build.web=true -Dlinkis.build.ldh=true -Dlinkis.build.with.jdbc=true

### Windows

mvnw.cmd -N install

mvnw.cmd clean install -Dmaven.javadoc.skip=true -Dmaven.test.skip=true

## compile web

cd incubator-linkis/linkis-web

npm install

npm run build与 MySQL JDBC 驱动程序捆绑在一起

由于 MySQL 的许可限制,官方发布的 linkis 镜像默认不捆绑 MySQL Java 数据库连接 (JDBC) 驱动程序。但是,在现阶段,linkis 仍然依赖这个库才能正常工作。为了解决这个问题,我们提供了一个脚本,可以帮助你自己从官方的linkis镜像中用mysql jdbc创建一个自定义镜像,这个工具创建的镜像将被linkis:with-jdbc默认标记为。

$> LINKIS_IMAGE=linkis:1.3.1

$> ./linkis-dist/docker/scripts/make-linikis-image-with-mysql-jdbc.sh请参考快速部署进行部署。

示例和指导

文档和视频

- Linkis 的文档在Linkis-Website Git Repository

- Bilibili上的聚会视频

建筑学

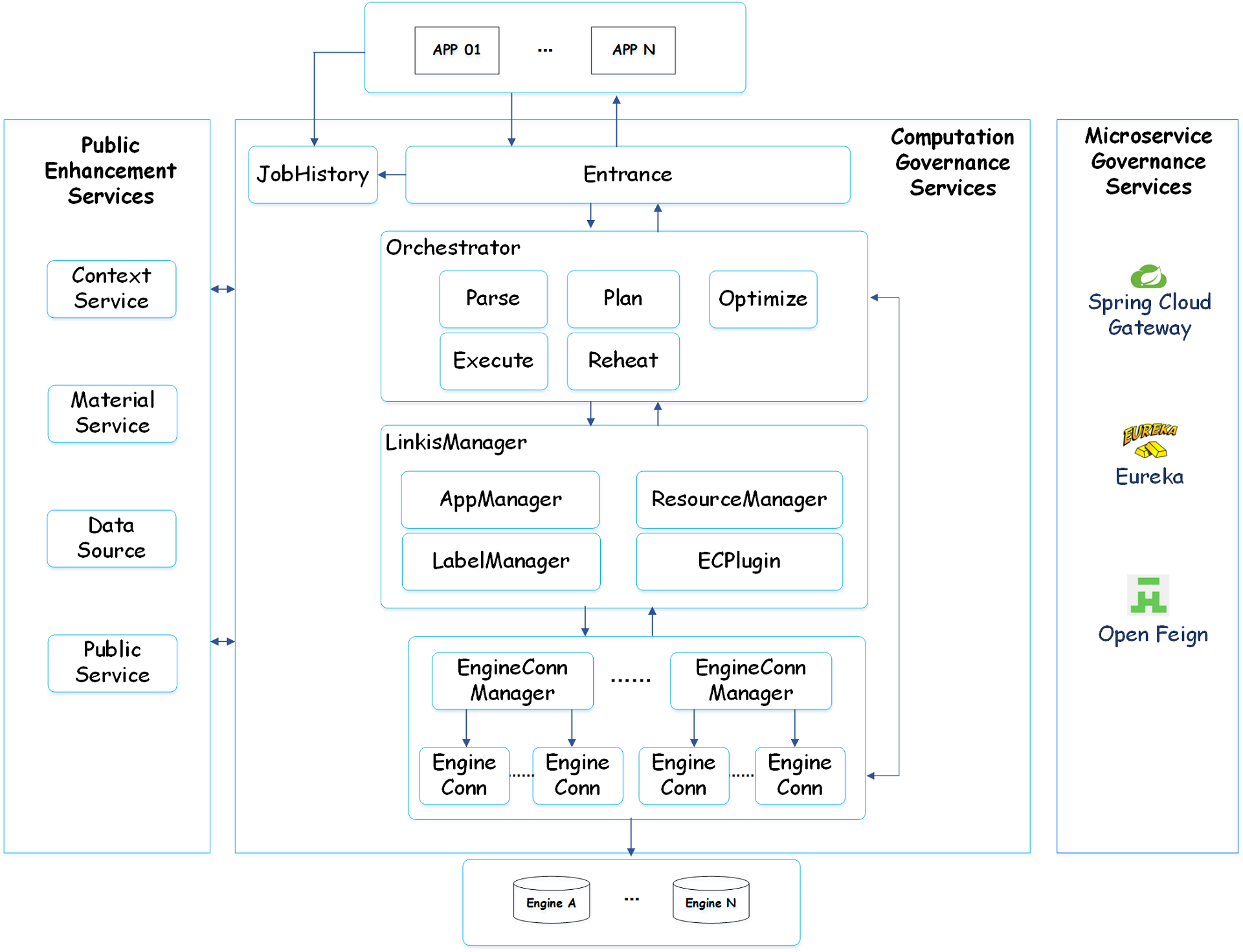

Linkis 服务可以分为三类:计算治理服务、公共增强服务和微服务治理服务

- 计算治理服务,支持处理任务/请求的 3 个主要阶段:提交 -> 准备 -> 执行

- 公共增强服务,包括素材库服务、上下文服务、数据源服务

- 微服务治理服务,包括 Spring Cloud Gateway、Eureka 和 Open Feign

下面是Linkis架构图。您可以在Linkis-Doc/Architecture中找到更详细的架构文档。