防止爬虫,原文链接:https

1. 四个问题

1. 解决什么问题(研究动机)

在无监督点云学习里,基于编码-解码 的无监督表征学习是一种范式。但是这样会带来一个问题:由于点云采样是随机变化的,这样会强制编码器学到变化的(但是这不是我们想要的,我们想要的是本质的,潜在的,可迁移的特征)。详见Abstract

2. 用了什么方法解决(方法)

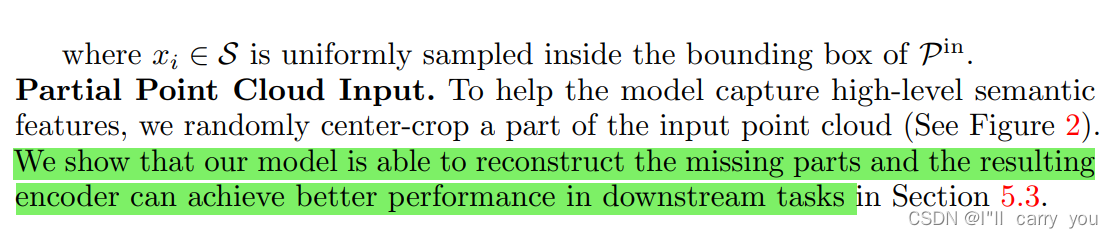

by replacing the point cloud decoder with an implicit decoder(implicit decoder? 具体的文中在2 Related Work 中Implicit Representations有介绍,暂时还不懂…)。

implicit decoder在文中说有这些好处,详见Abstract:Reconstructing under the implicit representation can prioritize that the encoder discards sampling variations, introducing more space to learn useful features

具体实作上:将x先用g() 映射为 g(x)就行了???

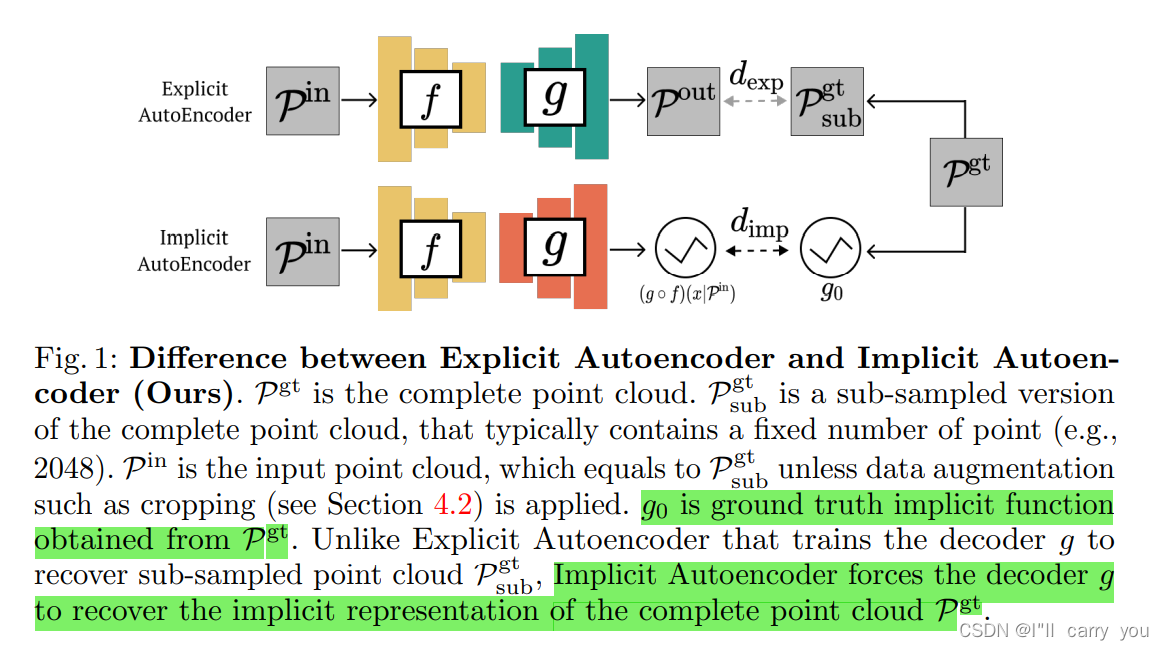

Explicit Autoencoder.:

Implicit Autoencoder.:

f, g, loss 的具体选择:

3. 效果如何

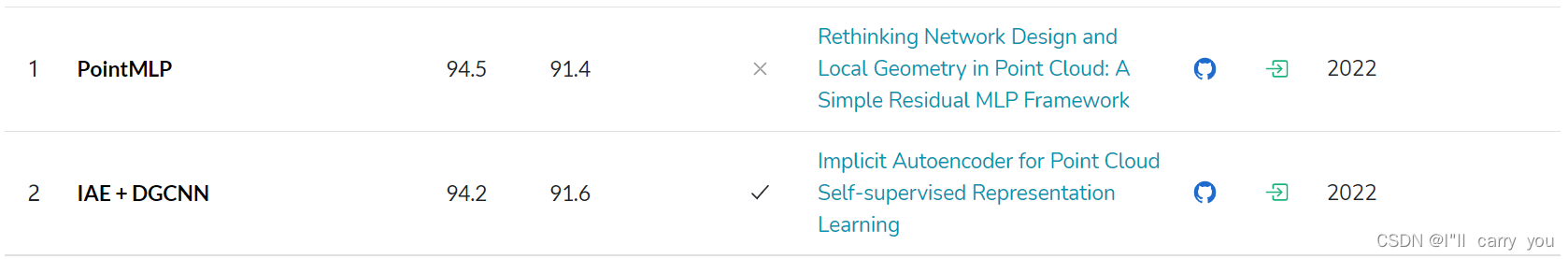

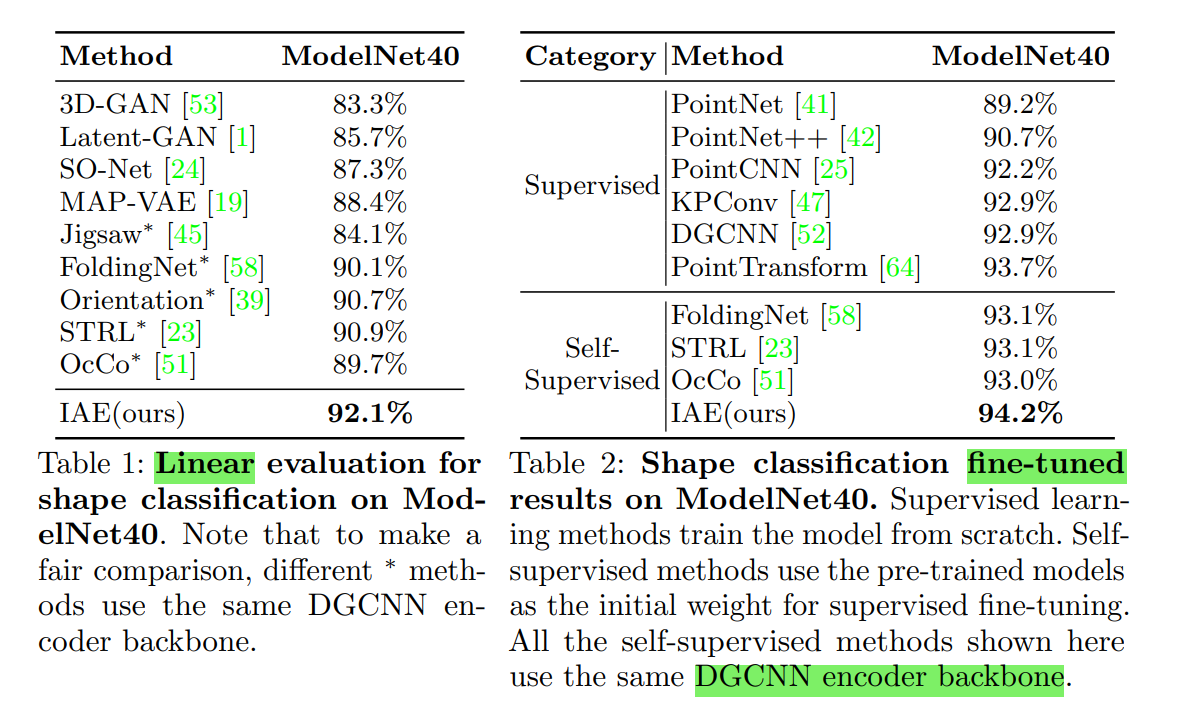

ModelNet-40 分类能排到 第2,上94了,94.2, 非常不错。

重点关注分类,当然文中还做了其它实验,具体可看文章。

4. 还存在什么问题

文中提到的:

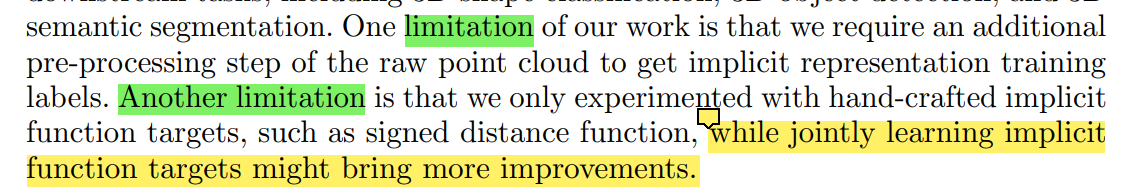

- 需要额外预处理数据

- implicit function的选择是怎样的?有无改进空间?

2. 论文介绍

1 Introduction

文章对self-supervised representation learning不错的介绍:无标签数据,迁移能力

文章对autoencoder的介绍:

基于autoencoder的点云研究相关工作:

研究动机:不需要 强制学习到不必要的信息(如变换)

组合怪:implicit + self-supervised representation

解决方法:1. implicit function;2. IAE的学习过程以最小化两个隐函数的差为指导 ,绕过计算密集且不稳定的显式数据关联;3. 此外,不需要对整个点云进行解码,IAE更小,资源效率更高

3. 参考资料

https://paperswithcode.com/paper/implicit-autoencoder-for-point-cloud-self

4. 收获

文章关键词:implicit autoencoder + self-supervised

implicit 不了解… 相关工作中有介绍

本质上提出了framework,没有提出新的模型,将autoencoder中decoder 换成 implicit decoder 就能获得巨大提升??? (ModelNet40上94不容易,94.2(fine-tune))

生成模型中点云的相关损失函数了解:

文中作者还附带中许多数学证明,不清楚…

相关工作索引了解:

2 Related Work

- Self-supervised Representation Learning on 2D image

- Self-supervised Representation Learning on Point Cloud

- Implicit Representations

生成模型,我的痛,还没有跑过一个实验,得抓紧学习 ,冲!