文章目录

Abstract

我们为移动和嵌入式视觉应用程序提供了一类称为MobileNets的高效模型。 MobileNets基于简化的体系结构,该体系结构使用深度可分离卷积来构建轻型深度神经网络。我们介绍了两个简单的全局超参数,它们可以有效地在延迟和准确性之间进行权衡。这些超参数允许模型构建者根据问题的约束条件为其应用选择合适尺寸的模型。与ImageNet分类中的其他流行模型相比,我们在资源和准确性的折衷方面进行了广泛的实验,并显示了出色的性能。然后,我们演示了MobileNet在各种应用程序和用例中的有效性,包括目标检测,细粒度分类,面部属性和大规模地理定位。

1. Introduction

自从AlexNet [19]通过赢得ImageNet挑战:ILSVRC 2012 [24],卷积神经网络就已经在计算机视觉中变得无处不在。为了获得更高的精度,通常的趋势是建立更深,更复杂的网络[27、31、29、8]。但是,这些提高准确性的进步并不一定使网络在大小和速度方面更加高效。在许多现实世界的应用中,例如机器人技术,无人驾驶汽车和增强现实,识别任务必须在计算受限的平台上及时进行。

本文介绍了一种有效的网络体系结构和一组两个超参数,以构建非常小,低延迟的模型,这些模型可以轻松满足移动和嵌入式视觉应用的设计要求。第2节回顾了构建小型模型的先前工作。第3节介绍了MobileNet体系结构以及两个用于定义更小,更有效的MobileNet的超参数 宽度乘数和分辨率。第4节介绍了ImageNet上的实验以及各种不同的应用程序和用例。第五节关于总结和结论。

2. Prior Work

在构建小型又高效的神经网络中出现了许多论文,例如: [16,34,12,36,22]。通常可以将许多不同的方法归类为压缩预训练网络或直接训练小型网络。本文提出了一种网络体系结构,它允许模型开发人员专门为其应用选择与资源限制(延迟,大小)相匹配的小型网络。MobileNets主要致力于优化时延,但也会产生小型网络。关于小型网络的许多论文只关注模型大小,却不考虑速度。

MobileNets主要是从[26]中最初引入并随后在Inception模型[13]中使用的深度可分离卷积构建的,以减少前几层的计算量。扁平化网络[16]构建了完全分解卷积的网络,并显示了分解网络的极大潜力。独立于本文,分解网络[34]引入了类似的分解卷积以及拓扑连接的使用。随后,Xception网络[3]演示了如何按比例放大深度可分离的滤波器以胜过Inception V3网络。另一个小型网络是Squeezenet [12],它使用瓶颈方法设计一个非常小的网络。精简的计算网络包括结构化转换网络[28]和深度油炸网络[37]。

获得小型网络的另一种方法是收缩,分解或压缩预训练的网络。基于乘积量化的压缩[36],哈希[2],修剪,矢量量化和霍夫曼编码[5]。另外,已经提出了各种因式分解来加快预训练网络的速度[14,20]。训练小型网络的另一种方法是蒸馏[9],该方法使用较大的网络来教授较小的网络。它是我们方法的补充,在第4节的某些用例中进行了介绍。另一种新兴方法是低比特位网络[4、22、11]。

3. MobileNet Architecture

在本节中,我们首先描述MobileNet构建的核心层,这些层是深度可分离的滤波器,然后描述MobileNet网络结构,并以两个模型压缩的超参数 宽度乘数和分辨率乘数的描述作为结束语。

3.1. Depthwise Separable Convolution

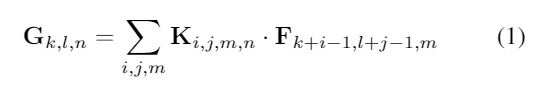

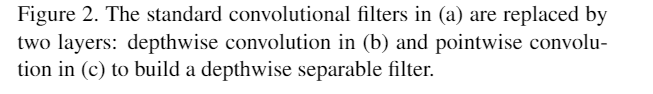

MobileNet模型基于深度可分离卷积,它是分解卷积的一种形式,它将标准卷积分解为深度卷积和一个1x1卷积称为点卷积。对于MobileNet,深度卷积将单个滤波器应用于每个输入通道。然后逐点卷积应用1×1卷积以组合深度卷积的输出。标准卷积分解和把输入组合为一组新的输出作为一步。深度可分离卷积将其分为两层,一个用于过滤的单独层和一个用于合并的单独层。这种分解具有显着减少计算量和模型大小的效果。图2显示了如何将标准卷积2(a)分解为深度卷积2(b)和1×1点卷积2(c)。

一个标准卷积输入是DF×DF×M,输出是 DK×DK×N,其中DF是输入特征矩阵的高度和宽度,M是输入维度,DK是输出特征矩阵的高度和宽度,N是输出维度。

卷积层参数计算为:DK×DK×M×N,其中DK是卷积核的大小,M是输入维度,N是输出维度。

标准卷积的输出特征矩阵假定步长为1,填充计算为:

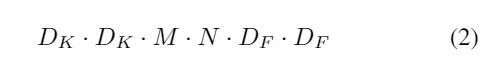

标准卷积的计算量为:

其中计算成本乘以输入通道数M,输出通道数N内核大小Dk×Dk和特征映射大小DF×DF。MobileNet模型解决了这些术语及其相互作用。首先,它使用深度可分解卷积来打破输出通道数与内核大小之间的相互作用。

标准卷积运算具有基于卷积核和组合特征的过滤特征的作用,以产生新的表示形式。通过使用分解卷积,可以将滤波和组合步骤分为两步叫做深度可分离卷积,大幅降低计算成本。

深度可分离卷积由两层组成:深度卷积和点卷积。我们使用深度卷积对每个输入通道(输入深度)应用单个滤波器。然后使用逐点卷积(1×1)卷积来组合深度卷积的输出。 MobileNets对两层同时使用了batchnorm和ReLU非线性激活函数。

深度卷积的计算成本为:DK·DK·M·DF·DF,其中DK是深度卷积核的大小,M是输出维度,DF是输出特征矩阵的大小

深度卷积相对于标准卷积非常有效。但是,它仅过滤输入通道,不将它们组合以创建新功能。为了生成这些新特征,需要一个额外的层来计算通过1×1卷积的深度卷积输出的线性组合。

深度卷积和1×1(点向)卷积的组合被称为深度可分离卷积,该卷积最初是在[26]中引入的。

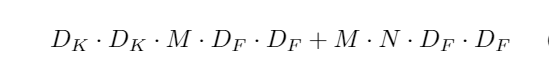

深度可分离卷积计算量:

这是深度卷积和1×1点卷积的总和。

这是深度卷积和1×1点卷积的总和。

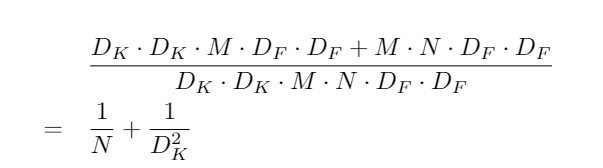

通过将卷积表示为过滤和组合的两步过程,我们减少了以下计算:

MobileNet使用3×3深度可分离卷积,其计算量比标准卷积少8到9倍,而第4节中可以看到仅有很小的精度降低。

在空间维度上进行额外的因式分解(例如在 [16,31])不会节省太多额外的计算,因为在深度卷积中花费了很少的计算。

3.2. Network Structure and Training

References

[1] M. Abadi, A. Agarwal, P. Barham, E. Brevdo, Z. Chen,C. Citro, G. S. Corrado, A. Davis, J. Dean, M. Devin, et al.Tensorflow: Large-scale machine learning on heterogeneoussystems, 2015.Software available from tensorflow. org, 1,2015. 4

[2] W. Chen, J. T. Wilson, S. Tyree, K. Q. Weinberger, andY. Chen. Compressing neural networks with the hashingtrick.CoRR, abs/1504.04788, 2015. 2

[3] F. Chollet. Xception: Deep learning with depthwise separable convolutions. arXiv preprint arXiv:1610.02357v2, 2016.1 (Xception)

[4] M. Courbariaux, J.-P. David, and Y. Bengio. Training deepneural networks with low precision multiplications.arXivpreprint arXiv:1412.7024, 2014. 2

[5] S. Han, H. Mao, and W. J. Dally. Deep compression: Com-pressing deep neural network with pruning, trained quantiza-tion and huffman coding.CoRR, abs/1510.00149, 2, 2015.2

[6] J. Hays and A. Efros. IM2GPS: estimating geographic in-formation from a single image. InProceedings of the IEEEInternational Conference on Computer Vision and PatternRecognition, 2008. 7

[7] J. Hays and A. Efros. Large-Scale Image Geolocalization.In J. Choi and G. Friedland, editors,Multimodal LocationEstimation of Videos and Images. Springer, 2014. 6, 7

[8] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learn-ing for image recognition.arXiv preprint arXiv:1512.03385,2015. 1 (residual _net)

[9] G. Hinton, O. Vinyals, and J. Dean. Distilling the knowledgein a neural network.arXiv preprint arXiv:1503.02531, 2015.2, 7

[10] J. Huang, V. Rathod, C. Sun, M. Zhu, A. Korattikara,A. Fathi, I. Fischer, Z. Wojna, Y. Song, S. Guadarrama, et al.Speed/accuracy trade-offs for modern convolutional objectdetectors.arXiv preprint arXiv:1611.10012, 2016. 7

[11] I. Hubara, M. Courbariaux, D. Soudry, R. El-Yaniv, andY. Bengio. Quantized neural networks: Training neural net-works with low precision weights and activations.arXivpreprint arXiv:1609.07061, 2016. 2

[12] F. N. Iandola, M. W. Moskewicz, K. Ashraf, S. Han, W. J.Dally, and K. Keutzer. Squeezenet: Alexnet-level accuracywith 50x fewer parameters and¡ 1mb model size.arXivpreprint arXiv:1602.07360, 2016. 1, 6 (Squeezenet)

[13] S. Ioffe and C. Szegedy. Batch normalization: Accelerating deep network training by reducing internal covariate shift.arXiv preprint arXiv:1502.03167, 2015. 1, 3, 7 (inceotion_v2)

[14] M. Jaderberg, A. Vedaldi, and A. Zisserman. Speeding up convolutional neural networks with low rank expansions. arXiv preprint arXiv:1405.3866, 2014. 2

[15] Y. Jia, E. Shelhamer, J. Donahue, S. Karayev, J. Long, R. Gir-shick, S. Guadarrama, and T. Darrell.Caffe: Convolu-tional architecture for fast feature embedding.arXiv preprintarXiv:1408.5093, 2014. 4

[16] J. Jin, A. Dundar, and E. Culurciello. Flattened convolutional neural networks for feedforward acceleration. arXiv preprint arXiv:1412.5474, 2014. 1, 3

[17] A. Khosla, N. Jayadevaprakash, B. Yao, and L. Fei-Fei.Novel dataset for fine-grained image categorization. InFirstWorkshop on Fine-Grained Visual Categorization, IEEEConference on Computer Vision and Pattern Recognition,Colorado Springs, CO, June 2011. 6

[18] J. Krause, B. Sapp, A. Howard, H. Zhou, A. Toshev,T. Duerig, J. Philbin, and L. Fei-Fei. The unreasonable ef-fectiveness of noisy data for fine-grained recognition.arXivpreprint arXiv:1511.06789, 2015. 6

[19] A. Krizhevsky, I. Sutskever, and G. E. Hinton. Imagenetclassification with deep convolutional neural networks. In Advances in neural information processing systems, pages1097–1105, 2012. 1, 6 (AlexNet)

[20] V. Lebedev, Y. Ganin, M. Rakhuba, I. Oseledets, andV. Lempitsky.Speeding-up convolutional neural net-works using fine-tuned cp-decomposition.arXiv preprintarXiv:1412.6553, 2014. 2

[21] W. Liu, D. Anguelov, D. Erhan, C. Szegedy, and S. Reed.Ssd:Single shot multibox detector.arXiv preprintarXiv:1512.02325, 2015. 7

[22] M. Rastegari, V. Ordonez, J. Redmon, and A. Farhadi. Xnor-net: Imagenet classification using binary convolutional neu-ral networks.arXiv preprint arXiv:1603.05279, 2016. 1, 2

[23] S. Ren, K. He, R. Girshick, and J. Sun. Faster r-cnn: Towardsreal-time object detection with region proposal networks. InAdvances in neural information processing systems, pages91–99, 2015. 7

[24] O. Russakovsky, J. Deng, H. Su, J. Krause, S. Satheesh,S. Ma, Z. Huang, A. Karpathy, A. Khosla, M. Bernstein,et al.Imagenet large scale visual recognition challenge.International Journal of Computer Vision, 115(3):211–252,2015. 1

[25] F. Schroff, D. Kalenichenko, and J. Philbin. Facenet: A uni-fied embedding for face recognition and clustering. InPro-ceedings of the IEEE Conference on Computer Vision andPattern Recognition, pages 815–823, 2015. 8

[26] L. Sifre.Rigid-motion scattering for image classification.PhD thesis, Ph. D. thesis, 2014. 1, 3 (深度可分离卷积最先提出)

[27] K. Simonyan and A. Zisserman. Very deep convolutionalnetworks for large-scale image recognition.arXiv preprintarXiv:1409.1556, 2014. 1, 6 (VGG)

[28] V. Sindhwani, T. Sainath, and S. Kumar. Structured transforms for small-footprint deep learning.InAdvances in Neural Information Processing Systems, pages 3088–3096,2015. 1

[29] C. Szegedy, S. Ioffe, and V. Vanhoucke.Inception-v4,inception-resnet and the impact of residual connections onlearning.arXiv preprint arXiv:1602.07261, 2016. 1 (inception_v4)

[30] C. Szegedy, W. Liu, Y. Jia, P. Sermanet, S. Reed,D. Anguelov, D. Erhan, V. Vanhoucke, and A. Rabinovich.Going deeper with convolutions. InProceedings of the IEEEConference on Computer Vision and Pattern Recognition,pages 1–9, 2015. 6

[31] C. Szegedy, V. Vanhoucke, S. Ioffe, J. Shlens, and Z. Wojna.Rethinking the inception architecture for computer vision.arXiv preprint arXiv:1512.00567, 2015. 1, 3, 4, 7 (inception)

[32] B. Thomee, D. A. Shamma, G. Friedland, B. Elizalde, K. Ni,D. Poland, D. Borth, and L.-J. Li. Yfcc100m: The newdata in multimedia research.Communications of the ACM,59(2):64–73, 2016. 7

[33] T. Tieleman and G. Hinton. Lecture 6.5-rmsprop: Dividethe gradient by a running average of its recent magnitude.COURSERA: Neural Networks for Machine Learning, 4(2),2012. 4

[34] M. Wang, B. Liu, and H. Foroosh. Factorized convolutionalneural networks. arXiv preprint arXiv:1608.04337, 2016. 1

[35] T. Weyand, I. Kostrikov, and J. Philbin. PlaNet - Photo Ge-olocation with Convolutional Neural Networks. InEuropeanConference on Computer Vision (ECCV), 2016. 6, 7

[36] J. Wu, C. Leng, Y. Wang, Q. Hu, and J. Cheng. Quantizedconvolutional neural networks for mobile devices. arXivpreprint arXiv:1512.06473, 2015. 1

[37] Z. Yang, M. Moczulski, M. Denil, N. de Freitas, A. Smola,L. Song, and Z. Wang. Deep fried convnets. In Proceedings of the IEEE International Conference on Computer Vision,pages 1476–1483, 2015. 1