交互式查询⼯具Impala

文章目录

主要内容

第 1 部分 Impala概述(Impala是什么,优势,劣势,与Hive对⽐)

第 2 部分 Impala的安装(制作本地Yum源⽅式安装)

第 3 部分 Impala的架构原理(有哪些组件,组件的作⽤,查询流程,查询计划)

第 4 部分 Impala的使⽤(使⽤与Hive类似,编写sql⽅式;Impala的DDL,查询语法,导⼊数据)

第 5 部分 Impala的Java 开发(Java+C++,使⽤JDBC⽅式查询Impala)

第 6 部分 Impala的优化(负载均衡,Impala中的Join的优化)

第 1 部分 Impala概述

1.1 Impala是什么

Impala是Cloudera提供的⼀款开源的针对HDFS和HBASE中的PB级别数据进⾏交互式实时查询(Impala速度快),Impala是参照⾕歌的新三篇论⽂当中的Dremel实现⽽来,其中旧三篇论⽂分别是(BigTable,GFS,MapReduce)分别对应我们即将学的HBase和已经学过的HDFS以及MapReduce。

Impala最⼤卖点和最⼤特点就是快速,Impala中⽂翻译是⾼⻆羚⽺。

1.2 Impala优势

回顾前⾯⼤数据课程路线其实就是⼀个⼤数据从业者⾯对的⼤数据相关技术发展的过程

- 技术发展以及更新换代的原因就是⽼的技术架构遇到新的问题,有些问题可以通过不断优化代码优化设计得以解决,有⼀些问题就不再是简简单单修改代码就能解决,需要从框架本身架构设计上改变,以⾄于需要推到重建。

- 在⼤数据领域主要解决的问题是数据的存储和分析,但是其实⼀个完整的⼤数据分析任务如果细分会有⾮常多具体的场景,⾮常多的环节;并没有⼀个类似Java Web的Spring框架实现⼤⼀统的局⾯。

⽐如我们按照阶段划分⼀个⼤数据开发任务,会有:数据采集(⽇志⽂件,关系型数据库中),数据清洗(数据格式整理,脏数据过滤等),数据预处理(为了后续分析所做的⼯作),数据分析:离线处理(T+1分析),实时处理(数据到来即分析),数据可视化,机器学习,深度学习等

⾯对如此众多的阶段再加上⼤数据天⽣的⼤数据量问题没有任何⼀个框架可以完美cover以上每个阶段。所以⼤数据领域有⾮常多框架,每个框架都有最适合⾃⼰的具体场景。⽐如:HDFS负责⼤数据量存储,MapReduce(Hive)负责⼤数据量的分析计算,

Impala的诞⽣

之前学习的Hive以及MR适合离线批处理,但是对交互式查询的场景⽆能为⼒(要求快速响应),所以为了解决查询速度的问题,Cloudera公司依据Google的Dremel开发了Impala,Impala抛弃了MapReduce使⽤了类似于传统的MPP数据库技术,⼤⼤提⾼了查询的速度。

MPP是什么?

MPP (Massively Parallel Processing),就是⼤规模并⾏处理,在MPP集群中,每个节点资源都是独⽴享有也就是有独⽴的磁盘和内存,每个节点通过⽹络互相连接,彼此协同计算,作为整体提供数据服务。

简单来说,MPP是将任务并⾏的分散到多个服务器和节点上,在每个节点上计算完成后,将各⾃部分的结果汇总在⼀起得到最终的结果

对于MPP架构的软件来说聚合操作⽐如计算某张表的总条数,则先进⾏局部聚合(每个节点并⾏计算),然后把局部汇总结果进⾏全局聚合(与Hadoop相似)。

Impala与Hive对⽐

Impala的技术优势

- Impala没有采取MapReduce作为计算引擎,MR是⾮常好的分布式并⾏计算框架,但MR引擎更多的是⾯向批处理,⽽非交互式的SQL执⾏。与 Hive相⽐:Impala把整个查询任务转为⼀棵执⾏计划树,⽽不是⼀连串的MR任务,在分发执⾏计划后,Impala使⽤拉取的⽅式获取上个阶段的执⾏结果,把结果数据、按执⾏树流式传递汇集,减少了写磁盘,再读磁盘的开销。Impala使⽤服务的⽅式避免 每次执⾏查询都需要启动的开销,即相⽐Hive没了MR启动时间。

- 使⽤LLVM(C++编写的编译器)产⽣运⾏代码,针对特定查询⽣成特定代码。

- 优秀的IO调度,Impala⽀持直接数据块读取和本地代码计算。

- 选择适合的数据存储格式可以得到最好的性能(Impala⽀持多种存储格式)。

- 尽可能使⽤内存,中间结果不写磁盘,及时通过⽹络以stream的⽅式传递。

Impala与Hive对⽐分析

查询过程

- Hive:在Hive中,每个查询都有⼀个“冷启动”的常⻅问题。(mr 每次都要启动关闭,申请资源,释放资源)

- Impala:Impala避免了任何可能的启动开销,这是⼀种本地查询语⾔。 因为要始终处理查询,则Impala守护程序进程总是在集群启动之后就准备就绪。守护进程在集群启动之后可以接收查询任务并执⾏查询任务。

中间结果 - Hive:Hive通过MR引擎实现所有中间结果,中间结果需要落盘,这对降低数据处理速度有不利影响。

- Impala:在执⾏程序之间使⽤流的⽅式传输中间结果,避免数据落盘。尽可能使⽤内存避免磁盘开销

交互查询 - Hive:对于交互式计算,Hive不是理想的选择。

- Impala:对于交互式计算,Impala⾮常适合。(数据量级PB级)

计算引擎

- Hive:是基于批处理的Hadoop MapReduce

- Impala:更像是MPP数据库

容错 - Hive:Hive是容错的(通过MR&Yarn实现)

- Impala:Impala没有容错,由于良好的查询性能,Impala遇到错误会重新执⾏⼀次查询

查询速度 - Impala:Impala⽐Hive快3-90倍。

Impala优势总结

- Impala最⼤优点就是查询速度快,在⼀定数据量下;

- 速度快的原因:避免了MR引擎的弊端,采⽤了MPP数据库技术,

1.3 Impala的缺点

- Impala属于MPP架构,只能做到百节点级,⼀般并发查询个数达到20左右时,整个系统的吞吐已经达到满负荷状态,在扩容节点也提升不了吞吐量,处理数据量在PB级别最佳。

- 资源不能通过YARN统⼀资源管理调度,所以Hadoop集群⽆法实现Impala、Spark、Hive等组件的动态资源共享。

1.4 适⽤场景

Hive: 复杂的批处理查询任务,数据转换任务,对实时性要求不⾼同时数据量⼜很⼤的场景。

Impala:实时数据分析,与Hive配合使⽤,对Hive的结果数据集进⾏实时分析。impala不能完全取代hive,impala可以直接处理hive表中的数据。

第 2 部分 Impala 安装与⼊⻔案例

2.1 集群准备

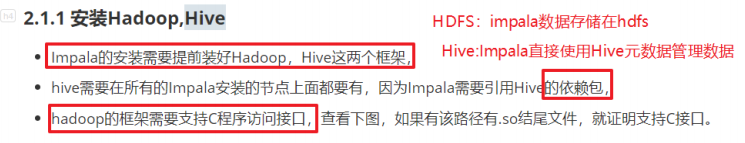

2.1.1 安装Hadoop,Hive

- Impala的安装需要提前装好Hadoop,Hive这两个框架,

- hive需要在所有的Impala安装的节点上⾯都要有,因为Impala需要引⽤Hive的依赖包,

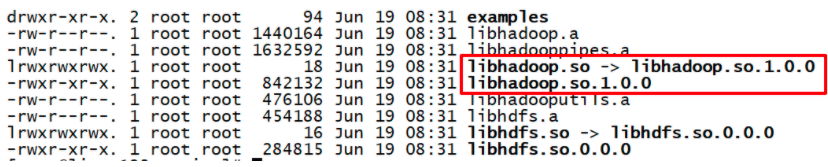

- hadoop的框架需要⽀持C程序访问接⼝,查看下图,如果有该路径有.so结尾⽂件,就证明⽀持C接⼝。

2.1.2 准备Impala的所有依赖包

本地Yum源⽅式

具体制作步骤

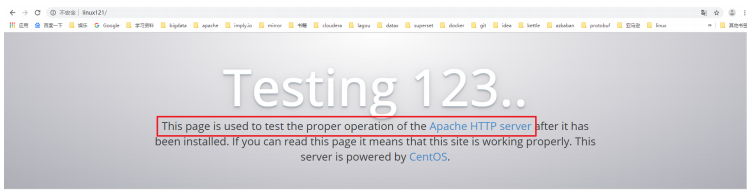

Yum源是Centos当中下载软件rpm包的地址,因此通过制作本地Yum源并指定Yum命令使⽤本地Yum源,为了使Yum命令(本机,跨⽹络节点)可以通过⽹络访问到本地源,我们使⽤Httpd这种静态资源服务器来开放我们下载所有的rpm包。

- Linux121安装Httpd服务器

#yum⽅式安装httpd服务器

yum install httpd -y

#启动httpd服务器

systemctl start httpd

#验证httpd⼯作是否正常,默认端⼝是80,可以省略

http://linux121

2. 新建⼀个测试⻚⾯

httpd默认存放⻚⾯路径下,新建⼀个⻚⾯test.html

cd /var/www/html/

vim test.html

#编辑如下内容,保存(wq)

<html>

<div style="font-size:100px">

this is a new page!!

</div>

</html>

访问

http://linux121/test.html

注:后续可以把下载的rpm包解压放置到此处便可以供⼤家访问。

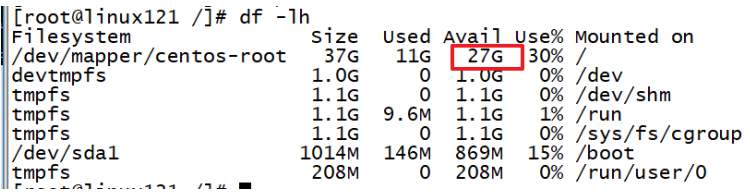

3. 下载Impala安装所需rpm包

Impala所需安装包需要到Cloudera提供地址下载

http://archive.cloudera.com/cdh5/repo-as-tarball/5.7.6/cdh5.7.6-

centos7.tar.gz

注意:该tar.gz包是包含了Cloudera所提供的⼏乎所有rpm包,但是为了⽅便我们不再去梳理其中依赖关系,全部下载来,整个⽂件⽐较⼤,有3.8G。选择⼀个磁盘空间够的节点,后续还要把压缩包解压所以磁盘空间要剩余10G以上。该包在资料中提供给⼤家。

移动该安装包到/opt/lagou/software

解压缩

tar -zxvf cdh5.7.6-centos7.tar.gz

- 使⽤Httpd盛放依赖包

创建软链接到/var/www/html下

cd /var/www/html

ln -s /opt/lagou/software/cdh/5.7.6 /var/www/html/cdh57

验证

http://linux121/cdh57

如果提示403 forbidden

vim /etc/selinux/config

将SELINUX=enforcing改为SELINUX=disabled

5. 修改Yum源配置⽂件

cd /etc/yum.repos.d

#创建⼀个新的配置⽂件

vim local.repo

#添加如下内容

[local]

name=local

baseurl=http://linux121/cdh57/

gpgcheck=0

enabled=1

name: 对于当前源的描述 baseurl: 访问当前源的地址信息 gpgcheck: 1 0,gpg校验 enabled:

1/0,是否使⽤当前源

- 分发local.repo⽂件到其它节点

rsync-script local.repo

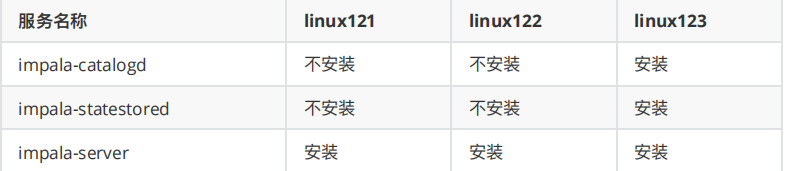

2.2 安装Impala

2.2.1 集群规划

Impala⻆⾊

impala-server:这个进程是Impala真正⼯作的进程,官⽅建议把impala-server安装在datanode节点,更靠近数据(短路读取),进程名impalad

impala-statestored:健康监控⻆⾊,主要监控impala-server,impala-server出现异常时告知给其它impala-server;进程名叫做statestored

impala-catalogd :管理和维护元数据(Hive),impala更新操作;把impala-server更新的元数据通知给其它impala-server,进程名catalogd

官⽅建议statestore与catalog安装在同⼀节点上!!

2.2.2 具体安装步骤

Linux123

yum install impala -y

yum install impala-server -y

yum install impala-state-store -y

yum install impala-catalog -y

yum install impala-shell -y

Linux121与Linux122

yum install impala-server -y

yum install impala-shell -y

配置Impala

- 修改hive-site.xml

<!--指定metastore地址,之前添加过可以不⽤添加 -->

<property>

<name>hive.metastore.uris</name>

<value>thrift://linux121:9083,thrift://linux123:9083</value>

</property>

<property>

<name>hive.metastore.client.socket.timeout</name>

<value>3600</value>

</property>

-

分发Hive安装包到集群节点

rsync -r /opt/lagou/servers/hive-2.3.7/ linux122:/opt/lagou/servers/

rsync -r /opt/lagou/servers/hive-2.3.7/ linux121:/opt/lagou/servers/ -

Linux123启动metastore服务

nohup hive --service metastore &

启动hiveserver2服务

nohup hive --service hiveserver2 &

- 修改HDFS集群hdfs-site.xml

配置HDFS集群的短路读取

什么是短路读取?

在HDFS中通过DataNode来读取数据。但是,当客户端向DataNode请求读取⽂件时,DataNode就会从磁盘读取该⽂件并通过TCP socket将数据发送到客户端。所谓“短路”是指Client客户端直接读取⽂件。很明显,这种情况只在客户端与数据放在同⼀地点(译者注:同⼀主机)时才有可能发⽣。短路读对于许多应⽤程序会带来重⼤的性能提升。

短路读取:就是Client与DataNode属于同⼀节点,⽆需再经过⽹络传输数据,直接本地读取。

要配置短路本地读,需要验证本机Hadoop是否有libhadoop.so;

进⼊以下⽬录:

cd /opt/lagou/servers/hadoop-2.9.2/lib/native/

短路读取配置步骤

a.创建短路读取本地中转站

#所有节点创建以下⽬录

mkdir -p /var/lib/hadoop-hdfs

b. 修改hdfs-site.xml

<!--添加如下内容 -->

<!--打开短路读取开关 -->

<!-- 打开短路读取配置-->

<property>

<name>dfs.client.read.shortcircuit</name>

<value>true</value>

</property>

<!--这是⼀个UNIX域套接字的路径,将⽤于DataNode和本地HDFS客户机之间的通信 -->

<property>

<name>dfs.domain.socket.path</name>

<value>/var/lib/hadoop-hdfs/dn_socket</value>

</property>

<!--block存储元数据信息开发开关 -->

<property>

<name>dfs.datanode.hdfs-blocks-metadata.enabled</name>

<value>true</value>

</property>

<property>

<name>dfs.client.file-block-storage-locations.timeout</name>

<value>30000</value>

</property>

注:分发到集群其它节点。重启Hadoop集群。

#停⽌集群

stop-dfs.sh

stop-yarn.sh

#启动集群

start-dfs.sh

start-yarn.sh

- Impala具体配置

引⽤HDFS,Hive配置

使⽤Yum⽅式安装impala默认的Impala配置⽂件⽬录为 /etc/impala/conf,Impala的使⽤要依赖Hadoop,Hive框架,所以需要把Hdfs,Hive的配置⽂件告知Impala。

执⾏以下命令把Hdfs,Hive的配置⽂件软链接到/etc/impala/conf下

ln -s /opt/lagou/servers/hadoop-2.9.2/etc/hadoop/core-site.xml /etc/impala/conf/core-site.xml

ln -s /opt/lagou/servers/hadoop-2.9.2/etc/hadoop/hdfs-site.xml /etc/impala/conf/hdfs-site.xml

ln -s /opt/lagou/servers/hive-2.3.7/conf/hive-site.xml /etc/impala/conf/hive-site.xml

注:所有节点都要执⾏此命令!

Impala⾃身配置

所有节点更改Impala默认配置⽂件以及添加mysql的驱动包

vim /etc/default/impala

<!--更新如下内容 -->

IMPALA_CATALOG_SERVICE_HOST=linux123

IMPALA_STATE_STORE_HOST=linux123

所有节点创建mysql的驱动包的软链接

#创建节点

mkdir -p /usr/share/java

ln -s /opt/lagou/servers/hive-2.3.7/lib/mysql-connector-java-5.1.46.jar /usr/share/java/mysql-connector-java.jar

修改bigtop的java_home路径

vim /etc/default/bigtop-utils

export JAVA_HOME=/opt/lagou/servers/jdk1.8.0_231

注意:Apache Bigtop 是⼀个针对基础设施⼯程师和数据科学家的开源项⽬,旨在全⾯打包、测试和配置领先的开源⼤数据组件/项⽬。Impala项⽬中使⽤到了此软件。

启动Impala

#linux123启动如下角色

service impala-state-store start

service impala-catalog start

service impala-server start

#其余节点启动如下角色

service impala-server start

验证Impala启动结果

ps -ef | grep impala

浏览器Web界⾯验证

访问impalad的管理界⾯

http://linux123:25000/

访问statestored的管理界⾯

http://linux123:25010/

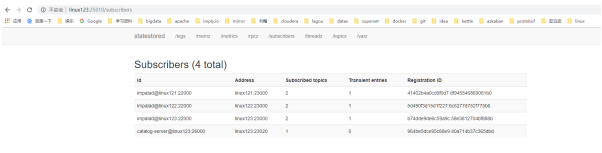

Statestore管理界⾯

注意:启动之后所有关于Impala的⽇志默认都在/var/log/impala 这个路径下,Linux123机器上⾯应该有三个进程,Linux121与Linux122机器上⾯只有⼀个进程,如果进程个数不对,去对应⽬录下查看报错⽇志.

消除Impala影响

由于使⽤Yum命令安装Impala,我们选择使⽤yum⾃动进⾏Impala依赖的安装和处理,所以本次安装默认会把Impala依赖的所有框架都会安装,⽐如Hadoop,Hive,Mysql等,为了保证我们⾃⼰安装的Hadoop等使⽤正常我们需要删除掉Impala默认安装的其它框架

[root@linux122 conf]# which hadoop

/usr/bin/hadoop

[root@linux122 conf]# which hive

/usr/bin/hive

#使⽤用which命令 查找hadoop,hive等会发现,命令文件是/usr/bin/hadoop 而非我们自己安装的路径,需要把这些删除掉,所有节点都要执行

rm -rf /usr/bin/hadoop

rm -rf /usr/bin/hdfs

rm -rf /usr/bin/hive

rm -rf /usr/bin/beeline

rm -rf /usr/bin/hiveserver2

#重新生效环境变量

source /etc/profile

jps 时出现没有名字的进程 或者process information unavailable

解决⽅式

rm -rf /tmp/hsperfdata_*

2.3 Impala⼊⻔案例

使⽤Yum⽅式安装Impala后,impala-shell可以全局使⽤;进⼊impala-shell命令⾏

impala-shell进⼊到impala的交互窗⼝

[root@linux123 conf]# impala-shell

Connected to linux123:21000

Server version: impalad version 2.3.0-cdh5.5.0 RELEASE (build

0c891d79aa38f297d244855a32f1e17280e2129b)

***********************************************************************************

Welcome to the Impala shell. Copyright (c) 2015 Cloudera, Inc. All rights

reserved.

(Impala Shell v2.3.0-cdh5.5.0 (0c891d7) built on Mon Nov 9 12:18:12 PST 2015)

The SET command shows the current value of all shell and query options.

***********************************************************************************

[linux123:21000] >

查看所有数据库

show databases;

Fetched 0 row(s) in 4.74s

[linux123:21000] > show databases;

Query: show databases

+------------------+

| name |

+------------------+

| _impala_builtins |

| default |

| |

+------------------+

如果想要使⽤Impala ,需要将数据加载到Impala中,如何加载数据到Impala中呢?

- 使⽤Impala的外部表,这种适⽤于已经有数据⽂件,只需将数据⽂件拷⻉到HDFS上,创建⼀张Impala外部表,将外部表的存储位置指向数据⽂件的位置即可。(类似Hive)

- 通过Insert⽅式插⼊数据,适⽤于我们没有数据⽂件的场景。

- 准备数据⽂件

user.csv

cd /data

vim user.csv

392456197008193000,张三,20,0

267456198006210000,李李四,25,1

892456199007203000,王五,24,1

492456198712198000,赵六,26,2

392456197008193000,张三,20,0

392456197008193000,张三,20,0

- 创建HDFS 存放数据的路径

hadoop fs -mkdir -p /user/impala/t1

#上传本地user.csv到hdfs /user/impala/t1

hadoop fs -put user.csv /user/impala/t1

- 创建表

-- 进⼊入impala-shell

impala-shell

use default;

-- 表如果存在则删除

drop table if exists t1;

-- 执行创建

create external table t1(

id string,

name string,

age int,gender int)

row format delimited fields terminated by ','

location '/user/impala/t1';

- 查询数据

[linux122:21000] > select * from t1;

Query: select * from t1

+--------------------+------+-----+--------+

| id | name | age | gender |

+--------------------+------+-----+--------+

| 392456197008193000 | 张三 | 20 | 0 |

| 267456198006210000 | 李四 | 25 | 1 |

| 892456199007203000 | 王五 | 24 | 1 |

| 492456198712198000 | 赵六 | 26 | 2 |

| 392456197008193000 | 张三 | 20 | 0 |

| 392456197008193000 | 张三 | 20 | 0 |

+--------------------+------+-----+--------+

- 创建t2表

-- 创建⼀一个内部表

create table t2(

id string,

name string,

age int,

gender int)

row format delimited fields terminated by ',';

-- 查看表结构

desc t1;

desc formatted t2;

- 插⼊数据到t2

insert overwrite table t2 select * from t1 where gender =0;

-- 验证数据

select * from t2;

[linux122:21000] > select * from t2;

Query: select * from t2

+--------------------+------+-----+--------+

| id | name | age | gender |

+--------------------+------+-----+--------+

| 392456197008193000 | 张三 | 20 | 0 |

| 392456197008193000 | 张三 | 20 | 0 |

| 392456197008193000 | 张三 | 20 | 0 |

+--------------------+------+-----+--------+

更新元数据

使⽤Beeline连接Hive查看Hive中的数据,发现通过Impala创建的表,导⼊的数据都可以被Hive感知到。

0: jdbc:hive2://linux123:10000> show tables;

+-----------+

| tab_name |

+-----------+

| t1 |

| t2 |

+-----------+

select * from t1;

0: jdbc:hive2://linux123:10000> select * from t1;

+---------------------+----------+---------+------------+

| t1.id | t1.name | t1.age | t1.gender |

+---------------------+----------+---------+------------+

| 392456197008193000 | 张三 | 20 | 0 |

| 267456198006210000 | 李四 | 25 | 1 |

| 892456199007203000 | 王五 | 24 | 1 |

| 492456198712198000 | 赵六 | 26 | 2 |

| 392456197008193000 | 张三 | 20 | 0 |

| 392456197008193000 | 张三 | 20 | 0 |

+---------------------+----------+---------+------------+

⼩结:

- 上⾯案例中Impala的数据⽂件我们准备的是以逗号分隔的⽂本⽂件,实际上,Impala可以⽀持RCFile,SequenceFile,Parquet等多种⽂件格式。

- Impala与Hive元数据的关系?

- Hive对于元数据的更新操作不能被Impala感知到;

- Impala对元数据的更新操作可以被Hive感知到。

- Impala同步Hive元数据命令:

⼿动执⾏invalidate metadata ,(后续详细讲解) - Impala是通过Hive的metastore服务来访问和操作Hive的元数据,但是Hive对表进⾏创建删除修改等操作,Impala是⽆法⾃动识别到Hive中元数据的变更情况的,如果想让Impala识别到Hive元数据的变化,所以需要进⼊impala-shell之后⾸先要做的操作就是执⾏invalidate metadata,该命令会将所有的Impala的元数据失效并重新从元数据库同步元数据信息。后⾯详细讲解元数据更新命令。

- Impala操作HDFS使⽤的是Impala⽤户,所以为了避免权限问题,我们可以选择关闭权限校验

在hdfs-site.xml中添加如下配置:

<!--关闭hdfs权限校验 -->

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

第 3 部分 Imapla的架构原理

第 1 节 Impala的组件

Impala是⼀个分布式,⼤规模并⾏处理(MPP)数据库引擎,它包括多个进程。Impala与Hive类似不是数据库⽽是数据分析⼯具;

#在linux123执⾏行行ps -ef | grep impala

#结果

impala 29212 1 0 Jul02 ? 00:01:06

/usr/lib/impala/sbin/statestored -log_dir=/var/log/impala -

state_store_port=24000

impala 29249 1 0 Jul02 ? 00:00:49

/usr/lib/impala/sbin/catalogd -log_dir=/var/log/impala

impala 29341 1 0 Jul02 ? 00:00:49 /usr/lib/impala/sbin/impalad

-log_dir=/var/log/impala -catalog_service_host=linux123 -

state_store_port=24000 -use_statestore -state_store_host=linux123 -

be_port=22000

第 2 节 Impala的查询

查询计划示例

以⼀个SQL例⼦来展示查询计划

SQL语句

select

t1.n1,

t2.n2,

count(1) as c

from t1 join t2 on t1.id = t2.id

join t3 on t1.id = t3.id

where t3.n3 between ‘a’ and ‘f’

group by t1.n1, t2.n2

order by c desc

limit 100;

QueryPlanner⽣成单机的执⾏计划

分析上⾯的单机执⾏计划,

第⼀步先去扫描t1表中需要的数据,如果数据⽂件存储是列式存储我们可以便利的扫描到所需的列id,n1;

接着需要与t2表进⾏Join操作,扫描t2表与t1表类似获取到所需数据列id,n2;

t1与t2表进⾏关联,关联之后再与t3表进⾏关联,这⾥Impala会使⽤谓词下推扫描t3表只取join所需数据;

对group by进⾏相应的aggregation操作,最终是排序取出指定数量的数据返回。

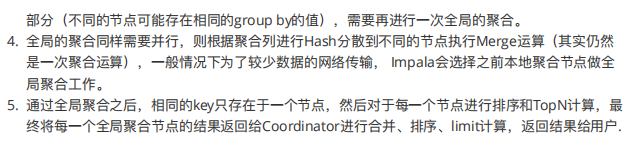

分布式并⾏执⾏计划

所谓的分布式并⾏化执⾏计划就是在单机执⾏计划基础之上结合数据分布式存储的特点,按照任务的计算要求把单机执⾏计划拆分为多段⼦任务,每个⼦任务都是可以并⾏执⾏的。上⾯的单机执⾏计划转为分布式并⾏执⾏计划如下图所示:

分布式并⾏执⾏计划流程图

第 4 部分 Impala的使⽤

第 1 节 Impala-shell命令参数

1.1 impala-shell外部命令

所谓的外部命令指的是不需要进⼊到impala-shell交互命令⾏当中即可执⾏的命令参数。impala-shell后⾯执⾏的时候可以带很多参数。你可以在启动 impala-shell 时设置,⽤于修改命令执⾏环境。

impala-shell –h可以帮助我们查看帮助⼿册。也可以参考课程附件资料。

⽐如⼏个常⻅的:

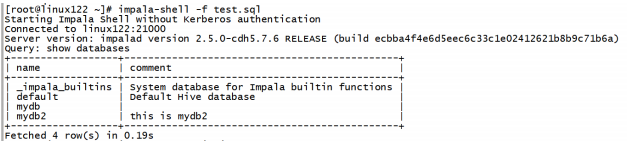

impala-shell –r刷新impala元数据,与建⽴连接后执行REFRESH 语句效果相同(元数据发⽣变化的时候)

impala-shell –f ⽂件路径 执⾏指的的sql查询⽂件。

impala-shell –i指定连接运⾏ impalad 守护进程的主机。默认端⼝是 21000。你可以连接到集群中运⾏impalad 的任意主机。

impala-shell –o保存执⾏结果到⽂件当中去。

展示Impala默认⽀持的内置函数需要进⼊Impala默认系统数据库中执⾏

show functions;

在其它数据库下⽆法查看!!

1.2 impala-shell内部命令

所谓内部命令是指,进⼊ impala-shell 命令⾏之后可以执⾏的语法。

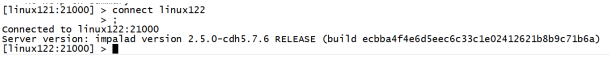

connect hostname 连接到指定的机器impalad上去执⾏。

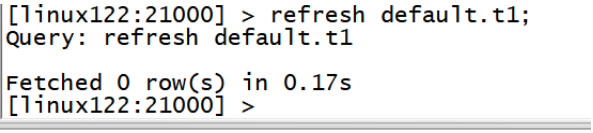

refresh dbname.tablename增量刷新,刷新某⼀张表的元数据,主要⽤于刷新hive当中数据表⾥⾯的数据改变的情况。

invalidate metadata全量刷新,性能消耗较⼤,主要⽤于hive当中新建数据库或者数据库表的时候来进⾏刷新。

quit/exit命令 从Impala shell中退出

explain 命令 ⽤于查看sql语句的执⾏计划。

explain的值可以设置成0,1,2,3等⼏个值,其中3级别是最⾼的,可以打印出最全的信息

set explain_level=3;

profile命令执⾏sql语句之后执⾏,可以

打印出更加详细的执⾏步骤,主要⽤于查询结果的查看,集群的调优等。

expalin:可以不真正执⾏任务,只是展示任务的执⾏计划;

profile:需要任务执⾏完成后调⽤,可以从更底层以及更详细的层⾯来观察我们运⾏impala的任务,进⾏调优。

第 2 节 Impala sql语法

2.1 数据库特定语句

1. 创建数据库

CREATE DATABASE语句⽤于在Impala中创建新数据库。

CREATE DATABASE IF NOT EXISTS database_name;

这⾥,IF NOT EXISTS是⼀个可选的⼦句。如果我们使⽤此⼦句,则只有在没有具有相同名称的现有数据库时,才会创建具有给定名称的数据库。

默认就会在hive的数仓路径下创建新的数据库名⽂件夹

/user/hive/warehouse/lagoutest.db

2. 删除数据库

Impala的DROP DATABASE语句⽤于从Impala中删除数据库。 在删除数据库之前,建议从中删除所有表。

如果使⽤级联删除,Impala会在删除指定数据库中的表之前删除它。

drop database sample cascade;

2.2 表特定语句

- create table语句

CREATE TABLE语句⽤于在Impala中的所需数据库中创建新表。 需要指定表名字并定义其列和每列的数据类型。

impala⽀持的数据类型和hive类似.

create table IF NOT EXISTS database_name.table_name (

column1 data_type,

column2 data_type,

column3 data_type,

………

columnN data_type

);

CREATE TABLE IF NOT EXISTS mydb.student(

name STRING,

age INT,

contact INT

);

默认建表的数据存储路径跟hive⼀致。也可以在建表的时候通过location指定具体路径。

- insert 语句

Impala的INSERT语句有两个⼦句: into和overwrite。into⽤于插⼊新记录数据,overwrite⽤于覆盖已有的记录。

insert into table_name (column1, column2, column3,...columnN)

values (value1,value2, value3,...valueN);

Insert into table_name values (value1, value2, value2);

这⾥,column1,column2,… columnN是要插⼊数据的表中的列的名称。还可以添加值⽽不指定列名,但是,需要确保值的顺序与表中的列的顺序相同。

例⼦

create table employee (

Id INT,

name STRING,

age INT,

address STRING,

salary BIGINT

);

insert into employee VALUES (1, 'Ramesh', 32, 'Ahmedabad', 20000 );

insert into employee values (2, 'Khilan', 25, 'Delhi', 15000 );

Insert into employee values (3, 'kaushik', 23, 'Kota', 30000 );

Insert into employee values (4, 'Chaitali', 25, 'Mumbai', 35000 );

Insert into employee values (5, 'Hardik', 27, 'Bhopal', 40000 );

Insert into employee values (6, 'Komal', 22, 'MP', 32000 );

overwrite覆盖⼦句覆盖表当中全部记录。 覆盖的记录将从表中永久删除。

Insert overwrite employee values (1, 'Ram', 26, 'Vishakhapatnam', 37000 );

- select语句

Impala SELECT语句⽤于从数据库查询数据, 此查询以表的形式返回数据。

4. describe 语句

Impala中的describe语句⽤于提供表的描述。 此语句的结果包含有关表的信息,例如列名称及其数据类型。

describe table_name;

describe formatted table_name;

- alter table

Impala中的Alter table语句⽤于对给定表执⾏更改。使⽤此语句,我们可以添加,删除或修改现有表中的列,也可以重命名它们.

参考Hive实现。

- delete、truncate table

Impala drop table语句⽤于删除Impala中的现有表。此语句还会删除内部表的底层HDFS⽂件。

注意:使⽤此命令时必须⼩⼼,因为删除表后,表中可⽤的所有信息也将永远丢失。

drop table database_name.table_name;

Impala的Truncate Table语句⽤于从现有表中删除所有记录。保留表结构。

您也可以使⽤DROP TABLE命令删除⼀个完整的表,但它会从数据库中删除完整的表结构,如果您希望存储⼀些数据,您将需要重新创建此表。

truncate table_name;

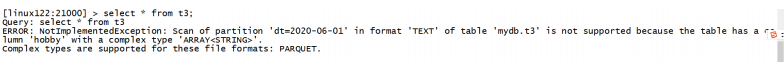

Impala对复杂数据类型的⽀持

对于Text存储格式中的复杂类型不⽀持,复杂类型要使⽤parquet格式。

- view视图

视图仅仅是存储在数据库中具有关联名称的Impala查询语⾔的语句。 它是以预定义的SQL查询形式的表的组合。

视图可以包含表的所有⾏或选定的⾏。

create view if not exists view_name

as select statement

创建视图view、查询视图view

create view if not exists employee_view

AS select name, age from employee;

修改视图

alter view database_name.view_name

as Select语句

删除视图

drop view database_name.view_name;

- order by⼦句

Impala ORDER BY⼦句⽤于根据⼀个或多个列以升序或降序对数据进⾏排序。 默认情况下,⼀些数据库按升序对查询结果进⾏排序。

select * from table_name ORDER BY col_name

[ASC|DESC] [NULLS FIRST|NULLS LAST]

可以使⽤关键字ASC或DESC分别按升序或降序排列表中的数据。

如果我们使⽤NULLS FIRST,表中的所有空值都排列在顶⾏; 如果我们使⽤NULLS LAST,包含空值的⾏将最后排列。

- group by⼦句

Impala GROUP BY⼦句与SELECT语句协作使⽤,以将相同的数据排列到组中。

select name, sum(salary)

from employee

group by name;

- having⼦句

having容易与where过滤进⾏混淆,

如何区分:

where:过滤的数据是原始数据,表中本来就存在的数据;

having:过滤的是查询结果数据;

按年龄对表进⾏分组,并选择每个组的最⼤⼯资,并显示⼤于20000的⼯资

select max(salary)

from employee

group by age

having max(salary) > 20000;

- limit、offset

Impala中的limit⼦句⽤于将结果集的⾏数限制为所需的数,即查询的结果集不包含超过指定限制的记录。

⼀般来说,select查询的resultset中的⾏从0开始。使⽤offset⼦句,我们可以决定从哪⾥开始进行limit。

select * from employee

order by salary

limit 2 offset 2;

使⽤offset关键字要求结果数据必须是排序之后的!!

第 3 节 Impala导⼊数据

- insert into values

这种⽅式⾮常类似于RDBMS的数据插⼊⽅式。

create table t_test2(id int,name string);

insert into table t_test2 values(1,”zhangsan”);

- insert into select

插⼊⼀张表的数据来⾃于后⾯的select查询语句返回的结果。 - create table as select

建表的字段个数、类型、数据来⾃于后续的select查询语句。

load data⽅式,这种⽅式不建议在Impala中使⽤,先使⽤load data⽅式把数据加载到Hive表中,然后使⽤以上⽅式插⼊Impala表中。

第 5 部分 Impala的JDBC⽅式查询

在实际⼯作当中,因为impala的查询⽐较快,所以可能有会使⽤到impala来做数据库查询的情况,我们可以通过java代码来进⾏操作impala的查询

- 导⼊jar包pom.xml

<dependencies>

<!-- https://mvnrepository.com/artifact/org.apache.hadoop/hadoop-common -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.9.2</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.hive/hive-common -->

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-common</artifactId>

<version>2.3.7</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.hive/hive-metastore-->

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-metastore</artifactId>

<version>2.3.7</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.hive/hive-service -->

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-service</artifactId>

<version>2.3.7</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.hive/hive-jdbc -->

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-jdbc</artifactId>

<version>2.3.7</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.hive/hive-exec -->

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-exec</artifactId>

<version>2.3.7</version>

</dependency>

</dependencies>

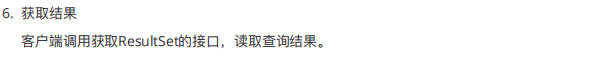

- java代码开发

ImpalaTest.java

package com.lagou.impala.jdbc;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.ResultSet;

public class ImpalaTest {

public static void main(String[] args) throws Exception {

//定义连接impala的驱动和连接url

String driver = "org.apache.hive.jdbc.HiveDriver";

String driverUrl = "jdbc:hive2://linux123:21050/default;auth=noSasl";

//查询的sql语句

String querySql = "select * from t1";

//获取连接

Class.forName(driver);

//通过Drivermanager获取连接

final Connection connection = DriverManager.getConnection(driverUrl);

final PreparedStatement ps = connection.prepareStatement(querySql);

//执行查询

final ResultSet resultSet = ps.executeQuery();

//解析返回结果

//获取到每条数据的列数

final int columnCount = resultSet.getMetaData().getColumnCount();

//遍历结果集

while (resultSet.next()) {

for (int i = 1; i <= columnCount; i++) {

final String string = resultSet.getString(i);

System.out.print(string + "\t");

}

System.out.println();

}

//关闭资源

ps.close();

connection.close();

}

}

第 6 部分 Impala进阶

第 1 节 Impala的负载均衡

mpala主要有三个组件,分别是statestore,catalog和impalad,对于Impalad节点,每⼀个节点都可以接收客户端的查询请求,并且对于连接到该Impalad的查询还要作为Coordinator节点(需要消耗⼀定的内存和CPU)存在,为了保证每⼀个节点的资源开销的平衡需要对于集群中的Impalad节点做⼀下负载均衡.

- Cloudera官⽅推荐的代理⽅案:HAProxy

- DNS做负载均衡

DNS做负载均衡⽅案是最简单的,但是性能⼀般,所以这⾥我们按照官⽅的建议使⽤HAProxy实现负载均衡

⽣产中应该选择⼀个⾮Impalad节点作为HAProxy的安装节点

1.1 HAProxy⽅案

安装haproxy(最好在没有Impalad 节点上,这里节点都有Impalad,选择放在Linux123上)

yum install haproxy -y

配置⽂件

vim /etc/haproxy/haproxy.cfg

具体配置内容

#---------------------------------------------------------------------

# Example configuration for a possible web application. See the

# full configuration options online.

#

# http://haproxy.1wt.eu/download/1.4/doc/configuration.txt

#

#---------------------------------------------------------------------

#---------------------------------------------------------------------

# Global settings

#---------------------------------------------------------------------

global

log 127.0.0.1 local2

chroot /var/lib/haproxy

pidfile /var/run/haproxy.pid

maxconn 4000

user haproxy

group haproxy

daemon

# turn on stats unix socket

stats socket /var/lib/haproxy/stats

#---------------------------------------------------------------------

# common defaults that all the 'listen' and 'backend' sections will

# use if not designated in their block

#---------------------------------------------------------------------

defaults

mode http#mode { tcp|http|health },tcp 表示4层,http表示7层,health仅作为健康检查使⽤用

log global

option httplog

option dontlognull

#option http-server-close

#option forwardfor except 127.0.0.0/8

#option abortonclose##连接数过大自动关闭

option redispatch #如果失效则强制转换其他服务器

retries 3 #尝试3次失败则从集群摘除

timeout http-request 10s

timeout queue 1m

#timeout connect 10s

#timeout client 1m

#timeout server 1m

timeout connect 1d#连接超时间,重要,hive查询数据能返回结果的保证

timeout client 1d#同上

timeout server 1d#同上

timeout http-keep-alive 10s

timeout check 10s#健康检查时间

maxconn 3000#最大连接数

listen status #定义管理理界⾯面

bind 0.0.0.0:1080 #管理理界⾯面访问IP和端⼝口

mode http #管理理界⾯面所使⽤用的协议

option httplog

maxconn 5000 #最⼤大连接数

stats refresh 30s #30秒⾃自动刷新

stats uri /stats

listen impalashell

bind 0.0.0.0:25003 #ha作为proxy所绑定的IP和端⼝

mode tcp #以4层⽅方式代理,重要

option tcplog

balance roundrobin #调度算法 'leastconn' 最少连接数分配,或者 'roundrobin',轮询分配

server impalashell_1 linux121:21000 check

server impalashell_2 linux122:21000 check

server impalashell_3 linux123:21000 check

listen impalajdbc

bind 0.0.0.0:25004 #ha作为proxy所绑定的IP和端⼝

mode tcp #以4层方式代理,重要

option tcplog

balance roundrobin #调度算法 'leastconn' 最少连接数分配,或者 'roundrobin',轮询分配

server impalajdbc_1 linux121:21050 check

server impalajdbc_2 linux122:21050 check

server impalajdbc_3 linux122:21050 check

#---------------------------------------------------------------------

# main frontend which proxys to the backends

#---------------------------------------------------------------------

frontend main *:5000

acl url_static path_beg -i /static /images /javascript/stylesheets

acl url_static path_end -i .jpg .gif .png .css .js

use_backend static if url_static

default_backend app

#---------------------------------------------------------------------

# static backend for serving up images, stylesheets and such

#---------------------------------------------------------------------

backend static

balance roundrobin

server static 127.0.0.1:4331 check

#---------------------------------------------------------------------

# round robin balancing between the various backends

#---------------------------------------------------------------------

backend app

balance roundrobin

server app1 127.0.0.1:5001 check

server app2 127.0.0.1:5002 check

server app3 127.0.0.1:5003 check

server app4 127.0.0.1:5004 check

启动

开启: service haproxy start

关闭: service haproxy stop

重启: service haproxy restart

使⽤

Impala-shell访问⽅式

impala-shell -i linux123:25003

使⽤起来⼗分⽅便,区别仅仅相当于是修改了⼀个ip地址和端⼝⽽已,其余不变。

jdbc:hive2://linux123:25004/default;auth=noSasl

Impala集群在操作过程中尽量多给内存,如果内存不能满⾜使⽤要求,Impala的执⾏很可能会报错!!

第 2 节 Impala优化

cloudera官⽹上的Impala⽂档,原名为《Impala Performance Guidelines and Best Practices》。主要介绍了为了提升impala性能应该考虑的⼀些事情,结合实际考虑:

- 基本优化策略

⽂件格式

- 对于⼤数据量来说,Parquet⽂件格式是最佳的

避免⼩⽂件

- insert … values 会产⽣⼤量⼩⽂件,避免使⽤

合理分区粒度

- 利⽤分区可以在查询的时候忽略掉⽆⽤数据,提⾼查询效率,通常建议分区数量在3万以下(太多的分区也会造成元数据管理的性能下降)

分区列数据类型最好是整数类型

- 分区列可以使⽤string类型,因为分区列的值最后都是作为HDFS⽬录使⽤,如果分区列使⽤整数类型可以降低内存消耗

获取表的统计指标

- 在追求性能或者⼤数据量查询的时候,要先获取所需要的表的统计指标(如:执⾏ compute stats )

减少传输客户端数据量

- 聚合(如 count、sum、max 等)

- 过滤(如 WHERE )

- limit限制返回条数

- 返回结果不要使⽤美化格式进⾏展示(在通过impala-shell展示结果时,添加这些可选参数: -B、 --output_delimiter )

在执⾏之前使⽤EXPLAIN来查看逻辑规划,分析执⾏逻辑

Impala join⾃动的优化⼿段就是通过使⽤COMPUTE STATS来收集参与Join的每张表的统计信息,然后由Impala根据表的⼤⼩、列的唯⼀值数⽬等来⾃动优化查询。为了更加精确地获取每张表的统计信息,每次表的数据变更时(如执⾏Insert,add partition,drop partition等)最好都要执⾏⼀遍COMPUTE STATS获取到准确的表统计信息。