SimCLR凭借着几个trick和豪气冲天的GPU/TPU把MOCO干趴了

扭头MOCO就用SimCLR的trick干了回去,

SimCLR,你在TPU上练的死劲不管用了!

MOCO v1

详见https://blog.csdn.net/weixin_42764932/article/details/112768710

MOCO v2

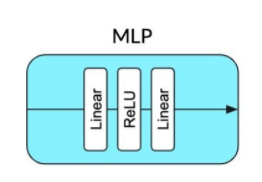

1. Projection Head

咱也在encoder之后增加了一个非线性映射

ImageNet linear classification accuracy:

MLP 对ImageNet 任务提升明显,从60.6%->66.2%

Table 1(a)shows its detection results: in contrast to the big leap on ImageNet, the detection gains are smaller.看来VOC detection提升不大

没关系,这才是热身,接着来

2. augmentation

看Table 1(b)

单独使用数据增强方法(引入新的blur augmentation),对linear classification 的准确率提高低于MLP, 但是在VOC detection的表现却更好,说明两任务之间的提升并不是单调一致的。

通过加入模糊增强来扩展原来的增强(我们发现,在更高的基线中,更强的颜色失真的增益正在减小)。

3. MLP、aug+二者结合

继续提升

4. a cosine (half-period) learning rate schedule

使用新的学习率方法在ImageNet 有小幅度提升,对detection任务有小幅下降。

增大训练的epoch可以提升两个任务的结果。

对比

使用200个epoch和256个批大小的预训练,

MoCo v2在ImageNet上达到了67.5%的精度:

这是比SimCLR在相同epoch、相同批大小下的结果高出5.6%,也优于SimCLR大批次的结果66.6%。

凭借800-epoch预训练,MoCo v2的成绩达到71.1%,超过了拥有1000个epoch的SimCLR的69.3%。

健身房练的死劲不好使了

节能环保