思想很新,效果也很好,CVPR的文章的确质量挺高。可以拿来作为改进的baseline。

Github : https://github.com/guoyongcs/DRN.

Abstract:

通过学习从低分辨率(LR)图像到高分辨率(HR)图像的非线性映射函数,深度神经网络在图像超分辨率(SR)方面表现出了良好的性能。然而,现有的SR方法有两个潜在的限制。首先,学习从LR到HR图像的映射函数是一个典型的不适定问题,因为存在无限个HR图像可以下采样到相同的LR图像。因此,可能的函数空间可能非常大,这使得很难找到一个好的解决方案。其次,配对的LR-HR数据在现实应用中可能是不可用的,底层的退化方法通常是未知的。对于这种更一般的情况,现有的SR模型常常会出现自适应问题,导致性能低下。为了解决上述问题,我们提出了一个对偶回归方案,通过对LR数据引入额外的约束来减少可能的函数空间。具体来说,除了LR图像到HR图像的映射外,我们还学习了一个额外的对偶回归映射,即估计下采样核并重建LR图像,这形成了一个闭环来提供额外的监督。更重要的是,由于双重回归过程不依赖于HR图像,我们可以直接从LR图像中学习。从这个意义上说,我们可以很容易地使SR模型适应真实世界的数据,例如来自YouTube的原始视频帧。利用配对训练数据和非配对真实数据进行的大量实验表明,我们的方法优于现有的方法。

Introduction:

先看效果很优秀啊!作者首先分析了,当前基于学习低分辨率(LR)图像到高分辨率(HR)图像的非线性映射的SR模型主要存在以下两个问题:

1.学习从LR到HR图像的映射是一个典型的不适定问题,因为存在无穷多的HR图像可以被缩小以获得相同的LR图像。因此,将LR映射到HR图像的可能函数空间变得非常大。因此,在如此大的空间中学习一个好的解决方案是非常困难的,因此学习性能是有限的。因此,如何减少映射函数的可能空间,提高SR模型的训练成为一个重要的问题。

2.现实场景中成对的数据是很难获得的。此外,通过特定的退化方法(如双三次)得到的LR图像不一定具有相同的分布。因此,为现实世界应用程序学习一个好的SR模型是非常具有挑战性的。更重要的是,如果我们直接将现有的SR模型应用于真实世界的数据,它们常常会产生严重的适应问题,并产生糟糕的性能。因此,如何有效地利用未配对数据使SR模型适应实际应用成为一个迫切而重要的问题。

–由于第二点是弱监督学习问题,我这里不做关注!

本文针对1的解决方法:

本文提出了一个新的对偶回归方案,它形成了一个闭环来提高SR性能。为了解决第一个限制,我们引入了一个附加的约束来减少可能的空间,以便超分辨图像能够重建输入的LR图像。理想情况下,如果映射来自LR->HR是最优的,超分辨图像可以向下采样得到相同的输入LR图像。有了这样的约束,我们就能够估计底层的下采样核,从而减少可能函数的空间,找到从LR到HR的良好映射。

Method:

1.何为对偶回归?

对偶回归的目标是减少LR->HR图像映射函数的可能空间。具体来说,算法除了学习LR–>HR图像的映射以外,还学习了从超分辨后的图像到LR图像的对偶映射。

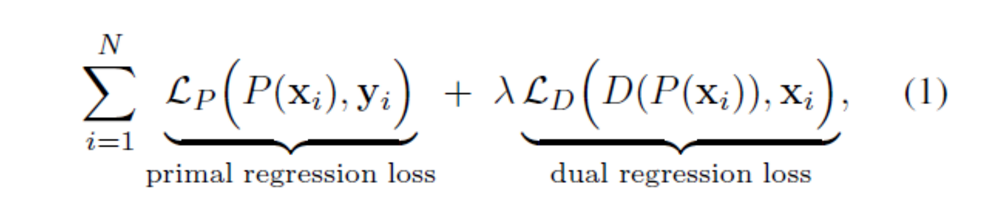

作者将整个任务分为Primal回归和Dual回归两个任务。同时学习了原始映射P重建HR图像和对偶映射D重建R图像。注意,对偶映射可以看作是底层下采样内核的估计。正式地将SR问题表述为包含两个回归任务的二元回归方案。

理论假设:其中,Primal回归和Dual回归任务形成的闭环, 并提供监督训练模型P和D 。如果P (x)是正确的HR图像映射函数, 然后down-sampled 后的图像D (P (x))应该非常接近输入 LR图像。通过这种约束,我们可以减少可能的映射和函数空间更容易学习更好的重建HR图像。

2.损失函数:

式子中,P(x)为Primal回归任务,即LR->HR过程。D(P(x))为Dual回归任务,即超分辨率后的图像->LR的过程。整个损失是两个任务损失的加权之和。

3.DRN:

整个网络是个UNet结构,其中,编码器部分由简单的卷积层和LeakyRelu组成,分辨率逐层降低。解码器部分由RCAB(残差结构+CA注意力)和pixelshuffle上采样组成。编码器和解码器组成了Primal回归任务。Dual回归任务对超分后的图像进行卷积下采样得到LR图像。

Experiments:

1.4X,8X结果:

2.模型复杂度: