问题描述:

昨天晚上都下班了,突然领导发消息实时数据没有了,我去什么鬼,我记得我走的时候数据还是正常启动的,怎么就没数据那,

我们数据是通过flink 从kafka 消费数据,然后写入到hbase.怎么就没数据那什么情况。

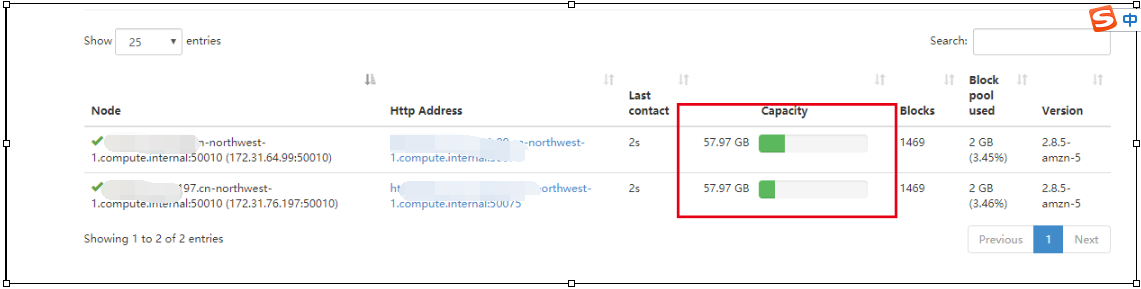

然后我去yarn的资源管理器上面查看运行情况 发现,程序挂掉了,什么情况。好好的怎么会挂掉。卧槽,我一看hdfs节点出现了不正常的机器unhealthy

r然后报错信息就是1/2 local-dirs are bad: /mnt/yarn; 1/1 log-dirs are bad: /var/log/hadoop-yarn/containers

然后我通过yarn的命令查看集群的节点情况果不其然

然后就找到这台机器,查看资源的使用情况 果然磁盘使用超过百分之90

所以只能先把磁盘空间降下来,要不然程序都起不了,然后我就开始删除这台服务器上面的相关日志,删除完成之后好一点变为了百分之53 现在可以把程序部署上去,然后

我就再看数据存在哪里把数据删一删,但是通过hbase的设置7天数据 但是本地磁盘并没有把内存降下来,最后发现 我的数据路径不在hdfs上面 我的数据在s3上,和hdfs有个毛关系

最后通过hdfs的命令去查询发现好多日志存在hdfs上面开始删除日志。

hdfs dfs -rmr /var/log/hadoop-yarn/apps/root/logs/*

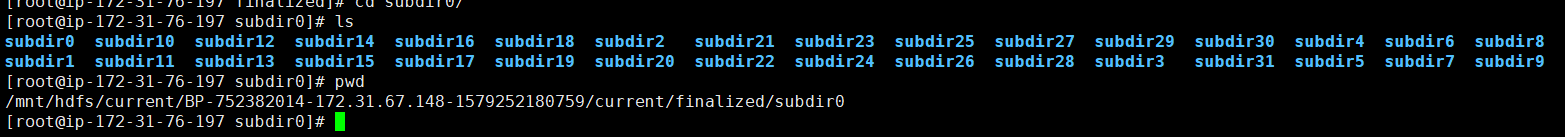

这里需要注意啊,我看好多人写的再本地有很多的subdir这样的文件占的磁盘空间特别多,这尼玛什么情况,

/mnt/hdfs/current/BP-752382014-172.31.67.148-1579252180759/current/finalized/subdir0

这里提一句啊,这里的这些数据是不能在本地删除的。他说你hdfs的元数据信息,你删除了系统就乱套了。

所以正确的做法是 我在hdfs上面删除数据 对应的本地的这些文件夹下面的数据都会被删除。

不要乱删文件 切记。

文件删除 问题解决了

这个时候的磁盘使用率下降。爽歪歪 hdfs的文件系统上磁盘也好了

坑了 我一天找不到原因 ,看到别人写的那些操作步骤都不详细。真是蛋疼 都不知道咋搞。