第七章 深度学习中的正则化

官网链接

2020-2-9 深度学习笔记7 - 深度学习中的正则化1(参数范数惩罚和范数惩罚约束)

2020-2-12 深度学习笔记7 - 深度学习中的正则化2(欠约束,数据集增强,噪声鲁棒性,输出目标注入噪声)

2020-2-13 深度学习笔记7 - 深度学习中的正则化3(半监督,多任务,提前终止-解决过拟合,参数绑定与参数共享)

2020-2-14 深度学习笔记7 - 深度学习中的正则化4(稀疏表示-稀疏化激活单元(元素稀疏),Bagging和其他集成方法,Dropout-廉价Bagging近似)

对抗训练-增强鲁棒性

什么是对抗样本(adversarial example)?

简单的说,就是会使得机器学习的算法产生误判的样本。

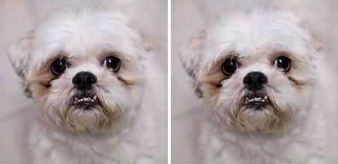

在数据集中通过故意添加细微的干扰所形成的输入样本,受干扰之后的输入导致模型以高置信度给出一个错误的输出。例如下图

人类观察者不会察觉原始样本和对抗样本之间的差异。但是深度神经网络会把左图看成狗,右图看成鸵鸟。

对抗样本主要用于计算机安全领域。

什么是对抗训练?

通过在原有的模型训练过程中注入对抗样本,从而提升模型对于微小扰动的鲁棒性【robustness就是系统的健壮性】。模型误判需要的扰动幅度越大,那么说明模型的鲁棒性越好。

在正则化背景下,通过对抗训练(adversarial training)可以减少原有独立同分布的测试集的错误率——在对抗扰动的训练集样本上训练网络。

主要原因之一是高度线性,神经网络主要是基于线性模块构建的。输入改变 ,则权重为 的线性函数将改变 ,对于高维的这是一个非常大的数。

对抗训练通过鼓励网络在训练数据附件的局部区域恒定来限制这一个高度敏感的局部线性行为。

切面距离、正切传播和流形正切分类器-克服维数灾难

许多机器学习通过假设数据位于低维流形附近来克服维数灾难。

一个利用流形假设的早期尝试是切面距离(tangent distance)算法。它是一种非参数的最近邻算法,其中使用的度量不是通用的欧几里德距离,而是根据邻近流形关于聚集概率的知识导出的。

正切传播(tangent prop)算法训练带有额外惩罚的神经网络分类器,使神经网络的每个输出f(x)对已知的变化因素是局部不变的。这些变化因素对应于沿着的相同样本聚集的流形的移动。正切传播不仅用于监督学习,还在强化学习中有所应用。

正切传播和流形正切分类器都会正则化

,使其不随

沿流形的移动而剧烈变化。

正切传播需要用户手动指定正切方向的计算函数(例如指定小平移后的图像保留在相同类别的流形中),而流形正切分类器通过训练自编码器拟合训练数据来估计流形的正切方向 。

根据流形正切分类器提出的算法相当简单:

(1)使用自编码器通过无监督学习来学习流形的结构

(2)如正切传播一样使用这些切面正则化神经网络分类器。

小结

本章中,我们已经描述了大多数用于正则化神经网络的通用策略。正则化是机器学习的中心主题。

又,机器学习的另一个中心主题是优化。