单个神经元网络

简化表示

正向传播:W*X+B=y

W,B为参数,X为样本值,y为预测值,Y为标签值

反向传播:根据差值标签值Y-预测值y,对W和B进行相应的调整。

循环往复进行

softmax分类算法

得出分别为y1,y2,y3的概率

得出分别为y1,y2,y3的概率

tensorflow代码:tf.nn.softmax(logits,name=None)

损失函数(即标注中差值的计算)

均值平方差

适用范围:输入为实数,无界的值

tensorflow代码:

MSE=tf.reduce_mean(tf.square(input_lables - output))

MSE=tf.reduce_mean(tf.pow(tf.sub(input_lables,output),2.0))

MSE=tf.reduce_mean(tf.sub(input_lables,output)))

交叉熵

适用范围:一般用于分类

tensorflow代码:

tf.nn.softmax_cross_rntropy_with_logits

tf.nn.sigmoid_cross_rntropy_with_logits

tf.nn.sparse_softmax_cross_entropy_with_logits

-tf.reduce_sum(y*tf.log(pred),1)

梯度下降

tensorflow代码:

tf.train.GradientDescentOptimizer

tf.train.AdamOptimizer

学习率

退化学习率:

退化学习率:

tf.train.expcnetial_decay(starter_learning_rate,global_step,100000,0.96)

多层神经网络

提高精度,解决非线性问题

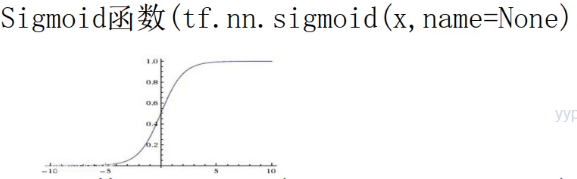

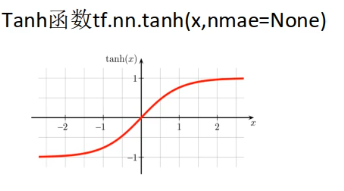

激活函数

不能加多层(最多为3)

特征值差异大,不能多层

特征值差异大,不能多层

小于0丢弃,大于0保留